深刻な-50

動機:

深いネットワークは、多くの場合、より豊富な特徴を抽出することができるが、表示されるネットワーク層の深化と

ネットワーク性能の深化であり、ネットワークの劣化の現象を弱めました。

Resnet50プラスネットワーク層との間にshutcutの接続は、学習の実際の目的は、残留アイテムです。現在のネットワークが最適に達した場合は、深めにする必要はありません、そして残留マッピング情報ネットワーク層の次の部分が0にプッシュされます、唯一のアイデンティティマッピングはそのまま上位レイヤのネットワークを受け継が。深めるために、現在のネットワークが必要な場合、ネットワーク層の残留マッピングの次の部分は、層間混合アイテムを学習し続けます。

実装

次の層への従来のネットワーク出力はF(X)であり、その後、次の層のresnetに出力されるF(X)+ X、F(x)は、残留マッピングを参照して、X IDマッピングを意味します。重量-BN-relu重量-BNプラスアイデンティティreluベース残留マッピング、V1の実装のため、V2の実装では、販売契約のidentiyマッピングを確保するために、BN-relu重量-BN-relu重量プラス同一でありますセックス。

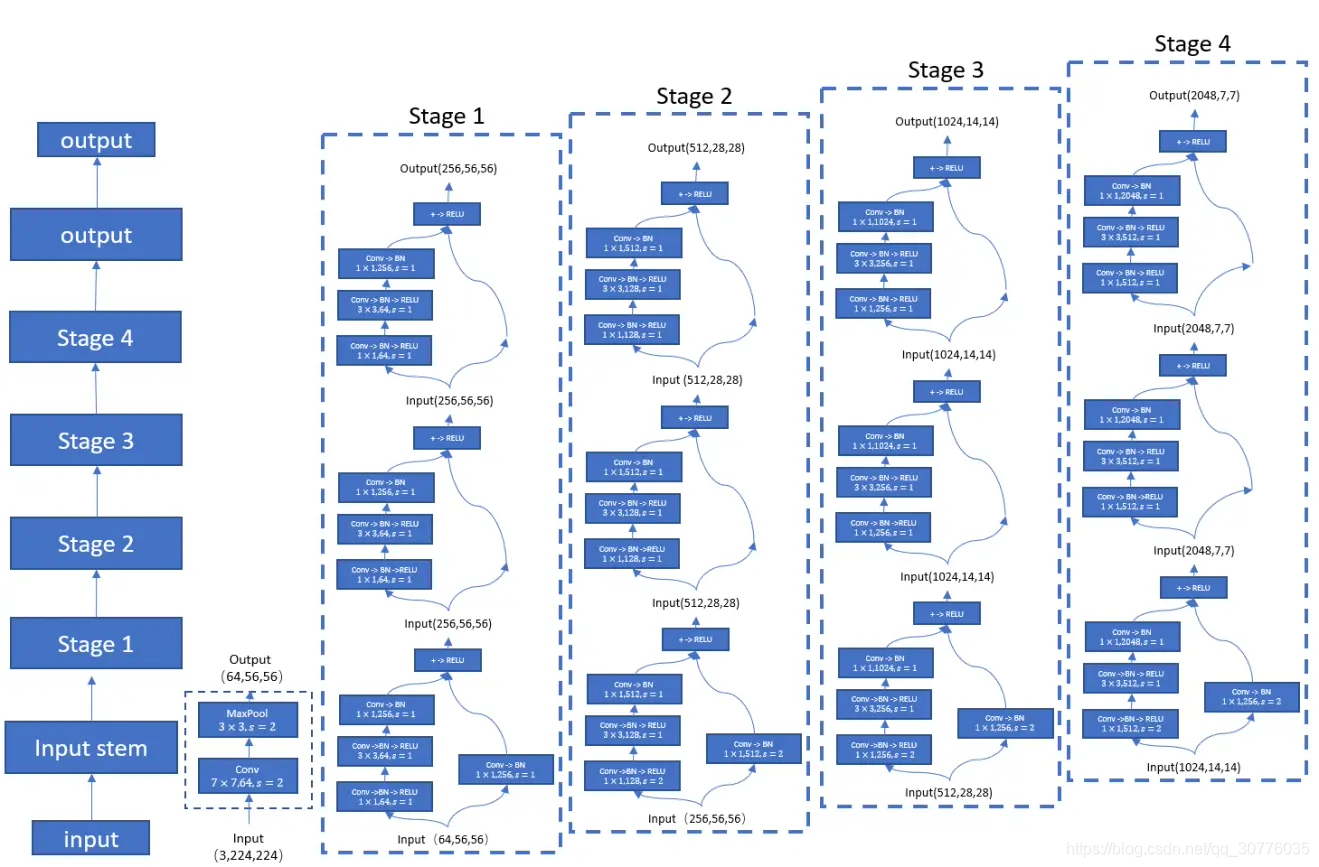

resnet-50構造

組成maxpooling共通ステージ1のCONVから、5つの段階に分けて、機能の予備抽出し、残りの4つのステージを作るために、サンプルブロックとボトルネックブロック2の各段は、残差ブロックから構成されています。

前と分岐後、このため残留マッピングブロックのボトルネックの名前を含むボトルネックブロックは1x1のCONV 3x3conv、回復チャネル、縮小パラメータおよび添加後1x1convにより、コンピューティング能力の数を減らすことがされています。入力への直接の枝のアイデンティティマッピングブロック。

処理すべき残差ブロックに基づいてブロックをダウンサンプリングする深度特徴マップステージとチャネル・アライメント問題を減少します。最初の分岐と残留分枝ストライドのアイデンティティによってstage3-5 CONVは、特徴マップを減らすために、2を設定します。ヘルプを1x1conv層アイデンティティブランチ、ブランチを追加することによって、ステージ2-5統一アイデンティティを完了し、枝の数は、残留長手方向チャネル拡張通路。特徴マップの低減を達成するための最初のストライドのCONV = 2を提供することにより。

クロスエントロピー損失

ソフトマックス関数超える出力の様々なタイプのクロスエントロピー確率は、サンプルが属する算出し、試料間の分布の推定と実際の分布を最小限。

BN層のトレーニング、テストの違い

トレーニング段階では、時間に各時間前に更新running_var running_mean、テストフェーズ、()と固定running_mean running_var BN層net.evalにより、今回二つの値は、最後のトレーニング・フェーズの前にあります決定された値、およびテストフェーズ全体で変わりません。

pytorch列車()はeval()

電車()トレーニング段階、オープンドロップアウトとBNの

はeval()ベータ、閉じドロップアウト、BN