introduction

Récemment, lors du Sequoia AI Summit aux États-Unis, le professeur Andrew Ng, une autorité de premier plan dans le domaine de l'intelligence artificielle, a publié des tendances de pointe et des informations approfondies sur les agents d'IA. Il a souligné que par rapport aux applications classiques de modèle de langage à grande échelle (LLM), le flux de travail de l'agent présente des caractéristiques plus itératives et conversationnelles, ouvrant la voie à de nouvelles idées dans le domaine du développement d'applications d'IA.

Lors de ce sommet, le professeur Ng Enda a discuté en profondeur des perspectives de développement d'AI Agent, qui constitue un sujet passionnant pour tous les développeurs et chercheurs en IA. Il a expliqué les principales caractéristiques du flux de travail des agents : plutôt que de rechercher un retour d'information immédiat, il préconise l'exécution des tâches via une communication continue et des processus itératifs pour obtenir de meilleurs résultats.

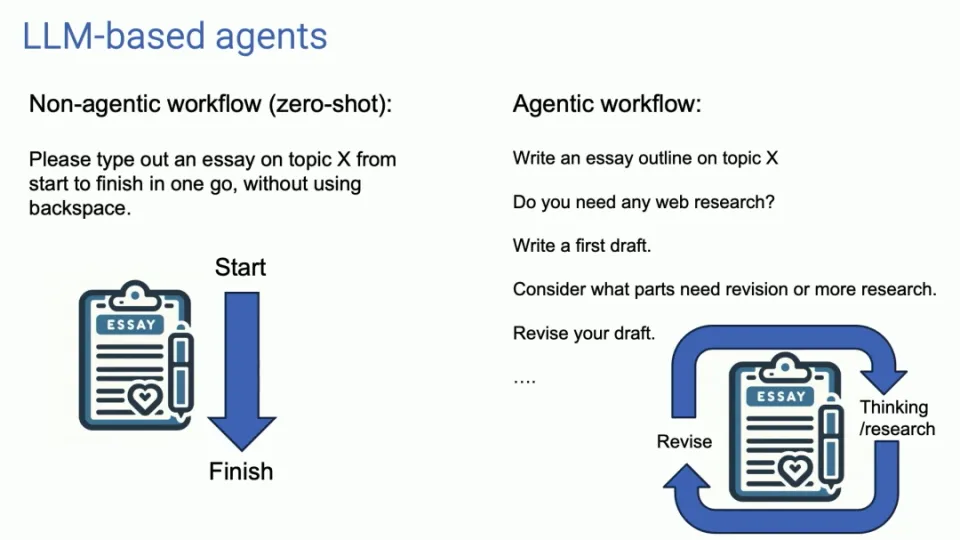

Caractéristiques du flux de travail de l'agent

L'utilisation traditionnelle du LLM est similaire à une entrée et une sortie uniques, tandis que le flux de travail de l'agent est comme un dialogue continu, optimisant les résultats de sortie à travers plusieurs itérations. Cette approche nous oblige à changer la façon dont nous interagissons avec l’IA, à déléguer davantage de tâches à l’agent et à attendre patiemment les résultats qu’elle fournit.

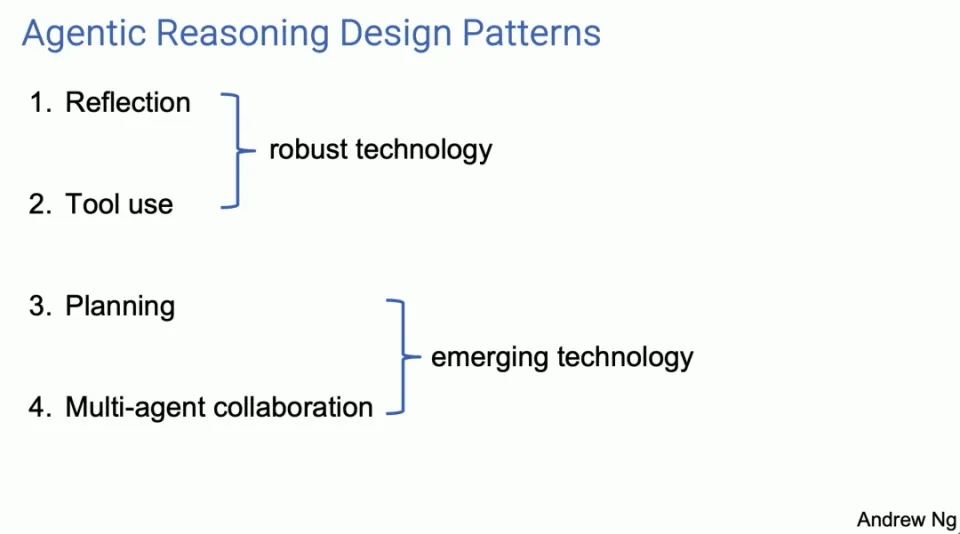

Quatre modèles de conception d'agent principaux

Le professeur Ng Enda a présenté quatre principaux modèles de conception d'agents, chacun montrant le potentiel d'améliorer les capacités de l'IA.

-

Réflexion

- L'agent améliore la qualité des résultats en auto-examinant et en corrigeant les résultats. Par exemple, lors de l’écriture de code, l’agent peut s’auto-réfléchir et corriger les erreurs, générant ainsi un meilleur code.

Agent Reflection est un outil que je pense que beaucoup d'entre nous utilisent, et c'est l'outil qui fonctionne. Je pense que c'est plus largement reconnu et que cela fonctionne plutôt bien. Je pense que ce sont des techniques assez robustes. Lorsque je les utilise, je les fais presque toujours bien fonctionner grâce à la planification et à la collaboration multi-agents.

Je pense qu'il s'agit plutôt d'un domaine émergent et je suis parfois surpris de voir à quel point ils fonctionnent lorsque je les utilise, mais au moins pour le moment, j'ai l'impression que je n'arrive pas toujours à les faire fonctionner de manière fiable. Permettez-moi d'expliquer ces quatre modèles de conception à travers plusieurs aspects. Si certains d'entre vous essayent cela eux-mêmes, ou demandent à leurs ingénieurs de les utiliser, je pense que vous obtiendrez une augmentation de productivité assez rapidement.

Concernant la réflexion, voici un exemple. Disons que je demande à un système d'écrire du code pour que je puisse accomplir une tâche donnée. Et puis nous avons un agent de codage, qui est juste un LLM qui vous invite à écrire du code, comme : « Hé, définissez doTask, écrivez une fonction comme celle-ci. »

Un exemple d'auto-réflexion pourrait être si vous demandiez ensuite à LLM quelque chose comme : "Voici un morceau de code destiné à accomplir une tâche, donnez-lui simplement exactement le même code qu'il vient de générer et dites, vérifiez si le code est correct, efficace, bien construit ? Écrivez simplement un indice comme celui-ci.

Il se peut que le même LLM que vous avez invité à écrire le code soit capable de trouver une erreur comme celle-ci à la ligne 5 et de la corriger d'une manière ou d'une autre. Si vous lui donnez maintenant vos propres commentaires et que vous le relancez, il peut proposer une deuxième version du code qui fonctionnera mieux que la première version.

Aucune garantie, mais cela fonctionne souvent assez bien pour valoir la peine d'être essayé pour de nombreuses applications, et de bon augure si vous le laissez exécuter les tests unitaires, et s'il échoue aux tests unitaires, pourquoi échoue-t-il aux tests unitaires ? Avoir cette conversation pourrait expliquer pourquoi les tests unitaires échouent. Essayez donc de changer certaines choses et obtenez peut-être la version 3.

À propos, pour ceux d'entre vous qui souhaitent en savoir plus sur ces technologies, je suis très enthousiasmé par elles. Pour chacune des quatre parties, j'ai une section de lecture recommandée en bas, où d'autres références sont incluses.

Encore une fois, avec les systèmes multi-agents, je décris un seul agent de code que vous invitez à se parler. Une évolution naturelle de cette idée est qu'au lieu d'un seul agent de code, vous pourriez avoir deux agents, dont l'un est l'agent de code et l'autre un agent de critique. Il peut s'agir du même LLM sous-jacent, mais déclenché de différentes manières. Disons que vous êtes un rédacteur de code expert, n'est-ce pas ? écrire le code. Un autre a dit, vous êtes un réviseur de code expert, révisez ce code.

Ce flux de travail est en fait facile à mettre en œuvre. Je pense que c'est une technique très polyvalente pour de nombreux flux de travail. Cela améliorera considérablement les performances de LLM.

-

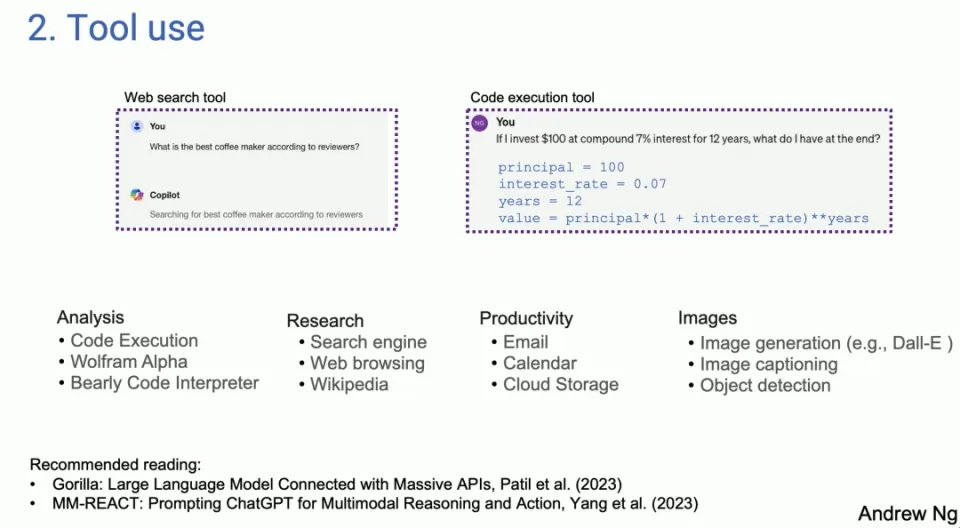

Utilisation des outils

- LLM est capable de générer du code et d'appeler des API pour effectuer des opérations pratiques, élargissant ainsi son champ d'application. Dans ce mode, LLM peut non seulement générer du texte, mais également interagir avec des outils et des interfaces externes.

Le deuxième modèle de conception est celui que de nombreuses personnes ont vu utilisé dans les systèmes basés sur LLM. Sur la gauche se trouve une capture d'écran de Copilot. Sur la droite se trouve quelque chose que j'ai tiré de GPT-4, mais le LLM d'aujourd'hui, si vous le demandez, quelle est la meilleure machine à café d'après une recherche en ligne, pour certaines questions, LLM générera le code et exécutera le code. Il s’avère qu’il existe de nombreux outils différents utilisés par de nombreuses personnes différentes pour l’analyse, l’acquisition d’informations, l’action et la productivité personnelle.

Les premiers travaux se sont tournés vers l’utilisation, à l’origine dans la communauté de la vision par ordinateur. Parce qu'avant LLM, ils ne pouvaient pas traiter les images. La seule option est donc de générer un appel de fonction capable de manipuler l'image, comme générer une image ou effectuer une détection d'objet, etc. Si vous regardez réellement la littérature, il est intéressant de constater qu'une grande partie du travail sur l'utilisation semble provenir du domaine de la vision, car avant GPT-4 et ainsi de suite, LLM était aveugle aux images, et c'est à cela que sert l'utilisation et l'extension du LLM. Des choses qui peuvent être faites.

-

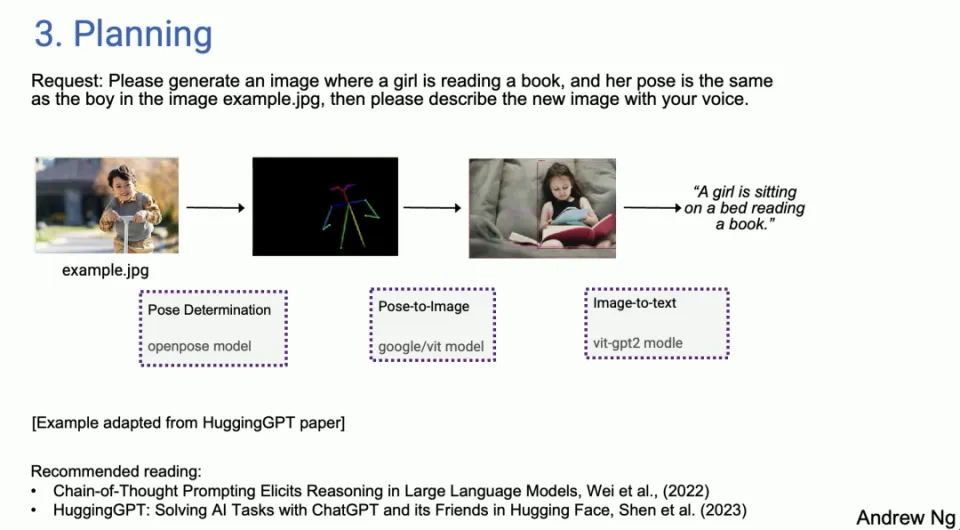

Planification

- L'agent peut décomposer des tâches complexes et les exécuter comme prévu, démontrant la capacité de l'IA à gérer des problèmes complexes. Les algorithmes de planification permettent aux agents de gérer et d'accomplir leurs tâches plus efficacement.

Et puis la planification, pour ceux qui n'ont pas beaucoup joué avec les algorithmes de planification, j'ai l'impression que beaucoup de gens parlent de moments ChatGPT où vous vous dites, wow, vous n'avez jamais rien vu de tel. Je ne pense pas que vous utilisiez encore un algorithme de planification. Beaucoup de gens seront surpris par AI Agent.

Je ne peux pas imaginer qu'un agent IA fasse ça aussi bien. J'ai fait des démos en direct et certaines d'entre elles ont échoué et l'agent AI a contourné ces échecs. En fait, j'ai rencontré pas mal de situations où, oui, je n'arrivais pas à croire que mon système d'IA faisait cela de manière autonome.

Mais dans un exemple adapté de l'article HuggingGPT, vous avez dit : veuillez générer une image d'une fille lisant un livre dans la même posture que le garçon dans l'exemple d'image point jpeg, veuillez décrire la nouvelle image avec la voix. Donc, pour donner un exemple, il existe aujourd'hui un agent IA, et vous pouvez décider que la première chose à faire est de déterminer la posture du garçon. Ensuite, trouvez le bon modèle et extrayez éventuellement la pose sur HuggingFace. Ensuite, vous devez trouver un modèle d'image de pose pour synthétiser une image d'une fille et suivre les instructions. Utilisez ensuite la détection d’images et enfin la synthèse vocale.

En fait, nous avons des agents aujourd'hui, je ne veux pas dire qu'ils travaillent de manière fiable, ils sont un peu capricieux. Ils ne fonctionnent pas toujours, mais quand ils le font, c'est en fait assez étonnant, mais avec Agent Sex Loops, vous pouvez parfois également vous remettre des premiers échecs. J'ai donc découvert que j'utilisais déjà Research Agent. Donc une partie de mon travail, une partie de mes recherches, mais je n'ai pas envie d'aller moi-même sur Google et d'y passer beaucoup de temps. Je suis censé envoyer à l'agent de recherche et revenir quelques minutes plus tard pour voir ce qu'il trouve, parfois ça marche, parfois non, mais cela fait déjà partie de mon flux de travail personnel.

-

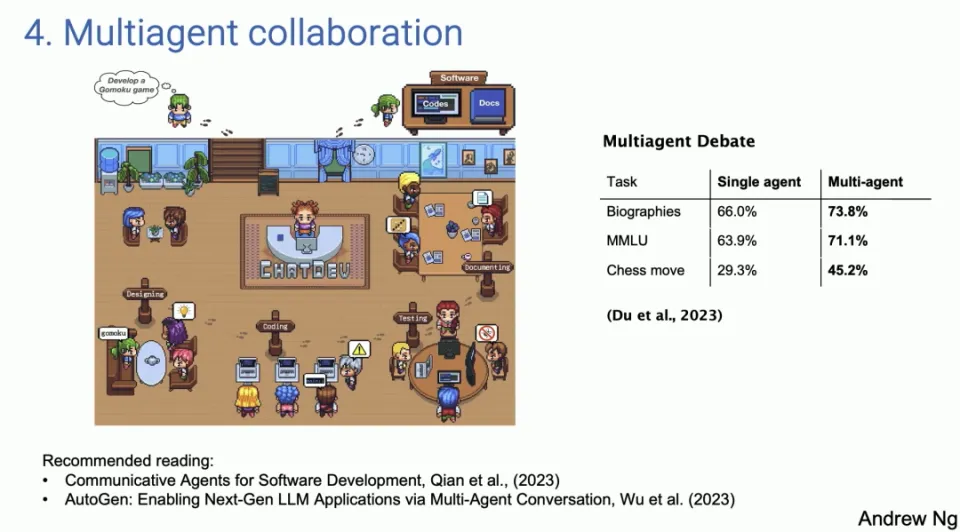

Collaboration multi-agents

- Plusieurs agents jouent différents rôles et coopèrent pour accomplir des tâches, simulant ainsi la collaboration dans un environnement de travail réel. La puissance de cette approche est qu’elle permet à LLM de devenir plus qu’un simple outil effectuant une tâche unique, mais plutôt un système collaboratif capable de gérer des problèmes et des flux de travail complexes.

Le dernier modèle de conception, la coopération multi-agents, semble intéressant, mais il fonctionne bien mieux que vous ne le pensez. Sur la gauche se trouve une capture d'écran d'un article appelé ChatDev, qui est entièrement open source, en fait open source. Comme beaucoup d'entre vous l'ont vu, Shining Social

La démo diffusée par le média, ChatDev, est open source et fonctionne sur mon ordinateur portable. ChatDev est un exemple de système multi-agents dans lequel vous pouvez inciter un LLM à agir tantôt comme le PDG d'une société d'ingénierie logicielle, tantôt comme un concepteur, tantôt comme un chef de produit et parfois comme un testeur.

En invitant LLM à lui dire que vous êtes maintenant le PDG, maintenant vous êtes l'ingénieur logiciel, ils collaborent et ont une conversation prolongée au point où si vous le lui dites, s'il vous plaît, développez un jeu, développez un jeu multijoueur, ils le feront. passez en fait quelques minutes à écrire du code, à le tester, à le répéter et vous obtenez un programme étonnamment complexe.

Ce type de collaboration multi-agents peut paraître un peu fantaisiste, mais il fonctionne en réalité mieux que vous ne l’imaginez. Non seulement parce que la coopération entre ces agents peut apporter des contributions plus riches et plus diversifiées, mais aussi parce qu'elle peut simuler un scénario plus proche d'un environnement de travail réel, dans lequel des personnes ayant des rôles et des expertises différents travaillent vers un objectif commun. La puissance de cette approche est qu’elle permet à LLM de devenir plus qu’un simple outil effectuant une tâche unique, mais plutôt un système collaboratif capable de gérer des problèmes et des flux de travail complexes.

La valeur potentielle de cette approche est énorme, car elle ouvre de nouvelles possibilités pour automatiser et rendre les flux de travail plus efficaces. Par exemple, en simulant les différents rôles d’une équipe de développement logiciel, une entreprise peut automatiser certaines tâches de développement, accélérant ainsi les projets et réduisant les erreurs. De même, cette méthode de coopération multi-agents peut également être appliquée à d'autres domaines, tels que la création de contenu, l'éducation et la formation, ainsi que la planification stratégique, élargissant ainsi le champ d'application du LLM dans diverses industries.

Potentiel et défis du flux de travail des agents

Bien que ces flux de travail d’agents soient pleins de potentiel, même s’ils se développent rapidement, ils présentent également certains défis. Certains modèles de conception sont relativement matures et fiables, tandis que d’autres sont encore incertains. De plus, l’importance de la génération rapide de tokens ne peut être ignorée, car elle permet d’obtenir de bons résultats même si elle est basée sur un LLM de moindre qualité et génère de nouveaux tokens par itération rapide.

Études de cas et applications pratiques

Le professeur Ng Enda a en outre expliqué l'efficacité du flux de travail des agents à travers des études de cas et des applications pratiques. Par exemple, l'analyse du codage à l'aide de Human Eval Benchmark et la comparaison des performances entre GPT-3.5 et GPT-4 montrent toutes deux la supériorité du flux de travail de l'agent. Dans le domaine du développement logiciel en particulier, des exemples d'application de systèmes multi-agents montrent comment améliorer l'efficacité du développement et réduire les erreurs en simulant différents rôles dans un environnement de travail réel.

perspectives d'avenir

Le professeur Ng Enda estime que les capacités des agents IA seront considérablement étendues et que nous devons apprendre de nouvelles façons de travailler avec les agents IA. Le potentiel d’une itération rapide et des premiers modèles indique que l’IA sera appliquée plus largement et plus profondément dans divers domaines.

Résumer

Grâce à des modèles de conception tels que la réflexion d'agent, la planification et la coopération multi-agents, nous pouvons non seulement améliorer les performances des LLM, mais également élargir leurs domaines d'application et en faire des outils plus puissants et plus flexibles. À mesure que ces technologies continuent de se développer et de s’améliorer, nous espérons que les agents IA joueront un rôle clé dans davantage de scénarios à l’avenir, apportant ainsi des solutions plus intelligentes et plus efficaces aux utilisateurs.

Cela ne fonctionne pas toujours. Je l'ai utilisé. Parfois ça ne marche pas, parfois c'est surprenant, mais la technologie s'améliore définitivement. Il existe également un modèle de conception, et il s'avère que le débat multi-agents, c'est-à-dire le débat entre différents agents, par exemple, vous pouvez faire débattre ChatGPT et Gemini, ce qui conduit en fait à de meilleures performances.

Par conséquent, le fait d’avoir plusieurs agents aériens simulés travaillant ensemble constitue également un modèle de conception puissant. Pour résumer, je pense que ce sont les modèles que j’ai vus. Je pense que si nous étions capables d’utiliser ces modèles, beaucoup d’entre nous pourraient obtenir des améliorations pratiques très rapidement. Je pense que le modèle de conception du raisonnement de l'agent sera important.

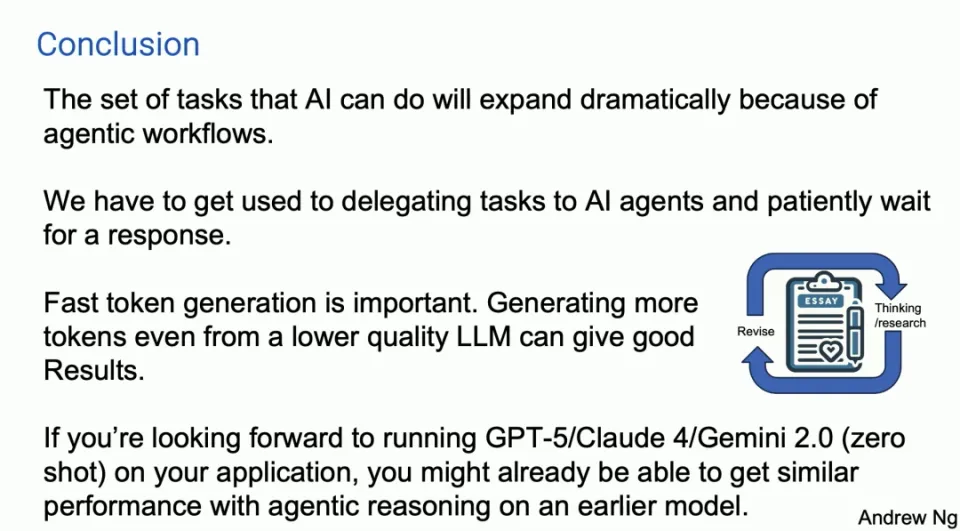

Voici ma courte diapositive récapitulative. Je prédis qu'en raison du flux de travail des agents, les tâches que l'IA peut effectuer s'élargiront considérablement cette année. Une chose à laquelle il est en fait difficile de s'habituer est que lorsque nous envoyons une invite au LLM, nous attendons une réponse immédiate. En fait, il y a dix ans, lorsque j'étais chez Google à parler de ce que nous appelions la recherche dans les grandes surfaces, l'une des raisons des longues invites, l'une des raisons pour lesquelles je n'ai pas réussi à insister, c'est que lorsque vous effectuez une recherche sur le Web, vous vous voulez effectuer une recherche en deux fois moins de temps. Obtenez une réponse en quelques secondes, n'est-ce pas ? C'est la nature humaine, la capture instantanée, le retour instantané.

Pour de nombreux flux de travail d'agents, je pense que nous devons apprendre à déléguer des tâches aux agents IA et attendre patiemment des minutes, voire des heures, pour une réponse, mais comme j'ai vu de nombreux managers novices déléguer des tâches à quelqu'un, puis cinq minutes. pareil, non ? Ce n’est pas productif.

Je pense que nous devons également apprendre à le faire avec certains de nos agents IA, même si c'est difficile. Je pensais avoir entendu une perte. Ensuite, une tendance importante est que les générateurs de jetons rapides sont importants car dans ces flux de travail d'agent, nous itérons constamment. LLM génère donc des jetons pour LLM, et c'est formidable de pouvoir générer des jetons beaucoup plus rapidement que quiconque ne peut les lire.

Je pense que générer plus de jetons rapidement, même à partir d'un LLM de qualité légèrement inférieure, peut donner de bons résultats par rapport aux jetons plus lents d'un meilleur LLM. Cela pourrait être un peu controversé car cela pourrait vous obliger à faire le tour du cercle plus de fois, un peu comme ce que j'ai montré sur la première diapositive avec GPDC et les résultats d'une architecture d'agent.

Franchement, j'attends vraiment avec impatience Claude5 et Claude4, GPT-5 et Gemini 2.0 et tous ces merveilleux modèles que vous construisez. Une partie de moi a l'impression que si vous cherchez à exécuter vos produits sur GPT-5, sans tir, vous pourriez en fait vous rapprocher de ce niveau de performances sur certaines applications que vous ne le pensez avec l'inférence d'agent, mais dans un premier modèle, Je pense que c'est une tendance importante.

Honnêtement, le chemin vers l'AGI ressemble plus à un voyage qu'à une destination, mais je pense que ce flux de travail d'agent pourrait nous aider à faire un petit pas en avant dans ce très long voyage.

Linus a pris les choses en main pour empêcher les développeurs du noyau de remplacer les tabulations par des espaces. Son père est l'un des rares dirigeants capables d'écrire du code, son deuxième fils est directeur du département de technologie open source et son plus jeune fils est un noyau. contributeur à l'open source. Huawei : Il a fallu 1 an pour convertir 5 000 applications mobiles couramment utilisées Migration complète vers Hongmeng Java est le langage le plus sujet aux vulnérabilités tierces Wang Chenglu, le père de Hongmeng : l'open source Hongmeng est la seule innovation architecturale. dans le domaine des logiciels de base en Chine, Ma Huateng et Zhou Hongyi se serrent la main pour « éliminer les rancunes ». Ancien développeur de Microsoft : les performances de Windows 11 sont « ridiculement mauvaises » " Bien que ce que Laoxiangji est open source, ce ne soit pas le code, les raisons qui le sous-tendent. sont très réconfortants. Meta Llama 3 est officiellement publié. Google annonce une restructuration à grande échelle.Cet article est une réimpression de l'article Heng Xiaopai et les droits d'auteur appartiennent à l'auteur original. Il est recommandé de consulter le texte original. Pour réimprimer cet article, veuillez contacter l'auteur original.