Cet article explore de manière exhaustive les concepts de base, les outils et les applications avancées de la technologie d'orchestration de conteneurs, y compris les principales plates-formes telles que Docker Compose et Kubernetes et leurs fonctions avancées telles que la gestion du réseau et du stockage, la surveillance, la sécurité, etc. En outre, l'article explore des exemples d'applications pratiques de ces technologies, fournissant ainsi un aperçu des tendances futures.

Suivez [TechLeadCloud] pour partager des connaissances complètes sur l'architecture Internet et la technologie des services cloud. L'auteur a plus de 10 ans d'expérience en architecture de services Internet, en recherche et développement de produits d'IA et en gestion d'équipe. Il est titulaire d'une maîtrise de l'Université Tongji de l'Université de Fudan, membre du Fudan Robot Intelligence Laboratory, architecte senior certifié par Alibaba Cloud. , un professionnel de la gestion de projet, et de la recherche et du développement de produits d'IA avec un chiffre d'affaires de plusieurs centaines de millions de dollars.

1. Introduction à l'orchestration de conteneurs

L'orchestration des conteneurs est au cœur de la gestion moderne des applications cloud natives et implique l'automatisation du déploiement, de la gestion, de la mise à l'échelle et de la configuration réseau des conteneurs à grande échelle. Avec l’essor de l’architecture des microservices et la complexité croissante des applications, l’orchestration de conteneurs est devenue une technologie clé pour parvenir à une gestion des services efficace, fiable et dynamique.

Le concept et l'importance de l'orchestration des conteneurs

Le concept d'orchestration de conteneurs découle de la nécessité de gérer efficacement des centaines ou des milliers de conteneurs sur un grand nombre de machines physiques ou virtuelles. Même si les conteneurs eux-mêmes sont légers et rapides, la gestion manuelle du déploiement et du cycle de vie de ces conteneurs n'est pas pratique dans des environnements de production complexes. En automatisant ces processus, l'orchestration des conteneurs offre plusieurs avantages clés :

- Utilisation efficace des ressources : grâce à une planification intelligente, les outils d'orchestration peuvent garantir que les conteneurs s'exécutent sur l'hôte le plus approprié et optimisent l'utilisation des ressources.

- Expansion et récupération rapides : en réponse à des pics de trafic soudains ou à des pannes de service, l'orchestration de conteneurs peut rapidement étendre ou redéployer les services.

- Automatisation et cohérence : les outils d'orchestration garantissent la cohérence du déploiement, réduisent les erreurs humaines et rendent le processus de déploiement plus automatisé et reproductible.

- Découverte de services et équilibrage de charge : la configuration du réseau et la communication entre les conteneurs sont automatiquement gérées via des outils d'orchestration, améliorant ainsi les performances globales des applications.

La tendance de développement de l'orchestration de conteneurs

Ces dernières années, avec le développement rapide de la technologie, l'orchestration de conteneurs est passée de l'automatisation initiale d'un service unique à une solution complète prenant en charge des applications complexes. Par exemple, Kubernetes prend non seulement en charge le déploiement et l'expansion de base, mais fournit également un maillage de services (tel qu'Istio) pour prendre en charge les exigences complexes de communication et de sécurité entre les microservices. De plus, l'essor de GitOps utilise le référentiel Git comme source de vérité pour le déploiement d'applications, rendant l'orchestration des conteneurs plus transparente et plus facile à gérer.

Cas d’application pratiques de l’orchestration de conteneurs

Dans les applications pratiques, l’orchestration de conteneurs est devenue la pierre angulaire de nombreux projets réussis. Par exemple, la plate-forme de conteneurisation de Netflix, Spinnaker, utilise la technologie d'orchestration de conteneurs pour prendre en charge son énorme architecture de microservices, permettant ainsi un déploiement rapide des services et une gestion efficace des ressources. Dans le domaine financier, Goldman Sachs gère son système de trading via Kubernetes, ce qui non seulement améliore la stabilité du système mais accélère également le lancement de nouvelles fonctionnalités.

2. Présentation des outils d'orchestration de conteneurs

Dans le domaine de l’orchestration de conteneurs, plusieurs outils et plateformes clés sont devenus des standards de l’industrie. Ces outils fournissent non seulement des fonctions de base de gestion de conteneurs, mais introduisent également des fonctionnalités avancées telles que la mise à l'échelle automatique, la découverte de services et les capacités d'auto-réparation. Nous explorerons certains des outils les plus importants : Docker Compose, Kubernetes et Docker Swarm, et comprendrons leurs concepts de base, leurs fonctionnalités et leurs scénarios applicables.

Docker Composer

Docker Compose est un outil permettant de définir et d'exécuter des applications Docker multi-conteneurs. Grâce à Compose, les utilisateurs peuvent utiliser des fichiers YAML pour configurer les services d'application. Ensuite, tous les services peuvent être créés et démarrés avec une simple commande. Docker Compose est particulièrement adapté aux environnements de développement et aux petits projets car il simplifie le processus de création et de gestion d'applications multi-conteneurs.

Caractéristiques

- Facile à utiliser : Gérez l'ensemble des services de l'application via un fichier YAML.

- Adapté au développement : adapté au déploiement et aux tests rapides dans un environnement de développement.

- Léger : Aucune infrastructure supplémentaire ou configuration complexe requise.

Applications

Par exemple, une équipe de développement peut utiliser Docker Compose pour configurer son environnement de développement local, notamment des serveurs d'applications, des bases de données et des services de mise en cache. Cela permet à toute l'équipe de travailler dans un environnement cohérent, réduisant ainsi les problèmes de type « ça fonctionne uniquement sur ma machine ».

Kubernetes

Kubernetes (K8s) est actuellement le système d'orchestration de conteneurs open source le plus populaire pour le déploiement, la mise à l'échelle et la gestion automatiques d'applications conteneurisées. Développé par Google et maintenu par la Cloud Native Computing Foundation (CNCF).

Kubernetes (K8s) est actuellement le système d'orchestration de conteneurs open source le plus populaire pour le déploiement, la mise à l'échelle et la gestion automatiques d'applications conteneurisées. Développé par Google et maintenu par la Cloud Native Computing Foundation (CNCF).

Caractéristiques

- Hautement évolutif : Peut gérer des déploiements de conteneurs à grande échelle.

- Écosystème robuste : prend en charge un large éventail de types de charges de travail, la découverte de services et l'équilibrage de charge.

- Exploitation et maintenance automatisées : y compris l'expansion automatique, l'auto-réparation et les mises à jour progressives.

Applications

À l'échelle mondiale, de nombreuses grandes entreprises telles que Spotify, Huawei et IBM utilisent Kubernetes pour prendre en charge leurs environnements de production. Kubernetes améliore non seulement l'efficacité de l'exploitation et de la maintenance de ces entreprises, mais leur offre également une stabilité et une évolutivité inégalées du système.

Essaim de Dockers

Docker Swarm est l'outil natif de gestion de cluster de Docker. Il utilise l'API Docker, de sorte que les utilisateurs déjà familiers avec Docker trouveront Swarm facile à démarrer et à utiliser.

Caractéristiques

- Docker native : Fortement intégré à l'écosystème Docker.

- Simple et facile à utiliser : Pour les projets de petite à moyenne taille, Swarm offre suffisamment de fonctionnalités.

- Léger : Aucune installation supplémentaire requise, uniquement Docker.

Applications

Docker Swarm constitue une option idéale pour les équipes qui utilisent déjà Docker et qui ont besoin d'une solution plus simple pour faire évoluer leurs applications sur plusieurs hôtes. Par exemple, une petite ou moyenne entreprise peut utiliser Swarm pour gérer plusieurs de ses services sans investir davantage de ressources dans l'apprentissage et le déploiement de Kubernetes.

3. Solution complète pour Docker Compose

Docker Compose est un outil permettant de définir et d'exécuter des applications Docker multi-conteneurs. Il permet aux utilisateurs de définir de manière déclarative des services, des réseaux et des volumes à l'aide de fichiers YAML pour créer, tester et déployer facilement des applications dans un environnement Docker.

Concepts de base de Docker Compose

1.Services

- Définition : Le service est le concept de base de Docker Compose, qui représente les composants d'une application (par exemple, base de données, front-end, back-end).

- Fonctionnalités : Chaque service peut définir ses images de conteneurs, ses mappages de ports, ses montages de volumes et ses dépendances.

2. Réseau

- Définition : Compose permet de définir des réseaux pour mettre en œuvre la communication entre les conteneurs.

- Caractéristiques : Prend en charge différents types de réseaux tels que les réseaux pontés ou superposés pour garantir l'isolation et la communication sécurisée entre les conteneurs.

3. Volumes

- Définition : Les volumes sont utilisés pour la persistance et le partage des données.

- Caractéristiques : Peut être partagé par plusieurs conteneurs et utilisé pour stocker des fichiers de base de données, des fichiers de configuration, etc.

Structure du fichier Docker Compose

Les fichiers YAML sont au cœur de Docker Compose, qui définissent toutes les configurations pertinentes des services, des réseaux et des volumes.

Exemple

version: "3.9" # 使用的Compose文件版本

services:

web:

image: "my-web-app:latest" # 定义使用的镜像

ports:

- "5000:5000" # 端口映射

networks:

- webnet # 网络配置

redis:

image: "redis:alpine"

networks:

- webnet

networks:

webnet:

Fonctionnalités avancées

1. Extension du service (échelle)

- Description : Augmente ou diminue automatiquement le nombre d'instances du service.

- Objectif : mettre à l'échelle dynamiquement les instances de service pour gérer la charge pendant les périodes de trafic élevé.

2. Bilan de santé

- Description : Surveiller l'état d'exécution du service.

- Objectif : Assurer le fonctionnement normal du service et redémarrer automatiquement les instances défaillantes.

3. Variables d'environnement

- Description : Définir et gérer les variables d'environnement lorsque le service est en cours d'exécution.

- Objectif : Configurer les connexions à la base de données, les clés API et autres informations sensibles.

Docker Compose dans les applications pratiques

Dans l'architecture de microservices, Docker Compose est largement utilisé dans les environnements de développement et de test locaux. Il permet aux développeurs de répliquer localement les environnements de production, garantissant que chaque composant de l'application s'exécute dans un environnement isolé et cohérent.

Exemples d'applications

Supposons qu'une équipe développe une application Web comprenant un front-end, un back-end et une base de données. À l'aide de Docker Compose, ils peuvent définir trois services : une application Node.js pour le front-end, une API Python pour le back-end et une base de données PostgreSQL. Chaque service peut s'exécuter dans son propre conteneur dédié et communiquer entre eux sur un réseau défini. De cette manière, toute l’équipe peut travailler sous la même configuration, réduisant ainsi les problèmes causés par les différences environnementales.

Résumer

Docker Compose fournit un outil simple mais puissant pour gérer et orchestrer des applications multi-conteneurs. Sa facilité d'utilisation et sa flexibilité le rendent idéal pour les environnements de développement et de déploiement à petite échelle. En acquérant une compréhension approfondie des différentes fonctionnalités et bonnes pratiques de Compose, les équipes de développement peuvent améliorer considérablement leur efficacité de développement et la qualité de leurs applications.

4. Solution complète pour Kubernetes

Kubernetes, communément appelé K8s, est actuellement la plateforme d'orchestration de conteneurs open source la plus populaire. Il fournit un cadre robuste pour automatiser le déploiement, la mise à l'échelle et la gestion des applications conteneurisées.

Concepts de base de Kubernetes

1. Pod

- Définition : Pod est la plus petite unité déployable dans Kubernetes, contenant généralement un ou plusieurs conteneurs.

- Caractéristiques : Conteneurs dans le stockage partagé Pod, configuration réseau et en cours d'exécution.

2.Services

- Définition : Le service est une manière abstraite de définir comment accéder à un ensemble de Pods avec la même fonctionnalité.

- Caractéristiques : Assurer la stabilité de l’accès au réseau et l’équilibrage de charge.

3. Déploiement

- Définition : le déploiement fournit des fonctionnalités de mise à jour déclarative pour les pods et les ReplicaSets (collections de pods).

- Caractéristiques : Prend en charge les mises à jour progressives et la restauration de version.

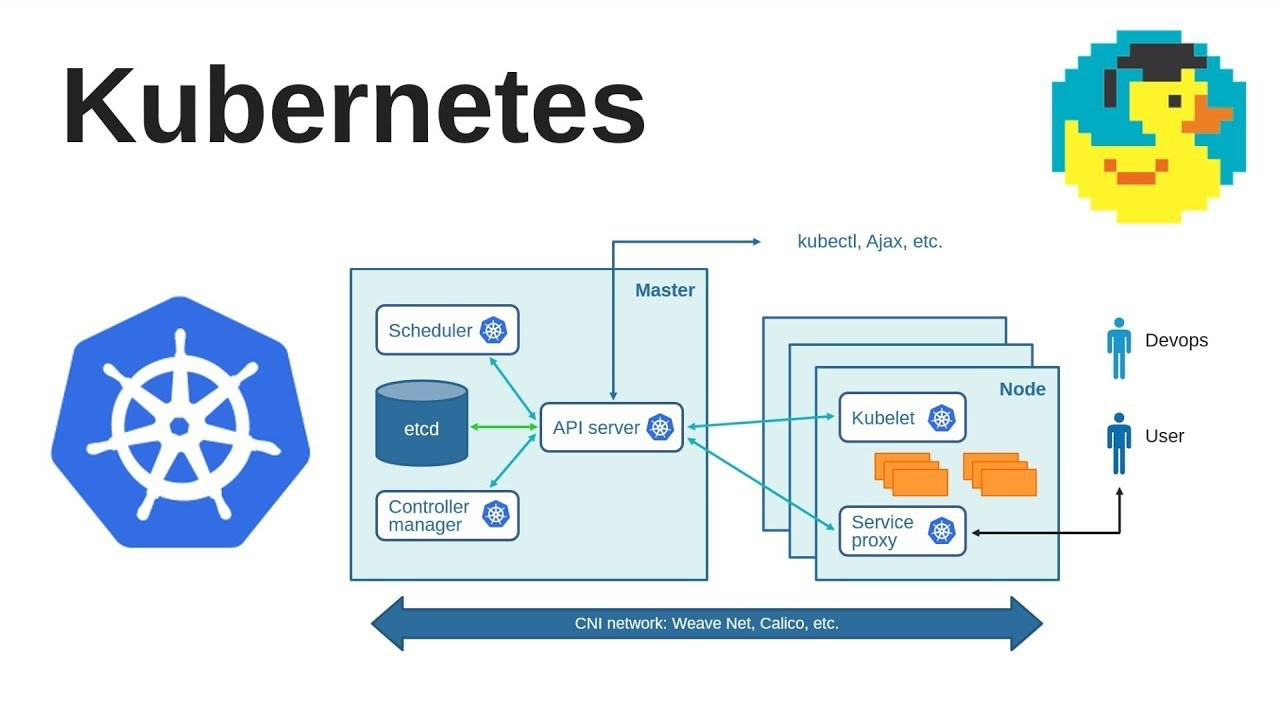

Composants architecturaux de Kubernetes

1. Plan de contrôle

- Fonction : Gérer l'état du cluster, tel que la planification, la réponse aux événements du cycle de vie du Pod, etc.

- Composants : y compris serveur API, planificateur, gestionnaire de contrôleur, etc.

2. Nœud

- Fonction : Exécuter le conteneur d'applications.

- Composants : y compris Kubelet, Kube-proxy et le runtime du conteneur.

3. Stockage

- Fonction : Fournir une solution de stockage persistante.

- Composants : prend en charge plusieurs options de stockage, telles que le stockage local, le stockage dans le cloud public, etc.

Fonctionnalités avancées de Kubernetes

1. Mise à l'échelle automatique

- Description : Augmentez ou diminuez automatiquement le nombre de pods en fonction de la charge.

- Application : garantissez les performances des applications et la rentabilité sous différentes charges.

2. Découverte de services et équilibrage de charge

- Description : Configurez automatiquement le réseau pour que les services puissent se découvrir et équilibrer la charge.

- Application : Simplifie la complexité de la communication interservices dans l'architecture microservice.

3. Déploiement et restauration automatisés

- Description : Gérez automatiquement le déploiement et la restauration des applications via une configuration déclarative.

- Application : Améliorer la fiabilité et la fréquence de déploiement et réduire le risque d'échec de déploiement.

Kubernetes dans des applications réelles

Kubernetes est devenu le standard de facto pour l'architecture des microservices. Il prend en charge les applications de toutes tailles, des petites start-ups aux grandes entreprises.

Exemples d'applications

Supposons qu'une plateforme de vente au détail en ligne doive gérer ses multiples microservices (tels que le traitement des commandes, le traitement des paiements, l'authentification des utilisateurs, etc.). À l'aide de Kubernetes, ces services peuvent être déployés en tant que pods ou déploiements indépendants et interconnectés via les services. À mesure que le nombre d’utilisateurs augmente, Kubernetes peut automatiquement faire évoluer les services pour garantir la fiabilité et les performances des applications.

Tendances futures de Kubernetes

Kubernetes continue de se développer et intègre davantage de technologies cloud natives, telles que la grille de services, l'architecture sans serveur, etc. À l'avenir, Kubernetes pourrait simplifier davantage la complexité du déploiement et de la gestion des applications, en faisant non seulement un outil d'orchestration de conteneurs, mais le cœur de l'ensemble de l'écosystème d'applications cloud natives.

5. Technologie avancée d'orchestration de conteneurs

Dans l’écosystème conteneurisé moderne, à mesure que la complexité des applications et du déploiement augmente, les technologies avancées d’orchestration de conteneurs deviennent une partie intégrante. Ces technologies améliorent non seulement l'efficacité et la flexibilité de la gestion des conteneurs, mais garantissent également la fiabilité et la sécurité du système.

la gestion du réseau

La gestion du réseau de conteneurs est un élément important pour garantir une communication correcte et sécurisée entre les conteneurs. Dans les environnements conteneurisés complexes, la gestion du réseau comprend, sans s'y limiter, les aspects suivants :

1. Modèle de réseau

- Concept : Le modèle de réseau de conteneurs définit la manière dont les conteneurs interagissent dans le réseau.

- Technologie : Tels que CNI (Container Network Interface), Flannel, Calico.

2. Maillage de services

- Concept : Service Grid gère la communication entre les microservices et fournit des fonctions telles que l'équilibrage de charge et la découverte de services.

- Technologie : Comme Istio, Linkerd.

- Application : Le maillage de services rend la communication complexe entre les microservices transparente et contrôlable.

Gestion du stockage

Dans l'orchestration de conteneurs, la gestion du stockage garantit la persistance et la cohérence des données. Les technologies avancées de gestion du stockage incluent :

1. Stockage persistant

- Concept : Fournir des solutions de stockage persistantes pour les conteneurs.

- Technologie : comme l'application de volumes persistants (PV) et de revendications de volumes persistants (PVC) dans Kubernetes.

2. Orchestration du stockage

- Concept : Gérer automatiquement l'allocation et le cycle de vie des ressources de stockage.

- Technologie : Comme Rook, Portworx.

Surveillance des conteneurs et gestion des journaux

Pour garantir la santé et les performances de votre environnement conteneurisé, la surveillance et la gestion des journaux sont essentielles.

1. Surveillance

- Concept : Surveillance en temps réel des métriques de performances des conteneurs et des clusters.

- Outils : tels que Prometheus, Grafana.

2. Gestion des journaux

- Concept : Collectez, stockez et analysez de manière centralisée les journaux des conteneurs.

- Outils : tels que ELK Stack (Elasticsearch, Logstash, Kibana), Fluentd.

Sécurité des conteneurs

La sécurité des conteneurs est un domaine de préoccupation important et croissant dans l'orchestration des conteneurs, notamment :

1. Analyse de sécurité des conteneurs

- Concept : Détection des failles de sécurité dans les images de conteneurs.

- Outils : comme Clair, Trivy.

2. Sécurité d'exécution

- Concept : Protéger les conteneurs en cours d'exécution contre les attaques.

- Outils : Tels que Falco, Sysdig.

Automatisation et gestion axée sur les politiques

La gestion automatisée et basée sur des règles de l'orchestration des conteneurs offre un niveau plus élevé de contrôle et d'efficacité.

1. Déploiement automatisé

- Technologie : comme GitOps, qui utilise le référentiel Git comme seule source de vérité pour réaliser un déploiement automatisé d'applications.

2. Gestion axée sur les politiques

- Technologie : comme OPA (Open Policy Agent), qui fournit une exécution de politique unifiée pour les environnements cloud natifs.

Suivez [TechLeadCloud] pour partager des connaissances complètes sur l'architecture Internet et la technologie des services cloud. L'auteur a plus de 10 ans d'expérience en architecture de services Internet, en recherche et développement de produits d'IA et en gestion d'équipe. Il est titulaire d'une maîtrise de l'Université Tongji de l'Université de Fudan, membre du Fudan Robot Intelligence Laboratory, architecte senior certifié par Alibaba Cloud. , un professionnel de la gestion de projet, et de la recherche et du développement de produits d'IA avec un chiffre d'affaires de plusieurs centaines de millions de dollars.

La première mise à jour majeure de JetBrains 2024 (2024.1) est open source. Même Microsoft prévoit de la payer. Pourquoi est-elle encore critiquée pour son open source ? [Récupéré] Le backend de Tencent Cloud s'est écrasé : un grand nombre d'erreurs de service et aucune donnée après la connexion à la console. L'Allemagne doit également être "contrôlable de manière indépendante". Le gouvernement de l'État a migré 30 000 PC de Windows vers Linux deepin-IDE et a finalement réussi démarrage ! Visual Studio Code 1.88 est sorti. Bon gars, Tencent a vraiment transformé Switch en une "machine d'apprentissage pensante". Le bureau à distance RustDesk démarre et reconstruit le client Web. La base de données de terminaux open source de WeChat basée sur SQLite, WCDB, a reçu une mise à niveau majeure.Si cela peut vous aider, accordez plus d'attention à TeahLead KrisChang, plus de 10 ans d'expérience dans l'industrie de l'Internet et de l'intelligence artificielle, plus de 10 ans d'expérience dans la gestion d'équipes techniques et commerciales, un baccalauréat en génie logiciel de Tongji, une maîtrise en gestion de l'ingénierie. de Fudan, architecte senior certifié Alibaba Cloud des services cloud, responsable de l'activité produits IA avec un chiffre d'affaires de plus de 100 millions.