1. Présentation de NoSQL

1. Pourquoi utiliser NoSQL ?

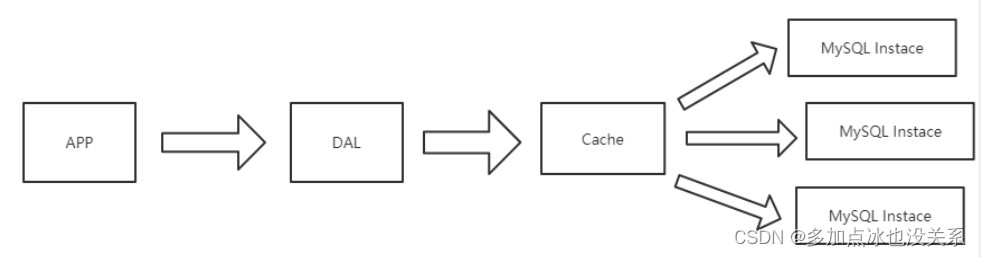

1. Le bon vieux temps de MySQL autonome

Dans les années 1990, le nombre de visites sur un site Web n’était généralement pas important, et une seule base de données pouvait facilement le gérer !

À cette époque, la plupart d’entre eux étaient des pages Web statiques et il n’existait pas beaucoup de sites Web interactifs dynamiques.

Dans le cadre de l’architecture ci-dessus, examinons quels sont les goulots d’étranglement du stockage de données ?

- La taille totale des données, lorsqu'elles ne peuvent pas tenir sur une seule machine

- L'index des données (B+ Tree) ne peut pas être stocké dans la mémoire d'une machine

- Le volume d'accès (lecture et écriture mixtes) ne peut être toléré par une seule instance

Si 1 ou 3 des conditions ci-dessus sont remplies, évoluez...

DAL : Database Access Layer

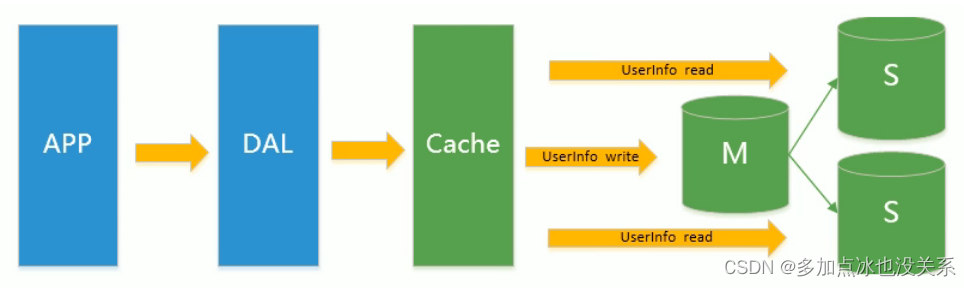

2. Memcached (cache) + MySQL + division verticale

Plus tard, à mesure que le nombre de visites augmentait, presque la plupart des sites Web utilisant l'architecture MySQL ont commencé à avoir des problèmes de performances au niveau de la base de données. Les programmes Web ne se concentraient plus uniquement sur les fonctions, mais recherchaient également les performances. Les programmeurs ont commencé à utiliser largement la technologie de mise en cache pour alléger la pression sur la base de données et optimiser la structure et l'index de la base de données. Il est devenu plus courant d'utiliser la mise en cache de fichiers pour alléger la pression sur la base de données. Cependant, lorsque le nombre de visites a continué d'augmenter , plusieurs machines Web ont commencé à utiliser la mise en cache de fichiers pour réduire la pression sur la base de données. Le cache ne peut pas être partagé et un grand nombre de petits caches de fichiers entraînent également une pression d'E/S relativement élevée. À cette époque, Memcached est naturellement devenu une technologie très à la mode produit.

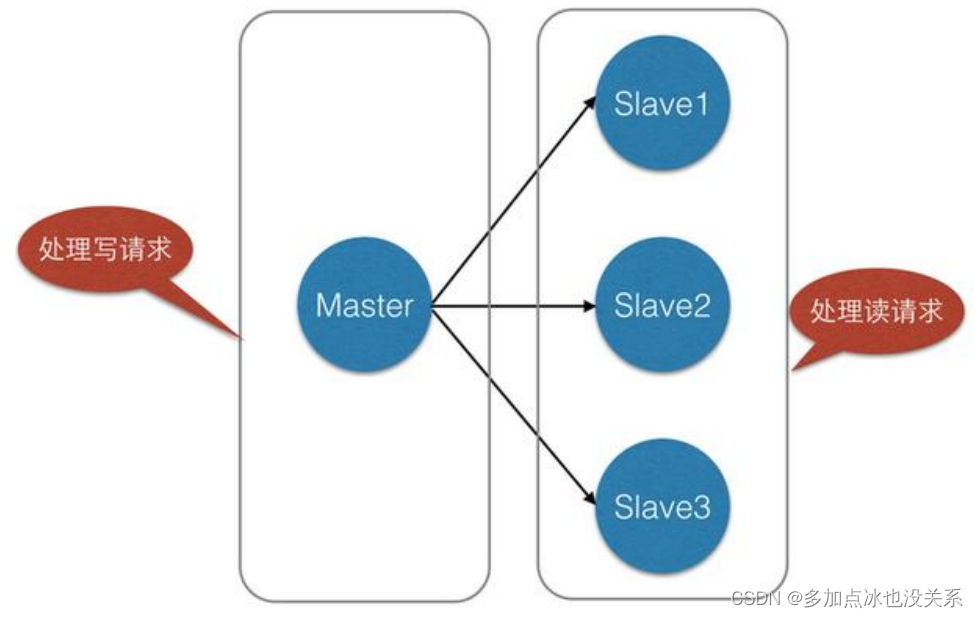

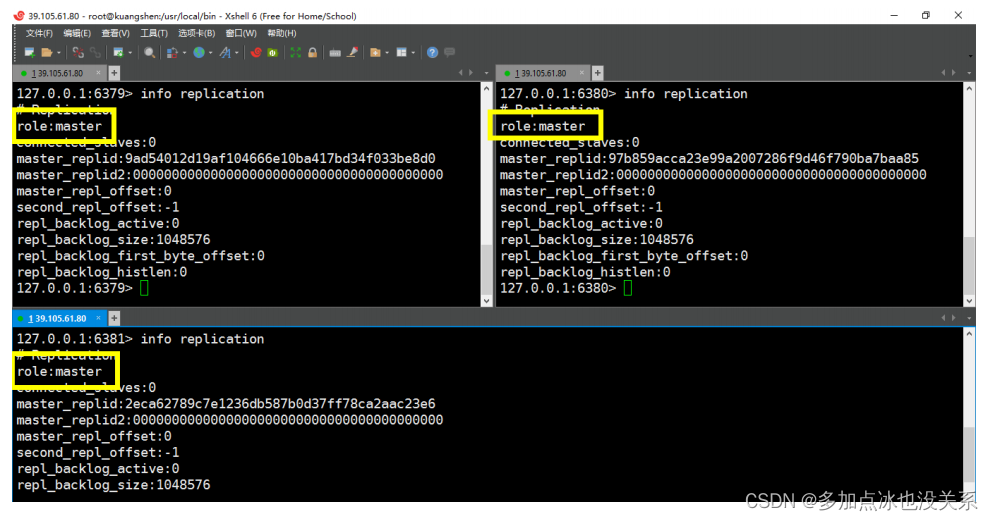

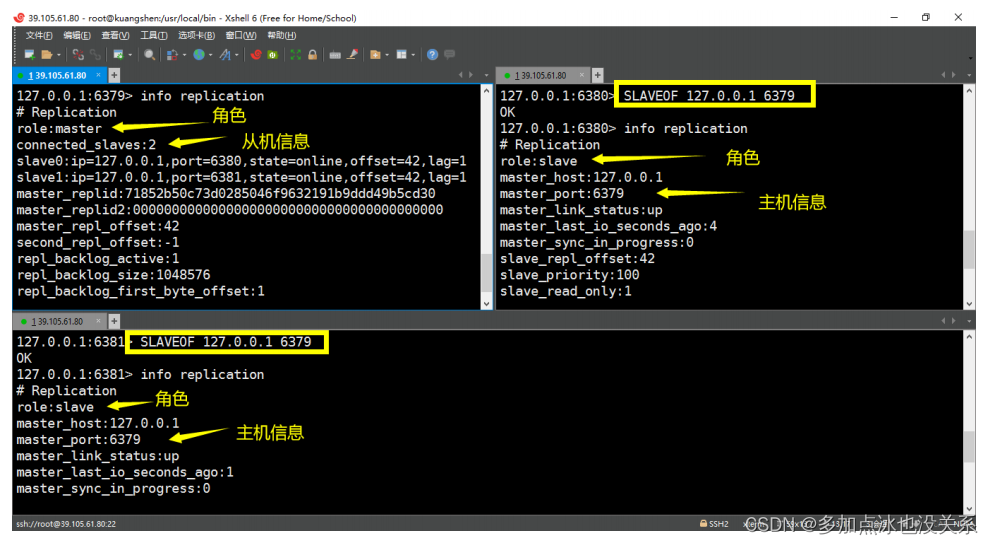

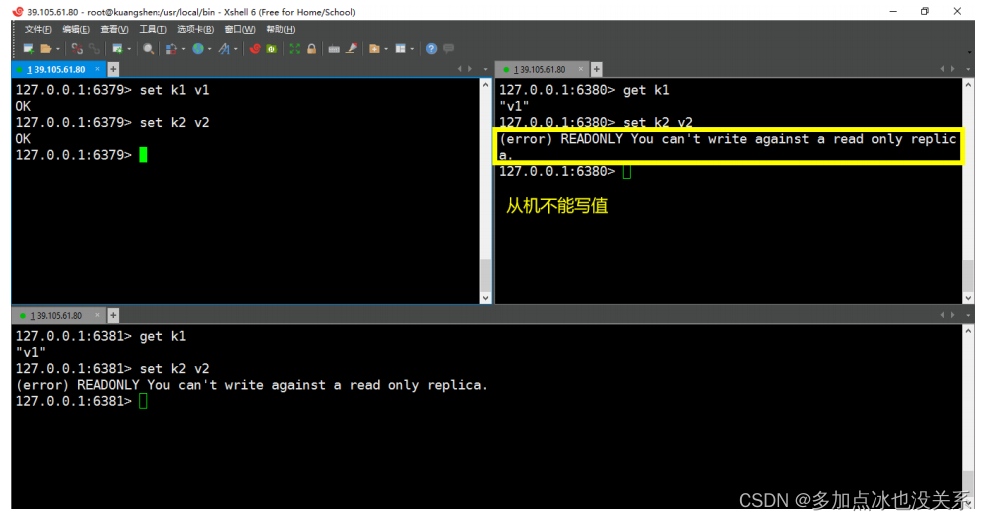

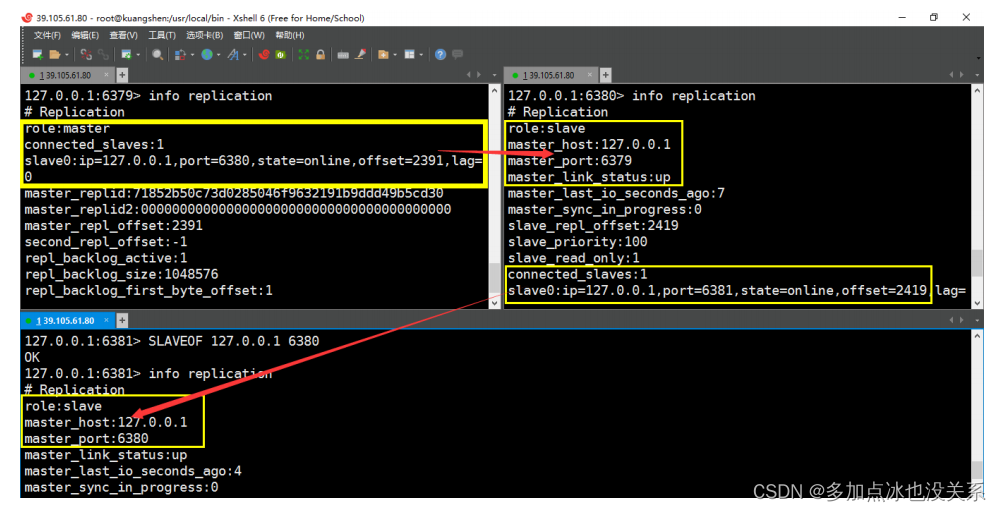

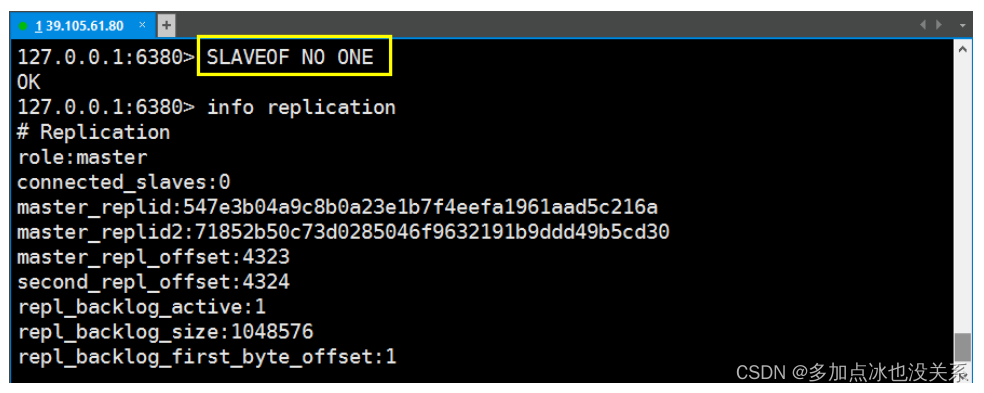

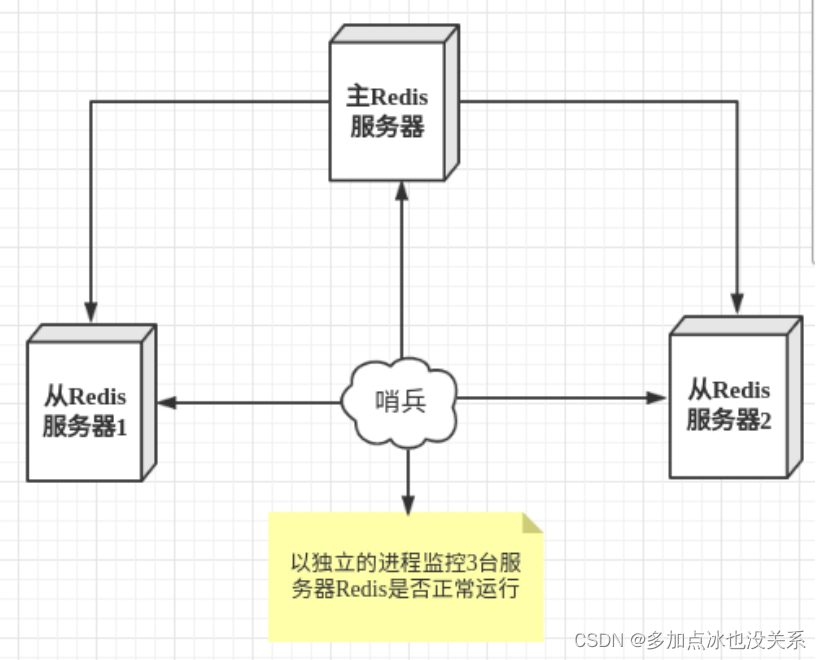

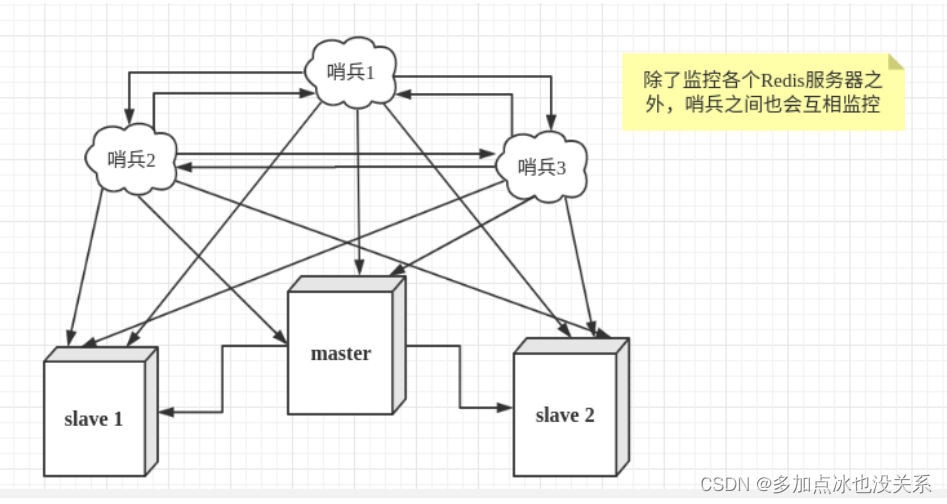

3. Séparation de lecture et d'écriture maître-esclave MySQL

À mesure que la pression d'écriture sur la base de données augmente, Memcached ne peut que soulager la pression de lecture sur la base de données. La concentration de la lecture et de l'écriture sur une seule base de données rend la base de données submergée. La plupart des sites Web ont commencé à utiliser la technologie de réplication maître-esclave pour séparer la lecture et l'écriture. pour améliorer les performances de lecture et d'écriture.Et l'évolutivité de la base de données de lecture, le mode maître-esclave de MySQL est devenu la norme pour les sites Web à l'heure actuelle.

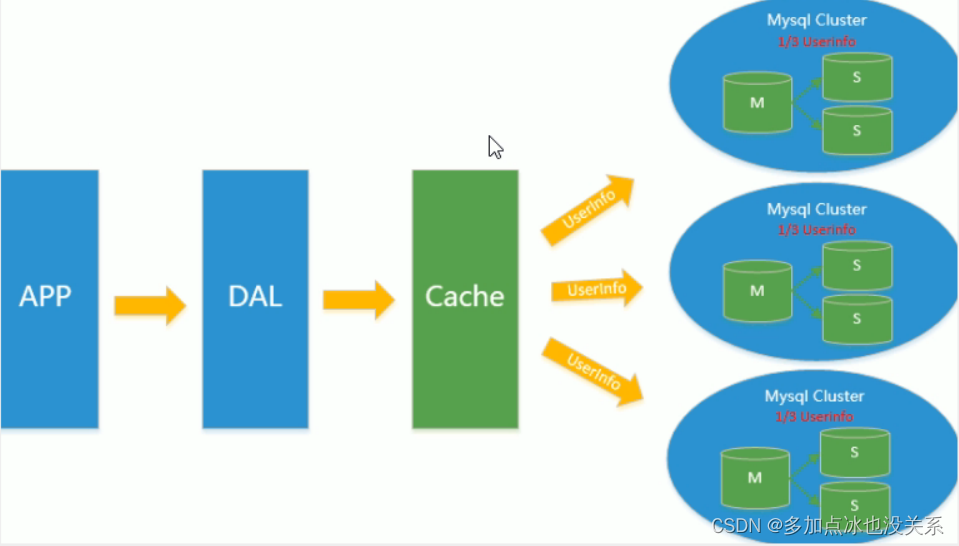

4. Sous-table et sous-base de données + division horizontale + cluster Mysql

Sur la base du cache de Memcached, de la réplication maître-esclave de MySQL et de la séparation lecture-écriture, la pression d'écriture de la base de données principale de MySQL a commencé à apparaître comme des goulots d'étranglement et la quantité de données a continué d'augmenter. Puisque MyISAM utilise des verrous de table, sous haute concurrence Verrouillage sérieux des problèmes surviendront et un grand nombre d'applications MySQL à haute concurrence commenceront à utiliser le moteur InnoDB au lieu de MyISAM.

Dans le même temps, il est devenu courant d'utiliser des sous-tableaux et des sous-bases de données pour atténuer la pression d'écriture et les problèmes d'expansion liés à la croissance des données. À cette époque, les sous-tableaux et les sous-bases de données sont devenus une technologie populaire, une question d'entrevue populaire et une question technique brûlante discutée dans l’industrie. C’est à cette époque que MySQL lance des partitions de tables pas encore stables, ce qui redonne également de l’espoir aux entreprises de force technique moyenne. Bien que MySQL ait lancé le cluster MySQL Cluster, ses performances ne peuvent pas très bien répondre aux besoins d'Internet, mais elles n'offrent qu'une très grande garantie en termes de haute fiabilité.

5. Goulot d'étranglement lié à l'évolutivité de MySQL

La base de données MySQL stocke également souvent des champs de texte volumineux, ce qui entraîne des tables de base de données très volumineuses, ce qui rend la récupération de la base de données très lente et difficile à restaurer rapidement. Par exemple, 10 millions de texte de 4 Ko correspondent à une taille proche de 40 Go. Si vous pouvez les éliminer données de MySQL, MySQL deviendra très petit. La base de données relationnelle est très puissante, mais elle ne peut pas bien gérer tous les scénarios d'application. MySQL a une faible évolutivité (nécessite une technologie complexe à mettre en œuvre) et le Big Data Pression d'E/S élevée et difficulté à changer le La structure des tables sont les problèmes rencontrés par les développeurs utilisant actuellement MySQL.

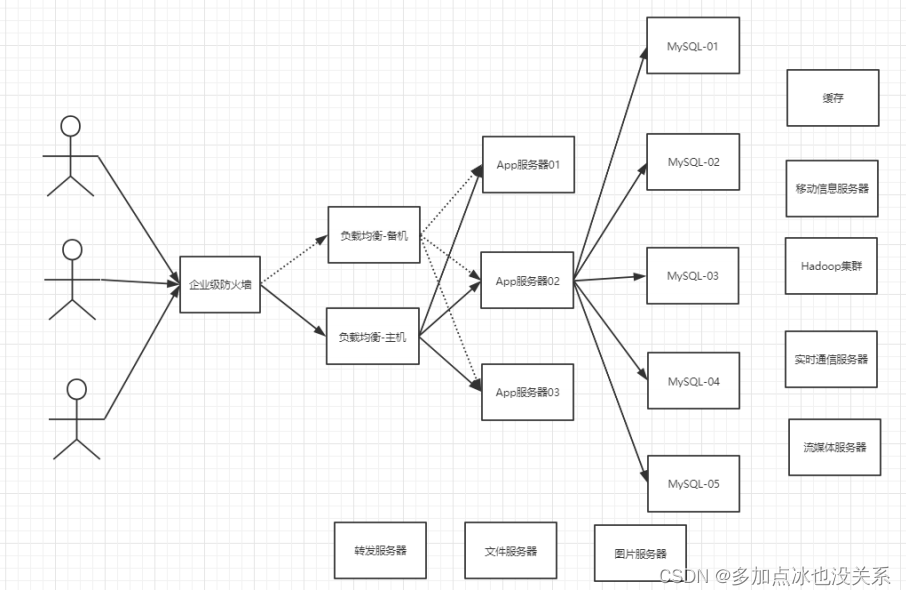

6. Comment est-ce aujourd’hui ? ?

7. Pourquoi utiliser NoSQL ?

Aujourd'hui, nous pouvons facilement accéder et capturer des données via des plateformes tierces (telles que Google, FaceBook, etc.). Les informations personnelles des utilisateurs, les réseaux sociaux, les localisations géographiques, les données générées par les utilisateurs et les journaux d'opérations des utilisateurs ont augmenté de façon exponentielle. Si l'on veut exploiter ces données utilisateur, les bases de données SQL ne sont plus adaptées à ces applications, et le développement de bases de données NoSQL Mais il peut très bien gérer ces données volumineuses !

2. Qu'est-ce que NoSQL ?

NoSQL

NoSQL = Not Only SQL, ce qui signifie : pas seulement SQL ;

Fait généralement référence aux bases de données non relationnelles. Avec l'essor des sites Web Internet Web2.0, les bases de données relationnelles traditionnelles sont devenues de plus en plus incapables de gérer les sites Web Web2.0, en particulier les sites Web purement dynamiques de type Web2.0 de services de réseaux sociaux ultra-larges et hautement concurrents. . Des capacités inadéquates ont exposé de nombreux problèmes insurmontables. Les bases de données non relationnelles se sont développées très rapidement en raison de leurs propres caractéristiques. Les bases de données NoSQL ont été créées pour résoudre les défis posés par les collectes de données à grande échelle et les multiples types de données, en particulier. Il s'agit d'une application Big Data. problème, notamment le stockage de données à très grande échelle.

(Google ou Facebook, par exemple, collectent chaque jour des milliards de données sur leurs utilisateurs). Ces types de magasins de données ne nécessitent pas de schéma fixe et peuvent évoluer sans opérations redondantes.

Caractéristiques de NoSQL

1. Facile à étendre

Il existe de nombreux types de bases de données NoSQL, mais une caractéristique commune est qu'elles suppriment les caractéristiques relationnelles des bases de données relationnelles.

Il n’y a aucune relation entre les données, elles sont donc très faciles à étendre et apportent également une évolutivité au niveau architectural.

2. Hautes performances pour les gros volumes de données

Les bases de données NoSQL ont des performances de lecture et d'écriture très élevées, en particulier lorsqu'elles traitent de grandes quantités de données. Cela est dû à sa nature non relationnelle et à la structure simple de la base de données.

Généralement, MySQL utilise le cache de requêtes, et le cache devient invalide à chaque fois que la table est mise à jour. C'est un cache très puissant. Dans les applications interactives fréquentes du Web2.0, les performances du cache ne sont pas élevées, tandis que le cache NoSQL est enregistrable. niveau, qui est une sorte de cache à granularité fine, donc NoSQL a des performances beaucoup plus élevées à ce niveau.

Record officiel : Redis peut écrire 80 000 fois et lire 110 000 fois par seconde !

3. Modèles de données diversifiés et flexibles

NoSQL n'a pas besoin de créer des champs pour les données à stocker à l'avance et peut stocker des formats de données personnalisés à tout moment. Dans les bases de données relationnelles, l'ajout et la suppression de champs sont une question très gênante. S’il s’agit d’une table contenant une très grande quantité de données, ajouter des champs est tout simplement un cauchemar.

4. SGBDR traditionnel VS NoSQL

传统的关系型数据库 RDBMS

- 高度组织化结构化数据

- 结构化查询语言(SQL)

- 数据和关系都存储在单独的表中

- 数据操纵语言,数据定义语言

- 严格的一致性

- 基础事务

NoSQL

- 代表着不仅仅是SQL

- 没有声明性查询语言

- 没有预定义的模式

- 键值对存储,列存储,文档存储,图形数据库

- 最终一致性,而非ACID属性

- 非结构化和不可预知的数据

- CAP定理

- 高性能,高可用性 和 可伸缩性

Expansion : 3V+3 haut

3V à l’ère du big data : principalement la description du problème

- Volume massif

- Variété

- Vitesse en temps réel

Top 3 des exigences Internet : principalement les exigences pour les programmes

- Haute concurrence

- La haute disponibilité

- haute performance

Les applications d'aujourd'hui utilisent SQL et NoSQL ensemble. Il n'y a pas de différence technologique, cela dépend simplement de la façon dont vous l'utilisez, n'est-ce pas ?

3. Analyse d'application classique

Parlons de la façon de stocker les informations sur les produits sur le site Web chinois d’Alibaba, en prenant comme exemple les vêtements et les sacs pour femmes :

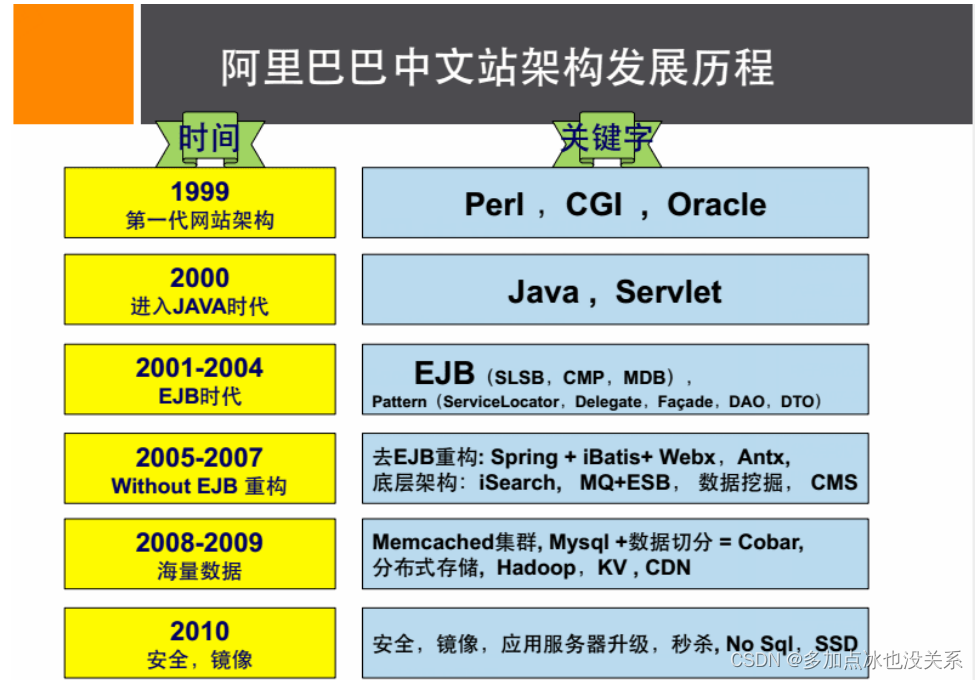

Parlons de l'histoire du développement de l'architecture : Livre recommandé « Dix ans de technologie Taobao »

1. Processus d'évolution : Source des images suivantes : Pratique de conception d'architecture de site Web chinois d'Alibaba

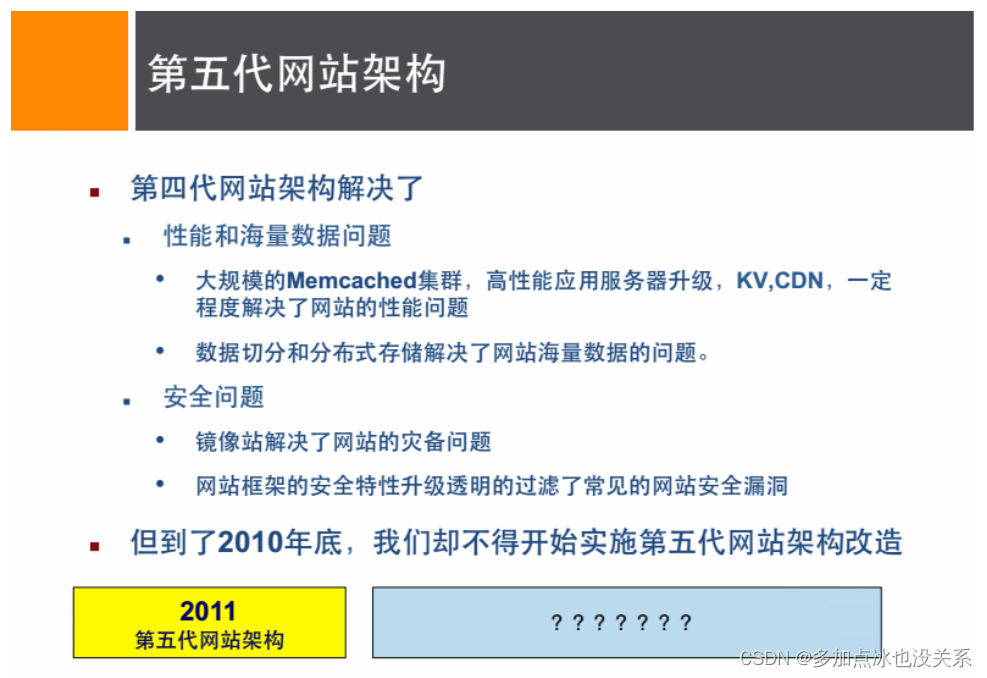

2. Cinquième génération

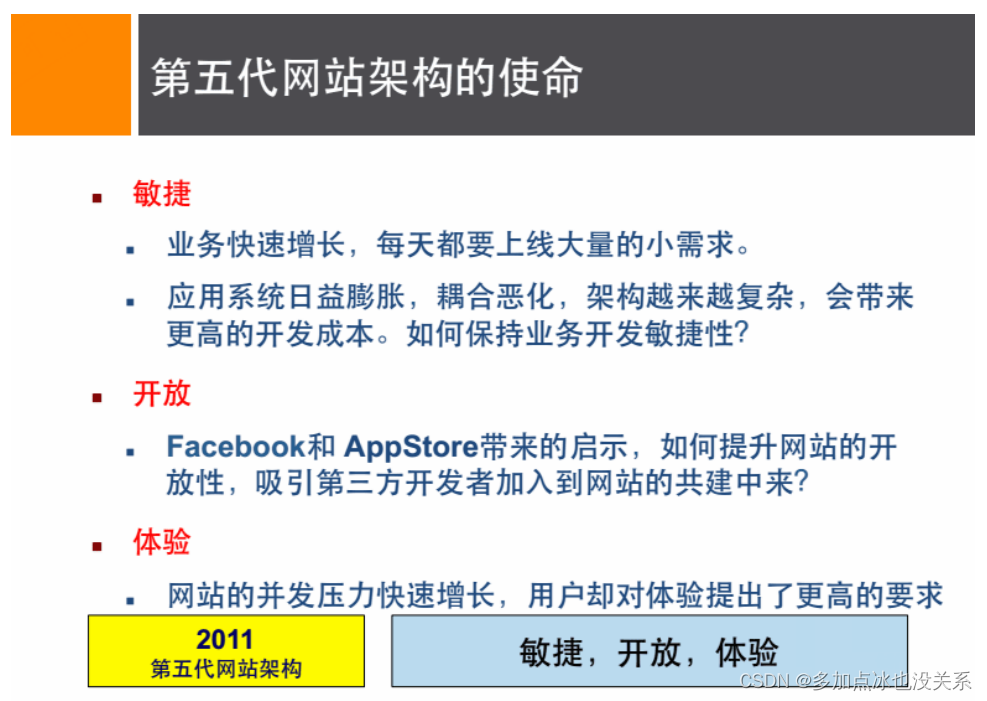

3. Mission de l'architecture de 5ème génération

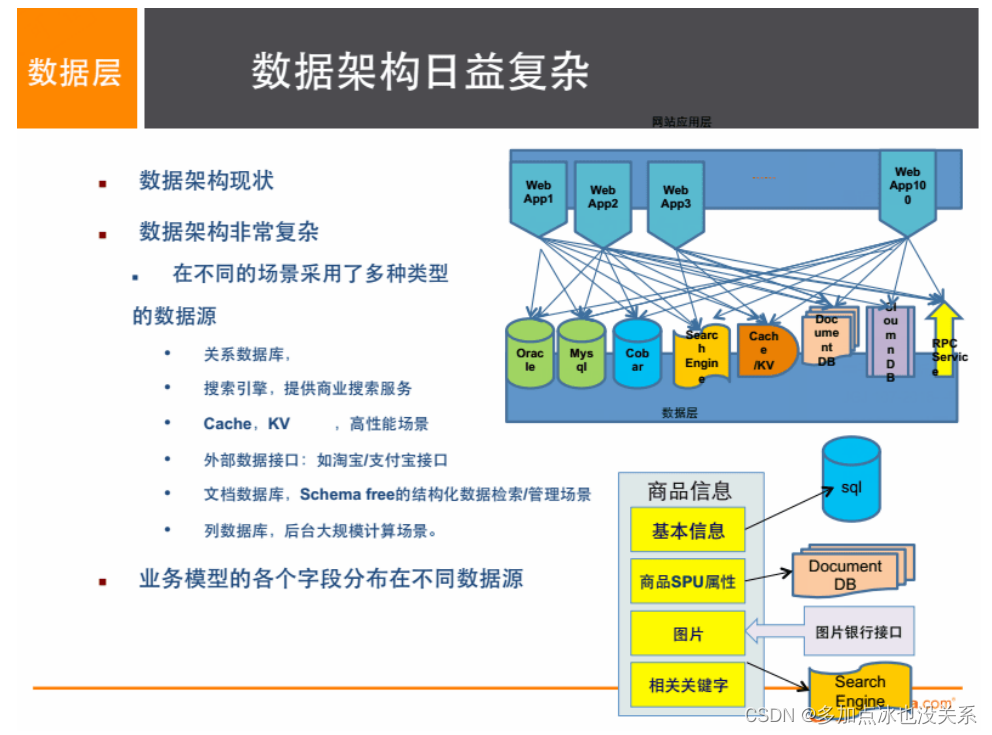

En rapport avec nous, problèmes de stockage de plusieurs sources de données et de plusieurs types de données

1. Informations de base du produit

名称、价格、出厂日期、生产厂商等

关系型数据库:mysql、oracle目前淘宝在去O化(也即,拿掉Oracle)

注意,淘宝内部用的MySQL是里面的大牛自己改造过的。

为什么去IOE:

2008年,王坚博士加入阿里巴巴,成为首席架构师。把云计算植入阿里IT基因。

2013年5月17日,阿里集团最后一台IBM小机在支付宝下线。这是自2009年“去IOE”战略透露以来,“去

IOE”非常重要的一个节点。“去 IOE”指的是摆脱掉IT部署中原有的IBM小型机、Oracle数据库以及EMC

存储的过度依赖。告别最后一台小机,意味着整个阿里集团尽管还有一些Oracle数据库和EMC存储,但是

IBM小型机已全部被替换。2013年7月10日,淘宝重中之重的广告系统使用的Oracle数据库下线,也是整

个淘宝最后一个 Oracle数据库。这两件事合在一起是阿里巴巴技术发展过程中的一个重要里程碑。

2. Description du produit, détails et informations d'évaluation (multitexte)

多文字信息描述类,IO读写性能变差

存在文档数据库MongDB中

3. Photos du produit

商品图片展现类

分布式文件系统中

- 淘宝自己的 TFS

- Google的 GFS

- Hadoop的 HDFS

4. Mots-clés du produit

搜索引擎,淘宝内用

ISearch:多隆一高兴一个人开发的

所有牛逼的人在牛逼之前,肯定有一段苦逼的岁月,但只要像傻逼一样的坚持,一定终将牛逼

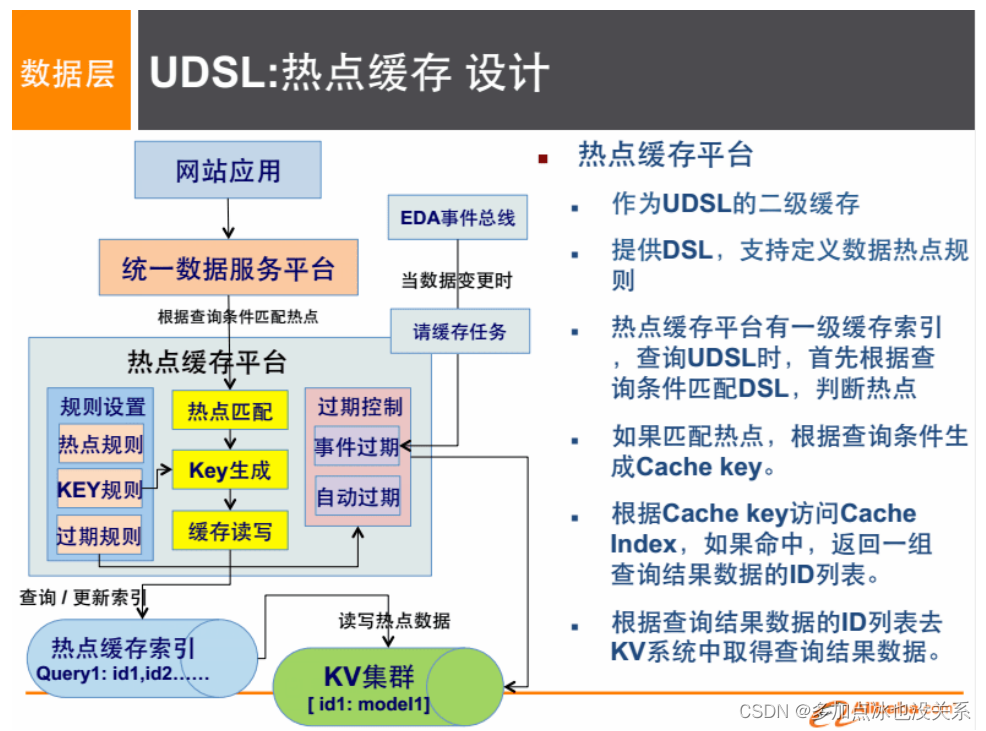

5. Hotspot et informations à haute fréquence sur les matières premières

内存数据库

Tair、Redis、Memcache等

6. Transactions sur matières premières, calcul des prix et accumulation de points !

外部系统,外部第三方支付接口

支付宝

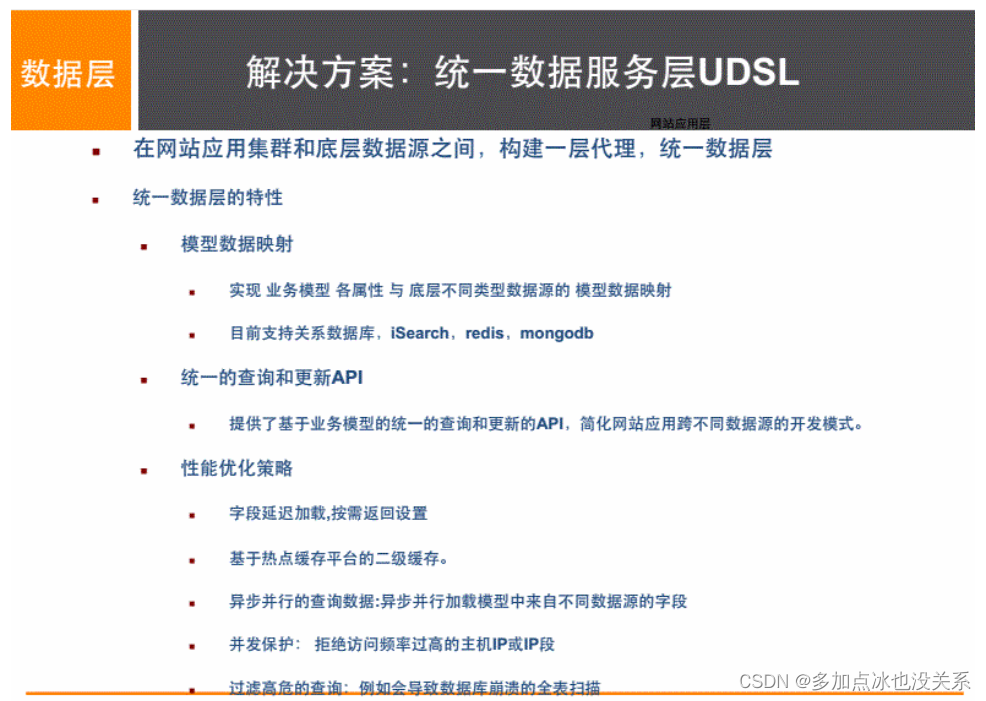

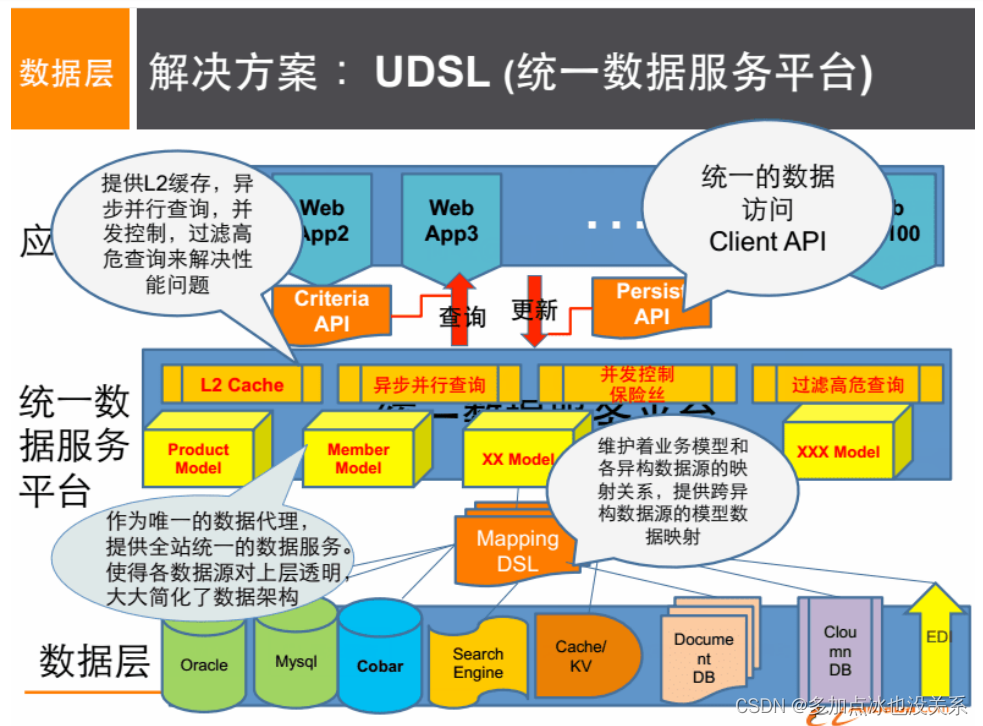

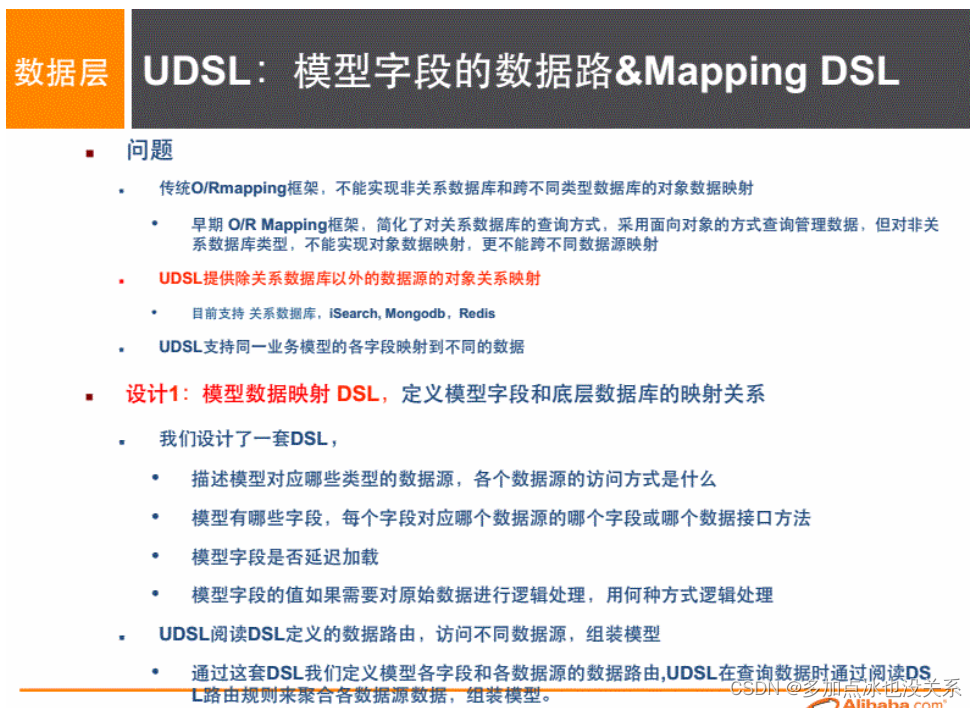

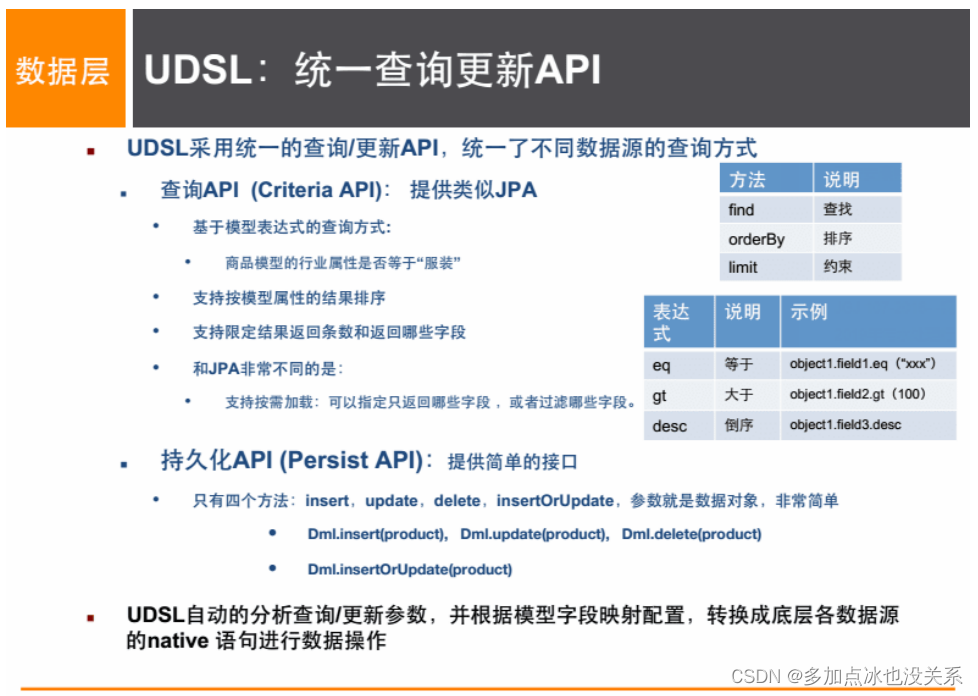

Difficultés et solutions pour les applications Internet à grande échelle (big data, haute concurrence, divers types de données)

difficulté:

- Diversité des types de données

- Diversité des sources de données et reconstruction des changements

- Les sources de données sont transformées et la plateforme de services de données ne nécessite pas de reconstruction approfondie.

Solution:

4. Introduction au modèle de données NoSQL

Conception du boîtier

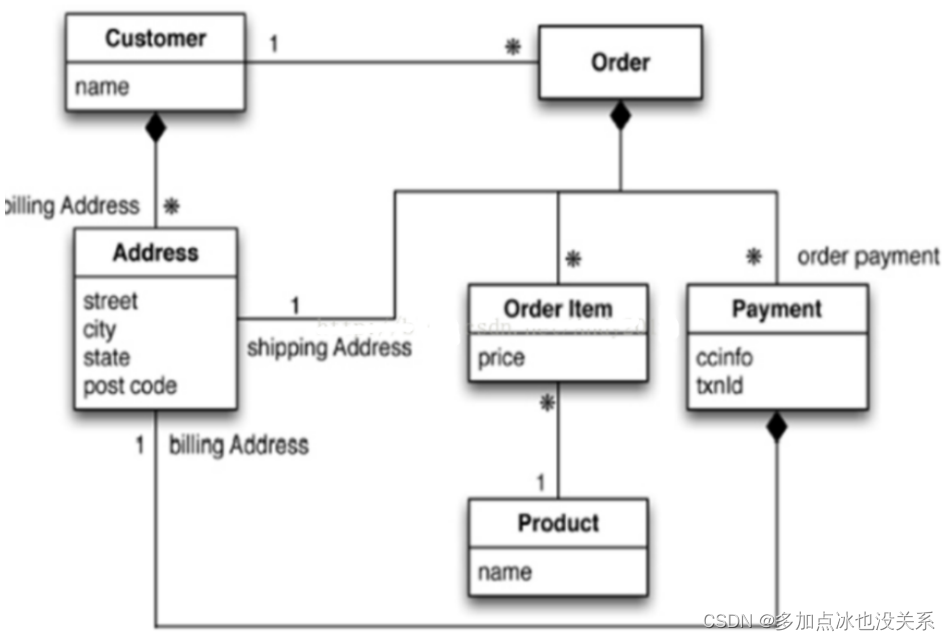

Utiliser un modèle de client, de commande, de commande et d'adresse de commerce électronique pour comparer les bases de données relationnelles et les bases de données non relationnelles

Comment concevoir une base de données relationnelle traditionnelle ?

Diagramme ER (1:1/1:N/N:N, les clés primaires et étrangères, etc. sont communes)

- L'utilisateur correspond à plusieurs commandes et plusieurs adresses

- Chaque commande correspond à chaque produit, prix et adresse

- Produits correspondant à chaque article

Chat : analyse du portrait d'utilisateur, le cœur des femmes est difficile à comprendre. J'ai regardé les vêtements et les rasoirs pour hommes, et sur la base de ses informations, j'ai découvert que l'anniversaire de son petit ami était très récent. Le portrait d'arrière-plan a été analysé et prêt à diffuser des publicités. , mais elle a acheté, j'ai pris une collation et je suis parti~

Les programmeurs nés dans les années 1990 changent vraiment la vie petit à petit. Si vous avez la chance d'entrer dans une grande usine, vous constaterez que les amis autour de vous travaillent dur. Ce sont vraiment le genre de personnes qui peuvent manger là-bas. Haidilao. Les gens qui sortent soudainement leurs cahiers et écrivent du code en mangeant sont considérés comme fous par les autres, mais eux seuls comprennent. C'est l'obsession de la technologie

Comment concevoir NoSQL

Vous pouvez essayer d'utiliser BSON .

BSON est un format de stockage binaire similaire à JSON, appelé Binary JSON. Comme JSON, il prend en charge les objets de document intégrés et les objets de tableau.

Utilisez BSON pour dessiner le modèle de données construit

{

"customer":{

"id":1000,

"name":"Z3",

"billingAddress":[{

"city":"beijing"}],

"orders":[

{

"id":17,

"customerId":1000,

"orderItems":[{

"productId":27,"price":77.5,"productName":"thinking in

java"}],

"shippingAddress":[{

"city":"beijing"}]

"orderPayment":[{

"ccinfo":"111-222-

333","txnid":"asdfadcd334","billingAddress":{"city":"beijing"}}],

}

]

}

}

Pensez à la base de données de modèles relationnels, comment la vérifiez-vous ? Si nous suivons notre nouveau BSON, il sera très simple à interroger.

- Les requêtes associées ne sont pas recommandées pour les opérations hautement concurrentes. Les sociétés Internet utilisent des données redondantes pour éviter les requêtes associées.

- Les transactions distribuées ne peuvent pas prendre en charge trop de concurrence.

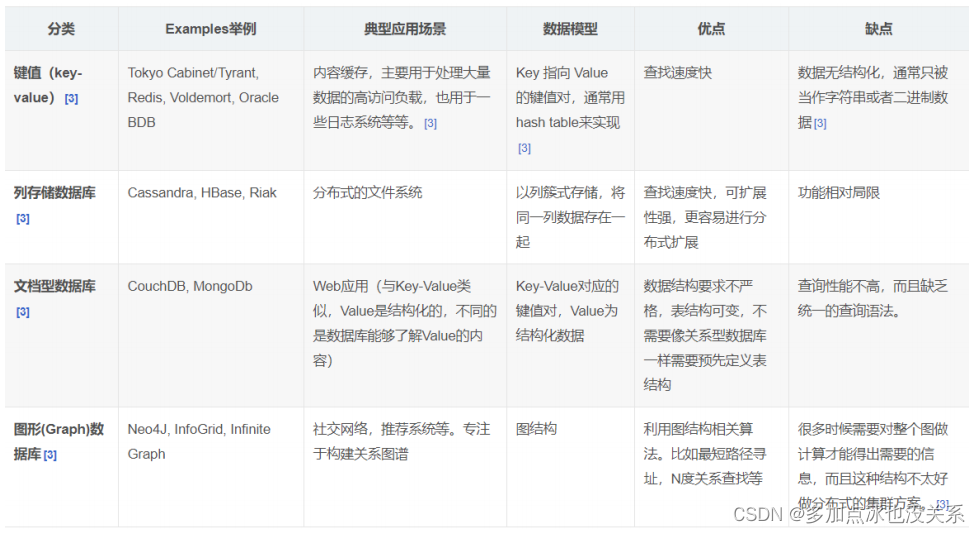

5. Quatre grandes catégories de NoSQL

Valeur clé KV :

- Sina : BerkeleyDB+redis

- Meituan : redis+tair

- Alibaba, Baidu : memcache+redis

Base de documents (plus de format bson) :

- CouchDB

- MongoDB

- MongoDB est une base de données basée sur le stockage de fichiers distribués. Écrit en langage C++. Conçu pour fournir des solutions de stockage de données évolutives et performantes pour les applications WEB.

- MongoDB est un produit entre une base de données relationnelle et une base de données non relationnelle. C'est la base de données non relationnelle la plus riche en fonctionnalités et ressemble le plus à une base de données relationnelle.

Base de données du magasin de colonnes :

- Cassandra, HBase

- Système de fichiers distribué

base de données relationnelle graphique

- Il ne s'agit pas de graphiques, mais de relations, telles que : cercle d'amis, réseau social, système de recommandation publicitaire.

- Réseaux sociaux, systèmes de recommandation, etc. Concentrez-vous sur la création de graphiques relationnels

- Neo4J, InfoGrille

Comparaison des quatre

6、CAP + BASE

Quels sont les ACID traditionnels ?

Les bases de données relationnelles suivent les règles ACID. Les transactions en anglais sont très similaires aux transactions du monde réel. Elles présentent les quatre caractéristiques suivantes :

- A (Atomicité) atomicité

原子性很容易理解,也就是说事务里的所有操作要么全部做完,要么都不做,事务成功的条件是事务

里的所有操作都成功,只要有一个操作失败,整个事务就失败,需要回滚。

比如银行转账,从A账户转100元至B账户,分为两个步骤:

1)从A账户取100元;

2)存入100元至B账户。

这两步要么一起完成,要么一起不完成,如果只完成第一步,第二步失败,钱会莫名其妙少了100

元。

- C (Cohérence) Cohérence

事务前后数据的完整性必须保持一致。

- I (Isolement) isolement

所谓的独立性是指并发的事务之间不会互相影响,如果一个事务要访问的数据正在被另外一个事务修

改,只要另外一个事务未提交,它所访问的数据就不受未提交事务的影响。比如现有有个交易是从A

账户转100元至B账户,在这个交易还未完成的情况下,如果此时B查询自己的账户,是看不到新增加

的100元的

- D (Durabilité) Durabilité

持久性是指一旦事务提交后,它所做的修改将会永久的保存在数据库上,即使出现宕机也不会丢失。

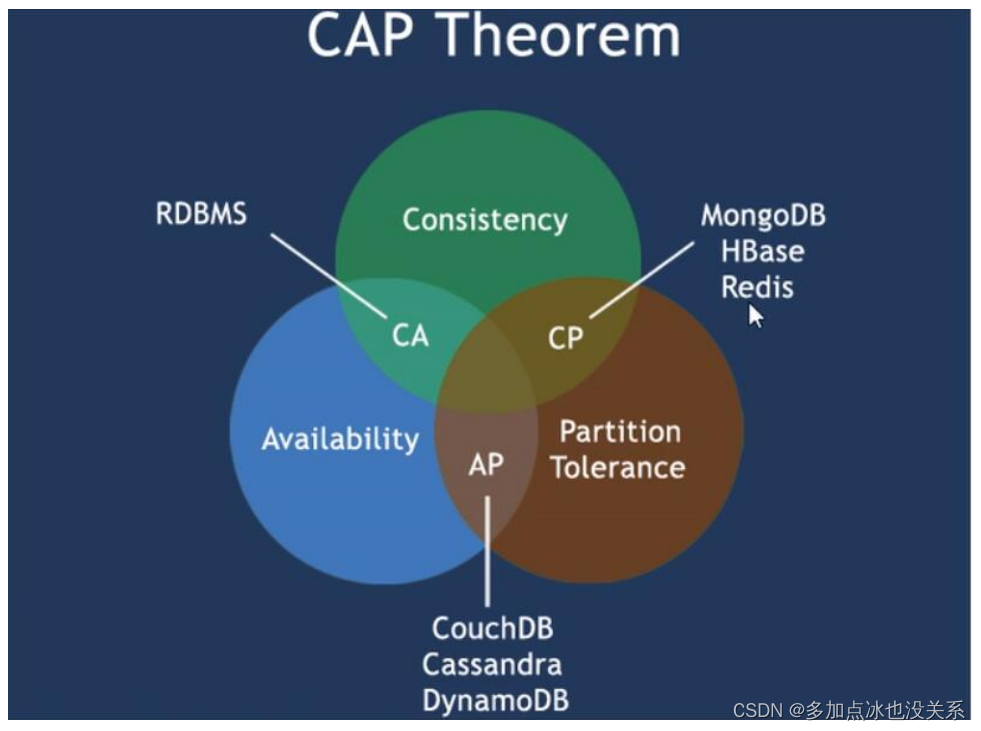

CAP (trois en deux)

- C : Cohérence (forte cohérence)

- R : Disponibilité

- P : tolérance de partition (tolérance aux pannes de partition)

La théorie CAP signifie que dans un système de stockage distribué, au maximum les deux points ci-dessus ne peuvent être atteints.

Étant donné que le matériel réseau actuel aura certainement des problèmes tels qu'une perte de paquets retardée, la tolérance aux pannes de partition est ce que nous devons atteindre .

On ne peut donc faire qu’un compromis entre cohérence et disponibilité : aucun système NoSQL ne peut garantir ces trois points à la fois.

Remarque : des compromis doivent être faits lors de la conception d'une architecture distribuée.

Trouvez un équilibre entre cohérence et disponibilité. La plupart des applications Web ne nécessitent pas réellement une forte cohérence.

Par conséquent, C est sacrifié au profit de P. C’est la direction actuelle des produits de bases de données distribuées.

Le choix entre cohérence et disponibilité

Pour les sites web web2.0, bon nombre des principales fonctionnalités des bases de données relationnelles sont souvent inutiles.

Exigences de cohérence des transactions de base de données

De nombreux systèmes Web en temps réel ne nécessitent pas de transactions de base de données strictes et ont des exigences très faibles en matière de cohérence en lecture. Dans certains cas, les exigences en matière de cohérence en écriture ne sont pas élevées. Permet une cohérence éventuelle.

Exigences d'écriture et de lecture en temps réel de la base de données

Pour les bases de données relationnelles, si vous interrogez une donnée immédiatement après l'avoir insérée, vous pouvez certainement lire les données. Cependant, pour de nombreuses applications Web, des performances en temps réel aussi élevées ne sont pas requises. Par exemple, après l'envoi d'un message, après un quelques secondes, il est tout à fait acceptable que mes abonnés voient cette mise à jour seulement dix secondes plus tard.

Demande de requêtes SQL complexes, en particulier les requêtes liées à plusieurs tables

Tout système Web contenant une grande quantité de données est très tabou en ce qui concerne les requêtes de corrélation de plusieurs grandes tables, ainsi que les requêtes de rapports complexes de type analyse de données, en particulier les sites Web de type SNS. Cette situation peut être évitée du point de vue des exigences et de la conception du produit. . Souvent, il n'y a que des requêtes de clé primaire d'une seule table et de simples requêtes de pagination conditionnelles d'une seule table. La fonction de SQL est considérablement affaiblie.

Le cœur de la théorie CAP est le suivant : un système distribué ne peut pas satisfaire simultanément aux trois exigences de cohérence, de disponibilité et de tolérance aux pannes de partition, il ne peut en satisfaire que deux à la fois. Ainsi, selon le principe CAP, les bases de données NoSQL sont divisées en trois catégories : satisfaisant le principe CA, satisfaisant le principe CP et satisfaisant le principe AP :

- CA - Cluster monopoint, système qui allie cohérence et disponibilité, généralement peu puissant en évolutivité.

- CP - Un système qui satisfait à la cohérence et doit tolérer les partitions, mais qui ne fonctionne généralement pas particulièrement bien.

- AP - Un système qui répond à la disponibilité, à la tolérance de partition et peut généralement avoir des exigences de cohérence inférieures.

Théorie BASE

La théorie BASE a été proposée par les architectes d'eBay. BASE est le résultat d'un compromis entre cohérence et disponibilité dans le CAP, il est issu de la synthèse de la pratique des systèmes distribués Internet à grande échelle et évolue progressivement sur la base de la loi CAP. L'idée centrale est que même si une forte cohérence ne peut être obtenue, chaque application peut adopter des méthodes appropriées en fonction de ses propres caractéristiques commerciales pour que le système atteigne la cohérence finale.

BASE est une solution proposée pour résoudre les problèmes causés par la forte cohérence des bases de données relationnelles et la disponibilité réduite.

BASE est en fait l'abréviation des trois termes suivants :

- Fondamentalement disponible : fondamentalement disponible signifie que le système distribué est autorisé à perdre une partie de sa disponibilité en cas de panne, c'est-à-dire que la disponibilité du cœur est garantie. Lors des promotions de commerce électronique, afin de faire face à l'augmentation du trafic, certains utilisateurs peuvent être dirigés vers la page de rétrogradation, et la couche de service ne peut fournir que des services de rétrogradation. Cela reflète la perte d’une certaine disponibilité.

- État souple : l'état souple fait référence au fait de permettre au système d'exister dans un état intermédiaire sans affecter la disponibilité globale du système. Dans le stockage distribué, une donnée comporte généralement au moins trois copies. Le délai qui permet la synchronisation des copies entre les différents nœuds est l'incarnation de l'état logiciel. La réplication asynchrone de MySQL Replication en est également une manifestation.

- Cohérence éventuelle : la cohérence finale signifie que toutes les copies de données dans le système peuvent éventuellement atteindre un état cohérent après une certaine période de temps. Une consistance faible est à l’opposé d’une consistance forte. La consistance finale est un cas particulier de consistance faible.

Son idée est d'améliorer l'évolutivité et les performances globales du système en permettant au système d'assouplir ses exigences en matière de cohérence des données à un moment donné. Pourquoi disons-nous cela ? La raison en est que les grands systèmes ne peuvent souvent pas utiliser des transactions distribuées pour compléter ces indicateurs en raison de la répartition géographique et des exigences de performance extrêmement élevées. Pour obtenir ces indicateurs, nous devons utiliser une autre façon de les compléter. Voici BASE C'est le solution à ce problème !

expliquer:

1. Distribué : Différents modules de services (projets) sont déployés sur plusieurs serveurs. Ils communiquent et appellent via Rpc pour fournir des services externes et collaborer au sein du groupe.

2. Cluster : le même module de service est déployé sur plusieurs serveurs différents et la planification unifiée est effectuée via un logiciel de planification distribué pour fournir

des services et un accès externes.

2. Démarrer avec Redis

1. Vue d'ensemble

Qu'est-ce que Redis

Redis : REmote DIctionary Server (serveur de dictionnaire distant)

Il est entièrement open source et gratuit. Il est écrit en langage C et est conforme au protocole BSD. Il s'agit d'une base de données à mémoire distribuée hautes performances (Clé/Valeur) qui s'exécute en fonction de la mémoire et prend en charge les bases de données NoSQL persistantes. C'est actuellement le base de données NoSQL la plus populaire. One, également connue sous le nom de serveur de structure de données

Redis et d'autres produits de mise en cache clé-valeur présentent les trois caractéristiques suivantes :

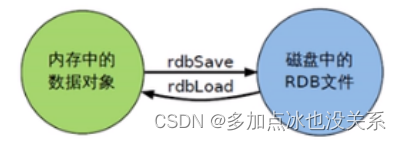

- Redis prend en charge la persistance des données, qui peut conserver les données en mémoire sur le disque et peut être rechargée pour être utilisée lors du redémarrage.

- Redis prend non seulement en charge les données de type clé-valeur simples, mais fournit également le stockage de structures de données telles que liste, ensemble, zset et hachage.

- Redis prend en charge la sauvegarde des données, c'est-à-dire la sauvegarde des données en mode maître-esclave.

Que peut faire Redis ?

Stockage mémoire et persistance : Redis prend en charge l'écriture asynchrone de données en mémoire sur le disque dur sans affecter la continuité du service.

L'opération de prise des N dernières données, par exemple : vous pouvez mettre les ID des 10 derniers commentaires dans la collection Redis List

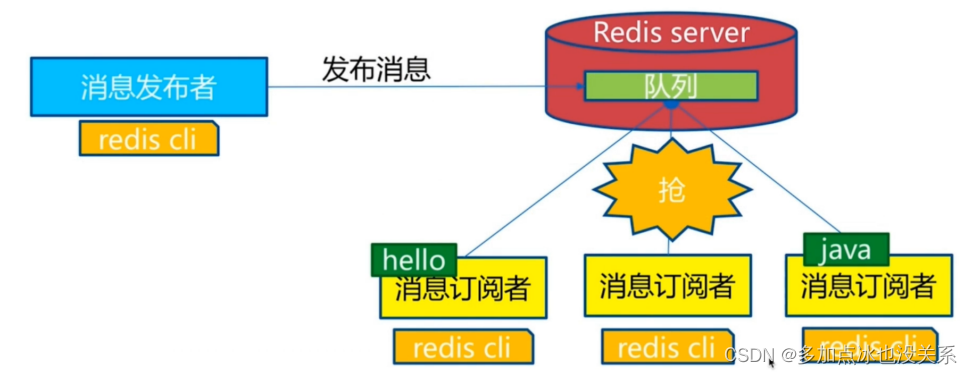

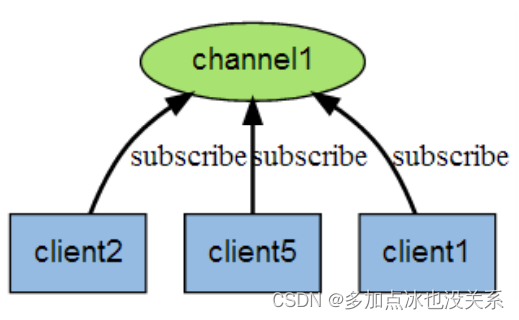

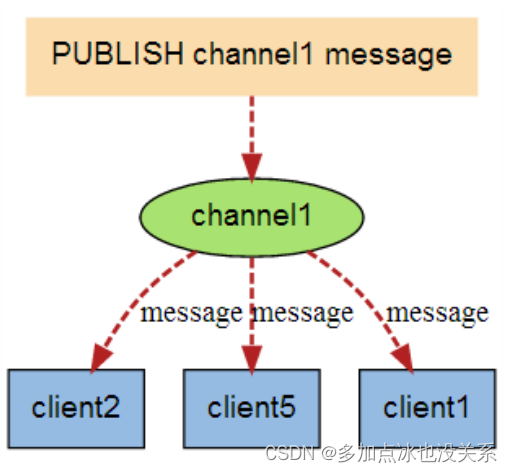

Système de messages de publication et d'abonnement

Analyse des informations cartographiques

minuterie, compteur

…

caractéristique

Types de données, opérations de base et configuration

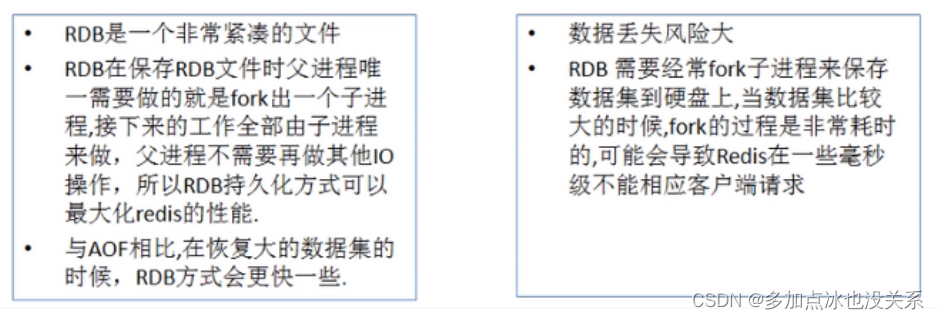

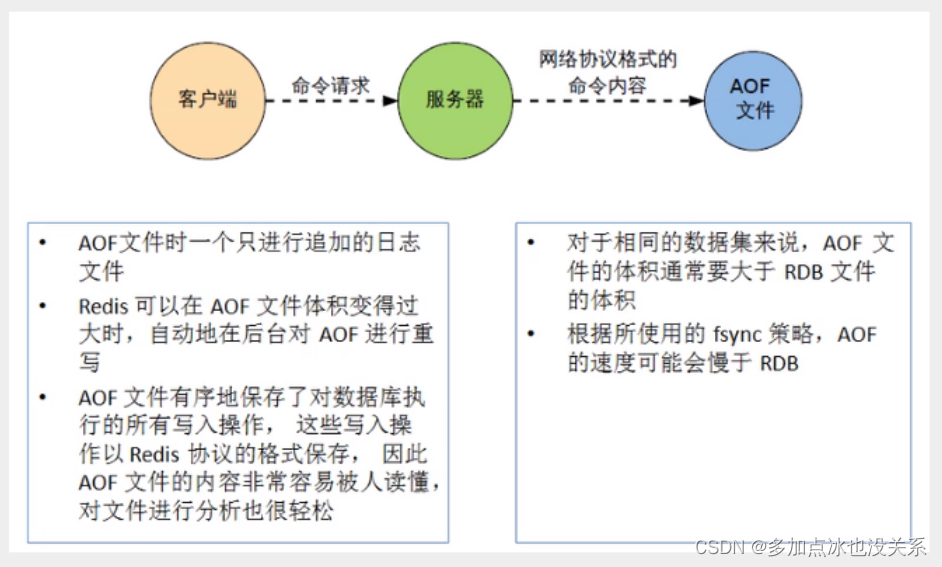

Persistance et réplication, RDB, AOF

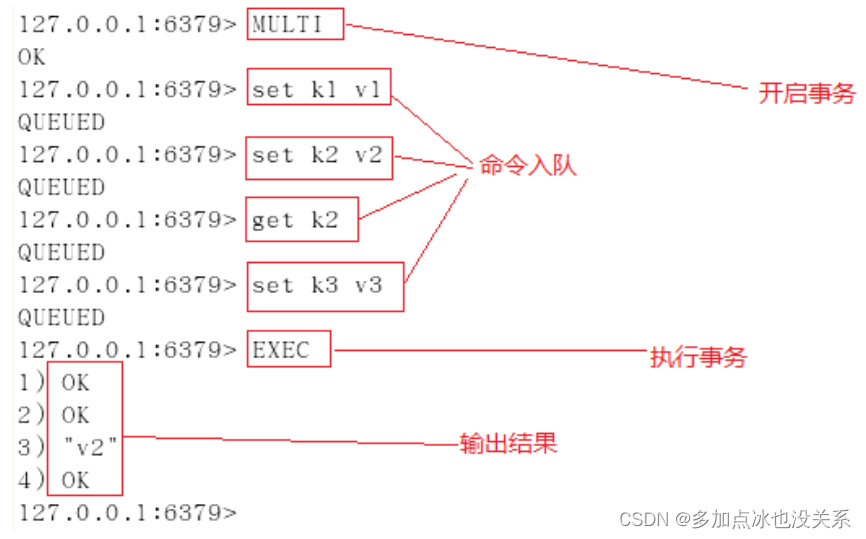

contrôle des transactions

…

Sites Web fréquemment utilisés

https://redis.io/ site officiel

http://www.redis.cn Site chinois

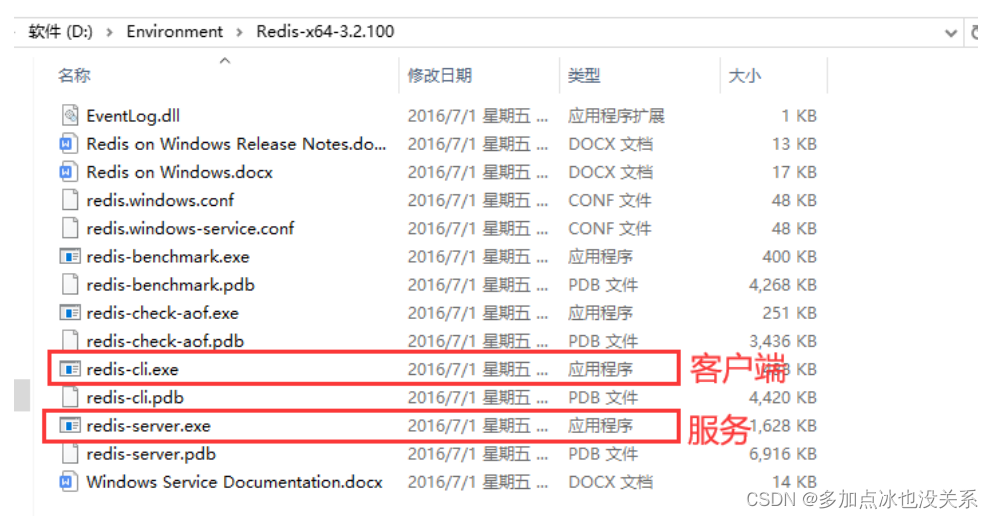

2. Installation de Windows

Adresse de téléchargement : https://github.com/dmajkic/redis/downloads (matériel fourni)

Décompressez-le dans le répertoire d'environnement de votre ordinateur

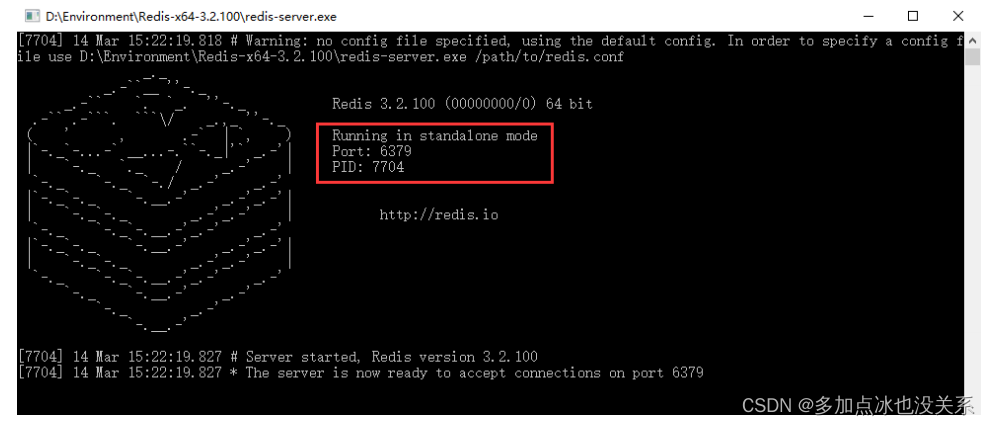

Double-cliquez sur redis-server.exe pour démarrer

Accédez à redis-cli via le client

# 基本的set设值

127.0.0.1:6379> set key kuangshen

OK

# 取出存储的值

127.0.0.1:6379> get key

"kuangshen"

indice important

Étant donné que les entreprises développent Redis, 99 % d'entre elles utilisent et installent la version Linux, et la version Windows n'est presque jamais impliquée. L'explication précédente est uniquement pour l'exhaustivité des connaissances. La version Windows n'est pas au centre. Vous pouvez y jouer vous-même et pratiquez-le en entreprise. Reconnaissez simplement une version : la version Linux

http://www.redis.cn/topics/introduction

3. Installation Linux

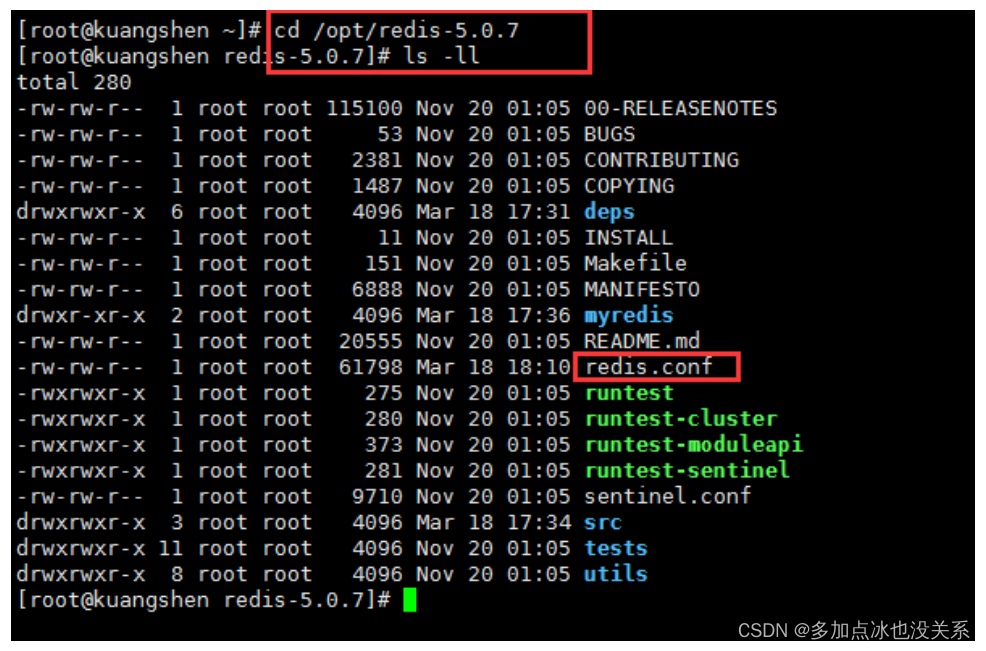

Adresse de téléchargement http://download.redis.io/releases/redis-5.0.7.tar.gz

étapes d'installation

- Téléchargez redis-5.0.7.tar.gz et placez-le dans notre répertoire Linux/opt

- Dans le répertoire /opt, décompressez la commande : tar -zxvf redis-5.0.7.tar.gz

- Une fois la décompression terminée, le dossier apparaît : redis-5.0.7

- Entrez dans le répertoire : cd redis-5.0.7

- Exécutez la commande make dans le répertoire redis-5.0.7

运行make命令时故意出现的错误解析:

1、安装gcc (gcc是linux下的一个编译程序,是c程序的编译工具)

能上网: yum install gcc-c++

版本测试: gcc-v

2、二次make

3、Jemalloc/jemalloc.h: 没有那个文件或目录

运行 make distclean 之后再make

4、Redis Test(可以不用执行)

- Si vous continuez à exécuter make install une fois make terminé

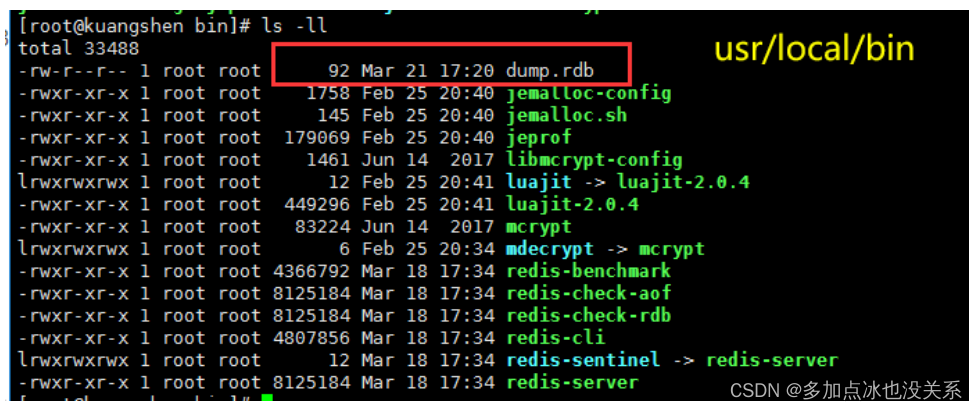

- Vérifiez le répertoire d'installation par défaut : usr/local/bin

/usr 这是一个非常重要的目录,类似于windows下的Program Files,存放用户的程序

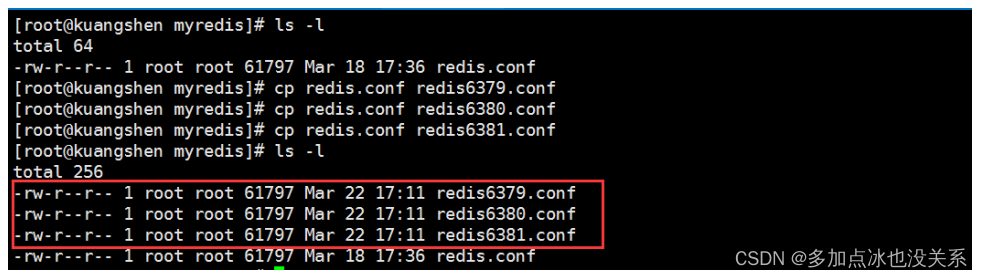

- Copier le fichier de configuration (sauvegarde)

cd /usr/local/bin

ls -l

# 在redis的解压目录下备份redis.conf

mkdir myredis

cp redis.conf myredis # 拷一个备份,养成良好的习惯,我们就修改这个文件

# 修改配置保证可以后台应用

vim redis.conf

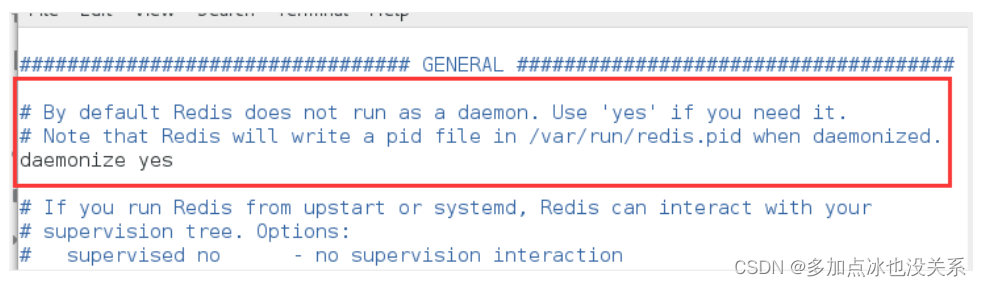

- A. Le thread démon de démonisation dans le fichier de configuration redis.conf est par défaut NON.

- B. daemonize est utilisé pour spécifier si Redis doit être démarré en tant que thread démon.

démoniser fait la différence entre oui ou non

-

démoniser: oui

- Redis utilise un mode multithread à processus unique. Lorsque l'option démoniser dans redis.conf est définie sur oui, cela signifie que le mode processus démon est activé. Dans ce mode, redis s'exécutera en arrière-plan et écrira le numéro pid du processus dans le fichier défini par l'option redis.conf pidfile. À ce stade, redis s'exécutera toujours à moins que le processus ne soit arrêté manuellement.

-

démoniser: non

- Lorsque l'option démoniser est définie sur non,l'interface actuelle entrera dans l'interface de ligne de commande redis.Une sortie forcée en quittant ou en fermant l'outil de connexion (putty, xshell, etc.) entraînera la fermeture du processus redis.

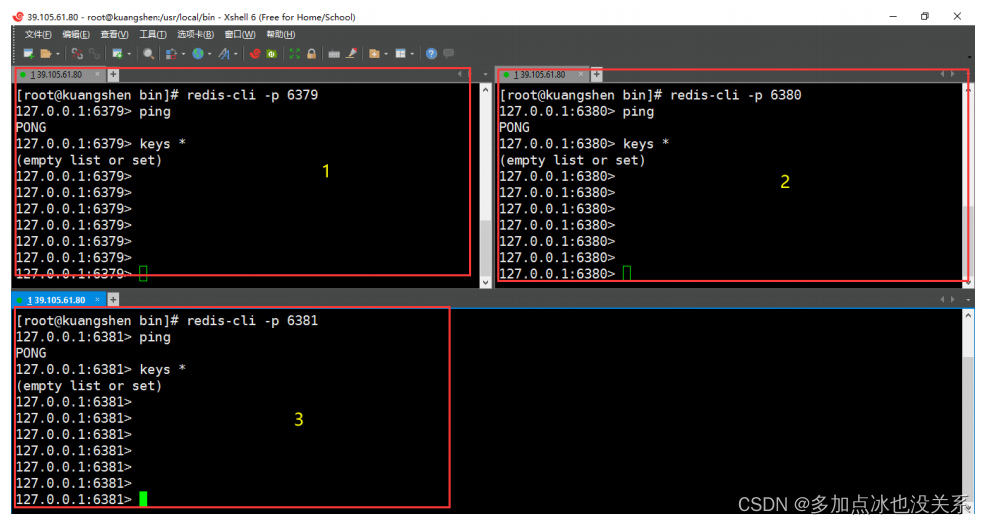

- Commencez le test !

# 【shell】启动redis服务

[root@192 bin]# cd /usr/local/bin

[root@192 bin]# redis-server /opt/redis-5.0.7/redis.conf

# redis客户端连接===> 观察地址的变化,如果连接ok,是直接连上的,redis默认端口号 6379

[root@192 bin]# redis-cli -p 6379

127.0.0.1:6379> ping

PONG

127.0.0.1:6379> set k1 helloworld

OK

127.0.0.1:6379> get k1

"helloworld"

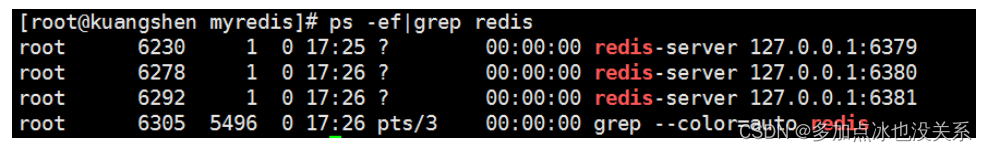

# 【shell】ps显示系统当前进程信息

[root@192 myredis]# ps -ef|grep redis

root 16005 1 0 04:45 ? 00:00:00 redis-server

127.0.0.1:6379

root 16031 15692 0 04:47 pts/0 00:00:00 redis-cli -p 6379

root 16107 16076 0 04:51 pts/2 00:00:00 grep --color=auto redis

# 【redis】关闭连接

127.0.0.1:6379> shutdown

not connected> exit

# 【shell】ps显示系统当前进程信息

[root@192 myredis]# ps -ef|grep redis

root 16140 16076 0 04:53 pts/2 00:00:00 grep --color=auto redis

4. Description des connaissances de base

Préparation : démarrez le service Redis et connectez le client

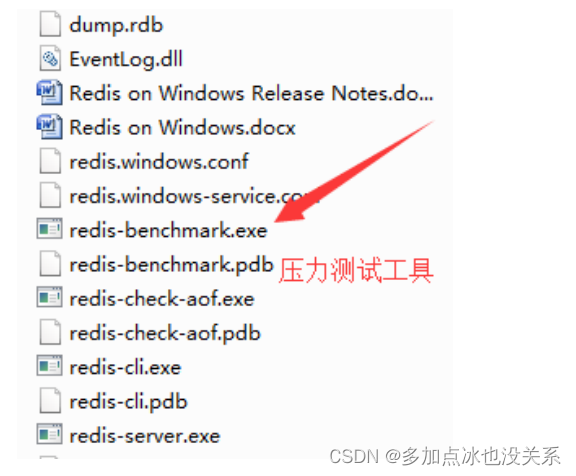

outil de test de stress Redis -----Redis-benchmark

Redis-benchmark est l'outil officiel de test de performances Redis qui peut tester efficacement les performances des services Redis.

Les paramètres facultatifs de l'outil de test de performances Redis sont les suivants :

| numéro de série | Possibilités | décrire | valeur par défaut |

|---|---|---|---|

| 1 | -h | Spécifier le nom d'hôte du serveur | 127.0.0.1 |

| 2 | -p | Spécifier le port du serveur | 6379 |

| 3 | -s | Spécifier le socket du serveur | |

| 4 | -c | Spécifiez le nombre de connexions simultanées | 50 |

| 5 | -n | Précisez le nombre de demandes | 10000 |

| 6 | -d | Spécifie la taille des données de la valeur SET/GET en octets | 2 |

| 7 | -k | 1 = rester en vie 0 = se reconnecter | 1 |

| 8 | -r | SET/GET/INCR utilise des clés aléatoires, SADD utilise des valeurs aléatoires | |

| 9 | -P | Demandes de canal | 1 |

| dix | -q | Forcer à quitter Redis. Afficher uniquement les valeurs de requête/s | |

| 11 | –csv | Sortie au format CSV | |

| 12 | -l | Générez des boucles qui exécutent des tests pour toujours | |

| 13 | -t | Exécutez uniquement une liste de commandes de test séparées par des virgules. | |

| 14 | -JE | Mode inactif. Ouvrez uniquement N connexions inactives et attendez. |

# 测试一:100个并发连接,100000个请求,检测host为localhost 端口为6379的redis服务器性能

redis-benchmark -h localhost -p 6379 -c 100 -n 100000

# 测试出来的所有命令只举例一个!

====== SET ======

100000 requests completed in 1.88 seconds # 对集合写入测试

100 parallel clients # 每次请求有100个并发客户端

3 bytes payload # 每次写入3个字节的数据,有效载荷

keep alive: 1 # 保持一个连接,一台服务器来处理这些请求

17.05% <= 1 milliseconds

97.35% <= 2 milliseconds

99.97% <= 3 milliseconds

100.00% <= 3 milliseconds # 所有请求在 3 毫秒内完成

53248.14 requests per second # 每秒处理 53248.14 次请求

Connaissance de base des bases de données

Il existe 16 bases de données par défaut. Semblable aux indices de tableau commençant à zéro, la valeur par défaut initiale est d'utiliser le numéro de bibliothèque zéro.

查看 redis.conf ,里面有默认的配置

databases 16

# Set the number of databases. The default database is DB 0, you can select

# a different one on a per-connection basis using SELECT <dbid> where

# dbid is a number between 0 and 'databases'-1

databases 16

Sélectionner la base de données des commutateurs de commande

127.0.0.1:6379> select 7

OK

127.0.0.1:6379[7]>

# 不同的库可以存不同的数据

Dbsize vérifie le nombre de clés dans la base de données actuelle

127.0.0.1:6379> select 7

OK

127.0.0.1:6379[7]> DBSIZE

(integer) 0

127.0.0.1:6379[7]> select 0

OK

127.0.0.1:6379> DBSIZE

(integer) 5

127.0.0.1:6379> keys * # 查看具体的key

1) "counter:__rand_int__"

2) "mylist"

3) "k1"

4) "myset:__rand_int__"

5) "key:__rand_int__"

Flushdb : effacer la bibliothèque actuelle

Flushall : effacer toutes les bibliothèques

127.0.0.1:6379> DBSIZE

(integer) 5

127.0.0.1:6379> FLUSHDB

OK

127.0.0.1:6379> DBSIZE

(integer) 0

Pourquoi le port par défaut est-il 6379 ? Effet éventail !

Pourquoi Redis est monothread

Il faut d’abord comprendre que Redis est rapide ! Le responsable a déclaré que Redis étant une opération basée sur la mémoire, le processeur n'est pas le goulot d'étranglement de Redis. Le goulot d'étranglement de Redis est probablement la taille de la mémoire de la machine ou la bande passante du réseau. Puisque le mono-threading est facile à mettre en œuvre et que le CPU ne deviendra pas un goulot d'étranglement, il est logique d'adopter la solution mono-thread !

Redis utilise une base de données KV basée sur la mémoire qui utilise un modèle à processus unique et à thread unique. Elle est écrite en langage C. Les données officiellement fournies peuvent atteindre plus de 100 000 QPS (nombre de requêtes par seconde). Ces données ne sont pas pires que Memcached, la même base de données KV basée sur la mémoire qui utilise un processus unique et multithread !

Pourquoi Redis est-il si rapide ?

1) Il y a toujours eu un malentendu dans le passé, penser que les serveurs hautes performances devaient être implémentés avec des multi-threads

La raison est très simple et est provoquée par le malentendu 2 : le multi-threading doit être plus efficace que le mono-threading, mais ce n'est pas le cas !

Avant d’en parler, j’espère que tout le monde comprend la vitesse du processeur, de la mémoire et du disque dur !

2) Le cœur de Redis est que si toutes mes données sont en mémoire, mon opération monothread sera la plus efficace. Pourquoi ? Parce que l'essence du multithreading est que le processeur simule plusieurs threads. Cette situation simulée est Il y a un prix, qui est le changement de contexte. Pour un système de mémoire, c'est le plus efficace sans changement de contexte. Redis utilise un seul processeur pour lier une partie des données de la mémoire, puis lors de la lecture et de l'écriture plusieurs fois dans les données de cette mémoire, tout est effectué sur un seul processeur, il gère donc cette question dans un seul thread. Dans le cas de la mémoire, cette solution est la meilleure.

Parce qu'un changement de contexte CPU prend environ 1 500 ns. La lecture de 1 Mo de données continues à partir de la mémoire prend environ 250 us. Supposons que 1 Mo de données soit lu 1 000 fois par plusieurs threads, puis il y a 1 000 changements de contexte temporel, puis 1 500 ns * 1 000 = 1 500 us. Il ne faut que 250 us pour lire 1 Mo de données dans un seul thread. Il faut 1 500 us juste pour changer le contexte temporel. Je n'inclus pas le temps qu'il vous faut pour lire un peu de données à chaque fois.

3. Cinq principaux types de données

Documentation officielle

Traduction complète :

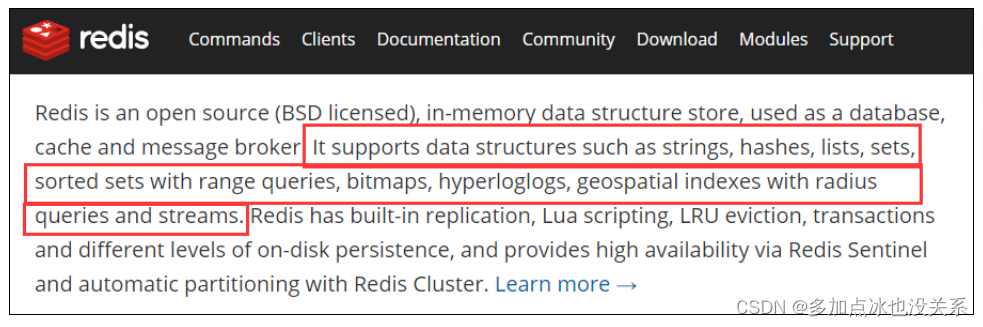

Redis est un magasin de structures de données en mémoire open source (sous licence BSD) utilisé comme base de données, cache et courtier de messages. Il prend en charge les structures de données telles que les chaînes, les hachages, les listes, les ensembles, les collections triées avec des requêtes de plage, les bitmaps, les hyperlogs, les index géospatiaux avec les requêtes de rayon et les flux. Redis intègre une réplication, des scripts Lua, une expulsion LRU, des transactions et différents niveaux de durabilité du disque, et offre une haute disponibilité grâce au partitionnement automatique de Redis Sentinel et Redis Cluster.

Chaîne (type de chaîne)

String est le type de Redis le plus basique. Vous pouvez le comprendre comme le même type que Memcached. Une clé correspond à une valeur.

Le type String est binaire sûr, ce qui signifie que la chaîne redis peut contenir n'importe quelle donnée, telle que des images jpg ou des objets sérialisés.

Le type String est le type de données le plus basique de Redis. La valeur de chaîne dans un Redis peut aller jusqu'à 512 Mo.

Hash (Hash, similaire à Map en Java)

Le hachage Redis est une collection de paires clé-valeur.

Le hachage Redis est une table de mappage de champs et de valeurs de type String. Le hachage est particulièrement adapté au stockage d'objets.

Semblable à Map<String,Object> en Java

Liste

Les listes Redis sont de simples listes de chaînes, triées par ordre d'insertion. Vous pouvez ajouter un élément en tête (à gauche) ou en queue (à droite) de la liste.

Sa couche inférieure est en fait une liste chaînée !

Ensemble

Redis's Set est une collection non ordonnée de type String, qui est implémentée via HashTable !

Zset (ensemble trié : ensemble ordonné)

Redis zset, comme set, est également une collection d'éléments de type String et n'autorise pas les membres en double.

La différence est que chaque élément est associé à une partition de type double.

Redis utilise des scores pour trier les membres de l'ensemble de petit à grand. Les membres de zset sont uniques, mais les scores (Score) peuvent être répétés.

1. Clé Redis (clé)

# keys * 查看所有的key

127.0.0.1:6379> keys *

(empty list or set)

127.0.0.1:6379> set name qinjiang

OK

127.0.0.1:6379> keys *

1) "name"

# exists key 的名字,判断某个key是否存在

127.0.0.1:6379> EXISTS name

(integer) 1

127.0.0.1:6379> EXISTS name1

(integer) 0

# move key db ---> 当前库就没有了,被移除了

127.0.0.1:6379> move name 1

(integer) 1

127.0.0.1:6379> keys *

(empty list or set)

# expire key 秒钟:为给定 key 设置生存时间,当 key 过期时(生存时间为 0 ),它会被自动删

除。

# ttl key 查看还有多少秒过期,-1 表示永不过期,-2 表示已过期

127.0.0.1:6379> set name qinjiang

OK

127.0.0.1:6379> EXPIRE name 10

(integer) 1

127.0.0.1:6379> ttl name

(integer) 4

127.0.0.1:6379> ttl name

(integer) 3

127.0.0.1:6379> ttl name

(integer) 2

127.0.0.1:6379> ttl name

(integer) 1

127.0.0.1:6379> ttl name

(integer) -2

127.0.0.1:6379> keys *

(empty list or set)

# type key 查看你的key是什么类型

127.0.0.1:6379> set name qinjiang

OK

127.0.0.1:6379> get name

"qinjiang"

127.0.0.1:6379> type name

string

2. Chaîne

Valeur unique Valeur unique

Descriptions de commandes courantes :

# ===================================================

# set、get、del、append、strlen

# ===================================================

127.0.0.1:6379> set key1 value1 # 设置值

OK

127.0.0.1:6379> get key1 # 获得key

"value1"

127.0.0.1:6379> del key1 # 删除key

(integer) 1

127.0.0.1:6379> keys * # 查看全部的key

(empty list or set)

127.0.0.1:6379> exists key1 # 确保 key1 不存在

(integer) 0

127.0.0.1:6379> append key1 "hello" # 对不存在的 key 进行 APPEND ,等同于 SET

key1 "hello"

(integer) 5 # 字符长度

127.0.0.1:6379> APPEND key1 "-2333" # 对已存在的字符串进行 APPEND

(integer) 10 # 长度从 5 个字符增加到 10 个字符

127.0.0.1:6379> get key1

"hello-2333"

127.0.0.1:6379> STRLEN key1 # # 获取字符串的长度

(integer) 10

# ===================================================

# incr、decr 一定要是数字才能进行加减,+1 和 -1。

# incrby、decrby 命令将 key 中储存的数字加上指定的增量值。

# ===================================================

127.0.0.1:6379> set views 0 # 设置浏览量为0

OK

127.0.0.1:6379> incr views # 浏览 + 1

(integer) 1

127.0.0.1:6379> incr views # 浏览 + 1

(integer) 2

127.0.0.1:6379> decr views # 浏览 - 1

(integer) 1

127.0.0.1:6379> incrby views 10 # +10

(integer) 11

127.0.0.1:6379> decrby views 10 # -10

(integer) 1

# ===================================================

# range [范围]

# getrange 获取指定区间范围内的值,类似between...and的关系,从零到负一表示全部

# ===================================================

127.0.0.1:6379> set key2 abcd123456 # 设置key2的值

OK

127.0.0.1:6379> getrange key2 0 -1 # 获得全部的值

"abcd123456"

127.0.0.1:6379> getrange key2 0 2 # 截取部分字符串

"abc"

# ===================================================

# setrange 设置指定区间范围内的值,格式是setrange key值 具体值

# ===================================================

127.0.0.1:6379> get key2

"abcd123456"

127.0.0.1:6379> SETRANGE key2 1 xx # 替换值

(integer) 10

127.0.0.1:6379> get key2

"axxd123456"

# ===================================================

# setex(set with expire)键秒值

# setnx(set if not exist)

# ===================================================

127.0.0.1:6379> setex key3 60 expire # 设置过期时间

OK

127.0.0.1:6379> ttl key3 # 查看剩余的时间

(integer) 55

127.0.0.1:6379> setnx mykey "redis" # 如果不存在就设置,成功返回1

(integer) 1

127.0.0.1:6379> setnx mykey "mongodb" # 如果存在就设置,失败返回0

(integer) 0

127.0.0.1:6379> get mykey

"redis"

# ===================================================

# mset Mset 命令用于同时设置一个或多个 key-value 对。

# mget Mget 命令返回所有(一个或多个)给定 key 的值。

# 如果给定的 key 里面,有某个 key 不存在,那么这个 key 返回特殊值 nil 。

# msetnx 当所有 key 都成功设置,返回 1 。

# 如果所有给定 key 都设置失败(至少有一个 key 已经存在),那么返回 0 。原子操

作

# ===================================================

127.0.0.1:6379> mset k10 v10 k11 v11 k12 v12

OK

127.0.0.1:6379> keys *

1) "k12"

2) "k11"

3) "k10"

127.0.0.1:6379> mget k10 k11 k12 k13

1) "v10"

2) "v11"

3) "v12"

4) (nil)

127.0.0.1:6379> msetnx k10 v10 k15 v15 # 原子性操作!

(integer) 0

127.0.0.1:6379> get key15

(nil)

# 传统对象缓存

set user:1 value(json数据)

# 可以用来缓存对象

mset user:1:name zhangsan user:1:age 2

mget user:1:name user:1:age

# ===================================================

# getset(先get再set)

# ===================================================

127.0.0.1:6379> getset db mongodb # 没有旧值,返回 nil

(nil)

127.0.0.1:6379> get db

"mongodb"

127.0.0.1:6379> getset db redis # 返回旧值 mongodb

"mongodb"

127.0.0.1:6379> get db

"redis"

La structure de données String est un simple type clé-valeur. En fait, la valeur peut être non seulement une chaîne, mais également un nombre.

Application générale de mise en cache clé-valeur :

Comptages conventionnels : nombre de publications sur Weibo, nombre de fans, etc.

3. Liste Liste

Valeur unique Valeur multiple

# ===================================================

# Lpush:将一个或多个值插入到列表头部。(左)

# rpush:将一个或多个值插入到列表尾部。(右)

# lrange:返回列表中指定区间内的元素,区间以偏移量 START 和 END 指定。

# 其中 0 表示列表的第一个元素, 1 表示列表的第二个元素,以此类推。

# 你也可以使用负数下标,以 -1 表示列表的最后一个元素, -2 表示列表的倒数第二个元素,以此类推。

# ===================================================

127.0.0.1:6379> LPUSH list "one"

(integer) 1

127.0.0.1:6379> LPUSH list "two"

(integer) 2

127.0.0.1:6379> RPUSH list "right"

(integer) 3

127.0.0.1:6379> Lrange list 0 -1

1) "two"

2) "one"

3) "right"

127.0.0.1:6379> Lrange list 0 1

1) "two"

2) "one"

# ===================================================

# lpop 命令用于移除并返回列表的第一个元素。当列表 key 不存在时,返回 nil 。

# rpop 移除列表的最后一个元素,返回值为移除的元素。

# ===================================================

127.0.0.1:6379> Lpop list

"two"

127.0.0.1:6379> Rpop list

"right"

127.0.0.1:6379> Lrange list 0 -1

1) "one"

# ===================================================

# Lindex,按照索引下标获得元素(-1代表最后一个,0代表是第一个)

# ===================================================

127.0.0.1:6379> Lindex list 1

(nil)

127.0.0.1:6379> Lindex list 0

"one"

127.0.0.1:6379> Lindex list -1

"one"

# ===================================================

# llen 用于返回列表的长度。

# ===================================================

127.0.0.1:6379> flushdb

OK

127.0.0.1:6379> Lpush list "one"

(integer) 1

127.0.0.1:6379> Lpush list "two"

(integer) 2

127.0.0.1:6379> Lpush list "three"

(integer) 3

127.0.0.1:6379> Llen list # 返回列表的长度

(integer) 3

# ===================================================

# lrem key 根据参数 COUNT 的值,移除列表中与参数 VALUE 相等的元素。

# ===================================================

127.0.0.1:6379> lrem list 1 "two"

(integer) 1

127.0.0.1:6379> Lrange list 0 -1

1) "three"

2) "one"

# ===================================================

# Ltrim key 对一个列表进行修剪(trim),就是说,让列表只保留指定区间内的元素,不在指定区间之内的元素都将被删除。

# ===================================================

127.0.0.1:6379> RPUSH mylist "hello"

(integer) 1

127.0.0.1:6379> RPUSH mylist "hello"

(integer) 2

127.0.0.1:6379> RPUSH mylist "hello2"

(integer) 3

127.0.0.1:6379> RPUSH mylist "hello3"

(integer) 4

127.0.0.1:6379> ltrim mylist 1 2

OK

127.0.0.1:6379> lrange mylist 0 -1

1) "hello"

2) "hello2"

# ===================================================

# rpoplpush 移除列表的最后一个元素,并将该元素添加到另一个列表并返回。

# ===================================================

127.0.0.1:6379> rpush mylist "hello"

(integer) 1

127.0.0.1:6379> rpush mylist "foo"

(integer) 2

127.0.0.1:6379> rpush mylist "bar"

(integer) 3

127.0.0.1:6379> rpoplpush mylist myotherlist

"bar"

127.0.0.1:6379> lrange mylist 0 -1

1) "hello"

2) "foo"

127.0.0.1:6379> lrange myotherlist 0 -1

1) "bar"

# ===================================================

# lset key index value 将列表 key 下标为 index 的元素的值设置为 value 。

# ===================================================

127.0.0.1:6379> exists list # 对空列表(key 不存在)进行 LSET

(integer) 0

127.0.0.1:6379> lset list 0 item # 报错

(error) ERR no such key

127.0.0.1:6379> lpush list "value1" # 对非空列表进行 LSET

(integer) 1

127.0.0.1:6379> lrange list 0 0

1) "value1"

127.0.0.1:6379> lset list 0 "new" # 更新值

OK

127.0.0.1:6379> lrange list 0 0

1) "new"

127.0.0.1:6379> lset list 1 "new" # index 超出范围报错

(error) ERR index out of range

# ===================================================

# linsert key before/after pivot value 用于在列表的元素前或者后插入元素。

# 将值 value 插入到列表 key 当中,位于值 pivot 之前或之后。

# ===================================================

redis> RPUSH mylist "Hello"

(integer) 1

redis> RPUSH mylist "World"

(integer) 2

redis> LINSERT mylist BEFORE "World" "There"

(integer) 3

redis> LRANGE mylist 0 -1

1) "Hello"

2) "There"

3) "World"

Résumé des performances

- Il s'agit d'une liste chaînée de chaînes, gauche et droite peuvent être insérées et ajoutées

- Si la clé n'existe pas, créez une nouvelle liste chaînée

- Si la clé existe déjà, ajoutez le contenu

- Si toutes les valeurs sont supprimées, les clés correspondantes disparaîtront.

- Le fonctionnement de la liste chaînée est extrêmement efficace tant sur la tête que sur la queue, mais si l’opération est effectuée sur les éléments du milieu, l’efficacité est très lamentable.

Une liste est une liste chaînée, et toute personne ayant une certaine connaissance des structures de données devrait être capable de comprendre sa structure. Grâce à la structure des listes, nous pouvons facilement implémenter des fonctions telles que le classement des dernières actualités. Une autre application de List est la file d'attente de messages. Vous pouvez utiliser l'opération PUSH de List pour stocker des tâches dans la liste, puis le thread de travail utilise l'opération POP pour extraire les tâches à exécuter. Redis fournit également une API pour exploiter un certain segment dans la liste. Vous pouvez directement interroger et supprimer des éléments d'un certain segment dans la liste.

La liste de Redis est une liste doublement chaînée dans laquelle chaque sous-élément est de type String. Des éléments peuvent être ajoutés ou supprimés de la tête ou de la queue de la liste via des opérations push et pop, de sorte que la liste puisse être utilisée comme une pile ou un file d'attente.

4. Définir

valeur unique valeur multiple

# ===================================================

# sadd 将一个或多个成员元素加入到集合中,不能重复

# smembers 返回集合中的所有的成员。

# sismember 命令判断成员元素是否是集合的成员。

# ===================================================

127.0.0.1:6379> sadd myset "hello"

(integer) 1

127.0.0.1:6379> sadd myset "kuangshen"

(integer) 1

127.0.0.1:6379> sadd myset "kuangshen"

(integer) 0

127.0.0.1:6379> SMEMBERS myset

1) "kuangshen"

2) "hello"

127.0.0.1:6379> SISMEMBER myset "hello"

(integer) 1

127.0.0.1:6379> SISMEMBER myset "world"

(integer) 0

# ===================================================

# scard,获取集合里面的元素个数

# ===================================================

127.0.0.1:6379> scard myset

(integer) 2

# ===================================================

# srem key value 用于移除集合中的一个或多个成员元素

# ===================================================

127.0.0.1:6379> srem myset "kuangshen"

(integer) 1

127.0.0.1:6379> SMEMBERS myset

1) "hello"

# ===================================================

# srandmember key 命令用于返回集合中的一个随机元素。

# ===================================================

127.0.0.1:6379> SMEMBERS myset

1) "kuangshen"

2) "world"

3) "hello"

127.0.0.1:6379> SRANDMEMBER myset

"hello"

127.0.0.1:6379> SRANDMEMBER myset 2

1) "world"

2) "kuangshen"

127.0.0.1:6379> SRANDMEMBER myset 2

1) "kuangshen"

2) "hello"

# ===================================================

# spop key 用于移除集合中的指定 key 的一个或多个随机元素

# ===================================================

127.0.0.1:6379> SMEMBERS myset

1) "kuangshen"

2) "world"

3) "hello"

127.0.0.1:6379> spop myset

"world"

127.0.0.1:6379> spop myset

"kuangshen"

127.0.0.1:6379> spop myset

"hello"

# ===================================================

# smove SOURCE DESTINATION MEMBER

# 将指定成员 member 元素从 source 集合移动到 destination 集合。

# ===================================================

127.0.0.1:6379> sadd myset "hello"

(integer) 1

127.0.0.1:6379> sadd myset "world"

(integer) 1

127.0.0.1:6379> sadd myset "kuangshen"

(integer) 1

127.0.0.1:6379> sadd myset2 "set2"

(integer) 1

127.0.0.1:6379> smove myset myset2 "kuangshen"

(integer) 1

127.0.0.1:6379> SMEMBERS myset

1) "world"

2) "hello"

127.0.0.1:6379> SMEMBERS myset2

1) "kuangshen"

2) "set2"

# ===================================================

- 数字集合类

- 差集: sdiff

- 交集: sinter

- 并集: sunion

# ===================================================

127.0.0.1:6379> sadd key1 "a"

(integer) 1

127.0.0.1:6379> sadd key1 "b"

(integer) 1

127.0.0.1:6379> sadd key1 "c"

(integer) 1

127.0.0.1:6379> sadd key2 "c"

(integer) 1

127.0.0.1:6379> sadd key2 "d"

(integer) 1

127.0.0.1:6379> sadd key2 "e"

(integer) 1

127.0.0.1:6379> SDIFF key1 key2 # 差集

1) "a"

2) "b"

127.0.0.1:6379> SINTER key1 key2 # 交集

1) "c"

127.0.0.1:6379> SUNION key1 key2 # 并集

1) "a"

2) "b"

3) "c"

4) "e"

5) "d"

Dans l'application Weibo, tous les abonnés d'un utilisateur peuvent être stockés dans une collection, et tous les fans peuvent être stockés dans une collection. Redis fournit également des opérations telles que l'intersection, l'union et la différence pour les collections, ce qui peut être très pratique pour implémenter des fonctions telles que l'attention conjointe, les préférences communes et les amis du deuxième degré. Pour toutes les opérations de collecte ci-dessus, vous pouvez également utiliser différentes commandes Rendre les résultats au client ou les enregistrer dans une nouvelle collection.

5. Hachage

Le mode kv reste inchangé, mais V est une paire clé-valeur

# ===================================================

# hset、hget 命令用于为哈希表中的字段赋值 。

# hmset、hmget 同时将多个field-value对设置到哈希表中。会覆盖哈希表中已存在的字段。

# hgetall 用于返回哈希表中,所有的字段和值。

# hdel 用于删除哈希表 key 中的一个或多个指定字段

# ===================================================

127.0.0.1:6379> hset myhash field1 "kuangshen"

(integer) 1

127.0.0.1:6379> hget myhash field1

"kuangshen"

127.0.0.1:6379> HMSET myhash field1 "Hello" field2 "World"

OK

127.0.0.1:6379> HGET myhash field1

"Hello"

127.0.0.1:6379> HGET myhash field2

"World"

127.0.0.1:6379> hgetall myhash

1) "field1"

2) "Hello"

3) "field2"

4) "World"

127.0.0.1:6379> HDEL myhash field1

(integer) 1

127.0.0.1:6379> hgetall myhash

1) "field2"

2) "World"

# ===================================================

# hlen 获取哈希表中字段的数量。

# ===================================================

127.0.0.1:6379> hlen myhash

(integer) 1

127.0.0.1:6379> HMSET myhash field1 "Hello" field2 "World"

OK

127.0.0.1:6379> hlen myhash

(integer) 2

# ===================================================

# hexists 查看哈希表的指定字段是否存在。

# ===================================================

127.0.0.1:6379> hexists myhash field1

(integer) 1

127.0.0.1:6379> hexists myhash field3

(integer) 0

# ===================================================

# hkeys 获取哈希表中的所有域(field)。

# hvals 返回哈希表所有域(field)的值。

# ===================================================

127.0.0.1:6379> HKEYS myhash

1) "field2"

2) "field1"

127.0.0.1:6379> HVALS myhash

1) "World"

2) "Hello"

# ===================================================

# hincrby 为哈希表中的字段值加上指定增量值。

# ===================================================

127.0.0.1:6379> hset myhash field 5

(integer) 1

127.0.0.1:6379> HINCRBY myhash field 1

(integer) 6

127.0.0.1:6379> HINCRBY myhash field -1

(integer) 5

127.0.0.1:6379> HINCRBY myhash field -10

(integer) -5

# ===================================================

# hsetnx 为哈希表中不存在的的字段赋值 。

# ===================================================

127.0.0.1:6379> HSETNX myhash field1 "hello"

(integer) 1 # 设置成功,返回 1 。

127.0.0.1:6379> HSETNX myhash field1 "world"

(integer) 0 # 如果给定字段已经存在,返回 0 。

127.0.0.1:6379> HGET myhash field1

"hello"

Le hachage Redis est une table de mappage de champs et de valeurs de type chaîne. Le hachage est particulièrement adapté au stockage d'objets.

Stockez certaines données modifiées, telles que les informations utilisateur, etc.

6. Ensemble commandé Zset

En fonction de l'ensemble, ajoutez une valeur de score. Précédemment défini, c'était k1 v1 v2 v3, maintenant zset est k1 score1 v1 score2 v2

# ===================================================

# zadd 将一个或多个成员元素及其分数值加入到有序集当中。

# zrange 返回有序集中,指定区间内的成员

# ===================================================

127.0.0.1:6379> zadd myset 1 "one"

(integer) 1

127.0.0.1:6379> zadd myset 2 "two" 3 "three"

(integer) 2

127.0.0.1:6379> ZRANGE myset 0 -1

1) "one"

2) "two"

3) "three"

# ===================================================

# zrangebyscore 返回有序集合中指定分数区间的成员列表。有序集成员按分数值递增(从小到大)次序排列。

# ===================================================

127.0.0.1:6379> zadd salary 2500 xiaoming

(integer) 1

127.0.0.1:6379> zadd salary 5000 xiaohong

(integer) 1

127.0.0.1:6379> zadd salary 500 kuangshen

(integer) 1

# Inf无穷大量+∞,同样地,-∞可以表示为-Inf。

127.0.0.1:6379> ZRANGEBYSCORE salary -inf +inf # 显示整个有序集

1) "kuangshen"

2) "xiaoming"

3) "xiaohong"

127.0.0.1:6379> ZRANGEBYSCORE salary -inf +inf withscores # 递增排列

1) "kuangshen"

2) "500"

3) "xiaoming"

4) "2500"

5) "xiaohong"

6) "5000"

127.0.0.1:6379> ZREVRANGE salary 0 -1 WITHSCORES # 递减排列

1) "xiaohong"

2) "5000"

3) "xiaoming"

4) "2500"

5) "kuangshen"

6) "500"

127.0.0.1:6379> ZRANGEBYSCORE salary -inf 2500 WITHSCORES # 显示工资 <=2500

的所有成员

1) "kuangshen"

2) "500"

3) "xiaoming"

4) "2500"

# ===================================================

# zrem 移除有序集中的一个或多个成员

# ===================================================

127.0.0.1:6379> ZRANGE salary 0 -1

1) "kuangshen"

2) "xiaoming"

3) "xiaohong"

127.0.0.1:6379> zrem salary kuangshen

(integer) 1

127.0.0.1:6379> ZRANGE salary 0 -1

1) "xiaoming"

2) "xiaohong"

# ===================================================

# zcard 命令用于计算集合中元素的数量。

# ===================================================

127.0.0.1:6379> zcard salary

(integer) 2

OK

# ===================================================

# zcount 计算有序集合中指定分数区间的成员数量。

# ===================================================

127.0.0.1:6379> zadd myset 1 "hello"

(integer) 1

127.0.0.1:6379> zadd myset 2 "world" 3 "kuangshen"

(integer) 2

127.0.0.1:6379> ZCOUNT myset 1 3

(integer) 3

127.0.0.1:6379> ZCOUNT myset 1 2

(integer) 2

# ===================================================

# zrank 返回有序集中指定成员的排名。其中有序集成员按分数值递增(从小到大)顺序排列。

# ===================================================

127.0.0.1:6379> zadd salary 2500 xiaoming

(integer) 1

127.0.0.1:6379> zadd salary 5000 xiaohong

(integer) 1

127.0.0.1:6379> zadd salary 500 kuangshen

(integer) 1

127.0.0.1:6379> ZRANGE salary 0 -1 WITHSCORES # 显示所有成员及其 score 值

1) "kuangshen"

2) "500"

3) "xiaoming"

4) "2500"

5) "xiaohong"

6) "5000"

127.0.0.1:6379> zrank salary kuangshen # 显示 kuangshen 的薪水排名,最少

(integer) 0

127.0.0.1:6379> zrank salary xiaohong # 显示 xiaohong 的薪水排名,第三

(integer) 2

# ===================================================

# zrevrank 返回有序集中成员的排名。其中有序集成员按分数值递减(从大到小)排序。

# ===================================================

127.0.0.1:6379> ZREVRANK salary kuangshen # 狂神第三

(integer) 2

127.0.0.1:6379> ZREVRANK salary xiaohong # 小红第一

(integer) 0

Par rapport à l'ensemble, l'ensemble trié ajoute un score de paramètre de poids, de sorte que les éléments de l'ensemble puissent être disposés dans l'ordre en fonction du score. Par exemple, un ensemble trié qui stocke les notes de toute la classe, la valeur définie peut être l'élève. numéro du camarade de classe et score Il peut s'agir de son score au test, de sorte que lorsque les données sont insérées dans la collection, elles seront naturellement triées. Vous pouvez utiliser un ensemble trié pour créer une file d'attente pondérée. Par exemple, le score des messages ordinaires est de 1 et le score des messages importants est de 2. Le thread de travail peut ensuite choisir d'obtenir les tâches de travail dans l'ordre inverse des scores. Priorisez les tâches importantes.

Application de classement, prenez les opérations TOP N !

4. Trois types de données spéciaux

1. Localisation géographique GEO

Introduction

La fonctionnalité GEO de Redis a été lancée dans la version 3.2 de Redis. Cette fonctionnalité peut stocker les informations de localisation géographique fournies par l'utilisateur et exploiter ces informations. Pour mettre en œuvre des fonctions qui s'appuient sur des informations de localisation géographique telles que les emplacements à proximité et les secousses. Le type de données de géo est zset.

La structure de données de GEO comporte un total de six commandes communes :

- géoajouter

- géopos

- géodiste

- rayon géographique

- rayon géographiquepar membre

- gethash

Document officiel : https://www.redis.net.cn/order/3685.html

géoajouter

Analyse:

# 语法

geoadd key longitude latitude member ...

# 将给定的空间元素(纬度、经度、名字)添加到指定的键里面。

# 这些数据会以有序集合的形式被储存在键里面,从而使得georadius和georadiusbymember这样的命令可以在之后通过位置查询取得这些元素。

# geoadd命令以标准的x,y格式接受参数,所以用户必须先输入经度,然后再输入纬度。

# geoadd能够记录的坐标是有限的:非常接近两极的区域无法被索引。

# 有效的经度介于-180-180度之间,有效的纬度介于-85.05112878 度至 85.05112878 度之间。,当用户尝试输入一个超出范围的经度或者纬度时,geoadd命令将返回一个错误。

Test : requête de recherche de longitude et de latitude par Baidu, simulant des données réelles

127.0.0.1:6379> geoadd china:city 116.23 40.22 北京

(integer) 1

127.0.0.1:6379> geoadd china:city 121.48 31.40 上海 113.88 22.55 深圳 120.21

30.20 杭州

(integer) 3

127.0.0.1:6379> geoadd china:city 106.54 29.40 重庆 108.93 34.23 西安 114.02

30.58 武汉

(integer) 3

géopos

Analyse:

# 语法

geopos key member [member...]

#从key里返回所有给定位置元素的位置(经度和纬度)

test:

127.0.0.1:6379> geopos china:city 北京

1) 1) "116.23000055551528931"

2) "40.2200010338739844"

127.0.0.1:6379> geopos china:city 上海 重庆

1) 1) "121.48000091314315796"

2) "31.40000025319353938"

2) 1) "106.54000014066696167"

2) "29.39999880018641676"

127.0.0.1:6379> geopos china:city 新疆

1) (nil)

géodiste

Analyse:

# 语法

geodist key member1 member2 [unit]

# 返回两个给定位置之间的距离,如果两个位置之间的其中一个不存在,那么命令返回空值。

# 指定单位的参数unit必须是以下单位的其中一个:

# m表示单位为米

# km表示单位为千米

# mi表示单位为英里

# ft表示单位为英尺

# 如果用户没有显式地指定单位参数,那么geodist默认使用米作为单位。

#geodist命令在计算距离时会假设地球为完美的球形,在极限情况下,这一假设最大会造成0.5%的误

差。

test:

127.0.0.1:6379> geodist china:city 北京 上海

"1088785.4302"

127.0.0.1:6379> geodist china:city 北京 上海 km

"1088.7854"

127.0.0.1:6379> geodist china:city 重庆 北京 km

"1491.6716"

rayon géographique

Analyse:

# 语法

georadius key longitude latitude radius m|km|ft|mi [withcoord][withdist]

[withhash][asc|desc][count count]

# 以给定的经纬度为中心, 找出某一半径内的元素

Test : reconnectez redis-cli et ajoutez le paramètre --raw pour forcer la sortie chinoise, sinon elle sera tronquée.

[root@kuangshen bin]# redis-cli --raw -p 6379

# 在 china:city 中寻找坐标 100 30 半径为 1000km 的城市

127.0.0.1:6379> georadius china:city 100 30 1000 km

重庆

西安

# withdist 返回位置名称和中心距离

127.0.0.1:6379> georadius china:city 100 30 1000 km withdist

重庆

635.2850

西安

963.3171

# withcoord 返回位置名称和经纬度

127.0.0.1:6379> georadius china:city 100 30 1000 km withcoord

重庆

106.54000014066696167

29.39999880018641676

西安

108.92999857664108276

34.23000121926852302

# withdist withcoord 返回位置名称 距离 和经纬度 count 限定寻找个数

127.0.0.1:6379> georadius china:city 100 30 1000 km withcoord withdist count

1

重庆

635.2850

106.54000014066696167

29.39999880018641676

127.0.0.1:6379> georadius china:city 100 30 1000 km withcoord withdist count

2

重庆

635.2850

106.54000014066696167

29.39999880018641676

西安

963.3171

108.92999857664108276

34.23000121926852302

rayon géographiquepar membre

Analyse:

# 语法

georadiusbymember key member radius m|km|ft|mi [withcoord][withdist]

[withhash][asc|desc][count count]

# 找出位于指定范围内的元素,中心点是由给定的位置元素决定

test:

127.0.0.1:6379> GEORADIUSBYMEMBER china:city 北京 1000 km

北京

西安

127.0.0.1:6379> GEORADIUSBYMEMBER china:city 上海 400 km

杭州

上海

géohash

Analyse:

# 语法

geohash key member [member...]

# Redis使用geohash将二维经纬度转换为一维字符串,字符串越长表示位置更精确,两个字符串越相似

表示距离越近。

test:

127.0.0.1:6379> geohash china:city 北京 重庆

wx4sucu47r0

wm5z22h53v0

127.0.0.1:6379> geohash china:city 北京 上海

wx4sucu47r0

wtw6sk5n300

âge

GEO ne fournit pas de commande pour supprimer des membres, mais comme l'implémentation sous-jacente de GEO est zset, vous pouvez utiliser la commande zrem pour supprimer les informations de localisation géographique.

127.0.0.1:6379> geoadd china:city 116.23 40.22 beijin

1

127.0.0.1:6379> zrange china:city 0 -1 # 查看全部的元素

重庆

西安

深圳

武汉

杭州

上海

beijin

北京

127.0.0.1:6379> zrem china:city beijin # 移除元素

1

127.0.0.1:6379> zrem china:city 北京 # 移除元素

1

127.0.0.1:6379> zrange china:city 0 -1

重庆

西安

深圳

武汉

杭州

上海

2、HyperLogLog

Introduction

Redis a ajouté la structure HyperLogLog dans la version 2.8.9.

Redis HyperLogLog est un algorithme utilisé pour les statistiques de cardinalité. L'avantage de HyperLogLog est que lorsque le nombre ou le volume des éléments d'entrée est très grand, l'espace requis pour calculer la cardinalité est toujours fixe et très petit.

Dans Redis, chaque clé HyperLogLog ne coûte que 12 Ko de mémoire pour calculer la cardinalité de près de 2^64 éléments différents. Cela contraste fortement avec une collection qui consomme plus de mémoire lors du calcul de la cardinalité : plus il y a d'éléments, plus la mémoire est consommée.

HyperLogLog est un algorithme qui fournit une solution de comptage de déduplication inexacte.

Par exemple : Si je souhaite compter l'UV d'une page Web (le nombre d'utilisateurs naviguant, les visites multiples du même utilisateur dans une journée ne peuvent être comptées qu'une seule fois), la solution traditionnelle consiste à utiliser Set pour enregistrer l'ID utilisateur, puis comptez le nombre d'éléments dans le jeu. Obtenez la page UV. Cependant, cette solution ne peut héberger qu'un petit nombre d'utilisateurs. Une fois le nombre d'utilisateurs augmenté, elle consommera beaucoup d'espace pour stocker les identifiants des utilisateurs. Mon but est de compter le nombre d'utilisateurs plutôt que de les sauvegarder. C'est une solution ingrate ! HyperLogLog utilisant Redis nécessite jusqu'à 12 000 utilisateurs pour compter un grand nombre d'utilisateurs. Bien qu'il ait un taux d'erreur d'environ 0,81 %, il est négligeable pour compter des données UV qui ne nécessitent pas de données très précises.

Qu'est-ce que la cardinalité ?

Par exemple, si l'ensemble de données est {1, 3, 5, 7, 5, 7, 8}, alors l'ensemble de cardinalité de cet ensemble de données est {1, 3, 5,7, 8}, et la cardinalité (non -éléments répétitifs) est 5. L'estimation de la cardinalité consiste à calculer rapidement la cardinalité dans la plage d'erreur acceptable.

commandes de base

| Commande | décrire |

|---|---|

| [Élément clé PFADD [élément…] | Ajoute l'élément spécifié à HyperLogLog. |

| [Touche PFCOUNT [clé…] | Renvoie l'estimation de cardinalité pour l'HyperLogLog donné. |

| [PFMERGE destkey sourcekey [sourcekey…] | Fusionnez plusieurs HyperLogLogs en un seul HyperLogLog et calculez l'union |

test

127.0.0.1:6379> PFADD mykey a b c d e f g h i j

1

127.0.0.1:6379> PFCOUNT mykey

10

127.0.0.1:6379> PFADD mykey2 i j z x c v b n m

1

127.0.0.1:6379> PFMERGE mykey3 mykey mykey2

OK

127.0.0.1:6379> PFCOUNT mykey3

15

3、BitMap

Introduction

Au cours du développement, vous pouvez rencontrer cette situation : vous devez compter certaines informations sur l'utilisateur, telles qu'actif ou inactif, connecté ou non ; ou vous devez enregistrer le statut d'enregistrement de l'utilisateur pendant un an. Si vous cochez dans, c'est 1, si vous ne vous êtes pas enregistré, c'est 1. 0. Si un stockage clé/valeur ordinaire est utilisé, 365 enregistrements seront enregistrés. Si le nombre d'utilisateurs est grand, l'espace requis sera également grand, Redis fournit donc la structure de données bitmap Bitmap. Bitmap fonctionne sur des bits binaires. Pour enregistrer, c'est 0 et 1 ; si vous souhaitez enregistrer le statut d'enregistrement pendant 365 jours, la représentation Bitmap est à peu près la suivante : 0101000111000111... Quels en sont les avantages ? Bien sûr, cela économise de la mémoire : 365 jours équivaut à 365 bits, et 1 octet = 8 bits, cela équivaut donc à utiliser 46 octets.

BitMap utilise un bit pour représenter la valeur ou l'état correspondant à un élément. La clé est l'élément correspondant lui-même. En fait, la couche inférieure est également implémentée via le fonctionnement de chaînes. Redis a ajouté plusieurs commandes liées aux bitmaps telles que setbit, getbit, bitcount, etc. depuis la version 2.2.

opération de définition de bits

Valeur de décalage de clé SETBIT : définit le bit de décalage de la clé sur la valeur (1 ou 0)

# 使用 bitmap 来记录上述事例中一周的打卡记录如下所示:

# 周一:1,周二:0,周三:0,周四:1,周五:1,周六:0,周天:0 (1 为打卡,0 为不打卡)

127.0.0.1:6379> setbit sign 0 1

0

127.0.0.1:6379> setbit sign 1 0

0

127.0.0.1:6379> setbit sign 2 0

0

127.0.0.1:6379> setbit sign 3 1

0

127.0.0.1:6379> setbit sign 4 1

0

127.0.0.1:6379> setbit sign 5 0

0

127.0.0.1:6379> setbit sign 6 0

0

getbitObtenir une opération

GETBIT key offset Obtient la valeur définie par offset. Si elle n'est pas définie, elle renvoie 0 par défaut.

127.0.0.1:6379> getbit sign 3 # 查看周四是否打卡

1

127.0.0.1:6379> getbit sign 6 # 查看周七是否打卡

0

opération statistique de comptage de bits

bitcount key [start, end] compte le nombre de clés avec le bit supérieur 1

# 统计这周打卡的记录,可以看到只有3天是打卡的状态:

127.0.0.1:6379> bitcount sign

3

5. Redis.conf

1. Familiarisé avec la configuration de base

Emplacement

Le fichier de configuration Redis se trouve dans le répertoire d'installation Redis et le nom du fichier est redis.conf

config get * # 获取全部的配置

Adresse du fichier de configuration :

Dans des circonstances normales, nous ferons une copie séparée pour l'exploitation. pour assurer la sécurité du fichier initial.

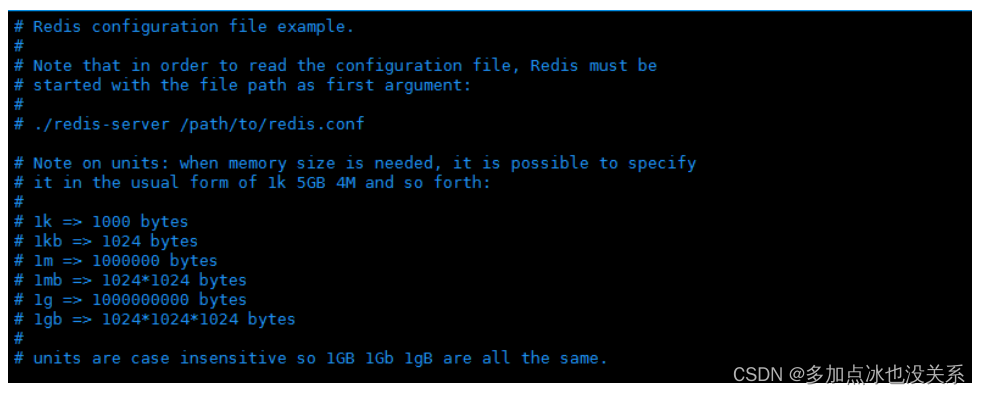

Unités Unités

1. Configurez les unités de taille. Certaines unités de mesure de base sont définies au début. Seuls les octets sont pris en charge, les bits ne sont pas pris en charge.

2. Insensible aux majuscules et aux minuscules

COMPREND contient

Semblable au fichier de configuration Spring, il peut être inclus via include. redis.conf peut être utilisé comme fichier total et peut inclure d'autres fichiers !

Configuration du réseau RÉSEAU

bind 127.0.0.1 # 绑定的ip

protected-mode yes # 保护模式

port 6379 # 默认端口

GÉNÉRAL Général

daemonize yes # 默认情况下,Redis不作为守护进程运行。需要开启的话,改为 yes

supervised no # 可通过upstart和systemd管理Redis守护进程

pidfile /var/run/redis_6379.pid # 以后台进程方式运行redis,则需要指定pid 文件

loglevel notice # 日志级别。可选项有:

# debug(记录大量日志信息,适用于开发、测试阶段);

# verbose(较多日志信息);

# notice(适量日志信息,使用于生产环境);

# warning(仅有部分重要、关键信息才会被记录)。

logfile "" # 日志文件的位置,当指定为空字符串时,为标准输出

databases 16 # 设置数据库的数目。默认的数据库是DB 0

always-show-logo yes # 是否总是显示logo

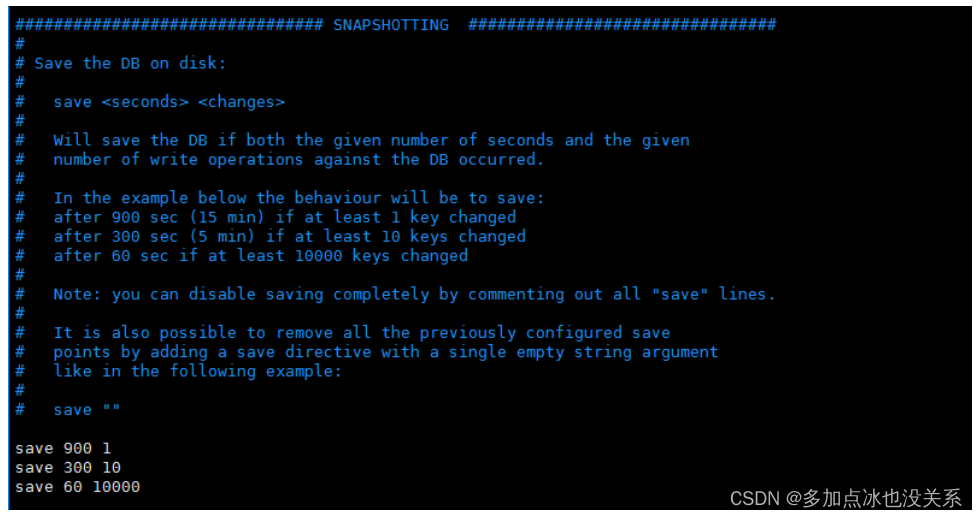

INSTANTANÉ INSTANTANÉ

# 900秒(15分钟)内至少1个key值改变(则进行数据库保存--持久化)

save 900 1

# 300秒(5分钟)内至少10个key值改变(则进行数据库保存--持久化)

save 300 10

# 60秒(1分钟)内至少10000个key值改变(则进行数据库保存--持久化)

save 60 10000

stop-writes-on-bgsave-error yes # 持久化出现错误后,是否依然进行继续进行工作

rdbcompression yes # 使用压缩rdb文件 yes:压缩,但是需要一些cpu的消耗。no:不压缩,需要更多的磁盘空间

rdbchecksum yes # 是否校验rdb文件,更有利于文件的容错性,但是在保存rdb文件的时候,会有大概10%的性能损耗

dbfilename dump.rdb # dbfilenamerdb文件名称

dir ./ # dir 数据目录,数据库的写入会在这个目录。rdb、aof文件也会写在这个目录

RÉPLICATION Nous parlerons plus tard de la réplication maître-esclave et vous l'expliquerons ! Sautez ici d'abord !

SÉCURITÉSécurité

Afficher, définir et annuler les mots de passe d'accès

# 启动redis

# 连接客户端

# 获得和设置密码

config get requirepass

config set requirepass "123456"

#测试ping,发现需要验证

127.0.0.1:6379> ping

NOAUTH Authentication required.

# 验证

127.0.0.1:6379> auth 123456

OK

127.0.0.1:6379> ping

PONG

limite

maxclients 10000 # 设置能连上redis的最大客户端连接数量

maxmemory <bytes> # redis配置的最大内存容量

maxmemory-policy noeviction # maxmemory-policy 内存达到上限的处理策略

#volatile-lru:利用LRU算法移除设置过过期时间的key。

#volatile-random:随机移除设置过过期时间的key。

#volatile-ttl:移除即将过期的key,根据最近过期时间来删除(辅以TTL)

#allkeys-lru:利用LRU算法移除任何key。

#allkeys-random:随机移除任何key。

#noeviction:不移除任何key,只是返回一个写错误。

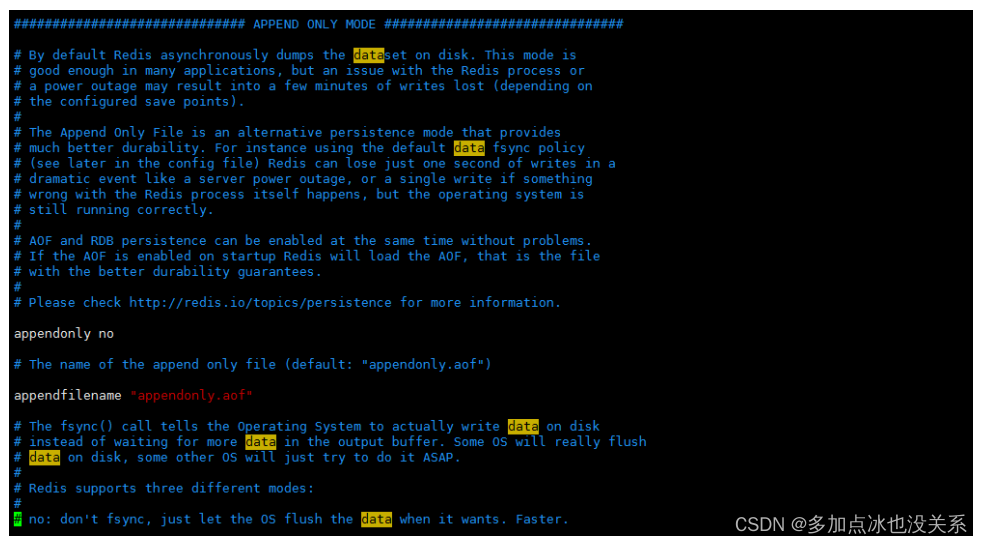

mode ajouter uniquement

appendonly no # 是否以append only模式作为持久化方式,默认使用的是rdb方式持久化,这种方式在许多应用中已经足够用了

appendfilename "appendonly.aof" # appendfilename AOF 文件名称

appendfsync everysec # appendfsync aof持久化策略的配置

# no表示不执行fsync,由操作系统保证数据同步到磁盘,速度最快。

# always表示每次写入都执行fsync,以保证数据同步到磁盘。

# everysec表示每秒执行一次fsync,可能会导致丢失这1s数据。

Nous expliquerons les détails plus tard lorsque nous expliquerons la configuration de persistance de Redis ! Comprenez d’abord, écoutez l’oreille !

2. Introduction aux configurations courantes

1. Redis ne s'exécute pas en tant que processus démon par défaut. Vous pouvez modifier cet élément de configuration et utiliser yes pour activer le processus démon.

démoniser non

2. Lorsque Redis s'exécute en mode démon, Redis écrira le pid par défaut dans le fichier /var/run/redis.pid, qui peut être spécifié via pidfile

fichier pid /var/run/redis.pid

3. Spécifiez le port d'écoute Redis. Le port par défaut est 6379. L'auteur a expliqué dans un de ses articles de blog pourquoi 6379 a été choisi comme port par défaut car 6379 est le numéro correspondant à MERZ sur le bouton du téléphone, et MERZ est extrait du nom de la chanteuse italienne Alessia Merz.

port 6379

4. L'adresse de l'hôte liée

lier 127.0.0.1

5. Lorsque le client est inactif pendant une longue période, la connexion est fermée. S'il est spécifié comme 0, cela signifie que cette fonction est désactivée.

délai d'attente 300

6. Spécifiez le niveau de journalisation. Redis prend en charge un total de quatre niveaux : débogage, détaillé, notification et avertissement. La valeur par défaut est détaillée.

niveau de journalisation verbeux

7. Mode de journalisation, la valeur par défaut est la sortie standard. Si Redis est configuré pour s'exécuter en mode démon et que le mode de journalisation est configuré comme sortie standard, le journal sera envoyé à /dev/null.

fichier journal, sortie standard

8. Définissez le nombre de bases de données. La base de données par défaut est 0. Vous pouvez utiliser la commande SELECT pour spécifier l'ID de la base de données sur la connexion.

bases de données 16

9. Spécifiez la période de temps et le nombre d'opérations de mise à jour pour synchroniser les données avec le fichier de données. Plusieurs conditions peuvent être remplies

Trois conditions sont fournies dans le fichier de configuration par défaut de save Redis :

save 900 1

save 300 10

save 60 10 000

signifie respectivement 1 changement en 900 secondes (15 minutes), 10 changements en 300 secondes (5 minutes) et 60 secondes. Il y a 10 000 changements .

10. Spécifiez s'il faut compresser les données lors de leur stockage dans la base de données locale. La valeur par défaut est oui. Redis utilise la compression LZF. Si vous souhaitez économiser du temps CPU, vous pouvez désactiver cette option, mais le fichier de base de données deviendra énorme.

rdbcompression oui

11. Spécifiez le nom du fichier de base de données locale. La valeur par défaut est dump.rdb.

nom de fichier db dump.rdb

12. Spécifiez le répertoire de stockage de la base de données locale

rép./

13. Définissez le moment où la machine locale dessert le service esclave, définissez l'adresse IP et le port du service maître. Lorsque Redis démarre, il synchronisera automatiquement les données du maître.

esclavede

14. Lorsque le service maître est protégé par mot de passe, le mot de passe permettant au service esclave de se connecter au maître

maîtreauth

15. Définissez le mot de passe de connexion Redis. Si le mot de passe de connexion est configuré, le client doit fournir le mot de passe via la commande AUTH lors de la connexion à Redis. Il est fermé par défaut.

exiger un laissez-passer foobaré

16. Définissez le nombre maximum de connexions client en même temps. La valeur par défaut est illimitée. Le nombre de connexions client que Redis peut ouvrir en même temps est le nombre maximum de descripteurs de fichiers que le processus Redis peut ouvrir. Si maxclients 0 est défini, cela signifie qu’il n’y a pas de limite. Lorsque le nombre de connexions client atteint la limite, Redis fermera la nouvelle connexion et renverra le message d'erreur du nombre maximum de clients atteint au client.

clients max 128

17. Spécifiez la limite de mémoire maximale de Redis. Redis chargera les données dans la mémoire au démarrage. Après avoir atteint la mémoire maximale, Redis tentera d'abord d'effacer les clés qui ont expiré ou sont sur le point d'expirer. Une fois cette méthode traitée, la mémoire maximale est encore atteinte, les réglages, les écritures ne seront plus possibles, mais les lectures seront toujours possibles. Le nouveau mécanisme vm de Redis stockera la clé en mémoire et la valeur dans la zone d'échange.

mémoire maximale

18. Spécifiez s'il faut effectuer la journalisation après chaque opération de mise à jour. Redis écrit les données sur le disque de manière asynchrone par défaut. S'il n'est pas activé, les données peuvent être perdues pendant un certain temps lors d'une panne de courant. Étant donné que les fichiers de données synchronisés de Redis sont synchronisés selon les conditions de sauvegarde ci-dessus, certaines données n'existeront en mémoire que pendant un certain temps. La valeur par défaut est non

en annexe seulement non

19. Spécifiez le nom du fichier journal de mise à jour, la valeur par défaut est appendonly.aof

appendfilename appendonly.aof

20. Spécifiez les conditions du journal de mise à jour. Il existe 3 valeurs facultatives :

non : signifie attendre que le système d'exploitation synchronise le cache de données sur le disque (rapide)

toujours : signifie appeler manuellement fsync() pour écrire les données sur le disque après chaque opération de mise à jour (lent, sûr)

toutes les secondes : signifie synchroniser une fois par seconde (compromis, valeur par défaut))

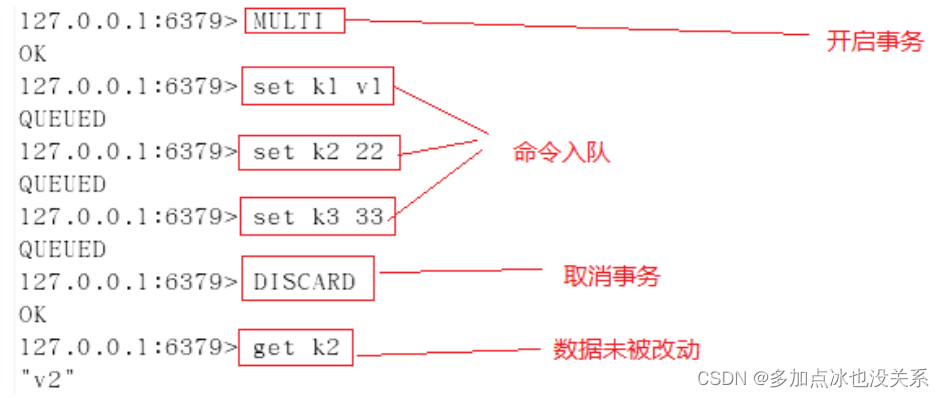

appendfsync chaque seconde