1. Introducción a nginx

- ¿Qué es nginx y qué puede hacer?

Nginx es un servidor web proxy inverso y HTTP de alto rendimiento. Es muy potente en el manejo de alta concurrencia y puede soportar pruebas de alta carga. Algunos informes muestran que puede admitir hasta 50,000 conexiones simultáneas.

Su característica es que ocupa menos memoria y tiene una fuerte capacidad de concurrencia. De hecho, la capacidad de concurrencia de nginx funciona mejor entre servidores web similares. Los usuarios de sitios web nginx en China continental incluyen: Baidu, JD.com, Sina, NetEase, Tencent , Taobao, etc

2. Nginx como servidor web

Nginx se puede utilizar como servidor web para páginas estáticas, y también admite lenguajes dinámicos del protocolo CGI, como perl y php. Pero Java no es compatible. Los programas Java solo se pueden completar cooperando con Tomcat. Nginx está especialmente desarrollado para la optimización del rendimiento. El rendimiento es su consideración más importante. La implementación es muy eficiente y puede soportar la prueba de alta carga. Según los informes, puede admitir hasta 50,000 conexiones simultáneas.

https://lnmp.org/nginx.html

3. Proxy directo

Nginx no solo puede actuar como un proxy inverso para lograr el equilibrio de carga. También se puede utilizar como proxy de reenvío para realizar funciones como navegar por Internet. Proxy de reenvío: si Internet fuera de la LAN se imagina como un gran grupo de recursos, el cliente de la LAN necesita acceder a Internet a través de un servidor proxy.Este tipo de servicio de proxy se denomina proxy de reenvío.

Simple: el proceso de acceder al servidor a través de un servidor proxy se denomina proxy de reenvío.

Es necesario configurar un servidor proxy en el cliente para acceder al sitio web especificado

4. Proxy inverso

Proxy inverso, de hecho, el cliente no es consciente del proxy, porque el cliente puede acceder sin ninguna configuración.

Solo necesitamos enviar la solicitud al servidor proxy inverso. Después de que el servidor proxy inverso selecciona el servidor de destino para obtener los datos, regresa al cliente. En este momento, el servidor proxy inverso y el servidor de destino son un servidor externo, y el servidor proxy tiene una dirección expuesta, lo que oculta la dirección IP real del servidor.

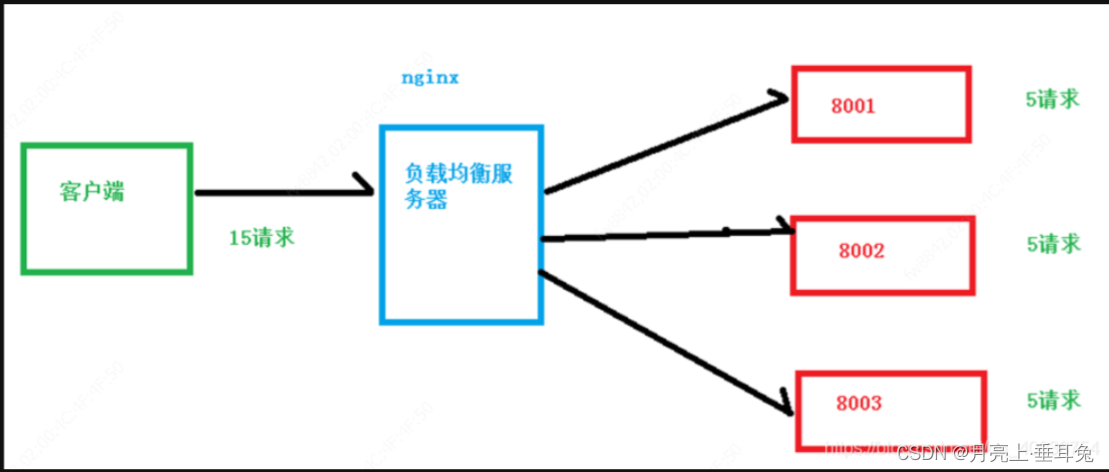

5. El equilibrio de carga

aumenta la cantidad de servidores y luego distribuye las solicitudes a cada servidor, cambiando la solicitud original a un solo servidor para distribuir las solicitudes a varios servidores y distribuir la carga a diferentes servidores, es decir, nuestro llamado balanceo de carga

El cliente envía varias solicitudes al servidor y el servidor procesa las solicitudes, algunas de las cuales pueden necesitar interactuar con la base de datos. Una vez que el servidor termina de procesar, devuelve los resultados al cliente.

这种架构模式对于早期的系统相对单一,并发请求相对较少的情况下是比较适合的,成 本也低。但是随着信息数量的不断增长,访问量和数据量的飞速增长,以及系统业务的复杂 度增加,这种架构会造成服务器相应客户端的请求日益缓慢,并发量特别大的时候,还容易 造成服务器直接崩溃。很明显这是由于服务器性能的瓶颈造成的问题,那么如何解决这种情 况呢?

我们首先想到的可能是升级服务器的配置,比如提高 CPU 执行频率,加大内存等提高机 器的物理性能来解决此问题,但是我们知道摩尔定律的日益失效,硬件的性能提升已经不能 满足日益提升的需求了。最明显的一个例子,天猫双十一当天,某个热销商品的瞬时访问量 是极其庞大的,那么类似上面的系统架构,将机器都增加到现有的顶级物理配置,都是不能 够满足需求的。那么怎么办呢?上面的分析我们去掉了增加服务器物理配置来解决问题的办法,也就是说纵向解决问题 的办法行不通了,那么横向增加服务器的数量呢?这时候集群的概念产生了,单个服务器解 决不了,我们增加服务器的数量,然后将请求分发到各个服务器上,将原先请求集中到单个服务器上的情况改为将请求分发到多个服务器上,将负载分发到不同的服务器,也就是我们 所说的负载均衡

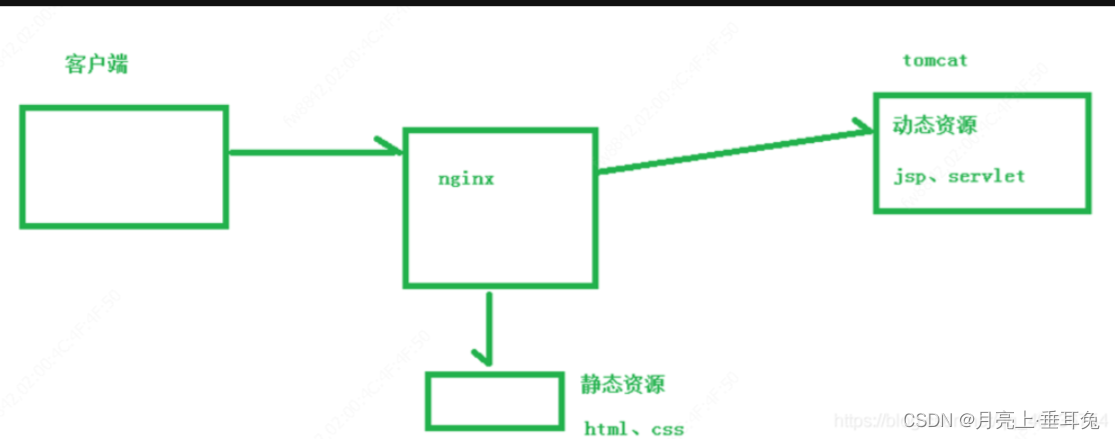

6. Separación de estática y dinámica

Para acelerar la velocidad de análisis del sitio web, diferentes servidores pueden analizar páginas dinámicas y páginas estáticas para acelerar la velocidad de análisis. Reduzca la presión sobre el servidor único original.

2. Instalación de Nginx (Linux: centos como ejemplo)

Al instalar nginx, preparé todos los paquetes utilizados para facilitar su uso:

https://download.csdn.net/download/qq_40036754/11891855

Originalmente quería poner Baidu Cloud Sí, pero es problemático, así que lo subí directamente a mis recursos, y también puedes contactarme directamente y te lo daré directamente.

- Preparativos

Abra la máquina virtual y use finalshell para conectarse al sistema operativo Linux

Vaya a nginx para descargar el software

http://nginx.org/

Instale primero su software dependiente y finalmente instale nginx.

Herramientas dependientes: pcre-8.3.7.tar.gz, openssl-1.0.1t.tar.gz, zlib-1.2.8.tar.gz, nginx-1.11.1.tar.gz. También lo proporciono aquí.

El módulo http de nginx usa pcre para analizar expresiones regulares. Es necesario instalar la biblioteca pcre en linux.

nginx usa zlib para gzip el contenido del paquete http. Es necesario instalar la biblioteca zlib en linux e instalar

la biblioteca openssl para que nginx admita https (es decir, en ssl HTTP sobre el protocolo

- Hay dos formas de iniciar la instalación

, una es descargar directamente y la otra es usar el paquete de descompresión. La mayoría de los paquetes de descompresión se utilizan aquí.

Mi ruta de instalación: /usr/feng/ Para

la instalación del sistema Mac, vaya aquí (no es muy diferente de la instalación de Linux): Tutorial de nginx de instalación de Mac os (éxito)

Instale pcre

Método 1, wget http://downloads.sourceforge. net/proyecto/pcre/pcre/8.37/pcre-8.37.tar.gz.

Fang 12. Cargue el paquete de código fuente comprimido, descomprima, compile e instale la trilogía.

1), descomprima el archivo, ingrese al directorio pcre,

2), después de completar ./configure,

3), ejecute el comando: make && make install

install openssl

download OpenSSL dirección:

http://distfiles.macports.org/openssl /

1), descomprima el archivo, regrese al directorio openssl,

2), después de completar ./configure,

3), ejecute el comando: make && make install install

zlib

1), descomprima el archivo, regrese al directorio zlib,

2), ./configure se completa Después de eso,

3), ejecute el comando: make && make install

**Install nginx**

1), descomprima el archivo, regrese al directorio nginx,

2) Después de completar ./configure,

3) Ejecute el comando: make && make install - Después de ejecutar nginx

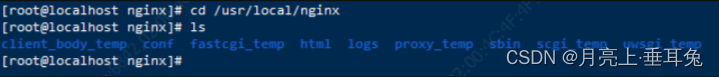

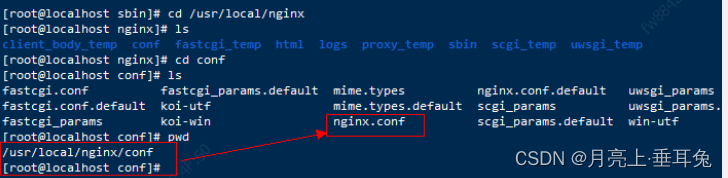

e instalar nginx, la carpeta nginx se generará automáticamente en la ruta /usr/local. Esto se genera automáticamente.

Ingrese a este directorio:

cd /usr/local/nginx

El contenido del directorio es el siguiente:

- Ingresa a la carpeta sbin, hay dos archivos:

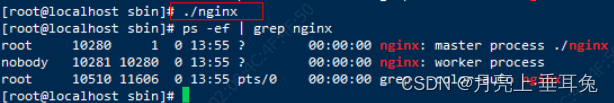

nginxynginx.old. - Comando de ejecución: se puede ejecutar ./nginx

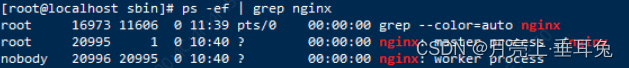

- Inicio de la prueba: ps -ef | grep nginx

- Ya iniciado.

- Verifique el puerto predeterminado de nginx (el predeterminado es 80) y use el formulario de la página web para probar (como Tomcat).

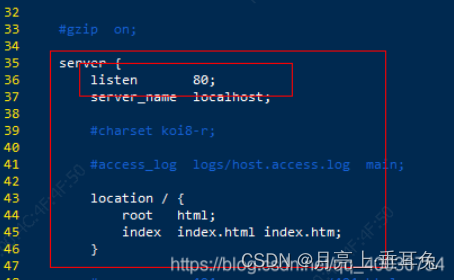

- Ingrese al directorio para ver el puerto: cd /usr/local/nginx/conf debajo del archivo nginx.conf . Este archivo también es el archivo de configuración de nginx. Bajo vim:

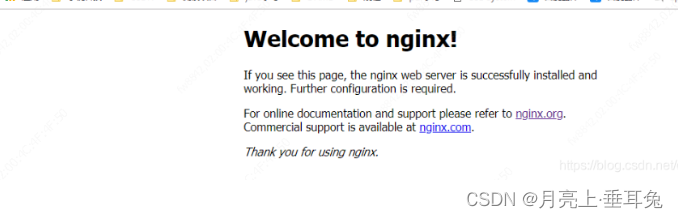

Ingrese la dirección IP: 80, se mostrará:

4. Problemas con el cortafuegos

Para acceder a nginx en Linux en el sistema Windows, no se puede acceder de forma predeterminada debido a problemas con el firewall (1) Cierre el firewall (2) Abra el número de puerto para acceder, puerto 80

Ver números de puerto abiertos

firewall-cmd --list-all

Establecer el número de puerto abierto

firewall-cmd --add-service=http –permanent

firewall-cmd --add-port=80/tcp --permanent

reiniciar cortafuegos

firewall-cmd –reload

3. Comandos comunes y archivos de configuración de Nginx

1. Comandos comunes de Nginx

a. Requisitos previos para usar nginx para operar comandos

El requisito previo para usar los comandos de operación de nginx: debe ingresar a la carpeta /sbin en el directorio generado automáticamente de nginx .

Nginx tiene dos directorios:

el primero : el directorio de instalación, lo pongo en:

/usr/opt/

El segundo : generar automáticamente el directorio:

/usr/local/nginx/

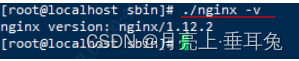

b. Ver el número de versión de nginx

./nginx -v

C. Inicie nginx

./nginx

D. Cerrar nginx

./nginx -s stop

E. Recargar nginx

Ejecute el comando en el directorio: /usr/local/nginx/sbin , sin reiniciar el servidor, se compilará automáticamente.

./nginx -s reload

2. Archivo de configuración de Nginx

a. Ubicación del archivo de configuración

/usr/local/nginx/conf/nginx.conf

B. Componentes de nginx

Hay muchos # en el archivo de configuración, los que están al principio indican el contenido del comentario, eliminamos todos los párrafos que comienzan con #, el contenido simplificado es el siguiente:

worker_processes 1;

events {

worker_connections 1024;

}

http {

include mime.types;

default_type application/octet-stream;

sendfile on;

keepalive_timeout 65;

server {

listen 80;

server_name localhost;

location / {

root html;

index index.html index.htm;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

}

- El archivo de configuración de nginx consta de tres partes

Parte 1: Bloques globales

Desde el archivo de configuración hasta el contenido entre el bloque de eventos, se establecerán algunas instrucciones de configuración que afectan el funcionamiento general del servidor nginx, que incluyen principalmente la configuración del usuario (grupo) que ejecuta el servidor Nginx, la cantidad de procesos de trabajo que se pueden generar , la ruta de almacenamiento del PID del proceso y la ruta y el tipo de almacenamiento del registro, la importación de archivos de configuración, etc.

Por ejemplo, la configuración en la primera línea de arriba:

worker_processes 1;

Esta es la configuración clave del servicio de procesamiento concurrente del servidor Nginx. Cuanto mayor sea el valor de worker_processes, más procesamiento concurrente puede soportar, pero estará restringido por hardware, software y otros dispositivos.

La segunda parte: el bloque de eventos

Por ejemplo, la configuración anterior

events {

worker_connections 1024;

}

Las instrucciones involucradas en el bloque de eventos

afectan principalmente a la conexión de red entre el servidor Nginx y el usuario. Las configuraciones comúnmente utilizadas incluyen habilitar la serialización de conexiones de red bajo múltiples procesos de trabajo, permitir que se reciban múltiples conexiones de red al mismo tiempo, y qué modelo basado en eventos elegir para procesar solicitudes de conexión, la cantidad máxima de conexiones que cada proceso de texto puede admitir al mismo tiempo, etc. **

El ejemplo anterior indica que la cantidad máxima de conexiones admitidas por cada proceso de trabajo es 1024.

Esta parte de la configuración tiene un gran impacto en el rendimiento de Nginx y debe configurarse de manera flexible en la práctica.

la tercera parte:

http { incluir mimo.tipos; aplicación de tipo_predeterminado/flujo de octetos; enviar archivo en; keepalive_timeout 65;

server {

listen 80;

server_name localhost;

location / {

root html;

index index.html index.htm;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root html;

}

}

Esta es la parte más frecuente de la configuración del servidor Nginx, donde se configuran la mayoría de las funciones, como definiciones de proxy, caché y registro y módulos de terceros.

Cabe señalar que: el bloque http también puede incluir el bloque global http y el bloque del servidor.

bloque global http

Las instrucciones de configuración del bloque global http incluyen importación de archivos, definición de MIME-TYPE, personalización de registros, tiempo de espera de conexión, número máximo de solicitudes de enlace único, etc.

Bloque servidor

Este bloque está estrechamente relacionado con el host virtual. Desde el punto de vista del usuario, el host virtual es exactamente igual que un host de hardware independiente. Esta tecnología fue creada para ahorrar el costo del hardware del servidor de Internet.

Cada bloque http puede incluir múltiples bloques de servidor y cada bloque de servidor es equivalente a un host virtual.

Cada bloque de servidor también se divide en bloques de servidor globales y puede contener varios bloques de ubicación al mismo tiempo.

La configuración más común del bloque de servidor global

es la configuración de monitoreo del host de la máquina virtual y el nombre o la configuración de IP del host virtual.

bloque de ubicación

Un bloque de servidor puede configurar múltiples bloques de ubicación.

La función principal de este bloque se basa en la cadena de solicitud (como server_name/uri-string) recibida por el servidor Nginx y la cadena que no sea el nombre del host virtual (o el alias de IP) (como el anterior /uri-string ) Match para procesar una solicitud específica. Aquí también se realizan funciones como la orientación de direcciones, el almacenamiento en caché de datos y el control de respuesta, así como la configuración de muchos módulos de terceros.