title: 数据结构与算法之美总结(数组、链表、栈、队列、递归、排序及二分)

date: 2023-04-15 01:41:26

tags:

- 数据结构

- 算法

categories: - 数据结构与算法

cover: https://cover.png

feature: false

1. 前言

1、什么是数据结构?什么是算法?

- 从广义上讲,数据结构就是指一组数据的存储结构。算法就是操作数据的一组方法

- 从狭义上讲,是指某些著名的数据结构和算法,比如队列、栈、堆、二分查找、动态规划等。这些都是前人智慧的结晶,可以直接拿来用。这些经典数据结构和算法,都是前人从很多实际操作场景中抽象出来的,经过非常多的求证和检验,可以高效地帮助我们解决很多实际的开发问题

2、数据结构和算法有什么关系呢?

数据结构是为算法服务的,算法要作用在特定的数据结构之上。 因此,我们无法孤立数据结构来讲算法,也无法孤立算法来讲数据结构

比如,因为数组具有随机访问的特点,常用的二分查找算法需要用数组来存储数据。但如果选择链表这种数据结构,二分查找算法就无法工作了,因为链表并不支持随机访问

数据结构是静态的,它只是组织数据的一种方式。如果不在它的基础上操作、构建算法,孤立存在的数据结构就是没用的

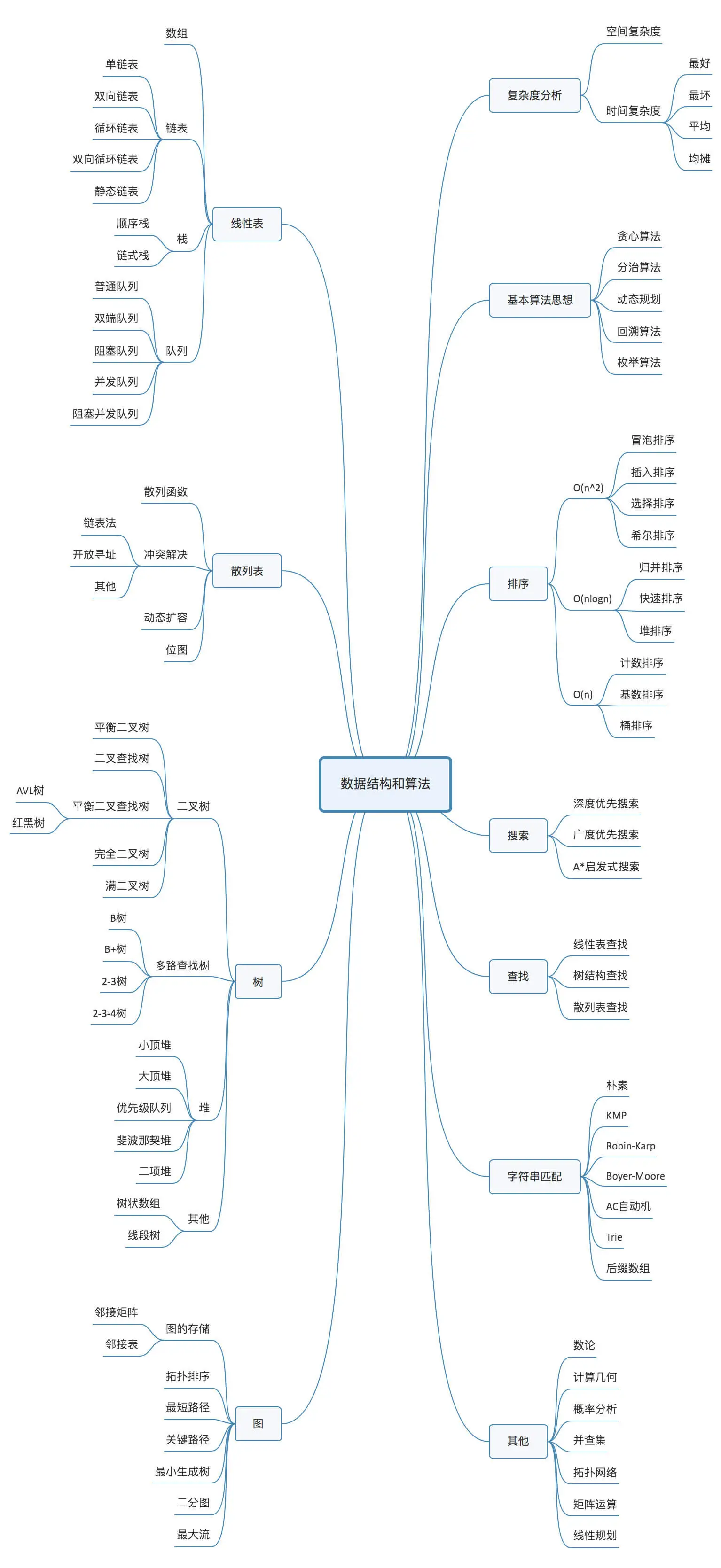

大部分数据结构和算法知识点如下图所示:

这里面有

- 10 个数据结构:数组、链表、栈、队列、散列表、二叉树、堆、跳表、图、Trie 树

- 10 个算法:递归、排序、二分查找、搜索、哈希算法、贪心算法、分治算法、回溯算法、动态规划、字符串匹配算法

掌握了这些基础的数据结构和算法,再学更加复杂的数据结构和算法,就会非常容易、非常快

2. 复杂度分析

La estructura de datos y el algoritmo en sí resuelven el problema de "rápido" y "ahorro", es decir, cómo hacer que el código se ejecute más rápido y cómo hacer que el código ahorre espacio de almacenamiento. Por lo tanto, la eficiencia de ejecución es una consideración muy importante para el algoritmo. Entonces, ¿cómo medir la eficiencia de ejecución del código del algoritmo que escribe? Aquí se utiliza el análisis de complejidad de tiempo y espacio.

2.1 ¿Por qué es necesario el análisis de complejidad?

Puede estar un poco confundido, ejecute el código una vez y, a través de estadísticas y monitoreo, puede obtener el tiempo de ejecución del algoritmo y el tamaño de memoria que ocupa. ¿Por qué hacer análisis de complejidad de tiempo y espacio? ¿Puede este método de análisis ser más preciso que los datos obtenidos al volver a ejecutarlo?

En primer lugar, es seguro decir que este método de evaluación de la eficiencia de la ejecución del algoritmo es correcto. Muchos libros de estructuras de datos y algoritmos también le dieron un nombre a este método, llamado estadísticas post hoc . Sin embargo, este método estadístico tiene limitaciones muy grandes.

1. Los resultados de la prueba dependen mucho del entorno de prueba.

La diferencia de hardware en el entorno de prueba tendrá un gran impacto en los resultados de la prueba. Por ejemplo, tome el mismo fragmento de código y ejecútelo con un procesador Intel Core i9 y un procesador Intel Core i3. No hace falta decir que el procesador i9 se ejecuta mucho más rápido que el procesador i3. Además, por ejemplo, la velocidad de ejecución del código a en esta máquina es más rápida que la del código b, y cuando se cambia a otra máquina, puede haber resultados completamente opuestos.

2. Los resultados de las pruebas se ven muy afectados por el tamaño de los datos

Para el mismo algoritmo de ordenación, el grado de ordenación de los datos a ordenar es diferente y el tiempo de ejecución de la ordenación será muy diferente. En casos extremos, si los datos ya están en orden, el algoritmo de clasificación no necesita hacer nada y el tiempo de ejecución será muy corto. Además, si la escala de datos de prueba es demasiado pequeña, es posible que los resultados de la prueba no reflejen realmente el rendimiento del algoritmo. Por ejemplo, para la clasificación de datos a pequeña escala, la clasificación por inserción puede ser más rápida que la clasificación rápida.

Por lo tanto, necesitamos un método que pueda estimar aproximadamente la eficiencia de ejecución del algoritmo sin usar datos de prueba específicos para probar . Este es el método de análisis de complejidad de tiempo y espacio.

2.2 Notación de complejidad Big O

La eficiencia de ejecución de un algoritmo, en términos generales, es el tiempo de ejecución del código del algoritmo. Pero, ¿cómo obtener el tiempo de ejecución de un código a simple vista sin ejecutar el código?

Aquí hay un código muy simple para encontrar 1, 2, 3, 4... n {1, 2, 3, 4... n}1 ,2 ,3 ,4... La suma acumulada de n , ahora, calculemos el tiempo de ejecución de este código

int cal(int n) {

int sum = 0;

int i = 1;

for (; i <= n; ++i) {

sum = sum + i;

}

return sum;

}

Desde la perspectiva de la CPU, cada línea de este código realiza una operación similar: leer datos-operar-escribir datos. Aunque el número de ejecuciones de CPU y el tiempo de ejecución correspondiente a cada línea de código son diferentes, esto es solo una estimación aproximada, por lo que se puede suponer que el tiempo de ejecución de cada línea de código es el mismo, que es unit_time. Según esta suposición, ¿cuál es el tiempo total de ejecución de este código?

Las líneas de código 2 y 3 requieren 1 tiempo de ejecución unit_time respectivamente, y las líneas 4 y 5 se ejecutan n veces, por lo que se necesitan 2 n ∗ unidad _ tiempo {2n*unidad\_tiempo}2 norte∗u ni t _ t im e tiempo de ejecución, por lo que el tiempo total de ejecución de este código es( 2 n + 2 ) ∗ unidad _ tiempo (2n+2)*unidad\_tiempo( 2 norte+2 )∗uni t_t im e . _ _ _ Se puede ver que el tiempo de ejecución de todos los códigos esT ( n ) T_{\left(n \right)}T( n )Proporcional al número de ejecuciones por línea de código

De acuerdo con esta idea de análisis, mire este código nuevamente

int cal(int n) {

int sum = 0;

int i = 1;

int j = 1;

for (; i <= n; ++i) {

j = 1;

for (; j <= n; ++j) {

sum = sum + i * j;

}

}

}

Todavía se supone que el tiempo de ejecución de cada declaración es unit_time. Entonces el tiempo total de ejecución de este código T ( n ) T_{\left(n \right)}T( n )¿Cuánto cuesta?

Cada una de las líneas de código 2, 3 y 4 requiere 1 unidad de tiempo para ejecutarse, y las líneas de código 5 y 6 se ejecutan n veces, lo que requiere 2 n ∗ unidad _ tiempo {2n * unidad\_tiempo}2 norte∗El tiempo de ejecución de uni t _ t im e , las líneas 7 y 8 del bucle de código ejecutado n 2 n^2norte2 veces, entonces necesitamos2 n 2 ∗ unidad _ tiempo {2n^2}*unidad\_tiempo2 norte2∗u ni t_time tiempo de ejecución . _ Por lo tanto, el tiempo total de ejecución de todo el códigoT ( n ) = ( 2 n 2 + 2 n + 3 ) ∗ unidad _ tiempo T_{\left(n \right)} = (2n^2 +2n+3)*unidad\_tiempoT( n )=( 2 norte2+2 norte+3 )∗u ni t _ tiempo _ _

Aunque no se conoce el valor específico de unit_time, se puede obtener una regla muy importante mediante el proceso de derivación del tiempo de ejecución de estos dos códigos, es decir, el tiempo de ejecución T(n) de todos los códigos es proporcional a los tiempos de ejecución n de cada línea de código

Resume esta ley en una fórmula: T ( n ) = O ( f ( n ) ) T_{\left( n \right)} = O{(f_{\left( n \right)})}T( n )=O ( f( n ))

Entre ellos, $T_{\left(n \right)} $ representa el tiempo de ejecución del código; n representa el tamaño de la escala de datos; f ( n ) f_{\left(n \right )}F( n )Indica la suma del número de veces que se ejecuta cada línea de código. Como esta es una fórmula, usa f ( n ) f_{\left(n \right)}F( n )Representar. O en la fórmula significa el tiempo de ejecución del código $T_{\left(n \right)} $ y f ( n ) f_{\left(n \right)}F( n )La expresión es proporcional a

Entonces, T ( n ) = O ( 2 n + 2 ) T_{\left(n \right)} = O{(2n+2)} en el primer ejemploT( n )=O ( 2n _+2 ) , T ( n ) = O ( 2 n 2 + 2 n + 3 ) T_{\left(n \right)} = O{(2n^2 + 2n + 3)} en el segundoejemploT( n )=O ( 2n _2+2 norte+3 ) . Esta es la notación de complejidad de tiempo de Big O. La complejidad temporal de Big O en realidad no representa específicamente el tiempo de ejecución real del código, pero representa la tendencia de cambio del tiempo de ejecución del código con el crecimiento de la escala de datos, por lo que también se denomina complejidad temporal asintótica o complejidad temporal para abreviar.

Cuando n es grande, puedes considerarlo como 10000, 100000. Sin embargo, las partes de bajo nivel, constante y coeficiente de la fórmula no afectan la tendencia de crecimiento, por lo que pueden ignorarse. Solo necesita registrar una magnitud máxima. Si usa la notación O grande para expresar la complejidad temporal de las dos piezas de código que acabamos de mencionar, se puede registrar como: T ( n ) = O ( n ) T_{\left(n \right)} = O(n )T( n )=O ( norte );T ( norte ) = O ( norte 2 ) T_{\izquierda(n \derecha)} = O(n^2)T( n )=O ( n2 )

2.3 Análisis de la Complejidad del Tiempo

El origen y la representación de la complejidad temporal de Big O se introdujeron anteriormente. Ahora veamos, ¿cómo analizar la complejidad temporal de una pieza de código?

1. Solo preste atención al código con la mayor cantidad de tiempos de ejecución de bucle

El método de representación de complejidad de Big O es solo una tendencia de cambio. Por lo general, las constantes, el orden bajo y los coeficientes en la fórmula se ignoran y solo se necesita registrar la magnitud del orden más grande. Por lo tanto, al analizar la complejidad temporal de un algoritmo o una pieza de código, solo preste atención a la pieza de código con la mayor cantidad de tiempos de ejecución de bucle. La magnitud de n en la cantidad de veces que se ejecuta este código central es la complejidad temporal de todo el código que se analizará

Como el ejemplo anterior:

int cal(int n) {

int sum = 0;

int i = 1;

for (; i <= n; ++i) {

sum = sum + i;

}

return sum;

}

La segunda y tercera líneas de código son tiempo de ejecución de nivel constante, que no tiene nada que ver con el tamaño de n, por lo que no tiene efecto sobre la complejidad. Los códigos en las líneas 4 y 5 son los que tienen más tiempos de ejecución de bucle, por lo que este fragmento de código debe analizarse enfáticamente. Estas dos líneas de código se ejecutan n veces, por lo que la complejidad de tiempo total es O ( n ) O(n)O ( n )

2. Regla de la suma: la complejidad total es igual a la complejidad del código de mayor magnitud

Por ejemplo:

int cal(int n) {

int sum_1 = 0;

int p = 1;

for (; p < 100; ++p) {

sum_1 = sum_1 + p;

}

int sum_2 = 0;

int q = 1;

for (; q < n; ++q) {

sum_2 = sum_2 + q;

}

int sum_3 = 0;

int i = 1;

int j = 1;

for (; i <= n; ++i) {

j = 1;

for (; j <= n; ++j) {

sum_3 = sum_3 + i * j;

}

}

return sum_1 + sum_2 + sum_3;

}

Este código se divide en tres partes, a saber, sum_1, sum_2, sum_3. Puede analizar la complejidad temporal de cada parte por separado, luego juntarlas y luego tomar la de mayor magnitud como la complejidad de todo el código.

¿Cuál es la complejidad temporal del primer período? Este bucle de código se ejecuta 100 veces, por lo que es un tiempo de ejecución constante, que no tiene nada que ver con el tamaño de n

Aquí nuevamente, incluso si este código se repite 10 000 o 100 000 veces, siempre que sea un número conocido, independientemente de n, sigue siendo un tiempo de ejecución constante. Cuando n es infinito, se puede ignorar. Aunque tendrá un gran impacto en el tiempo de ejecución del código, volviendo al concepto de complejidad del tiempo, representa la tendencia de cambio de la eficiencia de ejecución de un algoritmo y el crecimiento de la escala de datos, por lo que no importa cuánto tiempo sea el tiempo de ejecución constante, puede ignorarse. Porque no tiene ningún efecto sobre la tendencia de crecimiento por sí mismo.

¿Cuál es la complejidad temporal de la segunda pieza de código y la tercera pieza de código? La respuesta es O ( n ) O(n)O ( n ) SumaO ( n 2 ) O(n^2)O ( n2 ), debería ser fácil de analizar, se combina la complejidad temporal de estas tres piezas de código y se toma el orden de magnitud más grande. Por lo tanto, la complejidad temporal de todo el código esO ( n ) O(n)O ( n ) . Es decir: la complejidad temporal total es igual a la complejidad temporal del código de mayor magnitud. Luego abstraiga esta regla en una fórmula:

如果T 1 ( n ) = O ( f ( n ) ) T1_{\left(n \right)} = O(f_{\left(n \right)})T 1( n )=O ( f( n )), T 2 ( n ) = O ( g ( n ) ) T2_{\left(n \right)} = O(g_{\left(n \right)}) T2(n)=O(g(n))。那么 T ( n ) = T 1 ( n ) + T 2 ( n ) = m a x ( O ( f ( n ) ) , O ( g ( n ) ) = O ( m a x ( O ( f ( n ) ) , O ( g ( n ) ) ) ) T_{\left(n \right)} = T1_{\left(n \right)} + T2_{\left(n \right)} = max(O(f_{\left(n \right)}), O(g_{\left(n \right)}) =O(max(O(f_{\left(n \right)}), O(g_{\left(n \right)}))) T(n)=T1(n)+T2(n)=max(O(f(n)),O(g(n))=O(max(O(f(n)),O(g(n))))

3、乘法法则:嵌套代码的复杂度等于嵌套内外代码复杂度的乘积

类比上面的加法法则,如果 T 1 ( n ) = O ( f ( n ) ) T1_{\left(n \right)} = O(f_{\left(n \right)}) T1(n)=O(f(n)), T 2 ( n ) = O ( g ( n ) ) T2_{\left(n \right)} = O(g_{\left(n \right)}) T2(n)=O(g(n))。那么 T ( n ) = T 1 ( n ) ∗ T 2 ( n ) = O ( f ( n ) ) ∗ O ( g ( n ) ) = O ( f ( n ) ∗ g ( n ) ) T_{\left(n \right)} = T1_{\left(n \right)} * T2_{\left(n \right)} = O(f_{\left(n \right)}) * O(g_{\left(n \right)}) = O(f_{\left(n \right)} * g_{\left(n \right)}) T(n)=T1(n)∗T2(n)=O(f(n))∗O(g(n))=O(f(n)∗g(n))

也就是说,假设如果 T 1 ( n ) = O ( n ) T1_{\left(n \right)} = O(n) T1(n)=O ( norte ) ,T 2 ( norte ) = O ( norte 2 ) T2_{\izquierda(n \derecha)} = O(n^2)T2 _( n )=O ( n2 ),则T 1 ( n ) ∗ T 2 ( n ) = O ( n 3 ) T1_{\left(n \right)} * T2_{\left(n \right)} = O(n^3)T 1( n )∗T2 _( n )=O ( n3 )

Para implementar el código específico, la regla de multiplicación se puede considerar como un bucle anidado, como en el siguiente ejemplo:

int cal(int n) {

int ret = 0;

int i = 1;

for (; i < n; ++i) {

ret = ret + f(i);

}

}

int f(int n) {

int sum = 0;

int i = 1;

for (; i < n; ++i) {

sum = sum + i;

}

return sum;

}

Véase cal()función sola. Asumiendo que f()es solo una operación ordinaria, la complejidad temporal de las líneas 4~6 es, T 1 ( n ) = O ( n ) T1_{\left(n \right)} = O(n)T 1( n )=O ( n ) . Perof()la función en sí no es una operación simple, su complejidad temporal esT 2 ( n ) = O ( n ) T2_{\left(n \right)} = O(n)T2 _( n )=O ( n ) , entonces,cal()la complejidad temporal de toda la función es,T 1 ( n ) ∗ T 2 ( n ) = O ( n ) ∗ O ( n ) = O ( n 2 ) T1_{\left(n \right)} * T2_{\left(n \right)} = O(n) * O(n) = O(n^2)T 1( n )∗T2 _( n )=O ( n )∗O ( n )=O ( n2 )

2.4 Análisis de varios ejemplos comunes de complejidad de tiempo

Las escalas de complejidad comunes son las siguientes:

- Orden constante: O ( 1 ) O(1)O ( 1 )

- Orden logarítmico: O ( logn ) O(log n)O ( iniciar sesión ) _ _

- Orden lineal: O ( n ) O(n)O ( n )

- Orden logarítmico lineal: O ( nlogn ) O(n logn)O ( n log n ) _ _

- Orden cuadrático: O ( n 2 ) O(n^2)O ( n2 )

- Orden cúbico: O ( n 3 ) O(n^3)O ( n3 )

- orden k: O ( nk ) O(n^k)O ( nk )

- Orden exponencial: O ( 2 n ) O(2^n)O ( 2norte )

- Paso factorial: O ( n ! ) O(n!)O ( n !)

Para la escala compleja enumerada anteriormente, se puede dividir aproximadamente en dos categorías, escala polinómica y escala no polinómica. Entre ellos, solo hay dos magnitudes no polinómicas: O ( 2 n ) O(2^n)O ( 2n )sumaO ( n ! ) O(n!)O ( n !)

Cuando el tamaño de los datos n aumenta, el tiempo de ejecución de los algoritmos de nivel no polinomial aumentará considerablemente y el tiempo de ejecución de la resolución de problemas aumentará infinitamente. Por lo tanto, los algoritmos con complejidad temporal no polinomial son en realidad algoritmos muy ineficientes.

1, O ( 1 ) O (1)O ( 1 )

Primero se debe aclarar un concepto, O ( 1 ) O(1)O ( 1 ) es solo una representación de la complejidad de tiempo de nivel constante, no que solo se ejecute una línea de código. Por ejemplo, este código, incluso con 3 líneas, su complejidad temporal esO ( 1 ) O(1)O ( 1 ) en lugar deO(3)O(3)O ( 3 )

int i = 8;

int j = 6;

int sum = i + j;

Siempre que el tiempo de ejecución del código no aumente con el aumento de n, la complejidad temporal del código se registra como O ( 1 ) O(1)O ( 1 ) . En otras palabras, en general, siempre que no haya declaraciones de bucle o recursivas en el algoritmo, incluso si hay miles de líneas de código, la complejidad del tiempo esO ( 1 ) O(1)O ( 1 )

2、O (inicio de sesión) O(inicio de sesión)O ( iniciar sesión ) 、 O (iniciar sesión) O (iniciar sesión )O ( n log n ) _ _

La complejidad de tiempo logarítmica es muy común, y también es la complejidad de tiempo más difícil de analizar, como en el siguiente ejemplo:

i = 1;

while (i <= n) {

i = i * 2;

}

De acuerdo con el método de análisis de complejidad mencionado anteriormente, la tercera línea de código es el ciclo que se ejecuta con mayor frecuencia. Por lo tanto, siempre que pueda calcular cuántas veces se ejecuta esta línea de código, puede conocer la complejidad temporal de todo el código.

Se puede ver en el código que el valor de la variable i comienza desde 1 y se multiplica por 2 en cada ciclo. Cuando es mayor que n, el ciclo termina. De hecho, el valor de la variable i es una sucesión geométrica. Si los enumera uno por uno, debería verse así: 2 0 2 1 2 2 . . . 2 x = n {2^0 \ 2^1 \ 2^2 \ ... \ 2^x = n}20 2 1 2 2 ...2 X=norte

Entonces, siempre que conozca el valor de x, sabrá la cantidad de veces que se ejecuta esta línea de código. por 2 x = norte {2^x = norte}2X=n Resolviendo x Este problema se debe aprender en la escuela secundaria,x = log 2 nx = log_2 nX=registro _ _2n , por lo que la complejidad temporal de este código esO (log 2 n) O(log_2 n)O ( log _ _2norte )

Ahora, cambie un poco el código y vea, ¿cuál es la complejidad temporal de este código?

i = 1;

while (i <= n) {

i = i * 3;

}

De acuerdo con la idea que acabamos de mencionar, es fácil ver que la complejidad temporal de este código es O (log 3 n) O(log_3 n)O ( log _ _3norte )

De hecho, independientemente de la base 2, la base 3 o la base 10, la complejidad temporal de todos los órdenes logarítmicos se puede registrar como O (logn) O(log n)O ( iniciar sesión n ) . _ _ ¿por qué?

Los logaritmos se pueden convertir entre sí, según la fórmula:

logab = logcblogca log_a b = {log_c b \over log_c a}registro _ _unb=registro _ _doaregistro _ _dosegundo

Disponible log 2 n = log 3 nlog 3 2 log_2 n = {log_3 n \over log_3 2}registro _ _2norte=registro _ _32registro _ _3n. Entonces log 3 n log_3 nregistro _ _3n es igual alog 3 2 ∗ log 2 n log_3 2 * log_2 nregistro _ _32∗registro _ _2n , porqueO ( log 3 n ) = O ( C ∗ log 2 n ) O(log_3 n) = O(C * log_2 n)O ( log _ _3norte )=O ( C∗registro _ _2n ) , dondeC = log 3 2 C=log_3 2C=registro _ _32 es una constante. Basado en una teoría anterior: Al usar O grande para marcar la complejidad, se puede ignorar el coeficiente, es decir,O ( C f ( n ) ) = O ( f ( n ) ) O(Cf_{\left(n \right)}) = O(f_{\left(n \right)})O ( C f( n ))=O ( f( n )) . Entonces,O ( log 3 n ) O (log_3 n)O ( log _ _3n ) es igual aO ( log 2 n ) O(log_2 n)O ( log _ _2n ) . Por lo tanto, en el método de expresión de la complejidad del tiempo logarítmico, la "base" del logaritmo se ignora y se expresa uniformemente comoO (logn) O(log n)O ( iniciar sesión ) _ _

Si entiende el O (logn) O (log n) mencionado anteriormenteO ( iniciar sesión ) , NO (iniciar sesión) O ( iniciar sesión)O ( n log n ) es fácil de entender . Si la complejidad temporal de un fragmento de código esO (log n) O(log n)O ( logn ) , ejecuta el ciclo n veces, la complejidad del tiempo es O ( nlogn ) O(nlog n)O ( n log n ) también . _ Además,O ( nlogn ) O(nlog n)O ( n log n ) es también una complejidad de tiempo de algoritmo muy común . Por ejemplo, la complejidad temporal de la ordenación por fusión y la ordenación rápida esO (nlogn) O(nlog n)O ( n log n ) _ _

3、O (m + n) O(m+n)O ( m+norte )、O ( metro ∗ norte ) O(m*n)O ( m∗norte )

Hablamos de una complejidad temporal diferente a la anterior, la complejidad del código está determinada por el tamaño de los dos datos, como se muestra en el siguiente ejemplo:

int cal(int m, int n) {

int sum_1 = 0;

int i = 1;

for (; i < m; ++i) {

sum_1 = sum_1 + i;

}

int sum_2 = 0;

int j = 1;

for (; j < n; ++j) {

sum_2 = sum_2 + j;

}

return sum_1 + sum_2;

}

Como puede verse en el código, m y n representan dos escalas de datos. Es imposible evaluar de antemano cuál de m y n tiene una magnitud mayor, por lo que al expresar complejidad, uno no puede simplemente usar la regla de la suma y omitir uno de ellos. Entonces, la complejidad temporal del código anterior es O ( m + n ) O(m+n)O ( m+norte )

En este caso, la regla de la suma original es incorrecta y la regla de la suma debe cambiarse a: T 1 ( m ) + T 2 ( n ) = O ( f ( n ) + g ( n ) ) T1_{\left(m \right)} + T2_{\left(n \right)} = O(f_{\left(n \right)} + g_{\left(n \right)})T 1( m )+T2 _( n )=O ( f( n )+gramo( n )) . Pero la regla de la multiplicación continúa:T 1 ( m ) ∗ T 2 ( n ) = O ( f ( n ) ∗ g ( n ) ) T1_{\left(m \right)} * T2_{\left(n \right)} = O(f_{\left(n \right)} * g_{\left(n \right)})T 1( m )∗T2 _( n )=O ( f( n )∗gramo( n ))

2.5 Análisis de la complejidad del espacio

Después de comprender el análisis de la complejidad del tiempo mencionado anteriormente, el método de análisis de la complejidad del espacio es muy sencillo de aprender.

El nombre completo de complejidad temporal es complejidad temporal asintótica, lo que significa la relación de crecimiento entre el tiempo de ejecución del algoritmo y el tamaño de los datos . Por analogía, el nombre completo de complejidad espacial es complejidad espacial asintótica (complejidad espacial asintótica), que representa la relación de crecimiento entre el espacio de almacenamiento del algoritmo y la escala de datos.

El siguiente ejemplo (generalmente nadie escribirá así, aquí es para facilitar la explicación)

void print(int n) {

int i = 0;

int[] a = new int[n];

for (i; i < n; ++i) {

a[i] = i * i;

}

for (i = n - 1; i >= 0; --i) {

print out a[i]

}

}

Similar al análisis de la complejidad del tiempo, podemos ver que en la segunda línea de código, se aplica una variable de almacenamiento de espacio i, pero es de orden constante y no tiene nada que ver con el tamaño de los datos n, por lo que puede ignorarse. La línea 3 aplica para una matriz de tipo int con tamaño n, aparte de eso, el resto del código no ocupa más espacio, por lo que la complejidad espacial de todo el código es O ( n ) O(n )O ( n )

La complejidad del espacio común es O ( 1 ) O(1)O ( 1 )、O (n) O (n)O ( norte ) ,O ( norte 2 ) O (n ^ 2)O ( n2 ), la imagenO (logn) O(logn)O ( iniciar sesión ) 、 O (iniciar sesión) O (iniciar sesión )La complejidad logarítmica como O ( n log n ) generalmente no se usa. Además, el análisis de la complejidad del espacio es mucho más simple que el análisis de la complejidad del tiempo.

2.6 Complejidad de tiempo de caso promedio mejor, peor y promedio

Veamos primero un ejemplo:

// n 表示数组 array 的长度

int find(int[] array, int n, int x) {

int i = 0;

int pos = -1;

for (; i < n; ++i) {

if (array[i] == x) pos = i;

}

return pos;

}

La función de este código es encontrar la posición donde aparece la variable x en un arreglo desordenado (array). Si no se encuentra, se devuelve -1. Según el método de análisis mencionado anteriormente, la complejidad de este código es O ( n ) O(n)O ( n ) donde n es la longitud de la matriz

Para encontrar una parte de los datos en una matriz, no es necesario recorrer toda la matriz cada vez, porque es posible finalizar el bucle antes de tiempo si se encuentra a la mitad. Sin embargo, este código no está escrito de manera suficientemente eficiente. Puede optimizar este código de búsqueda de esta manera:

// n 表示数组 array 的长度

int find(int[] array, int n, int x) {

int i = 0;

int pos = -1;

for (; i < n; ++i) {

if (array[i] == x) {

pos = i;

break;

}

}

return pos;

}

这个时候,问题就来了。优化完之后,这段代码的时间复杂度还是 O ( n ) O(n) O(n) 吗?很显然,前面讲的分析方法,解决不了这个问题

因为,要查找的变量 x 可能出现在数组的任意位置。如果数组中第一个元素正好是要查找的变量 x,那就不需要继续遍历剩下的 n-1 个数据了,那时间复杂度就是 O ( 1 ) O(1) O(1)。但如果数组中不存在变量 x,那就需要把整个数组都遍历一遍,时间复杂度就成了 O ( n ) O(n) O(n)。所以,不同的情况下,这段代码的时间复杂度是不一样的

为了表示代码在不同情况下的不同时间复杂度,需要引入三个概念:最好情况时间复杂度(best case time complexity)、最坏情况时间复杂度(worst case time complexity)和平均情况时间复杂度(average case time complexity)

- 顾名思义,最好情况时间复杂度就是,在最理想的情况下,执行这段代码的时间复杂度。就像刚刚讲到的,在最理想的情况下,要查找的变量 x 正好是数组的第一个元素,这个时候对应的时间复杂度就是最好情况时间复杂度

- 同理,最坏情况时间复杂度就是,在最糟糕的情况下,执行这段代码的时间复杂度。就像刚举的那个例子,如果数组中没有要查找的变量 x,需要把整个数组都遍历一遍才行,所以这种最糟糕情况下对应的时间复杂度就是最坏情况时间复杂度

La complejidad de tiempo del mejor de los casos y la complejidad del tiempo del peor de los casos corresponden a la complejidad del código en casos extremos, y la probabilidad de ocurrencia en realidad no es alta. Para representar mejor la complejidad del caso promedio, es necesario introducir otro concepto: la complejidad temporal promedio del caso, en lo sucesivo denominada complejidad temporal promedio.

¿Cómo analizar la complejidad del tiempo promedio? Todavía usando el ejemplo de encontrar la variable x justo ahora

La posición de la variable x que se encuentra en el arreglo tiene n+1 casos: está en la posición 0~n-1 del arreglo y no está en el arreglo. En cada caso, sume el número de elementos que se deben recorrer y luego divida por n+1 para obtener el número promedio de elementos que se deben recorrer. La fórmula es la siguiente (la suma de la secuencia aritmética es igual al primer elemento más el último elemento multiplicado por el número de elementos dividido por 2):

1 + 2 + 3 + . . . + n + nn + 1 = ( 1 + n ) × n 2 + nn + 1 = n + n 2 + 2 n 2 n + 1 = n ( n + 3 ) 2 ( n + 1 ) {1 + 2 + 3 + ... + n + n \over n + 1} = { {(1 + n) \times {n \over 2} + n} \over n + 1} = { {n + n^2 + 2n \sobre 2} \sobre n + 1} = {n(n + 3) \sobre 2(n+1 ) }norte+11+2+3+...+norte+n=norte+1( 1+norte )×2n+n=norte+12norte + norte2 +2n_=2 ( n+1 )norte _ _+3 )

En la notación O grande de la complejidad del tiempo, se pueden omitir los coeficientes, los órdenes bajos y las constantes. Por lo tanto, después de simplificar la fórmula anterior, la complejidad del tiempo promedio obtenida es O ( n ) O(n )O ( n )

Aunque esta conclusión es correcta, el proceso de cálculo es ligeramente problemático. ¿Cuál es el problema? Las n+1 situaciones mencionadas anteriormente tienen diferentes probabilidades

La variable x que se va a buscar está en la matriz o no está en la matriz. La probabilidad correspondiente a estas dos situaciones es engorrosa de contar. Para facilitar la comprensión, se supone que la probabilidad de estar en el arreglo y no estar en el arreglo es 1/2. Además, la probabilidad de que los datos a buscar aparezcan en las n posiciones de 0 a n-1 es la misma, que es 1/n. Por lo tanto, según la regla de la multiplicación de probabilidades, la probabilidad de que los datos a buscar aparezcan en cualquier posición entre 0 y n-1 es 1 2 n {1 \over 2n}2 norte1

Por lo tanto, el mayor problema en el proceso de derivación anterior es que no se tiene en cuenta la probabilidad de ocurrencia de varias situaciones. Si además se tiene en cuenta la probabilidad de ocurrencia de cada situación, el proceso de cálculo de la complejidad temporal media queda así:

1 × 1 2 norte + 2 × 1 2 norte + 3 × 1 2 norte + . . . + norte × 1 2 norte + norte × 1 2 = ( ( 1 + norte ) × norte 2 ) × 1 2 norte + norte 2 = norte + norte 2 4 norte + norte 2 = 3 norte + 1 4 1 \times {1 \over 2n} + 2 \times {1 \over 2n} + 3 \times {1 \over 2n} + ... + n \time s {1 \over 2n} + n \times {1 \over 2} = ((1 + n) \times {n \over 2}) \times {1 \over 2n} + {n \over 2} = {n + n^2 \over 4n} + {n \over 2} = {3n + 1 \over 4}1×2 norte1+2×2 norte1+3×2 norte1+...+norte×2 norte1+norte×21=(( 1+norte )×2n)×2 norte1+2n=4 nortenorte+norte2+2n=43 norte+1

Este valor es el promedio ponderado en la teoría de la probabilidad , también conocido como valor esperado , por lo que el nombre completo de complejidad de tiempo promedio debe llamarse complejidad de tiempo promedio ponderado o complejidad de tiempo esperado

Después de introducir la probabilidad, el promedio ponderado del código anterior es 3 n + 1 4 {3n + 1 \over 4}43 n + 1. Expresado en notación O grande, la complejidad temporal media ponderada de este código sigue siendo O ( n ) O(n)O ( n )

De hecho, en la mayoría de los casos, no hay necesidad de distinguir entre las complejidades de tiempo del caso mejor, peor y promedio. En muchos casos, el uso de una complejidad puede satisfacer las necesidades. Solo cuando la misma pieza de código tiene una diferencia de orden de magnitud en la complejidad del tiempo en diferentes circunstancias, estas tres representaciones de complejidad se utilizarán para distinguir

2.7 Complejidad del tiempo amortizado

Complejidad de tiempo, suena un poco como la complejidad de tiempo promedio. Como se mencionó anteriormente, en la mayoría de los casos, no es necesario distinguir entre la mejor, la peor y la complejidad promedio. La complejidad promedio solo se usa en algunos casos especiales, y los escenarios de aplicación de la complejidad del tiempo amortizado son más especiales y más limitados que ella, como en el siguiente ejemplo (solo por conveniencia de explicación, generalmente nadie lo escribirá así):

// array 表示一个长度为 n 的数组

// 代码中的 array.length 就等于 n

int[] array = new int[n];

int count = 0;

void insert(int val) {

if (count == array.length) {

int sum = 0;

for (int i = 0; i < array.length; ++i) {

sum = sum + array[i];

}

array[0] = sum;

count = 1;

}

array[count] = val;

++count;

}

Este código implementa una función para insertar datos en una matriz. Cuando la matriz está llena, es decir, en el código count == array.length, use el ciclo for para atravesar la matriz para sumar y borrar la matriz, coloque el valor de la suma después de la suma en la primera posición de la matriz y luego inserte nuevos datos. Pero si la matriz tiene espacio libre al principio, inserte los datos directamente en la matriz.

¿Cuál es la complejidad temporal de este código?

En el caso más ideal, hay espacio libre en la matriz, y solo es necesario insertar los datos en la posición donde se cuenta el subíndice de la matriz, por lo que la complejidad del tiempo es $ O(1) $ en el mejor de los casos. En el peor de los casos, no hay espacio libre en la matriz, y la matriz debe recorrerse y sumarse primero, y luego se insertan los datos, por lo que la complejidad del tiempo en el peor de los casos es O ( n ) O(n )O ( n )

¿Cuál es la complejidad del tiempo promedio? La respuesta es O ( 1 ) O(1)O ( 1 ) . Todavía se puede analizar a través del método de la teoría de la probabilidad mencionado anteriormente.

Suponiendo que la longitud de la matriz es n, según la posición de inserción de datos, se puede dividir en n casos, y la complejidad temporal de cada caso es O ( 1 ) O(1)O ( 1 ) . Además, existe una situación "extra", que consiste en insertar un dato cuando no hay espacio libre en la matriz. La complejidad temporal en este momento esO ( n ) O(n)O ( n ) . Además, la probabilidad de estas n+1 situaciones es la misma, todas son1 n + 1 {1 \over n+1}norte + 11. Por tanto, según el método de cálculo de la media ponderada, la complejidad temporal media obtenida es:

1 × 1 norte + 1 + 1 × 1 norte + 1 + . . . + norte × 1 norte + 1 = O ( 1 ) 1 \times {1 \sobre n + 1} + 1 \times {1 \sobre n + 1} + ... + n \times {1 \sobre n + 1} = O(1)1×norte+11+1×norte+11+...+norte×norte+11=O ( 1 )

Pero el análisis de complejidad promedio en este ejemplo no necesita ser tan complicado y no necesita introducir el conocimiento de la teoría de la probabilidad. ¿Por qué es esto? Primero comparemos este insert()ejemplo con el ejemplo anterior find(), encontrará que hay una gran diferencia entre los dos.

- En primer lugar,

find()la complejidad de la función es O ( 1 ) O(1) en casos extremosO ( 1 ) . Peroinsert()en la mayoría de los casos, la complejidad del tiempo esO ( 1 ) O(1)O ( 1 ) . Solo en unos pocos casos, la complejidad es relativamente alta,O ( n ) O(n)O ( n ) - Para

insert()la función, O ( 1 ) O(1)O ( 1 ) complejidad de tiempo para inserción yO ( n ) O(n)La inserción de la complejidad del tiempo O ( n ) , la frecuencia de ocurrencia es muy regular, y existe una cierta relación de tiempo antes y después, generalmente unO (n) O (n)Inserción O ( n ) seguida de n-1O ( 1 ) O(1)O ( 1 ) operación de inserción, itera una y otra vez

Por lo tanto, para el análisis de complejidad de una escena tan especial, no es necesario averiguar todas las situaciones de entrada y las probabilidades de ocurrencia correspondientes como en el método de análisis de complejidad promedio anterior, y luego calcular el promedio ponderado

Para este escenario especial, se introduce un método de análisis más simple: el método de análisis amortizado La complejidad temporal obtenida a través del análisis amortizado se denomina complejidad temporal amortizada

Entonces, ¿cómo utilizar el método de análisis amortizado para analizar la complejidad del tiempo amortizado del algoritmo?

Mire el ejemplo anterior de insertar datos en la matriz, cada vez que O ( n ) O(n)Las operaciones de inserción O ( n ) serán seguidas por n-1 vecesO ( 1 ) O(1)O ( 1 ) operación de inserción, por lo que la operación que consume más tiempo se distribuye uniformemente a las siguientes n-1 operaciones que consumen menos tiempo, y la complejidad de tiempo promedio de este grupo de operaciones continuas es O ( 1 ) O(1)O ( 1 ) . Esta es la idea general del análisis amortizado

Los escenarios de aplicación de la complejidad del tiempo amortizado y el análisis amortizado son relativamente especiales, por lo que no se utilizan con frecuencia.

En un grupo de operaciones continuas en una estructura de datos, la complejidad de tiempo es muy baja en la mayoría de los casos. Solo en algunos casos, la complejidad de tiempo es relativamente alta, y existe una relación de tiempo coherente entre estas operaciones. En este momento, este grupo de operaciones se puede analizar en conjunto para ver si el consumo de tiempo de la operación con mayor complejidad de tiempo se puede amortizar con otras operaciones con menor complejidad de tiempo. Además, cuando se puede aplicar el análisis de la complejidad del tiempo amortizado, la complejidad del tiempo amortizado general es igual a la complejidad del tiempo en el mejor de los casos.

Aunque muchos libros de estructura de datos y algoritmos se han esforzado mucho en distinguir entre la complejidad de tiempo promedio y la complejidad de tiempo amortizado, de hecho, personalmente creo que la complejidad de tiempo amortizado es una complejidad de tiempo promedio especial, y no hay necesidad de esforzarse demasiado para distinguirlos. Lo más importante a dominar es su método de análisis, análisis de amortización. En cuanto a si el resultado del análisis se llama promedio o se comparte equitativamente, esto es solo una forma de decir que no es importante.

3. Matrices

3.1 ¿Cómo lograr el acceso aleatorio?

Array (Array) es una estructura de datos de tabla lineal. Utiliza un conjunto de espacios de memoria contiguos para almacenar un conjunto de datos del mismo tipo.

Hay varias palabras clave en esta definición Después de entender estas palabras clave, básicamente puede comprender el concepto de matrices a fondo.

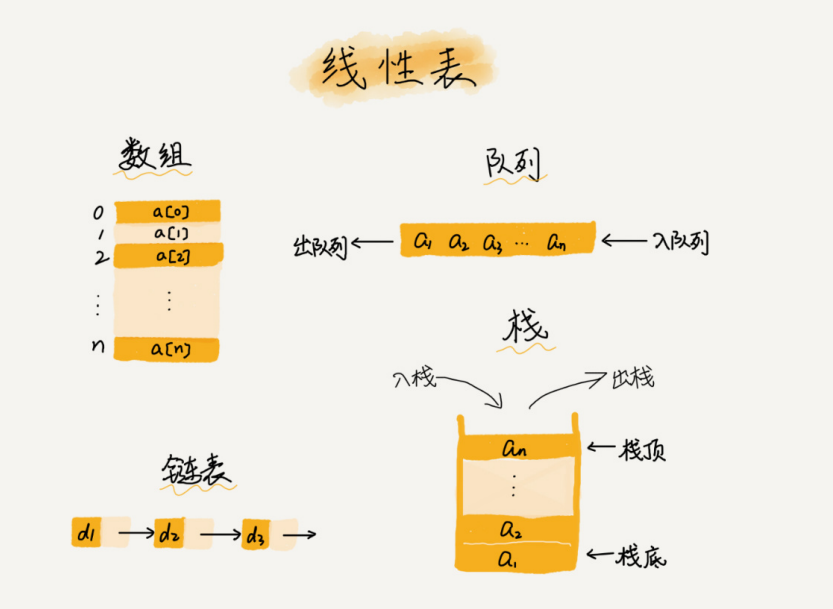

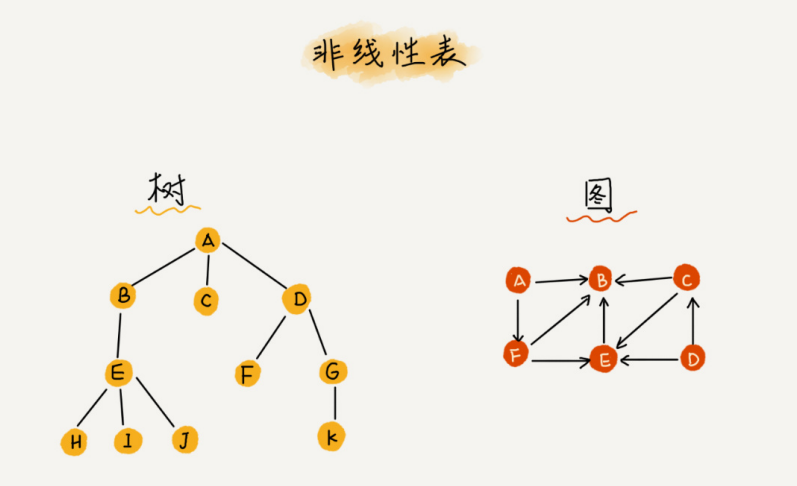

1. Lista lineal

Como su nombre lo indica, una tabla lineal es una estructura en la que los datos se organizan como una línea. Los datos de cada tabla lineal tienen como máximo dos direcciones, adelante y atrás. De hecho, además de las matrices, las listas enlazadas, las colas, las pilas, etc. también son estructuras de tablas lineales.

El concepto opuesto es una tabla no lineal, como un árbol binario, un montón, un gráfico, etc. La razón por la que se llama no lineal es que en una tabla no lineal, no hay un contexto simple entre los datos

2. Espacio de memoria contiguo y el mismo tipo de datos

Es precisamente por estas dos limitaciones que tiene una función llamada "killer": "acceso aleatorio". Pero hay ventajas y desventajas. Estas dos limitaciones también hacen que muchas operaciones en la matriz sean muy ineficientes. Por ejemplo, si desea eliminar o insertar una parte de los datos en la matriz, para garantizar la continuidad, necesita mover una gran cantidad de datos.

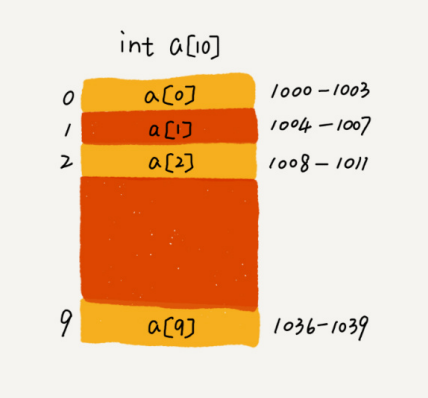

¿Cómo implementa la matriz el acceso aleatorio a los elementos de la matriz en función de los subíndices?

Tome una matriz de tipo int con una longitud de 10 int[] a = new int[10]como ejemplo. En la figura a continuación, la computadora asigna un espacio de memoria continuo de 1000 a 1039 para la matriz a[10], donde la primera dirección del bloque de memoria es base_address = 1000

La computadora asigna una dirección a cada unidad de memoria, y la computadora usa la dirección para acceder a los datos en la memoria. Cuando la computadora necesita acceder aleatoriamente a un elemento en la matriz, primero calculará la dirección de memoria del elemento a través de la siguiente fórmula de direccionamiento:

a[i]_dirección = dirección_base + i * tamaño_tipo_datos

Donde data_type_size representa el tamaño de cada elemento en la matriz. En el ejemplo anterior, los datos de tipo int se almacenan en la matriz, por lo que data_type_size es bytes 4. Esta fórmula es muy simple, por lo que no introduciré demasiado aquí

Hay un "error" que corregir aquí. Durante las entrevistas, a menudo se pregunta la diferencia entre matrices y listas vinculadas, y muchas personas responden: "Las listas vinculadas son adecuadas para la inserción y eliminación, y la complejidad del tiempo es O ( 1 ) O(1)O ( 1 ) ; la matriz es adecuada para la búsqueda, la complejidad del tiempo de búsqueda esO(1)O(1)O ( 1 ) ”

De hecho, esta representación es inexacta. Las matrices son adecuadas para las operaciones de búsqueda, pero la complejidad temporal de la búsqueda no es O ( 1 ) O(1)O ( 1 ) . Incluso para arreglos ordenados, usando búsqueda binaria, la complejidad del tiempo esO (logn) O(logn)O ( iniciar sesión n ) . _ _ Por lo tanto, la expresión correcta debería ser que la matriz admita el acceso aleatorio, y la complejidad temporal del acceso aleatorio según el subíndice esO ( 1 ) O(1)O ( 1 )

3.2 "insertar" y "eliminar" ineficientes

Como se mencionó anteriormente, para mantener la continuidad de los datos de la memoria en la matriz, las dos operaciones de inserción y eliminación serán relativamente ineficientes. Ahora, ¿por qué exactamente esto está causando la ineficiencia? ¿Cuáles son las formas de mejorarlo?

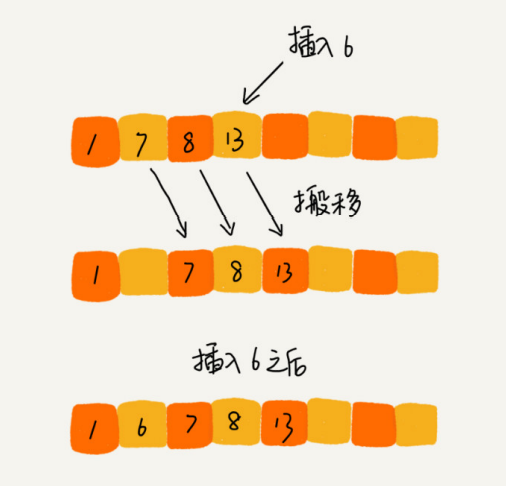

Primer vistazo a la operación de inserción

Suponiendo que la longitud de la matriz es n, ahora, si es necesario insertar un dato en la posición k-ésima de la matriz. Para liberar la k-ésima posición para los nuevos datos, es necesario mover los elementos de la k-ésima a la n-ésima parte hacia atrás secuencialmente. ¿Cuál es la complejidad temporal de la operación de inserción?

Si inserta elementos al final de la matriz, no es necesario mover los datos y la complejidad del tiempo es O ( 1 ) O(1)O ( 1 ) . Pero si inserta un elemento al comienzo de la matriz, todos los datos deben moverse hacia atrás uno por uno, por lo que la peor complejidad de tiempo esO ( n ) O(n)O ( n ) . Debido a que la probabilidad de insertar un elemento en cada posición es la misma, la complejidad de tiempo de caso promedio es1 + 2 + ... nn = O ( n ) {1 + 2 + ... n \over n} = O(n)norte1 + 2 + ... norte=O ( n )

Si los datos en la matriz están ordenados, cuando se inserta un nuevo elemento en una determinada posición, los datos después de k deben moverse de acuerdo con el método de ahora. Sin embargo, si los datos almacenados en la matriz no tienen reglas, la matriz solo se considera una colección de datos almacenados. En este caso, si desea insertar una matriz en la posición k-ésima, para evitar el movimiento de datos a gran escala, existe otra forma sencilla de mover directamente el bit de datos k-ésimo al final del elemento de la matriz y colocar el nuevo elemento directamente en la posición k-ésima.

Por ejemplo, los siguientes 5 elementos se almacenan en la matriz a[10]: a, b, c, d, e. Ahora el elemento x debe insertarse en la tercera posición. Simplemente coloque c en a[5] y asigne a[2] a x. Finalmente, los elementos de la matriz son los siguientes: a, b, x, d, e, c

Utilizando esta técnica de procesamiento, en un escenario específico, la complejidad temporal de insertar un elemento en la posición k-ésima se reducirá a O (1) O(1)O ( 1 ) . Esta idea de procesamiento también se utilizará en la clasificación rápida

Veamos la operación de eliminación.

Similar a la inserción de datos, si desea eliminar los datos en la k-ésima posición, también debe mover los datos para la continuidad de la memoria; de lo contrario, habrá un agujero en el medio y la memoria no será continua.

Similar a la inserción, si elimina los datos al final de la matriz, la complejidad de tiempo del mejor de los casos es O ( 1 ) O (1)O ( 1 ) ; si elimina los datos al principio, la complejidad de tiempo en el peor de los casos esO(n) O(n)O ( n ) ; la complejidad del tiempo de caso promedio también esO ( n ) O(n)O ( n )

De hecho, en algunos escenarios especiales, no es necesario buscar la continuidad de los datos en la matriz. Si se realizan varias operaciones de eliminación juntas, ¿se mejorará mucho la eficiencia de la eliminación?

Por ejemplo, se almacenan 8 elementos en la matriz a[10]: a, b, c, d, e, f, g, h. Ahora, para eliminar a, b, c tres elementos a la vez

Para evitar que los datos de d, e, f, g y h se muevan tres veces, primero puede grabar los datos eliminados. Cada operación de eliminación en realidad no mueve los datos, sino que solo registra que los datos se han eliminado. Cuando la matriz no tiene más espacio para almacenar datos, se activa una operación de eliminación real, lo que reduce en gran medida el movimiento de datos causado por la operación de eliminación.

Si comprende la JVM, encontrará que esta es la idea central del algoritmo de recolección de basura de barrido de marcas de JVM. Este es el encanto de las estructuras de datos y los algoritmos. En muchos casos, no se trata de memorizar una determinada estructura de datos o algoritmo de memoria, sino aprender las habilidades de pensamiento y procesamiento que hay detrás. Estas cosas son las más valiosas. Si presta atención, ya sea en el desarrollo de software o en el diseño de la arquitectura, siempre puede encontrar la sombra de ciertos algoritmos y estructuras de datos.

3.3 Tenga cuidado con el acceso a la matriz fuera de los límites

Primero, analicemos los resultados de ejecución de este código de lenguaje C:

int main(int argc, char * argv[]) {

int i = 0;

int arr[3] = {

0};

for(; i <= 3; i++) {

arr[i] = 0;

printf("hello world\n");

}

return 0;

}

El resultado de este código no es imprimir tres líneas de "hola palabra", sino imprimir "hola mundo" infinitamente.¿Por qué?

Debido a que el tamaño de la matriz es 3, a[0], a[1], a[2], y el código está mal escrito, la condición final del bucle for está mal escrita como i<=3 en lugar de i<3, por lo que cuando i=3, el acceso de la matriz a[3] está fuera de los límites

En el lenguaje C, todos los espacios de memoria son de libre acceso siempre que no sean memoria de acceso restringido. De acuerdo con la fórmula de direccionamiento de matriz mencionada anteriormente, a[3] también se ubicará en una dirección de memoria que no pertenece a la matriz, y esta dirección resulta ser la dirección de memoria donde se almacena la variable i, entonces a[3]=0 es equivalente a i=0, por lo que conducirá a un bucle infinito de código

La matriz fuera de los límites es un comportamiento pendiente en el lenguaje C, y no existe una regulación sobre cómo el compilador debe manejar el acceso a la matriz fuera de los límites. Debido a que la esencia de acceder a una matriz es acceder a una parte de la memoria continua, siempre que la dirección de memoria obtenida al calcular el desplazamiento de la matriz esté disponible, es posible que el programa no informe ningún error.

En este caso, generalmente se producirán errores lógicos inexplicables.Al igual que en el ejemplo anterior, la depuración es muy difícil. Además, muchos virus informáticos también usan las lagunas en el código para acceder a direcciones ilegales cuando la matriz está fuera de los límites para atacar el sistema, por lo que al escribir código, debe tener cuidado con la matriz fuera de los límites.

Pero no todos los lenguajes son como C, lo que deja el trabajo de las comprobaciones fuera de los límites de la matriz a los programadores, ya que Java mismo hará comprobaciones fuera de los límites, como las siguientes líneas de código Java, arrojarájava.lang.ArrayIndexOutOfBoundsException

int[] a = new int[3];

a[3] = 10;

3.4 ¿Pueden los contenedores reemplazar completamente los arreglos?

Para los tipos de matrices, muchos lenguajes ofrecen clases de contenedor, como ArrayList en Java y vector en C++ STL. En el desarrollo de proyectos, ¿cuándo es apropiado usar arreglos y cuándo es apropiado usar contenedores?

Tome el lenguaje Java como ejemplo. Si es ingeniero de Java y usa ArrayList casi todos los días, debe estar muy familiarizado con él. Entonces, ¿qué ventajas tiene sobre las matrices?

Personalmente, la mayor ventaja de ArrayList es que puede encapsular los detalles de muchas operaciones de matriz. Por ejemplo, al insertar y eliminar datos en la matriz mencionada anteriormente, es necesario mover otros datos. Además, tiene otra ventaja, es decir, admite la expansión dinámica.

La matriz en sí necesita especificar el tamaño por adelantado cuando se define, porque necesita asignar espacio de memoria continuo. Si solicita una matriz con un tamaño de 10, cuando los datos 11 deben almacenarse en la matriz, debe reasignar un espacio más grande, copiar los datos originales y luego insertar los nuevos datos.

Si usa ArrayList, no necesita preocuparse en absoluto por la lógica de expansión subyacente, ya que ArrayList ya se ha implementado. Cada vez que el espacio de almacenamiento no sea suficiente, expandirá automáticamente el espacio a 1,5 veces el tamaño

Sin embargo, debe prestar atención aquí, porque la operación de expansión implica la aplicación de memoria y el movimiento de datos, lo que lleva mucho tiempo. Por lo tanto, si el tamaño de los datos que se almacenarán se puede determinar de antemano, es mejor especificar el tamaño de los datos de antemano al crear ArrayList.

Por ejemplo, desea extraer 10 000 datos de la base de datos y colocarlos en ArrayList. Mire las siguientes líneas de código. Por el contrario, especificar el tamaño de los datos por adelantado puede ahorrar una gran cantidad de aplicaciones de memoria y operaciones de movimiento de datos.

ArrayList<User> users = new ArrayList(10000);

for (int i = 0; i < 10000; ++i) {

users.add(xxx);

}

Entonces, ¿la matriz es inútil? Por supuesto que no, a veces es más apropiado usar una matriz

- Java ArrayList no puede almacenar tipos básicos, como int y long, y debe empaquetarse como clases Integer y Long, mientras que Autoboxing y Unboxing consumirán una cierta cantidad de rendimiento, por lo que si presta especial atención al rendimiento o desea usar tipos básicos, puede usar matrices

- Si el tamaño de los datos se conoce de antemano y la operación en los datos es muy simple, la mayoría de los métodos proporcionados por ArrayList no se usan y la matriz también se puede usar directamente.

- Otra es que cuando se van a representar arreglos multidimensionales, a menudo es más intuitivo usar arreglos. Por ejemplo

Object[][] array, si usa un contenedor, debe definirlo así:ArrayList<ArrayList> array

Para el desarrollo comercial, basta con utilizar el contenedor directamente, ahorrando tiempo y esfuerzo. Después de todo, una pérdida de rendimiento no afectará en absoluto al rendimiento general del sistema. Pero si está realizando un desarrollo de muy bajo nivel, como el desarrollo de un marco de red, la optimización del rendimiento debe ser extrema.En este momento, los arreglos serán mejores que los contenedores y se convertirán en la primera opción.

3.5 ¿Por qué las matrices comienzan a numerarse desde 0 en lugar de 1 en la mayoría de los lenguajes de programación?

Desde el modelo de memoria de almacenamiento en matriz, la definición más precisa de "subíndice" debería ser "compensación". Como se mencionó anteriormente, si a se usa para representar la primera dirección de la matriz, a[0] es la posición con un desplazamiento de 0, es decir, la primera dirección, y a[k] representa el desplazamiento de posición por k type_size, por lo que solo necesita usar esta fórmula para calcular la dirección de memoria de a[k]:

a[k]_dirección = base_dirección + k * tipo_tamaño

Sin embargo, si la matriz comienza a contar desde 1, entonces la dirección de memoria para calcular el elemento de la matriz a[k] se convierte en:

a[k]_dirección = base_dirección + (k - 1) * tipo_tamaño

Comparando las dos fórmulas, no es difícil encontrar que comenzando la numeración desde 1, cada acceso aleatorio a un elemento de la matriz requiere una operación de resta más.Para la CPU, es una instrucción de resta más.

Los arreglos son una estructura de datos muy básica, y el acceso aleatorio a los elementos del arreglo a través de subíndices es una operación de programación muy básica. La optimización de la eficiencia debe ser lo más extrema posible. Entonces, para reducir una operación de resta, la matriz elige comenzar a numerar desde 0 en lugar de 1

Sin embargo, no importa cuántas explicaciones se den arriba, no es una prueba abrumadora de que el número inicial de la matriz debe comenzar con 0. La razón más importante puede ser razones históricas

Los diseñadores del lenguaje C comenzaron a contar los subíndices de la matriz con 0, y luego los lenguajes de alto nivel como Java y JavaScript siguieron al lenguaje C, o en otras palabras, para reducir el costo de aprendizaje de los programadores del lenguaje C que aprenden Java hasta cierto punto, continuaron usando el hábito de contar desde 0. De hecho, las matrices no comienzan a contar desde 0 en muchos lenguajes, como Matlab. Incluso hay algunos lenguajes que admiten subíndices negativos, como Python

4. Lista vinculada

4.1 Estructura de lista enlazada

Una lista enlazada es una estructura de datos un poco más compleja que una matriz. Estas dos estructuras de datos muy básicas y de uso común a menudo se comparan juntas. Así que vamos a ver cuál es la diferencia entre los dos

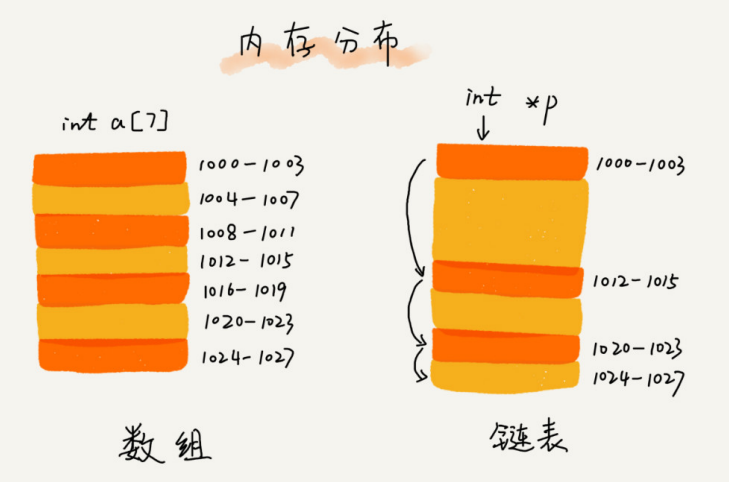

estructura de almacenamiento subyacente

Como se muestra en la figura a continuación, la matriz necesita un espacio de memoria continuo para almacenar y los requisitos de memoria son relativamente altos. Si solicita una matriz con un tamaño de 100 MB, cuando no hay espacio de almacenamiento continuo y lo suficientemente grande en la memoria, incluso si el espacio total disponible restante de la memoria es superior a 100 MB, la aplicación seguirá fallando

Por el contrario, la lista enlazada no necesita un espacio de memoria continuo, sino que conecta un grupo de bloques de memoria dispersos en serie a través de "punteros", por lo que si solicitas una lista enlazada con un tamaño de 100 MB, no habrá ningún problema.

Hay varias estructuras de listas enlazadas. Estas son las tres estructuras de listas enlazadas más comunes. Son: lista enlazada simple, lista enlazada doble y lista enlazada circular.

1. Lista enlazada simple

Como se acaba de mencionar, la lista enlazada conecta un grupo de bloques de memoria dispersos a través de punteros. Entre ellos, el bloque de memoria se denomina "nodo" de la lista enlazada. Para unir todos los nodos, además de almacenar datos, cada nodo de la lista enlazada también necesita registrar la dirección del siguiente nodo en la cadena. Como se muestra en la figura, el puntero que registra la dirección del siguiente nodo se denomina puntero sucesor siguiente.

Como se puede ver en la figura anterior, hay dos nodos especiales, que son el primer nodo y el último nodo. Es costumbre llamar al primer nodo el nodo de cabeza y al último nodo el nodo de cola. Entre ellos, el nodo principal se usa para registrar la dirección base de la lista enlazada. Con él, puede recorrer para obtener toda la lista vinculada. La característica especial del nodo final es: el puntero no apunta al siguiente nodo, sino que apunta a una dirección vacía NULL, lo que indica que este es el

último nodo en la lista enlazada

Al igual que las matrices, las listas vinculadas también admiten operaciones de búsqueda, inserción y eliminación de datos.

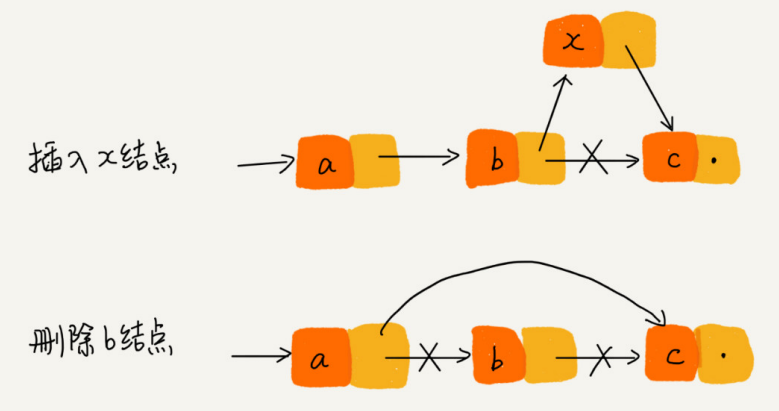

Al realizar operaciones de inserción y eliminación de arreglos, para mantener la continuidad de los datos de la memoria, es necesario mover una gran cantidad de datos, por lo que la complejidad del tiempo es O ( n ) O(n)O ( n ) . Al insertar o eliminar un dato en la lista enlazada, no hay necesidad de mover nodos para mantener la continuidad de la memoria, porque el espacio de almacenamiento de la lista enlazada en sí no es continuo. Por lo tanto, insertar y eliminar un dato en la lista enlazada es muy rápido.

Como se muestra en la figura a continuación, para las operaciones de inserción y eliminación de la lista enlazada, solo se deben considerar los cambios de puntero de los nodos adyacentes, por lo que la complejidad de tiempo correspondiente es O ( 1 ) O(1 )O ( 1 )

Sin embargo, hay pros y contras. Si una lista enlazada quiere acceder aleatoriamente al k-ésimo elemento, no es tan eficiente como una matriz. Debido a que los datos en la lista enlazada no se almacenan continuamente, es imposible calcular directamente la dirección de memoria correspondiente a través de la fórmula de direccionamiento de acuerdo con la primera dirección y el subíndice como una matriz, sino que debe atravesar un nodo por uno de acuerdo con el puntero hasta que se encuentre el nodo correspondiente.

Puedes pensar en una lista enlazada como un equipo. Todos en el equipo solo saben quién es la persona que está detrás de ellos, así que cuando quieras saber quién es la persona en el k-ésimo lugar, debes comenzar desde la primera persona y contar uno por uno. Por lo tanto, el rendimiento del acceso aleatorio de la lista enlazada no es tan bueno como el de la matriz, lo que requiere O ( n ) O(n)O ( n ) tiempo complejidad

2. Lista enlazada circular

Una lista enlazada circular es un tipo especial de lista enlazada simple. De hecho, la lista enlazada circular también es muy simple. La única diferencia entre esta y la lista enlazada individualmente es el nodo de cola. El puntero del nodo final de la lista enlazada individualmente apunta a una dirección vacía, lo que indica que este es el último nodo. El puntero del nodo final de la lista enlazada circular apunta al nodo principal de la lista enlazada. Como se muestra en la figura a continuación, está conectado de extremo a extremo como un anillo, por lo que se denomina lista enlazada "circular".

En comparación con la lista enlazada simple, la ventaja de la lista enlazada circular es que es más conveniente ir desde el final de la cadena hasta el principio de la cadena. Cuando los datos a tratar tienen las características de una estructura en anillo, es especialmente adecuado utilizar una lista enlazada circular. Como el famoso problema de Joseph. Aunque también se puede implementar con una lista enlazada simple, si se implementa con una lista enlazada circular, el código será mucho más simple

3. Lista doblemente enlazada

La lista enlazada unidireccional tiene solo una dirección, y el nodo tiene solo un puntero sucesor que apunta al siguiente nodo. La lista doblemente enlazada, como sugiere el nombre, admite dos direcciones: cada nodo tiene más de un puntero sucesor que apunta al siguiente nodo y un puntero predecesor que apunta al nodo anterior.

La lista doblemente enlazada requiere dos espacios adicionales para almacenar la dirección del nodo sucesor y el nodo predecesor. Por lo tanto, si se almacena la misma cantidad de datos, la lista de enlaces dobles ocupa más espacio de memoria que la lista de enlaces simples. Aunque dos punteros son una pérdida de espacio de almacenamiento, pueden admitir el recorrido bidireccional, lo que también brinda la flexibilidad de las operaciones de listas doblemente vinculadas. En comparación con la lista enlazada simple, ¿qué tipo de problema es adecuada para resolver la lista doblemente enlazada?

Desde un punto de vista estructural, una lista doblemente enlazada puede soportar O ( 1 ) O(1)En el caso de complejidad temporal O ( 1 ) , encuentre el nodo predecesor Es esta característica la que hace que las operaciones de inserción y eliminación de la lista doblemente enlazada en algunos casos sean más simples y eficientes que las de la lista enlazada simple.

En este momento, se puede decir que la complejidad temporal de las operaciones de inserción y eliminación de la lista enlazada simple mencionada anteriormente ya es O ( 1 ) O (1)O ( 1 ) , ¿qué tan eficiente puede ser una lista doblemente enlazada? El análisis anterior es más teórico, y muchos libros de estructuras de datos y algoritmos dirán esto, pero esta declaración es en realidad inexacta o tiene requisitos previos. Analicemos las dos operaciones de la lista enlazada aquí.

Operación de eliminación : en el desarrollo de software real, eliminar una parte de los datos de la lista vinculada no es más que las siguientes dos situaciones

- Eliminar los nodos cuyo valor es igual a un valor dado entre los nodos

- Eliminar el nodo al que apunta el puntero dado

Para el primer caso, ya sea una lista de un solo enlace o una lista de enlaces dobles, para encontrar un nodo cuyo valor sea igual a un valor dado, es necesario recorrer y comparar uno a uno desde el nodo principal hasta encontrar un nodo cuyo valor sea igual a un valor dado, y luego eliminarlo mediante la operación de puntero mencionada anteriormente.

Aunque la complejidad del tiempo de la operación de borrado simple es O ( 1 ) O(1)O ( 1 ) , pero el tiempo de búsqueda transversal es el principal punto que consume mucho tiempo, y la complejidad de tiempo correspondiente esO ( n ) O(n)O ( n ) . De acuerdo con la regla de la suma en el análisis de complejidad temporal, la complejidad temporal total de la operación de lista enlazada correspondiente al nodo cuyo valor es igual al valor dado esO ( n ) O(n)O ( n )

Para el segundo caso, se ha encontrado el nodo a eliminar, pero para eliminar un nodo q se necesita conocer su nodo predecesor, y la lista enlazada simple no admite obtener directamente el nodo predecesor, por lo que para encontrar el nodo predecesor, aún es necesario recorrer la lista enlazada desde el nodo principal hasta, indicando que p es el nodo predecesor de p->next=qq

Pero para listas doblemente enlazadas, esta situación es más ventajosa. Debido a que los nodos en la lista doblemente enlazada ya han guardado los punteros de los nodos predecesores, no hay necesidad de atravesar como una lista enlazada simple. Por lo tanto, para el segundo caso, O(n)la complejidad de tiempo requerida para la operación de borrado de la lista con enlace simple es , mientras que la lista con enlace doble solo necesita realizarse O(1)dentro de la complejidad de tiempo de !

La operación de inserción es la misma, si desea insertar un nodo delante de un nodo específico en la lista enlazada, la lista doblemente enlazada tiene una gran ventaja sobre la lista enlazada simple. Una lista doblemente enlazada se puede hacer en O ( 1 ) O(1)O ( 1 ) la complejidad del tiempo está hecha, mientras que la lista enlazada unidireccional necesitaO (n) O(n)O ( n ) tiempo complejidad

Además de las ventajas de las operaciones de inserción y eliminación, para una lista enlazada ordenada, la eficiencia de la consulta valor por valor de una lista doblemente enlazada también es mayor que la de una lista enlazada simple. Debido a que se puede registrar la posición p de la última búsqueda, y cada vez que se realiza una consulta, se decide si buscar hacia adelante o hacia atrás según la relación entre el valor a buscar y el tamaño de p, por lo que en promedio solo se necesita buscar la mitad de los datos

¿Crees que las listas con enlaces dobles son más eficientes que las listas con enlaces simples? Esta es la razón por la que en el desarrollo de software real, aunque la lista doblemente enlazada consume más memoria, todavía se usa más ampliamente que la lista enlazada simple. Si está familiarizado con el lenguaje Java, debe haber utilizado el contenedor LinkedHashMap. Si profundiza en el principio de implementación de LinkedHashMap, encontrará que se utiliza la estructura de datos de la lista doblemente enlazada.

De hecho, hay un punto de conocimiento más importante que debes dominar, es decir, la idea de diseño de intercambiar espacio por tiempo . Cuando el espacio de memoria es suficiente, si persigue más la velocidad de ejecución del código, puede elegir un algoritmo o estructura de datos con una complejidad de espacio relativamente alta pero una complejidad de tiempo relativamente baja. Por el contrario, si la memoria es relativamente escasa, como el código que se ejecuta en un teléfono móvil o una microcomputadora de un solo chip, en este momento es necesario revertir la idea de diseño de intercambiar tiempo por espacio.

El almacenamiento en caché es en realidad la idea de diseño de usar el espacio por tiempo. Si los datos se almacenan en el disco duro, ahorrará memoria, pero cada vez que se buscan los datos, se debe consultar el disco duro, que será más lento. Sin embargo, si los datos se cargan en la memoria de antemano a través de la tecnología de almacenamiento en caché, aunque consumirá más espacio de memoria, la velocidad de cada consulta de datos mejorará considerablemente.

Para los programas que se ejecutan lentamente, pueden optimizarse consumiendo más memoria (espacio por tiempo); para los programas que consumen demasiada memoria, pueden reducir el consumo de memoria consumiendo más tiempo (tiempo por espacio)

Después de entender la lista enlazada circular y la lista doblemente enlazada, si estas dos listas enlazadas se integran juntas, será una nueva versión: lista doblemente enlazada

4.2 Comparación de rendimiento de lista enlazada VS matriz

Las matrices y las listas enlazadas son dos formas muy diferentes de organizar la memoria. Es precisamente debido a la diferencia en el almacenamiento de memoria que la complejidad temporal de sus operaciones de inserción, eliminación y acceso aleatorio es todo lo contrario.

Sin embargo, la comparación entre arreglos y listas enlazadas no puede limitarse a la complejidad del tiempo. Además, en el desarrollo de software real, no es posible decidir qué estructura de datos usar para almacenar datos solo mediante análisis de complejidad.

La matriz es simple y fácil de usar. La implementación utiliza un espacio de memoria continuo. Los datos en la matriz se pueden leer de antemano con la ayuda del mecanismo de caché de la CPU, por lo que la eficiencia de acceso es mayor. La lista enlazada no se almacena continuamente en la memoria, por lo que no es compatible con la memoria caché de la CPU y no hay forma de leer con anticipación de manera efectiva.

La desventaja de una matriz es que su tamaño es fijo y, una vez que se declara, ocupará todo el espacio de memoria continua. Si la matriz declarada es demasiado grande, es posible que el sistema no tenga suficiente espacio de memoria contiguo asignado, lo que resultará en "memoria insuficiente". Si la matriz declarada es demasiado pequeña, puede que no sea suficiente. En este momento, solo podemos solicitar un espacio de memoria más grande y copiar la matriz original en él, lo que lleva mucho tiempo. La lista vinculada en sí no tiene límite de tamaño y, naturalmente, admite la expansión dinámica, que es la mayor diferencia entre ella y la matriz.

Java 中的 ArrayList 容器虽然支持动态扩容,但实际上还是数组的拷贝操作。当往支持动态扩容的数组中插入一个数据时,如果数组中没有空闲空间了,就会申请一个更大的空间,将数据拷贝过去,而数据拷贝的操作是非常耗时的

举一个稍微极端的例子。如果用 ArrayList 存储了了 1GB 大小的数据,这个时候已经没有空闲空间了,当再插入数据的时候,ArrayList 会申请一个 1.5GB 大小的存储空间,并且把原来那 1GB 的数据拷贝到新申请的空间上。听起来是不是就很耗时?

除此之外,如果代码对内存的使用非常苛刻,那数组就更适合。因为链表中的每个结点都需要消耗额外的存储空间去存储一份指向下一个结点的指针,所以内存消耗会翻倍。而且,对链表进行频繁的插入、删除操作,还会导致频繁的内存申请和释放,容易造成内存碎片,如果是 Java 语言,就有可能会导致频繁的 GC(Garbage Collection,垃圾回收)。所以,在实际的开发中,针对不同类型的项目,要根据具体情况,权衡究竟是选择数组还是链表

4.3 如何基于链表实现 LRU 缓存淘汰算法?

缓存是一种提高数据读取性能的技术,在硬件设计、软件开发中都有着非常广泛的应用,比如常见的 CPU 缓存、数据库缓存、浏览器缓存等等

缓存的大小有限,当缓存被用满时,哪些数据应该被清理出去,哪些数据应该被保留?这就需要缓存淘汰策略来决定。常见的策略有三种:先进先出策略 FIFO(First In,First Out)、最少使用策略 LFU(Least Frequently Used)、最近最少使用策略 LRU(Least Recently Used)

这些策略其实见名知义,那么如何基于链表实现 LRU 缓存淘汰算法呢?

可以维护一个有序单链表,越靠近链表尾部的结点是越早之前访问的。当有一个新的数据被访问时,从链表头开始顺序遍历链表

-

如果此数据之前已经被缓存在链表中了,遍历得到这个数据对应的结点,并将其从原来的位置删除,然后再插入到链表的头部

-

Si los datos no están en la lista enlazada de caché, se pueden dividir en dos situaciones:

- Si el caché no está lleno en este momento, inserte este nodo directamente en el encabezado de la lista enlazada

- Si la memoria caché está llena en este momento, se elimina el nodo final de la lista vinculada y se inserta un nuevo nodo de datos en el encabezado de la lista vinculada.

De esta forma se implementa una caché LRU con una lista enlazada, ¿es muy sencillo?

Ahora veamos la complejidad temporal del acceso a la memoria caché m. Debido a que la lista vinculada debe recorrerse independientemente de si la memoria caché está llena o no, la complejidad temporal del acceso a la memoria caché es O ( n ) O(n) para esta idea de implementación basada en la lista vinculada.O ( n )

De hecho, puede continuar optimizando esta idea de implementación, como la introducción de una tabla hash (tabla Hash) para registrar la ubicación de cada dato, reduciendo la complejidad del tiempo de acceso a la memoria caché a O ( 1 ) O(1)O ( 1 )

Además de la idea de implementación basada en la lista enlazada, de hecho, las matrices también se pueden usar para implementar la estrategia de eliminación de caché LRU.

4.4 ¿Cómo escribir fácilmente el código correcto de la lista enlazada?

No es fácil escribir bien el código de una lista vinculada, especialmente aquellas operaciones complicadas de listas vinculadas, como la inversión de listas vinculadas, la fusión de listas vinculadas ordenadas, etc., son muy propensas a errores al escribir. ¿Por qué el código de lista enlazada es tan difícil de escribir? ¿Cómo podemos escribir el código correcto de la lista enlazada más fácilmente?

1. Comprender el significado de punteros o referencias

De hecho, no es difícil entender la estructura de la lista enlazada, pero una vez que se mezcla con punteros, es fácil confundirse. Por lo tanto, si desea escribir el código de la lista enlazada correctamente, primero debe comprender el puntero

Algunos lenguajes tienen el concepto de "punteros", como el lenguaje C; algunos lenguajes no tienen punteros, sino que usan "referencias", como Java y Python. Independientemente de si se trata de un "puntero" o una "referencia", de hecho, sus significados son los mismos y todas son direcciones de memoria que almacenan el objeto apuntado.

De hecho, para la comprensión de los punteros, solo necesita recordar la siguiente oración:

Asignar una variable a un puntero es en realidad asignar la dirección de la variable al puntero o, por el contrario, la dirección de memoria de la variable se almacena en el puntero, apuntando a la variable, y la variable se puede encontrar a través del puntero.

Al escribir código de lista enlazada, a menudo hay tales códigos: · p->next = q. Esta línea de código significa que el siguiente puntero en el nodo p almacena la dirección de memoria del nodo q

También hay uno más complicado, que se usa a menudo cuando se escribe código de lista enlazada: p->next = p->next->next. Esta línea de código indica que el siguiente puntero del nodo p almacena la dirección de memoria del siguiente nodo del nodo p

Una vez que haya dominado el concepto de punteros o referencias, debería poder comprender fácilmente el código de la lista vinculada.

2. Tenga cuidado con los punteros perdidos y las fugas de memoria

Al escribir el código de la lista vinculada, el puntero apunta de un lado a otro, y no sé a dónde apunta por un tiempo. Por lo tanto, al escribir, tenga cuidado de no perder el puntero.

¿Cómo se pierden a menudo los punteros? Aquí hay un ejemplo de la operación de inserción de una lista enlazada individualmente

Como se muestra en la figura, se espera insertar el nodo x entre el nodo ay el nodo adyacente b, asumiendo que el puntero actual p apunta al nodo a. Si la implementación del código se cambia a la siguiente, se producirán pérdidas de puntero y pérdida de memoria

p->next = x; // 将 p 的 next 指针指向 x 结点;

x->next = p->next; // 将 x 的结点的 next 指针指向 b 结点;

Después del primer paso, el puntero p->siguiente ya no apunta al nodo b, sino que apunta al nodo x. La segunda línea de código es equivalente a asignar x a x->next, apuntándose a sí mismo. Por lo tanto, toda la lista enlazada se divide en dos mitades y no se puede acceder a todos los nodos desde el nodo b en adelante.

Para algunos lenguajes, como el lenguaje C, la gestión de la memoria es responsabilidad del programador, si no se libera manualmente el espacio de memoria correspondiente al nodo, se producirán pérdidas de memoria. Por lo tanto, al insertar un nodo, debe prestar atención al orden de las operaciones. Primero debe apuntar el siguiente puntero del nodo x al nodo b, y luego apuntar el siguiente puntero del nodo a al nodo x, para que el puntero no se pierda, lo que provocaría pérdidas de memoria. Entonces, para el código insertado hace un momento, solo necesita invertir el orden del código en la línea 1 y la línea 2

De manera similar, al eliminar un nodo de lista vinculada, también debe recordar liberar manualmente el espacio de memoria; de lo contrario, también se producirán pérdidas de memoria. Por supuesto, para un lenguaje de programación como Java, donde la máquina virtual administra automáticamente la memoria, no hay necesidad de considerar tanto

3. Use Sentinel para simplificar la dificultad de implementación

Primero, revisemos las operaciones de inserción y eliminación de la lista enlazada individualmente. Si inserta un nuevo nodo después del nodo p, solo necesita las siguientes dos líneas de código para hacerlo

new_node->next = p->next;

p->next = new_node;

Sin embargo, al insertar el primer nodo en una lista enlazada vacía, la lógica de ahora no se puede utilizar. Se requiere el siguiente procesamiento especial, donde head representa el nodo principal de la lista enlazada. Por lo tanto, a partir de este código, se puede encontrar que para la operación de inserción de la lista enlazada simple, la lógica de inserción del primer nodo y otros nodos es diferente

if (head == null) {

head = new_node;

}

Veamos la operación de eliminación del nodo de lista enlazada individualmente. Si desea eliminar el nodo sucesor del nodo p, solo necesita una línea de código para hacerlo

p->next = p->next->next;

Sin embargo, si desea eliminar el último nodo de la lista vinculada, el código de eliminación anterior no funcionará. Similar a la inserción, también se requiere un manejo especial para este caso.

if (head->next == null) {

head = null;

}

Del anterior análisis paso a paso, se puede observar que para las operaciones de inserción y eliminación de la lista enlazada se necesita realizar un manejo especial para el caso de insertar el primer nodo y eliminar el último nodo. De esta manera, el código será engorroso de implementar, no conciso, y es fácil cometer errores debido a una consideración incompleta. ¿Cómo resolver este problema?

Sentinel , el centinela mencionado aquí es para resolver el "problema de límites" y no participa directamente en la lógica empresarial

head = nullIndica que no hay más nodos en la lista enlazada. Donde head representa el puntero del nodo principal, apuntando al primer nodo en la lista enlazada. Si se introduce un ganglio centinela, en cualquier momento, independientemente de si la lista enlazada está vacía o no, el puntero de la cabeza siempre apuntará a este ganglio centinela. Este tipo de lista enlazada con ganglios centinela también se denomina lista enlazada principal. Por el contrario, una lista enlazada sin un ganglio centinela se denomina lista enlazada sin cabeza.

Como se muestra en la figura a continuación, se puede encontrar que el nodo centinela no almacena datos. Debido a que el nodo centinela siempre ha existido, la inserción del primer nodo y la inserción de otros nodos, la eliminación del último nodo y la eliminación de otros nodos se pueden unificar en el mismo código para implementar la lógica.

De hecho, esta técnica de usar centinelas para simplificar la dificultad de programación se usa en muchas implementaciones de código, como clasificación por inserción, clasificación por fusión, programación dinámica, etc.

4. Preste atención al procesamiento de las condiciones de contorno

En el desarrollo de software, el código es más propenso a errores en algunas situaciones límite o anormales. El código de lista enlazada no es una excepción. Para implementar el código de lista enlazada sin errores, es necesario comprobar si las condiciones de contorno se tienen en cuenta durante el proceso de escritura y después de que se complete la escritura, y si el código puede ejecutarse correctamente bajo las condiciones de contorno.

Hay varias condiciones de contorno que se utilizan a menudo para comprobar si el código de la lista enlazada es correcto:

- ¿Funciona correctamente el código si la lista enlazada está vacía?

- ¿Funciona correctamente el código si la lista enlazada contiene solo un nodo?

- ¿Funciona correctamente el código si la lista enlazada contiene solo dos nodos?

- ¿Funciona correctamente la lógica del código cuando se trata de nodos de cabeza y nodos de cola?

Después de escribir el código de la lista enlazada, además de verificar si el código puede funcionar en condiciones normales, también depende de si el código aún puede funcionar correctamente en las condiciones límite anteriores. Si no hay problemas bajo estas condiciones de contorno, básicamente se puede considerar que no hay problema.

Por supuesto, las condiciones de contorno no se limitan a las enumeradas anteriormente. Para diferentes escenarios, puede haber condiciones límite específicas. Esto debe ser pensado por usted mismo, pero la rutina es la misma.

De hecho, no solo escriba código de lista enlazada, sino que al escribir cualquier código, no solo implemente las funciones en condiciones comerciales normales, sino que debe pensar más en las condiciones límite o las condiciones anormales que pueden encontrarse cuando se ejecuta el código. ¡Cómo lidiar con el encuentro, para que el código escrito sea lo suficientemente robusto!

5. Dibujar ejemplos para ayudar a pensar

Para las operaciones de lista enlazada un poco complicadas, como la inversión de lista enlazada única mencionada anteriormente, el puntero apunta aquí y allá durante un rato, y luego se marea durante un rato. Siempre siento que mi capacidad cerebral no es suficiente y no puedo pensar con claridad. Entonces, en este momento, se pueden usar otros métodos para ayudar a la comprensión, como: método de ejemplo y método de dibujo

Puedes encontrar un ejemplo específico, dibujarlo en un papel, liberar algo de capacidad cerebral y dejar más para el pensamiento lógico, de modo que sientas que tu pensamiento es mucho más claro. Por ejemplo, una operación como la inserción de un dato en una lista enlazada individualmente generalmente toma un ejemplo de varias situaciones y dibuja los cambios de la lista enlazada antes y después de la inserción, como se muestra en la figura.

Es mucho más fácil escribir código mirando la imagen. Además, después de escribir el código, también puede dar algunos ejemplos, dibujar en papel, seguir el código y encontrar fácilmente errores en el código.

6. Escribe más y practica más, no hay atajos

¡La práctica hace la perfección! Aquí hay 5 operaciones comunes de listas enlazadas. Siempre que pueda escribir estas operaciones de manera competente, escríbalas varias veces si no está familiarizado con ellas, para que nunca tenga miedo de escribir códigos de listas enlazadas nuevamente.

- Lista inversa de enlaces simples

- Detección de anillos en lista enlazada

- Fusión de dos listas enlazadas ordenadas

- Eliminar el último nodo n de la lista enlazada

- Encuentra el nodo medio de la lista enlazada

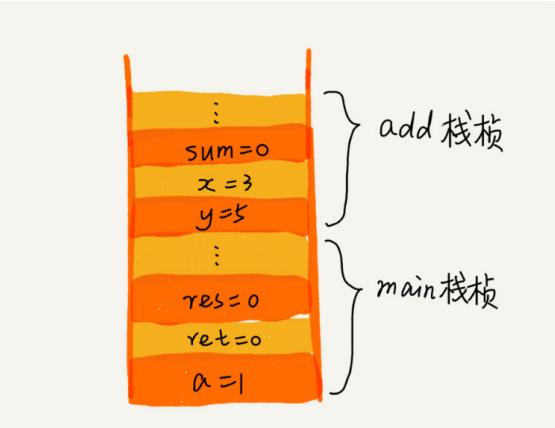

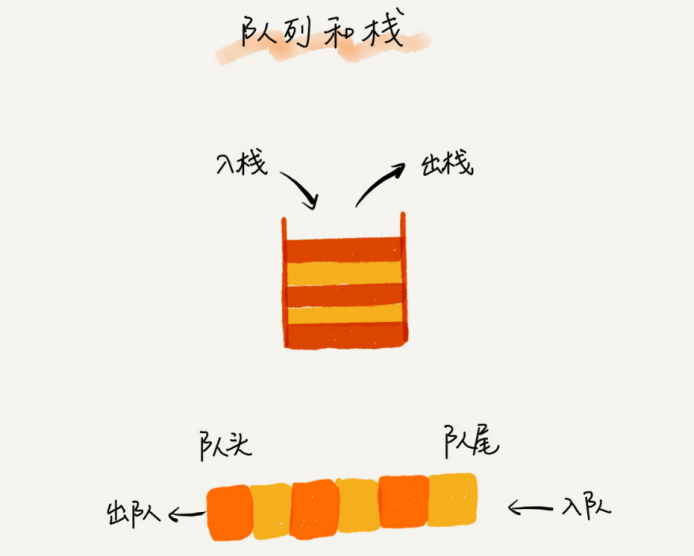

5. Apilar

5.1 ¿Cómo entender "pila"?

Un ejemplo muy adecuado de una "pila" es una pila de platos apilados uno encima del otro. Cuando solemos colocar los platos, los colocamos uno a uno de abajo hacia arriba; cuando los sacamos, también los tomamos uno a uno de arriba a abajo, y no podemos sacarlos del medio arbitrariamente. Último en entrar, primero en salir, último en salir avanzado , esta es una estructura típica de "pila"

Por las características operativas de la pila, la pila es una tabla lineal con "operaciones restringidas" , que solo permite insertar y borrar datos en un extremo.

De hecho, desde un punto de vista funcional, una matriz o una lista enlazada puede reemplazar una pila, pero una estructura de datos específica es una abstracción de una escena específica. Además, una matriz o una lista enlazada expone demasiadas interfaces de operación. La operación es de hecho flexible y gratuita, pero es relativamente incontrolable cuando se usa y, naturalmente, es más propensa a errores.

Cuando un conjunto de datos solo implica la inserción y eliminación de datos en un extremo y satisface las características de último en entrar, primero en salir y primero en entrar, último en salir, se debe preferir la estructura de datos de "pila".

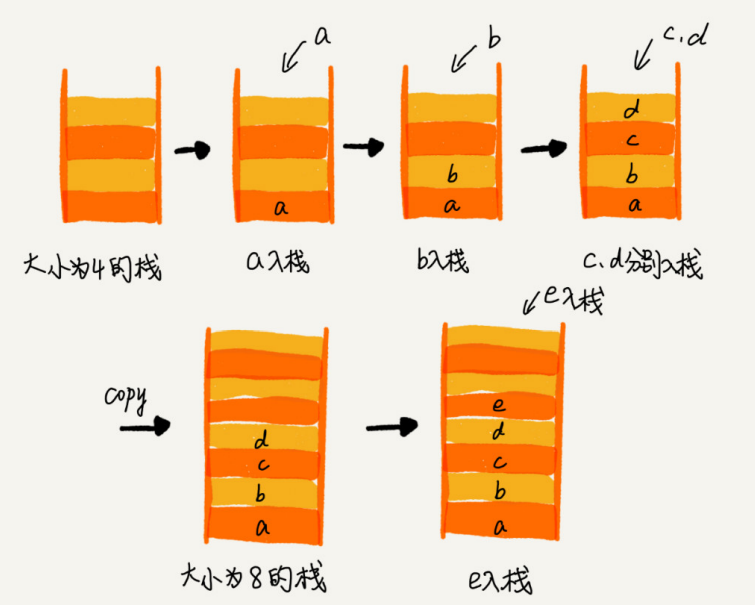

5.2 ¿Cómo implementar un "stack"?

La pila incluye principalmente dos operaciones, empujar y sacar, es decir, insertar datos en la parte superior de la pila y eliminar datos de la parte superior de la pila.

De hecho, una pila se puede implementar con una matriz o una lista enlazada. Una pila implementada con una matriz se llama pila secuencial, y una pila implementada con una lista enlazada se llama pila enlazada.

Aquí se implementa una pila secuencial basada en matriz

// 基于数组实现的顺序栈

public class ArrayStack {

private String[] items; // 数组

private int count; // 栈中元素个数

private int n; // 栈的大小

// 初始化数组,申请一个大小为 n 的数组空间

public ArrayStack(int n) {

this.items = new String[n];

this.n = n;