Resumen

El sistema de percepción de conducción panorámica es una parte importante de la conducción autónoma. Un sistema de percepción de alta precisión puede ayudar al vehículo a tomar decisiones más confiables mientras conduce. Demostramos una red de percepción panorámica YOLOP para realizar simultáneamente la detección de objetos de tráfico, la segmentación del área de conducción y la detección de líneas de carril . Consiste en una red de codificación para la extracción de características y tres redes de decodificación para tareas específicas. Nuestro modelo funciona muy bien en el conjunto de datos BDD100K, logrando la mejor exactitud y precisión en las tres tareas. Además, confirmamos el impacto del entrenamiento conjunto en este modelo multitarea a través de experimentos de ablación. Hasta donde sabemos, esta es la primera implementación en tiempo real de tres tareas de percepción visual en el dispositivo integrado TX2 y logró una precisión excelente. Para facilitar una mayor investigación, el código fuente abierto y el modelo preentrenado se encuentran en https://github.com/hustvl/YOLOP .

1. Introducción

Recientemente, un gran número de estudios de conducción autónoma han demostrado la importancia de los sistemas de percepción panorámica. Desempeña un papel importante en la conducción autónoma porque puede extraer información visual de las imágenes de la cámara para ayudar al sistema de toma de decisiones a controlar el comportamiento del vehículo. Para controlar mejor el vehículo, el sistema de percepción visual debe comprender la escena y luego proporcionar la siguiente información para el sistema de toma de decisiones: posición del obstáculo, si es un área transitable, posición de la línea del carril. La detección de objetos en los sistemas de reconocimiento panorámico ayuda a los vehículos a evitar obstáculos y obedecer las normas de tránsito. La detección de áreas de conducción y líneas de carril también son muy importantes, ya que son muy importantes para planificar las trayectorias de los vehículos.

Para un sistema de percepción panorámica, la alta precisión y el rendimiento en tiempo real son dos requisitos clave, que son cruciales para que el vehículo tome decisiones precisas y oportunas. En escenarios prácticos, limitados por los recursos informáticos de la computadora de a bordo, es bastante difícil cumplir con estos dos requisitos al mismo tiempo.

Muchos métodos manejan estas tareas por separado. Por ejemplo, Faster RCNN y YOLOv4 se pueden usar para la detección de objetivos; ENet y PSPNet se pueden usar para la segmentación semántica. SCNN y SADENet se pueden utilizar para detectar líneas de carril. Aunque estos métodos logran un buen rendimiento, realizar estas tareas por separado lleva más tiempo que la detección simultánea. Al implementar un sistema de percepción panorámica en un dispositivo integrado en el vehículo, se deben tener en cuenta los recursos informáticos limitados y los retrasos informáticos. Además, las diferentes tareas en una escena de tráfico suelen contener información relacionada. Como se muestra en la Figura 1, la línea del carril suele ser el límite del área transitable, y el área transitable suele rodear estrechamente los objetos de tráfico. Una red multitarea que procesa varias tareas simultáneamente en lugar de secuencialmente; la información se comparte entre varias tareas, que normalmente comparten una red troncal. Por lo tanto, es de gran importancia explorar métodos multitarea en la conducción autónoma.

Con el fin de resolver el problema de múltiples tareas en la red de percepción panóptica para obtener alta precisión y alta velocidad simultáneamente, diseñamos una red simple y eficiente. Usamos una CNN liviana como red de codificación para extraer características. Estos mapas de características de la red de codificación luego se procesan utilizando tres redes de decodificación. Utilizamos el modelo de detección de etapa única de mejor desempeño en esta etapa como la red de detección y decodificación: la red de etapa única es más rápida que la red de dos etapas; el cabezal de detección de etapa única basado en ancla está más correlacionado con el otro dos tareas de segmentación semántica, normalmente segmentación de instancias La tarea utiliza un cabezal de detección basado en regiones. Se verifican dos argumentos en la parte experimental: los mapas de características generados por la red de codificación contienen características semánticas de diferentes niveles y escalas, y nuestra rama de segmentación semántica puede usar estos mapas de características para la predicción semántica a nivel de píxel.

Además de la estrategia de entrenamiento integral, también experimentamos con algunos paradigmas de optimización alternativos para entrenar gradualmente nuestro modelo. Por un lado, podemos colocar tareas no relacionadas en diferentes pasos de entrenamiento para evitar la limitación mutua. Por otro lado, la tarea que se entrena primero puede guiar otras tareas. Así que este paradigma funciona a veces, pero es engorroso. Sin embargo, los experimentos muestran que este enfoque de entrenamiento alternativo no es necesario para nuestro modelo, ya que el entrenamiento de extremo a extremo puede funcionar bastante bien. Nuestro sistema de percepción de conducción panorámica logra 41 FPS en NVIDIA TITAN XP y 23 FPS en Jetson TX2; mientras tanto, logra lo último en tres tareas en el conjunto de datos BDD100K [28].

En general, nuestras principales contribuciones son: (1) Proponemos una red multitarea eficiente que puede manejar de manera conjunta tres tareas clave en la conducción autónoma: detección de objetos, segmentación de áreas manejables y detección de líneas de carril, para ahorrar costos computacionales y reducir el tiempo de inferencia. Nuestro trabajo es el primero en lograr la detección en tiempo real en un dispositivo integrado mientras se mantiene un rendimiento de última generación en el conjunto de datos BDD100K. (2) Diseñamos experimentos de ablación para verificar la efectividad de nuestro esquema multitarea. Demostramos que estas tres tareas se pueden aprender de forma conjunta sin la tediosa optimización alternativa. (3) A través de los experimentos de ablación, se encuentra que el mecanismo de predicción de la tarea de detección basada en cuadrículas es más relevante que el mecanismo de predicción de la tarea de segmentación semántica, que proporciona una referencia para otros trabajos de investigación de aprendizaje multitarea relacionados.

2. Trabajo relacionado

En esta sección, revisamos las soluciones a las tres tareas anteriores por separado y luego presentamos algunos trabajos de aprendizaje de tareas múltiples relacionados. Solo nos enfocamos en soluciones basadas en aprendizaje profundo.

2.1 Detección de objetos de tráfico

En los últimos años, con el rápido desarrollo del aprendizaje profundo, han surgido muchos algoritmos de detección de objetos destacados. Los algoritmos de detección de objetivos convencionales actuales se pueden dividir en métodos de dos etapas y métodos de una etapa.

El enfoque de dos etapas lleva a cabo la tarea de detección en dos pasos. En primer lugar, se obtienen propuestas de región y, a continuación, se utilizan las características de las propuestas de región para localizar y clasificar objetos. La generación de propuestas regionales ha pasado por varias etapas de desarrollo.

Los algoritmos de las series SSD y YOLO son representativos de los métodos de una etapa. El algoritmo puede realizar tanto la regresión del cuadro delimitador como la clasificación de objetos. YOLO divide la imagen en cuadrículas S×S en lugar de extraer propuestas de regiones con la red RPN, lo que acelera enormemente la detección. YOLO9000 presenta un mecanismo basado en anclas para mejorar la recuperación de las detecciones. YOLOv3 utiliza la estructura de red piramidal de características para lograr una detección multiescala. YOLOv4 mejora aún más el rendimiento de la detección al refinar la estructura de la red, la función de activación, la función de pérdida y la aplicación de un aumento de datos enriquecido.

2.2 Segmentación del área de conducción

Debido al rápido desarrollo del aprendizaje profundo, muchos métodos basados en CNN han logrado un gran éxito en el campo de la segmentación semántica y pueden aplicarse a la tarea de segmentación de áreas manejables, proporcionando resultados a nivel de píxel. FCN [15] introduce por primera vez una red totalmente convolucional para la segmentación semántica. A pesar de las mejoras en la conexión salteada , su rendimiento sigue estando limitado por la salida de baja resolución. PSPNet [30] propone un módulo de agrupación piramidal para extraer características a diferentes escalas para mejorar su rendimiento. Además de la precisión, la velocidad también es un factor clave para evaluar esta tarea. Para lograr la velocidad de inferencia en tiempo real, ENet [19] reduce el tamaño de los mapas de características. En los últimos años, se ha introducido el aprendizaje multitarea para manejar esta tarea, y EdgeNet [6] combina la detección de bordes con tareas de segmentación de áreas manejables para obtener resultados de segmentación más precisos sin afectar la velocidad de inferencia.

2.3 Detección de línea de carril

En la detección de carriles, hay muchas investigaciones innovadoras basadas en el aprendizaje profundo. [17] construyó una red de doble rama para la segmentación semántica y la incrustación de píxeles de imágenes. Las funciones de doble rama se agrupan aún más para lograr la segmentación de instancias de carril. SCNN [18] propone la convolución por segmentos, que permite que la información se transfiera entre píxeles a través de filas y columnas en una capa, pero tales convoluciones consumen mucho tiempo. Enet-SAD [9] emplea un método de destilación de autoatención para permitir que los mapas de características de bajo nivel se aprendan de los mapas de características de alto nivel. Este enfoque mejora el rendimiento del modelo mientras lo mantiene liviano.

2.4 Métodos para el aprendizaje multitarea

El objetivo del aprendizaje multitarea es aprender mejores representaciones compartiendo información entre múltiples tareas. En particular, los métodos de aprendizaje multitarea basados en CNN pueden lograr compartir la convolución en la estructura de la red. Mask R-CNN [7] agrega una rama de máscara de objeto predictivo a Faster RCNN, combinando de manera efectiva tareas de segmentación de instancias y detección de objetos, y estas dos tareas pueden mejorar el rendimiento de cada una. LSNet [3] resume la detección de objetos, la segmentación de instancias y la estimación de poses como reconocimiento visual sensible a la posición y utiliza una solución unificada para manejar estas tareas. MultiNet [25] realiza simultáneamente tres tareas conscientes de la escena de clasificación de escenas, detección de objetos y segmentación de áreas manejables a través de un codificador compartido y tres decodificadores independientes. DLT-Net [20] hereda la estructura codificador-decodificador y construye tensores de contexto entre decodificadores de subtareas para compartir información específica entre tareas. [29] propusieron una subestructura con correlación entre la segmentación del área del carril y la detección del límite del carril. Al mismo tiempo, se propone una nueva función de pérdida para restringir la línea del carril al contorno exterior del área del carril para que se superpongan geométricamente. Sin embargo, esta suposición anterior también limita su aplicación, por lo que solo es efectiva cuando la línea del carril envuelve estrechamente el área del carril. Además, también vale la pena pensar en el paradigma de entrenamiento de los modelos multitarea. [10] afirman que el entrenamiento conjunto es apropiado y beneficioso solo cuando todas estas tareas están efectivamente relacionadas; de lo contrario, es necesario recurrir a la optimización alterna. Por lo tanto, Faster R-CNN [24] emplea un método de entrenamiento práctico de 4 pasos para aprender características compartidas. Este patrón puede ser útil a veces, pero en su mayoría es redundante.

3. Metodología

Proponemos una red de avance simple y eficiente que puede realizar simultáneamente las tareas de detección de objetos de tráfico, segmentación de áreas transitables y detección de líneas de carril. Como se muestra en la Figura 2, nuestra red de percepción de conducción panorámica se llama YOLOP, que consiste en una red de codificación compartida y tres redes de decodificación para resolver tareas específicas. No hay bloques compartidos complejos y redundantes entre diferentes decodificadores, lo que reduce el consumo computacional y permite entrenar la red de extremo a extremo.

3.1 Codificador

Nuestra red comparte un codificador, que consta de una red troncal y una red de cuello.

3.1.1 Red troncal

Las características de la imagen de entrada se extraen mediante la red troncal. Por lo general, se utiliza alguna red clásica de clasificación de imágenes como columna vertebral. Debido al excelente desempeño de YOLOv4 en la detección de objetivos, elegimos CSPDarknet como la columna vertebral para resolver el problema de la replicación de gradientes en el proceso de optimización. Admite la propagación de características y la reutilización de características, lo que reduce la cantidad de parámetros y cálculos. Por lo tanto, es beneficioso garantizar el rendimiento en tiempo real de la red.

3.1.2 Red de cuello

La red de cuello se utiliza para fusionar las características producidas por la red troncal. Nuestra red de cuello consiste principalmente en un módulo de agrupación de pirámide espacial y un módulo de pirámide de características. SPP genera y fusiona características de diferentes escalas, y FPN fusiona características de diferentes niveles semánticos, de modo que las características generadas contienen información de múltiples escalas y múltiples niveles semánticos. Adoptamos el método de Concat para fusionar características.

3.2 Decodificador

Tres cabezales decodificadores están diseñados para tres tareas específicas.

3.2.1 Cabezal de detección

Similar a YOLOv4, adoptamos un esquema de detección de múltiples escalas basado en cuadros de anclaje. En primer lugar, empleamos una arquitectura de aumento de ruta (PAN), una red piramidal de características de abajo hacia arriba. FPN transfiere características semánticas de arriba hacia abajo, mientras que PAN transfiere características posicionales de abajo hacia arriba. Los combinamos para obtener un mejor efecto de fusión de características y luego usamos directamente el mapa de características de fusión multiescala en PAN para la detección. Luego, a cada punto característico se le asignan tres cuadros de anclaje con diferentes relaciones de aspecto. Estos cabezales de detección predecirán las coordenadas del cuadro delimitador, la longitud y el ancho, la confianza de si contiene el objeto y la probabilidad de a qué clase pertenece el objeto.

3.2.2 Cabezal de segmentación de áreas transitables y cabezal de segmentación de carriles

El cabezal de segmentación de áreas transitables y el cabezal de segmentación de líneas de carril adoptan la misma estructura. La última capa de FPN sirve como entrada a la rama de segmentación (W/8, H/8, 256). Nuestra rama dividida es muy simple. Después de tres veces de muestreo, restauramos el mapa de características de entrada al tamaño (W, H, 2), que representa la probabilidad de áreas transitables/líneas de carril y fondo en la imagen de entrada. Dado que el módulo SPP se comparte en la red de cuello, no se agregan módulos SPP adicionales a la rama dividida en esta red, lo que reduce en parte el rendimiento de la red. Además, usamos la interpolación del vecino más cercano para el muestreo superior en lugar de la deconvolución, lo que ahorra costos computacionales. Por lo tanto, nuestro decodificador de segmentación no solo es muy preciso, sino también rápido.

3.3 Función de pérdida

Debido a que hay tres decodificadores en la red, la función de pérdida consta de tres partes. Para la pérdida de detección, es una suma ponderada de pérdida de clase, pérdida de objeto y pérdida de límite.

![]()

La pérdida de categoría y la pérdida objetivo son pérdidas focales, que se utilizan para reducir la pérdida de muestras fáciles de clasificar y hacer que la red se centre en muestras difíciles. La pérdida de contorno es una pérdida CIOU, que considera la distancia, la tasa de superposición y la relación de aspecto. Ambas ramas de segmentación adoptan la pérdida de CE para minimizar el error de clasificación entre el valor predicho y el valor real en el mapa de características de salida de la red. ![]() Vale la pena señalar que la pérdida de IoU ( ) se agrega a la pérdida de línea de carril , lo que puede mejorar el efecto de la red que predice líneas de carril dispersas.

Vale la pena señalar que la pérdida de IoU ( ) se agrega a la pérdida de línea de carril , lo que puede mejorar el efecto de la red que predice líneas de carril dispersas.

En general, la pérdida es una suma ponderada de estas tres partes.

![]()

3.4 Métodos de entrenamiento

Probamos diferentes formas de entrenar el modelo. La forma más sencilla es la capacitación de extremo a extremo, que puede aprender tres tareas al mismo tiempo. Pero cuando todas las tareas están relacionadas, este método de entrenamiento es efectivo. Además, también probamos el entrenamiento alternativo. En cada paso, el modelo solo puede enfocarse en una o más tareas relacionadas sin considerar tareas irrelevantes. Incluso si no todas las tareas están relacionadas, nuestro modelo puede aprender completamente cada tarea de esta manera. El método de entrenamiento paso a paso se muestra en el Método 1.

4. Experimenta

4.1 Configuración

4.1.1 Configuración del conjunto de datos

El conjunto de datos BDD100K respalda la investigación de aprendizaje multitarea en el campo de la conducción autónoma. Debido a la diversidad geográfica, ambiental y climática del conjunto de datos, los modelos entrenados en el conjunto de datos BDD100K son lo suficientemente sólidos como para transferirse a nuevos entornos. Por lo tanto, elegimos BDD100K para entrenar y evaluar nuestro modelo. El conjunto de entrenamiento contiene 70 000 imágenes, el conjunto de validación contiene 10 000 imágenes y el conjunto de prueba contiene 20 000 imágenes. Dado que las etiquetas del conjunto de prueba no están disponibles públicamente, probamos en el conjunto de validación.

4.1.2 Detalles adicionales

Para mejorar el rendimiento del modelo, empleamos algunas técnicas y métodos de aumento de datos empíricamente.

Para hacer que el cabezal de detección contenga más conocimiento previo, usamos el algoritmo de agrupamiento k-means para obtener el cuadro anterior del conjunto de datos. Adam se utiliza como optimizador, y la tasa de aprendizaje se inicializa... Durante el proceso de entrenamiento, el entrenamiento de precalentamiento y el algoritmo de recocido de coseno se utilizan para ajustar la tasa de aprendizaje, con el objetivo de hacer que el modelo converja más rápido.

Empleamos el aumento de datos para aumentar la diversidad del gráfico y hacer que el modelo sea más robusto...

4.2 Resultados

En esta sección, entrenamos brevemente nuestro modelo de principio a fin y luego comparamos los resultados de YOLOP y otros modelos representativos en tres tareas.

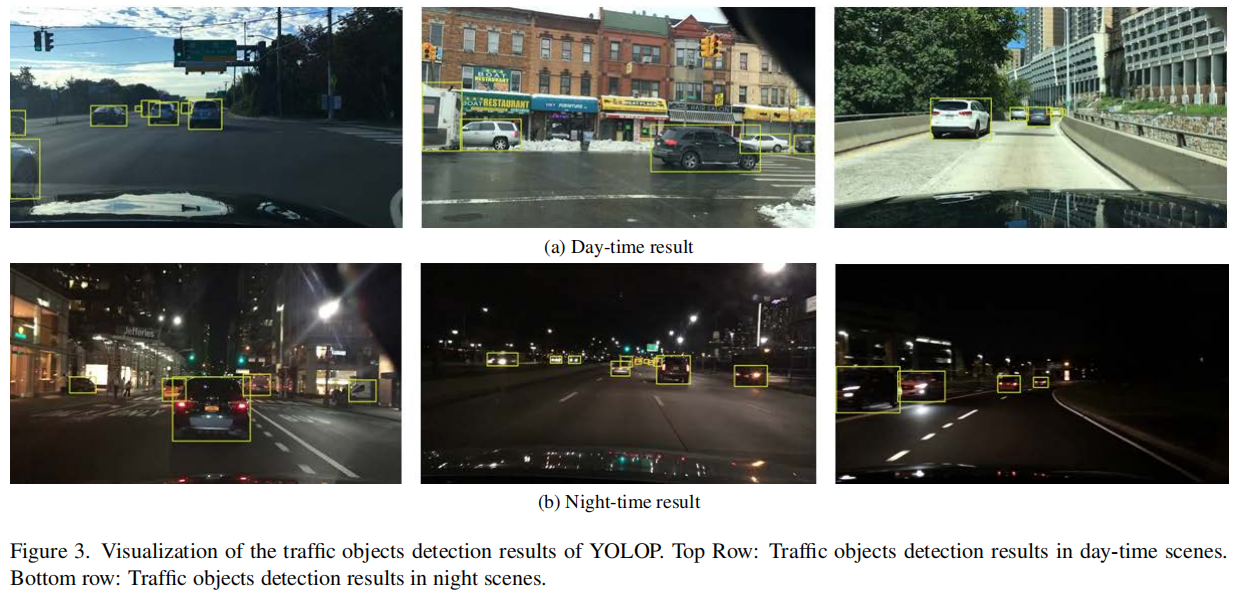

4.2.1 Resultados de la detección de objetos de tráfico

Los resultados de visualización de la detección de objetos de tráfico se muestran en la Figura 3. Dado que Multinet y DLT-Net solo pueden detectar vehículos, solo consideramos los resultados de detección de cinco modelos para vehículos. Como se muestra en la Tabla 1, usamos el recuerdo y mAP50 como métricas de evaluación para la precisión de detección. Nuestro modelo supera a Faster-RCNN, MultiNet y DLTNet en precisión de detección. Comparado con YOLOv5, YOLOP no es muy diferente en precisión porque usa muchos trucos. YOLOP puede realizar la detección en tiempo real, y YOLOv5 es más rápido porque no hay un cabezal de segmentación de área manejable ni un cabezal de segmentación de detección de línea de carril.

La Figura 4 es una comparación cualitativa de YOLOP y Faster RCNN. Debido al intercambio de información entre múltiples tareas, los resultados de predicción de YOLOP son más razonables. Por ejemplo, YOLOP no identifica erróneamente los objetos alejados del carril como vehículos. Además, FN tiene menos ejemplos y cuadros delimitadores más precisos.

4.2.2 Resultados de la segmentación del área transitable

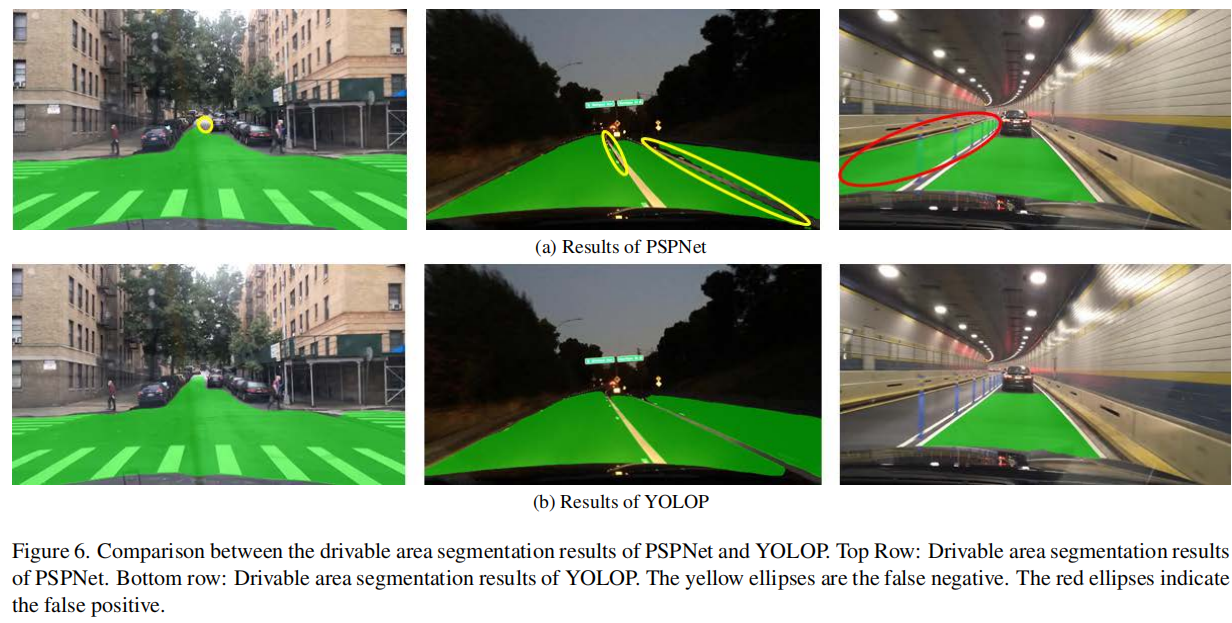

Los resultados de visualización de la segmentación del área manejable se muestran en la Fig. 5. En este documento, tanto el área/conducible como el área/alternativa se consideran áreas conducibles. Nuestro modelo solo necesita distinguir las regiones manejables del fondo de la imagen. El rendimiento de segmentación del modelo se evalúa utilizando mIoU, como se muestra en la Tabla 2. Se puede ver que nuestro modelo es 19,9%, 20,2% y 1,9% mejor que MultiNet, DLTNet y PSPNet, respectivamente. Y, la velocidad de inferencia del modelo es de 4 a 5 veces más rápida que ellos.

Los resultados de PSPNet y YOLOP se comparan como se muestra en la Figura 6. Tanto PSPNet como YOLOP se desempeñan muy bien en esta tarea. Pero YOLOP es significativamente mejor en la segmentación de regiones de borde junto a vehículos o líneas de carril. Creemos que esto se debe principalmente a que las otras dos tareas proporcionan información marginal para esta tarea. Al mismo tiempo, YOLOP cometió menos errores estúpidos, como juzgar mal el área del carril opuesto como un área manejable.

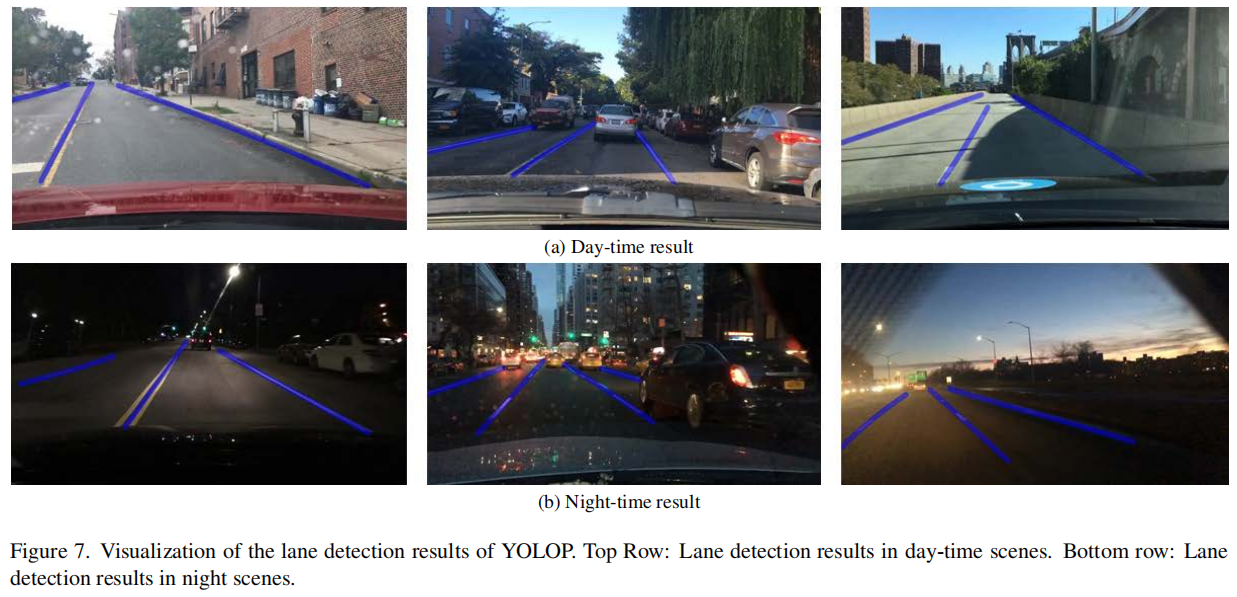

4.2.3 Resultados de detección de línea de carril

Los resultados de visualización de la detección de carriles se muestran en la Figura 7. Las líneas de carril en el conjunto de datos BDD100K están marcadas con dos líneas, por lo que usar anotaciones directamente es complicado. La configuración experimental sigue [9] para facilitar la comparación. Primero, calculamos la línea central en función de las dos líneas de anotación. Luego, establecemos el ancho de las líneas de los carriles para el entrenamiento en 8 píxeles, mientras mantenemos el ancho de las líneas de los carriles para el conjunto de prueba en 2 píxeles. Utilizamos la precisión de píxeles y el IoU de carriles como métricas de evaluación. Como se muestra en la Tabla 3, nuestro modelo supera a los otros tres modelos por un amplio margen. La Figura 8 es una comparación de los resultados de detección de línea de carril de ENet-SAD y YOLOP. Los resultados de segmentación de YOLOP son significativamente más precisos y continuos que los de ENet-SAD. YOLOP no malinterpreta las áreas donde se encuentran o se pueden conducir algunos vehículos como líneas de carril debido a la información compartida por las otras dos tareas, pero Enet-SAD siempre lo hace.

4.3 Experimento de ablación

Diseñamos los siguientes tres experimentos de ablación para ilustrar aún más la eficacia de nuestro esquema. Todas las métricas de evaluación en esta sección son consistentes con lo anterior.

4.3.1 Entrenamiento conjunto vs entrenamiento individual

En la Tabla 4, comparamos el rendimiento del método de entrenamiento conjunto con múltiples métodos de entrenamiento alternativos. Claramente, nuestro modelo ya funciona muy bien a través del entrenamiento de extremo a extremo, por lo que no hay necesidad de una optimización alternativa. Curiosamente, los métodos que primero se entrenan en la tarea de detección de objetos muestran un mejor rendimiento. Creemos que esto se debe principalmente a que nuestro modelo está más cerca de un modelo de detección completa y es más difícil que el modelo converja al realizar la tarea de detección. Más importante aún, el método de tres pasos funciona ligeramente mejor que el método de dos pasos. Se puede realizar un entrenamiento alternativo similar con muchos más pasos, pero observamos mejoras insignificantes.

Nota: E, D, S, W son el codificador, el cabezal de detección, dos cabezales de segmentación y toda la red, respectivamente. Por lo tanto, el método 1 se puede etiquetar como ED-SW, al igual que los otros métodos.

4.3.2 Multitarea vs monotarea

Para verificar la efectividad de nuestro esquema de aprendizaje multitarea, comparamos el desempeño de los esquemas multitarea y monotarea. Por un lado, entrenamos a nuestro modelo para que realice 3 tareas simultáneamente. Por otro lado, entrenamos a nuestros modelos para realizar las tareas de detección de objetos de tráfico, segmentación de áreas transitables y segmentación de líneas de carril, respectivamente. La Tabla 5 muestra la comparación del desempeño de estos dos esquemas en cada tarea específica. Se puede ver que nuestro modelo emplea un esquema multitarea para lograr un rendimiento cercano al de una sola tarea. Además, el modelo multitarea puede ahorrar mucho tiempo en comparación con la realización de cada tarea individualmente.

4.3.3 Basado en cuadrícula frente a basado en región

Probar la idea de que los mecanismos de predicción basados en cuadrículas son más relevantes para dos tareas de segmentación semántica que los mecanismos de predicción basados en regiones. Ampliamos Faster RCNN agregando dos cabezales de segmentación, llamando a este modelo RCNN-P. (i) realizar tareas de detección y dos tareas de segmentación por separado, (ii) realizar tres tareas simultáneamente. En los dos experimentos anteriores, las dos tareas de segmentación se entrenan conjuntamente porque no es necesario considerar la interacción entre ellas. Todos los escenarios experimentales son iguales, y los resultados se muestran en la Tabla 6. En el marco R-CNNP, el rendimiento del entrenamiento multitarea es mucho peor que el entrenamiento de las tareas de detección y las tareas de segmentación semántica por separado. Obviamente, en el marco de R-CNNP, hay un conflicto en la combinación de las dos tareas. Pero no existe tal problema en nuestro marco YOLOP, y la realización de un entrenamiento multitarea equivale a centrarse solo en tareas de detección o segmentación semántica. Por lo tanto, creemos que esto se debe al hecho de que el cabezal de detección de YOLOP realiza directamente tareas de clasificación global o regresión en todo el mapa de características generado por el codificador como los otros dos cabezales de segmentación semántica, por lo que son similares y están relacionados en términos de mecanismo de predicción. Sin embargo, el jefe de detección de R-CNNP necesita seleccionar primero las propuestas de la región y luego hacer predicciones sobre los mapas de características de cada propuesta individual, lo cual es bastante diferente del mecanismo de predicción global de la segmentación semántica. Además, R-CNNP va muy por detrás de YOLOP en términos de velocidad de inferencia. Por lo tanto, nuestro marco es una mejor opción para la formación conjunta en tareas de detección y segmentación.

5. Conclusión

Este documento propone una red novedosa, simple y eficiente que puede manejar simultáneamente las tres tareas de percepción de conducción autónoma de detección de objetos, segmentación de áreas manejables y detección de líneas de carril, y puede entrenarse de extremo a extremo. Nuestro modelo funciona notablemente bien en el desafiante conjunto de datos BDD100k, logrando o superando sustancialmente el estado del arte en las tres tareas. Es el primero en lograr la inferencia en tiempo real en un dispositivo integrado Jetson TX2, lo que garantiza que nuestra red se pueda utilizar en escenarios del mundo real. Además, también verificamos que el mecanismo de predicción basado en grillas es más relevante para la tarea de segmentación semántica. Esto puede tener cierto significado de referencia para trabajos de investigación de aprendizaje multitarea similares.

Actualmente, si bien nuestras redes multitarea pueden capacitarse de principio a fin sin comprometer el desempeño de las demás, esperamos mejorar el desempeño de estas tareas a través de métodos de aprendizaje multitarea más apropiados. Además, nuestro modelo actualmente solo puede realizar tres tareas simultáneamente, y en el marco futuro se pueden agregar más tareas relacionadas con los sistemas de percepción de conducción autónoma, como la estimación de profundidad, para hacer que todo el sistema sea más completo y práctico.