1. Historia de Linux

1,Unix

La relación entre UNIX y Linux es un tema interesante. Entre los principales sistemas operativos actuales del lado del servidor, UNIX nació a fines de la década de 1960, Windows nació a mediados de la década de 1980 y Linux nació a principios de la década de 1990. Se puede decir que UNIX es el "hermano mayor" en el sistema operativo Tanto Windows como Linux más tarde hicieron referencia a UNIX.

El sistema operativo UNIX fue inventado por Ken Thompson y Dennis Ritchie. Parte de sus orígenes técnicos se remontan al programa de ingeniería Multics iniciado en 1965, iniciado por Bell Labs, el Instituto de Tecnología de Massachusetts y General Electric Company con el objetivo de desarrollar un programa interactivo de programación múltiple. sistema operativo compartido capaz de reemplazar el sistema operativo por lotes que se usaba ampliamente en ese momento.

Descripción: el sistema operativo de tiempo compartido permite que una computadora preste servicios a varios usuarios al mismo tiempo, y los usuarios de la terminal conectados a la computadora emiten comandos de forma interactiva. El tiempo de la CPU se divide en varios segmentos, llamados intervalos de tiempo). El sistema operativo toma intervalos de tiempo como una unidad y sirve a cada usuario final por turno, un intervalo de tiempo a la vez.

Desafortunadamente, el proyecto Multics era tan grande y complejo que sus desarrolladores no tenían idea de cómo sería y terminó en un fracaso.

Los investigadores de Bell Labs encabezados por Ken Thompson aprendieron las lecciones del fracaso del proyecto Multics y realizaron el prototipo de un sistema operativo de tiempo compartido en 1969, que se denominó oficialmente UNIX en 1970.

Curiosamente, la intención original de Ken Thompson para desarrollar UNIX era ejecutar un juego de computadora que escribió, Space Travel, que simula el movimiento de los cuerpos celestes en el sistema solar, con jugadores pilotando naves espaciales, viendo el paisaje e intentando aterrizar en varios planetas y lunas. . Probó sucesivamente en múltiples sistemas, pero los resultados no fueron satisfactorios, por lo que decidió desarrollar su propio sistema operativo, y así nació UNIX.

Desde 1970, el sistema UNIX se ha vuelto gradualmente popular entre los programadores dentro de Bell Labs. En 1971-1972, el colega de Ken Thompson, Dennis Ritchie, inventó el legendario lenguaje C, un lenguaje de alto nivel adecuado para escribir software de sistemas. Su nacimiento fue un hito importante en el desarrollo de los sistemas UNIX. En el desarrollo de los sistemas operativos, el lenguaje ensamblador es ya no es el idioma dominante.

En 1973, la mayor parte del código fuente del sistema UNIX se reescribió en lenguaje C, lo que sentó las bases para mejorar la portabilidad del sistema UNIX (los sistemas operativos anteriores usaban principalmente lenguaje ensamblador, que dependía en gran medida del hardware). condiciones para mejorar la eficiencia de desarrollo del software del sistema. Se puede decir que el sistema UNIX y el lenguaje C son hermanos gemelos y tienen una relación inseparable.

A principios de la década de 1970, hubo otro gran invento en el mundo de la informática: el protocolo TCP/IP, que era un protocolo de red desarrollado después de que el Departamento de Defensa de EE. UU. se hiciera cargo de ARPAnet. El Departamento de Defensa de los EE. UU. empaquetó el protocolo TCP/IP con el sistema UNIX y el lenguaje C, y AT&T emitió una licencia no comercial para varias universidades de los Estados Unidos, lo que dio inicio al desarrollo del sistema UNIX, el C y el protocolo TCP/IP, que han influido en los tres campos de sistema operativo, lenguaje de programación y protocolo de red, respectivamente. Ken Thompson y Dennis Ritchie recibieron el Premio Turing, el premio más importante en informática, en 1983 por sus destacadas contribuciones al campo de la informática.

Posteriormente, aparecieron varias versiones de sistemas UNIX, como Sun Solaris, FreeBSD, IBM AIX, HP-UX, etc.

2. Solaris y FreeBSD

Solaris es una rama importante del sistema UNIX. Solaris puede ejecutarse en plataformas de CPU x86 además de plataformas de CPU SPARC. En el mercado de servidores, la plataforma de hardware de Sun tiene alta disponibilidad y alta confiabilidad, y es el sistema UNIX dominante en el mercado. Solaris x86 es un servidor que se utiliza para aplicaciones de producción reales. Solaris x86 se puede utilizar de forma gratuita para aplicaciones de estudio, investigación o comerciales, sujeto a los términos de licencia pertinentes de Sun.

FreeBSD se originó a partir de la versión UNIX desarrollada por la Universidad de California, Berkeley, es desarrollado y mantenido por voluntarios de todo el mundo, brindando diferentes niveles de soporte para sistemas informáticos con diferentes arquitecturas. FreeBSD se publica bajo el acuerdo de licencia BSD, que permite que cualquier persona lo use y distribuya libremente con la premisa de conservar la información del acuerdo de licencia y los derechos de autor, y no restringe la distribución del código FreeBSD bajo otro acuerdo, por lo que las empresas comerciales pueden integrar libremente el código FreeBSD en en sus productos. OS X de Apple es un sistema operativo basado en FreeBSD.

Una parte considerable de los grupos de usuarios de FreeBSD y Linux se superponen, los entornos de hardware compatibles con los dos también son relativamente consistentes y el software utilizado es relativamente similar. La mayor característica de FreeBSD es la estabilidad y la eficiencia, y es una buena opción como sistema operativo de servidor; sin embargo, su soporte de hardware no es tan completo como el de Linux, por lo que no es adecuado como sistema de escritorio.

3. El nacimiento de Linux

El kernel de Linux fue escrito originalmente por Linus Torvalds como un pasatiempo cuando era estudiante en la Universidad de Helsinki, en ese momento sintió que Minix, una versión mini del sistema operativo UNIX para la enseñanza, era demasiado difícil de usar, por lo que decidió desarrollar su propio sistema operativo. La versión 1 se lanzó en septiembre de 1991 con solo 10 000 líneas de código.

Linus Torvalds no mantuvo los derechos de autor del código fuente de Linux, hizo público el código e invitó a otros a mejorar Linux juntos. A diferencia de Windows y otros sistemas operativos propietarios, Linux es de código abierto y gratuito para que cualquiera lo use.

Se estima que solo el 2 % del código del kernel de Linux ahora está escrito por el propio Linus Torvalds, aunque todavía posee el kernel de Linux (la parte central del sistema operativo) y conserva nuevas formas de seleccionar código nuevo y necesita fusionar el código final. derecho rector. El Linux que todo el mundo usa ahora, prefiero decir que fue desarrollado conjuntamente por Linus Torvalds y muchos expertos en Linux que se incorporaron más tarde.

El software de fuente abierta es un modelo que es diferente del software comercial. Literalmente, significa código de fuente abierta. No tiene que preocuparse por ningún truco, lo que traerá innovación y seguridad al software.

Linux es muy popular entre los entusiastas de la informática por dos razones principales:

- Pertenece al software de código abierto, los usuarios pueden obtenerlo y su código fuente sin pagar una tarifa, y pueden realizar las modificaciones necesarias según sus propias necesidades, usarlo de forma gratuita y continuar difundiéndolo sin restricciones;

- Tiene todas las características de UNIX, y cualquiera que use el sistema operativo UNIX o quiera aprender el sistema operativo UNIX puede beneficiarse de Linux.

Además, el código abierto en realidad no es equivalente a libre, sino un nuevo modelo de ganancias de software. En la actualidad, muchos programas son de código abierto, lo que tiene un profundo impacto en la industria informática e Internet.

2. Introducción al núcleo de Linux

1. La composición del sistema informático.

Un sistema informático es una simbiosis de hardware y software, que son interdependientes e inseparables.

El hardware de la computadora, incluidos los periféricos, los procesadores, la memoria, los discos duros y otros dispositivos electrónicos, constituye el motor de la computadora, pero sin un software que la opere y controle, no puede funcionar por sí misma.

El software que completa este trabajo de control se llama sistema operativo. El sistema operativo es el software del sistema que administra los recursos de hardware y software de la computadora, y también es el núcleo y la piedra angular del sistema informático. El sistema operativo necesita manejar tareas básicas como administrar y configurar la memoria, priorizar el suministro y la demanda de recursos del sistema, controlar los dispositivos de entrada y salida, operar la red y administrar el sistema de archivos. El sistema operativo también proporciona una interfaz para que el usuario interactúe con el sistema.

La composición del sistema operativo:

Bootloader: Es el principal responsable del proceso de arranque del dispositivo.

Shell: Shell es un lenguaje de programación que puede controlar otros archivos, procesos y todos los demás programas.

Kernel: Es el componente principal del sistema operativo, gestiona la memoria, la CPU y otros componentes relacionados.

Entorno de escritorio: este es el entorno con el que los usuarios suelen interactuar.

Servidor gráfico: Es un subsistema del sistema operativo que muestra gráficos en la pantalla

Aplicaciones: Son ensamblajes que realizan diferentes tareas del usuario como word, excel, etc.

· Daemons: proveedores de servicios backend.

2. ¿Qué es el Núcleo?

El núcleo es una parte clave del sistema operativo porque controla todos los programas del sistema. Actúa como un puente entre las aplicaciones y el procesamiento de datos a nivel de hardware con la ayuda de la comunicación entre procesos y las llamadas al sistema.

Cuando el dispositivo arranca, el sistema operativo se carga en la memoria, momento en el que el kernel pasa por un proceso de inicialización que se ocupa de la parte de asignación de memoria y la mantiene allí hasta que el sistema operativo se apaga. Y crea un entorno en el que ejecutar aplicaciones, donde el kernel se encarga de tareas de bajo nivel como la gestión de tareas, la gestión de la memoria, la gestión de riesgos, etc.

El kernel actúa como un proveedor de servicios, por lo que un programa puede pedirle al kernel que realice varias tareas, como solicitar el uso de un disco, una tarjeta de red u otro hardware, y el kernel establece interrupciones para que la CPU permita la multitarea. Protege el entorno informático al evitar que programas erróneos entren en las funciones operativas de otros programas. Bloquea la entrada de programas no autorizados al no permitir espacio de almacenamiento y limita la cantidad de dinero que consumen

tiempo de CPU.

en breve:

1. Desde un punto de vista técnico, el núcleo es una capa intermedia entre el hardware y el software. La función es pasar la solicitud de la capa de aplicación al hardware y actuar como el controlador subyacente para abordar varios dispositivos y componentes en el sistema.

2. Desde el nivel de la aplicación, la aplicación no tiene conexión con el hardware, sino solo con el kernel, que es la capa más baja en la jerarquía que conoce la aplicación. En la práctica, el kernel abstrae los detalles relevantes.

3. El núcleo es un administrador de recursos. Responsable de asignar los recursos compartidos disponibles (tiempo de CPU, espacio en disco, conexión de red, etc.) a varios procesos del sistema.

4. El núcleo es como una biblioteca que proporciona un conjunto de comandos orientados al sistema. Las llamadas al sistema son como llamar funciones ordinarias a una aplicación.

3. Clasificación de los granos

En general, hay tres categorías de núcleos:

1. Kernel monolítico: contiene una serie de controladores de dispositivos que crean una interfaz de comunicación entre el hardware y el software de un dispositivo.

Es el kernel muy utilizado por los sistemas operativos. En una arquitectura monolítica, el kernel consta de varios módulos que pueden cargarse y descargarse dinámicamente. Esta arquitectura extenderá la funcionalidad del sistema operativo y permitirá una fácil extensión del kernel.

Con una arquitectura monolítica, el mantenimiento del núcleo se facilita porque permite cargar y descargar módulos relacionados cuando es necesario corregir un error en un módulo en particular. Por lo tanto, elimina el tedioso trabajo de bajar y volver a compilar todo el kernel para realizar pequeños cambios. En un núcleo monolítico, es más fácil descargar módulos que ya no se utilizan.

2. Micro kernel: solo puede realizar funciones básicas.

Los micronúcleos se han desarrollado como una alternativa a los núcleos monolíticos para abordar el creciente problema del código del núcleo que los núcleos monolíticos no pueden. Esta arquitectura permite que ciertos servicios básicos (como pilas de protocolos, administración de controladores de dispositivos, sistemas de archivos, etc.) se ejecuten en el espacio del usuario. Esto mejora la funcionalidad del sistema operativo con un código mínimo, mejora la seguridad y garantiza la estabilidad.

Limita el daño a las áreas afectadas al permitir que el resto del sistema funcione sin interrupción. En una arquitectura de microkernel, todos los servicios esenciales del sistema operativo están disponibles para los programas a través de la comunicación entre procesos (IPC). Los micronúcleos permiten la interacción directa entre los controladores de dispositivos y el hardware.

3. Núcleo híbrido: combina varios aspectos del núcleo monolítico y el micronúcleo.

Un núcleo híbrido puede decidir qué ejecutar en modo usuario y modo supervisor. Por lo general, en un entorno de kernel mixto, elementos como los controladores de dispositivos y la E/S del sistema de archivos se ejecutarán en modo de usuario, mientras que las llamadas al servidor y el IPC permanecerán en modo de supervisor.

4. Género de diseño del kernel

1. Micronúcleo. Las funciones más básicas son implementadas por un kernel central (microkernel). Windows NT utiliza la arquitectura de micronúcleo. Por las características de la arquitectura del microkernel, la parte central del sistema operativo es un pequeño kernel que implementa algunos servicios básicos, como la creación y eliminación de procesos, la gestión de memoria, la gestión de interrupciones, etc. Las otras partes del sistema de archivos, los protocolos de red, etc., se ejecutan en el espacio del usuario fuera del microkernel. Estas funciones se delegan a unos pocos procesos independientes que se comunican con el kernel central a través de interfaces de comunicación bien definidas.

2. Núcleo macro (único). Todo el código para el núcleo, incluidos los subsistemas (como la gestión de memoria, gestión de archivos, controladores de dispositivos) se empaqueta en un solo archivo. Todas las funciones se realizan juntas, todas en el núcleo, es decir, todo el núcleo es un solo programa muy grande. Cada función en el kernel tiene acceso a todas las demás partes del kernel. En la actualidad, se admite la carga y descarga dinámica (recorte) de módulos, y el kernel de Linux se implementa en función de esta estrategia.

Un sistema operativo que usa un microkernel tiene buena escalabilidad y el kernel es muy pequeño, pero dicho sistema operativo es ineficiente debido al costo del paso de mensajes entre diferentes capas. Para un sistema operativo de arquitectura única, todos los módulos están integrados juntos, la velocidad y el rendimiento del sistema son buenos, pero la escalabilidad y la capacidad de mantenimiento son relativamente deficientes.

Hablando lógicamente, la estructura de microkernel de Linux está implementada, pero no lo está, Linux es una estructura de un solo kernel (monolítica). Esto significa que, si bien Linux se divide en varios subsistemas que controlan varios componentes del sistema (como la gestión de la memoria y la gestión de procesos), todos los subsistemas están estrechamente integrados para formar el kernel completo.

Por el contrario, un sistema operativo de microkernel proporciona un conjunto mínimo de funciones, y todas las demás capas del sistema operativo se ejecutan según el proceso sobre el microkernel. Los sistemas operativos de microkernel son generalmente menos eficientes debido al paso de mensajes entre capas, pero dichos sistemas operativos son muy escalables.

Hablando fundamentalmente, es una de las filosofías de diseño de Linux descomponer una cosa en pequeños problemas, y luego cada pequeño problema es solo responsable de una tarea.El kernel de Linux se puede extender a través de módulos.

Un módulo es un programa que se ejecuta en el espacio del núcleo, que en realidad es una especie de archivo de objeto. No está vinculado y no se puede ejecutar de forma independiente, pero su código se puede vincular al sistema en tiempo de ejecución para que se ejecute como parte del núcleo. o tomado del núcleo, para que pueda extenderse dinámicamente la funcionalidad del núcleo.

Este código objeto generalmente consiste en un conjunto de funciones y estructuras de datos que se utilizan para implementar un sistema de archivos, un controlador u otra funcionalidad del núcleo superior. El nombre completo del mecanismo del módulo debe ser un módulo de kernel cargable dinámicamente (módulo de kernel cargable) o LKM, generalmente denominado módulo. A diferencia de los procesos antes mencionados que se ejecutan en el espacio de usuario externo del sistema operativo del sistema microkernel, el módulo no se ejecuta como un proceso, pero al igual que otras funciones del kernel vinculadas estáticamente, se ejecuta en nombre del proceso actual en modo kernel. Debido a la introducción del mecanismo del módulo, el kernel de Linux se puede minimizar, es decir, algunas funciones básicas se implementan en el kernel, como la interfaz del módulo al kernel, la forma en que el kernel administra todos los módulos, etc. y la escalabilidad del sistema se deja al módulo para completar.

Los módulos tienen características de kernel que brindan los beneficios de un microkernel sin la sobrecarga adicional.

5. Funciones del núcleo

El kernel de Linux implementa muchas propiedades arquitectónicas importantes. En un nivel superior o inferior, el núcleo se divide en subsistemas.

Linux también puede verse como un todo porque integra todos estos servicios básicos en el kernel. Esto es diferente de la arquitectura de microkernel, que proporciona algunos servicios básicos como comunicación, E/S, memoria y administración de procesos, y servicios más específicos se conectan a la capa de microkernel.

Las tareas principales del núcleo son:

· Gestión de procesos para la ejecución de aplicaciones.

· Gestión de memoria y E/S (entrada/salida).

· Control de llamadas al sistema (comportamiento central del núcleo).

· Gestión de dispositivos con controladores de dispositivos.

· Proporcionar un entorno de ejecución para la aplicación.

6. Las funciones principales del núcleo

Las funciones principales del kernel de Linux son: administración de almacenamiento, administración de CPU y procesos , sistema de archivos, administración y controlador de dispositivos, comunicación de red e inicialización del sistema (arranque), llamadas al sistema, etc.

Las funciones principales son las siguientes:

- Gestión de la memoria del sistema

- gestión de programas de software

- gestión de dispositivos de hardware

- gestión del sistema de archivos

1) Gestión de la memoria del sistema

Una de las principales funciones del núcleo del sistema operativo es la gestión de la memoria. El kernel administra no solo la memoria física disponible en el servidor, sino que también crea y administra la memoria virtual (es decir, la memoria que en realidad no existe).

El núcleo implementa la memoria virtual a través del espacio de almacenamiento en el disco duro, que se denomina espacio de intercambio. El núcleo intercambia constantemente el contenido de la memoria virtual entre el espacio de intercambio y la memoria física real. Esto hace que el sistema piense que tiene más memoria disponible que la memoria física.

Una unidad de almacenamiento de memoria se divide en grupos en bloques llamados páginas. El núcleo coloca cada página de memoria en la memoria física o espacio de intercambio. Luego, el kernel mantiene una tabla de páginas de memoria que indica qué páginas están en la memoria física y qué páginas se intercambian en el disco.

2) Gestión de programas de software

El sistema operativo Linux se refiere a ejecutar programas como procesos. Los procesos pueden ejecutarse en primer plano, mostrando la salida en la pantalla, o en segundo plano, escondiéndose detrás de escena. El kernel controla cómo el sistema Linux administra todos los procesos que se ejecutan en el sistema.

El kernel crea el primer proceso (llamado proceso init) para iniciar todos los demás procesos en el sistema. Cuando se inicia el núcleo,

carga el proceso de inicio en la memoria virtual. Cuando el kernel inicia cualquier otro proceso, asigna un área dedicada en la memoria virtual para que el nuevo proceso almacene los datos y el código utilizado por ese proceso.

Algunas distribuciones de Linux usan una tabla para administrar los procesos para que se inicien automáticamente cuando se enciende el sistema. En los sistemas Linux, esta tabla suele estar ubicada en el archivo especial /etc/inittab.

Otros sistemas (como la popular distribución Ubuntu Linux) usan el directorio /etc/init.d, donde

se colocan los scripts que inician o detienen una aplicación en el arranque. Estos scripts se inician a través de entradas en el directorio /etc/rcX.d, donde X representa el nivel de ejecución.

El sistema init del sistema operativo Linux adopta el nivel de ejecución. El nivel de ejecución determina que el proceso de inicio ejecuta ciertos tipos de procesos definidos en el archivo /etc/inittab o el directorio /etc/rcX.d. El sistema operativo Linux tiene 5 niveles de ejecución de arranque.

- En el nivel de ejecución 1, solo se inician los procesos básicos del sistema y un proceso de terminal de consola. Lo llamamos modo de usuario único. El modo de usuario único generalmente se usa para realizar un mantenimiento urgente del sistema de archivos cuando hay un problema con el sistema. Obviamente, en este modo, solo una persona (generalmente el administrador del sistema) puede iniciar sesión en el sistema para manipular datos.

- El nivel de ejecución de inicio estándar es 3. En este nivel de ejecución, se inician la mayoría de las aplicaciones, como los programas de soporte de red. Otro nivel de ejecución común en Linux es 5. En este nivel de ejecución, el sistema inicia el sistema gráfico de ventanas X, lo que permite a los usuarios iniciar sesión en el sistema a través de una ventana de escritorio gráfica.

Puede usar el comando ps para ver los procesos que se ejecutan actualmente en un sistema Linux.

3) Gestión de dispositivos de hardware

Otra responsabilidad del kernel es administrar los dispositivos de hardware. Cualquier dispositivo con el que un sistema Linux necesite comunicarse debe

incluir su código de controlador en el código del kernel. El código del controlador actúa como intermediario entre la aplicación y el dispositivo de hardware, lo que permite el intercambio de datos entre el kernel y el dispositivo. Hay dos métodos para insertar el código del controlador del dispositivo en el kernel de Linux:

- Código de controlador de dispositivo compilado en el kernel

- módulo de controlador de dispositivo conectable al kernel

Anteriormente, la única forma de insertar el código del controlador del dispositivo era volver a compilar el kernel. Cada vez que se agrega un nuevo dispositivo al sistema, se debe volver a compilar el código del núcleo. A medida que el kernel de Linux admite más y más dispositivos de hardware, este proceso se vuelve cada vez más ineficiente. Afortunadamente, los desarrolladores de Linux han ideado una forma mejor de insertar el código del controlador en un kernel en ejecución.

A los desarrolladores se les ocurrió el concepto de módulos del núcleo. Permite que el código del controlador se inserte en un kernel en ejecución sin volver a compilar el

kernel. Al mismo tiempo, los módulos del kernel también se pueden eliminar del kernel cuando el dispositivo ya no está en uso. Este enfoque simplifica y amplía enormemente el uso de dispositivos de hardware en Linux.

El sistema Linux trata los dispositivos de hardware como archivos especiales llamados archivos de dispositivo. Hay 3 categorías de archivos de dispositivo:

- Archivo de dispositivo de caracteres: se refiere a los dispositivos que procesan datos de un carácter a la vez, como la mayoría de los tipos de módems y

terminales. - Archivo de dispositivo de bloque: se refiere a un dispositivo que puede procesar grandes bloques de datos cada vez que procesa datos, como un disco duro.

- Archivo de dispositivo de red: se refiere al dispositivo que utiliza paquetes de datos para enviar y recibir datos, incluidas varias tarjetas de red y un dispositivo de bucle invertido especial.

4) Gestión del sistema de archivos

A diferencia de otros sistemas operativos, el kernel de Linux admite la lectura y escritura de datos del disco duro a través de diferentes tipos de sistemas de archivos. Además

de sus propios sistemas de archivos, Linux también admite

la lectura y escritura de datos de los sistemas de archivos de otros sistemas operativos (como Microsoft Windows). El kernel debe compilarse con soporte para todos los sistemas de archivos posibles. La siguiente tabla enumera los sistemas de archivos estándar que utilizan los sistemas Linux para leer y escribir datos.

Todos los discos duros a los que accede el servidor Linux deben estar formateados con uno de los tipos de sistemas de archivos enumerados en la tabla anterior.

El kernel de Linux es altamente eficiente en el uso de memoria y CPU y es muy estable a lo largo del tiempo. Pero lo más interesante de Linux es la portabilidad de este tamaño y complejidad. Linux está compilado para ejecutarse en una gran cantidad de procesadores y plataformas con diferentes restricciones y requisitos de arquitectura. Un ejemplo es que Linux puede ejecutarse en un procesador con una unidad de gestión de memoria (MMU) o en aquellos procesadores que no proporcionan una MMU. El puerto uClinux del kernel de Linux brinda soporte para no MMU.

En tercer lugar, la arquitectura general del kernel de Linux

1. Arquitectura del núcleo de Linux

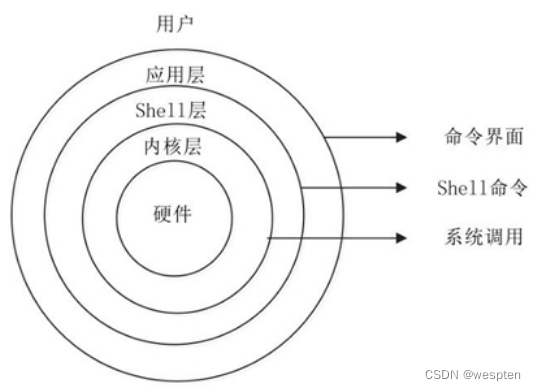

El sistema UNIX/Linux se puede resumir aproximadamente en tres niveles, la capa inferior es el kernel del sistema (Kernel); la capa intermedia es la capa Shell, es decir, la capa de interpretación de comandos; la capa superior es la capa de aplicación.

(1) capa del núcleo

La capa del núcleo es el núcleo y la base del sistema UNIX/Linux. Está conectada directamente a la plataforma de hardware, controla y administra varios recursos (recursos de hardware y recursos de software) en el sistema y organiza de manera efectiva la operación del proceso, por lo tanto ampliar las funciones del hardware.Mejorar la eficiencia de utilización de los recursos y proporcionar a los usuarios un entorno de aplicación conveniente, eficiente, seguro y confiable.

(2) Capa de concha

La capa Shell es la interfaz que interactúa directamente con el usuario. El usuario puede ingresar la línea de comando en el indicador, y el Shell lo interpreta y genera los resultados correspondientes o la información relacionada, por lo que también llamamos al Shell un intérprete de comandos, que puede completar muchas tareas de manera rápida y fácil utilizando los comandos enriquecidos proporcionados por el sistema.

(3) capa de aplicación

La capa de aplicación proporciona un entorno gráfico basado en el protocolo X Window. El Protocolo X Window define las funciones que debe tener un sistema.

El kernel de Linux es solo una parte del sistema operativo Linux. A la derecha, administra todos los dispositivos de hardware del sistema; a la derecha, proporciona interfaces para la rutina de la biblioteca (como la biblioteca C) u otras aplicaciones a través de llamadas al sistema.

1) Espacio del núcleo:

El espacio del kernel incluye llamadas al sistema, el kernel y el código relacionado con la arquitectura de la plataforma. El kernel se encuentra en un estado de sistema elevado que incluye un espacio de memoria protegido y acceso completo al hardware del dispositivo. Este estado del sistema y el espacio de la memoria se denominan colectivamente como espacio del kernel. Dentro del espacio del kernel, el acceso principal al hardware y los servicios del sistema se administran y se brindan como servicios al resto del sistema.

2) Espacio de usuario:

El espacio de usuario también contiene, la aplicación del usuario, la biblioteca C. El espacio de usuario o dominio de usuario es el código que se ejecuta fuera del entorno del kernel del sistema operativo, el espacio de usuario se define como las diversas aplicaciones, programas o bibliotecas que utiliza el sistema operativo para interactuar con el kernel.

Las aplicaciones del usuario se ejecutan en el espacio del usuario y pueden acceder a una parte de los recursos disponibles de la computadora a través de llamadas al sistema del kernel. Mediante el uso de los servicios básicos proporcionados por el núcleo, se pueden crear aplicaciones de nivel de usuario, como juegos o software de oficina.

El núcleo proporciona un conjunto de interfaces para que las aplicaciones que se ejecutan en modo de usuario interactúen con el sistema. También conocidas como llamadas al sistema, estas interfaces permiten que las aplicaciones accedan al hardware y otros recursos del núcleo. Las llamadas al sistema no solo proporcionan un nivel de hardware abstracto para las aplicaciones, sino que también garantizan la seguridad y la estabilidad del sistema.

La mayoría de las aplicaciones no usan llamadas al sistema directamente. En su lugar, se utiliza una interfaz de programación de aplicaciones (API) para la programación. Tenga en cuenta que no existe una correlación entre la API y las llamadas al sistema. Las API se proporcionan a las aplicaciones como parte de un archivo de biblioteca y, por lo general, estas API se implementan a través de una o más llamadas al sistema.

2. Arquitectura del kernel de Linux

Para administrar los diversos recursos y dispositivos anteriores, el kernel de Linux propone la siguiente arquitectura:

De acuerdo con las funciones principales del kernel, el kernel de Linux propone 5 subsistemas:

1. Programador de procesos, también conocido como gestión de procesos, programación de procesos. Responsable de administrar los recursos de la CPU para que cada proceso pueda acceder a la CPU de la manera más justa posible.

2. Administrador de memoria, gestión de memoria. Responsable de administrar los recursos de memoria para que los procesos puedan compartir de manera segura los recursos de memoria de la máquina. Además, la gestión de la memoria proporcionará un mecanismo de memoria virtual, que permite que el proceso use más memoria de la que el sistema puede usar. La memoria no utilizada se almacenará en la memoria no volátil externa a través del sistema de archivos, y cuando sea necesario utilizado, se recuperará en la memoria.

3. VFS (Sistema de archivos virtual), sistema de archivos virtual. El kernel de Linux abstrae dispositivos externos con diferentes funciones, como dispositivos de disco (discos duros, discos, NAND Flash, Nor Flash, etc.), dispositivos de entrada y salida, dispositivos de visualización, etc., en una interfaz de operación de archivo unificada (abierta, cerrar, leer, etc.) escribir, etc.) para acceder. Esta es la encarnación de "todo es un archivo" en el sistema Linux (de hecho, Linux no lo hace completamente, porque la CPU, la memoria, la red, etc. aún no son archivos. Si realmente necesita que todo sea un archivo, depende de lo que esté desarrollando Bell Labs. " Plan 9 ").

4. Red, subsistema de red. Responsable de administrar el equipo de red del sistema e implementar una variedad de estándares de red.

5. IPC (Comunicación entre procesos), comunicación entre procesos. IPC no administra ningún hardware, es el principal responsable de la comunicación entre procesos en el sistema Linux.

Programador de procesos

La programación de procesos es el subsistema más importante del kernel de Linux, que proporciona principalmente control de acceso a la CPU. Debido a que en la computadora, los recursos de la CPU son limitados y muchas aplicaciones usan los recursos de la CPU, por lo que se requiere el "subsistema de programación de procesos" para programar y administrar la CPU.

El subsistema de programación de procesos incluye 4 submódulos (ver la figura a continuación), y sus funciones son las siguientes:

- Política de programación, la estrategia para implementar la programación de procesos, que determina qué (o cuáles) procesos tendrán la CPU.

- Los programadores específicos de la arquitectura, la parte relacionada con la arquitectura, se utilizan para abstraer el control de diferentes CPU en una interfaz unificada. Estos controles se utilizan principalmente en procesos de suspensión y reanudación, que implican acceso a registros de CPU, operaciones de instrucciones de ensamblaje, etc.

- Programador independiente de la arquitectura, la parte independiente de la arquitectura. Se comunicará con el "módulo de política de programación" para decidir qué proceso ejecutar a continuación y luego reanudará el proceso especificado a través del "módulo de programadores específicos de la arquitectura".

- Interfaz de llamada del sistema, la interfaz de llamada del sistema. El subsistema de programación de procesos abre la interfaz que debe proporcionarse al espacio de usuario a través de la interfaz de llamada al sistema y, al mismo tiempo, protege los detalles que no necesitan ser afectados por el programa de espacio de usuario.

Administrador de memoria (MM)

La gestión de la memoria es también el subsistema más importante del kernel de Linux, que proporciona principalmente control de acceso a los recursos de la memoria. El sistema Linux establecerá una relación de mapeo entre la memoria física del hardware y la memoria utilizada por el proceso (llamada memoria virtual), este mapeo es en unidades de procesos, por lo que diferentes procesos pueden usar la misma memoria virtual, y estos mismos La memoria virtual se puede mapear a diferentes memorias físicas.

El subsistema de gestión de memoria incluye 3 submódulos (ver la figura a continuación), y sus funciones son las siguientes:

- Administradores específicos de arquitectura, partes relacionadas con la arquitectura. Proporciona una interfaz virtual para acceder a la memoria del hardware.

- Architecture Independent Manager, la parte independiente de la arquitectura. Proporciona todos los mecanismos de administración de memoria, incluidos: asignación de memoria basada en procesos, intercambio de memoria virtual.

- Interfaz de llamada del sistema, la interfaz de llamada del sistema. A través de esta interfaz, las funciones como la asignación de memoria, la liberación y el mapa de archivos se proporcionan a los programas y aplicaciones del espacio del usuario.

Sistema de archivos virtual (VFS)

Un sistema de archivos en el sentido tradicional es un método para almacenar y organizar datos informáticos. Abstrae bloques de datos fríos en discos de computadora, discos duros y otros dispositivos de una manera fácil de entender y humana (estructura de archivos y directorios), lo que facilita su búsqueda y acceso. Por lo tanto, la esencia del sistema de archivos es "el método de almacenamiento y organización de datos", y la manifestación del sistema de archivos es "leer datos de un determinado dispositivo y escribir datos en un determinado dispositivo".

A medida que avanza la tecnología informática, también lo hacen los métodos de almacenamiento y organización de datos, lo que da como resultado varios tipos de sistemas de archivos, como FAT, FAT32, NTFS, EXT2, EXT3 y más. Para que sea compatible, el sistema operativo o kernel debe admitir múltiples tipos de sistemas de archivos en la misma forma, lo que amplía el concepto de sistema de archivos virtual (VFS). La función de VFS es administrar varios sistemas de archivos, proteger sus diferencias y proporcionar a los programas de usuario una interfaz para acceder a los archivos de manera unificada.

Podemos leer o escribir datos de discos, discos duros, NAND Flash y otros dispositivos, por lo que los sistemas de archivos originales se crearon en estos dispositivos. Este concepto también se puede extender a otros dispositivos de hardware, como la memoria, la pantalla (LCD), el teclado, el puerto serie, etc. Nuestro control de acceso a dispositivos de hardware también se puede resumir como lectura o escritura de datos, por lo que se puede acceder a ellos con una interfaz de operación de archivos unificada. El kernel de Linux hace exactamente eso, abstrayendo los sistemas de archivos de los dispositivos, los sistemas de archivos en memoria y más, además de los sistemas de archivos de disco tradicionales. Estas lógicas son implementadas por el subsistema VFS.

El subsistema VFS incluye 6 submódulos (ver la figura a continuación), y sus funciones son las siguientes:

- Los controladores de dispositivos, los controladores de dispositivos, se utilizan para controlar todos los dispositivos y controladores externos. Dado que hay una gran cantidad de dispositivos de hardware (especialmente productos integrados) que no son compatibles entre sí, también hay muchos controladores de dispositivos. Por lo tanto, casi la mitad de los códigos fuente en el kernel de Linux son controladores de dispositivos, y la mayoría de los ingenieros de nivel inferior de Linux (especialmente empresas nacionales) escriben o mantienen controladores de dispositivos y no tienen tiempo para estimar otro contenido (son precisamente los esencia del kernel de Linux). donde).

- Interfaz independiente del dispositivo, este módulo define una forma unificada de describir los dispositivos de hardware (modelo de dispositivo unificado), todos los controladores de dispositivos cumplen con esta definición, lo que puede reducir la dificultad del desarrollo. Al mismo tiempo, la interfaz se puede proporcionar hacia arriba con una situación consistente.

- Sistemas lógicos, cada sistema de archivos corresponde a un Sistema lógico (sistema de archivos lógicos), que implementa una lógica de sistema de archivos específica.

- Interfaz independiente del sistema, este módulo es responsable de representar los dispositivos de hardware y los sistemas de archivos lógicos con una interfaz unificada (dispositivo rápido y dispositivo de caracteres), de modo que el software de la capa superior ya no se preocupe por la forma específica del hardware.

- System Call Interface, la interfaz de llamada del sistema, proporciona al usuario una interfaz unificada para acceder al sistema de archivos y dispositivos de hardware.

Subsistema de red (red)

El subsistema de red en el kernel de Linux es principalmente responsable de administrar varios dispositivos de red, implementar varias pilas de protocolos de red y, finalmente, realizar la función de conectar otros sistemas a través de la red. En el kernel de Linux, el subsistema de red es casi autónomo, incluye 5 submódulos (consulte la figura a continuación) y sus funciones son las siguientes:

- Los controladores de dispositivos de red, los controladores de dispositivos de red, son los mismos que los controladores de dispositivos en el subsistema VFS.

- Interfaz independiente del dispositivo, que es la misma que en el subsistema VFS.

- Protocolos de red, que implementa varios protocolos de transmisión de red, como IP, TCP, UDP, etc.

- Interfaz independiente del protocolo, protege diferentes dispositivos de hardware y protocolos de red, y proporciona interfaces (sockets) en el mismo formato.

- La interfaz de llamada del sistema, la interfaz de llamada del sistema, proporciona espacio de usuario con una interfaz unificada para acceder a dispositivos de red.

subsistema IPC, consulte:

3. Estructura de directorios del código fuente del kernel de Linux

El código fuente del kernel de Linux consta de tres partes principales:

1. Código del núcleo del kernel, incluidos varios subsistemas y submódulos, y otros subsistemas de soporte, como administración de energía, inicialización de Linux, etc.

2. Otros códigos no centrales, como archivos de biblioteca (porque el kernel de Linux es un kernel autónomo, es decir, el kernel no depende de ningún otro software y puede compilarse por sí mismo), colecciones de firmware, KVM (virtual tecnología de máquinas), etc.

3. Scripts de compilación, archivos de configuración, documentos de ayuda, instrucciones de derechos de autor y otros archivos auxiliares

El siguiente directorio del kernel usa el kernel linux-3.14 como explicación:

1. documentación:

Proporcionar asistencia con la documentación. Para obtener información explicativa sobre el núcleo, habrá un manual de ayuda en este directorio.

比如linux-3.14-fs4412/Documentation/devicetree/bindings/interrupt-controller/interrupts.txt

Este archivo explica la descripción detallada de la celda del dispositivo interrumpe la propiedad del nodo del número de dispositivo.

Solo según el nombre de la carpeta, podemos encontrar la documentación que necesitamos.

arco es una abreviatura de arquitectura. Todo el código relacionado con la arquitectura está en este directorio comenzando con

directorios include/asm-*/. Cada arquitectura compatible con Linux tiene un directorio correspondiente en el directorio arch, y más

Los pasos se descomponen en subdirectorios como boot, mm, kernel, etc.:

|--arm brazo y subdirectorios para arquitecturas compatibles

|--boot Bootloader e implementación del administrador de memoria utilizado para iniciar el kernel en esta plataforma de hardware.

|--descompresión del núcleo comprimido

|--programa de herramientas para generar una imagen del núcleo comprimida

| --kernel: contiene implementaciones que admiten características específicas de la arquitectura, como el manejo de semáforos y SMP.

| --lib: contiene implementaciones específicas de la arquitectura de funciones comunes como strlen y memcpy.

| --mm: contiene la implementación del administrador de memoria específico de la arquitectura.

Además de estos tres subdirectorios, la mayoría de las arquitecturas también tienen un subdirectorio de arranque, si es necesario, que contiene la implementación del administrador de memoria utilizado para iniciar el kernel en tales plataformas de hardware.

Código de controlador, un controlador es una pieza de software que controla el hardware. Este directorio es el directorio más grande del kernel, y aquí se pueden encontrar controladores para tarjetas gráficas, tarjetas de red, adaptadores SCSI, buses PCI, buses USB y cualquier otro periférico o bus compatible con Linux.

El código para el sistema de archivos virtual (VFS) y el código para cada uno de los diferentes sistemas de archivos se encuentran en este directorio. Todos los sistemas de archivos compatibles con Linux tienen un subdirectorio correspondiente en el directorio fs. Por ejemplo, el sistema de archivos ext2 corresponde al directorio fs/ext2.

Un sistema de archivos es el medio entre el dispositivo de almacenamiento y los procesos que necesitan acceder al dispositivo de almacenamiento. Los dispositivos de almacenamiento pueden ser localmente accesibles físicamente, como discos duros o unidades de CD-ROM, que utilizan los sistemas de archivos del sistema ext2/ext3 e isofs, respectivamente.

También hay algunos sistemas de archivos virtuales (procs), que son un sistema de archivos estándar presente. Sin embargo, los archivos que contiene solo existen en la memoria y no ocupan espacio en el disco.

Este directorio contiene la mayoría de los archivos de encabezado del núcleo y está agrupado en los siguientes subdirectorios. Para modificar la arquitectura del procesador, simplemente edite el archivo MAKE del kernel y vuelva a ejecutar el programa de configuración del kernel de Linux.

| include/asm-*/ Cada subdirectorio correspondiente a un arco, como include/asm-alpha,

Incluir/asm-brazo, etc. Los archivos en cada subdirectorio definen las funciones de preprocesamiento y en línea necesarias para admitir una arquitectura determinada, la mayoría de las cuales son implementaciones de lenguaje ensamblador completas o parciales.

| include/linux Los archivos de encabezado independientes de la plataforma están todos en este directorio, generalmente está vinculado al directorio

/usr/include/linux (o todos los archivos que contiene se copiarán endirectorio /usrinclude/linux)

Código de inicialización del núcleo. Incluye main.c, código para crear espacio de usuario temprano y otro código de inicialización.

IPC (Comunicación entre Procesos). Contiene memoria compartida, semáforos y otras formas de código IPC.

La parte central del kernel, incluida la programación del proceso (sched.c), así como la creación y cancelación del proceso (fork.c y exit.c), y otra parte del código central relacionado con la plataforma. están en el directorio arch/*/kernel.

Este directorio contiene parte del código de gestión de memoria que es independiente de la arquitectura. El código de gestión de memoria dependiente de la arquitectura se encuentra en arch/*/mm.

El código de red central implementa varios protocolos de red comunes, como TCP/IP, IPX, etc.

Este directorio contiene el código de la biblioteca central. Implementa un subconjunto genérico de la biblioteca C estándar, que incluye funciones para la manipulación de cadenas y memoria (strlen, mmcpy, etc.) y funciones relacionadas con las series sprintf y atoi. A diferencia del código bajo arch/lib, el código de la biblioteca aquí está escrito en C y se puede usar directamente en la nueva versión portada del kernel. El código de la biblioteca relacionado con la arquitectura del procesador se coloca en arch/mm.

Los controladores de dispositivos de bloque incluyen controladores IDE (en ide.c). Un dispositivo de bloque es un dispositivo que recibe y envía datos en bloques. El código de la capa de bloque inicial se encuentra en parte en el directorio de controladores y en parte en el directorio fs. Desde la versión 2.6.15, el código central de la capa de bloques se ha extraído y colocado en el directorio de bloques de nivel superior. Si desea buscar el proceso de inicialización de estos dispositivos que pueden contener sistemas de archivos, debe ser device_setup() en drivers/block/genhd.c. Al instalar un sistema de archivos nfs, no solo se debe inicializar el disco duro sino también la red. Los dispositivos de bloque incluyen dispositivos IDE y SCSI.

Fireware contiene un código que permite a las computadoras leer y comprender las señales enviadas desde los dispositivos. Por ejemplo, una cámara administra su propio hardware, pero la computadora debe comprender las señales que la cámara envía a la computadora. Los sistemas Linux utilizan el firmware vicam para comprender la comunicación de la cámara. De lo contrario, sin el firmware, el sistema Linux no sabría qué hacer con la información de la cámara. Además, el firmware también ayuda a enviar mensajes desde el sistema Linux al dispositivo. De esta forma, el sistema Linux puede decirle a la cámara que se reajuste o apague la cámara.

Implemente cpio, etc. para empaque y compresión. El código de esta carpeta crea estos archivos después de compilar el kernel.

Este directorio contiene código para diferentes modelos de seguridad de Linux. Es importante mantener su computadora a salvo de virus y piratas informáticos. De lo contrario, el sistema Linux puede resultar dañado.

La API de cifrado utilizada por el propio núcleo implementa algoritmos de cifrado y hash de uso común, así como algunos algoritmos de comprobación de compresión y CRC. Ejemplo: "sha1_generic.c" Este archivo contiene el código para el algoritmo de cifrado SHA1.

No hay código del núcleo en este directorio, solo los archivos de secuencias de comandos utilizados para configurar el núcleo. Al ejecutar comandos como make menuconfig o make xconfig para configurar el kernel, el usuario interactúa con los scripts ubicados en este directorio.

Controlador de la tarjeta de sonido y otro código fuente relacionado con el sonido.

Algunos ejemplos de programación del núcleo

Esta carpeta contiene código de virtualización, que permite a los usuarios ejecutar varios sistemas operativos a la vez. Con la virtualización, el sistema operativo invitado se ejecuta como cualquier otra aplicación que se ejecute en el host de Linux.

Esta carpeta contiene herramientas para interactuar con el kernel.

COPIA: Información de licencia y autorización. El kernel de Linux tiene la licencia GPLv2. Esta licencia otorga a cualquier persona el derecho de usar, modificar, distribuir y compartir el código fuente y compilado de forma gratuita. Sin embargo, nadie puede vender el código fuente.

CRÉDITOS: lista de colaboradores

Kbuild: este es un script que establece algunas configuraciones del kernel. Por ejemplo, este script establece una variable ARCH, que es el tipo de procesador que el desarrollador desea generar para que el kernel lo admita.

Kconfig: los desarrolladores utilizarán este script al configurar el kernel

MANTENEDORES: esta es una lista de los mantenedores actuales, sus direcciones de correo electrónico, páginas de inicio y partes o archivos específicos del kernel que son responsables de desarrollar y mantener. Esto es útil cuando un desarrollador encuentra un problema en el kernel y quiere poder informarlo a un mantenedor que pueda solucionarlo.

Makefile: este script es el archivo principal para compilar el kernel. Este archivo pasa los parámetros y archivos de compilación y la información necesaria requerida para la compilación al compilador.

LÉAME: este documento proporciona información para los desarrolladores que desean saber cómo compilar el kernel.

REPORTE DE ERRORES: Este documento proporciona información sobre cómo reportar errores.

El código del núcleo es un archivo con la extensión ".c" o ".h". La extensión ".c" indica que el núcleo está escrito en C, uno de los muchos lenguajes de programación, y los archivos "h" son archivos de encabezado, y también están escritos en C. Los archivos de encabezado contienen una gran cantidad de código que los archivos ".c" deben usar porque pueden importar el código existente en lugar de reescribirlo, lo que ahorra tiempo a los programadores. De lo contrario, existirá un conjunto de código que realiza la misma acción en muchos o en todos los archivos "c". Esto también consume y desperdicia espacio en el disco duro. (Anotación: los archivos de encabezado no solo pueden guardar la codificación repetida, sino que también la reutilización del código reducirá la posibilidad de errores de código)

Resumen de la arquitectura general del kernel de Linux:

Arquitectura del núcleo de Linux:

(1) interfaz de llamada del sistema

La capa SCI proporciona algunos mecanismos para realizar llamadas de función desde el espacio del usuario al kernel. Como se mencionó anteriormente, esta interfaz depende de la arquitectura, incluso dentro de la misma familia de procesadores. SCI es en realidad un servicio de multiplexación y demultiplexación de llamadas de función muy útil. Puede encontrar la implementación de SCI en ./linux/kernel y las partes dependientes de la arquitectura en ./linux/arch.

(2) Gestión de procesos

El enfoque de la gestión de procesos es la ejecución del proceso. En el núcleo, estos procesos se denominan subprocesos y representan una virtualización de procesador separada (código de subproceso, datos, pila y registros de CPU). En el espacio del usuario, el término proceso se usa a menudo, pero la implementación de Linux no distingue entre los dos conceptos (proceso e hilo). El núcleo proporciona una interfaz de programación de aplicaciones (API) a través de SCI para crear un nuevo proceso (fork, exec o funciones de interfaz de sistema operativo portátil [POSIX]), detener procesos (matar, salir) y comunicarse y sincronizarse entre ellos (señalar o mecanismo POSIX).

La gestión de procesos también incluye hacer frente a la necesidad de compartir la CPU entre los procesos activos. El kernel implementa un nuevo tipo de algoritmo de programación que opera en tiempo constante, independientemente de cuántos subprocesos compitan por la CPU. Este algoritmo se denomina programador O(1), y el nombre implica que se necesita la misma cantidad de tiempo para programar varios subprocesos que para programar un subproceso. El programador O(1) también puede soportar múltiples procesadores (llamado multiprocesamiento simétrico o SMP). Puede encontrar el código fuente para la gestión de procesos en ./linux/kernel y la fuente dependiente de la arquitectura en ./linux/arch.

(3) Gestión de la memoria

Otro recurso importante administrado por el núcleo es la memoria. Para mayor eficiencia, si la memoria virtual es administrada por hardware, la memoria se administra en las llamadas páginas de memoria (4 KB para la mayoría de las arquitecturas). Linux incluye formas de administrar la memoria disponible, así como los mecanismos de hardware utilizados para el mapeo físico y virtual. Pero la administración de memoria puede administrar más de 4 KB de búfer. Linux proporciona abstracciones para búferes de 4 KB, como el asignador de bloques. Este modo de administración de memoria utiliza un búfer de 4 KB como base, luego asigna estructuras a partir de él y realiza un seguimiento del uso de la página de memoria, como qué páginas de memoria están llenas, cuáles no están completamente utilizadas y cuáles están vacías. Esto permite que el modo ajuste dinámicamente el uso de la memoria según las necesidades del sistema. Con el fin de permitir que varios usuarios utilicen la memoria, a veces se agota la memoria disponible. Por este motivo, las páginas se pueden sacar de la memoria y colocar en el disco. Este proceso se denomina intercambio porque las páginas se intercambian de la memoria al disco. El código fuente para la gestión de la memoria se puede encontrar en ./linux/mm.

(4) Sistema de archivos virtuales

El sistema de archivos virtual (VFS) es un aspecto muy útil del kernel de Linux porque proporciona una abstracción de interfaz común para el sistema de archivos. VFS proporciona una capa de intercambio entre SCI y los sistemas de archivos compatibles con el kernel.

Jerarquía del sistema de archivos:

Además de VFS, hay una abstracción API genérica para funciones como abrir, cerrar, leer y escribir. Debajo del VFS se encuentra la abstracción del sistema de archivos, que define cómo se implementan las funciones de nivel superior. Son complementos para un sistema de archivos determinado (más de 50). El código fuente del sistema de archivos se puede encontrar en ./linux/fs. Debajo de la capa del sistema de archivos se encuentra la memoria caché del búfer, que proporciona un conjunto general de funciones para la capa del sistema de archivos (independiente del sistema de archivos específico). Esta capa de almacenamiento en caché optimiza el acceso a los dispositivos físicos al retener los datos durante un período de tiempo (o al leerlos por adelantado para que estén disponibles cuando se necesiten). Debajo de la memoria caché del búfer se encuentra el controlador del dispositivo, que implementa una interfaz para un dispositivo físico específico.

(5) Pila de red

La pila de red está diseñada para seguir una arquitectura en capas que imita el propio protocolo. Recuerde que el Protocolo de Internet (IP) es el protocolo de capa de red central subyacente al protocolo de transporte (a menudo llamado Protocolo de control de transmisión o TCP). Por encima de TCP está la capa de socket, que se llama a través de SCI. La capa de socket es la API estándar del subsistema de red, que proporciona una interfaz de usuario para varios protocolos de red. Desde el acceso de marco sin formato a las unidades de datos de protocolo IP (PDU) a TCP y el protocolo de datagramas de usuario (UDP), la capa de socket proporciona una forma estandarizada de administrar conexiones y mover datos entre puntos finales. El código fuente de la red en el núcleo se puede encontrar en ./linux/net.

(6) controlador de dispositivo

Gran parte del código del kernel de Linux se encuentra en los controladores de dispositivos, que pueden ejecutar dispositivos de hardware específicos. El árbol de fuentes de Linux proporciona un subdirectorio de controladores, que se divide en varios dispositivos compatibles, como Bluetooth, I2C, serie, etc. El código de los controladores de dispositivos se puede encontrar en ./linux/drivers.

(7) Código dependiente de la arquitectura

Aunque Linux es en gran medida independiente de la arquitectura en la que se ejecuta, algunos elementos deben tenerse en cuenta en la arquitectura para funcionar correctamente y lograr una mayor eficiencia. El subdirectorio ./linux/arch define la parte del código fuente del kernel que depende de la arquitectura y contiene varios subdirectorios específicos de la arquitectura (que juntos forman el BSP). Para un sistema de escritorio típico, se usa el directorio x86. Cada subdirectorio de arquitectura contiene muchos otros subdirectorios, cada uno de los cuales se centra en un aspecto específico del kernel, como el arranque, el kernel, la gestión de la memoria, etc. Estos códigos dependientes de la arquitectura se pueden encontrar en ./linux/arch.

Si la portabilidad y la eficiencia del kernel de Linux no fueran lo suficientemente buenas, Linux también proporciona algunas otras funciones que no encajan en las categorías anteriores. Como sistema operativo de producción y software de código abierto, Linux es una buena plataforma para probar nuevos protocolos y sus mejoras. Linux admite una serie de protocolos de red, incluido el típico TCP/IP y extensiones para redes de alta velocidad (más de 1 Gigabit Ethernet [GbE] y 10 GbE). Linux también puede admitir protocolos como el Protocolo de transmisión de control de flujo (SCTP), que proporciona muchas funciones más avanzadas que TCP (el sucesor del protocolo de la capa de transporte).

Linux también es un kernel dinámico que admite la adición o eliminación dinámica de componentes de software. Conocidos como módulos del kernel cargables dinámicamente, el usuario puede insertarlos en el momento del arranque según sea necesario (actualmente, el dispositivo en particular requiere este módulo) o en cualquier momento.

Una de las últimas mejoras de Linux es un sistema operativo (llamado hipervisor) que se puede utilizar como sistema operativo para otros sistemas operativos. Más recientemente, ha habido modificaciones en el kernel llamadas Máquinas virtuales basadas en kernel (KVM). Esta modificación habilita una nueva interfaz para el espacio de usuario que permite que otros sistemas operativos se ejecuten sobre el kernel habilitado para KVM. Además de ejecutar otras instancias de Linux, Microsoft Windows también se puede virtualizar. La única limitación es que el procesador subyacente debe admitir las nuevas instrucciones de virtualización.

En cuarto lugar, el diseño de la arquitectura general del núcleo

1. Mecanismo del núcleo

Cada función se convierte en diferentes subsistemas del kernel.Si los subsistemas quieren comunicarse, se debe diseñar un mecanismo que permita que los subsistemas se comuniquen entre sí de una manera segura, confiable y eficiente.

Linux ha absorbido la experiencia de diseño de microkernel en el desarrollo paso a paso.Aunque es un kernel único, tiene las características de microkernel.

Linux utiliza un diseño de kernel modular para tener ambas características de microkernel, pero dicho diseño modular no es un subsistema como un microkernel, sino un kernel compuesto por módulos funcionales centrales y periféricos. Todos los subsistemas del micronúcleo se ejecutan de forma independiente y pueden funcionar sin depender de otras partes. Los módulos de Linux deben depender del núcleo, pero pueden cargarse cuando están en uso y descargarse dinámicamente cuando no están en uso. El módulo en Linux se representa externamente como un archivo de biblioteca del tipo programa, pero el archivo de biblioteca del programa es .so, y el módulo del núcleo es .ko (objeto del núcleo), que es llamado por el núcleo.

Suponiendo que si el kernel proporciona el controlador, imagine compilar un kernel e instalarlo en el host, en caso de que luego se descubra que no puede controlar el nuevo dispositivo de hardware que agregamos más tarde. Dado que todo tipo de hardware está controlado por el kernel, y el kernel no proporciona este programa, es muy problemático para los usuarios y fabricantes recompilar el kernel.

El diseño modular puede evitar esta situación.Cada fabricante desarrolla su propio controlador de forma modular, y solo necesita desarrollar su propio programa de controlador para un dispositivo específico.

Una de las cosas que han hecho los desarrolladores del kernel de Linux es hacer que los módulos del kernel se puedan cargar y descargar durante el tiempo de ejecución, lo que significa que puede agregar o eliminar dinámicamente características del kernel. Esto no solo puede agregar capacidades de hardware al kernel, sino que también puede incluir módulos para ejecutar procesos de servidor, como virtualización de bajo nivel, pero también puede reemplazar todo el kernel sin necesidad de reiniciar la computadora en algunos casos.

Podemos compilar estos módulos cuando sea necesario. Cuando no se necesita una función, se puede desmontar por sí misma sin afectar el funcionamiento del núcleo. Imagínese si pudiera actualizar a un paquete de servicio de Windows sin reiniciar, ese es uno de los beneficios y ventajas de la modularidad.

1) mecanismo de trabajo de la CPU

Modo de trabajo de la CPU

Las CPU modernas generalmente implementan diferentes modos de trabajo. Tome ARM como ejemplo: ARM implementa 7 modos de trabajo. En diferentes modos, las instrucciones que la CPU puede ejecutar o los registros a los que se puede acceder son diferentes:

(1) Modo de usuario usr

(2) Sistema de modo de sistema

(3) Modo de gestión svc

(4) fiq de interrupción rápida

(5) Interrupción externa irq

(6) Terminación de acceso a datos aprox.

(7) Excepción de instrucción indefinida

Tome (2) X86 como ejemplo: X86 implementa 4 niveles diferentes de permisos, Ring0—Ring3; Ring0 puede ejecutar instrucciones privilegiadas y acceder a dispositivos IO; Ring3 tiene muchas restricciones

Por lo tanto, desde la perspectiva de la CPU, para proteger la seguridad del kernel, Linux divide el sistema en espacio de usuario y espacio de kernel.

El espacio de usuario y el espacio del kernel son dos estados diferentes de ejecución del programa. Podemos completar la transferencia del espacio del usuario al espacio del kernel a través de "llamadas al sistema" e "interrupciones de hardware".

Las aplicaciones se ejecutan en el kernel, es solo el caso lógico. Sin embargo, en realidad funciona directamente en el hardware. Todos los datos de la aplicación están en la memoria y el procesamiento de datos es todo CPU, pero no se pueden usar a voluntad y deben ser administrados por el kernel.

Pero solo hay una CPU. Cuando el programa de aplicación está funcionando, el kernel se suspende y el programa de aplicación también está en el espacio de memoria. Una vez que el programa de aplicación quiere acceder a otros recursos de hardware, es decir, cuando quiere ejecutar I /O instrucciones, no se puede ejecutar. Debido a que el programa de aplicación no puede ver el hardware, el programa de aplicación es un programa basado en llamadas al sistema. Cuando el programa de aplicación necesita acceder a recursos de hardware, inicia una solicitud de privilegio a la CPU. Una vez que la CPU recibe la solicitud de privilegio, la CPU despierta el kernel y ejecuta la operación en el kernel.Una pieza de código (no un programa completo del kernel), luego devuelve el resultado a la aplicación, luego el código del kernel sale y el programa del kernel se suspende.

Durante este tiempo, la CPU cambia del modo usuario al modo kernel, que parece ser un modo privilegiado.

Todas las aplicaciones se ejecutan directamente en el hardware, y el kernel solo las administra y monitorea cuando es necesario, por lo que el kernel también es un monitor, un programa de monitoreo y un programa de monitoreo de recursos y procesos.

El kernel no tiene productividad, y la productividad la genera una aplicación llamada, por lo que deberíamos intentar que el sistema se ejecute en modo aplicación, así que cuanto menos tiempo ocupe el kernel, mejor. El núcleo ocupa principalmente tiempo en funciones relacionadas, como el cambio de procesos y el procesamiento de interrupciones. El propósito del cambio de modo es completar la producción, pero el cambio de procesos y la producción no tienen ningún significado. El procesamiento de interrupciones puede considerarse relacionado con la producción en sí, porque la aplicación necesita ejecutar I/O.

El propósito principal del kernel es completar la administración del hardware, y existe la idea en Linux de que cada proceso se deriva de su proceso principal y fork() del proceso principal, luego, quién bifurcará() y administrará estos procesos, por lo que Con el gran programa de ama de llaves init, gestiona todos los procesos en el espacio de usuario como un todo.

El kernel no realizará la administración del espacio de usuario, por lo que después de iniciar el kernel, primero debemos iniciar init si queremos iniciar el espacio de usuario, por lo que el número PID de init siempre es 1. Init también se deriva de su proceso principal fork(), que es un mecanismo en el espacio del kernel para guiar específicamente los procesos del espacio del usuario. init es una aplicación, en /sbin/init, un archivo ejecutable.

tiempo de CPU

Debido a que cada proceso en la memoria monopoliza directamente la CPU, el kernel virtualiza la CPU y se la proporciona al proceso. La CPU se virtualiza a nivel de kernel. Al dividir la CPU en segmentos de tiempo, se completa con el paso del tiempo. En Al asignar la potencia informática entre los procesos, la CPU proporciona su potencia informática en términos de tiempo.

Cuanto mayor sea el poder de cómputo que se puede proporcionar por unidad de tiempo, más rápida debe ser la velocidad, de lo contrario, el tiempo solo se puede extender. Es por eso que necesitamos una CPU más rápida para ahorrar tiempo.

Características computacionales de la CPU

La E/S es el dispositivo más lento. Nuestra CPU pasa mucho tiempo esperando que se complete la E/S. Para evitar esperas inactivas y sin sentido, cuando necesitemos esperar, deje que la CPU ejecute otros procesos o subprocesos.

Deberíamos exprimir al máximo la potencia de cálculo de la CPU, porque la potencia de cálculo de la CPU oscila con el oscilador de la frecuencia del reloj a lo largo del tiempo, y funciona tanto si la usas como si no.

Si deja la CPU inactiva, aún consume energía y, con el tiempo, la potencia informática se pierde, por lo que puede hacer que la CPU funcione al 80-90% de su utilización, lo que significa que su capacidad de producción está en pleno juego. La CPU no está mal, no hay desgaste, es un equipo eléctrico, excepto que la potencia es grande, el calor es grande y la disipación de calor es suficiente.Para el equipo eléctrico, se dañará si no es usó.

9 Mecanismos de Sincronización en el Kernel de Linux

Linux a menudo usa una tabla hash para implementar un caché (Cache), que es información a la que se debe acceder rápidamente.

Después de que el sistema operativo introduce el concepto de proceso, después de que el proceso se convierte en la entidad de programación, el sistema tiene la capacidad de ejecutar múltiples procesos al mismo tiempo, pero también conduce a la competencia de recursos y al intercambio entre los diversos procesos del sistema.

Además, debido a la introducción de interrupciones, mecanismos de excepción y preferencia del estado del núcleo, estas rutas de ejecución del núcleo (procesos) se ejecutan de manera intercalada. Para las rutas del núcleo ejecutadas por estas rutas intercaladas, si no se toman las medidas de sincronización necesarias, se accederá a algunas estructuras de datos clave y se modificarán intercaladas, lo que dará como resultado estados inconsistentes de estas estructuras de datos, lo que a su vez provocará fallas en el sistema. Por lo tanto, para asegurar el funcionamiento eficiente, estable y ordenado del sistema, Linux debe adoptar un mecanismo de sincronización.

En el sistema Linux, llamamos sección crítica al segmento de código que accede a los recursos compartidos. Lo que hace que varios procesos accedan al mismo recurso compartido se denomina fuente concurrente.

Las principales fuentes de concurrencia bajo sistemas Linux son:

Procesamiento de interrupciones: por ejemplo, cuando un proceso se interrumpe mientras se accede a un recurso crítico y luego ingresa al controlador de interrupciones, si está en el controlador de interrupciones, también se accede al recurso crítico. Aunque no es estrictamente concurrencia, también provocará una condición de carrera para el recurso.

Prioridad del estado del kernel: por ejemplo, cuando un proceso accede a un recurso crítico, se produce una prioridad del estado del kernel y luego ingresa a un proceso de alta prioridad.Si el proceso también accede al mismo recurso crítico, causará un conflicto de proceso a proceso. concurrencia

Simultaneidad de múltiples procesadores: existe una estricta concurrencia entre procesos en un sistema multiprocesador.Cada procesador puede programar y ejecutar un proceso de forma independiente, y varios procesos se ejecutan al mismo tiempo.

Como se mencionó anteriormente, se puede ver que el propósito de usar el mecanismo de sincronización es evitar que múltiples procesos accedan simultáneamente al mismo recurso crítico.

9 mecanismos de sincronización:

1) Por variable de CPU

El formulario principal es una matriz de estructuras de datos, un elemento de la matriz para cada CPU del sistema.

Caso de uso: los datos deben ser lógicamente independientes

Pautas de uso: se debe acceder a las variables por CPU con la preferencia deshabilitada en la ruta de control del kernel.

2) Operaciones atómicas

Principio: Se realiza mediante las instrucciones ensambladoras que son atómicas para "leer-modificar-escribir" en instrucciones en lenguaje ensamblador.

3) Barreras de la memoria

Justificación: utilice una primitiva de barrera de memoria para asegurarse de que una operación que precede a la primitiva se haya completado antes de que comience la operación que sigue a la primitiva.

4) bloqueo de giro

Se utiliza principalmente en entornos multiprocesador.

Justificación: si una ruta de control del kernel descubre que el spinlock solicitado ya está "bloqueado" por una ruta de control del kernel que se ejecuta en otra CPU, ejecuta una instrucción de bucle repetidamente hasta que se libera el bloqueo.

Descripción: Los spinlocks se usan generalmente para proteger secciones críticas que el kernel no puede adelantar.

En un solo procesador, los spinlocks solo deshabilitan o habilitan la prioridad del kernel.

5) Bloqueo de secuencia

Un bloqueo secuencial es muy similar a un bloqueo giratorio, excepto que el escritor en un bloqueo secuencial tiene una prioridad más alta que el lector, lo que significa que el escritor puede continuar ejecutándose incluso cuando el lector está leyendo.

6)UCR

Se utiliza principalmente para proteger las estructuras de datos que leen varias CPU.

Múltiples lectores y escritores pueden ejecutarse al mismo tiempo, y RCU no tiene bloqueos.

Restricciones de uso:

1) RCU solo protege las estructuras de datos que se asignan y referencian dinámicamente mediante punteros

2) En una sección crítica protegida por RCU, ninguna ruta de control del kernel puede dormir.

principio:

Cuando el escritor quiere actualizar los datos, hace una copia de toda la estructura de datos haciendo referencia al puntero y luego hace modificaciones a esta copia. Después de la modificación, el escritor cambia el puntero a la estructura de datos original para que apunte a la copia modificada (la modificación del puntero es atómica).

7) Semáforo:

Principio: cuando la ruta de control del kernel intenta adquirir el recurso ocupado protegido por el semáforo del kernel, el proceso correspondiente se suspende; solo cuando se libera el recurso, el proceso vuelve a ser ejecutable.

Restricciones de uso: solo las funciones que pueden dormir pueden adquirir semáforos del núcleo;

Ni los manejadores de interrupciones ni las funciones diferibles pueden usar semáforos del núcleo.

8) Inhabilitación de interrupción local

Principio: la prohibición de interrupción local puede garantizar que, incluso si el dispositivo de hardware genera una señal IRQ, la ruta de control del kernel continuará ejecutándose, de modo que la estructura de datos a la que accede la rutina de procesamiento de interrupción esté protegida.

Desventaja: deshabilitar las interrupciones locales no limita el acceso simultáneo a las estructuras de datos compartidas por parte de los controladores de interrupciones que se ejecutan en otra CPU.

Por lo tanto, en un entorno multiprocesador, la desactivación de interrupciones locales debe usarse junto con spinlocks.

9) Prohibición de interrupción suave local

Método 1:

Dado que softirq comienza a ejecutarse al final del controlador de interrupciones de hardware, la forma más fácil es deshabilitar las interrupciones en esa CPU.

Debido a que no se activa ninguna rutina de manejo de interrupciones, softirq no tiene posibilidad de ejecutarse.

Método 2:

Softirq se puede activar o desactivar en la CPU local manipulando el contador softirq almacenado en el campo preempt_count del descriptor thread_info actual. Porque el kernel a veces solo necesita deshabilitar softirq sin deshabilitar las interrupciones.

2) mecanismo de memoria

El mecanismo de memoria de Linux incluye espacio de direcciones, memoria física, asignación de memoria, mecanismo de paginación y mecanismo de conmutación.

espacio de dirección

Una de las ventajas de la memoria virtual es que cada proceso piensa que tiene todo el espacio de direcciones que necesita. El tamaño de la memoria virtual puede ser muchas veces el tamaño de la memoria física del sistema. Cada proceso del sistema tiene su propio espacio de direcciones virtuales, que es completamente independiente entre sí. Un proceso que ejecuta una aplicación no afectará a otros procesos, y las aplicaciones también están protegidas entre sí. El sistema operativo asigna el espacio de direcciones virtuales a la memoria física. Desde el punto de vista de la aplicación, este espacio de direcciones es un espacio de direcciones lineal y plano; sin embargo, el kernel maneja el espacio de direcciones virtuales del usuario de manera muy diferente.

El espacio de direcciones lineal se divide en dos partes: el espacio de direcciones del usuario y el espacio de direcciones del kernel. El espacio de direcciones del usuario no cambia cada vez que ocurre un cambio de contexto, mientras que el espacio de direcciones del kernel siempre permanece igual. La cantidad de espacio asignado para el espacio del usuario y el espacio del kernel depende principalmente de si el sistema tiene una arquitectura de 32 bits o de 64 bits. Por ejemplo, x86 es una arquitectura de 32 bits que admite solo 4 GB de espacio de direcciones, de los cuales 3 GB están reservados para el espacio de usuario y 1 GB se asigna para el espacio de direcciones del kernel. El tamaño de partición específico está determinado por la variable de configuración del kernel PAGE_OFFSET.

memoria física

Para admitir múltiples arquitecturas, Linux usa una forma independiente de la arquitectura para describir la memoria física.

La memoria física se puede organizar en bancos de memoria (bancos), cada uno a una distancia específica del procesador. Este tipo de diseño de memoria se ha vuelto muy común a medida que más y más máquinas adoptan la tecnología Nonuniform Memory Access (NUMA). Las máquinas virtuales Linux representan este arreglo como nodos. Cada nodo se divide en varios bloques de memoria denominados zonas de gestión, que representan un rango de direcciones en la memoria. Hay tres zonas de gestión diferentes: ZONE_DMA, ZONE_NORMAL y ZONE_HIGHMEM. Por ejemplo, x86 tiene las siguientes áreas de administración de memoria:

ZONE_DMA Los primeros 16 MB de la dirección de memoria

ZONE_NORMAL 16 MB~896 MB ZONE_HIGHMEM

896 MB~el final de la dirección de memoria

Cada área de administración tiene su propio propósito. Algunos dispositivos ISA anteriores tenían restricciones sobre qué direcciones podían realizar operaciones de E/S, y ZONE_DMA elimina estas restricciones.

ZONE_NORMAL se utiliza para todas las operaciones y asignaciones del núcleo. Es extremadamente importante para el rendimiento del sistema.

ZONE_HIGHMEM es el resto de la memoria en el sistema. Cabe señalar que ZONE_HIGHMEM no se puede usar para la asignación del kernel y las estructuras de datos, y solo se puede usar para guardar los datos del usuario.

mapa de memoria