En primer lugar para instalar Zookeeper

首先使用XFTP工具 将Zookeeper和HBase的压缩包上传到集群的节点上去(hadoop2)

Después de subir archivos a un nodo en el cluster se pueden utilizar scp apache-zookeeper-3.5.6-bin.tar.gz jee@hadoop3:/home/jee/software/para enviar el archivo a otro dos máquinas en un comando de clúster

ZOOKEEPER descomprimir el paquete comprimido hadoop2sudo tar -zxvf apache-zookeeper-3.5.6-bin.tar.gz -C /usr/local/

Zookeeper nombre del paquete cambia un poco demasiado largo nombramosmv apache-zookeeper-3.5.6-bin/ zookeeper

A continuación, modificar los usuarios y grupos de usuarios (necesidad de cambiar al usuario root) chown -R jee:jee zookeeper/(originalmente el usuario root se revisa nuestros propios usuarios normales)

Creamos una zkDatacarpeta que se utiliza para almacenar datos (Nota: Para pasar de nuevo a normal del usuario o usuarios y grupos de usuarios else esta carpeta es la raíz de)mkdir zkData

A continuación configuramos Zookeeper

Introduzca la ruta: /usr/local/zookeeper/confel archivo renombrado zoo.cfg zoo_sample.cfgmv zoo_sample.cfg zoo.cfg

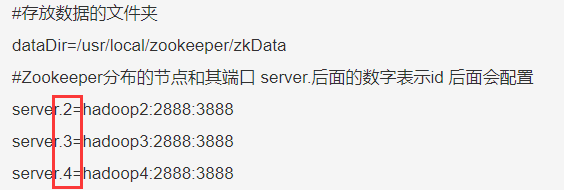

Zoo.cfg modificar el archivo de configuración de la siguiente información:

#存放数据的文件夹

dataDir=/usr/local/zookeeper/zkData

#Zookeeper分布的节点和其端口 server.后面的数字表示id 后面会配置

server.2=hadoop2:2888:3888

server.3=hadoop3:2888:3888

server.4=hadoop4:2888:3888

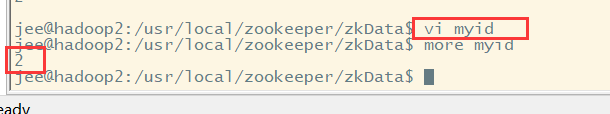

myid configuración

在hadoop2上zookeeper的zkData路径下创建myid文件。写入id。

Hadoop2的myid 为2

Hadoop3的myid 为3

Hadoop4的myid 为4

Identificación de escritura tiene que ser consistente y archivo de configuración zoo.cfg.

Hasta ahora hemos Zookeeper configuración en un solo nodo se ha completado, entonces 在其他两台节点上解压文件+修改用户组+创建zkData文件夹a continuación, hacemos Zookeeper otros dos nodos se han instalado para modificar sólo un perfil delgado que vamos a tener sólo los archivos configurados distribuidos a dos nodo de Taiwán en él

在配置好的节点上执行下面命令:

rsync -rvl /usr/local/zookeeper/conf/* jee@hadoop3:/usr/local/zookeeper/conf

rsync -rvl /usr/local/zookeeper/conf/* jee@hadoop4:/usr/local/zookeeper/conf

A continuación, crear myid en zkData estos dos nodos

hadoop3的zkData的目录下创建myid,写入3

Hadoop4的zkData的目录下创建myid,写入4

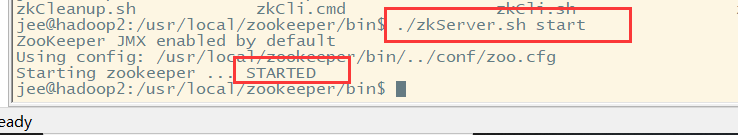

Entonces comenzamos a ver si la configuración del clúster tiene éxito

Iniciar y detener el clúster:

启动:

/usr/local/zookeeper/bin/zkServer.sh start

停止:

/usr/local/zookeeper/bin/zkServer.sh stop

注:zookeeper集群的每个服务器都需要启动/停止,所有zookeeper服务器启动后,只有一个Leader,其他都是follower

Ver estado:

执行:/usr/local/zookeeper/bin/zkServer.sh status

信息如下:

ZooKeeper JMX enabled by default

Using config: /usr/local/zookeeper/bin/../conf/zoo.cfg

Client port found: 2181. Client address: localhost.

Mode: follower

Configuración de HBase

En primer lugar extraer los archivos comprimidos en un /usr/local/directorio llamado Modificar hbasey modificar los usuarios y grupos de usuariossudo chown -R jee:jee hbase/

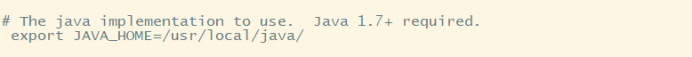

Modificar el archivo de configuración hbase-env.sh

1.修改JDK环境变量JAVA_HOME

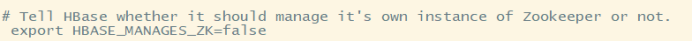

2.修改HBASE-MANAGES-ZK=false;

默认为true,表示使用Hbase自带的zookeeper。修改为false,表示使用独立安装的zookeeper。

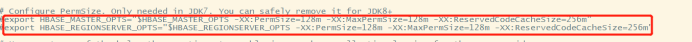

3.如果使用的jdk 1.8以上版本,需要移除HBASE-MASTER-OPTS和HBASE-REGIONSERVER-OPTS配置

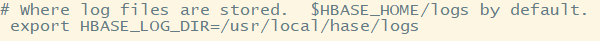

4.创建并配置HBASE_LOG_DIR路径

reconfiguración hbase-site.xml

<!--zookeeper的节点主机名-->

<configuration>

<property>

<name>hbase.zookeeper.quorum</name>

<value>hadoop2:2181,hadoop3:2181,hadoop4:2181</value>

<description>The directory shared by RegionServers.

</description>

</property>

<!--hbase的存储根目录,设为hadoopHDFS根目录下的hbase-->

<property>

<name>hbase.rootdir</name>

<value>hdfs://hadoop2:9000/hbase</value>

<description>The directory shared by RegionServers.

</description>

</property>

<property>

<name>hbase.cluster.distributed</name>

<value>true</value>

<description>The mode the cluster will be in. Possible values are

false: standalone and pseudo-distributed setups with managed Zookeeper

true: fully-distributed with unmanaged Zookeeper Quorum (see hbase-env.sh)

</description>

</property>

<property>

<name>hbase.master.port</name>

<value>16000</value>

</property>

<property>

<name>hbase.zookeeper.property.dataDir</name>

<value>/usr/local/zookeeper/zkData</value>

</property>

</configuration>

Sobrescribir regionserversarchivos de clúster nombre de la máquina que escribimos

regionservers中的节点表示 这些节点都是RegionServer

配置从节点名称:

hadoop2

hadoop3

hadoop4

Hbase conexión suave Hadoop:

将hadoop的core-site.xml和hdfs-site.xml放到hbase/conf目录下。

ln 软链接命令

ln -s /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hbase/conf/core-site.xml

ln -s /usr/local/hadoop/etc/hadoop/core-site.xml /usr/local/hbase/conf/hdfs-site.xml

Hasta ahora hemos hbase de configuración en un nodo se ha completado y que todos将这台节点上的HBase拷贝到其他节点上去

sudo scp -r /usr/local/hbase root@hadoop3:/usr/local/hbase

sudo scp -r /usr/local/hbase root@hadoop4:/usr/local/hbase

然后再修改拷过去的HBase的用户和用户组

并且 软链接是不会拷贝过去的 所以我们需要在Hadoop2和Hadoop3中也创建两个软链接

Además, hbase tiempo muy exigentes probable brecha entre los diferentes nodos de unos minutos puede conducir a HBase a la orden, así que necesitamos conjunto 时钟同步al nodo haga oportunamente en el clúster son los mismos

将一台节点作为主节点 另外的节点作为从节点 然后从节点向主节点拉取时间即可

我们将Hadoop2作为主节点 Hadoop3和Hadoop4作为从节点 开始设置

1.先在Hadoop2中安装NTP

sudo apt-get install ntp

2.修改被同步机器的/etc/ntp.conf

主要配置:

(1) 哪些机器能够访问时钟同步服务,进行时钟同步。权限配置

(2)配置时钟同步的服务端,时间服务的层级

#限制只能是192.168.124.0/24网段的IP可以连接机器同步时间,不支持远程登陆

//需要根据自己的本地IP修改

restrict 192.168.124.0 mask 255.255.255.0 nomodify notrap

//下面这两个不用修改

server 127.127.1.0 #表示本机

fudge 127.127.1.0 stratum 10 #fudge和server相同,stratum 时间服务器的层级

关闭需要同步时间机器的ntp(除hadoop2的其他机器)

sudo service ntp stop

同步时间(除hadoop2的其他机器都要执行)

sudo ntpdate hadoop2

在除hadoop2的其他机器,将同步时间的命令放在crontab中(切换到root用户下操作)

crontab -e # 打开crontab

0 8 * * * ntpdate deptest1 #需要添加的命令,每天早上八点同步一次