Einführung

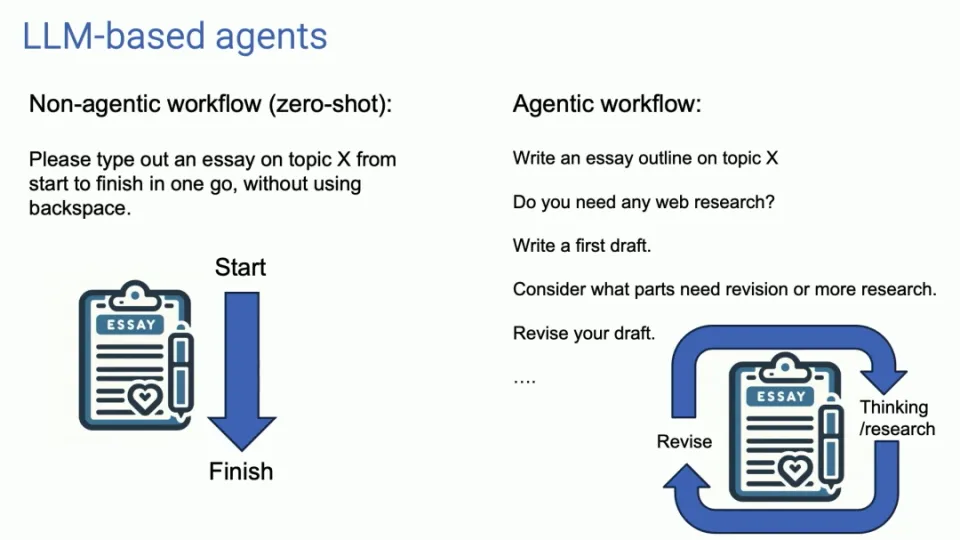

Kürzlich veröffentlichte Professor Andrew Ng, eine hochkarätige Autorität auf dem Gebiet der künstlichen Intelligenz, auf dem Sequoia AI Summit in den Vereinigten Staaten topaktuelle Trends und tiefgreifende Erkenntnisse zu KI-Agenten. Er wies darauf hin, dass der Agent-Workflow im Vergleich zu herkömmlichen Large-Scale-Language-Model-Anwendungen (LLM) mehr iterative und konversationelle Eigenschaften aufweist, was uns neue Ideen im Bereich der KI-Anwendungsentwicklung eröffnet.

Auf diesem Gipfel diskutierte Professor Ng Enda eingehend die Entwicklungsaussichten von AI Agent, einem spannenden Thema für alle KI-Entwickler und -Forscher. Er erklärte die Kernmerkmale des Agent-Workflows: Anstatt sofortiges Feedback anzustreben, befürwortet er die Erledigung von Aufgaben durch kontinuierliche Kommunikation und iterative Prozesse, um bessere Ergebnisse zu erzielen.

Merkmale des Agenten-Workflows

Die herkömmliche LLM-Nutzung ähnelt der einmaligen Eingabe und Ausgabe, während der Agent-Workflow einem kontinuierlichen Dialog gleicht und die Ausgabeergebnisse durch mehrere Iterationen optimiert. Dieser Ansatz erfordert, dass wir die Art und Weise ändern, wie wir mit der KI interagieren, Aufgaben stärker an den Agenten delegieren und geduldig auf die Ergebnisse warten, die sie liefert.

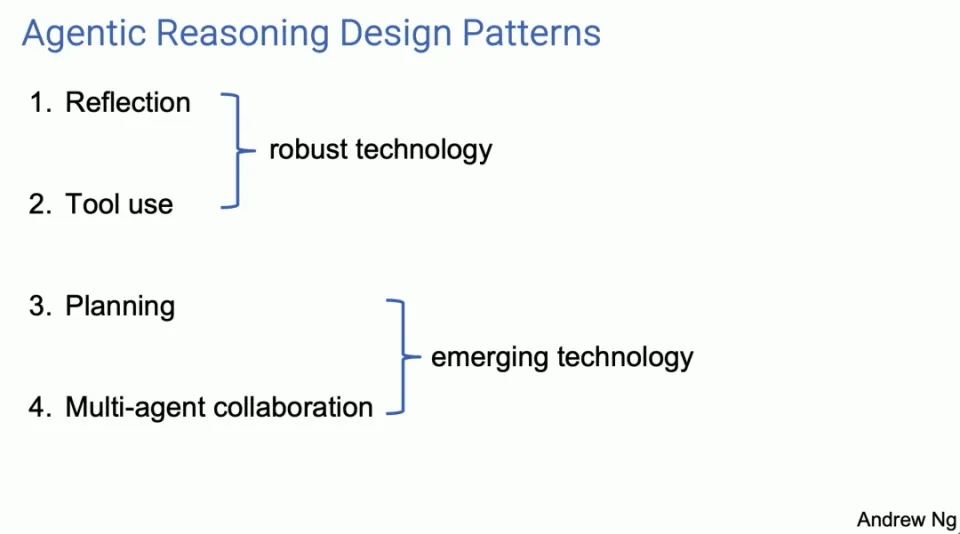

Vier Hauptentwurfsmuster für Agenten

Professor Ng Enda stellte vier Hauptentwurfsmuster für Agenten vor, von denen jedes das Potenzial zur Verbesserung der KI-Fähigkeiten zeigt.

-

Betrachtung

- Der Agent verbessert die Qualität der Ergebnisse, indem er die Ausgabe selbst überprüft und korrigiert. Beim Schreiben von Code kann der Agent beispielsweise Fehler selbst reflektieren und korrigieren und so besseren Code generieren.

Agent Reflection ist ein Tool, das meiner Meinung nach viele von uns verwenden, und es ist das Tool, das funktioniert. Ich denke, dass es weithin bekannt ist und tatsächlich recht gut funktioniert. Ich denke, das sind ziemlich robuste Techniken. Wenn ich sie verwende, läuft die Planung und die Zusammenarbeit mit mehreren Agenten fast immer gut.

Ich denke, das ist eher ein aufstrebendes Gebiet und ich bin manchmal überrascht, wie gut sie funktionieren, wenn ich sie verwende, aber zumindest im Moment habe ich das Gefühl, dass ich sie nicht immer zuverlässig zum Laufen bringen kann. Lassen Sie mich diese vier Designmuster anhand mehrerer Aspekte erläutern. Wenn einige von Ihnen zurückgehen und es selbst ausprobieren oder Ihre Ingenieure dazu bringen, diese zu verwenden, werden Sie meiner Meinung nach ziemlich schnell einen Produktivitätsschub erzielen.

Bezüglich der Reflexion finden Sie hier ein Beispiel. Nehmen wir an, ich bitte ein System, Code zu schreiben, damit ich eine bestimmte Aufgabe erledigen kann. Und dann haben wir einen Codierungsagenten, der einfach ein LLM ist, den Sie zum Schreiben von Code auffordern, etwa: „Hey, definieren Sie doTask, schreiben Sie eine Funktion wie diese.“

Ein Beispiel für Selbstreflexion könnte sein, wenn Sie LLM dann mit etwas auffordern wie: „Hier ist ein Codestück, das eine Aufgabe erfüllen soll. Geben Sie ihm einfach genau denselben Code, den sie gerade generiert haben, und sagen Sie: Überprüfen Sie noch einmal, ob der Code korrekt ist.“ effizient, gut konstruiert? Schreiben Sie einfach einen Hinweis wie diesen.“

Es könnte sich herausstellen, dass derselbe LLM, den Sie zum Schreiben des Codes aufgefordert haben, einen Fehler wie diesen in Zeile 5 finden und ihn irgendwie beheben kann. Wenn Sie nun Ihr eigenes Feedback geben und es erneut auffordern, wird möglicherweise eine zweite Version des Codes erstellt, die möglicherweise besser funktioniert als die erste Version.

Keine Garantie, aber es funktioniert oft so gut, dass es für viele Anwendungen einen Versuch wert ist, und es verheißt Gutes, wenn man es die Unit-Tests ausführen lässt, und wenn es die Unit-Tests nicht besteht, warum besteht es dann auch die Unit-Tests nicht? Dieses Gespräch könnte Aufschluss darüber geben, warum die Unit-Tests fehlschlagen. Versuchen Sie also, einige Dinge zu ändern und holen Sie sich vielleicht Version 3.

Übrigens, für diejenigen unter Ihnen, die mehr über diese Technologien erfahren möchten, bin ich sehr gespannt darauf. Für jeden der vier Teile habe ich unten einen Abschnitt mit empfohlener Lektüre, in dem weitere Referenzmaterialien enthalten sind.

Auch hier beschreibe ich bei Multi-Agent-Systemen einen einzelnen Code-Agenten, den Sie dazu auffordern, mit sich selbst zu kommunizieren. Eine natürliche Weiterentwicklung dieser Idee besteht darin, dass Sie anstelle eines einzelnen Code-Agenten zwei Agenten haben könnten, von denen einer der Code-Agent und der andere ein Kritikagent ist. Dabei kann es sich um dasselbe zugrunde liegende LLM handeln, das jedoch auf unterschiedliche Weise ausgelöst wird. Nehmen wir einmal an, Sie sind ein Experte im Code-Schreiben, oder? schreibe den Code. Ein anderer sagte: Sie sind ein erfahrener Code-Reviewer, überprüfen Sie diesen Code.

Dieser Workflow ist eigentlich einfach zu implementieren. Ich denke, dass dies eine sehr vielseitige Technik für viele Arbeitsabläufe ist. Dadurch wird die Leistung von LLM deutlich verbessert.

-

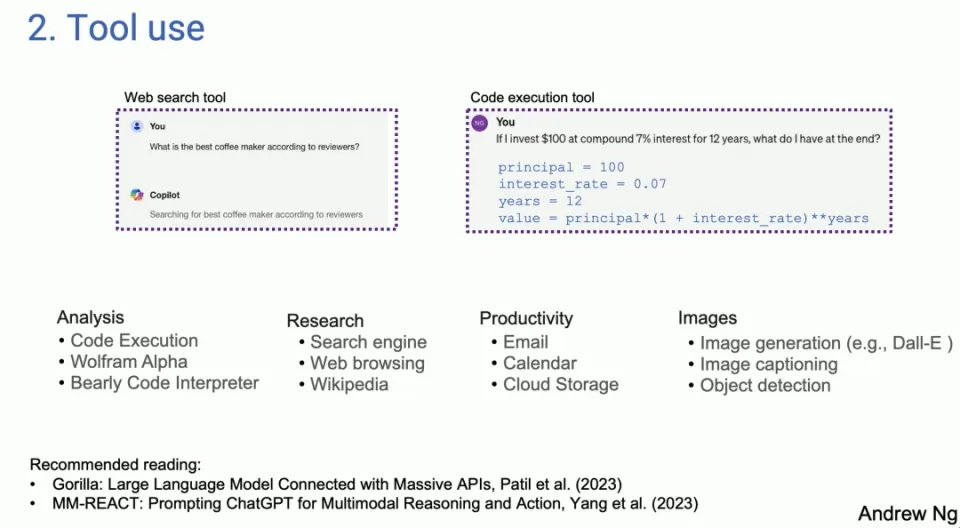

Werkzeuggebrauch

- LLM ist in der Lage, Code zu generieren und APIs aufzurufen, um praktische Vorgänge durchzuführen, wodurch sein Anwendungsbereich erweitert wird. In diesem Modus kann LLM nicht nur Texte generieren, sondern auch mit externen Tools und Schnittstellen interagieren.

Das zweite Entwurfsmuster ist eines, das viele Leute in LLM-basierten Systemen verwendet haben. Links ist ein Screenshot von Copilot. Auf der rechten Seite habe ich etwas aus GPT-4 übernommen, aber das heutige LLM: Wenn Sie bei einer Online-Suche nach der besten Kaffeemaschine fragen, generiert LLM bei bestimmten Fragen den Code und führt den Code aus. Es stellt sich heraus, dass es viele verschiedene Tools gibt, die von vielen verschiedenen Menschen zur Analyse, Informationsbeschaffung, Aktion und persönlichen Produktivität verwendet werden.

Frühe Arbeiten fanden Anwendung, ursprünglich in der Computer-Vision-Community. Denn vor LLM konnten sie keine Bilder verarbeiten. Die einzige Möglichkeit besteht also darin, einen Funktionsaufruf zu generieren, der das Bild manipulieren kann, z. B. ein Bild generieren oder eine Objekterkennung durchführen usw. Wenn man sich tatsächlich die Fachliteratur anschaut, ist es interessant, dass ein Großteil der Arbeiten zur Nutzung offenbar aus dem Bereich der Bildverarbeitung stammt, denn vor GPT-4 und so weiter war LLM blind für Bilder, und das ist die Nutzung und Erweiterung von LLM Dinge, die getan werden können.

-

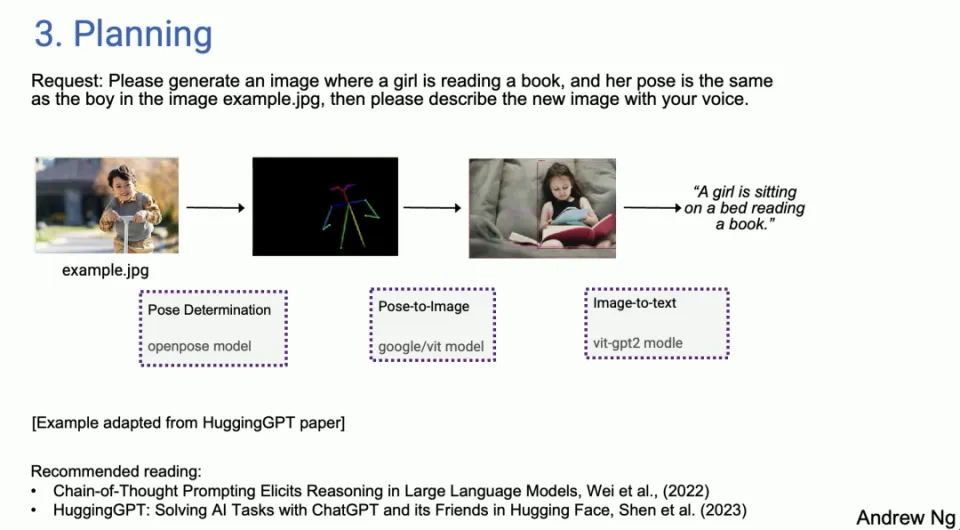

Planung

- Der Agent kann komplexe Aufgaben aufschlüsseln und wie geplant ausführen und so die Fähigkeit der KI zur Bewältigung komplexer Probleme demonstrieren. Planungsalgorithmen ermöglichen es Agenten, Aufgaben effizienter zu verwalten und abzuschließen.

Und dann die Planung: Für diejenigen, die noch nicht viel mit Planungsalgorithmen herumgespielt haben: Ich habe das Gefühl, dass viele Leute über ChatGPT-Momente sprechen, in denen man denkt: „Wow, so etwas habt ihr noch nie gesehen.“ Ich glaube nicht, dass Sie noch einen Planungsalgorithmus verwenden. Viele Menschen werden von AI Agent überrascht sein.

Ich kann mir nicht vorstellen, dass ein KI-Agent das gut macht. Ich habe Live-Demos durchgeführt und einige davon sind fehlgeschlagen, und der AI-Agent hat diese Fehler umgangen. Ich bin tatsächlich auf einige Situationen gestoßen, in denen ich nicht glauben konnte, dass mein KI-System das einfach autonom erledigt hat.

Aber ein Beispiel aus dem HuggingGPT-Papier, Sie sagten: Bitte erstellen Sie ein Bild eines Mädchens, das ein Buch in der gleichen Haltung wie der Junge im Bild liest. Beispiel: Punkt-JPEG. Bitte beschreiben Sie das neue Bild mit Stimme. Um ein Beispiel zu nennen: Heute gibt es einen KI-Agenten, und Sie können entscheiden, dass Sie als Erstes die Haltung des Jungen bestimmen müssen. Suchen Sie dann das richtige Modell und extrahieren Sie möglicherweise die Pose auf HuggingFace. Als nächstes müssen Sie ein Posenbildmodell finden, um ein Bild eines Mädchens zu synthetisieren, und den Anweisungen folgen. Dann nutzen Sie die Bilderkennung und schließlich Text-to-Speech.

Wir haben heute tatsächlich Agenten, ich möchte nicht sagen, dass sie zuverlässig arbeiten, sie sind ein wenig wählerisch. Sie funktionieren nicht immer, aber wenn doch, ist es eigentlich ziemlich erstaunlich, aber mit Agent Sex Loops kann man sich manchmal auch von frühen Misserfolgen erholen. So stellte ich fest, dass ich bereits Research Agent nutzte. Also ein Teil meiner Arbeit, ein Teil meiner Recherche, aber ich habe keine Lust, selbst zu Google zu gehen und viel Zeit damit zu verbringen. Ich soll es an den Forschungsagenten senden und ein paar Minuten später wiederkommen, um zu sehen, was es findet. Manchmal funktioniert es, manchmal nicht, aber es ist bereits Teil meines persönlichen Arbeitsablaufs.

-

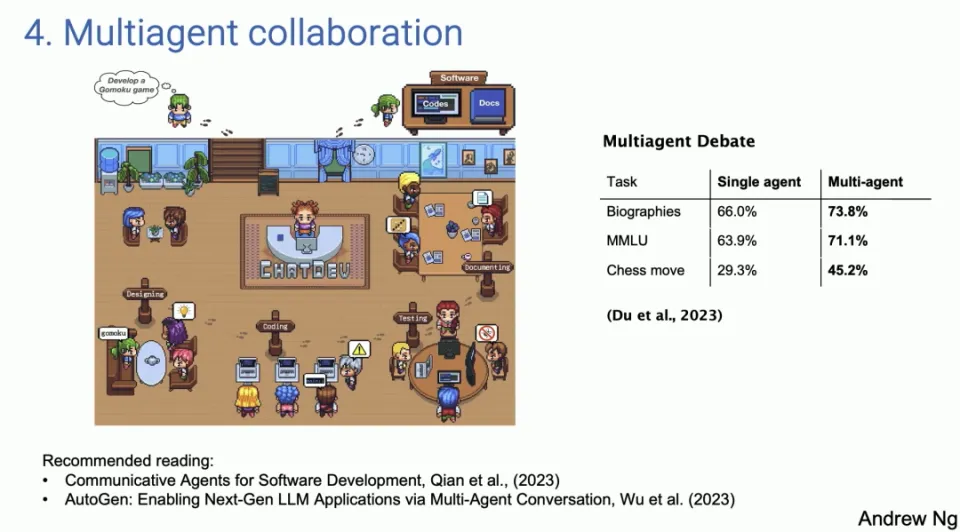

Multiagenten-Zusammenarbeit

- Mehrere Agenten spielen unterschiedliche Rollen und arbeiten bei der Erledigung von Aufgaben zusammen, wodurch die Zusammenarbeit in einer realen Arbeitsumgebung simuliert wird. Die Stärke dieses Ansatzes besteht darin, dass LLM zu mehr als nur einem Werkzeug wird, das eine einzelne Aufgabe ausführt, sondern zu einem kollaborativen System wird, das in der Lage ist, komplexe Probleme und Arbeitsabläufe zu bewältigen.

Das letzte Entwurfsmuster, die Multi-Agenten-Kooperation, klingt interessant, funktioniert aber viel besser, als Sie vielleicht denken. Auf der linken Seite ist ein Screenshot aus einem Artikel namens ChatDev zu sehen, der vollständig Open Source ist, eigentlich Open Source. Wie viele von Ihnen gesehen haben, Shining Social

Die von den Medien veröffentlichte Demo, ChatDev, ist Open Source und läuft auf meinem Laptop. ChatDev ist ein Beispiel für ein Multi-Agenten-System, bei dem Sie einen LLM dazu veranlassen können, sich manchmal wie der CEO eines Softwareentwicklungsunternehmens, manchmal wie ein Designer, manchmal wie ein Produktmanager und manchmal wie ein Tester zu verhalten.

Indem man LLM dazu auffordert, zu sagen, dass man jetzt der CEO und jetzt der Software-Ingenieur ist, arbeiten sie zusammen und führen ein ausführliches Gespräch, bis zu dem Punkt, dass sie es tun werden, wenn man es sagt: „Entwickeln Sie bitte ein Spiel, entwickeln Sie ein Multiplayer-Spiel.“ Verbringen Sie tatsächlich ein paar Minuten damit, den Code zu schreiben, ihn zu testen, zu iterieren und am Ende steht ein überraschend komplexes Programm.

Diese Art der Multi-Agenten-Zusammenarbeit klingt vielleicht etwas fantasievoll, funktioniert aber tatsächlich besser, als Sie sich vorstellen können. Dies liegt nicht nur daran, dass die Zusammenarbeit zwischen diesen Agenten reichhaltigere und vielfältigere Beiträge liefern kann, sondern auch daran, dass sie ein Szenario simulieren kann, das einer realen Arbeitsumgebung näher kommt, in der Menschen mit unterschiedlichen Rollen und Fachkenntnissen auf ein gemeinsames Ziel hinarbeiten. Die Stärke dieses Ansatzes besteht darin, dass LLM zu mehr als nur einem Werkzeug wird, das eine einzelne Aufgabe ausführt, sondern zu einem kollaborativen System wird, das in der Lage ist, komplexe Probleme und Arbeitsabläufe zu bewältigen.

Der potenzielle Wert dieses Ansatzes ist enorm, da er neue Möglichkeiten zur Automatisierung und effizienteren Gestaltung von Arbeitsabläufen eröffnet. Durch die Simulation der verschiedenen Rollen eines Softwareentwicklungsteams kann ein Unternehmen beispielsweise bestimmte Entwicklungsaufgaben automatisieren und so Projekte beschleunigen und Fehler reduzieren. In ähnlicher Weise kann diese Multi-Agenten-Kooperationsmethode auch auf andere Bereiche wie die Erstellung von Inhalten, Bildung und Schulung sowie strategische Planung angewendet werden, wodurch der Anwendungsbereich von LLM in verschiedenen Branchen weiter erweitert wird.

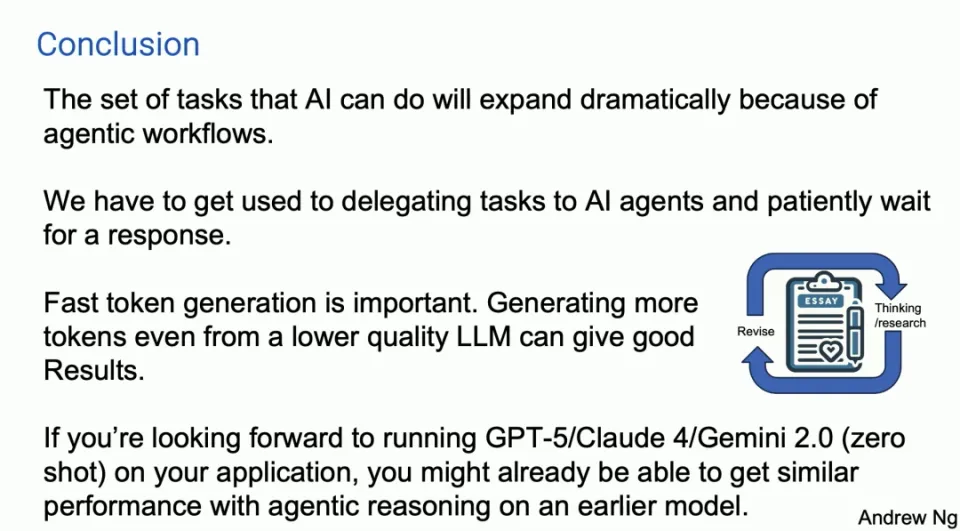

Potenzial und Herausforderungen des Agenten-Workflows

Obwohl diese Agenten-Workflows voller Potenzial sind und sich schnell weiterentwickeln, gibt es auch einige Herausforderungen. Einige Entwurfsmuster sind relativ ausgereift und zuverlässig, während andere noch unsicher sind. Darüber hinaus darf die Bedeutung der schnellen Token-Generierung nicht außer Acht gelassen werden, da sie es ermöglicht, gute Ergebnisse zu erzielen, selbst wenn sie auf einem LLM mit geringerer Qualität basiert und neue Token durch schnelle Iteration generiert.

Fallstudien und praktische Anwendungen

Professor Ng Enda erläuterte die Wirksamkeit des Agent-Workflows anhand von Fallstudien und praktischen Anwendungen. Beispielsweise zeigen die Codierungsanalyse mithilfe des Human Eval Benchmark und der Leistungsvergleich zwischen GPT-3.5 und GPT-4 beide die Überlegenheit des Agent-Workflows. Insbesondere im Bereich der Softwareentwicklung zeigen Anwendungsbeispiele von Multi-Agenten-Systemen, wie durch die Simulation verschiedener Rollen in einer realen Arbeitsumgebung die Entwicklungseffizienz verbessert und Fehler reduziert werden können.

Zukunftsausblick

Professor Ng Enda glaubt, dass die Fähigkeiten von KI-Agenten erheblich erweitert werden und wir neue Wege der Arbeit mit KI-Agenten erlernen müssen. Das Potenzial schneller Iteration und früher Modelle deutet darauf hin, dass KI in verschiedenen Bereichen breiter und tiefer eingesetzt werden wird.

Zusammenfassen

Durch Entwurfsmuster wie Agent Reflection, Planung und Multi-Agent-Kooperation können wir nicht nur die Leistung von LLMs verbessern, sondern auch ihre Anwendungsbereiche erweitern und sie zu leistungsfähigeren und flexibleren Werkzeugen machen. Während sich diese Technologien weiterentwickeln und verbessern, freuen wir uns darauf, dass KI-Agenten in Zukunft in weiteren Szenarien eine Schlüsselrolle spielen und den Menschen intelligentere und effizientere Lösungen bieten.

Es funktioniert nicht immer. Ich habe es benutzt. Manchmal funktioniert es nicht, manchmal ist es überraschend, aber die Technologie wird definitiv besser. Es gibt auch ein Entwurfsmuster, und es stellt sich heraus, dass bei einer Multi-Agent-Debatte, also einer Debatte zwischen verschiedenen Agenten, beispielsweise ChatGPT und Gemini miteinander debattieren können, was tatsächlich zu einer besseren Leistung führt.

Daher ist die Zusammenarbeit mehrerer simulierter Luftagenten ebenfalls ein leistungsstarkes Entwurfsmuster. Zusammenfassend denke ich, dass dies die Muster sind, die ich gesehen habe. Ich denke, wenn wir diese Muster nutzen könnten, könnten viele von uns sehr schnell praktische Verbesserungen erzielen. Ich denke, dass das Entwurfsmuster für die Argumentation des Agenten wichtig sein wird.

Hier ist meine kurze Zusammenfassungsfolie. Ich gehe davon aus, dass aufgrund des Agenten-Workflows die Aufgaben, die KI erledigen kann, in diesem Jahr erheblich zunehmen werden. Eine Sache, an die man sich eigentlich nur schwer gewöhnen kann, ist die Tatsache, dass wir, wenn wir eine Aufforderung an das LLM senden, eine sofortige Antwort erwarten. Als ich vor zehn Jahren bei Google über das sprach, was wir „Big-Box-Suche“ nannten, war einer der Gründe für lange Eingabeaufforderungen, einer der Gründe dafür, dass es mir nicht gelungen ist, die Suche voranzutreiben, tatsächlich, weil man bei einer Websuche, man Sie möchten in der Hälfte der Zeit suchen und innerhalb von Sekunden eine Antwort erhalten, oder? Das liegt in der Natur des Menschen: sofortige Erfassung, sofortiges Feedback.

Bei vielen Agenten-Workflows denke ich, dass wir lernen müssen, Aufgaben an KI-Agenten zu delegieren und geduldig Minuten oder sogar Stunden auf eine Antwort zu warten, aber ich habe gesehen, dass viele unerfahrene Manager Aufgaben an jemanden delegieren und dann fünf Minuten nach der Inspektion sind das Gleiche, oder? Das ist nicht produktiv.

Ich denke, wir müssen lernen, das auch bei einigen unserer KI-Agenten zu tun, auch wenn es schwierig ist. Ich dachte, ich hätte einen Verlust gehört. Ein wichtiger Trend besteht darin, dass schnelle Token-Generatoren wichtig sind, da wir in diesen Agent-Workflows ständig iterieren. LLM generiert also Token für LLM, und es ist großartig, Token viel schneller generieren zu können, als jeder lesen kann.

Ich denke, dass die schnelle Generierung weiterer Token, selbst aus einem LLM mit etwas geringerer Qualität, im Vergleich zu langsameren Token aus einem besseren LLM gute Ergebnisse liefern kann. Das könnte ein wenig kontrovers sein, weil es dazu führen könnte, dass man den Kreis mehrmals umkreist, ähnlich wie ich es auf der ersten Folie mit GPDC und den Ergebnissen einer Agentenarchitektur gezeigt habe.

Ehrlich gesagt freue ich mich wirklich auf Claude5 und Claude4, GPT-5 und Gemini 2.0 und all diese wunderbaren Modelle, die ihr baut. Ein Teil von mir hat das Gefühl, dass Sie, wenn Sie Ihre Sachen auf GPT-5, Zero-Shot, ausführen möchten, bei manchen Anwendungen tatsächlich näher an dieses Leistungsniveau herankommen, als Sie denken, mit Agent-Inferenz, aber bei einem frühen Modell Ich denke, das ist ein wichtiger Trend.

Ehrlich gesagt fühlt sich der Weg zu AGI eher wie eine Reise als wie ein Ziel an, aber ich denke, dieser Agent-Workflow könnte uns helfen, auf dieser sehr langen Reise einen kleinen Schritt vorwärts zu machen.

Linus nahm die Sache selbst in die Hand, um zu verhindern, dass Kernel-Entwickler Tabulatoren durch Leerzeichen ersetzen. Sein Vater ist einer der wenigen Führungskräfte, die Code schreiben können, sein zweiter Sohn ist Direktor der Open-Source-Technologieabteilung und sein jüngster Sohn ist ein Kern Mitwirkender bei Open Source: Es dauerte ein Jahr, 5.000 häufig verwendete mobile Anwendungen zu konvertieren. Java ist die Sprache, die am anfälligsten für Schwachstellen von Drittanbietern ist. Wang Chenglu, der Vater von Hongmeng: Open Source Hongmeng ist die einzige architektonische Innovation im Bereich der Basissoftware in China. Ma Huateng und Zhou Hongyi geben sich die Hand, um „den Groll zu beseitigen.“ Ehemaliger Microsoft-Entwickler: Die Leistung von Windows 11 ist „lächerlich schlecht“. sind sehr herzerwärmend . Meta Llama 3 wird offiziell veröffentlichtDieser Artikel ist ein Nachdruck des Artikels Heng Xiaopai und das Urheberrecht liegt beim ursprünglichen Autor. Es wird empfohlen, den Originaltext zu lesen. Um diesen Artikel erneut zu drucken, wenden Sie sich bitte an den Originalautor.