大数据老司机的经验-走自己特色的技术路

浪院长 浪尖聊大数据

浪尖写本文的主要原因就是在qq,微信群,及星球里发现很多提问者提的问题都是由于解决问题方式或思路不对导致的。还有就是在学习一门新技术的时候,如何做呢?

很多人都是找浪尖要视频,我觉得这个行为也不是很好,老司机们都不会这么做。那么,今天浪尖就写文章讲讲浪尖自己是如何学习一门新技术或者解决工作中的问题的吧。

1. 官网

第一件事翻看官网,很多问题都是自己概念没弄清楚造成的,或者不了解框架的使用原则。

比如,这种问题

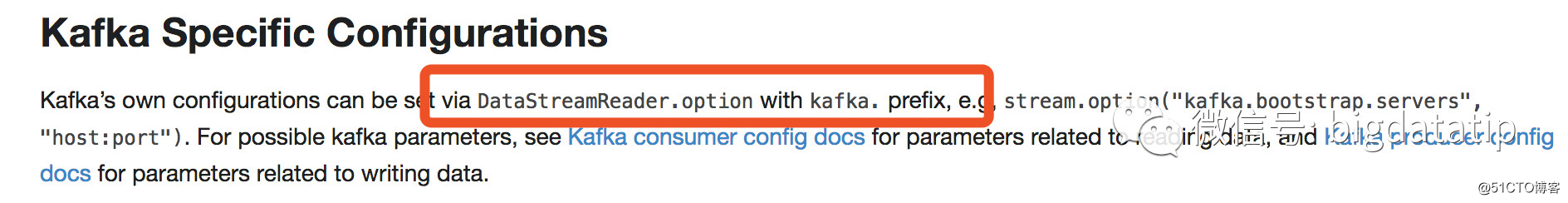

那么,其实官网的底部有详细的讲解

http://spark.apache.org/docs/latest/structured-streaming-kafka-integration.html

这就是按照自己思维惯性去做事情,而不是按照官网手册去做。所以,要多看看官网,我觉得对于自己刚开始学习一项东西的时候,官网翻三五遍很有必要。

不要用我不会英文来搪塞自己,谷歌翻译越来越准确了。

2. 案例

很多人学大数据的时候,不知道如何下手写一些demo,也总想着靠视频去获取项目实战经验。要知道,视频中所谓的千亿级别数据的项目等都是demo,没人会给你千亿的数据让你练手,当然,即使给你你也玩不了,没资源啊。

在这里强调一下,项目不是重点,重点是根据工程理解原理,只有你理解了原理,才能很容易定位瓶颈,找到调优方式。

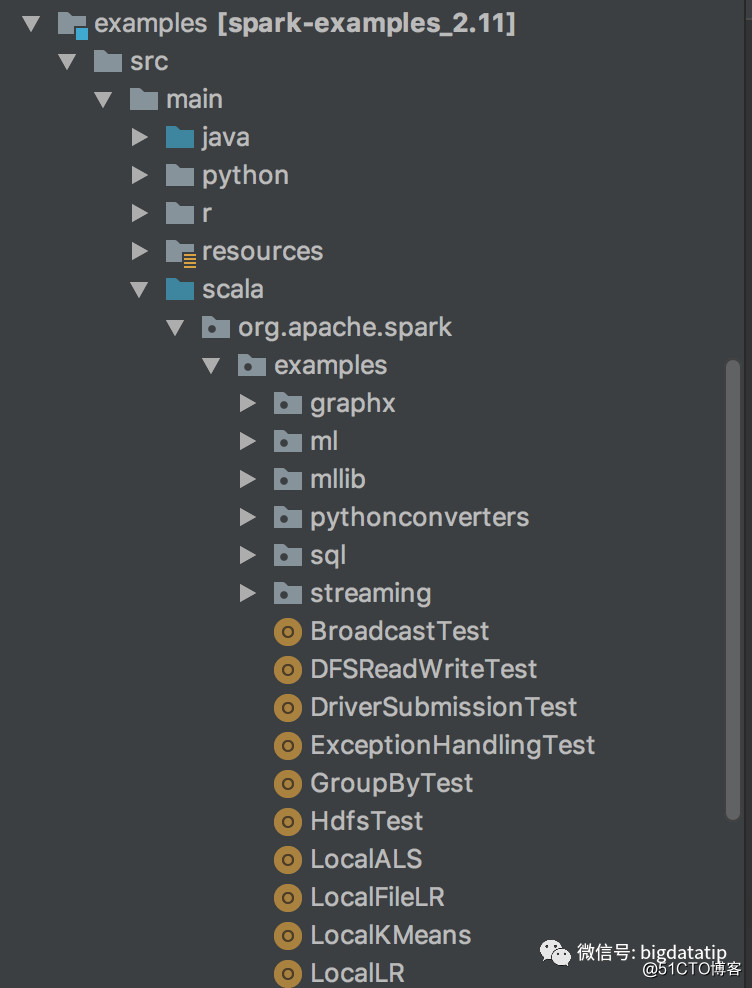

还有很多小白找浪尖要demo,实际上很没必要。首先,可以去github搜,其次也可以去下载源码,看源码内的demo。一般源码里examples module里面包含很多案例。

比如,spark源码里的demo案例,

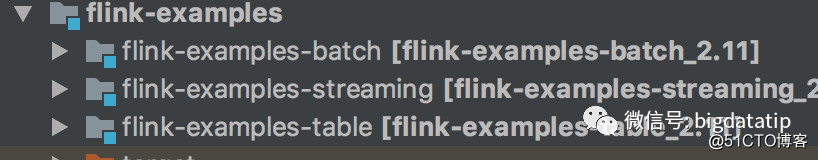

再比如flink源码里的demo案例,

里面案例很多,而且会支持多种编程语言。

这些完全足够你去入门了

3. 权威指南

权威指南,并不一定叫做这个名字,知识较好书籍的概称。但是对于大数据领域很多好资料就是真的叫权威指南了,没有的就去看官网。比如hbase权威指南,hadoop权威指南。我觉得无论你是刚入门还是老司机,除了官网要肯几遍,权威指南也要啃几遍,来充实一下你的大脑,否则大脑里都没有相关内容,那么编码不就是瞎蒙或者按照思维惯性了吗?那更别说调优了。

Spark 下操作 HBase(1.0.0 新 API)

还有就是hadoop的各种面试题,肯定去读hadoop权威指南,很多博客就是抄的hadoop权威指南,人抄写总会有笔误,我不明白,你为啥还宁愿看有可能存在笔误的内容而不去看权威指南呢?官网也是类似。

4. 搜索引擎

谷歌 百度。

关键字搜索这个不用多说,吐槽一下,百度广告过多,建议大家搞定谷歌。

5. 请教大牛

才是问别人。问的问题要描述清楚,还有描述一下自己尝试的解决方法,这样便于别人给你针对性的解决问题,过滤掉不必要的猜测。

禁忌,在吗?

禁忌,有人会。。。吗?

.....

大家都很忙的,所以请教别人问题的时候,一定要直奔主题,可参考:

1) 贴出详细log截图

不要就发一行或者半行,大牛也不是神;

更不要直接发错误日志,不便于观察阅读,就发截图即可尽可能长的截图。

2) 写出问题出现的背景

比如你在做什么的时候出现的,log指出的是哪一行代码,最好也贴出来。

3) 有没有尝试自己去解决,采用了哪些手段?

4) 态度要好。

无论是否有人愿意帮你,你在整理这套问题的时候,思路都会更加清晰,说不定就找到了解决方案。

6. 源码

源码里有你想要的一切,在这里不多说,后面出文章详细说说如何利用源码。

对源码的大致方针是:

不要害怕源码,要根据工作需求,摘抄,修改源码。

以上就是浪尖总结的经验。要结合实际情况灵活处理,形成自己的方法,而不是什么都去生搬硬套。