一、软间隔支持向量机直观理解

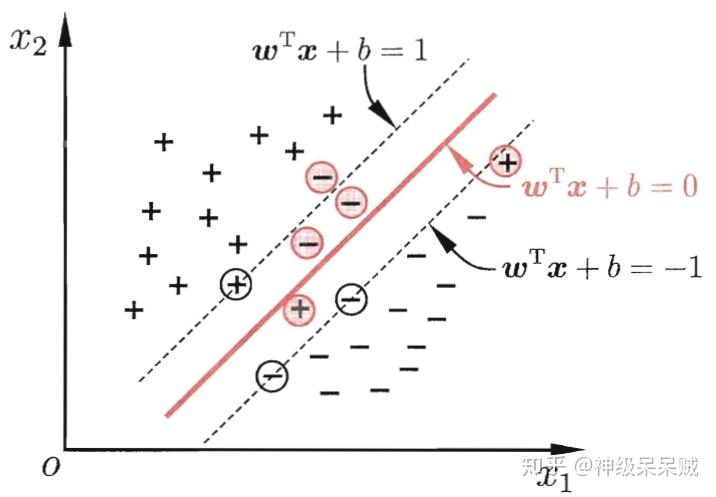

之前所介绍的支持向量机形式都是要求所有的样本都要能被正确地划分,这又被称作"硬间隔支持向量机",当数据是带有噪声的,就可能会产生一些脱离群体的点。在实际情况中,采用硬间隔的方式难以确定合适的核函数使得训练样本在特征空间中线性可分,即使能确定某个核函数能进行很好的划分,但模型可能也会存在过拟合的现象,导致模型的泛化能力较差。

存在一些样本点不满足约束条件

软间隔支持向量机旨在允许模型对一些离群点保持“容忍”态度。

二、软间隔支持向量基本形式

在硬间隔模型中,约束条件:

如果样本存在噪声,约束条件变成:

这里的 表示第

个样本点允许偏离函数间隔的值,又称作松弛变量。那么新的优化方程为:

这里的 是一个常量,又称作惩罚系数。当

值设置得很大时,目标函数后一项所占权重比也会很大,优化过程中将会着重优化后一项,即减小第

个样本点允许偏离函数间隔的值,模型退化成硬间隔型式,则可能会出现过拟合。同样地,当

值设置的非常小时,可能出现欠拟合情况。

之前提到的松弛变量 :

其中 :

由于 非凸,非连续,在求解目标函数时较为困难。因此还有一些其他的替代损失函数:

hinge损失:

指数损失:

对率损失:

三、模型求解

由拉格朗日乘子法,将(1)式转化成:

这里的 是约束条件

的拉格朗日乘子,

是约束条件

的拉格朗日乘子。

求偏导得:

代入到(2)式中,得到该问题的对偶式:

对比之前硬间隔下的对偶问题,二者差距仅仅在 多了一个上限

。如果使用核函数型式,则只需要把

换成

即可。求解拉格朗日乘子可以像之前那样使用SMO算法求解,具体过程不再赘述。

参考文献:

1.支持向量机通俗导论(理解SVM的三层境界) - Mac Track - CSDN博客

3.深入理解拉格朗日乘子法(Lagrange Multiplier) 和KKT条件

4.周志华. 机器学习[M]. 清华大学出版社, 2016

5.Andrew Ng 《machine learning》系列课程