点击下方卡片,关注“CVer”公众号

AI/CV重磅干货,第一时间送达

Physics-based Efficient Full Projector Compensation using only Natural image

Yuqi Li, Member, IEEE, Wenting Yin, Jiabao Li, and Xijiong Xie

本文旨在设计一个基于物理模型的全投影补偿架构,通过几张采样的自然图像对实现投影仪-相机系统(Procams)的几何校正和辐射度补偿。这项研究将全投影仪补偿作为一个数值优化问题,以适应由运动引起的几何形状和反射率的变化。借助基于物理的补偿方案,本方法保证了准确的颜色计算和投影表面的反射率估计。实验结果表明,本文提出的方法优于最先进的端到端的全投影仪补偿方法,具有更少的计算时间,更小的内存消耗,更好的图像质量以及更大的几何精度。

文章链接(已收录顶刊TVCG):https://www.computer.org/csdl/journal/tg/5555/01/10138930/1NBiTaSSkTK

开源代码:https://github.com/kylin-leo/FullProjectorCompensation

一、研究动机

投影仪在交互式娱乐、可视化和艺术品的虚拟展览中都有广泛的应用。过去的二十年中,已经开发了许多技术如分析Procams 的“刺激-响应”模型和修改输入的投影仪图像,来消除非平面的纹理表面对观测图像的几何失真和颜色偏差的影响。在投影显示中,几何校正和辐射度补偿的组合过程被称为全投影补偿。

目前针对全投影补偿任务的研究中,大多数方法假设Procams是静止的,通过Procams投影多张结构光图像和颜色采样图像到投影表面上并进行捕获,从而根据投影-拍摄的图像对中分析出对应的几何关系和颜色转换函数。然而,在实际环境中,投影仪、相机或投影表面在显示过程中的运动是不可避免且无法预测的,因此对于现有的Procams必须在运动发生后重新进行校准和补偿。此外,现有的全补偿方法对于连续显示也是不适用的,因为它们需要先投影一些与投影内容无关的额外的帧进行投影校正和补偿,这显著中断了显示过程并降低了观察者的观看体验。随着信息技术和神经网路的发展,神经网络也被引入进行投影补偿问题的求解。虽然这些方法可以获取投影仪-相机图像的几何映射并消除底层纹理表面的影响,但网络训练需要很长的等待时间(通常超过十分钟)才能完成完全补偿,并且这些方法仍然需要投影几张纯色图像来计算投影表面的反射率。因此,全投影补偿问题仍然存在严峻挑战。

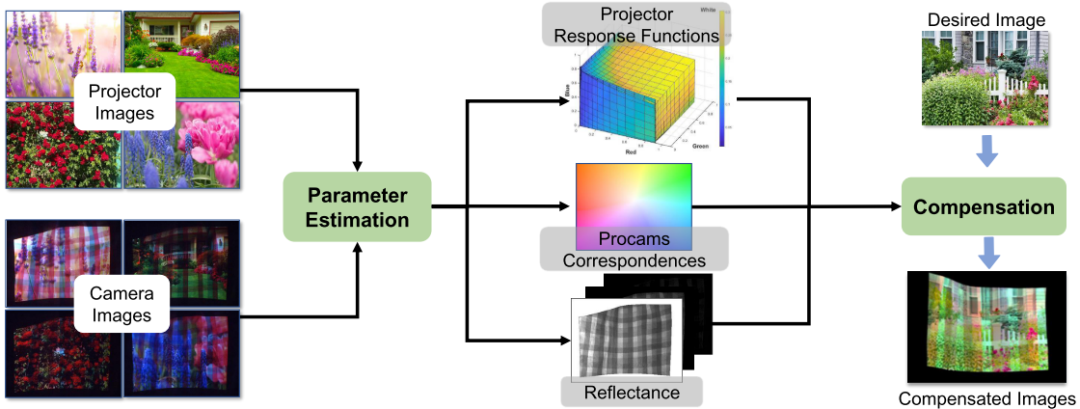

为了解决这些问题,本方法将全投影补偿作为一个统一的优化问题。与以前的方法不同,本方法有三个核心设计。首先是基于物理的全投影补偿方法,可以仅使用几张自然图像实现对投影表面几何失真的校正和颜色偏差的补偿。由于本方法是使用自然图像进行实验,所以可以选择放映电影或幻灯片中的关键帧内容进行投影补偿,提高了Procams使用的便利性。其次,本方法将Procams中影响图像质量的动静态因素进行解耦和分开建模,从而提高了本方法的可解释性和灵活性。对于静态的投影仪响应函数,本方法利用深度网络进行拟合求解;第三,对于动态变化的从投影仪图像到相机图像几何偏移量,本文提出了一种新的基于光流估计的几何校正方法进行求解,并通过正则化的矩阵分解优化方法来估计投影表面的反射率。

二、研究方法

本方法通过Procams捕获的投影仪-相机图像对进行模型训练,求解出投影仪响应函数、投影表面的反射率以及像素之间的几何偏移量,从而计算出每张输入图像对应的补偿图像,当投影补偿图像时达到视觉校正的效果。

全投影补偿任务的整体结构图

Procams中,投影表面上显示图像的物理模型可以表示为:

表示相机拍摄的图像中像素的RGB通道强度,表示相机RGB通道的光谱灵敏度函数(SSF),表示像素所在的投影表面的光谱反射率函数,表示与投影仪输入图像中像素p对应的处的光谱功率分布(SPD), 是人眼可见波长的范围,下标表示在波长处获得各函数值的采样操作。

在投影表面上显示图像的Procams的物理模型

由于投影表面的光是由投影仪的多个原色贡献的,因此每个像素的SPD可以被因式分解为每个原色的SPD与其贡献度的权重。函数用来表示从每个输入RGB通道强度到每个原色的加权值的传递函数,表示参数。假设投影仪有个原色,对于每个 RGB输入,函数可以将其映射到向量。将分解每个原色的光谱功率与权重的乘积,则公式可以转换为

若Procams系统的设备和投影表面确定下来并保持不变,则相机的SSF ,投影仪传递函数以及每个原色的SPD在显示过程中都是固定的。因此在投影显示期间的动态因素仅仅是投影图像和相机图像之间的位移以及光谱反射率。将$$ \int_{400nm}^{780nm} \mathbf{P}\lambda , \mathbf{R}\lambda(\mathbf{x}) \mathbf{S}^{r,g,b}_\lambda , d \lambda $$压缩到中:

其中表示观测图像中每个像素的强度矢量,表示一个的向量,表示一个的颜色混合矩阵。因此,在进行投影补偿之前,需要估计静态函数中的参数、投影仪和相机图像之间的空间偏移量以及从已知的投影图像和相机图像中求解色彩混合矩阵,则目标函数可以构造为:

其中表示L2范数,表示光照像素的集合,表示空间偏移量的先验,表示的核范数,表示权重。第一数据项计算了所有被照射像素的平方重构误差,但是该模型是一个待优化的不适定模型,因此引入和的正则化项以减少可能解的数目。但是很难获得中参数的隐式表达,因此为了求解该优化问题,在等式中引入了一个辅助变量,则目标函数可以转换为:

由于各个变量在物理上是相互独立的,因此,目标函数的求解可以转换为交替优化关于, , 和的四个子问题:

这四个子问题的求解需要经过多次迭代的交替优化才能得到所有参数的最优解。在每次迭代中,变量, , 和通过优化子问题来进行更新。的优化可以转换为最小二乘问题,应用梯度下降算法进行优化:

(1)投影仪响应函数

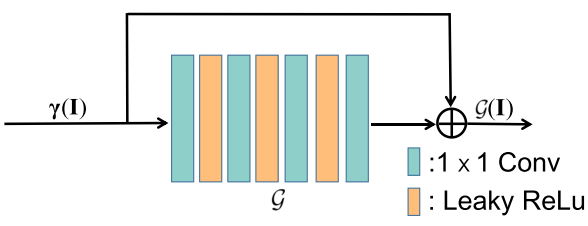

为了近似投影仪响应函数,本方法设计了一个卷积神经网络,将投影输入图像作为网络的输入,具有相同空间分辨率和个主通道数量的张量作为网络的输出,同时主通道的数量很容易从投影仪的产品规格中获得。

使用残差网络逼近的投影仪响应函数的网络结构

残差网络结构的使用可以仅用大致准确的初始化来训练网络,从而加快了网络中其他参数的优化。此外,跳跃连接层可以保证输入的RGB值在网络输出中占主导地位,因此可以粗略地确定输出的结果大小。同时网络输出的确定可以避免由于和的自由度过大导致的矩阵分解中没有意义的解的出现。为了防止神经网络中的梯度爆炸,将对网络的每一层进行谱归一化操作,这使得网络的优化更加稳定。与多尺度UNet结构相比,该网络消耗的存储器和计算资源较少,所以能够实现高效的参数估计和补偿。

(2)几何校正

几何校正是为了获得投影仪输入图像和相机拍摄图像之间的像素对应关系,可以根据估计的位移偏移量来进行求解。该等式与优化光流估计问题的目标函数是一致的。为了满足现有的光流方法的要求,在每次迭代时选择

和 中的前三个通道的最高强度作为光流的输入,则目标函数转换为:表示所选择的三个通道的索引,表示投影仪输入图像和相机拍摄图像之间的位移或密集流的先验。本文应用GMA作为深度光流估计方法。GMA是目前现有的最优的一种利用自注意力机制来实现对光流估计最有效和鲁棒的方法。

(3) 颜色补偿

随着相机或投影表面的移动,相机拍摄的图像中的每个像素的光谱反射率R也会跟着改变,因此是动态变化的。的变化直接反映的变化,因为Procams确定后,投影仪的原色P和相机的光谱灵敏度函数也随之确定。

对颜色混合矩阵的求解应用半二次分裂方法引入辅助变量,通过邻近梯度下降策略交替优化和。本文使用一种常见的软阈值算法对矩阵的奇异值施加稀疏约束以降低颜色混合矩阵的秩。则目标函数转换为:

其中表示权重值,则目标函数的求解转换为优化和。对于的优化可以使用梯度下降算法进行,对于的更新可以使用奇异值分解(SVD)软阈值方法:

其中表示梯度下降的步长,是矩阵H经过 SVD分解后得到的矩阵,表示软阈值操作,即$ soft(y_1,y_2) = max(y_1-y_2, 0) \fracy_1}{y_1|\sigma表示阈值参数,(\cdot)_+表示与激活函数的作用一致。这里\mathcal{U}和\mathcal{V}分别是大小为n \times 3m和3m \times 3m的矩阵。假设在应用低秩正则化后\hat{\mathbf{H}}的秩降为k(k<3m),那么\mathcal{U}和\mathcal{V}的最后3m-k$列变为零。因此,这里使用SVD方法不仅可以帮助降低矩阵的秩,而且可以将显示过程中的静态因素和动态因素分开。

(4) 补偿算法

一旦确定了各个子问题的优化算法,利用已知的估计参数, 和可以直接实现单张图片的补偿显示。首先将输入的补偿投影图像视为未知矩阵,然后使用固定点迭代算法对其进行优化。为了让网络训练具有更高的效率,本文用期望的图像来初始化,并且使用训练网络的前向模型来生成补偿图像:

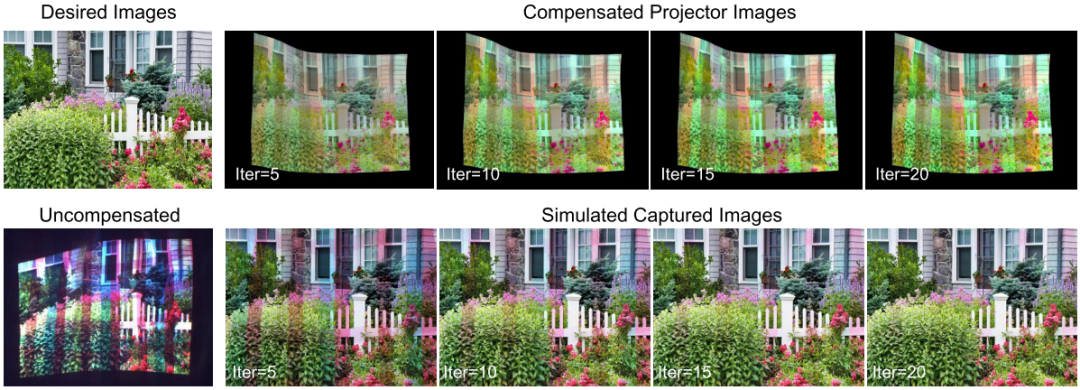

由于对模型应用了谱归一化,因此算法的收敛性得到了保证。根据收敛性分析,随着迭代次数的增加,模拟的补偿图像的颜色与期望的颜色变得更加接近。由于我们的网络只包含4个全连通层和数十个参数而且拥有较低的计算复杂度. 在GPU并行加速下,对600 × 800图像的每次迭代可以在1.1ms内完成。

三、实验结果

本方法在拍摄的投影仪-相机图像数据集上进行了实验,通过估计的, 和来生成模拟的观测图像,随着迭代次数的增加,模拟结果越来越接近期望的图像。同时,20次迭代的补偿可以在内完成。

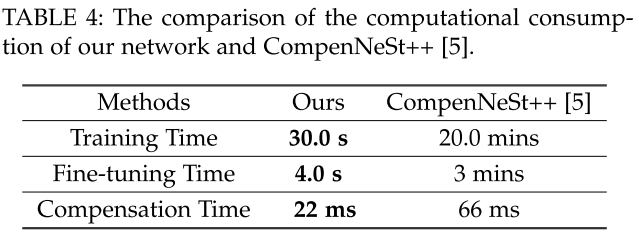

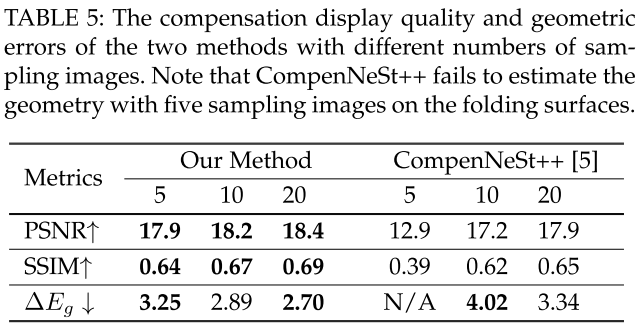

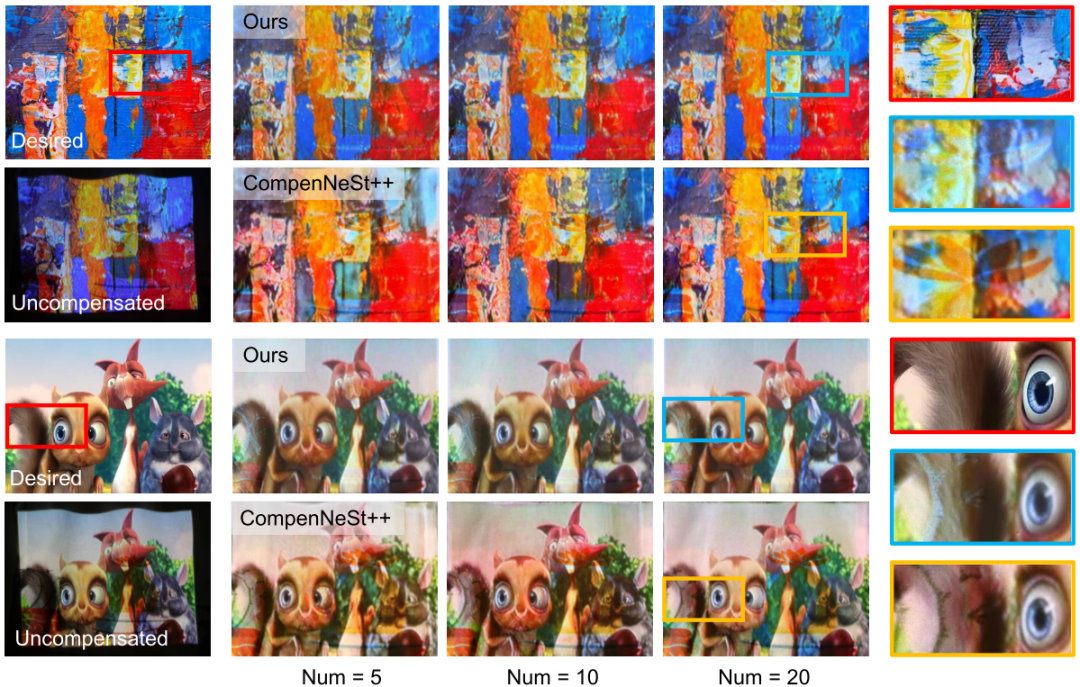

为了更好的说明本方法的高效性,本文的方法也与目前最优的全投影补偿方法进行了比较,在PSNR、SSIM和几何精度方面,我们的方法提供了比CompensNeSt++更好的补偿质量。几何精度采用平均几何重投影误差进行评估。同时也对两个方法的网络计算消耗了比较,与CompensNeSt++相比本方法具有更少的训练与补偿时间。图5中展示了两个方法的补偿效果可视化图,这两种方法都使用不同采样图像(Num=5、10、20)来训练。请注意我们仅使用5张采样图像进行网络训练的补偿结果优于CompensNeSt++使用20张采样图像进行训练的补偿结果。具体细节可参考原文。

四、结语

本文提出了一种基于物理的全投影补偿框架,用于补偿Procams在显示过程中产生的几何失真和颜色偏差。通过分析Procams的特点与投影-拍摄的自然图像对,本文将影响图像显示质量的动静态因素分开进行建模和求解,从而对于输入的新投影图像能快速生成对应的补偿图像。实验结果表明,本文的方法具有更高的几何估计精度,更好的补偿图像显示质量,以及更短的训练时间。

ICCV / CVPR 2023论文和代码下载

后台回复:CVPR2023,即可下载CVPR 2023论文和代码开源的论文合集

后台回复:ICCV2023,即可下载ICCV 2023论文和代码开源的论文合集目标检测和Transformer交流群成立

扫描下方二维码,或者添加微信:CVer333,即可添加CVer小助手微信,便可申请加入CVer-目标检测或者Transformer 微信交流群。另外其他垂直方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch、TensorFlow和Transformer、NeRF等。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测或者Transformer+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲扫码或加微信号: CVer333,进交流群

CVer计算机视觉(知识星球)来了!想要了解最新最快最好的CV/DL/AI论文速递、优质实战项目、AI行业前沿、从入门到精通学习教程等资料,欢迎扫描下方二维码,加入CVer计算机视觉,已汇集数千人!

▲扫码进星球

▲点击上方卡片,关注CVer公众号整理不易,请点赞和在看![]()