1.设计内容

根据新闻数据,建立一个模型来准确地将一条新闻分类为 REAL 或 FAKE。

2.数据集

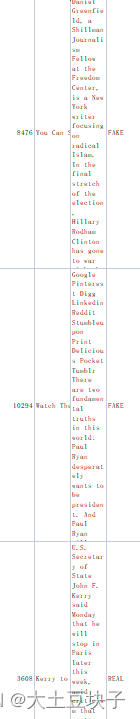

新闻数据集。该数据集的形状为 7796×4。第一列标识新闻,第二和第三列是标题和文本,第四列有标签,表示新闻是真实的还是假的

如图:

CSV(逗号分隔值)(Comma-Separated Values,CSV,有时也称为字符分隔值,因为分隔字符也可以不是逗号),其文件以纯文本形式存储表格数据(数字和文本)。纯文本意味着该文件是一个字符序列,不含必须像二进制数字那样被解读的数据。CSV文件由任意数目的记录组成,记录间以某种换行符分隔;每条记录由字段组成,字段间的分隔符是其它字符或字符串,最常见的是逗号或制表符。通常,所有记录都有完全相同的字段序列。通常都是纯文本文件。

3.设计要求:

(1)数据操作:

①使用数据集。获取数据的形状,并输出前五条数据。找出没有假新闻的文章和没有真新闻的文章(如果存在的话)。将数据集拆分为训练集和测试集。

②标签。根据新闻数据中的FAKE和REAL,对数据建立一个新的标签属性列。

③数据预处理。对句子进行分词,统计每个句子中的词频。根据分词和词频结果,以及标签建立训练数据。

(2)训练模型,训练两个模型用于假新闻检测。

(3)模型评估,在测试集上运行模型:

①输出混淆矩阵。

②计算精度、准确率、召回率。

模型原理

-

逻辑回归:通过给定的n组数据(训练集)来训练模型,并在训练结束后对给定的一组或多组数据(测试集)进行分类。其中每一组数据都是由p 个指标构成。将每个样本进行“打分”,然后设置一个阈值(概率),大于该阈值为一个类别,反之另一类别。

-

BernoulliNB 实现了用于多重伯努利分布数据的朴素贝叶斯训练和分类算法,即有多个特征,但每个特征 都假设是一个二元 (Bernoulli, boolean) 变量。 因此,这类算法要求样本以二元值特征向量表示;如果样本含有其他类型的数据, 一个 BernoulliNB 实例会将其二值化(取决于 binarize 参数)。

-

PassiveAggressiveClassifier体现出了一种在线学习(online learning)的思想。样本是否分类正确 模型预测的可能性(程度/概率)是否贴近实际。 Passive Aggressive Algorithms算法根据以上的判断准则优化自己的模型:在样本分类正确 且 模型对可能性的预测准确(程度大于一)时;模型不做调整(这里体现出了被动) 在样本分类正确 ;但 模型对可能性的预测有失偏颇(不太准确)时,模型做出轻微的调整 。

-

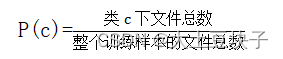

TF-IDF:自动提取关键词

TF-IDF(Term Frequency-InversDocument Frequency)是一种常用于信息处理和数据挖掘的加权技术。该技术采用一种统计方法,根据字词的在文本中出现的次数和在整个语料中出现的文档频率来计算一个字词在整个语料中的重要程度。它的优点是能过滤掉一些常见的却无关紧要本的词语,同时保留影响整个文本的重要字词。

一个词语在一篇文章中出现次数越多, 同时在所有文档中出现次数越少, 越能够代表该文章。

TF-IDF应用

(1)搜索引擎;(2)关键词提取;(3)文本相似性;(4)文本摘要

布袋模型

词袋是一篇文档中单词出现的文本表示,它包含两个信息:

-

一个已知单词构成的字典

-

一种已知单词出现的度量

扫描二维码关注公众号,回复: 14791073 查看本文章

它之所以称为词“袋”,是因为它只关心单词是否出现,而且关于文档中的单词的顺序和结构信息都忽略掉了。

概要设计

这个检测假新闻的python项目涉及假新闻和真新闻。

-

第一个模型使用用逻辑回归将分类问题转化为回归问题

-

第二个模型使用BernoulliNB实现了用于多重伯努利分布数据的朴素贝叶斯训练和分类算法,

为了更准确,初始化一个PassiveAggressiveClassifier(增量学习算法) 并拟合模型。

最后,精度分数和混淆矩阵告诉我们模型的表现如何。

其中,利用TF-IDF(一种用于信息检索与数据挖掘的常用加权技术)和词袋模型进行文本处理,以准确地将一条新闻分类为真实或虚假。

数据预处理

进行必要的导入

import numpy as np

import pandas as pd

import itertools

from sklearn.model_selection import train_test_split

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.linear_model import PassiveAggressiveClassifier

from sklearn.metrics import accuracy_score, confusion_matrix

from sklearn.linear_model import LogisticRegression

from sklearn.neighbors import NearestNeighbors`

将数据读入DataFrame,并获取数据和前 5 条记录的形状。

#Read the data

df=pd.read_csv('news.csv')

#Get shape and head

df.shape

df.head()

统计清除数据集中无用数据

df.isnull().sum()

从DataFrame中获取标签

#DataFlair - Get the labels

labels=df.label

labels.head()

将数据集拆分为训练集和测试集

#DataFlair - Split the dataset

x_train,x_test,y_train,y_test=train_test_split(df['text'], labels, test_size=0.2, random_state=7)

数据可视化

#Get shape and head

df.shape

df.head()

TF-IDF

#DataFlair - Initialize a TfidfVectorizer

tfidf_vectorizer=TfidfVectorizer(stop_words='english', max_df=0.7)

#DataFlair - Fit and transform train set, transform test set

tfidf_train=tfidf_vectorizer.fit_transform(x_train)

tfidf_test=tfidf_vectorizer.transform(x_test)

逻辑回归进行分类:

tfidf_vectorizer=TfidfVectorizer(stop_words='english', max_df=0.7)

train_word = tfidf_vectorizer.fit_transform(x_train)

test_word = tfidf_vectorizer.transform(x_test)

#输出每条评论的词频向量

print(train_word)

#print(test_word)

model = LogisticRegression()#逻辑回归

model.fit(train_word, y_train)

#验证是否预测正确

y_predict = model.predict(test_word)

#print('布尔比对:\n', y_predict == y_test)

accuracy_score(y_test, y_predict)

用词袋模型:

cv = CountVectorizer()

train_word = cv.fit_transform(x_train)

test_word = cv.transform(x_test)

#输出每条评论的词频向量

print(train_word)

#print(test_word)

BernoulliNB模型:

bnb_model = BernoulliNB()

# 02.训练模型

bnb_model = bnb_model.fit(train_word, y_train)

# 03.模型预测

Y_pred = bnb_model.predict(test_word)

# 04.模型评价(输出混淆矩阵;准确率;召回率;精度)

from sklearn.metrics import confusion_matrix

from sklearn import metrics

confusion_matrix =metrics.confusion_matrix(y_test,Y_pred) # 混淆矩阵(注意与上面示例的混淆矩阵的图位置并不一一对应)

tn, fp, fn, tp = metrics.confusion_matrix(y_test,Y_pred).ravel() # 混淆矩阵各值

混淆矩阵:

print(confusion_matrix) #混淆矩阵

精度:

ACC = metrics.accuracy_score(y_test,Y_pred)

准确率和召回率

precision = tp / (tp + fp)

recall=tp/(tp+fn)

4.模型设计思路

- 数据集给出新闻的[text,lable] 这两个指标,然后判断新闻真假。对于这个问题,我们可以先测量每条新闻的文本特征以及对应的指标真假,把真和假分别用0和1来表示,把这n组数据输入模型进行训练。训练之后再把待分类新闻文本特征的输入模型中,判断是否属于“真”还是“假”。

逻辑回归是用来进行分类的。

伯努利贝叶斯分类器(BernoulliNB),也就是二项分布,适用于离散特征

特征取值只能是0和1(如文本分类中某个词出现,特征为1;无,特征为0)。

最后再用 Passive Aggressive Algorithms算法根据判断准则优化以上的模型