定义

VC Dimension:全称是Vapnik-Chervonenkis dimension。其用来衡量一个模型的复杂度,定义为:在该模型对应的空间中随机撒x点,然后对其中的每个点随机分配一个2类标签,使用你的模型来分类,并且要分对,请问x至多是多少。这个x就是VC维。

例子

1.线性函数

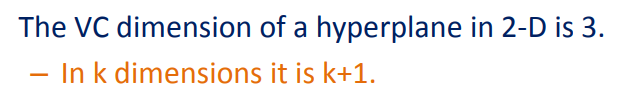

如果选用二维空间中的直线作为判别函数,该分类模型的VC维是多少?

答案:3

解释:如果是3个点,无论如何随机的打标签,都存在一条直线都可以将两类样本分开。

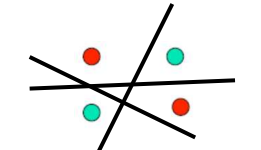

如果是4个点,就可能会出现一种标签序列,使得不存在一条直线将两类样本分开。如下图。

如果选用三维空间中的直线作为判别函数,该分类模型的VC维是多少?

答案:4

总结:

2.正弦函数

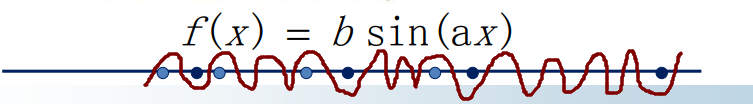

如果选用一维空间中的正弦函数作为判别函数,该分类模型的VC维是多少?

答案: ∞ \infty ∞

解释:我们总是可以调节相位和周期来使得对任意给定的样本点数量,任意的标签序列,将其分对。

比如调节b,a使得如下图,浅蓝色的点在函数的下面,深蓝色的点在函数上面。(画得不标准哈~~)。

3.最近邻模型

在任意空间使用最近邻分类器,该分类模型的VC维是多少?

答案: ∞ \infty ∞

解释:无论你给定多少个样本点,设为 q q q个,然后怎样地随机分配标签,设分配完毕后,正类有 m m m个,负类有 n n n个。我都可以设计一个如下分类器,将这些有标签的样本保存下来,正类标签样本集合为: x 1 , x 2 , . . . x m {x_1,x_2,...x_m} x1,x2,...xm,负类标签样本集合为: y 1 , y 2 . . . y n {y_1,y_2...y_n} y1,y2...yn,然后对这 q q q个样本进行分类,以 x i x_i xi为例,我们使用最近邻分类器,发现 x i x_i xi离我们保存的 x i x_i xi距离为0,那么判别其为正类。其他依次类推,总之,全部可以分对。

另外,作为补充,我们发现,如果将最近邻分类器变成K近邻分类器,VC维会降低,这个留给你做思考,很简单地~。

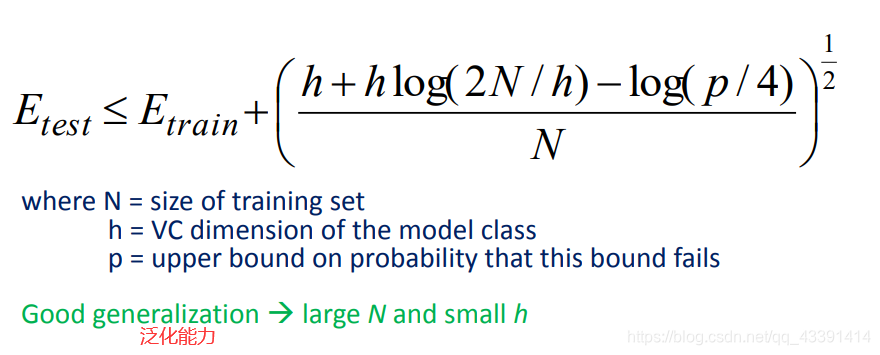

相关讨论