Single image depth estimation by dilated deep residual convolutional neural network and soft-weight-sum inference

论文在这儿

扩张卷积dilated convolution的理解

大体介绍

本篇论文通过均匀离散化log空间的深度值从而将深度估计看作是一个分类问题。本篇论文介绍了一个新的残差卷积神经网络来进行单张图像的深度评估。这个方法得益于扩张网络(dilated convolution),skip connection architecture,soft-weight-sum inference的使用,通过很少的训练样本和模型参数获得了很好的效果。

①神经网络结构

权重由预先训练的152层残差CNN(Kaiming He, Xiangyu Zhang, Shaoqing Ren, and Jian

Sun, “Deep residual learning for image recognition,” in CVPR, 2016, pp. 770–778)初始化。

- 去除所有的全连接层以减少模型参数

- 使用扩张网络,在不增加参数的情况下扩大神经元的感受野(the receptive field of the neuron),保持特征图(the feature map)的空间分辨率

- 将中间特征映射(feature map)与最终特征映射直接连接。The skip connection design有利于多尺度特征融合和边界保持

(1)Dilated Convolution:

(2)Skip Connection:

由于CNN具有层次结构,意味着高水平神经元(high level neurons)具有更大的感受野和更抽象的特征,而低水平神经元具有更小的感受野和更多的边界信息。我们提出将高层次特征映射和中间特征映射连接起来。跳跃连接结构有利于多尺度融合和边界保持。

② SOFT-WEIGHT-SUM INFERENCE

我们通过均匀离散化log空间的深度值从而将深度估计看作是一个分类问题。我们采用多项式逻辑损失函数训练我们的网络结构:

其中,N表示训练样本的数目。k是样本n对应的标签,m是bins的数目。

(a)预测得分分布(predicted score distribution),非零分集中分布

(b)the confusion matrix on the test set, which present a kind of diagonal dominant structure(对角)

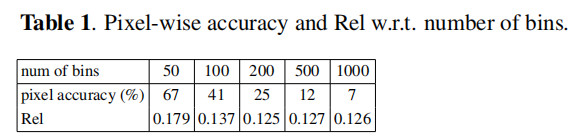

不同数量的discretization bins关于the pixel-wise accuracy and Relative error (Rel)的结果:

受实验结果的启发,我们提出了the soft-weight-sum inference.该方法将预测得分(the predicted score)自然地转化为连续的深度值。

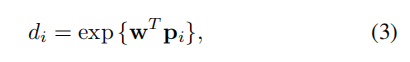

其中,w是depth bins的权重向量。p_i是样本i的输出成绩。在本篇论文的实验中,我们将bins的数量设置为200。

实验结果: