Ein großes Modell (LLM) ist ein Modell der künstlichen Intelligenz, das darauf ausgelegt ist, menschliche Sprache zu verstehen und zu generieren. Sie sind auf große Textdatenmengen geschult und können ein breites Spektrum an Aufgaben ausführen, darunter Textzusammenfassung, Übersetzung, Stimmungsanalyse und mehr. LLMs zeichnen sich durch ihren großen Umfang aus, der Milliarden von Parametern enthält und ihnen hilft, komplexe Muster in linguistischen Daten zu lernen. Diese Modelle basieren häufig auf Deep-Learning-Architekturen wie Transformern, wodurch sie bei einer Vielzahl von NLP-Aufgaben eine beeindruckende Leistung erzielen können.

Ende 2022 startete OpenAI ChatGPT, ein groß angelegtes Sprachmodell auf Basis von GPT-3.5. Aufgrund seiner hervorragenden Leistung wurden ChatGPT und das dahinter stehende groß angelegte Sprachmodell schnell zu einem heißen Thema im Bereich der künstlichen Intelligenz. Die Aufmerksamkeit und Aufmerksamkeit einer großen Anzahl wissenschaftlicher Forscher und Entwickler auf sich ziehen. Mitmachen.

Diese Woche wurden 10 herausragende Arbeiten im Bereich LLM ausgewählt. Um die Lektüre für alle zu erleichtern, werden nur der Papiertitel, der Autor, die AMiner AI-Rezension und andere Informationen aufgeführt. Bei Interesse können Sie den QR-Code scannen Sehen Sie sich den Originaltext an und die PC-Daten werden synchronisiert (um sie zu sammeln, können Sie sie auf Ihrem PC speichern. Über das Terminal anzeigen). Täglich neue Zeitungen können auch angezeigt werden, indem Sie sich in das Miniprogramm einloggen.

1. Machen Sie Ihr LLM nicht zu einem Bewertungs-Benchmark-Betrüger

In diesem Artikel werden die potenziellen Risiken und Auswirkungen einer unangemessenen Verwendung von Bewertungsmaßstäben und einer irreführenden Interpretation von Bewertungsergebnissen in groß angelegten Sprachmodellen (LLMs) erörtert. Die Autoren konzentrieren sich insbesondere auf ein bestimmtes Problem, das zu unangemessenen Bewertungen führen kann, nämlich den „Benchmark Leakage“, der sich auf mit dem Bewertungssatz verbundene Daten bezieht, die gelegentlich für das Modelltraining verwendet werden. Dieses Phänomen tritt immer häufiger auf, da Pre-Training-Daten normalerweise vor Modelltests vorbereitet werden. Die Autoren führten umfangreiche Experimente durch, um die Auswirkungen der Benchmark-Nutzung zu untersuchen, und stellten fest, dass dadurch die Bewertungsergebnisse erheblich verbessert werden können, was letztendlich zu einer unzuverlässigen Bewertung der Modellleistung führt. Um die Nutzung vorhandener Evaluierungsbenchmarks zu verbessern, schlagen die Autoren abschließend mehrere Richtlinien für LLM-Entwickler und Benchmark-Betreuer vor. Die Autoren hoffen, dass diese Arbeit die Aufmerksamkeit auf eine angemessene Ausbildung und Bewertung von LLMs lenken wird.

Link:https://www.aminer.cn/pub/65484c09939a5f4082af623d/?f=cs

2. Ziya2: Datenzentriertes Lernen ist alles, was LLMs brauchen

In diesem Artikel wird ein großes Sprachmodell (LLM) namens Ziya2 vorgestellt, das LLaMA2 als Basismodell verwendet und auf 70 Milliarden Token weiter vorab trainiert ist. Die Forschung konzentriert sich auf Techniken vor dem Training und die Optimierung von Rechenzentren, um den Lernprozess von Ziya2 in verschiedenen Phasen zu verbessern. Experimentelle Ergebnisse zeigen, dass Ziya2 andere Modelle in mehreren Benchmarks deutlich übertrifft, insbesondere mit ermutigenden Ergebnissen im Vergleich zu repräsentativen Open-Source-Modellen.

Link:https://www.aminer.cn/pub/65499deb939a5f4082bebeea/?f=cs

3. LCM-LoRA: Ein universelles Beschleunigungsmodul mit stabiler Diffusion

In diesem Artikel wird ein universelles stabiles Diffusionsbeschleunigungsmodul namens LCM-LoRA vorgestellt. Latent Consistency Models (LCMs) haben bemerkenswerte Ergebnisse bei der Beschleunigung von Text-zu-Bild-Generierungsaufgaben erzielt und qualitativ hochwertige Bilder mit minimalen Inferenzschritten erzeugt. LCMs werden aus vorab trainierten latenten Diffusionsmodellen (LDMs) extrahiert und erfordern nur etwa 32 Trainingsstunden für A100-GPUs. Dieser Bericht erweitert das Potenzial von LCMs in zwei Aspekten: Erstens erweitern wir durch die Anwendung der LoRa-Destillation auf stabile Diffusionsmodelle, einschließlich SD-V1.5, SSD-1B und SDXL, den Anwendungsbereich von LCMs und machen das Modell zu einem geringeren Speicherverbrauch. Erzielung einer besseren Bilderzeugungsqualität. Zweitens identifizieren wir die durch LCM-Destillation erhaltenen LoRa-Parameter als ein allgemein stabiles Diffusionsbeschleunigungsmodul namens LCM-LoRA. LCM-LoRA kann ohne Schulung direkt in eine Vielzahl fein abgestimmter stabiler Diffusionsmodelle (LoRAs) eingebunden werden, was es zu einem vielseitigen Beschleuniger macht, der für eine Vielzahl von Bilderzeugungsaufgaben geeignet ist. Im Vergleich zu früheren numerischen PF-ODE-Lösern (wie DDIM, DPM-Solver) kann LCM-LoRA als Plug-in-neuronaler PF-ODE-Löser mit starken Generalisierungsfähigkeiten betrachtet werden.

Projektseite: https://github.com/luosiallen/latent-consistency-model.

Link:https://www.aminer.cn/pub/654d9745939a5f40826b39ed/?f=cs

4. LRM: Großes Rekonstruktionsmodell für Einzelbild zu 3D

In diesem Artikel wird eine Methode namens LRM (Large Reconstruction Model) vorgestellt, mit der das 3D-Modell eines Objekts aus einem einzelnen Eingabebild in nur 5 Sekunden vorhergesagt werden kann. Im Gegensatz zu früheren Methoden, die typischerweise auf kleinen Datensätzen (wie ShapeNet) und auf klassenspezifische Weise trainiert werden, verwendet LRM eine skalierbare transformatorbasierte Architektur mit 500 Millionen lernbaren Parametern. , neuronale Strahlungsfelder (NeRF) direkt aus Eingabebildern vorherzusagen . Die Autoren trainieren das Modell durchgängig anhand einer großen Menge an Multi-View-Daten mit etwa 1 Million Objekten, darunter synthetische Renderings von Objaverse und echte Erfassungen von MVImgNet. Diese Kombination aus Hochleistungsmodellen und umfangreichen Trainingsdaten ermöglicht eine starke Verallgemeinerung unserer Modelle und die Erstellung hochwertiger 3D-Rekonstruktionen aus einer Vielzahl von Testeingaben, einschließlich realer Feldaufnahmen und vom Modell generierter Bilder. Eine Videodemonstration und ein interaktives 3D-Netz finden Sie unter: https://yiconghong.me/LRM/.

Link:https://www.aminer.cn/pub/654c4abd939a5f4082b35938/?f=cs

5. GLaMM: Pixel Grounding Large Multimodal Model

In diesem Artikel wird GLaMM vorgestellt: das erste groß angelegte multimodale Modell auf Pixelebene. Multimodale Modelle (LMMs) erweitern große Sprachmodelle auf den visuellen Bereich. In früheren Studien wurden ganze Bilder und Texthinweise verwendet, um unbegründete Textantworten zu generieren, während in neueren Studien LMMs auf Regionsebene verwendet wurden, um visuell begründete Antworten zu generieren. Sie können jedoch jeweils nur eine Objektkategorie angeben und erfordern, dass der Benutzer die Region angibt oder es kann keine dichte Objekterdung auf Pixelebene bieten. In diesem Artikel stellen die Autoren das erste Modell vor, das Antworten in natürlicher Sprache erzeugen kann, die nahtlos mit entsprechenden Objektsegmentierungsmasken verknüpft sind – GLaMM. GLaMM kann nicht nur Objekte, die in Gesprächen auftauchen, erden, sondern ist auch flexibel genug, um Text und optionale visuelle Hinweise (Regionen von Interesse) als Eingabe zu akzeptieren. Dies ermöglicht Benutzern die Interaktion mit dem Modell in unterschiedlicher Granularität in Text- und visuellen Bereichen. Aufgrund des Fehlens standardisierter Benchmarks für die Generierung visuell fundierter Detaildialoge führen die Autoren ein umfassendes Bewertungsprotokoll und sorgfältig kuratierte fundierte Dialoge ein. Die von den Autoren vorgeschlagene Grounded Conversation Generation (GCG)-Aufgabe erfordert groß angelegte, dicht geerdete Naturszenenkonzepte. Zu diesem Zweck schlagen wir unter Verwendung unserer vorgeschlagenen automatisierten Annotationspipeline einen dicht annotierten Grounding-anything-Datensatz (GranD) vor, der 7,5 Millionen einzigartige Konzepte enthält, die auf insgesamt 810 Millionen Regionen mit Segmentierungsmasken basieren. Zusätzlich zu GCG schneidet GLaMM auch bei nachgelagerten Aufgaben wie der Segmentierung referenzieller Ausdrücke, der Beschreibung auf Bild- und Regionsebene und dem visuellen Sprachdialog gut ab. Projektseite: https://mbzuai-oryx.github.io/groundingLMM.

Link:https://www.aminer.cn/pub/65499e11939a5f4082beca5d/?f=cs

6. CogVLM: Visueller Experte für vorab trainierte Sprachmodelle

In diesem Artikel wird CogVLM vorgestellt, ein leistungsstarkes Open-Source-Grundlagenmodell für visuelle Sprache. Im Gegensatz zu gängigen flachen Ausrichtungsmethoden schließt CogVLM die Lücke zwischen vorab trainierten Sprachmodellen und Bildkodierern durch trainierbare visuelle Expertenmodule in den Aufmerksamkeits- und FFN-Schichten. Daher ist CogVLM in der Lage, eine tiefe Verschmelzung visueller Sprachfunktionen zu erreichen, ohne die Leistung von NLP-Aufgaben zu beeinträchtigen. CogVLM-17B erreicht Spitzenleistungen bei 10 klassischen modalübergreifenden Benchmarks, darunter NoCaps, Flicker30k captioning, RefCOCO, RefCOCO+, RefCOCOg, Visual7W, GQA, ScienceQA, VizWiz VQA und TDIUC sowie bei VQAv2, OKVQA und Ranked Zweiter in TextVQA, COCO-Untertitelung und anderen Aufgaben, über oder vergleichbar mit PaLI-X 55B.

Link:https://www.aminer.cn/pub/65260ee8cd549670787e1513/?f=cs

7. Ebenen der AGI: Operationalisierung des Fortschritts auf dem Weg zur AGI

In diesem Artikel wird eine Methode zur Klassifizierung der Fähigkeiten und Verhaltensweisen von Modellen der künstlichen allgemeinen Intelligenz (AGI) und ihrer Vorläufer vorgeschlagen. Dieses Framework schlägt eine Hierarchie der AGI-Leistung, Allgegenwärtigkeit und Autonomie vor. Die Autoren hoffen, dass dieser Rahmen ebenso nützlich sein wird wie die Stufen des autonomen Fahrens und eine gemeinsame Sprache für den Vergleich von Modellen, die Bewertung von Risiken und die Messung des Fortschritts auf dem Weg zu AGI bietet. Bei der Entwicklung dieses Frameworks analysierten die Autoren bestehende AGI-Definitionen und extrahierten sechs Prinzipien, die eine nützliche AGI-Ontologie erfüllen sollte. Zu diesen Grundsätzen gehören die Fokussierung auf Fähigkeiten statt auf Mechanismen, die getrennte Bewertung von Generalisierbarkeit und Leistung sowie die Definition von Phasen auf dem Weg zur AGI, anstatt sich auf den Endpunkt zu konzentrieren. Basierend auf diesen Prinzipien schlägt der Autor ein „AGI-Level“ vor, das auf der Fähigkeitstiefe (Leistung) und der Breite (Universalität) basiert, und überlegt, wie aktuelle Systeme in diese Ontologie passen. Sie diskutieren anspruchsvolle Anforderungen für zukünftige Benchmarks, die das Verhalten und die Fähigkeiten von AGI-Modellen im Vergleich zu diesen Ebenen quantitativ messen. Abschließend diskutieren sie, wie diese AGI-Ebenen mit Einsatzüberlegungen wie Autonomie und Risiko interagieren, und betonen die Bedeutung der Auswahl eines Mensch-Computer-Interaktionsparadigmas für den verantwortungsvollen und sicheren Einsatz hochleistungsfähiger KI-Systeme.

Link:https://www.aminer.cn/pub/65499d88939a5f4082be9a34/?f=cs

8. mPLUG-Owl2: Revolutionierung des multimodalen großen Sprachmodells mit Modalitätskooperation

In diesem Artikel wird ein multimodales, groß angelegtes Sprachmodell namens mPLUG-Owl2 vorgestellt, das die Leistung von Text und multimodalen Aufgaben durch die Nutzung modaler Zusammenarbeit verbessert. mPLUG-Owl2 verfügt über ein modulares Netzwerkdesign und der Sprachdecoder dient als universelle Schnittstelle zur Verwaltung verschiedener Modalitäten. Insbesondere führt mPLUG-Owl2 gemeinsame Funktionsmodule ein, um die Modalitätszusammenarbeit zu fördern, und Modalitätsanpassungsmodule, um modalitätsspezifische Funktionen zu bewahren. Experimentelle Ergebnisse zeigen, dass mPLUG-Owl2 in der Lage ist, Textaufgaben und multimodale Aufgaben zu verallgemeinern und mithilfe eines einzigen allgemeinen Modells eine Leistung auf dem neuesten Stand der Technik zu erzielen. Es ist erwähnenswert, dass mPLUG-Owl2 das erste multimodale groß angelegte Sprachmodell ist, das modale Kollaborationsphänomene sowohl im Klartext als auch in multimodalen Szenen zeigt und einen neuen Weg für die Entwicklung zukünftiger multimodaler Grundmodelle eröffnet. .

Verbindung:https://www.aminer.cn/pub/654c4abd939a5f4082b35909/?f=cs

9. LLaVA-Plus: Lernen, Tools zum Erstellen multimodaler Agenten zu verwenden

In diesem Artikel wird ein zweisprachiges Basismodell namens Skywork-13B vorgestellt, das auf 3,2 Billionen Token aus englischem und chinesischem Text trainiert wird. Dies ist das größte und am besten trainierte zweisprachige Basismodell unter den bisher veröffentlichten groß angelegten Sprachmodellen. Der Artikel stellt eine zweistufige Trainingsmethode vor, die auf allgemeines Training und domänenspezifisches erweitertes Training abzielt. Untersuchungen zeigen, dass das Modell nicht nur bei beliebten Benchmarks gut abschneidet, sondern auch in verschiedenen Bereichen den neuesten Stand der chinesischen Sprachmodellierung erreicht. Darüber hinaus schlägt der Artikel eine neuartige Methode zur Leckerkennung vor, was darauf hinweist, dass die Kontamination von Testdaten ein dringendes Problem ist, das einer weiteren Forschung durch die LLM-Community bedarf. Um die zukünftige Forschung voranzutreiben, veröffentlichen die Autoren auch Skywork-13B sowie Kontrollpunkte der Zwischenstufe, die während des Trainings gewonnen wurden. Gleichzeitig veröffentlichte der Autor auch einen Teil des SkyPile-Korpus, einem Satz von mehr als 150 Milliarden Webseiten-Text-Tags und dem bisher größten hochwertigen offenen chinesischen Pre-Training-Korpus. Der Autor hofft, dass Skywork-13B und das offene Korpus zu wertvollen Open-Source-Ressourcen werden können, damit mehr Menschen Zugang zu hochwertigen Sprachmodellen haben.

Link:https://www.aminer.cn/pub/654d96ff939a5f40826adf41/?f=cs

10. TEAL: Tokenisieren und betten Sie ALLE für multimodale große Sprachmodelle ein

In diesem Artikel wird eine Methode namens TEAL (Tokenize and Embed ALL) zur Verarbeitung von Eingaben und zur Generierung von Nicht-Text-Modalitäten in multimodalen großen Sprachmodellen (MM-LLMs) vorgestellt. TEAL behandelt die Eingabe einer beliebigen Modalität als eine Folge von Token und lernt einen gemeinsamen Einbettungsraum für alle Modalitäten. Konkret verwendet TEAL zunächst einen vorhandenen Tagger, um die Eingabe einer beliebigen Modalität in eine Tag-Sequenz zu diskretisieren, und verwendet dann eine lernbare Einbettungsmatrix, um die Tag-Sequenz in einen gemeinsamen Einbettungsraum einzubetten. MM-LLMs müssen nur multimodale Markierungen nacheinander vorhersagen, genau wie Text-LLMs. Schließlich wird der entsprechende De-Labeler angewendet, um die Ausgabe jeder Modalität basierend auf der vorhergesagten Label-Sequenz zu generieren. Durch die gemeinsame Einbettung des Raums ermöglicht TEAL eingefrorenen LLMs die Durchführung von Verständnis- und Generierungsaufgaben mit Nicht-Text-Modalitäten wie Bildern und Audio. Daher kann Text-LLM nur als Schnittstelle dienen und eine hohe Leistung in Bezug auf Textverständnis und -generierung aufrechterhalten. Experimente zeigen, dass TEAL erhebliche Verbesserungen beim multimodalen Verständnis erzielt und ein einfaches multimodales Generierungsschema implementiert.

Link:https://www.aminer.cn/pub/654c4abd939a5f4082b35985/?f=cs

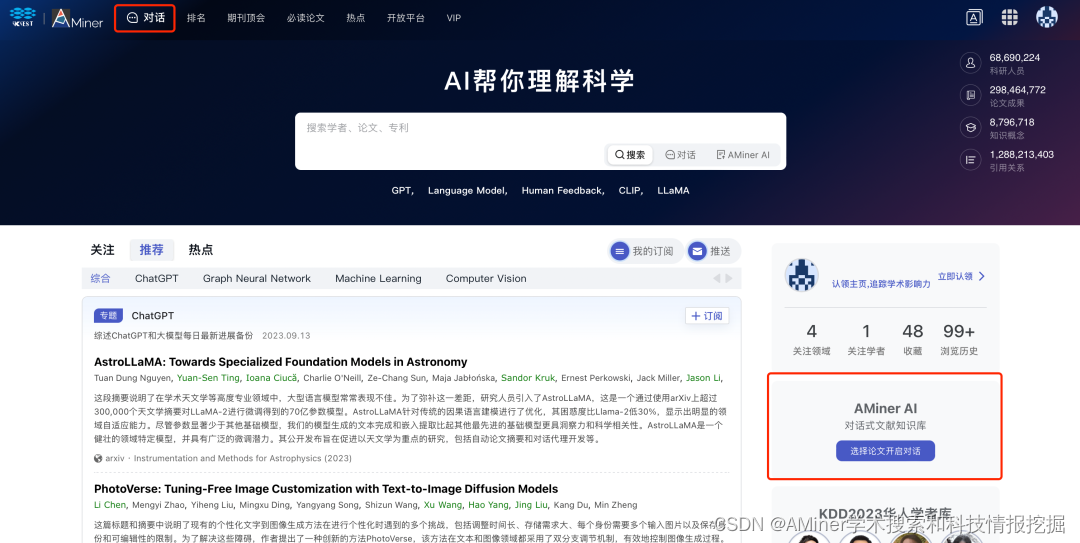

Wie verwende ich AMiner AI?

Die Verwendung von AMiner AI ist sehr einfach. Öffnen Sie die AMiner-Homepage und rufen Sie die AMiner AI-Seite über die Navigationsleiste oben auf der Seite oder in der unteren rechten Ecke auf.

Auf der AMiner AI-Seite können Sie wählen, ob Sie eine Konversation basierend auf einem einzelnen Dokument oder eine Konversation basierend auf der gesamten Datenbank (persönliche Dokumentendatenbank) führen möchten. Sie können wählen, ob Sie ein lokales PDF hochladen oder direkt auf AMiner nach Dokumenten suchen möchten.

AMiner AI-Informationen:https://www.aminer.cn/chat/g/explain