Muitas vezes encontramos a palavra otimização de desempenho em trabalhos iniciais ou entrevistas, parece que isso não é difícil de dizer, afinal todos podem falar sobre isso. Mas se você deseja ter uma solução direta de desempenho ao encontrar gargalos de desempenho em vários cenários no trabalho, ou para impressionar o entrevistador durante uma entrevista, então você não pode simplesmente se limitar a “diga o que vier à mente” ou “Para dar uma ideia aproximada”. ideia, precisamos ter um mapa de conhecimento sistemático e aprofundado de todos os ângulos. Este artigo também pode ser considerado um resumo do meu conhecimento pessoal de front-end, porque “otimização de desempenho” não é apenas “otimização”, o que significa? Antes de implementar um plano de otimização, você deve primeiro saber por que precisa otimizar dessa forma e qual é o propósito de fazê-lo. Isso requer que você tenha um bom entendimento dos princípios de framework, js, css, navegador, mecanismo js, rede, etc. Portanto, a otimização de desempenho realmente cobre muito conhecimento de front-end, até mesmo a maior parte do conhecimento de front-end.

Primeiro, vamos falar sobre a essência do desempenho do front-end. O front-end é um aplicativo de rede. O desempenho do aplicativo é determinado pela sua eficiência operacional. Se adicionarmos a rede antes, isso está relacionado à eficiência da rede. Portanto, acho que a essência do desempenho front-end é o desempenho da rede e o desempenho operacional. Portanto, as duas categorias principais no sistema de otimização de desempenho front-end são: rede e tempo de execução, e então subdividimos cada pequena área desses dois temas principais, o que é suficiente para tecer um enorme gráfico de conhecimento front-end.

nível de rede

Se compararmos a conexão de rede a um cano de água, se você quiser abrir uma página agora, pode ser visto como se tivesse um copo d’água na mão da outra pessoa, e você deseja conectar a água ao seu copo. Se quiser ir mais rápido, existem três maneiras: 1. Fazer com que o fluxo do cano de água seja maior e mais rápido; 2. Deixar o outro lado reduzir a água do copo; 3. Tenho água no copo e não preciso do seu. O tráfego da tubulação de água é a largura de banda da rede, a otimização do protocolo e outros fatores que afetam a velocidade da rede; quando um copo de água diminui, significa compactação, divisão de código, carregamento lento e outros meios para reduzir solicitações; o último é usar o cache.

Vamos falar primeiro sobre a velocidade da rede. A velocidade da rede não é determinada apenas pela operadora do usuário, mas também pela familiarização com os princípios dos protocolos de rede e pelo ajuste dos protocolos de rede para otimizar sua eficiência.

A rede de computadores é teoricamente um modelo OSI de sete camadas, mas na prática pode ser vista como cinco camadas (ou modelo de quatro camadas), nomeadamente a camada física, a camada de enlace de dados, a camada de rede, a camada de transporte e a camada de aplicação. Cada camada é responsável por encapsular, desmontar e analisar seus próprios protocolos e executar suas próprias tarefas. Por exemplo, é como se a empregada do palácio vestisse e despisse o imperador camada por camada: você é responsável pelo casaco e eu pela roupa íntima, cada um desempenhando suas funções. Como front-end, focamos principalmente na camada de aplicação e na camada de transporte, começando com o protocolo HTTP da camada de aplicação com o qual lidamos todos os dias.

Otimização do protocolo http

1. Em HTTP/1.1, é necessário evitar atingir o limite máximo simultâneo de solicitações do navegador para o mesmo nome de domínio (geralmente 6 para Chrome)

- Quando há um grande número de solicitações de recursos de página, você pode preparar vários nomes de domínio e usar diferentes solicitações de nomes de domínio para ignorar o limite máximo de simultaneidade.

- Vários ícones pequenos podem ser mesclados em uma imagem grande, de modo que vários recursos de imagem exijam apenas uma solicitação. O front-end exibe os ícones correspondentes (também chamados de imagens sprite) por meio do estilo CSS de posição de fundo.

2. Reduza o tamanho do cabeçalho HTTP

- Por exemplo, solicitações do mesmo domínio carregarão automaticamente cookies, o que é um desperdício se não for necessária autenticação. Este tipo de recurso não deve estar no mesmo domínio do site.

3. Faça uso total do cache HTTP. O cache pode eliminar solicitações diretamente e melhorar significativamente o desempenho da rede.

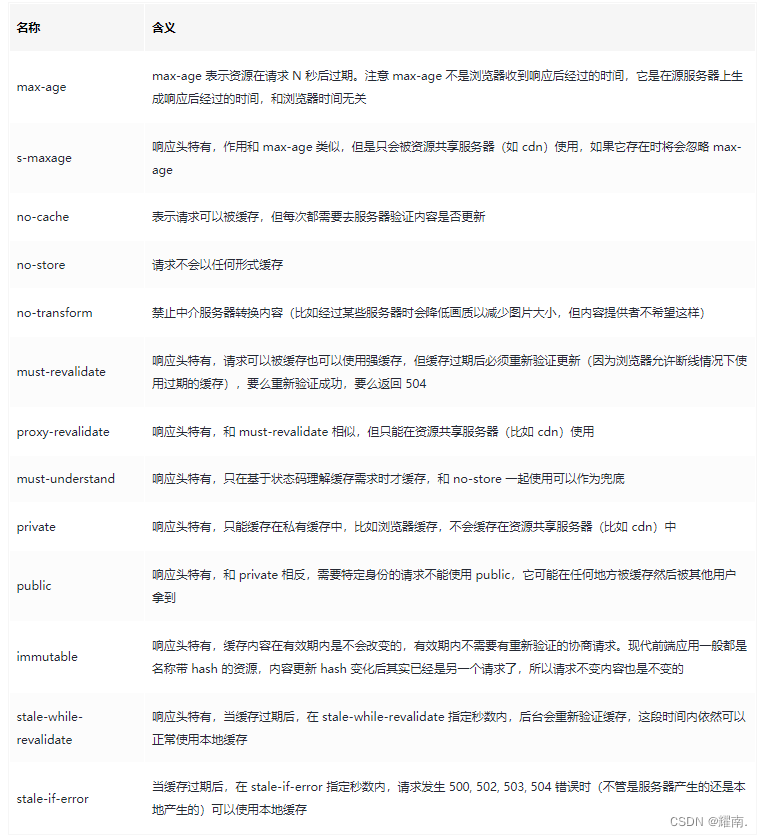

- Os navegadores podem usar valores de cabeçalho HTTP, como no-cache e max-stale de controle de cache, para controlar se devem usar cache forte, negociar cache e se a expiração do cache ainda está disponível e outras funções.

- O servidor usa valores de cabeçalho http, como max-age, public, stale-while-revalidate de cache-control para controlar o tempo de cache forte, se ele pode ser armazenado em cache pelo servidor proxy, por quanto tempo o cache expira e como tempo que leva para atualizar automaticamente o cache.

4. A atualização para HTTP/2.0 ou superior pode melhorar significativamente o desempenho da rede. (Deve usar TLS, ou seja, https)

5. Otimize HTTPS

Existem dois aspectos principais que consomem muito desempenho do HTTPS:

- A primeira etapa é o processo de handshake do protocolo TLS;

- A segunda etapa é a transmissão de mensagens criptografadas simetricamente após o handshake.

Para a segunda etapa, os atuais algoritmos de criptografia simétrica convencionais AES e ChaCha20 têm bom desempenho, e alguns fabricantes de CPU também fizeram otimizações no nível de hardware para eles, portanto, o consumo de desempenho de criptografia nesta etapa pode ser considerado muito pequeno.

Na primeira etapa, o processo de handshake do protocolo TLS não apenas aumenta o atraso da rede (pode levar até 2 tempos de ida e volta da rede RTT), mas algumas etapas do processo de handshake também causarão perdas de desempenho, como:

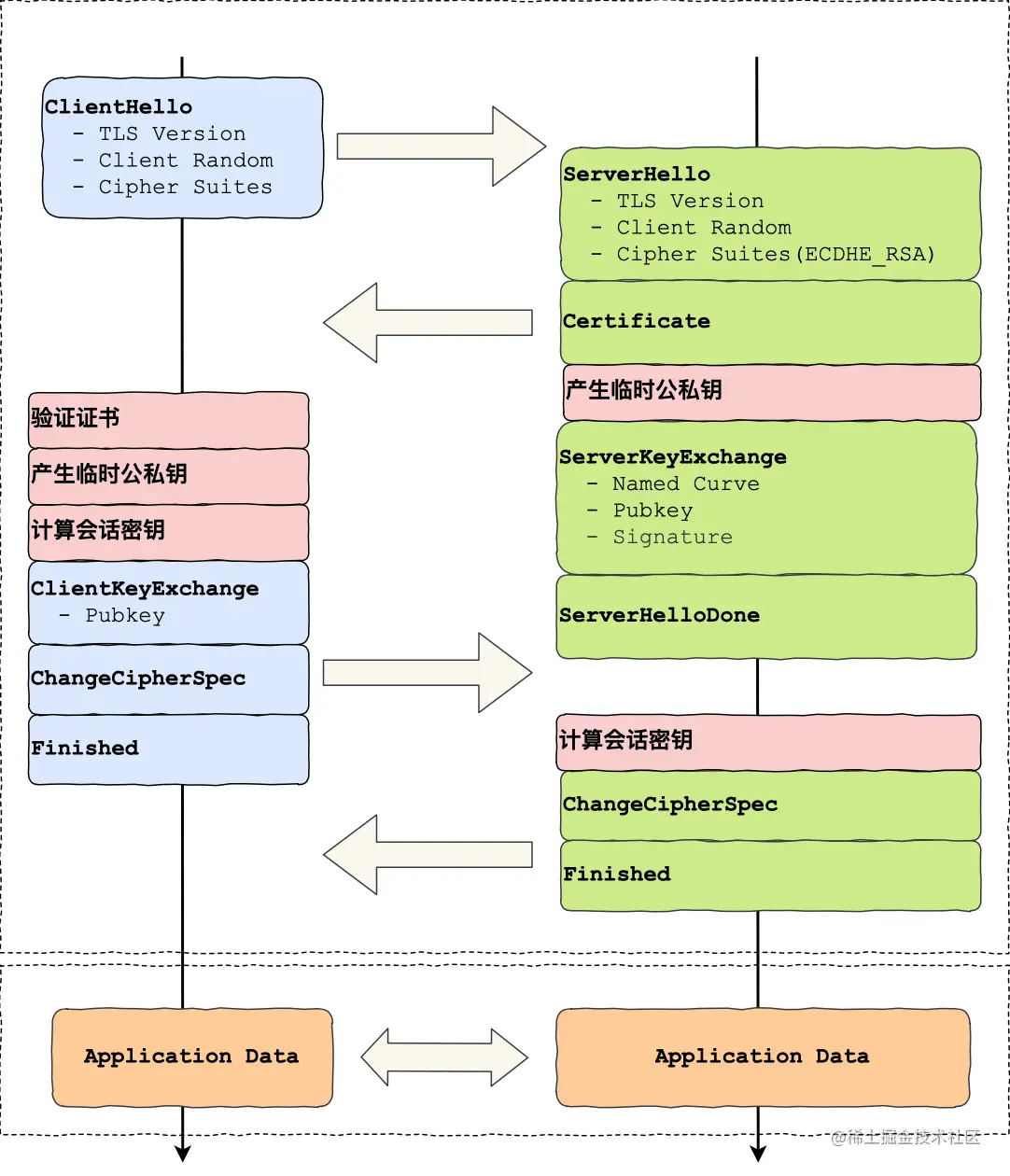

Se o algoritmo de acordo de chave ECDHE for usado, tanto o cliente quanto o servidor precisarão gerar temporariamente chaves públicas e privadas de curva elíptica durante o processo de handshake; quando o cliente verificar o certificado, ele acessará o servidor CA para obter a CRL ou OCSP em para verificar se o certificado do servidor foi revogado; Em seguida, ambas as partes calculam o Pré-Mestre, que é a chave de criptografia simétrica. Para entender melhor em qual estágio de todo o handshake do protocolo TLS estão essas etapas, você pode consultar esta imagem:

HTTPS pode ser otimizado usando os seguintes meios:

- Otimização de hardware: O servidor usa uma CPU que suporta o conjunto de instruções AES-NI

- Otimização de software: atualize a versão Linux e a versão TLS. O TLS/1.3 otimizou bastante o número de handshakes, exigindo apenas 1 tempo RTT, e oferece suporte à segurança de encaminhamento (o que significa que se a chave for quebrada agora ou no futuro, isso não afetará a segurança das mensagens interceptadas anteriormente).

- Otimização de certificado: grampeamento OCSP. Em circunstâncias normais, o navegador precisa verificar com a CA se o certificado foi revogado, e o servidor pode consultar periodicamente a CA para obter o status do certificado, obter um resultado de resposta com carimbo de data e hora e assinatura e armazená-lo em cache. Quando um cliente inicia uma solicitação de conexão, o servidor envia diretamente o "resultado da resposta" ao navegador durante o processo de handshake TLS, para que o próprio navegador não precise solicitar a CA.

- Reutilização de sessão 1: ID da sessão. Ambas as partes retêm a sessão na memória. Na próxima vez que uma conexão for estabelecida, a mensagem de saudação carregará o ID da sessão. Depois que o servidor a receber, ele a pesquisará na memória. Se encontrá-la , ele usará diretamente a chave de sessão para restaurar o estado da sessão, ignorando o resto do processo. Por segurança, as chaves de sessão na memória expiram periodicamente. Mas tem duas desvantagens: 1. O servidor deve salvar a chave de sessão de cada cliente. À medida que o número de clientes aumenta, o uso de memória do servidor aumenta. 2. Hoje em dia, os serviços do site são geralmente fornecidos por vários servidores por meio de balanceamento de carga. Quando o cliente se conecta novamente, ele pode não atingir o servidor que visitou da última vez. Se não conseguir atingir o servidor, ainda terá que passar pelo processo completo Processo de handshake TLS.

- Reutilização de sessão 2: Ticket de sessão, quando o cliente e o servidor estabelecem uma conexão pela primeira vez, o servidor irá criptografar a "chave de sessão" e enviá-la ao cliente como um Ticket, e o cliente salvará o Ticket. Isso é semelhante ao esquema de token usado para verificar a identidade do usuário no desenvolvimento web. Quando o cliente se conectar ao servidor novamente, o cliente enviará um ticket. Se o servidor puder descriptografá-lo, ele poderá obter a última chave de sessão e, em seguida, verificar o período de validade. Se não houver problema, a sessão poderá ser restaurada e a comunicação criptografada começa diretamente. Como somente o servidor pode criptografar e descriptografar essa chave, desde que ela possa ser descriptografada, significa que não há fraude. Para servidores de cluster, certifique-se de que a chave usada para criptografar a “chave de sessão” em cada servidor seja consistente, para que quando o cliente trouxer o Ticket para acessar qualquer servidor, a sessão possa ser restaurada.

Nem o ID de sessão nem o ticket de sessão têm segurança de encaminhamento, porque uma vez que a chave que criptografa a "chave de sessão" é quebrada ou o servidor vaza a chave, o texto cifrado de comunicação anteriormente sequestrado pode ser quebrado. Ao mesmo tempo, também é difícil enfrentar ataques de repetição.O chamado ataque de repetição consiste em assumir que o intermediário intercepta a mensagem de pós-solicitação, embora não possa descriptografar as informações nela contidas, ele pode reutilizar a mensagem não idempotente para solicite o servidor. Porque existe um servidor de tickets que pode reutilizar https diretamente. Para reduzir os danos dos ataques de repetição, um tempo de expiração razoável pode ser definido para a chave de sessão criptografada.

A seguir está uma introdução detalhada aos pontos de conhecimento http.

HTTP/0.9

A versão inicial é muito simples, com o objetivo de promover rapidamente seu uso. A função é apenas um simples get html. O formato da mensagem de solicitação é o seguinte:

GET /index.html

HTTP/1.0

Com o desenvolvimento da Internet, o http precisa atender a mais funções, por isso possui o familiar cabeçalho http, código de status, método de solicitação GET POST HEAD, cache, etc.

A desvantagem desta versão é que a conexão TCP será desconectada após cada solicitação, e a próxima solicitação HTTP exigirá que o TCP restabeleça a conexão. Portanto, alguns navegadores adicionaram um cabeçalho Connection: keep-alive não padrão, e o servidor responderá com o mesmo cabeçalho. Através deste acordo, o TCP pode manter uma conexão longa. Solicitações http subsequentes podem reutilizar este TCP até que uma parte feche ativamente isto.

HTTP/1.1

A versão 1.1 é atualmente amplamente utilizada. Nesta versão, a conexão longa tcp é usada por padrão. Se quiser fechá-la, você precisa adicionar ativamente o cabeçalho Connection: close.

Além disso, também possui um mecanismo de pipeline (pipelining), onde o cliente pode enviar continuamente várias solicitações http na mesma conexão tcp sem esperar o retorno do http. No passado, o design das solicitações HTTP era que apenas uma solicitação HTTP pudesse ser enviada por vez em uma conexão TCP. Somente após receber seu valor de retorno a solicitação HTTP seria concluída e a próxima solicitação HTTP poderia ser enviada. Embora a versão http/1.1 possa enviar vários https continuamente com base no mecanismo de pipeline, a versão 1.1 ainda só pode retornar respostas na ordem FIFO (primeiro a entrar, primeiro a sair) no servidor, portanto, se o primeiro http for muito lento durante a resposta, o os subsequentes ainda serão bloqueados pelo primeiro http. Ao receber múltiplas respostas consecutivas, o navegador irá dividi-las por Conteúdo-Comprimento.

Além disso, foi adicionada codificação de transferência em partes, substituindo o formato do buffer por um fluxo de fluxo. Por exemplo, para um vídeo, você não precisa mais lê-lo completamente na memória e depois enviá-lo. Você pode usar o fluxo para enviar uma pequena parte após cada pequena parte ser lida. Use o cabeçalho Transfer-Encoding: chunked para ativar. Haverá um número hexadecimal na frente de cada pedaço para representar o comprimento do pedaço. Se o número for 0, significa que o pedaço foi enviado. Em cenários como transferência ou processamento de arquivos grandes, o uso desse recurso pode melhorar a eficiência e reduzir o uso de memória.

Esta versão tem as seguintes desvantagens:

1. Bloqueio frontal. Uma solicitação-resposta é necessária antes que um http completo seja concluído e, em seguida, o próximo http possa ser enviado. Se o http anterior for lento, isso afetará o próximo horário de envio. Ao mesmo tempo, o navegador possui um número máximo de solicitações HTTP simultâneas para o mesmo nome de domínio, caso ultrapasse o limite, deverá aguardar a conclusão da anterior.

2. Redundância de cabeçalho http. Talvez cada cabeçalho de solicitação HTTP na página seja basicamente o mesmo, mas esses textos devem ser carregados sempre, o que é um desperdício de recursos de rede.

Na verdade, as deficiências do http1.1 são essencialmente causadas pelo seu posicionamento inicial como um protocolo de texto simples. Se quiser enviar fora de ordem, você precisará modificar o próprio protocolo, como adicionar um identificador exclusivo à solicitação/resposta e, em seguida, analisar o texto na outra extremidade para encontrar a ordem correspondente. Você precisa encapsular o protocolo http novamente, converter o texto em dados binários e realizar processamento de encapsulamento adicional. De acordo com o princípio de abertura e fechamento, novas adições são melhores que modificações, então obviamente a última solução é mais razoável. Portanto, http/2.0 dividirá os dados originais em quadros binários para facilitar as operações subsequentes. Isso equivale a adicionar mais algumas etapas ao original, e o núcleo http original não mudou.

HTTP/2.0

Novas melhorias não incluem apenas a otimização da multiplexação de longa data em HTTP/1.1, corrigindo o problema de bloqueio de cabeçalho, permitindo que a prioridade da solicitação seja definida, mas também incluem um algoritmo de compactação de cabeçalho (HPACK). Além disso, o HTTP/2 usa texto binário em vez de texto simples para empacotar e transmitir dados entre o cliente e o servidor.

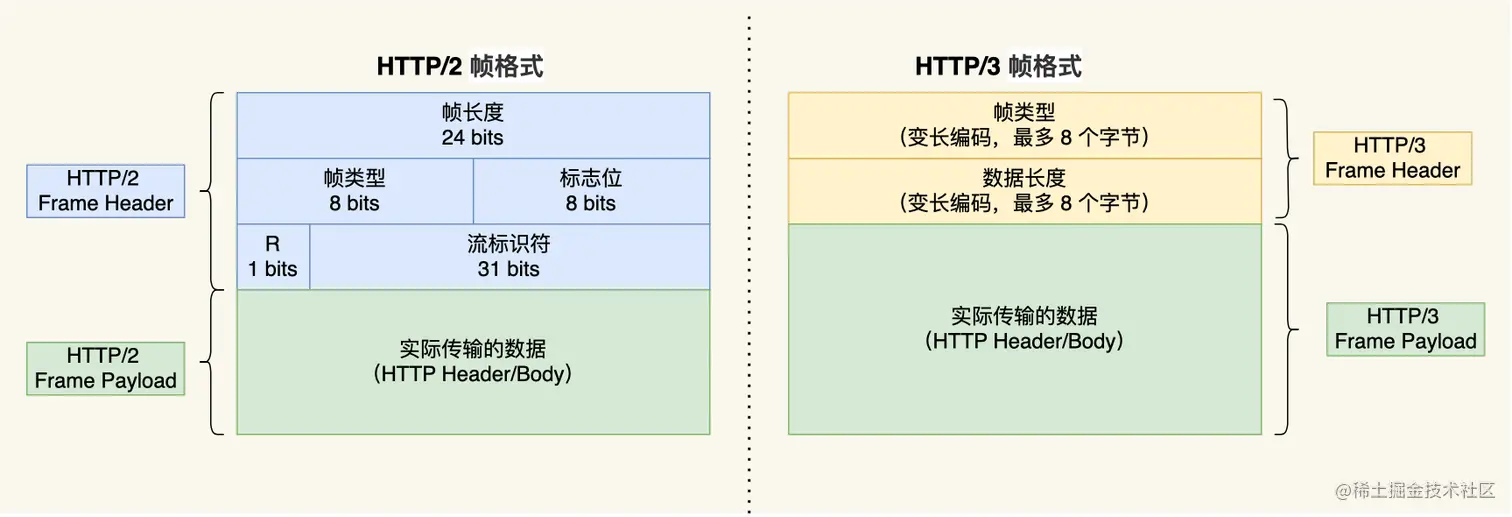

Quadros, mensagens, fluxos e conexões TCP

Podemos pensar na versão 2.0 como a adição de uma camada de enquadramento binário em http. Uma mensagem (uma solicitação ou resposta completa é chamada de mensagem) é dividida em vários quadros. O quadro contém: tipo, comprimento, sinalizadores, identificador de fluxo Stream e carga útil do quadro. Ao mesmo tempo, o conceito abstrato de fluxo também é adicionado. O identificador de fluxo de cada quadro representa a qual fluxo ele pertence. Como http/2.0 pode ser enviado fora de ordem sem esperar, o remetente/receptor enviará fora de ordem de acordo com ao identificador de fluxo. Os dados são montados. Para evitar conflitos causados por IDs de fluxo duplicados em ambas as extremidades, o fluxo iniciado pelo cliente possui um ID ímpar e o fluxo iniciado pelo servidor possui um ID par. O conteúdo do protocolo original não é afetado. O primeiro cabeçalho de informação em http1.1 é encapsulado no quadro Headers e o corpo da solicitação será encapsulado no quadro Data. Múltiplas solicitações usam apenas um canal TCP. Esta iniciativa mostrou na prática que o carregamento de novas páginas pode ser acelerado de 11,81% a 47,7% em comparação com HTTP/1.1. Métodos de otimização como vários nomes de domínio e imagens sprite não são mais necessários em http/2.0.

Algoritmo HPACK

O algoritmo HPACK é um algoritmo recentemente introduzido no HTTP/2 e é usado para compactar cabeçalhos HTTP. O princípio é:

De acordo com o Apêndice A da RFC 7541, o cliente e o servidor mantêm um dicionário estático comum (Tabela Estática), que contém códigos para nomes de cabeçalhos comuns e combinações de nomes e valores de cabeçalhos comuns; o cliente e o servidor seguem a primeira entrada O primeiro a

sair princípio mantém um dicionário dinâmico comum (tabela dinâmica) que pode adicionar conteúdo dinamicamente; o

cliente e o servidor suportam a codificação Huffman com base nesta tabela de código Huffman estática de acordo com o Apêndice B da RFC 7541).

envio de servidor

No passado, os navegadores precisavam iniciar ativamente solicitações para obter dados do servidor. Isso requer a adição de scripts de solicitação js adicionais ao site, e você também precisa aguardar o carregamento dos recursos js antes de ligar. Isso resulta em atraso no tempo de solicitação e em mais solicitações. HTTP/2 oferece suporte a push ativo do lado do servidor, o que não exige que o navegador envie solicitações ativamente, economizando a eficiência das solicitações e otimizando a experiência de desenvolvimento. O front-end pode escutar eventos push do servidor por meio do EventSource.

HTTP/3.0

O HTTP/2.0 fez muitas otimizações em comparação com seu antecessor, como multiplexação, compactação de cabeçalho, etc., mas como a camada subjacente é baseada em TCP, alguns pontos problemáticos são difíceis de resolver.

bloqueio de linha

O HTTP é executado sobre o TCP. Embora o enquadramento binário já possa garantir que várias solicitações no nível HTTP não sejam bloqueadas, você pode saber pelos princípios do TCP mencionados acima que o TCP também possui bloqueio e retransmissão head-of-line. O recebimento do pacote não será devolvido e os subsequentes não serão enviados. Portanto, HTTP/2.0 resolve apenas o bloqueio inicial no nível HTTP e ainda é bloqueado em todo o link de rede. Seria ótimo se um novo protocolo pudesse ser usado para transmitir mais rapidamente em ambientes de rede modernos.

Latência de handshake TCP, TLS

O TCP possui 3 handshakes, o TLS (1.2) possui 4 handshakes e um total de 3 atrasos RTT são necessários para emitir uma solicitação http real. Ao mesmo tempo, como o mecanismo de prevenção de congestionamento do TCP começa a partir de um início lento, ele diminuirá ainda mais a velocidade.

Trocar de rede causa reconexão

Sabemos que a exclusividade de uma conexão TCP é determinada com base no IP e na porta de ambas as extremidades. Hoje em dia, as redes móveis e o transporte estão muito desenvolvidos. Quando você entra no escritório ou vai para casa, seu celular se conecta automaticamente ao WIFI. É muito comum que as redes de telefonia móvel mudem as estações base de sinal em metrôs e trens de alta velocidade em dez segundos. Todos eles causarão alterações de IP, invalidando assim a conexão TCP anterior. O que se manifesta é que uma página da web que está parcialmente aberta de repente não pode ser carregada, e um vídeo que está armazenado em buffer até a metade não pode ser armazenado em buffer no final.

Protocolo QUIC

Os problemas acima são inerentes ao TCP. Para resolvê-los, só podemos alterar o protocolo. http/3.0 usa o protocolo QUIC. Um protocolo completamente novo requer suporte de hardware, que inevitavelmente levará muito tempo para se popularizar, então o QUIC é construído sobre um protocolo UDP existente.

O protocolo QUIC tem muitas vantagens, como:

Sem bloqueio de cabeçalho

O protocolo QUIC também possui o conceito de Stream e multiplexação semelhante ao HTTP/2. Ele também pode transmitir vários Streams simultaneamente na mesma conexão. Um Stream pode ser considerado como uma solicitação HTTP.

Como o protocolo de transporte usado pelo QUIC é o UDP, o UDP não se preocupa com a ordem dos pacotes, nem o UDP se os pacotes forem perdidos.

No entanto, o protocolo QUIC ainda precisa garantir a confiabilidade dos pacotes de dados. Cada pacote de dados é identificado exclusivamente por um número de sequência. Quando um pacote em um fluxo é perdido, mesmo que outros pacotes no fluxo cheguem, os dados não podem ser lidos pelo HTTP/3. Os dados não serão entregues ao HTTP/3 até que o QUIC retransmita o pacote perdido.

Desde que o pacote de dados de um determinado fluxo seja totalmente recebido, o HTTP/3 pode ler os dados desse fluxo. Isso é diferente do HTTP/2, onde se um pacote for perdido em um fluxo, outros fluxos serão afetados.

Portanto, não há dependência entre vários Streams na conexão QUIC. Eles são todos independentes. Se um determinado stream perder pacotes, isso afetará apenas esse stream e outros streams não serão afetados.

Estabelecimento de conexão mais rápido

Para os protocolos HTTP/1 e HTTP/2, TCP e TLS são camadas e pertencem à camada de transporte implementada pelo kernel e à camada de apresentação implementada pela biblioteca OpenSSL, respectivamente. Portanto, eles são difíceis de mesclar e precisam ser abalados em lotes. Primeiro o handshake TCP e depois o handshake TLS.

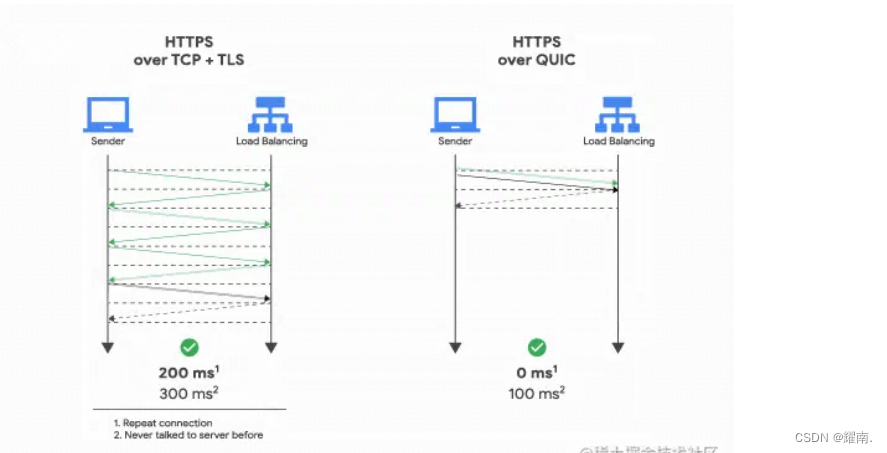

Embora HTTP/3 também exija um handshake de protocolo QUIC antes de transmitir dados, esse processo de handshake requer apenas 1 RTT. O objetivo do handshake é confirmar o "ID de conexão" de ambas as partes, como migração de conexão (por exemplo, a rede precisa a ser migrado devido à comutação de IP) Implementado com base no ID de conexão.

O protocolo QUIC de HTTP/3 não está em camadas com TLS, mas QUIC contém TLS internamente. Ele carregará o "registro" em TLS em seu próprio quadro. Além disso, QUIC usa TLS 1.3, portanto, apenas um RTT pode completar o estabelecimento da conexão e negociação de chave "simultaneamente". Mesmo durante a segunda conexão, o pacote de dados do aplicativo pode ser enviado junto com as informações de handshake QUIC (informações de conexão + informações TLS) para obter o efeito de 0-RTT.

Conforme mostrado na parte direita da figura abaixo, quando a sessão HTTP/3 é restaurada, os dados da carga útil são enviados junto com o primeiro pacote, que pode atingir 0-RTT:

Migração de conexão

Quando a rede do dispositivo móvel muda de 4G para WiFi, significa que o endereço IP mudou, portanto a conexão deve ser desconectada e depois restabelecida. O processo de estabelecimento de uma conexão inclui o atraso do handshake triplo TCP e o Aperto de mão de quatro vias TLS. E o processo de desaceleração do início lento do TCP dá aos usuários a sensação de que a rede está travada repentinamente, então o custo de migração da conexão é muito alto. Se você estiver em um trem de alta velocidade, seu IP hUI poderá mudar continuamente, o que fará com que sua conexão TCP seja reconectada constantemente.

O protocolo QUIC não usa um método de quatro tuplas para "ligar" a conexão, mas usa o ID de conexão para marcar os dois pontos finais da comunicação. O cliente e o servidor podem escolher cada um um conjunto de IDs para se marcar, então mesmo se a rede do dispositivo móvel Após a alteração, o endereço IP muda. Contanto que as informações de contexto (como ID de conexão, chave TLS, etc.) ainda sejam retidas, a conexão original pode ser reutilizada "perfeitamente", eliminando o custo de reconexão sem qualquer atraso, conseguindo A função de migração de conexão é fornecida.

Estrutura de quadro simplificada, compressão de cabeçalho otimizada QPACK

O HTTP/3 usa a mesma estrutura de quadro binário do HTTP/2. A diferença é que o Stream precisa ser definido no quadro binário do HTTP/2, enquanto o próprio HTTP/3 não precisa mais definir o Stream e usa o Stream no QUIC. diretamente, então HTTP/ A estrutura do quadro 3 também se tornou mais simples.

De acordo com os diferentes tipos de quadros, eles são geralmente divididos em duas categorias: quadros de dados e quadros de controle. Os quadros de cabeçalho (cabeçalhos HTTP) e os quadros de DADOS (corpos de pacotes HTTP) pertencem a quadros de dados.

HTTP/3 também foi atualizado em termos de algoritmo de compactação de cabeçalho, que foi atualizado para QPACK. Semelhante ao método de codificação HPACK em HTTP/2, QPACK em HTTP/3 também usa tabela estática, tabela dinâmica e codificação Huffman.

Em relação às mudanças na tabela estática, a tabela estática do HPACK no HTTP/2 possui apenas 61 entradas, enquanto a tabela estática do QPACK no HTTP/3 foi ampliada para 91 entradas.

A codificação Huffman de HTTP/2 e HTTP/3 não é muito diferente, mas os métodos de codificação e decodificação de tabela dinâmica são diferentes.

Na chamada tabela dinâmica, após a primeira solicitação-resposta, ambas as partes atualizarão os itens de cabeçalho (como alguns cabeçalhos customizados) não incluídos na tabela estática em suas respectivas tabelas dinâmicas, e então usarão apenas 1 número para representá-los em transmissões subsequentes.Então a outra parte pode consultar os dados correspondentes da tabela dinâmica com base neste número, sem ter que transmitir dados longos todas as vezes, o que melhora muito a eficiência da codificação.

Pode-se observar que a tabela dinâmica é sequencial, se o primeiro cabeçalho da solicitação for perdido e as solicitações subsequentes encontrarem esse cabeçalho novamente, o remetente pensará que a outra parte já o armazenou na tabela dinâmica, então comprimirá o cabeçalho No entanto, a outra parte não pode decodificar o cabeçalho HPACK porque a outra parte não estabeleceu uma tabela dinâmica. Portanto, a decodificação de solicitações subsequentes deve ser bloqueada até que o pacote de dados perdido na primeira solicitação seja retransmitido antes que a decodificação normal possa ser alcançada.

O QPACK do HTTP/3 resolve esse problema, mas como ele o resolve?

O QUIC terá dois fluxos unidirecionais especiais. Apenas uma extremidade do chamado fluxo unidirecional pode enviar mensagens. Fluxos bidirecionais são usados para transmitir mensagens HTTP. O uso desses dois fluxos unidirecionais:

Um é chamado QPACK Encoder Stream, que é usado para passar um dicionário (valor-chave) para a outra parte.Por exemplo, ao se deparar com um cabeçalho de solicitação HTTP que não pertence a uma tabela estática, o cliente pode enviar o dicionário por meio deste Stream; o outro é chamado QPACK Decoder Stream, que é usado para responder à outra parte e informar que o dicionário que acabou de ser enviado foi atualizado para sua tabela dinâmica local, e você pode usar este dicionário para codificação posteriormente. Esses dois fluxos unidirecionais especiais são usados para sincronizar as tabelas dinâmicas de ambas as partes.A parte codificadora usará a tabela dinâmica para codificar o cabeçalho HTTP após receber a notificação de confirmação de atualização da parte decodificadora. Se a mensagem de atualização da tabela dinâmica for perdida, isso fará com que apenas alguns cabeçalhos não sejam compactados e não bloqueará a solicitação HTTP.

Explicação detalhada do cache HTTP

Se um recurso de rede não precisar ser solicitado e for obtido diretamente do cache local, é naturalmente o mais rápido. O mecanismo de cache é definido no protocolo http, que é dividido em cache local (também chamado de cache forte) e cache que precisa ser verificado por meio de solicitações (também chamado de cache de negociação).

Cache local (cache forte)

Em http1.0, o cabeçalho de resposta expires é usado para indicar o tempo de expiração do valor de retorno.Dentro desse tempo, o navegador pode usar o cache diretamente sem solicitar novamente. Após http1.1, ele foi alterado para o cabeçalho de resposta Cache-Control, que pode atender a mais requisitos de cache.A idade máxima interna indica que o recurso expirará N segundos após a solicitação. Observe que a idade máxima não é o tempo decorrido após o navegador receber a resposta. É o tempo decorrido após a geração da resposta no servidor de origem e não tem nada a ver com o tempo do navegador. Portanto, se outro servidor de cache na rede armazenar a resposta por 100 segundos (indicado pelo campo Idade do cabeçalho de resposta), o cache do navegador deduzirá 100 segundos do seu tempo de expiração. Quando o cache expirar (ignoramos o impacto de obsoleto enquanto revalida, máximo obsoleto etc.), o navegador iniciará uma solicitação condicional para verificar se o recurso está atualizado (também chamado de cache de negociação).

Solicitação condicional (negociar cache)

O cabeçalho da solicitação terá os campos If-Modified-Since e If-None-Match, que são Last-Modified e etag no último cabeçalho de resposta da solicitação, respectivamente. Last-Modified indica a hora em que o recurso foi modificado pela última vez, em segundos. Etag é o identificador de uma versão específica de um recurso (por exemplo, um etag pode ser gerado por hash do conteúdo). O servidor retornará uma resposta de código de status 304 quando não houver alteração em If-None-Match ou If-Modified-Since. O navegador pensará que o recurso não foi atualizado e reutilizará o cache local. Como o tempo de modificação do registro da Última Modificação é em segundos, se a frequência de modificação ocorrer dentro de 1 segundo, não será possível avaliar com precisão se ele foi atualizado, portanto, a prioridade de julgamento do etag é maior do que a da Última Modificação.

Se no-cache for definido em Cache-Control, o cache forte será forçado a não ser usado e o cache negociado será usado diretamente, ou seja, max-age=0. Se nenhum armazenamento for definido, nenhum cache será usado.

A estratégia de cache do navegador para solicitações é simplesmente assim. Podemos ver que o cache é determinado pelos cabeçalhos de resposta e de solicitação. Durante o processo de desenvolvimento, o gateway e o navegador geralmente o configuram automaticamente para nós. Se você tiver necessidades específicas, pode ser personalizado para usar mais funções de controle de cache.

Funcionalidade completa de controle de cache

Cache-Control também possui recursos de controle de cache mais detalhados. Para o significado completo dos cabeçalhos de resposta e cabeçalhos de solicitação, consulte a tabela abaixo.

cabeçalho de resposta

Cabeçalhos de solicitação (apenas aqueles que não estão incluídos nos cabeçalhos de resposta são listados) |max-stale|O cache ainda está disponível quando expira não mais do que o máximo de segundos obsoletos | |min-fresh|Requer que o serviço de cache retorne novos caches dados em min-fresh segundos, caso contrário, não usará cache local | |only-if-cached| O navegador exige que o recurso de destino seja retornado somente se o servidor de cache o tiver armazenado em cache |

Cabeçalhos de solicitação (apenas aqueles que não estão incluídos nos cabeçalhos de resposta são listados) |max-stale|O cache ainda está disponível quando expira não mais do que o máximo de segundos obsoletos | |min-fresh|Requer que o serviço de cache retorne novos caches dados em min-fresh segundos, caso contrário, não usará cache local | |only-if-cached| O navegador exige que o recurso de destino seja retornado somente se o servidor de cache o tiver armazenado em cache |

Otimização do protocolo TCP

Você pode precisar dele ao escrever node. Está tudo bem, não se preocupe, quem está interessado apenas em front-end puro pode pular :)

Primeiro, forneceremos diretamente métodos de otimização para diferentes problemas.Os princípios específicos do TCP e por que esses fenômenos ocorrem serão introduzidos em detalhes posteriormente.

A seguinte otimização tcp geralmente ocorre no lado da solicitação

1. O tamanho da primeira solicitação não deve exceder 14kb, o que pode efetivamente utilizar o início lento do tcp. O mesmo pode ser feito para o primeiro pacote da página front-end.

- Supondo que a janela TCP inicial seja 10 e o MSS seja 1460, o tamanho do recurso da primeira solicitação não deve exceder 14.600 bytes, que é cerca de 14kb. Desta forma, o TCP do extremo oposto pode ser enviado de uma só vez, caso contrário, será enviado pelo menos 2 vezes, o que requer um RTT (tempo de ida e volta da rede) adicional.

2. O que devo fazer se o TCP for bloqueado devido ao envio frequente de pequenos pacotes de dados (menos que MSS)?

Isso é muito comum em operações de jogos (embora o protocolo tcp geralmente não seja usado) e em linha de comando ssh

- Desligue o algoritmo de Nagel

- Evite confirmação atrasada

Como otimizar a retransmissão de perda de pacotes TCP

- Ative o SACK via net.ipv4.tcp_sack (habilitado por padrão)

- Ative o D-SACK via net.ipv4.tcp_dsack (habilitado por padrão)

A seguinte otimização tcp geralmente ocorre no lado do servidor

1. O número de solicitações simultâneas recebidas pelo servidor é muito alto ou ele encontra um ataque SYN, fazendo com que a fila SYN fique cheia e incapaz de responder às solicitações.

- Usesyn cookies

- Reduza o número de novas tentativas de sincronização

- Aumentar o tamanho da fila de sincronização

2. Muitos TIME-WAITs fazem com que as portas disponíveis fiquem cheias e nenhuma outra solicitação possa ser enviada.

- Use a configuração tcp_max_tw_buckets do sistema operacional para controlar o número de TIME-WAITs simultâneos

- Se possível, aumente o intervalo de portas e o endereço IP do cliente ou servidor

O método de otimização TCP acima é baseado na compreensão do mecanismo TCP e no ajuste dos parâmetros do sistema operacional, o que pode alcançar a otimização do desempenho da rede até certo ponto. A seguir começaremos com o mecanismo de implementação do tcp e depois explicaremos o que esses métodos de otimização fazem.

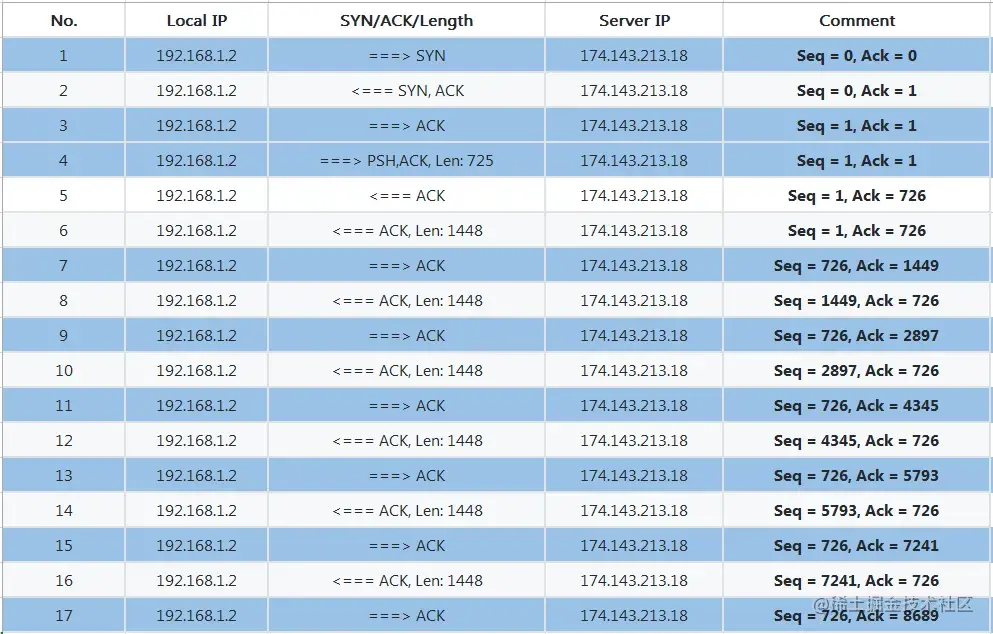

Todos sabemos que uma conexão deve ser estabelecida antes da transmissão TCP, mas na verdade, a transmissão em rede não requer o estabelecimento de uma conexão. A rede foi originalmente projetada para ser em rajadas e enviar a qualquer momento, então o projeto da rede telefônica foi abandonado . Normalmente, a chamada conexão TCP é, na verdade, apenas um estado entre dois dispositivos que salva alguma comunicação entre si, e não é uma conexão real. O TCP precisa distinguir se é a mesma conexão por meio de cinco tuplas, uma das quais é o protocolo e as quatro restantes são src_ip, src_port, dst_ip, dst_port (ip duplo e número da porta). Além disso, há quatro coisas importantes no cabeçalho do segmento de mensagem TCP: Número de sequência é o número de sequência (seq) do pacote, que indica a posição do primeiro bit da parte de dados deste pacote em todo o fluxo de dados , que é usado para resolver o problema de caos de pacotes de rede. Número de confirmação (ack) representa o comprimento dos dados recebidos desta vez + o seq recebido desta vez.É também o próximo número de sequência da outra parte (remetente), que é usado para confirmar o recebimento e resolver o problema de não perder pacotes . Janela, também chamada de janela anunciada, é uma janela deslizante usada para implementar o controle de fluxo. Flag TCP é o tipo de pacote, como SYN, FIN, ACK, etc., que é usado principalmente para controlar a máquina de estado TCP.

A parte principal é apresentada abaixo:

tcp três vezes "aperto de mão"

A essência do handshake de três vias é saber o número de sequência inicial, MSS, janela e outras informações de ambas as partes, para que os dados possam ser unidos de maneira ordenada em uma situação fora de ordem, e o máximo capacidade de carga da rede e do hardware pode ser determinada.

O número de sequência sequencial inicial (ISN) é de 32 bits, que é gerado pelo relógio virtual adicionando 1 continuamente a uma frequência de 4 microssegundos. Ele retorna a 0 quando excede 2 ^ 32 e um ciclo leva 4,55 horas. A razão pela qual cada estabelecimento de conexão não inicia em 0 é para evitar o problema de conflito sequencial entre pacotes novos e pacotes antigos que chegam atrasados após a conexão ser desconectada e restabelecida. 4,55 horas excederam o Tempo de Vida Máximo do Segmento (MSL) e o pacote antigo não existe mais.

- O cliente envia um pacote SYN (flags: SYN), assumindo que a sequência inicial é x, então seq = x. O cliente tcp entra no estado SYN_SEND.

- O servidor tcp está inicialmente no estado LISTEN. Após recebê-lo, ele envia um pacote ACK (flags: ACK, SYN). Suponha que a sequência inicial seja y, seq = y, ack = x + 1. Isso ocorre porque os flags têm SYN e ocupa 1 comprimento. Então, em seguida, o cliente deve começar em x + 1. O servidor entra no estado SYN_RECEIVED.

- O cliente envia um pacote ACK após recebê-lo, seq = x + 1, ack = y + 1. Em seguida, continue a enviar o conteúdo real do pacote PSH (assumindo que o comprimento dos dados é 100), seq = x + 1, ack = y + 1. A razão pela qual o conteúdo real de seq e ack permanece inalterado em relação ao pacote ack é porque o sinalizador é ACK, que é usado apenas para confirmação e não ocupa o comprimento em si. O cliente entra no estado ESTABLISHED.

- O servidor envia um pacote ACK após recebê-lo, seq = y + 1, ack = x + 101. O servidor entra no estado ESTABLISHED.

O cálculo de seq e ack pode ser comparado com esta imagem de captura de pacote (a imagem é da Internet, o número de sequência nela é um número de sequência relativo)

Tempo limite e ataques de SYN

Durante o handshake de três vias, depois que o servidor recebe o pacote SYN e retorna o SYN-ACK, o TCP está em um estado intermediário de semi-conexão. O kernel do sistema operacional colocará temporariamente a conexão na fila SYN. Após o três- Se o handshake for bem-sucedido, a conexão será colocada na fila completa. Se o servidor não receber o ACK do cliente, ele irá expirar e tentar novamente. A repetição padrão é 5 vezes, dobrando de 1s, 1s, 2s, 4s... até o quinto tempo limite, levará um total de 63s, momento em que o tcp será desconectado. Elimine esta conexão. Alguns invasores aproveitarão esse recurso para enviar um grande número de pacotes SYN ao servidor e depois se desconectar. O servidor terá que esperar 63 segundos antes de limpar a conexão da fila SYN, fazendo com que a fila SYN do TCP do servidor fique cheia e incapazes de continuar a prestar serviços. Essa situação também pode ocorrer em condições normais de grande concorrência. Neste momento podemos definir os seguintes parâmetros no Linux:

- tcp_syncookies, ele pode gerar um número de sequência especial (também chamado de cookie) a partir das informações quádruplas, o carimbo de data / hora incrementado a cada 64s e o valor da opção MSS após a fila SYN estar cheia.Este cookie pode ser enviado diretamente ao cliente como um seq. Jianlian. Desta forma inteligente, tcp_syncookies salva algumas informações em SYN sem precisar armazená-las localmente. Os observadores cuidadosos descobrirão que o tcp_syncookies parece exigir apenas dois apertos de mão para estabelecer uma conexão. Por que não incorporá-lo ao padrão tcp? Porque também tem deficiências, 1. A codificação do MSS é de apenas 3 bits, portanto, apenas 8 valores MSS podem ser usados no máximo. 2. O servidor deve rejeitar outras opções na mensagem SYN do cliente que sejam negociadas apenas em SYN e SYN+ ACK, pois o servidor não possui local para salvar essas opções, como Wscale e SACK. 3. Adicionadas operações criptográficas. Portanto, quando a fila SYN estiver cheia devido à grande simultaneidade normal, não use este método, pois é apenas uma versão emasculada do tcp.

- tcp_synack_retries, use-o para reduzir o número de novas tentativas para o tempo limite do SYN-ACK, o que também reduz o tempo de limpeza da fila SYN.

- tcp_max_syn_backlog, aumenta o número máximo de conexões SYN, ou seja, aumenta a fila SYN.

- tcp_abort_on_overflow, rejeita a conexão quando a fila SYN está cheia.

tcp "onda" quatro vezes

Supondo que o cliente se desconecte primeiro, a sequência no exemplo segue o último handshake.

Antes de fechar, o status tcp de ambas as extremidades é ESTABELECIDO.

- O cliente envia um pacote FIN (flags: FIN) para indicar que pode ser fechado, seq = x + 101, ack = y + 1. O cliente muda para o estado FIN-WAIT-1.

- O servidor recebe este FIN e retorna um ACK, seq = y + 1, ack = x + 102. O servidor muda para o estado CLOSE-WAIT. Após receber este ACK, o cliente muda para o estado FIN-WAIT-2.

- O servidor pode ter algum trabalho inacabado e, após a conclusão, enviará um pacote FIN para decidir fechar, seq = y + 1, ack = x + 102. O servidor muda para o estado LAST-ACK.

- O cliente retorna um ACK de confirmação após receber o FIN, seq = x + 102, ack = y + 2. O cliente muda para o estado TIME-WAIT

- Após receber o ACK do cliente, o servidor fecha diretamente a conexão e passa para o estado CLOSED. Se o cliente não receber novamente o FIN do servidor após aguardar o tempo 2*MSL, ele fecha a conexão e passa para o estado CLOSED.

Por que é necessário um longo TEMPO DE ESPERA? 1. Ele pode evitar que a nova conexão que reutiliza as quatro tuplas receba pacotes antigos atrasados. 2. Ele pode garantir que o servidor foi fechado.

Por que o tempo TIME-WAIT é 2*MSL (tempo máximo de sobrevivência do segmento, RFC793 define MSL como 2 minutos e o Linux o define como 30s)? Porque após o envio do FIN, o servidor irá reenviar se a espera pelo ACK expirar. O FIN tem o maior tempo de sobrevivência MSL, e a retransmissão deve ocorrer antes disso. O FIN reenviado também tem o maior tempo de sobrevivência MSL. Portanto, após 2 vezes o tempo MSL, o cliente ainda não recebeu o reenvio do servidor, indicando que o servidor recebeu o ACK e fechou, então o cliente pode ser fechado.

O que devo fazer se houver muitos TIME-WAITs gerados pela desconexão?

Sabemos que o Linux irá esperar 1 minuto por padrão antes de fechar a conexão, neste momento a porta está sempre ocupada. Se houver uma grande conexão curta simultânea, muitos TIME-WAITs podem fazer com que a porta fique cheia ou a CPU fique muito ocupada.

As duas últimas configurações são fortemente recomendadas para não serem usadas.

- tcp_max_tw_buckets, controla o número de TIME-WAITs simultâneos. O valor padrão é 180000. Se exceder, o sistema destruirá e registrará o log.

- ip_local_port_range, aumente o intervalo de portas do cliente

- Se possível, aumente a porta de serviço do servidor (as conexões TCP são baseadas em IP e porta, quanto mais, mais conexões estarão disponíveis)

- Se possível, aumente o IP do cliente ou servidor

- tcp_tw_reuse, o carimbo de data/hora deve estar habilitado no cliente e no servidor antes de poder ser usado. Ele só entra em vigor no cliente. Após a abertura, não há necessidade de aguardar o TIME-WAIT, leva apenas 1s. Novas conexões podem reutilizar diretamente este soquete. Por que preciso ativar o carimbo de data/hora? Porque o pacote da conexão antiga pode circular e finalmente chegar ao servidor, e o novo quíntuplo de conexão que reutiliza o soquete é o mesmo que o pacote antigo.Desde que o carimbo de data / hora seja anterior ao novo pacote, deve ser o pacote da conexão antiga, que pode ser evitada. Pacotes antigos inúteis foram aceitos erroneamente.

- tcp_tw_recycle, o processamento tcp_tw_recycle é mais agressivo, ele reciclará rapidamente o soquete no estado TIME_WAIT. A reciclagem rápida só ocorrerá quando tcp_timestamps e tcp_tw_recycle estiverem habilitados. Quando o cliente acessa o servidor através do ambiente NAT, o estado TIME_WAIT será gerado após o servidor ser fechado ativamente. Se o servidor tiver as opções tcp_timestamps e tcp_tw_recycle ativadas, o tempo de segmentação TCP do mesmo host IP de origem dentro de 60 segundos O carimbo deve ser incrementado, caso contrário será descartado. O Linux removeu a configuração tcp_tw_recycle a partir da versão 4.12 do kernel.

janela deslizante tcp e controle de fluxo

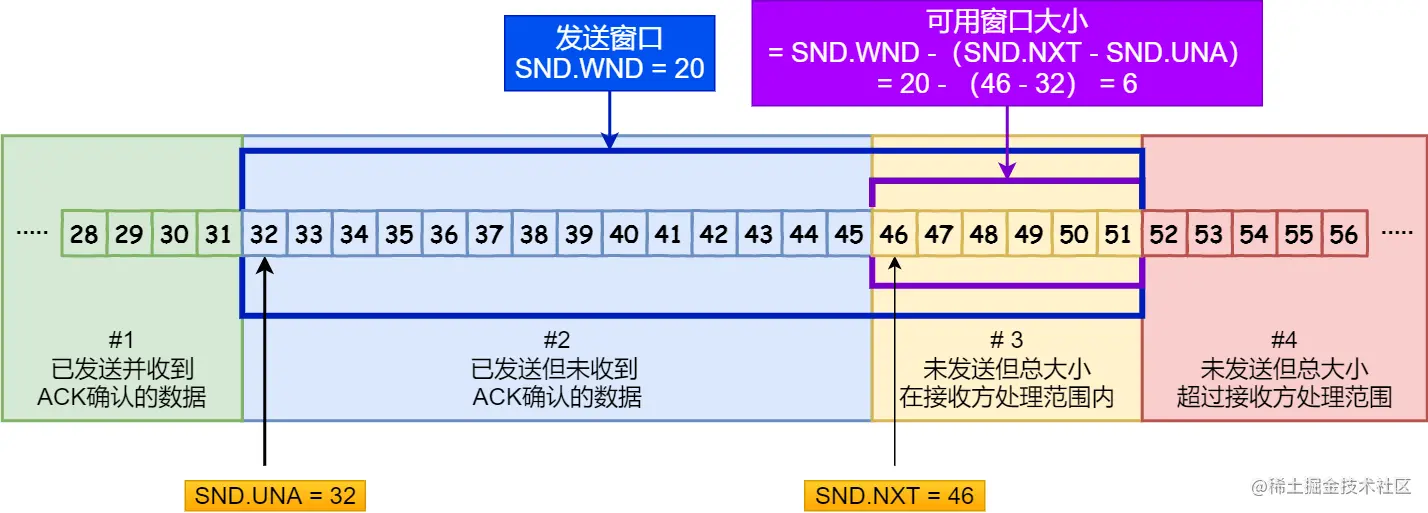

O sistema operacional abriu uma área de cache para tcp, que limita o número máximo de pacotes de dados enviados e recebidos pelo tcp. Ela pode ser visualizada como uma janela deslizante. A janela do remetente é chamada de janela de envio swnd, e a do destinatário é chamada de janela de recebimento rwnd. O comprimento dos dados que foram enviados, mas não recebidos, + o comprimento dos dados armazenados em buffer a serem enviados = o comprimento total da janela de envio.

Durante o handshake, ambas as extremidades trocam valores da janela e o valor mínimo será eventualmente obtido. Suponha que o tamanho da janela do remetente seja 20 e que 10 pacotes sejam enviados no início, mas nenhuma confirmação foi recebida ainda, portanto, apenas mais 10 pacotes poderão ser colocados no buffer no futuro. Se o buffer estiver cheio, nenhum outro dado poderá ser enviado. Quando o receptor recebe dados, ele também os coloca no buffer. Se a capacidade de processamento for menor que a capacidade de envio do peer, o buffer se acumulará e a janela de recebimento disponível ficará menor. O valor da janela carregado pelo ack permitirá que o remetente para reduzir a quantidade de dados enviados. Além disso, o sistema operacional também ajustará o tamanho do buffer. Neste momento, uma situação pode ocorrer. A janela de recebimento original disponível é 10, que foi notificada ao peer por meio de confirmação, mas o sistema operacional diminui repentinamente o buffer e a janela é reduzida em 15. Em vez disso, a janela de recebimento disponível é reduzida em 15. Devo 5. O remetente recebeu anteriormente que a janela disponível é 10, então os dados ainda serão enviados, mas os dados não podem ser processados pelo destinatário, então o tempo limite. Para evitar esta situação, o TCP impõe que se o sistema operacional quiser modificar o buffer, ele deve enviar antecipadamente a janela disponível modificada.

Sabemos pelo conteúdo acima que o TCP limita o tráfego de envio pelas janelas em ambas as extremidades. Se a janela for 0, significa que o envio deve ser interrompido temporariamente. Quando o buffer do receptor estiver cheio e uma confirmação com janela 0 for enviada, e após um período de tempo o receptor for capaz de receber, uma confirmação com janela diferente de 0 será enviada para notificar o remetente para continuar enviando. Se esse ack for perdido, será muito grave, o remetente nunca saberá que o destinatário pode recebê-lo e ficará esperando e entrará em situação de impasse. Para evitar esse problema, o projeto do TCP é que após o remetente ser notificado para interromper o envio (ou seja, após receber a confirmação da janela 0), ele iniciará um cronômetro e enviará uma sonda de janela (sonda de janela) a cada 30 -60 segundos. Após receber a mensagem, o destinatário deve responder na janela atual. Se a detecção da janela for 0 por três vezes consecutivas, algumas implementações TCP enviarão pacotes RST para interromper a conexão.

Se a janela do receptor já for muito pequena, o remetente ainda usará esta janela para enviar dados. O cabeçalho tcp + cabeçalho ip tem 40 bytes, e os dados podem ter apenas alguns bytes, o que é muito antieconômico. Como evitar esta situação? Vamos dar uma olhada em como otimizar o pacote de drama decimal.

pacote pequeno tcp

Para o receptor, desde que não seja permitido enviar em uma janela pequena, o receptor geralmente tem esta estratégia: se a janela de recebimento for menor que o valor mínimo de MSS e espaço de cache/2, diga ao peer que a janela é 0 e pare de enviar dados. Até que a janela seja maior que essa condição.

Para o remetente, usando o algoritmo Nagle, apenas uma das duas condições a seguir é atendida antes do envio:

- Tamanho da janela >= MSS e tamanho total dos dados >= MSS

- Receba a confirmação dos dados enviados anteriormente

Se nenhum deles for atendido, ele continuará acumulando dados e os enviará todos juntos quando uma determinada condição for atendida.

O pseudocódigo é o seguinte

if there is new data to send then

if the window size ≥ MSS and available data is ≥ MSS then

send complete MSS segment now

else

if there is unconfirmed data still in the pipe then

enqueue data in the buffer until an acknowledge is received

else

send data immediately

end if

end if

end if

O algoritmo Nagle está ativado por padrão, mas em cenários como ssh com pequenos dados e muitas interações, Nagle será muito ruim quando encontrar confirmação atrasada, por isso precisa ser desligado. (O algoritmo Nagle não possui configuração global do sistema e precisa ser desligado de acordo com as respectivas aplicações)

Depois de falar sobre otimização de pequenos dados, agora vamos falar sobre a janela deslizante. Na verdade, a janela finalmente adotada pelo tcp não é inteiramente determinada pela janela deslizante. A janela deslizante apenas evita que ambas as extremidades excedam as capacidades de envio e recebimento. A rede as condições entre as duas extremidades também devem ser consideradas. Se ambas as extremidades enviam e recebem As capacidades são muito fortes, mas o ambiente de rede é muito ruim no momento. O envio de uma grande quantidade de dados só tornará a rede mais congestionada, então há ainda uma janela de congestionamento. O TCP assumirá o valor mínimo da janela deslizante e da janela de congestionamento.

início lento tcp e prevenção de congestionamento

Primeiro de tudo, vamos falar sobre o que é MSS. MSS é o comprimento máximo permitido de bytes de dados de um segmento tcp, que é o MTU (comprimento máximo de dados da camada de enlace de dados, especificado pelo hardware) menos o cabeçalho IP 20 bytes menos o cabeçalho tcp 20 Calculado em bytes, geralmente é 1460. Isso significa que um pacote TCP pode transportar até 1.460 bytes de dados da camada superior. O MSS mínimo é negociado em ambas as extremidades durante o handshake TCP. Em um ambiente de rede real, as solicitações passarão por vários dispositivos intermediários, e o MSS no SYN será modificado por eles.No final, será o valor mínimo em todo o caminho, não apenas o valor mínimo em ambas as extremidades.

O TCP possui uma cwnd (janela de congestionamento) responsável por evitar o congestionamento da rede. Seu valor é um múltiplo inteiro do tamanho do segmento TCP, que representa quantos pacotes o TCP pode enviar de uma vez (por conveniência, partimos de 1 para representá-lo). Seu valor inicial é muito pequeno, aumentará gradativamente até que ocorra perda de pacotes e retransmissão para detectar recursos de transmissão de rede disponíveis. No algoritmo clássico de início lento, no modo de confirmação rápida, cada vez que uma confirmação é recebida com sucesso, cwnd + 1, então cwnd aumenta exponencialmente, 1, 2, 4, 8, 16... até que o limite de início lento ssthresh seja atingido. (limiar de início lento), ssthresh é geralmente igual a max (valor de dados externos/2, 2*SMSS), SMSS é o tamanho máximo do segmento do remetente. Quando cwnd < ssthresh, o algoritmo de início lento é usado. Quando cwnd >= ssthresh, o algoritmo para evitar congestionamento é usado.

Algoritmo para evitar congestionamento, após o recebimento de cada confirmação de confirmação, cwnd aumentará em 1/cwnd, ou seja, todos os últimos pacotes enviados serão confirmados, cwnd + 1. Diferente do algoritmo de início lento, o algoritmo de prevenção de congestionamento aumenta linearmente até que dois tipos de retransmissões ocorram e então diminui, 1. ocorre retransmissão de tempo limite, 2. ocorre retransmissão rápida.

Confirmação rápida/atrasada, retransmissão de tempo limite e retransmissão rápida

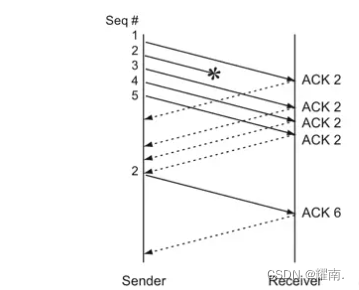

No modo de confirmação rápida, o receptor envia uma confirmação imediatamente após receber o pacote, mas o TCP não retorna uma confirmação toda vez que recebe um pacote, o que é um desperdício de largura de banda da rede. O TCP também pode entrar no modo de confirmação atrasada. A extremidade receptora iniciará o temporizador de confirmação atrasada e verificará se a confirmação deve ser enviada a cada 200 ms. Se houver dados a serem enviados, eles também poderão ser mesclados com a confirmação. Supondo que o remetente envie vários pacotes de uma vez, o peer não pode responder com 10 acks, mas responderá apenas com o último ack do maior pacote consecutivo recebido. Por exemplo, se 1, 2, 3,...10 são transmitidos, o terminal receptor recebe todos eles, então ele responde com uma confirmação de 10, para que o terminal emissor saiba que todos os 10 primeiros foram recebidos, e o próximo um é iniciado a partir de 11. Se houver uma perda de pacote no meio, o reconhecimento antes da perda de pacote será retornado.

Retransmissão de tempo limite: O remetente iniciará um cronômetro após o envio. O tempo limite (RTO) é adequado para ser definido como um pouco maior que um RTT (tempo de ida e volta do pacote). Se o tempo limite de recebimento expirar, o pacote de dados será reenviado. Se os dados reenviados expirarem, o tempo limite será duplicado. Neste momento, ssthresh se torna cwnd/2, cwnd é redefinido para o valor inicial e o algoritmo de início lento é usado. Pode-se observar que o cwnd cai de um penhasco, portanto a ocorrência de retransmissão de tempo limite tem um grande impacto no desempenho da rede. Temos que esperar pelo RTO antes de retransmitir?

Retransmissão rápida: O TCP possui um design de retransmissão rápida. Se o receptor não receber o pacote em ordem, ele responderá com a maior confirmação consecutiva. Se o remetente receber 3 dessas confirmações consecutivas, ele considerará o pacote perdido e poderá rapidamente Retransmita esse pacote uma vez sem voltar ao início lento. Por exemplo, o receptor recebeu 1, 2 e 4, então respondeu com um ACK de 2 e depois recebeu 5 e 6. Como 3 foi interrompido no meio, ele ainda respondeu com um ACK de 2 duas vezes. O remetente recebeu o mesmo ack três vezes seguidas, então sabia que 3 estava perdido e retransmitiu rapidamente 3. O receptor recebe 3 e os dados são contínuos, então uma confirmação de 6 é retornada e o remetente pode continuar a transmitir a partir de 7. Assim como a imagem abaixo:

Quando ocorre uma retransmissão rápida:

- ssthresh = cwnd/2, cwnd = ssthresh + 3, comece a retransmitir pacotes perdidos e insira o algoritmo de recuperação rápida. A razão para +3 é que 3 acks duplicados foram recebidos, indicando que a rede atual pode pelo menos enviar e receber normalmente esses 3 pacotes adicionais.

- Quando um ACK duplicado é recebido, a janela de congestionamento aumenta em 1

- Quando o ACK do novo pacote de dados é recebido, cwnd é definido com o valor ssthresh na primeira etapa.

O algoritmo de retransmissão rápida apareceu pela primeira vez na versão Tahoe do 4.3BSD, e a recuperação rápida apareceu pela primeira vez na versão Reno do 4.3BSD, também chamada de versão Reno do algoritmo de controle de congestionamento TCP. Pode-se observar que o algoritmo de retransmissão rápida de Reno visa a retransmissão de um pacote, porém, na prática, um tempo limite de retransmissão pode causar a retransmissão de muitos pacotes de dados, portanto, quando vários pacotes de dados são perdidos de uma janela de dados, surgem problemas quando rápido algoritmos de retransmissão e recuperação rápida são acionados. Portanto, surge o NewReno, que é ligeiramente modificado com base na recuperação rápida do Reno e pode recuperar múltiplas perdas de pacotes em uma janela. Especificamente: Reno sai do estado de recuperação rápida quando recebe um ACK de novos dados, e NewReno precisa receber confirmação de todos os pacotes de dados na janela antes de sair do estado de recuperação rápida, melhorando ainda mais o rendimento.

Como retransmitir TCP "com precisão"

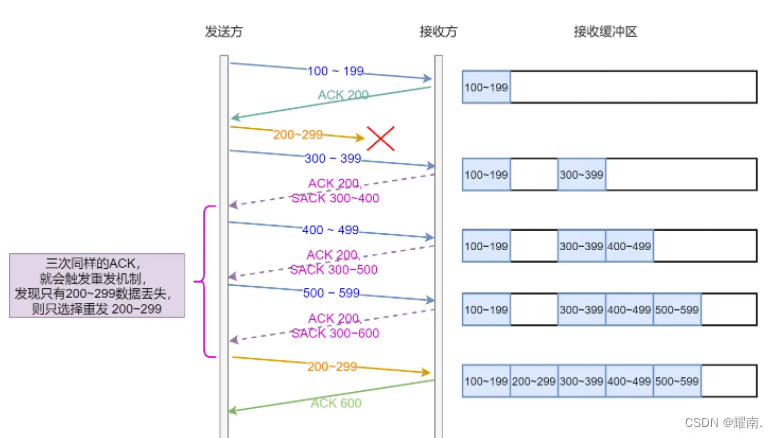

Se ocorrer perda parcial de pacotes, o remetente não sabe quais pacotes foram perdidos parcial ou completamente. Por exemplo, se a extremidade receptora receber 1, 2, 4, 5, 6, a extremidade emissora poderá saber por meio de confirmação que os pacotes após 3 serão perdidos e acionará uma retransmissão rápida. Haverá duas decisões neste momento: 1. Retransmitir apenas o terceiro pacote. 2. Não sei se os pacotes 4, 5, 6... também foram perdidos, então simplesmente retransmito tudo depois do 3. Ambas as opções não são muito boas, se você reenviar apenas 3, se realmente perdê-las depois, cada uma terá que aguardar a retransmissão. Mas se todos forem retransmitidos diretamente, seria um desperdício perder apenas 3. Como deveríamos otimizá-lo?

A retransmissão rápida apenas reduz a chance de acionar a retransmissão por tempo limite.Nem a retransmissão rápida nem a retransmissão por tempo limite resolvem o problema de saber com precisão se deve retransmitir um ou todos eles. Existe um método melhor chamado Reconhecimento Seletivo (SACK), que precisa ser suportado por ambas as extremidades. O Linux o alterna através do parâmetro net.ipv4.tcp_sack. O SACK adicionará um dado ao cabeçalho tcp para informar ao remetente quais segmentos de dados foram recebidos além do máximo contínuo, para que o remetente saiba que os dados não precisam ser retransmitidos. Uma imagem vale mais que mil palavras:

Há também SACK Duplicado (D-SACK). Se o ACK de confirmação do destinatário for perdido, o remetente pensará erroneamente que o destinatário não o recebeu, acionando um tempo limite e uma retransmissão. Neste momento, o destinatário receberá dados duplicados. Ou porque o pacote enviado encontra congestionamento na rede, o pacote retransmitido chega antes do pacote anterior e o receptor também receberá dados duplicados. Neste momento, você pode adicionar um pedaço de dados SACK ao cabeçalho tcp. O valor é o intervalo do segmento de dados repetido. Como o segmento de dados é menor que o ack, o remetente sabe que o destinatário recebeu os dados e não os retransmitirá .

D-SACK é ligado e desligado no Linux através do parâmetro net.ipv4.tcp_dsack.

Resumindo, a função do SACK e do D-SACK é informar ao remetente quais pacotes não foram recebidos e se os pacotes foram recebidos repetidamente. Ele pode determinar se o pacote de dados foi perdido, o ack foi perdido, os dados o pacote foi atrasado pela rede ou a rede foi interrompida. Copiou o pacote de dados.

Um cache mais poderoso: Service Worker

O controle de cache HTTP mencionado acima é principalmente no backend, e se o cache expirar, embora haja um cache negociado, ainda haverá mais ou menos solicitações, o que requer uma rede, e geralmente só pode armazenar em cache solicitações de obtenção. Essas limitações impedem que o front-end seja capaz de executar aplicativos locais como o cliente. Então, há alguma maneira de tornar o front-end completamente cache de proxy? Sejam recursos estáticos ou interfaces de API, tudo pode ser decidido pelo próprio front-end. Ele pode até transformar a página da web em um aplicativo local completo, como um aplicativo . Este é o Service Worker sobre o qual falaremos a seguir, vamos ver quais recursos ele possui.

Cache off-line

O Service Worker pode ser considerado um proxy entre o aplicativo e a solicitação de rede, ele pode interceptar a solicitação e tomar as ações apropriadas com base na disponibilidade da rede ou em outra lógica personalizada. Por exemplo, você pode armazenar em cache HTML, CSS, JS, imagens e outros recursos depois que o aplicativo for aberto pela primeira vez. Na próxima vez que você abrir a página da web, intercepte a solicitação e retorne-a diretamente ao cache, para que seu aplicativo pode ser aberto off-line. Se o dispositivo estiver conectado à Internet posteriormente, você poderá solicitar os recursos mais recentes em segundo plano e determinar se ele foi atualizado. Se tiver sido atualizado, você pode lembrar o usuário de atualizar e atualizar. Em termos de inicialização, os aplicativos front-end que usam Service Worker não exigem nenhuma rede, assim como os aplicativos clientes.

notificação push

Além das solicitações de proxy, o Service Worker também pode permitir ativamente que o navegador envie notificações, assim como as notificações do aplicativo. Você pode usar esta função para fazer "recuperação do usuário", "notificações quentes", etc.

Itens proibídos

Nosso código js principal é executado no thread de renderização, e o Service Worker é executado em outro thread de trabalho, portanto, não bloqueará o thread principal, mas também fará com que algumas APIs fiquem inutilizáveis, como operar dom. Ao mesmo tempo, ele foi projetado para ser completamente assíncrono, de modo que APIs síncronas, como XHR e Web Storage, não possam ser usadas e solicitações de busca possam ser usadas. Import() dinâmico também não é possível, apenas módulos de importação estáticos são possíveis.

Por motivos de segurança, o Service Worker só pode ser executado no protocolo HTTPS (use localhost para permitir http). Afinal, sua capacidade de assumir solicitações já é muito poderosa. Se for adulterado maliciosamente por um intermediário, usuários comuns podem fazer isso A página da web nunca renderizará o conteúdo correto. No FireFox, também não está disponível no modo de navegação anônima.

Instruções

O código do Service Worker deve ser um arquivo js independente e pode ser acessado por meio de solicitações https. Se você estiver em um ambiente de desenvolvimento, poderá permitir o acesso a partir de endereços como http://localhost. Depois de prepará-los, você deve primeiro registrá-los no código do projeto:

if ("serviceWorker" in navigator) {

navigator.serviceWorker.register("/js/service-worker.js", {

scope: "../",

});

} else {

console.log("浏览器不支持Service Worker");

}

Suponha que o endereço do seu site seja https://www.xxx.com e que o js do Service Worker esteja preparado em https://www.xxx.com/js/service-worker.js e /js/service-worker .js é na verdade A solicitação é https://www.xxx.com/js/service-worker.js. O escopo na configuração indica o caminho sob o qual o Service Worker entra em vigor. Se o escopo não for definido, o diretório raiz padrão entrará em vigor. O Service Worker será usado em qualquer caminho na página da web. De acordo com o método de escrita no exemplo, se ./ estiver definido, o caminho efetivo será /js/* e ../ será o diretório raiz.

O Service Worker passará por esses 3 ciclos de vida

- Download

- Instalar

- Ativar

A primeira é a fase de download. Ao entrar em uma página da web controlada por um Service Worker, o download começará imediatamente. Se você já baixou antes, a atualização poderá ser determinada após esse download. A atualização será determinada nas seguintes circunstâncias:

- Ocorreu um salto de página dentro do escopo

- Um evento foi acionado no Service Worker e não foi baixado em 24 horas.

Quando o arquivo baixado for novo, ele tentará instalar o Install.Os critérios para julgar se é um arquivo novo são: primeiro download e comparação byte a byte com o arquivo antigo.

Se esta for a primeira vez que o Service Worker é usado, uma instalação será tentada e, após a instalação bem-sucedida, ative-o.

Se um Service Worker antigo já estiver em uso, ele será instalado em segundo plano e não será ativado após a instalação. Esta situação é chamada de trabalhador em espera. Imagine que o js antigo e o novo podem ter conflitos lógicos. O js antigo está em execução há algum tempo. Se você substituir diretamente o antigo pelo novo e continuar a executar a página da web, ela poderá travar diretamente.

Quando o novo Service Worker será ativado? Você deve esperar até que todas as páginas que usam o Service Worker antigo sejam fechadas antes que o novo Service Worker se torne um trabalhador ativo. Você também pode usar ServiceWorkerGlobalScope.skipWaiting() para pular a espera diretamente. Clients.claim() permite que o novo Service Worker controle as páginas existentes atualmente (aquelas que usam o antigo Service Worker).

Você pode saber quando a instalação ou ativação ocorre ouvindo eventos. O evento mais comumente usado é FetchEvent, que é acionado quando a página inicia uma solicitação. Você também pode usar Cache para armazenar dados em cache e usar FetchEvent.respondWith() para retornar a solicitação valor de retorno que você deseja. A seguir está uma maneira comum de escrever uma solicitação de cache:

// 缓存版本,可以升级版本让过去的缓存失效

const VERSION = 1;

const shouldCache = (url: string, method: string) => {

// 你可以自定义shouldCache去控制哪些请求应该缓存

return true;

};

// 监听每个请求

self.addEventListener("fetch", async (event) => {

const { url, method } = event.request;

event.respondWith(

shouldCache(url, method)

? caches

// 查找缓存

.match(event.request)

.then(async (cacheRes) => {

if (cacheRes) {

return cacheRes;

}

const awaitFetch = fetch(event.request);

const awaitCaches = caches.open(VERSION);

const response = await awaitFetch;

const cache = await awaitCaches;

// 放进缓存

cache.put(event.request, response.clone());

return response;

})

.catch(() => {

return fetch(event.request);

})

: fetch(event.request)

);

});

O cache de código acima não será atualizado após ser estabelecido. Se o seu conteúdo puder mudar e você estiver preocupado com a possibilidade de o cache ficar obsoleto, você pode retornar ao cache primeiro para garantir que os usuários possam ver o conteúdo o mais rápido possível, e em seguida, solicite o mais recente no plano de fundo do Service Worker. Os dados são atualizados no cache e, finalmente, o thread principal é notificado para informar ao usuário que o conteúdo foi atualizado, permitindo que o usuário decida se deseja atualizar o aplicativo. Você pode tentar escrever o código para solicitação em segundo plano e atualizar o julgamento sozinho. Aqui falamos principalmente sobre como o Service Worker informa ao thread principal que o conteúdo solicitado foi atualizado. Como se comunicar entre os dois threads?

Como o Service Worker se comunica com o thread principal

Por que a comunicação é necessária? Primeiro de tudo, se você quiser depurar, o console.log no thread de trabalho não aparecerá no DevTools. Em segundo lugar, se o seu recurso Service Worker for atualizado, ele deverá ser notificado ao thread principal, para que sua página possa exibir uma mensagem para lembrar ao usuário se ele deseja atualizar. Portanto, a comunicação pode ser uma necessidade comercial. Como o Service Worker é um thread separado, ele não pode se comunicar diretamente com nosso thread principal. Mas uma vez resolvido o problema de comunicação, ele pode ter muitos usos maravilhosos. Por exemplo, várias páginas no mesmo site podem usar threads de Service Worker para se comunicar entre páginas. Então, como resolver o problema de comunicação? Podemos criar um canal de mensagens new MessageChannel(), que possui duas portas que podem enviar e receber mensagens de forma independente. Forneça uma das portas, port2, ao Service Worker e deixe a porta port1 ativada o tópico principal, então eles poderão se comunicar através deste canal. O código a seguir mostrará como permitir que dois threads se comuniquem entre si para obter funções como "imprimir log de thread de trabalho", "notificar atualização de conteúdo" e "atualizar aplicativo".

código no thread principal

const messageChannel = new MessageChannel();

// 将port2交给控制当前页面的那个Service Worker

navigator.serviceWorker.controller.postMessage(

// "messageChannelConnection"是自定义的,用来区分消息类型

{ type: "messageChannelConnection" },

[messageChannel.port2]

);

messageChannel.port1.onmessage = (message) => {

// 你可以自定义消息格式来满足不同业务

if (typeof message.data === "string") {

// 可以打印来自worker线程的日志

console.log("from service worker message:", message.data);

} else if (message.data && typeof message.data === "object") {

switch (message.data.classification) {

case "content-update":

// 你可以自定义不同的消息类型,来做出不同的UI表现,比如『通知用户更新』

alert("有新内容哦,你可以刷新页面查看");

break;

default:

break;

}

}

};

Código no Service Worker

let messageChannelPort: MessagePort;

self.addEventListener("message", onMessage);

// 收到消息

const onMessage = (event: ExtendableMessageEvent) => {

if (event.data && event.data.type === "messageChannelConnection") {

// 拿到了port2保存起来

messageChannelPort = event.ports[0];

} else if (event.data && event.data.type === "skip-waiting") {

// 如果主线程发出了"skip-waiting"消息,这里就会直接更新Service Worker,也就让应用升级了。

self.skipWaiting();

}

};

// 发送消息

const postMessage = (message: any) => {

if (messageChannelPort) {

messageChannelPort.postMessage(message);

}

};

Compressão de arquivos, desempenho de imagem, adaptação de pixels do dispositivo

A compactação de arquivos de recursos, como js, css, imagens, etc. pode reduzir bastante o tamanho e melhorar bastante o desempenho da rede. Geralmente, o serviço de back-end configurará automaticamente o cabeçalho de compactação para nós, mas também podemos mudar para um algoritmo de compactação mais eficiente para obter uma melhor taxa de compactação.

codificação de conteúdo

Se você abrir qualquer site e olhar sua rede de recursos, verá que há um cabeçalho de codificação de conteúdo nos cabeçalhos de resposta, que pode ser gzip, compress, deflate, identidade, br e outros valores. Além da identidade não representar compactação, você pode definir outros valores para compactar o arquivo e acelerar a transmissão http, sendo o mais comum o gzip. Com suporte de compatibilidade, você pode definir especificamente alguns formatos de compactação mais recentes, como br (Brotli), para obter uma taxa de compactação superior a gzip.

arquivo de fonte

Se uma fonte especial for necessária na página e o texto na página for fixo ou pequeno (por exemplo, apenas letras e números), você poderá cortar manualmente o arquivo de fonte para que contenha apenas o texto necessário, o que pode reduzir bastante o tamanho do arquivo.

Se as palavras na página forem dinâmicas, você não terá como saber quais serão. Em cenários apropriados, como cenários em que os usuários podem visualizar efeitos de fonte ao inserir texto. Os usuários geralmente inserem apenas algumas palavras, portanto não há necessidade de apresentar todo o pacote de fontes, mas você não sabe o que o usuário irá inserir. Assim, você pode permitir que o back-end (ou construir uma camada de bff baseada em nodejs) gere dinamicamente um arquivo de fonte contendo apenas algumas palavras e retorne-o para você com base nas palavras desejadas. Embora haja mais uma solicitação de consulta, arquivos de fontes de vários Mb ou até mais de dez Mb podem ser reduzidos para alguns KB.

Formato de imagem

As imagens geralmente não são compactadas pelos métodos acima, porque esses formatos de imagem já foram compactados para você e a compactação novamente não terá muito efeito. Portanto, a escolha do formato da imagem é a chave para afetar o tamanho e a qualidade da imagem. De um modo geral, quanto menor for a compressão, mais tempo demora e pior é a qualidade da imagem. Mas não é absoluto: o novo formato pode fazer tudo melhor que o formato antigo, mas tem pouca compatibilidade. Então você precisa encontrar um equilíbrio.

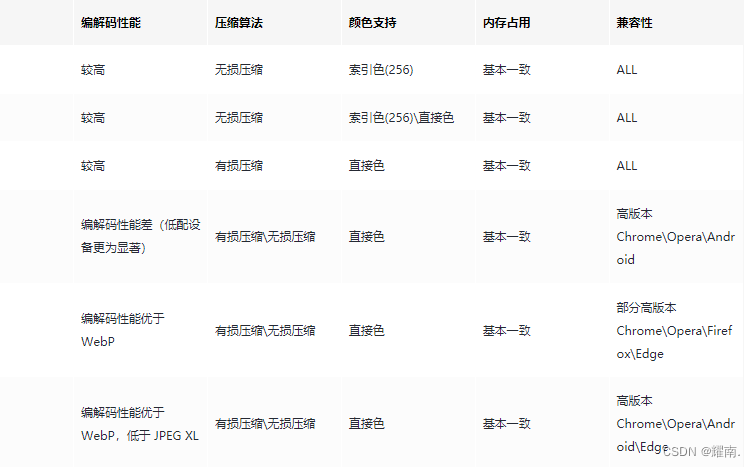

Em termos de formatos de imagem, além dos comuns PNG-8/PNG-24, JPEG e GIF, prestamos mais atenção a vários outros formatos de imagem mais recentes:

- WebP

- JPEGXL

- AVIF

Use uma tabela para compará-los em termos de tipo de imagem, canal de transparência, animação, desempenho de codificação e decodificação, algoritmo de compactação, suporte de cores, uso de memória e compatibilidade:

Do ponto de vista do desenvolvimento técnico, é dada prioridade ao uso de formatos de imagem relativamente novos: WebP, JPEG XL e AVIF. JPEG XL é muito promissor para substituir o formato de imagem tradicional, mas a compatibilidade ainda é muito ruim. A compatibilidade com AVIF é melhor que JPEG XL, mantendo alta qualidade de imagem após a compactação e evitando artefatos de compactação irritantes e outros problemas. No entanto, as velocidades de decodificação e codificação não são tão rápidas quanto JPEG XL e a renderização progressiva não é suportada. Basicamente, o WebP é suportado por todos os navegadores, exceto o IE. Para imagens complexas (como fotos), o desempenho da codificação sem perdas do WebP não é bom, mas o desempenho da codificação com perdas é muito bom. A velocidade de decodificação de imagem do WebP com qualidade semelhante não é muito diferente da do JPEG XL, mas a taxa de compactação do arquivo pode ser muito melhorada. Então, por enquanto, parece que se você deseja melhorar o desempenho da imagem do seu site, seria melhor usar WebP em vez do formato tradicional.

Uso do elemento Imagem

Então, há algo que possa nos ajudar automaticamente a usar formatos de imagem semelhantes a WebP, AVIF e JPEG XL mencionados acima em navegadores que suportam alguns formatos de imagem modernos, enquanto navegadores que não suportam recorrem ao método JPEG, PNG normal? A especificação HTML5 adiciona um novo elemento Picture. O elemento <picture> fornece versões de uma imagem para diferentes cenários de exibição/dispositivo contendo zero ou mais elementos <source> e um elemento <img>. O navegador selecionará o elemento filho <source> com melhor correspondência ou, se não houver correspondência, selecionará a URL no atributo src do elemento <img>. A imagem selecionada é então renderizada no espaço ocupado pelo elemento <img>.

<picture>

<!-- 可能是一些对兼容性有要求的,但是性能表现更好的现代图片格式-->

<source src="image.avif" type="image/avif" />

<source src="image.jxl" type="image/jxl" />

<source src="image.webp" type="image/webp" />

<!-- 最终的兜底方案-->

<img src="image.jpg" type="image/jpeg" />

</picture>

Adaptação do tamanho da imagem: pixels físicos, pixels independentes do dispositivo

Se você deseja um ótimo desempenho de imagem, deve usar tamanhos de imagem apropriados para elementos de tamanhos diferentes. Se uma imagem de 500*500 for exibida em uma área de 100*100 pixels, isso é obviamente um desperdício; pelo contrário, uma imagem de 100*100 em 500*500 pixels fica muito borrada, o que reduz a experiência do usuário. Antes de falar sobre adaptação de tamanho, devemos primeiro falar sobre o que são pixels independentes de dispositivo e pixels físicos, e o que é DPR.

Quando escrevemos width: 100px em CSS, o que é exibido na tela é na verdade um pixel independente do dispositivo (também chamado de pixel lógico) de 100px de comprimento, que não é necessariamente os 100 pixels (pixels físicos) da tela. Na tela original, os pixels independentes do dispositivo e os pixels físicos eram 1:1, ou seja, largura: 1px corresponde a 1 ponto emissor de luz de pixel na tela. Com o subsequente desenvolvimento da tecnologia de exibição, os pixels das telas do mesmo tamanho tornaram-se cada vez mais refinados. Talvez a posição original de 1 pixel agora seja composta por 4 pixels. Isso traz maior densidade de pixels e uma melhor experiência visual, mas também cria um problema. Se width: 1px representar um ponto de luz de pixel como antes, a mesma página diminuirá neste dispositivo porque os pixels agora são menores. Para resolver esse problema, os fabricantes criaram o conceito de pixels independentes de dispositivos, que não são pixels reais, mas sim lógicos. Se 1 pixel no dispositivo for agora substituído por 2 pixels menores, então a proporção de pixels do dispositivo (DPR) do dispositivo será 2, e uma imagem desenhada com largura: 1px será desenhada por 2 pixels, então o tamanho e usado para ser consistente. Da mesma forma, em um dispositivo com uma tela mais fina, supondo que ele seja composto de 3 pixels menores em vez do tamanho tradicional de 1 pixel, então seu DPR é 3 e width: 1px é na verdade desenhado por 3 pixels. Agora você pode entender por que o entrevistador fez perguntas como "Como desenhar uma borda de 1px", porque sob alto DPR seu 1px na verdade não é 1px.

Portanto, podemos obter esta equação de pixel: 1 pixel css = 1 pixel independente do dispositivo = pixel físico * DPR.

Forneça imagens apropriadas para diferentes telas DPR

Portanto, embora nossos elementos img tenham todos 100px, o tamanho ideal da imagem que precisamos exibir é, na verdade, diferente em diferentes dispositivos DPR. Quando DPR = 2, uma imagem de 200px deve ser exibida, e quando DPR = 3, uma imagem de 300px deve ser exibida, caso contrário ocorrerão condições desfocadas.

Então, quais são algumas soluções possíveis?

Opção 1: gráficos múltiplos simples e brutos

O DPR mais alto em dispositivos comuns agora é 3, então a maneira mais simples é usar a exibição de imagem 3x mais alta por padrão. Mas isso causará muito desperdício de largura de banda, diminuirá o desempenho da rede e reduzirá a experiência do usuário, o que definitivamente não está de acordo com o “estilo” do nosso artigo.

Opção 2: consulta à mídia

Podemos usar consultas de mídia @media para aplicar diferentes CSS com base no DPR do dispositivo atual

#img {

background: url([email protected]);

}

@media (device-pixel-ratio: 2) {

#img {

background: url([email protected]);

}

}

@media (device-pixel-ratio: 3) {

#img {

background: url([email protected]);

}

}

A vantagem desta solução é que ela pode exibir imagens com diferentes ampliações sob diferentes DPR.

As desvantagens desta solução são:

- Existem muitas ramificações lógicas, e não existem apenas dispositivos no mercado com DPR = 2 ou 3, mas também alguns dispositivos com DPR decimal. Você precisa escrever muito código para cobrir tudo.

- Problemas de compatibilidade de sintaxe, por exemplo, em alguns navegadores é -webkit-min-device-pixel-ratio. Você pode resolver isso com o autoprefixer, mas isso também apresenta um custo adicional.

Opção 3: sintaxe de conjunto de imagens css

#img {

/* 不支持 image-set 的浏览器*/

background-image: url("../[email protected]");

/* 支持 image-set 的浏览器*/

background-image: image-set(

url("./[email protected]") 2x,

url("./[email protected]") 3x

);

}

Entre eles, 2x e 3x correspondem a diferentes DPR. As desvantagens da solução de conjunto de imagens são as mesmas das consultas de mídia, por isso não entrarei em detalhes. A vantagem é que é mais específico do que consultas de mídia e permite que você finja ser uma onda.

Opção 4: atributo do elemento srcset

<img src="[email protected]" srcset="[email protected] 2x, [email protected] 3x" />

Os 2x e 3x internos indicam a correspondência de DPRs diferentes e [email protected] é o resultado final. As vantagens e desvantagens são as mesmas do conjunto de imagens. A vantagem pode ser que não requer escrita de CSS e é mais conciso.

Opção 5: atributo srcset combinado com atributo tamanhos

<img

sizes="(min-width: 600px) 600px, 300px"