1. Introdução

A linguagem usada para descrever o fluxo de dados é chamada Pig Latin. O ambiente de execução para executar programas Pig Latin atualmente tem dois ambientes: o ambiente de execução local em uma única JVM e o ambiente de execução distribuída no cluster Hadoop.

No Pig, cada operação ou transformação deve processar os dados de entrada e, em seguida, produzir o resultado de saída. Essas operações de transformação são convertidas em uma série de trabalhos de MapReduce. O Pig permite que o programador não precise saber como essas transformações são realizadas, para que o O engenheiro pode se concentrar no foco nos dados, não nos detalhes da implementação.

2 Baixe e instale

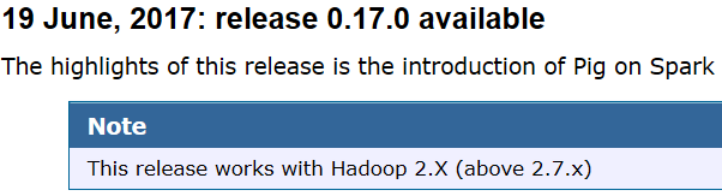

Endereço de download do pacote de instalação: http://pig.apache.org/releases.html.

#tar -xzvf pig-0.17.0.tar.gz -C / usr / local / #cd

/ usr / local /

#mv pig-0.17.0 / pig

#vi /root/.bashrc

export PIG_HOME=/usr/local/pig

export PATH=$PATH:$PIG_HOME/bin

#source /root/.bashrc

#pig -help

#pig -version 【0.17.0】

#hadoop versão 【2.8.5】

#pig -x modo de execução local set

grunt>

grunt> quit exit

3 Tipo de execução

3.1 modo local

Grunt é a concha de Porco. No modo local, o Pig é executado em uma única JVM e acessa o sistema de arquivos local.Este modo é usado para testar ou processar conjuntos de dados em pequena escala.

#pig -x local

grunt>

grunt> quit

Por exemplo, extraia a primeira coluna do arquivo / etc / passwd no Linux e produza-o.

#head -n 5 / etc / passwd

root:x:0:0:root:/root:/bin/bash

bin:x:1:1:bin:/bin:/sbin/nologin

daemon:x:2:2:daemon:/sbin:/sbin/nologin

adm:x:3:4:adm:/var/adm:/sbin/nologin

lp:x:4:7:lp:/var/spool/lpd:/sbin/nologin

#pig -x local -brief

Connecting to hadoop file system at: file:///

[表示本地文件系统]

usar

grunt> A = load '/etc/passwd' using PigStorage(':');注意空格不可少

grunt> B = foreach A generate $0 as id;注意空格不可少

grunt> dump B;注意空格不可少

3.2 Modo MapReduce

Se você executar este comando sem o Hadoop instalado, um erro será relatado.

ERROR 4010: Não é possível encontrar configurações hadoop no classpath (nem hadoop-site.xml nem core-site.xml foi encontrado no classpath). Se você planeja usar o modo local, coloque a opção -x local na linha de comando.

O Pig encontra e executa o cliente Hadoop correspondente de acordo com a variável de ambiente HADOOP_HOME.

#cat /root/.bashrc

export HADOOP_HOME=/usr/local/hadoop

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

export HADOOP_CONF_DIR=/usr/local/hadoop/etc/hadoop

export HADOOP_CLASSPATH=/usr/local/hadoop/share/hadoop/common/lib

#pig -brief

Connecting to hadoop file system at: hdfs://pda1:9000

(1) Inicie o cluster hadoop

# start-dfs.sh

# start-yarn.sh

# mr-jobhistory-daemon.sh start historyserver Observe que esta linha deve ser executada

(2) Carregue o arquivo para o cluster

#hdfs dfs -ls /

#hdfs dfs -put / etc / passwd /

(3) Entre no shell do Pig, execute-o, extraia A com uma separação ':', coloque a primeira coluna de A em B e descarte B.

#pig -x mapreduce -brief

grunt> A = load '/ passwd' using PigStorage (':');

grunt> B = foreach A gera $ 0 como id;

grunt> dump B;

(4) Feche o cluster

# mr-jobhistory - daemon.sh stop

historyserver

# stop-yarn.sh # stop-dfs.sh