Esta série de blog relacionado, referência geeks de tempo - Algo sobre protocolo de rede

Discussão divertida sobre protocolo de rede - Palestra 21 | Data Center: Sou desenvolvedor e tenho uma casa para construir uma casa de campo

Esteja você assistindo notícias, fazendo pedidos, assistindo vídeos, baixando arquivos, o destino final está no data center. Nós aprendemos muito sobre protocolos de rede e conhecimentos relacionados à rede antes.Você está curioso, como é um data center?

Data center

O data center é uma mistura, e quase todo o conhecimento aprendido antes é usado.

Quando conversamos sobre a rede do escritório, sabíamos que havia muitos computadores no escritório. Se você deseja acessar a rede externa, precisa passar por algo chamado gateway , que geralmente é um roteador.

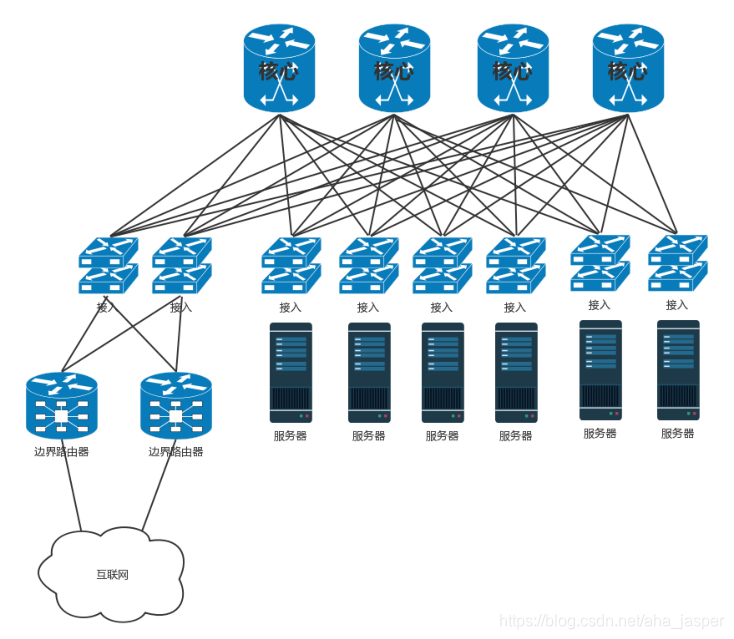

Também existem muitos computadores no data center, mas não é o mesmo que o laptop ou o desktop em nosso escritório. Dentro do data center estão servidores. É colocado em um servidor chamado uma cremalheira (cremalheira) prateleira acima.

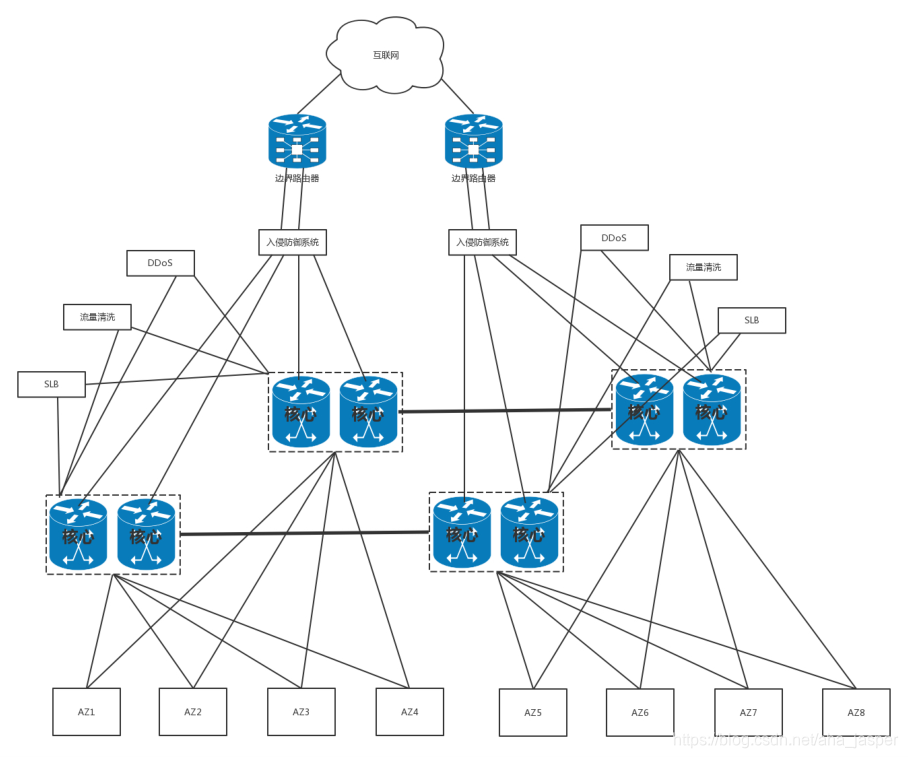

A entrada e saída do data center também são roteadores, porque na fronteira do data center, assim como na fronteira de um país, é chamado de roteador de fronteira . Para alta disponibilidade, haverá vários roteadores de borda.

Geralmente, apenas uma rede de uma operadora está conectada em casa e, para alta disponibilidade, para fornecer serviços através de outra operadora quando um operador tiver um problema, o roteador de borda do data center conectará vários operadores Rede.

Como é um roteador, você precisa executar um protocolo de roteamento.O data center é geralmente uma área autônoma (AS) no protocolo de roteamento. Se a máquina no centro de dados quiser acessar o site externo, a máquina no centro de dados também fornece serviços para o mundo externo, os quais podem obter as informações de roteamento interno e externo através do protocolo BGP. Esse é o conceito de BGP de várias linhas que costumamos ouvir .

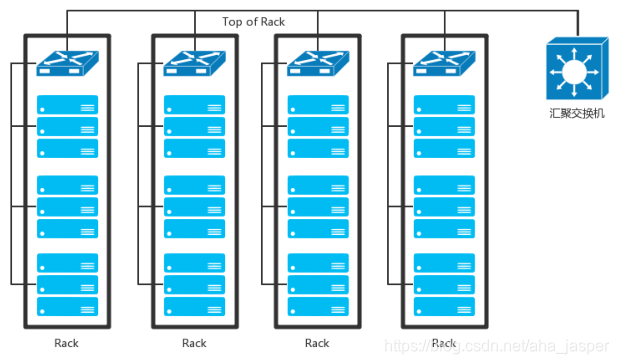

Se o datacenter for muito simples e houver poucas máquinas, assim como em casa ou dormitório, todos os servidores estarão conectados diretamente ao roteador. No entanto, muitas vezes existem muitas máquinas no data center.Quando um rack é preenchido, é necessário um comutador para conectar esses servidores e se comunicar.

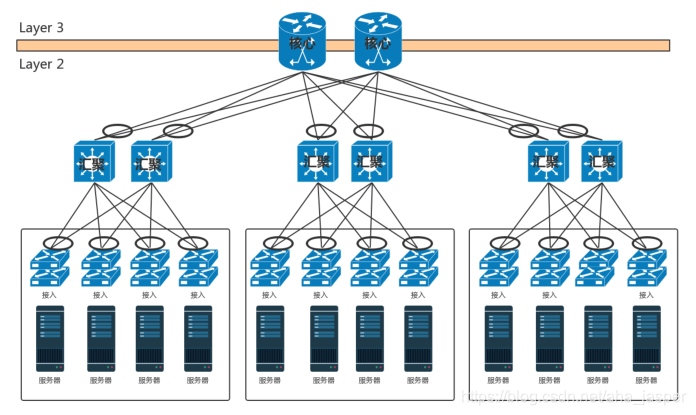

Esses comutadores costumam ser colocados na parte superior do rack, portanto são chamados de comutadores TOR (Top Of Rack) . Essa camada de comutadores costuma ser chamada de camada de acesso (camada de acesso) . Observe que essa camada de acesso não é um conceito com a camada de acesso do aplicativo descrito anteriormente.

Quando um rack não pode ser colocado, são necessários vários racks e também é necessário um comutador para conectar os vários racks. Esses comutadores têm requisitos de desempenho mais altos e maior largura de banda. Essas opções são chamadas de opções da camada de agregação (Camada de agregação) .

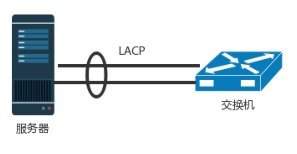

Toda conexão no data center precisa considerar a alta disponibilidade. A primeira coisa a considerar aqui é que, se uma máquina tiver apenas uma placa de rede e um cabo de rede estiver conectado, ele será conectado ao comutador TOR. Se a placa de rede estiver quebrada ou o cabo de rede cair acidentalmente, a máquina não poderá entrar. Portanto, pelo menos duas placas de rede e dois cabos de rede precisam ser conectados ao switch TOR, mas as duas placas de rede devem funcionar como uma placa de rede, o que geralmente é chamado de ligação da placa de rede .

Isso requer que o servidor e o switch suportem um protocolo LACP (Link Aggregation Control Protocol) . Eles se comunicam, agregam várias placas de rede em uma placa de rede e agregam vários cabos de rede em um cabo de rede.O balanceamento de carga pode ser realizado entre os cabos de rede ou pode ser usado como preparação para alta.

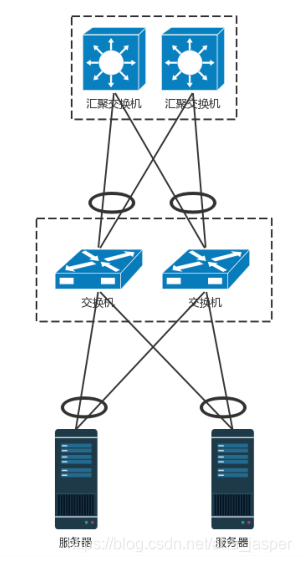

A placa de rede tem uma garantia de alta disponibilidade, mas o switch ainda tem problemas. Se houver apenas um comutador em um rack e ele travar, o rack inteiro não poderá mais ser conectado à Internet. Portanto, o comutador TOR também precisa de alta disponibilidade, e a conexão entre a camada de acesso e a camada de agregação também precisa de alta disponibilidade e não pode ser conectada em uma única linha.

O método mais tradicional é implantar dois comutadores de acesso e dois comutadores de agregação. O servidor e os dois comutadores de acesso estão conectados, e o comutador de acesso e as duas agregações estão conectados. Naturalmente, isso formará um anel, portanto, é necessário ativar o protocolo STP e remover o anel, mas as duas agregações podem ser apenas um mestre e um backup. Aprendemos no protocolo STP que apenas uma maneira funcionará.

O switch possui uma tecnologia chamada empilhamento ; portanto, outro método é formar vários switches em um switch lógico, o servidor é conectado a vários switches da camada de acesso através de várias distribuições de fios e os vários fios do switch da camada de acesso são respectivamente Conecte-se a vários comutadores e forme uma conexão hiperativa empilhando protocolos privados .

Devido aos maiores requisitos de largura de banda e ao maior impacto da suspensão, duas pilhas podem não ser suficientes, podem existir mais, como quatro pilhas para um comutador lógico.

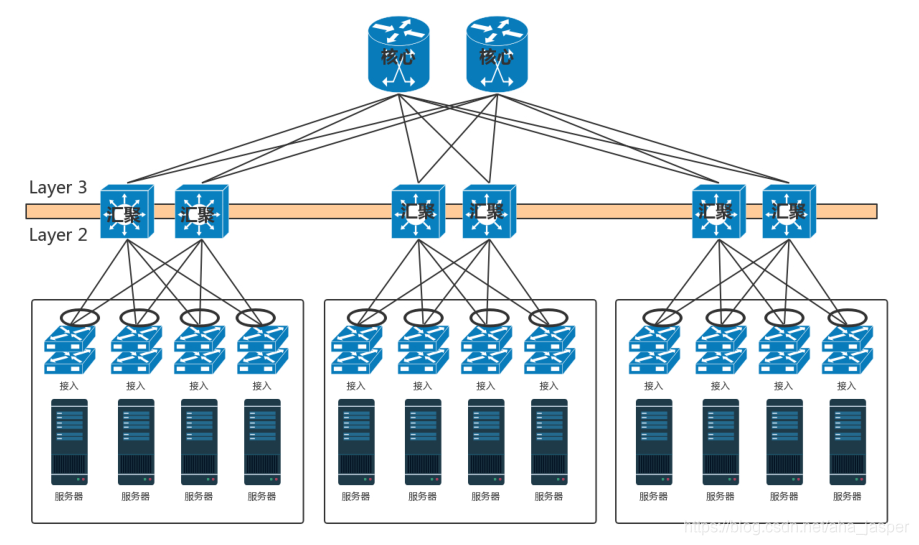

A camada de convergência conecta um grande número de nós de computação para formar um cluster. Nesse cluster, os servidores se comunicam através da segunda camada.Esta área é chamada de POD (ponto de entrega) e, às vezes, também é chamada de zona disponível (zona disponível) .

Quando o número de nós é muito grande, uma zona de disponibilidade não pode ser colocada e várias zonas de disponibilidade precisam ser conectadas.O switch que conecta várias zonas de disponibilidade é chamado de switch principal .

Os comutadores principais têm maior taxa de transferência e requisitos mais altos para alta disponibilidade.Eles definitivamente precisam ser empilhados, mas muitas vezes o empilhamento não é suficiente para atender à taxa de transferência, portanto vários conjuntos de comutadores principais ainda precisam ser implantados. Para alta disponibilidade, os switches principais e de agregação também são totalmente interconectados.

Naquele momento, ainda havia esse problema.O que devo fazer se houvesse um loop?

Uma maneira é que diferentes zonas de disponibilidade estejam em redes da Camada 2. Diferentes segmentos de rede precisam ser alocados. A agregação e o núcleo se comunicam através de uma rede da Camada 3. A Camada 2 não está em um domínio de broadcast e não haverá anel da Camada 2. O problema da estrada. Não há problema com o anel de três camadas, desde que o melhor caminho seja selecionado através do protocolo de roteamento. Por que a segunda camada não pode ter um loop e a terceira camada pode? Você pode recuperar a situação do segundo loop da camada.

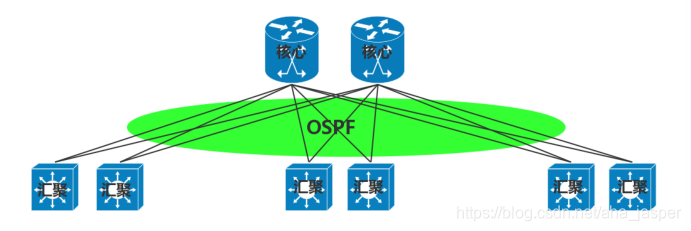

Conforme mostrado na figura, o protocolo de roteamento interno OSPF é usado para encontrar o melhor caminho para o acesso entre a camada principal e a camada de agregação, e o roteamento equivalente a ECMP pode ser usado para carregar o equilíbrio e a alta disponibilidade entre vários caminhos.

No entanto, com o número crescente de máquinas no data center, especialmente com computação em nuvem e big data, o tamanho do cluster é muito grande e todos eles exigem uma rede de camada 2. Isso requer que a interconexão de duas camadas suba da camada de convergência para a camada principal , ou seja, abaixo do núcleo, todas são interconexões de duas camadas, todas em um domínio de broadcast, geralmente chamado de segunda camada grande .

Se o tráfego horizontal da Camada 2 grande não for grande e o número de comutadores principais não for grande, o empilhamento poderá ser feito. No entanto, se o tráfego horizontal for grande e o empilhamento não for suficiente, vários conjuntos de comutadores principais precisam ser implantados e totalmente interconectados à camada de agregação. Como o empilhamento resolve apenas o problema sem anel em um grupo de comutadores principais e toda a interconexão entre grupos, outros mecanismos são necessários para resolvê-lo.

Se for STP, a capacidade de implantar vários conjuntos de núcleos não pode expandir o tráfego horizontal, porque apenas um conjunto ainda funciona.

Assim, a segunda camada introduziu o TRILL (interconexão transparente de muitos links) , que é um protocolo de interconexão transparente com vários links . A ideia básica é que, se houver um problema com um anel da camada 2, mas não houver um problema com um anel da camada 3, a capacidade de roteamento da camada 3 será simulada na camada 2.

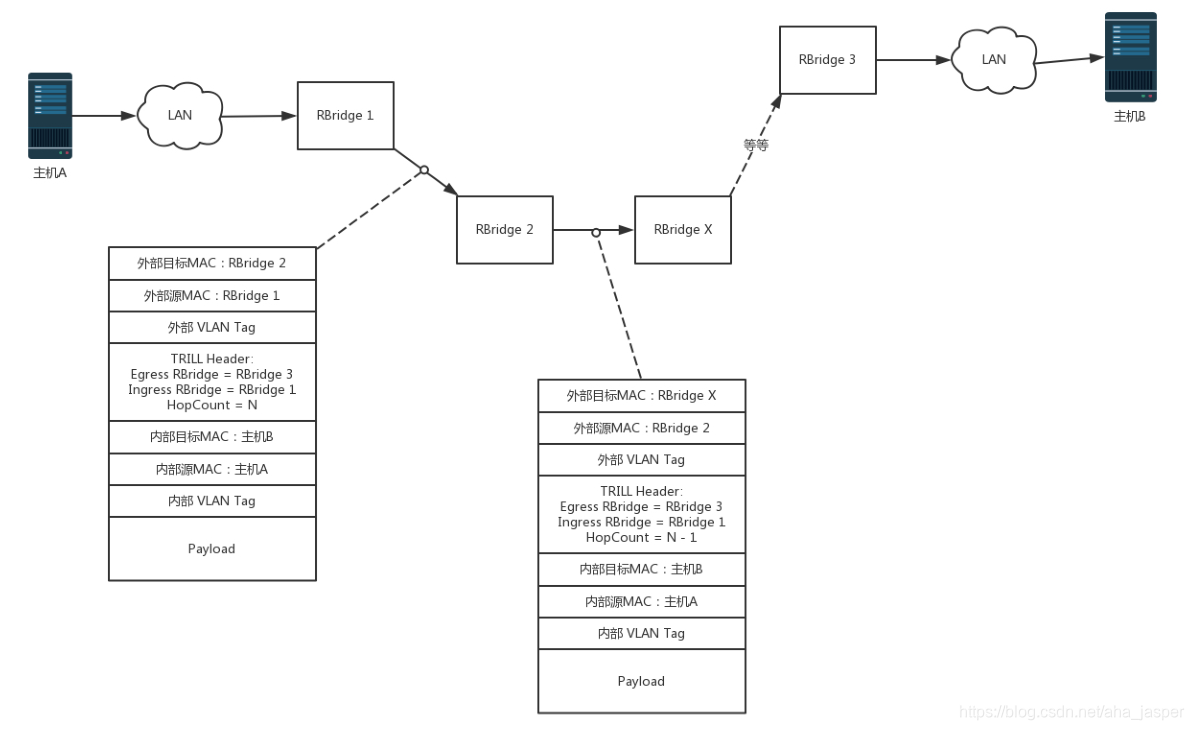

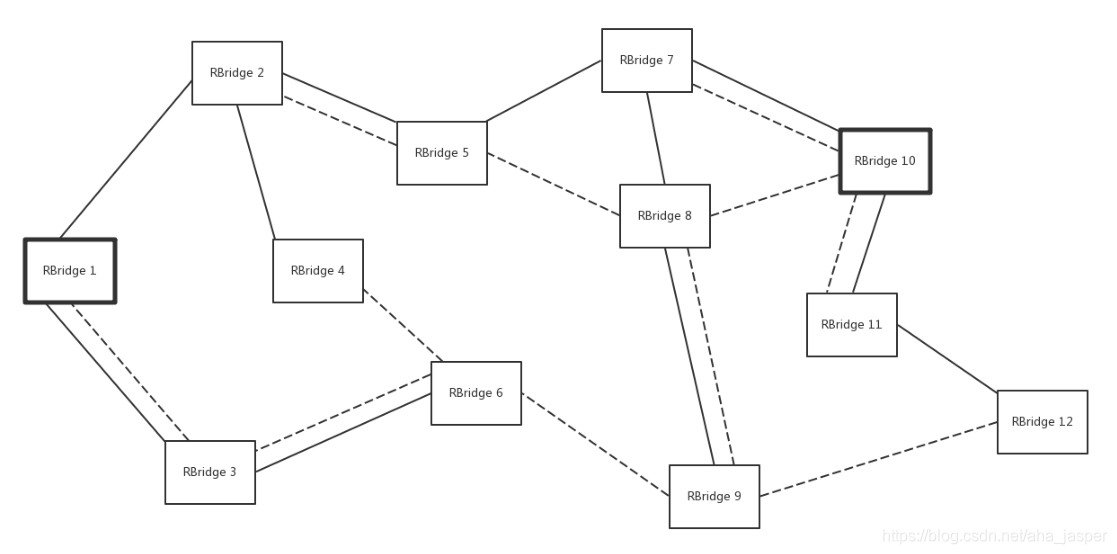

O switch que executa o protocolo TRILL é chamado RBridge , que é um dispositivo de ponte com características de roteamento e encaminhamento , mas essa rota é baseada no endereço MAC, não no IP.

O Rbridage opera através do protocolo de estado do link . Lembra-se deste protocolo de roteamento? Por meio dele, você pode aprender a topologia de toda a Camada 2 e saber qual MAC deve ser acessado a partir de qual ponte; você também pode calcular o caminho mais curto e também pode usar o roteamento de custo igual para balanceamento de carga e alta disponibilidade.

O protocolo TRILL adiciona seu próprio cabeçalho ao cabeçalho MAC original e ao cabeçalho MAC externo. O Ingress RBridge no cabeçalho TRILL é um pouco como o endereço IP de origem no cabeçalho IP.Egress RBridge é o endereço IP de destino.Esses dois endereços são de ponta a ponta e não serão alterados durante o roteamento intermediário. O MAC externo pode ter uma ponte para o próximo salto, assim como o próximo salto para roteamento também é apresentado pelo endereço MAC.

Conforme mostrado no processo mostrado na figura, há um pacote a ser enviado do host A para o host B, através do RBridge 1, RBridge 2, RBridge X, etc. até RBridge 3. O pacote recebido pelo RBridge 2 é dividido em duas camadas: a camada interna é o endereço MAC e a VLAN interna do host tradicional A e do host B.

Primeiro, adicione um cabeçalho TRILL à camada externa, que descreve que o pacote vem do RBridge 1, precisa sair do RBridge 3 e tem a mesma contagem de saltos do endereço IP da camada 3. Do lado de fora, o MAC de destino é o RBridge 2, o MAC de origem é o RBridge 1 e a VLAN externa.

Quando o RBridge 2 recebe esse pacote, verifique primeiro se o MAC é o seu próprio MAC.Se for, depende se é o Egress RBridge, ou seja, se é o último salto; Encontre o próximo salto RBridge X de maneira semelhante para rotear a pesquisa e envie o pacote.

Nos pacotes enviados pelo RBridge 2, as informações internas permanecem inalteradas e o cabeçalho TRILL externo está dentro. Da mesma forma, ao descrever que esse pacote vem do RBridge 1, ele deve sair do RBridge 3, mas a contagem de saltos é reduzida em 1. O MAC de destino da camada externa se torna RBridge X e o MAC de origem se torna RBridge 2.

Isso continua encaminhando até o RBridge 3, descompacta a camada externa e envia o pacote da camada interna para o host B.

Esse processo é muito semelhante ao roteamento IP?

Para o grande pacote de difusão de segunda camada, ele também precisa ser realizado pela tecnologia da árvore de distribuição. Sabemos que STP é um gráfico com um anel e uma árvore é formada pela remoção de arestas, e a árvore de distribuição é um gráfico com um anel para formar várias árvores.As árvores diferentes têm VLANs diferentes e alguns pacotes de transmissão são transmitidos pela VLAN A Alguns transmitem da VLAN B para obter balanceamento de carga e alta disponibilidade.

Fora do switch principal está o roteador de borda. Nesse ponto, a hierarquia do servidor para o limite do datacenter é clara.

No comutador principal, geralmente existem alguns dispositivos de segurança, como detecção de intrusão, proteção DDoS e assim por diante. Essa é uma barreira para todo o data center para impedir ataques externos. Muitas vezes existem balanceadores de carga no comutador principal, o princípio foi mencionado no capítulo anterior.

Em alguns centros digitais, para dispositivos de armazenamento, também haverá uma rede de armazenamento para conectar a SAN e o NAS. No entanto, para a nova computação em nuvem, SAN e NAS tradicionais não são usados, mas o armazenamento definido por software implementado em máquinas x86.Este armazenamento também é um servidor e pode ser integrado aos nós de computação em um rack, o que o torna mais Eficaz, não há rede de armazenamento separada.

Portanto, a rede de todo o data center é mostrada abaixo.

Essa é uma estrutura de rede típica de três camadas. A terceira camada aqui não se refere à camada IP, mas às três camadas da camada de acesso, da camada de convergência e da camada principal. Este modelo é muito útil para solicitações de tráfego externo para aplicativos internos. Esse tipo de fluxo é de fora para dentro ou de dentro para fora, correspondendo à figura acima, de cima para baixo, de baixo para cima, de norte a sul, por isso é chamado de tráfego norte-sul .

No entanto, com o desenvolvimento da computação em nuvem e do big data, há cada vez mais interação entre os nós. Por exemplo, a computação de big data geralmente precisa copiar dados para diferentes nós. Isso precisa passar pelo comutador para transformar os dados da esquerda para a direita. Da direita para a esquerda, esquerda oeste para direita leste, é chamado fluxo leste-oeste .

Para resolver o problema do tráfego leste-oeste, a Rede Leaf Ridge (Spine / Leaf) evoluiu .

- Chave folha (folha) , diretamente conectada ao servidor físico. O ponto de demarcação da rede L2 / L3 está no comutador de folhas e, acima do comutador de folhas, há uma rede de camada 3.

- Uma chave de coluna é equivalente a uma chave de núcleo. Múltiplos caminhos são selecionados dinamicamente entre cristas de folhas através do ECMP. O switch da coluna fornece apenas uma rede de roteamento L3 flexível para o switch leaf. O tráfego norte-sul pode ser enviado diretamente do comutador da coluna, mas através do comutador paralelo ao comutador de folhas e, em seguida, conectado ao roteador de borda.

A arquitetura de rede tradicional de três camadas é uma estrutura vertical, enquanto a arquitetura de rede de cumeeira é uma estrutura plana, mais fácil de expandir horizontalmente.

Sumário

Bem, é isso para datacenters complexos. Vamos resumir, você precisa se lembrar desses três pontos-chave.

- O data center é dividido em três andares. O servidor está conectado à camada de acesso, à camada de agregação, à camada principal e aos roteadores de borda mais externa e aos dispositivos de segurança.

- Todos os links no datacenter exigem alta disponibilidade. O servidor precisa estar vinculado a uma placa de rede e os comutadores precisam ser empilhados.Os dispositivos da camada 3 podem usar o roteamento de custo igual e os dispositivos da camada 2 podem usar o TRILL.

- Com o desenvolvimento de Yunhe Daxiju, o fluxo leste-oeste é cada vez mais importante que o fluxo norte-sul, por isso evolui para uma estrutura de rede de arestas.

Por fim, deixarei duas perguntas:

- Para o datacenter, a alta disponibilidade é muito importante e cada dispositivo deve considerar a alta disponibilidade.Esta alta disponibilidade na sala de computadores, você sabe o que fazer?

- As atividades acima mencionadas de navegar em notícias, fazer compras, baixar e assistir a vídeos são todos usuários comuns que acessam recursos no datacenter por meio da rede pública. Como os administradores de TI devem acessar o data center?