2.4 다른 통합

2.4.1Hive 통합 스파크

Spark整合hive,需要将hive_home下的conf下的hive_site.xml放到spark_home下的conf目录下。(3台服务器都做相同的配置)

[root@bigdata2 spark-2.3.0-bin-hadoop2.7]# cd $HIVE_HOME/conf

[root@bigdata2 conf]# cp hive-site.xml $SPARK_HOME/conf

당신이 방법으로 ./spark-sql 원사 실행을 사용하려면, 우리는 $ SPARK_HOME / 항아리 아래에 MySQL의 커넥터 - 자바-5.1.38.jar에 넣어 필요

2.4.2 하이브 통합 HBase를

(1) (사육사 주소) 구성 속성을 추가, 하이브-site.xml 파일을 수정

<property>

<name>hbase.zookeeper.quorum</name>

<value>bigdata2:2181,bigdata3:2181,bigdata4:2181,bigdata5:2181,bigdata6:2181</value>

</property>

(2) 도입 HBase를 종속성은

하이브에서 환경 변수에 패키지에서 설치 패키지 디렉토리 파일 lib 폴더 HBase를합니다

추가 hive-env.sh 파일 :

export HIVE_CLASSPATH=$HIVE_CLASSPATH:$HBASE_HOME/lib

상기 구성은 다른 시스템에 동기화 2

2.5 연결

2.5.1Cli 연결

2.5.2HiveServer2 / 직선

더 직선의 사용에 대해, 참조 : HTTPS : (더 자세한 hiveserver2 직선 구성 / 소개 한 함) //cwiki.apache.org/confluence/display/Hive/HiveServer2+Clients

现在使用的最新的hive版本是hive-2.3.5,都需要对hadoop集群做如下改变,否则无法使用。

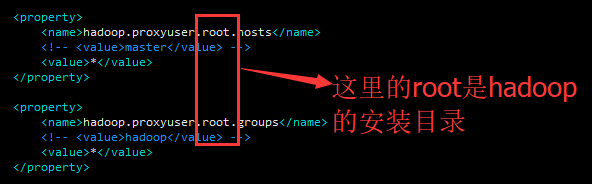

2.5.2.1 수정 하둡 클러스터 코어-site.xml 파일은 다음이다

<property>

<name>hadoop.proxyuser.root.hosts</name>

<!-- <value>master</value> -->

<value>*</value>

</property>

<property>

<name>hadoop.proxyuser.root.groups</name>

<!-- <value>hadoop</value> -->

<value>*</value>

</property>

즉 :

구성 분석 :

1, 감각 구성 hadoop.proxyuser.root.hosts *이 HDFS 루트 클러스터에 프록시 사용자가 액세스 할 수를 사용 하둡 클러스터의 노드를 나타냅니다.

2 hadoop.proxyuser.hadoop.groups 사용자 에이전트가 속하는 그룹이다.

. (3) 상기 루트 hadoop.proxyuser.root.hosts 하둡 사용자, 즉 하둡 설치 디렉토리이다.

다시 시작 클러스터 하둡 후 위부터 시행

2.5.2.2 수정은 하이브를 site.xml 다음과 :

<property>

<name>dfs.webhdfs.enabled</name>

<value>true</value>

</property>

<property>

<name>hive.server2.thrift.client.user</name>

<value>root</value>

<description>Username to use against thrift client</description>

</property>

<property>

<name>hive.server2.thrift.client.password</name>

<value>123456</value>

<description>Password to use against thrift client</description>

</property>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>hadoop1</value>

<description>Bind host on which to run the HiveServer2 Thrift service.</description>

</property>

<property>

<name>hive.server2.thrift.port</name>

<value>10000</value>

<description>Port number of HiveServer2 Thrift interface when hive.server2.transport.mode is 'binary'.</description>

</property>

<property>

<name>hive.server2.thrift.http.port</name>

<value>10001</value>

<description>Port number of HiveServer2 Thrift interface when hive.server2.transport.mode is 'http'.</description>

</property>

이 사용자 이름 루트, 암호가 운영 체제 로그인 이름과 암호입니다 있습니다.

그런 다음 실행 :

nohup hive --service hiveserver2 &

또는 유사한 실행은 다음과 같은 방법을 사용하여 :

nohup hiveserver2 1>/home/hadoop/hiveserver.log 2>/home/hadoop/hiveserver.err &

或者:nohup hiveserver2 1>/dev/null 2>/dev/null &

或者:nohup hiveserver2 >/dev/null 2>&1 &

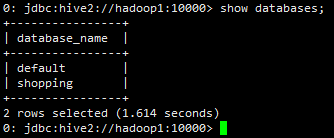

beenline 방법 로그인 :

beeline -u jdbc:hive2//hadoop1:10000 -n root

-u :指定元数据的连接信息

-n :指定用户名和密码

另外还有一种方式可以去连接

先执行beeline,然后再输入:!connect jdbc:hive2://hadoop1:10000

[root@hadoop1 apache-hive-2.3.4-bin]# bin/beeline

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/home/installed/apache-hive-2.3.4-bin/lib/log4j-slf4j-impl-2.6.2.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/home/installed/hadoop-2.8.5/share/hadoop/common/lib/slf4j-log4j12-1.7.10.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Beeline version 2.3.4 by Apache Hive

beeline> !connect jdbc:hive2://hadoop1:10000

Connecting to jdbc:hive2://hadoop1:10000

Enter username for jdbc:hive2://hadoop1:10000:

Enter password for jdbc:hive2://hadoop1:10000:

Connected to: Apache Hive (version 2.3.4)

Driver: Hive JDBC (version 2.3.4)

Transaction isolation: TRANSACTION_REPEATABLE_READ

0: jdbc:hive2://hadoop1:10000>

또 다른 예 :

[root@hadoop1 apache-hive-2.3.4-bin]# beeline -u jdbc:hive2://hadoop1:10000 -n root

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/home/installed/apache-hive-2.3.4-bin/lib/log4j-slf4j-impl-2.6.2.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/home/installed/hadoop-2.8.5/share/hadoop/common/lib/slf4j-log4j12-1.7.10.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.apache.logging.slf4j.Log4jLoggerFactory]

Connecting to jdbc:hive2://hadoop1:10000

Connected to: Apache Hive (version 2.3.4)

Driver: Hive JDBC (version 2.3.4)

Transaction isolation: TRANSACTION_REPEATABLE_READ

Beeline version 2.3.4 by Apache Hive

0: jdbc:hive2://hadoop1:10000>

2.5.3Hive WUI

일시적으로 약간

2.5.4와 다람쥐 SQL 클라이언트 통합

https://cwiki.apache.org/confluence/display/Hive/HiveServer2+Clients 하단에있는 소개가 포함되어 있습니다.

2.5.5 및 Oracle SQL 개발자 통합

오라클의 통합 할 수 SQLDevelopers

https://community.hortonworks.com/articles/1887/connect-oracle-sql-developer-to-hive.html