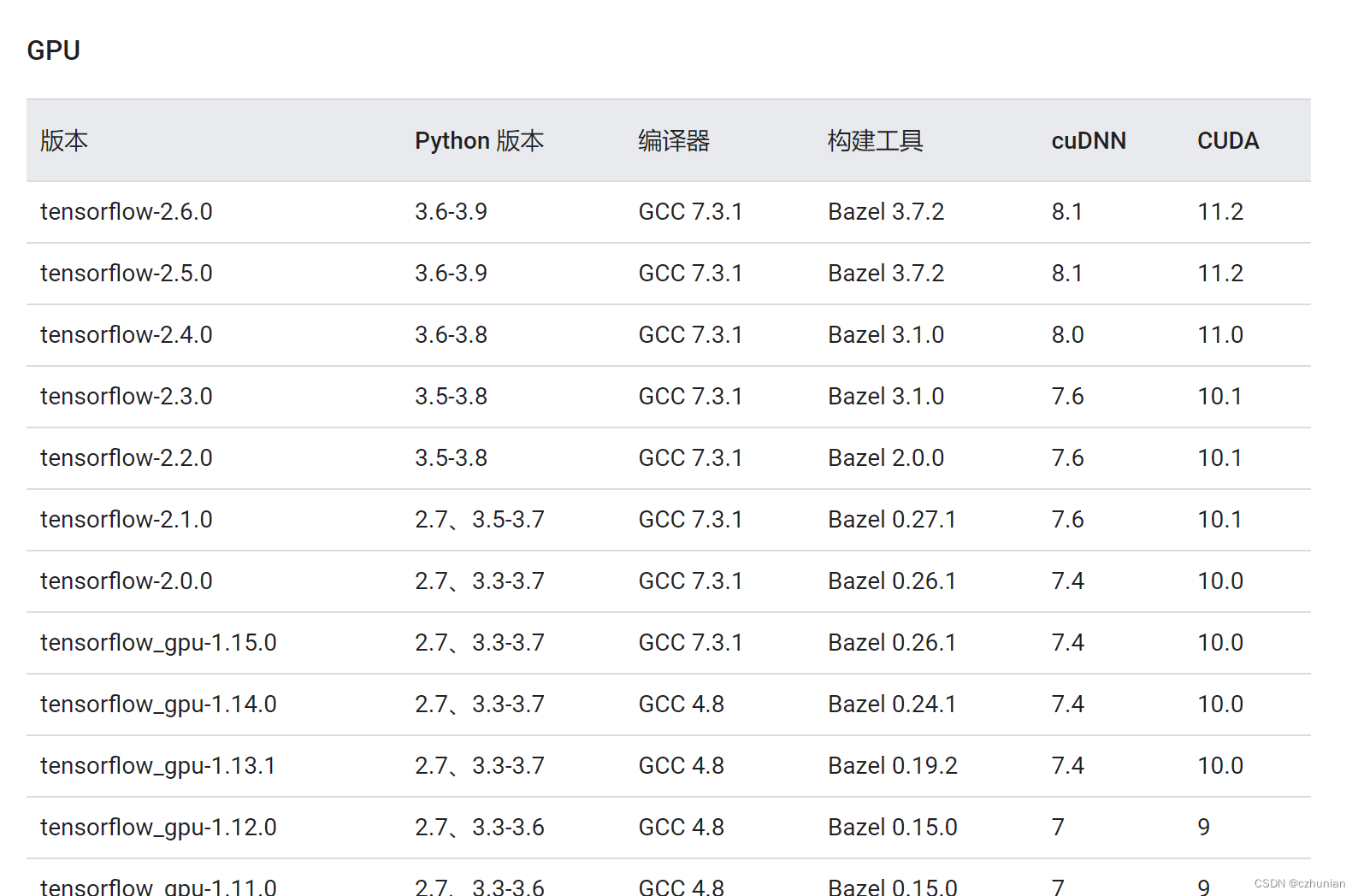

1. cuda のインストール、cuda と TensorFlow のバージョンは対応しています、リンクhttps://www.tensorflow.org/install/source#tested_source_configurations

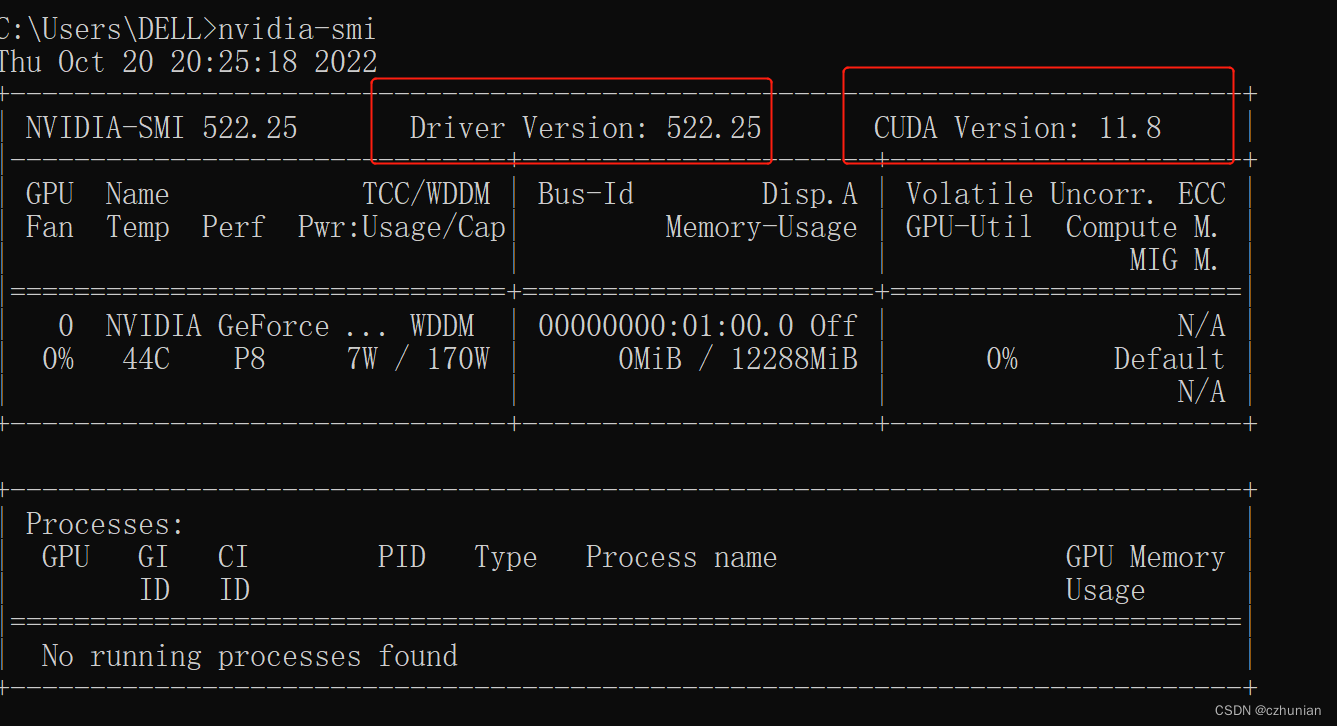

1. 自分でインストールしたドライバーのバージョンを確認します (nvidia-smi)

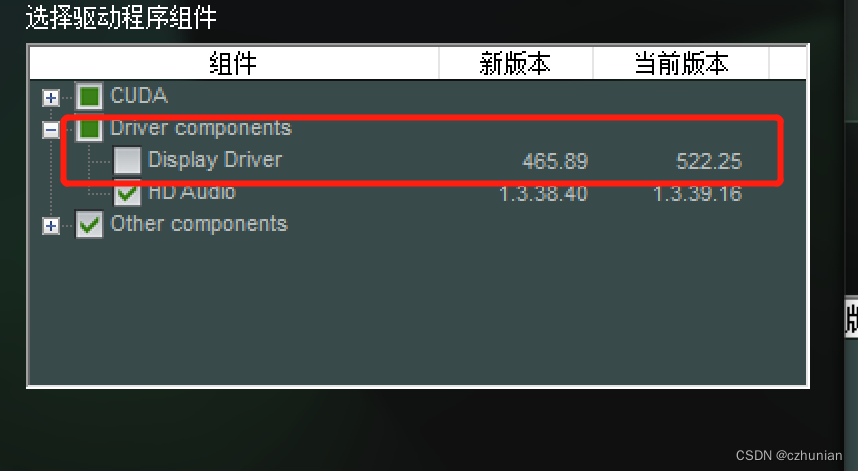

2. 必要な cuda をインストールし、ダウンロード リンクCUDA Toolkit Archive | NVIDIA Developer

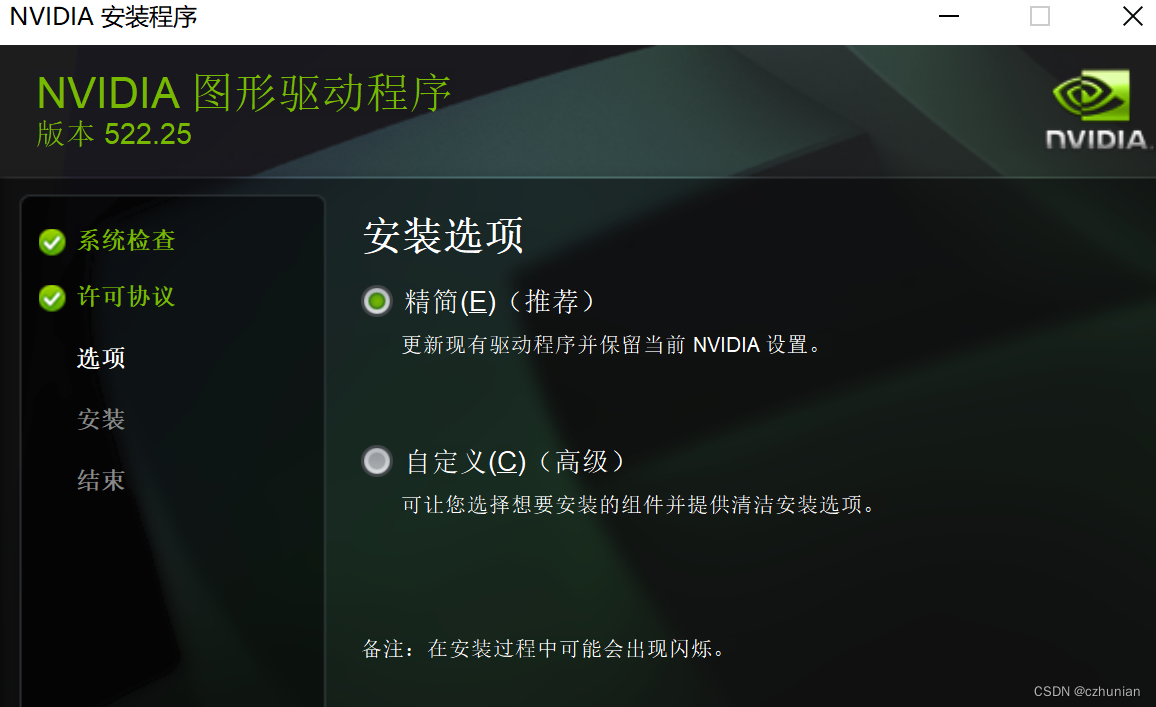

必要なバージョンを見つけて、対応する環境をダウンロードし、インストールをカスタマイズし、新しいドライバーのバージョンを確認します。現在のバージョンより高くない場合は、インストールしないでください。

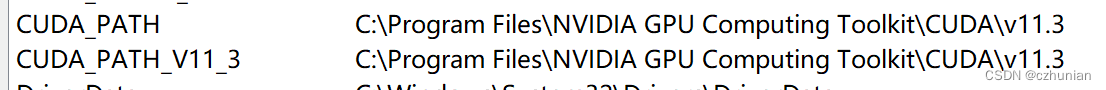

インストールが成功したら、環境変数を構成し、インストール パスを覚えておいてください。

(インストールに失敗した場合は、ドライバーをアンインストールし、再度インストールすると成功します。アンインストールにはソフトウェア 抽出コード: 1233 を使用できます。)

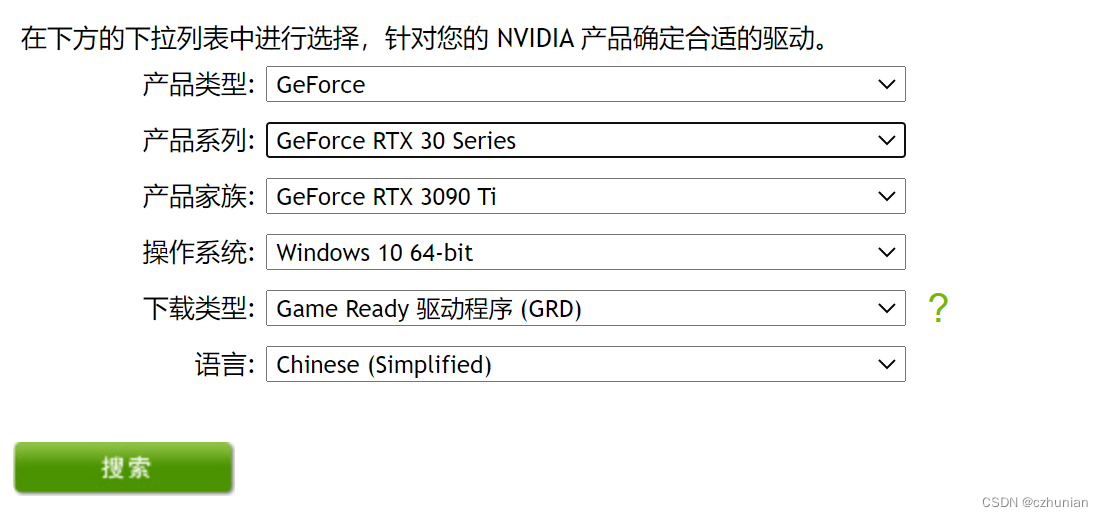

(cudatookit が正常にインストールされていて、グラフィックス カードが見つからない場合は、公式Webサイト

からドライバーをインストールするだけです)

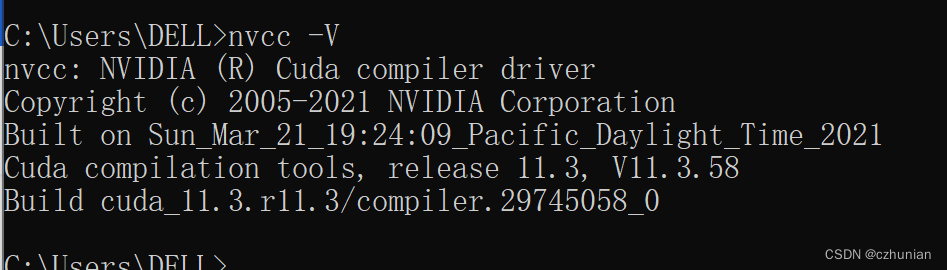

インストールされているcudaのバージョンを確認する

ここでのバージョンは、nvidia-smi に対応する cuda バージョンとは異なります。以下の 4 番目の点の説明を参照してください。

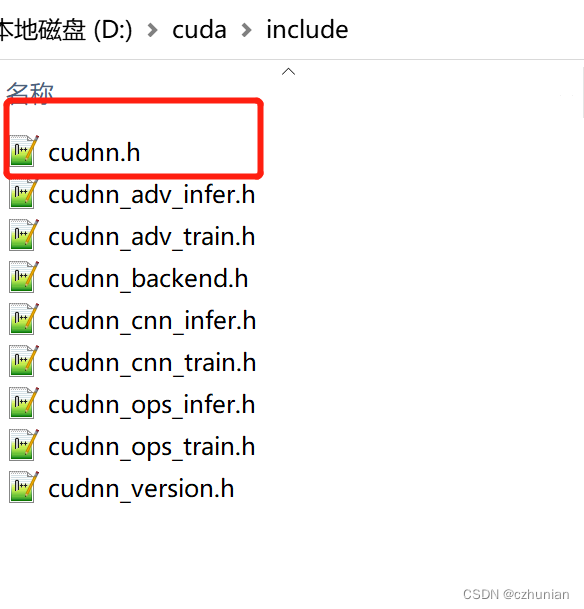

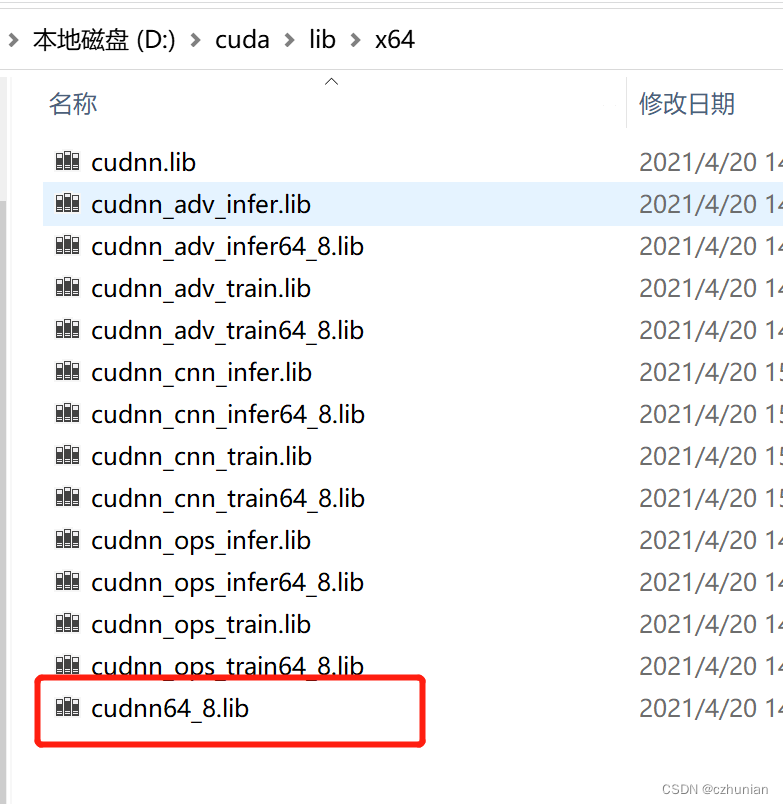

2. cuDNNニューラルネットワーク加速ライブラリのインストール

cuDNN はアプリケーション プログラムではなく、いくつかのファイル パッケージです。ダウンロード後、CUDA ディレクトリにコピーするだけです。

cuDNN ダウンロード ページ: cuDNN ダウンロード ページ(対応するバージョンを覚えておいてください。上記を参照してください)

cuDNN は実際には CUDA の単なるパッチであり、深層学習操作用に最適化されています。

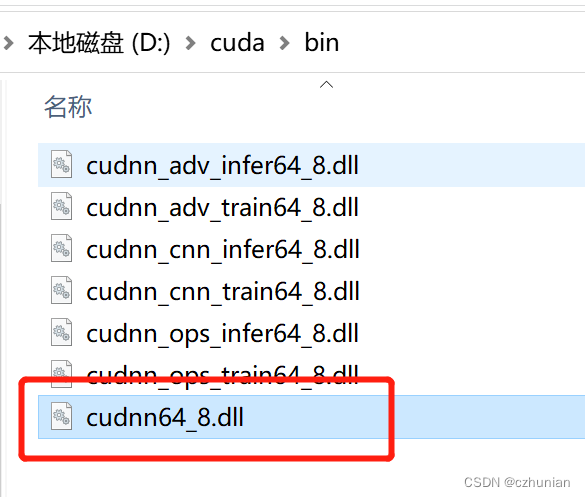

次のファイル (lib、bin など) を v11.3 ディレクトリの下の対応するディレクトリにコピーします。

または、これら 3 つのディレクトリを v11.3 ディレクトリに直接コピーします (ファイル コピーを上書きしないでください)。

3. TensorFlow2.5-GPU バージョンをインストールします

1. 指定されたバージョンの TensorFlow2.5 をインストールします。ここでは、wheel ファイルを直接ダウンロードして、仮想環境を作成します (conda の作成) チュートリアル conda install Pytorch (GPU)_czhunian のブログ-CSDN blog_conda install pytorch gpu

2. ホイールのリンクをダウンロードしますhttps://github.com/fo40225/tensorflow-windows-wheel

対応するバージョンを選択し、このバージョンのすべてのファイルをダウンロードします。

3. 仮想環境で、conda で tf2 をアクティブ化し、仮想環境に入り、wheel ファイル パスに切り替え、pip install コマンドでインストールします。

4. テストします。出力 True は、インストールが成功したことを意味します。

import tensorflow as tf

tf.test.is_gpu_available()4. Cuda と NVIDIA ドライバーのバージョンの関係、リンク

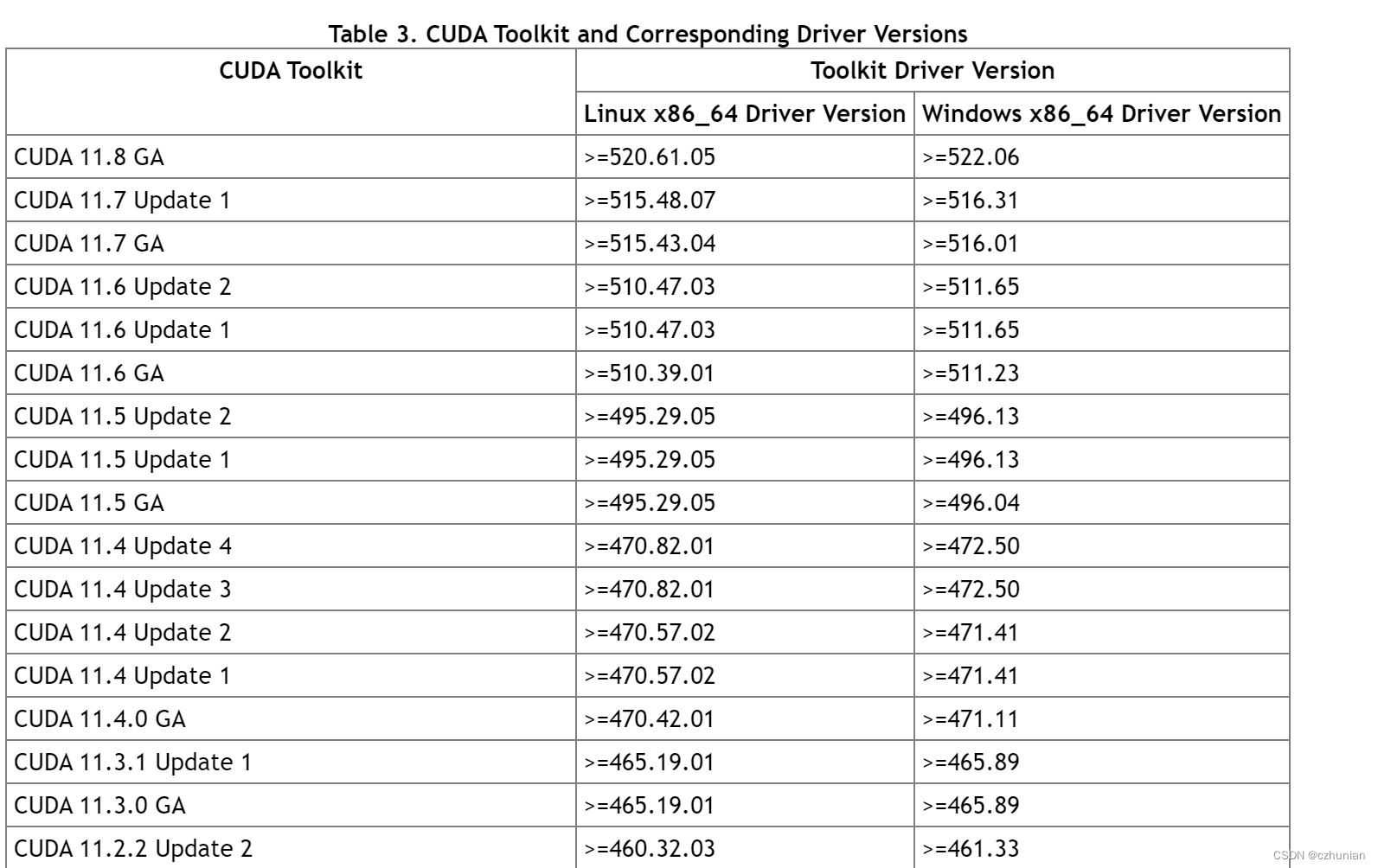

主に表 3、cuda バージョンとドライバーの関係を見てください。

CUDAドライバーバージョンの表示(ドライバーバージョン):NVIDIA GPUドライバーバージョン(nvidia-smi)

CUDA ランタイム バージョンの表示 (ランタイム バージョン):自分でインストールした cudatoolkit パッケージ (nvcc -V)

- ドライバー API

libcuda.so(例)をサポートするために必要なファイルは、GPU ドライバー インストーラーによってインストールされます。nvidia-smiこれは、このカテゴリの API に属します。 - ランタイム API ( や など

libcudart.so)nvccをサポートするために必要なファイルは、CUDA Toolkit インストーラによってインストールされます。(CUDA Toolkit インストーラーは GPU ドライバー インストーラーを統合する場合があります)。nvccは、CUDA ツールキットとともにインストールされる CUDA コンパイラ ドライバー ツールです。このツールキットは、ビルドに使用された CUDA ランタイム バージョンのみを認識します。どのバージョンの GPU ドライバーがインストールされているか、または GPU ドライバーがインストールされているかどうかさえもわかりません。

要約すると、ドライバー API とランタイム API の CUDA バージョンに一貫性がない場合は、CUDA Toolkit インストーラーの GPU ドライバー インストーラーではなく、別の GPU ドライバー インストーラーを使用していることが原因である可能性があります。

要約すると、ドライバーのバージョンはランタイムのバージョンと競合しません (ここでは、ランタイムがドライバーのバージョンより大きいことはできないはずです)。CUDA Toolkit (ランタイム) は本質的に単なるツールキットであり、複数の cudatoolkit バージョンをインストールすることもできます。 、経由 環境変数を変更して、使用する cuda のバージョンを選択します。

V. まとめ

グラフィックス カード ドライバーのバージョン >= 対応する cudatoolkit バージョン <= 対応する tensorflow バージョン;したがって、cuda はブリッジです。

1. インストールする tensorflow バージョンを決定します。

2. tensorflow バージョンに従って、cudatoolkit のバージョンを決定し、cudann のバージョンを決定します。

3. cuda のバージョンに従って、グラフィックス カード ドライバーのバージョンを決定し、十分でない場合はアップグレードし、十分な場合は無視します。