新しい Zhiyuan レポート

編集者:編集部[新芝源の紹介] Nvidia は再び戦略を拡大し、今度はスーパー GPU GH200 を直接使用して市場を爆発させました。

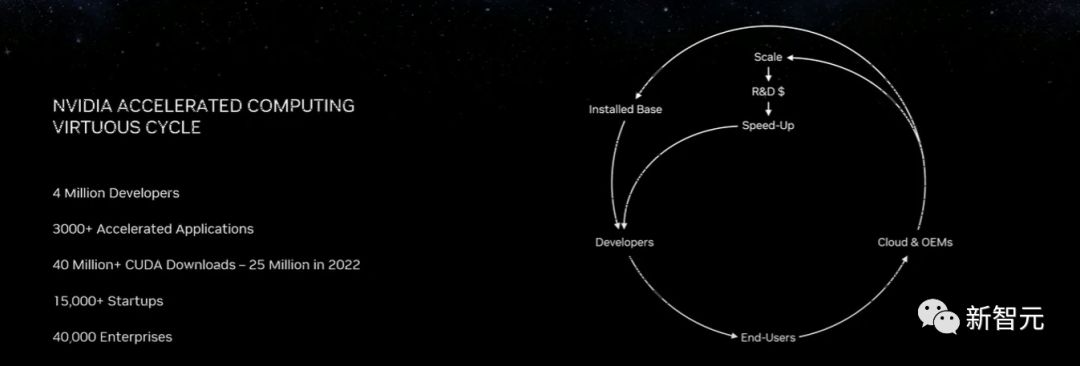

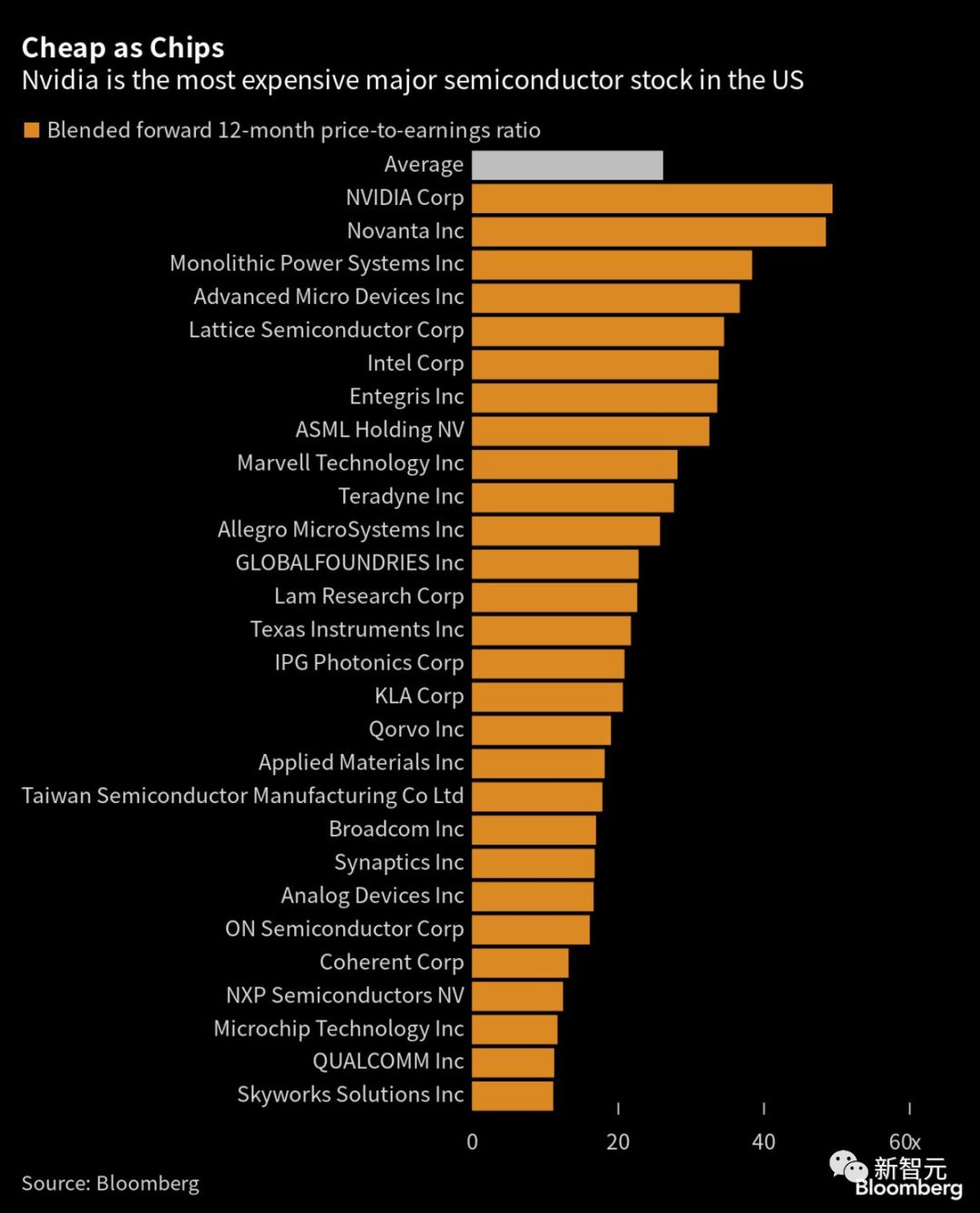

本日の COMPUTEX カンファレンスで、Nvidia CEO の Huang Renxun は、生成 AI の転換点に到達した ことを世界に発表しました。それ以来、世界のあらゆる場所でコンピューティングのニーズが存在することになります。 株価が 2,000 億ドル急騰した Nvidia は、すでにこの瞬間に備えています。 冒頭、黒のレザーに身を包んだラオ・ファン氏が「皆さん、こんにちは!帰ってきました!」と熱弁してステージに登場し、 次に大物キラーである「スーパーGPU」GH200を持ち出し、Google Cloud、Meta、 Microsoft が GH200 を最初に入手することになります。

3,500人以上が現場に集まり、2時間に及ぶ熱弁を体験したと言われています。

4年ぶり、長い間離れていたラオ・ファンさんも中国語が堪能になった。

3,500人以上が現場に集まり、2時間に及ぶ熱弁を体験したと言われています。

4年ぶり、長い間離れていたラオ・ファンさんも中国語が堪能になった。

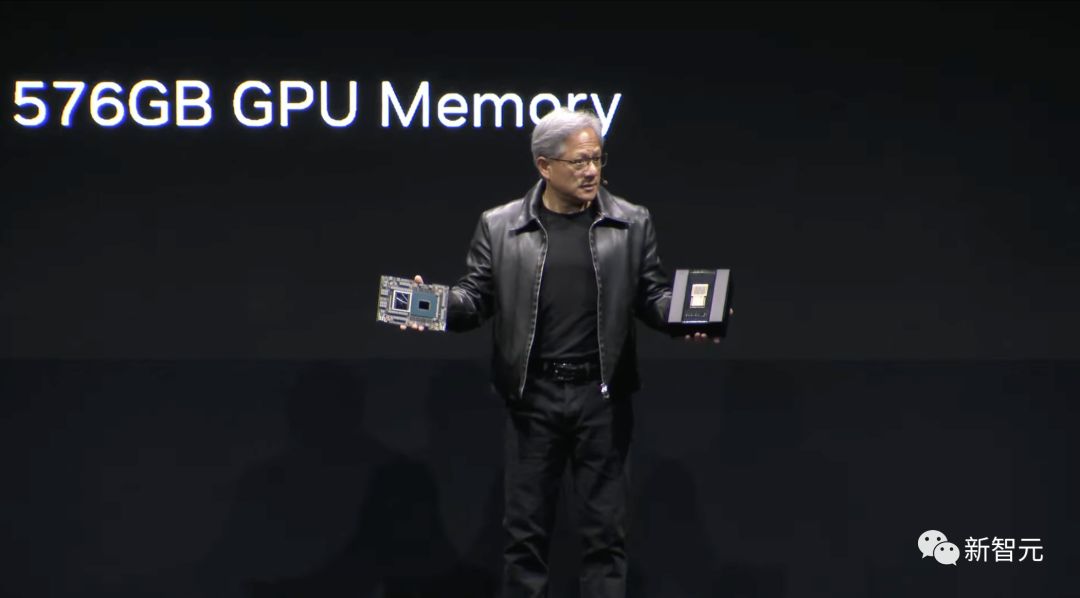

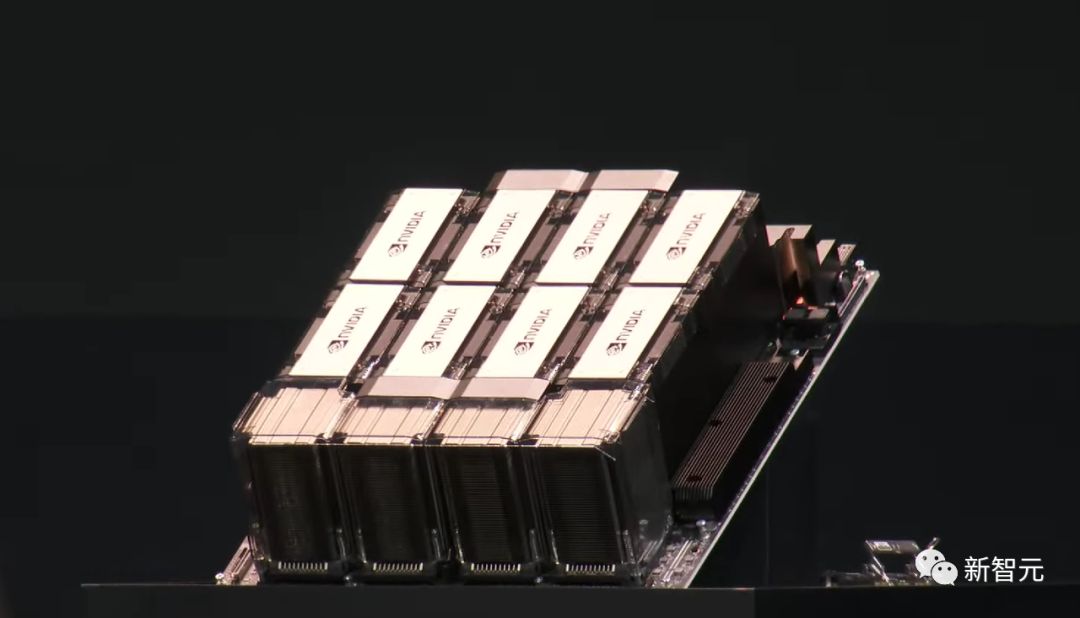

「スーパーチップ」GH200

この「スーパー GPU」は、NVLink-c2c 相互接続テクノロジーを使用して、ARM ベースの省エネ Grace CPU と高性能 NVIDIA H100 Tensor コア GPU を組み合わせ、最大 900GB/秒の総帯域幅を提供します。

現在、GH200 がサポートするシステムには 400 を超えるシステム構成が追加されています。

これらのシステム構成は、Nvidia の最新の CPU、GPU、DPU アーキテクチャのさまざまな組み合わせによって強化されています。

これらには、生成 AI に対する需要の高まりに応えるために作成されたアーキテクチャである Grace、Hopper、Ada Lovelace、BlueField が含まれます。

この「スーパー GPU」は、NVLink-c2c 相互接続テクノロジーを使用して、ARM ベースの省エネ Grace CPU と高性能 NVIDIA H100 Tensor コア GPU を組み合わせ、最大 900GB/秒の総帯域幅を提供します。

現在、GH200 がサポートするシステムには 400 を超えるシステム構成が追加されています。

これらのシステム構成は、Nvidia の最新の CPU、GPU、DPU アーキテクチャのさまざまな組み合わせによって強化されています。

これらには、生成 AI に対する需要の高まりに応えるために作成されたアーキテクチャである Grace、Hopper、Ada Lovelace、BlueField が含まれます。

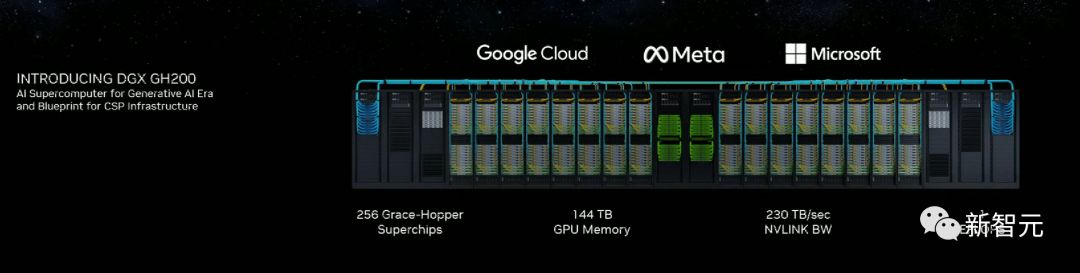

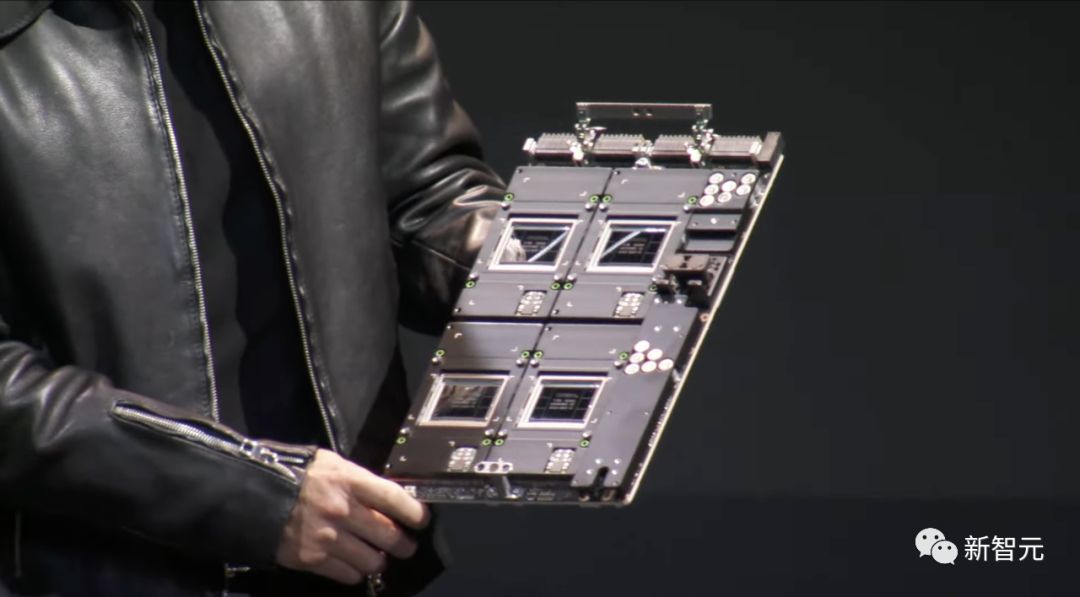

さらに、Lao Huang 氏はさらに重要なことも発表しました。それは、256 台の GH200 で構成されるスーパーコンピューターが登場するということです。

さらに、Lao Huang 氏はさらに重要なことも発表しました。それは、256 台の GH200 で構成されるスーパーコンピューターが登場するということです。

今年発売されたスーパーコンピュータ「DGX GH200」

Nvidia によると、新しい DGX GH200 人工知能スーパーコンピューティング プラットフォームは、大規模な生成 AI 負荷向けに設計されています。 256 個の Grace Hopper スーパー チップで構成されるこのスーパーコンピューターは、最大 1 エクサフロップの並外れた AI パフォーマンスと 144 TB の共有メモリ (前世代の DGX A100 のほぼ 500 倍) を備えています。 たとえば、GPT-3 トレーニングでは、前世代の DGX H100 クラスターよりも 2.2 倍高速になる可能性があります。 さらに、この巨大企業には 150 マイルの光ファイバーと 2,000 台を超えるファンが組み込まれています。 現在、Nvidia は Google、Meta、Microsoft の 3 つの巨人と協力しています。

生成人工知能の爆発的な成長により、Microsoft や Google などの大手企業は、より強力でパフォーマンスの優れたシステムを望んでいます。

DGX H200 は、Nvidia のカスタム NVLink スイッチ チップを使用して、InfiniBand やイーサネットなどの標準クラスタ接続の制限を回避し、最大のワークロードの大規模なスケーラビリティのための最大のスループットを提供するように設計されています。

生成人工知能の爆発的な成長により、Microsoft や Google などの大手企業は、より強力でパフォーマンスの優れたシステムを望んでいます。

DGX H200 は、Nvidia のカスタム NVLink スイッチ チップを使用して、InfiniBand やイーサネットなどの標準クラスタ接続の制限を回避し、最大のワークロードの大規模なスケーラビリティのための最大のスループットを提供するように設計されています。

さらに、NVIDIA は、独自の大規模 AI スーパーコンピューター「NVIDIA Helios」を構築中で、今年稼働する予定であると述べた。

NVIDIA Quantum-2 InfiniBand ネットワークに接続された 4 台の DGX GH200 システムを使用して、大規模な AI モデルをトレーニングするためのデータ スループットを向上させます。

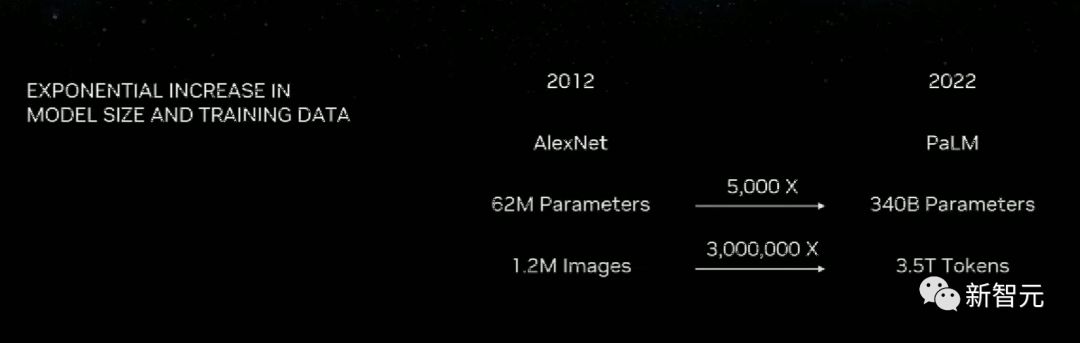

以前は、データセンターは非常に大規模で CPU ベースであり、アルゴリズムの反復に長い時間がかかり、アルゴリズムのほとんども CPU 中心でした。

現在、Grace Hopper を使用すると、このプロセスを数日、場合によっては数時間で行うことができます。業界全体に革命を起こすことになるでしょう!

さらに、NVIDIA は、独自の大規模 AI スーパーコンピューター「NVIDIA Helios」を構築中で、今年稼働する予定であると述べた。

NVIDIA Quantum-2 InfiniBand ネットワークに接続された 4 台の DGX GH200 システムを使用して、大規模な AI モデルをトレーニングするためのデータ スループットを向上させます。

以前は、データセンターは非常に大規模で CPU ベースであり、アルゴリズムの反復に長い時間がかかり、アルゴリズムのほとんども CPU 中心でした。

現在、Grace Hopper を使用すると、このプロセスを数日、場合によっては数時間で行うことができます。業界全体に革命を起こすことになるでしょう!

(待って、PaLM 540B のパラメータではないですか?)

(待って、PaLM 540B のパラメータではないですか?)

ラオ・ファン: 買えば買うほどお金が節約できます!

Lao Huang氏は、このような製品を買えば買うほど節約になると言えると述べました。

Lao Huang氏は、このような製品を買えば買うほど節約になると言えると述べました。

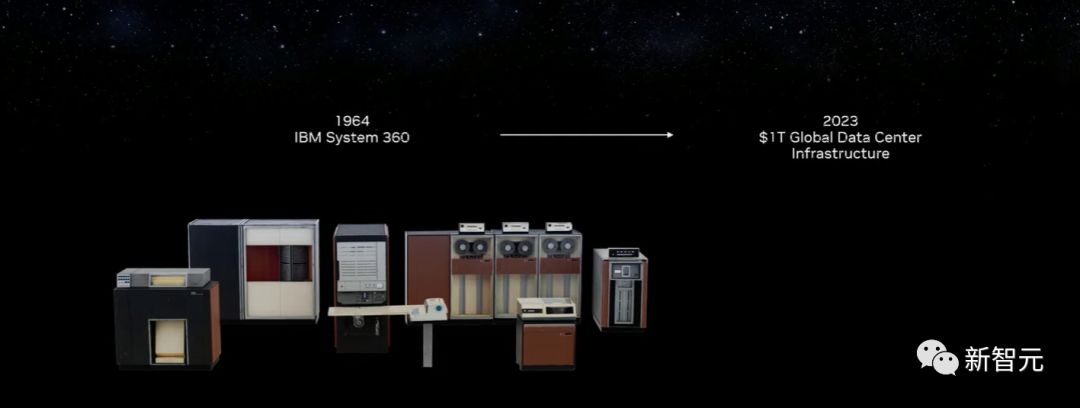

次に、老黄氏は 1964 年の IBM 360 について言及し、CPU の重要性を強調しました。

Lao Huang 氏は、「60 年が経ち、今ではデータセンターができました。今日、データセンターはコンピューターです。」と自信を持って繰り返しました。Lao

次に、老黄氏は 1964 年の IBM 360 について言及し、CPU の重要性を強調しました。

Lao Huang 氏は、「60 年が経ち、今ではデータセンターができました。今日、データセンターはコンピューターです。」と自信を持って繰り返しました。Lao

Huang 氏が述べたように、新しいコンピューティング モデルが作成されています。

Huang 氏が述べたように、新しいコンピューティング モデルが作成されています。

CPU を使用するよりも GPU を使用する方が優れているのはなぜですか?

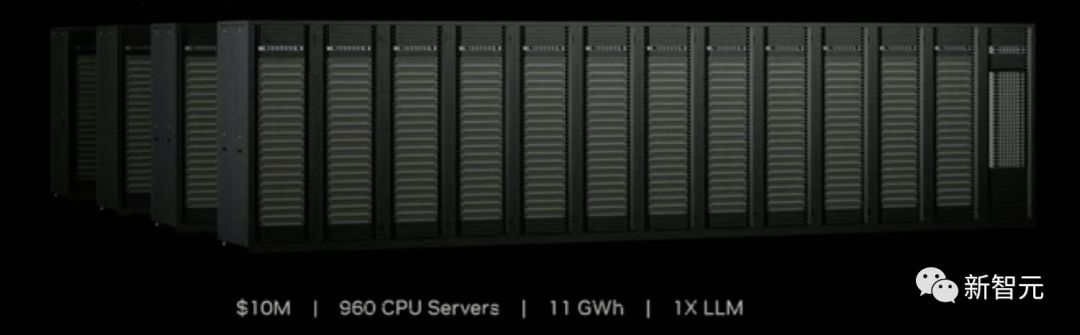

Lao Huang 氏は構成から分析を行いました。1,000 万米ドルのコストで 960 個の CPU を備えたデータセンターを構築できますが、このデータセンターには 1X LMM (Large Language Model) データ量を処理するために 11GWh の電力が必要です。

CPU を使用するよりも GPU を使用する方が優れているのはなぜですか?

Lao Huang 氏は構成から分析を行いました。1,000 万米ドルのコストで 960 個の CPU を備えたデータセンターを構築できますが、このデータセンターには 1X LMM (Large Language Model) データ量を処理するために 11GWh の電力が必要です。

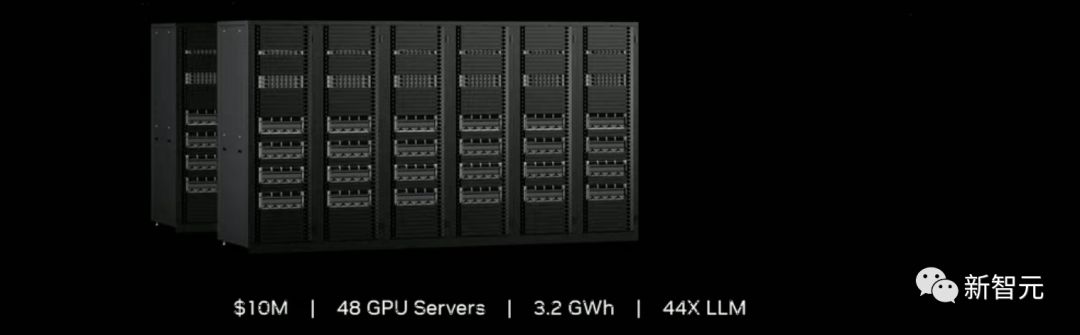

しかし、同じ金額で、48 個の GPU を備えたデータセンターを構築できますが、消費電力は 3.2GWh のみで、44 倍の LLM データ量を処理できます。

しかし、同じ金額で、48 個の GPU を備えたデータセンターを構築できますが、消費電力は 3.2GWh のみで、44 倍の LLM データ量を処理できます。

ご存知のように、このような構成は十分に素晴らしいです。しかし、これでは十分ではありません。

極限のパフォーマンスを得るには、同じ消費電力で GPU の数を 172 まで直接増やすことができます。

現時点での計算能力は、CPU データセンターの 150 倍にもなります。もちろん予算も3400万ドルに増額された。

ご存知のように、このような構成は十分に素晴らしいです。しかし、これでは十分ではありません。

極限のパフォーマンスを得るには、同じ消費電力で GPU の数を 172 まで直接増やすことができます。

現時点での計算能力は、CPU データセンターの 150 倍にもなります。もちろん予算も3400万ドルに増額された。

さらに、目の前の作業 (1X LLM) だけを完了したい場合、Lao Huang はコスト削減にも役立ちます - 2 つの GPU を備えたデータセンターをわずか 40 万米ドルで購入できます

。消費電力はわずか 0.13ギガワット時。

さらに、目の前の作業 (1X LLM) だけを完了したい場合、Lao Huang はコスト削減にも役立ちます - 2 つの GPU を備えたデータセンターをわずか 40 万米ドルで購入できます

。消費電力はわずか 0.13ギガワット時。

聴衆から拍手が起こり、ラオ・ファンは「買えば買うほど、節約できる」というマントラを取り出し、さらに3回繰り返しました。

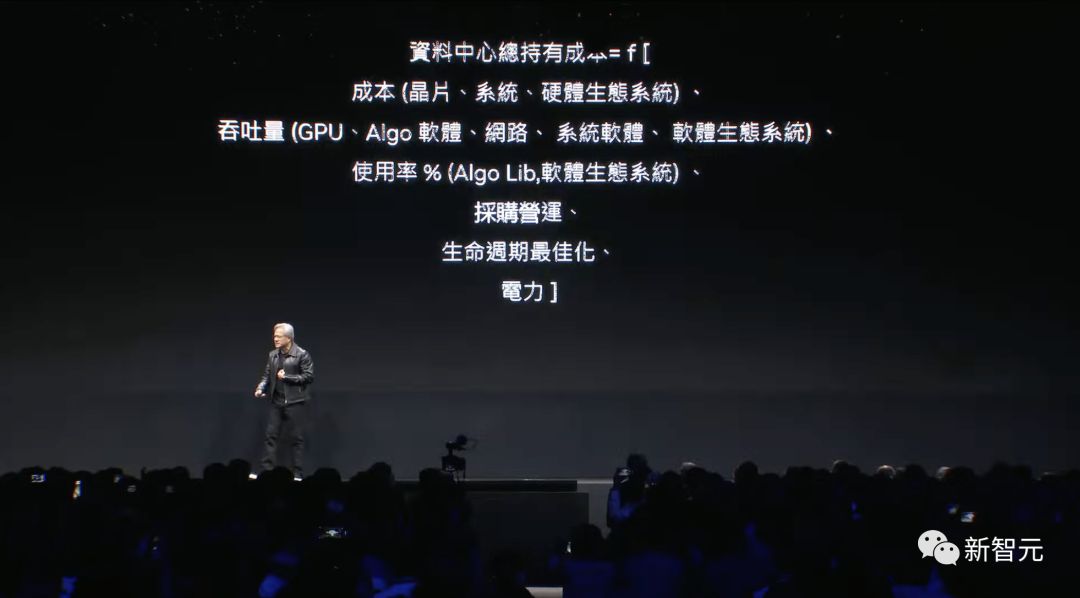

この背後にある戦略は何ですか? ラオ・ファンは公式を与えた。

聴衆から拍手が起こり、ラオ・ファンは「買えば買うほど、節約できる」というマントラを取り出し、さらに3回繰り返しました。

この背後にある戦略は何ですか? ラオ・ファンは公式を与えた。

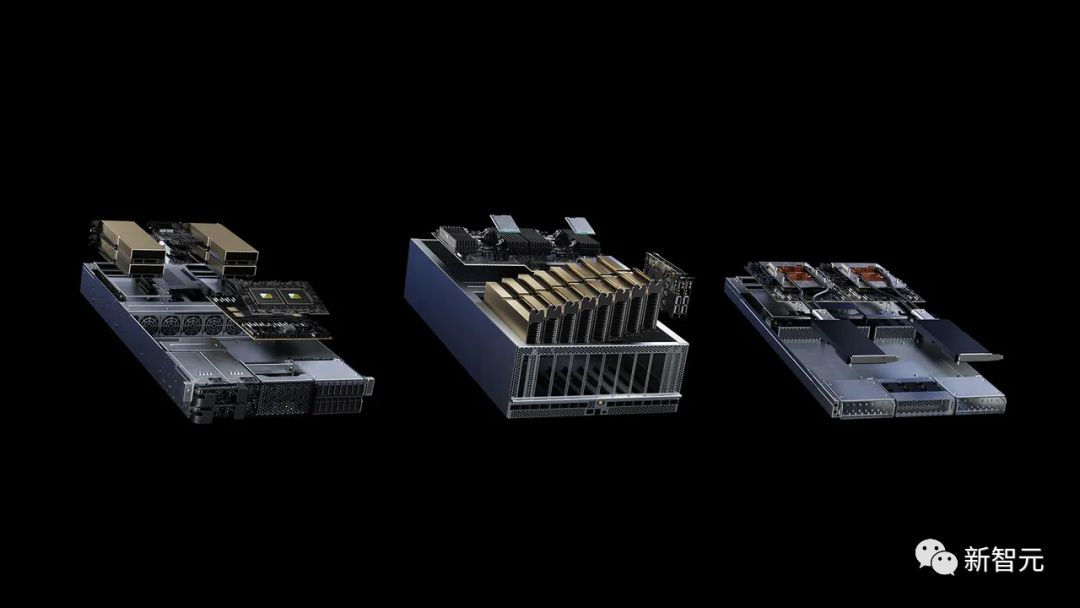

MGX: モジュラー アーキテクチャ

同時に、Huang 氏は、システム メーカーが 100 を超えるサーバー バリアントを迅速かつコスト効率よく構築するためのリファレンス アーキテクチャである NVIDIA MGXTM も発表しました。 この仕様により、開発コストが最大 4 分の 3 削減され、開発期間が 3 分の 2 のわずか 6 か月に短縮されると言われています。 MGX を使用すると、テクノロジー企業はサーバーのアクセラレーション コンピューティングの基本システム アーキテクチャを最適化し、独自の GPU、DPU、CPU を選択できます。 MGX は、クラウドやエンタープライズ データ センターにも簡単に統合できます。

ハードウェアに加えて、MGX は NVIDIA の完全なソフトウェア スタックでもサポートされており、開発者や企業は AI、HPC、その他のアプリケーションを構築および高速化できます。

これには、NVIDIA AI プラットフォームのソフトウェア レイヤーである NVIDIA AI Enterprise が含まれます。これは、AI とデータ サイエンスを加速する 100 以上のフレームワーク、事前トレーニング済みモデル、開発ツールを備え、エンタープライズ AI の開発と展開を完全にサポートします。

ハードウェアに加えて、MGX は NVIDIA の完全なソフトウェア スタックでもサポートされており、開発者や企業は AI、HPC、その他のアプリケーションを構築および高速化できます。

これには、NVIDIA AI プラットフォームのソフトウェア レイヤーである NVIDIA AI Enterprise が含まれます。これは、AI とデータ サイエンスを加速する 100 以上のフレームワーク、事前トレーニング済みモデル、開発ツールを備え、エンタープライズ AI の開発と展開を完全にサポートします。

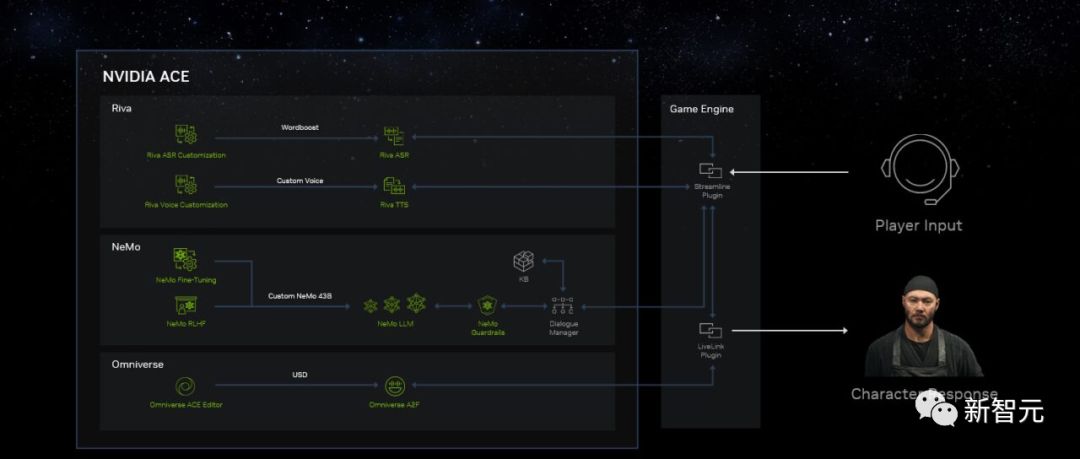

AIをゲームに導入し、リアルタイムボイスチャットを備えたNPCキャラクターが登場

この講演のハイライトは、新しいカスタム AI モデル ファウンドリ サービスである Avatar Cloud Engine (ACE) for Game です。 現場では、Lao Huang氏が右手にRTX 4060 Ti、左手にコンピューターを持ち、サイバーパンク2077でリアルタイムレイトレーシングを実行している様子をデモしていた。 「サイバーパンク」らしさあふれるラーメン屋のシーンで、プレイヤーがボタンを押して自分の声で話すと、店主のジンが答えます。 ジンは NPC キャラクターですが、彼の応答はプレイヤーの音声入力に基づいて生成 AI によってリアルタイムで生成されます。ジンには、プレイヤーの口調やバックストーリーに合わせたリアルな顔のアニメーションと声も備わっています。

このリアルなキャラクターの生成には、リアルタイム人工知能モデル レンダリング ツール Nvidia Ace が使用されます。

Lao Huang氏は、このゲームのキャラクターはプリセットされていないと述べました。彼らは典型的なクエストギバー NPC タイプを持っています。

このリアルなキャラクターの生成には、リアルタイム人工知能モデル レンダリング ツール Nvidia Ace が使用されます。

Lao Huang氏は、このゲームのキャラクターはプリセットされていないと述べました。彼らは典型的なクエストギバー NPC タイプを持っています。

ただし、ビデオを見ると、アバターの会話が少し堅苦しいことがわかりますが、それほど悪くはありません。

ただし、ビデオを見ると、アバターの会話が少し堅苦しいことがわかりますが、それほど悪くはありません。

AIの専門知識を持たない人は取り残される

40 年間、私たちは PC、インターネット、モバイル、クラウドを創造してきましたが、今は人工知能の時代です。 何を作りますか それが何であれ、私たちがやったようにそれを追いかけてください。歩くことではなく、走ること。食べ物を求めて逃げるか、逃げて食べ物になることを許すかのどちらかです。

5月27日、黄仁勲氏は国立台湾大学で卒業式のスピーチを行った。

今、彼は全世界の注目を集めています。

即座に兆のマスターに変身し、彼の言葉はさらに大胆になった。

黄仁勲氏は、すべての企業と個人が人工知能について精通すべきであり、そうでなければ失敗する危険があると述べた。

5月27日、黄仁勲氏は国立台湾大学で卒業式のスピーチを行った。

今、彼は全世界の注目を集めています。

即座に兆のマスターに変身し、彼の言葉はさらに大胆になった。

黄仁勲氏は、すべての企業と個人が人工知能について精通すべきであり、そうでなければ失敗する危険があると述べた。

同氏は、機敏な企業は人工知能を活用して自社の地位を向上させるだろうし、そのような企業は倒産しないだろうと強調した。

AIが仕事を奪うのではないかと心配する人も多いですが、本当に仕事を奪うのはAI技術を習得した人たちです。

その際、彼はスピーチの中で次のように予言しました:あらゆる観点から見て、AIの繁栄はコンピュータ産業の再生の機会です。今後 10 年間で、私たちの業界は数兆ドル規模の従来型コンピューターを新しい AI コンピューターに置き換えることになります。

今日の講演からは、その未来の原型が垣間見えた気がします。

同氏は、機敏な企業は人工知能を活用して自社の地位を向上させるだろうし、そのような企業は倒産しないだろうと強調した。

AIが仕事を奪うのではないかと心配する人も多いですが、本当に仕事を奪うのはAI技術を習得した人たちです。

その際、彼はスピーチの中で次のように予言しました:あらゆる観点から見て、AIの繁栄はコンピュータ産業の再生の機会です。今後 10 年間で、私たちの業界は数兆ドル規模の従来型コンピューターを新しい AI コンピューターに置き換えることになります。

今日の講演からは、その未来の原型が垣間見えた気がします。