Inhaltsverzeichnis

3.1. Übersicht über die Datenverbindungsschicht

Hosts, Router usw. im Netzwerk müssen die Datenverbindungsschicht implementieren

Hosts, Switches usw. im LAN müssen die Datenverbindungsschicht implementieren

Betrachten Sie den Datenfluss aus einer hierarchischen Perspektive

Beobachten Sie den Framefluss nur von der Datenverbindungsschicht

Von der Datenverbindungsschicht verwendete Kanäle

Zuverlässige Übertragung von Änderungen

Lösen Sie das Problem der transparenten Übertragung

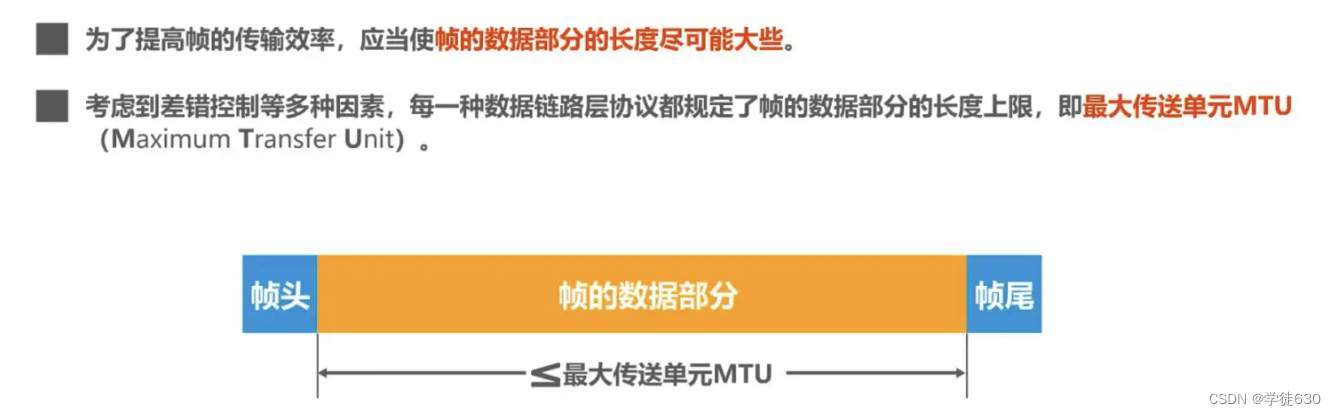

Die Länge des Datenteils des Frames

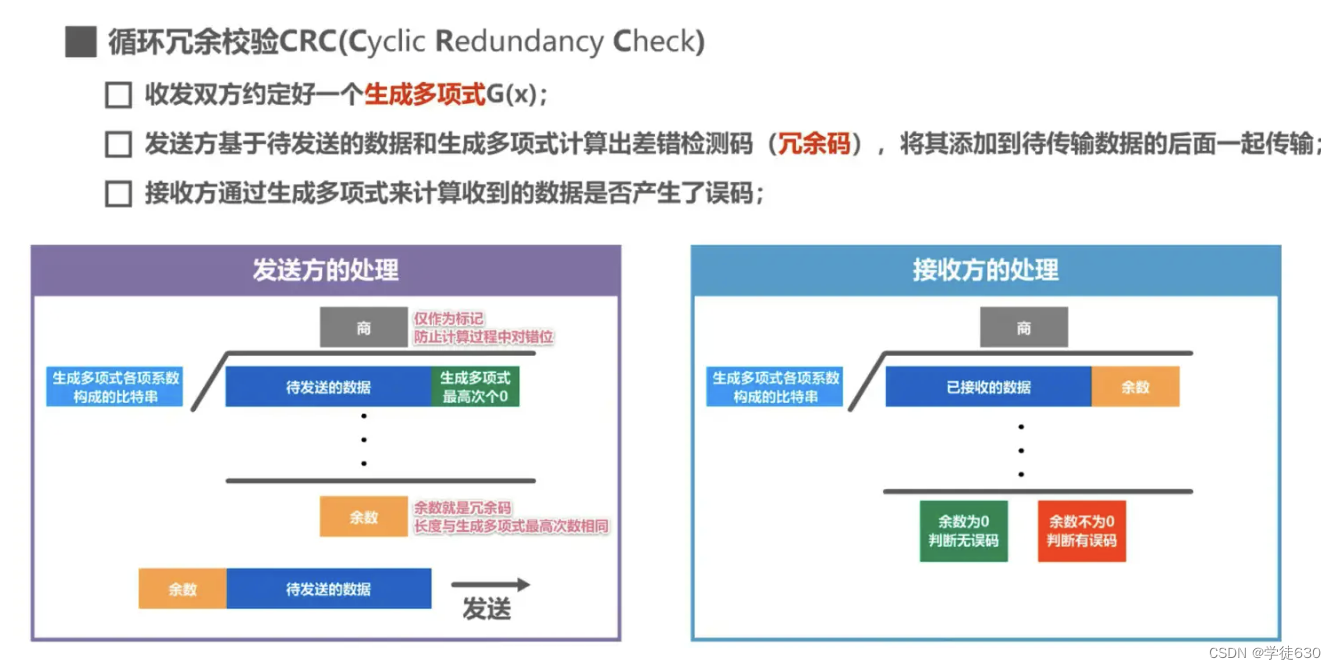

Zyklische Redundanzprüfung CRC (Zyklische Redundanzprüfung)

Auslastung des Stop-Wait-Protokollkanals

Fallback-N-Frame-Protokoll GBN

Warum das Fallback-N-Frame-Protokoll verwenden?

Es liegt eine Fehlersituation vor

Wählen Sie das Neuübertragungsprotokoll SR

3.5. Punkt-zu-Punkt-Protokoll PPP

3.6. Medienzugriffskontrolle (Medienzugriffskontrolle) – Sendekanal

Frequenzmultiplex FDM (Frequency Division Multiplexing)

Zeitmultiplex TDM (Time Division Multiplexing)

Wellenlängenmultiplex WDM (Wellenlängenmultiplex)

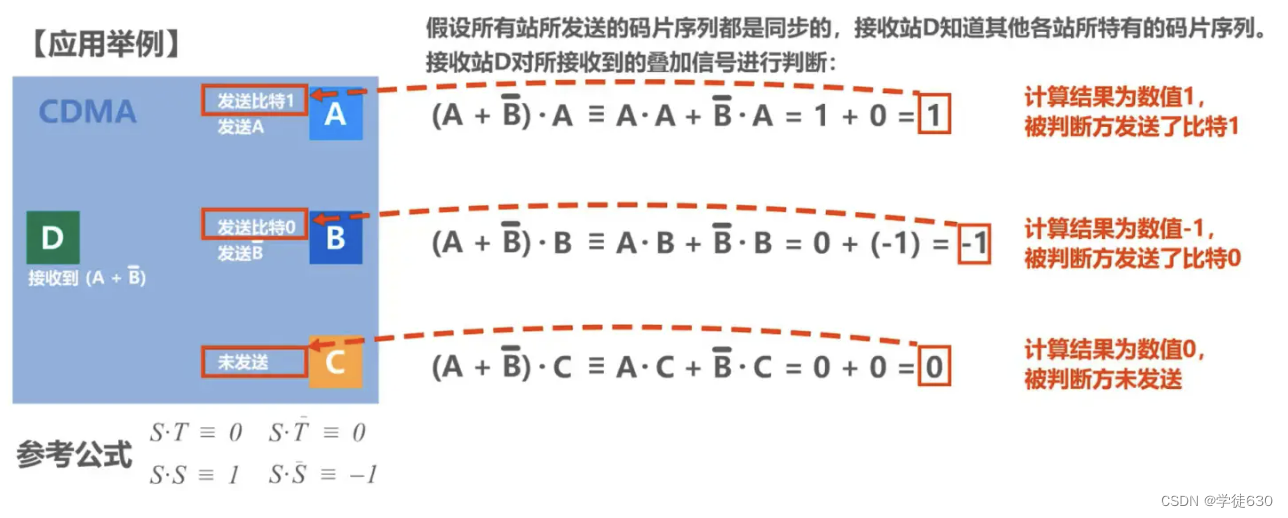

Codemultiplexing CDM (Codemultiplexing)

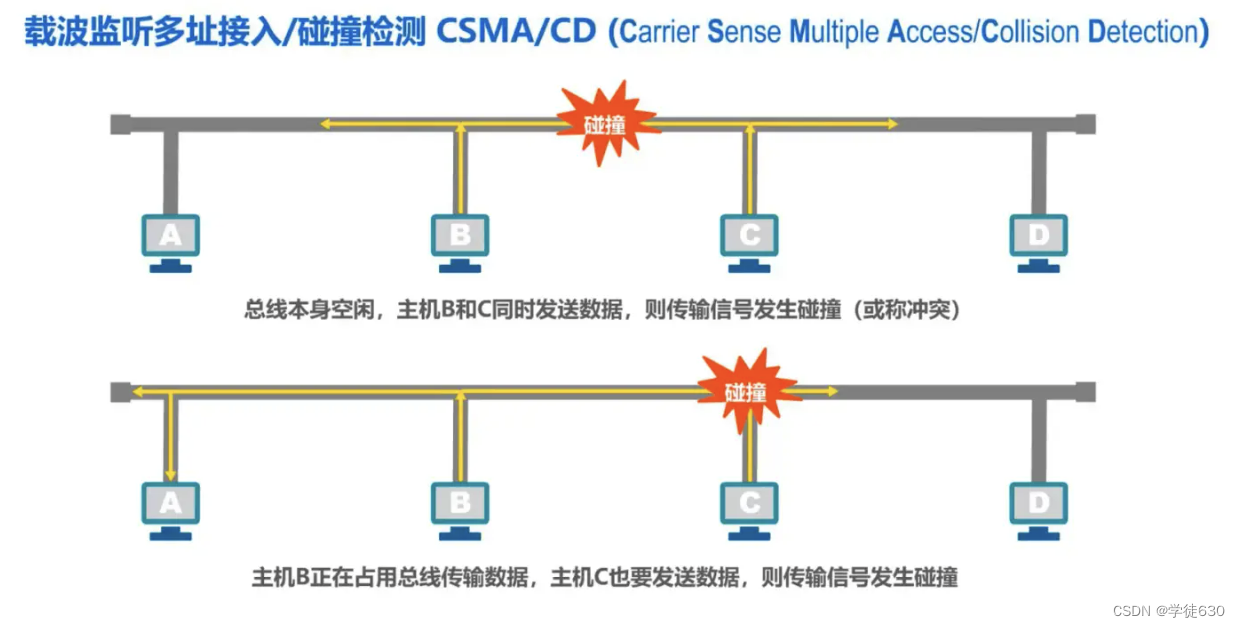

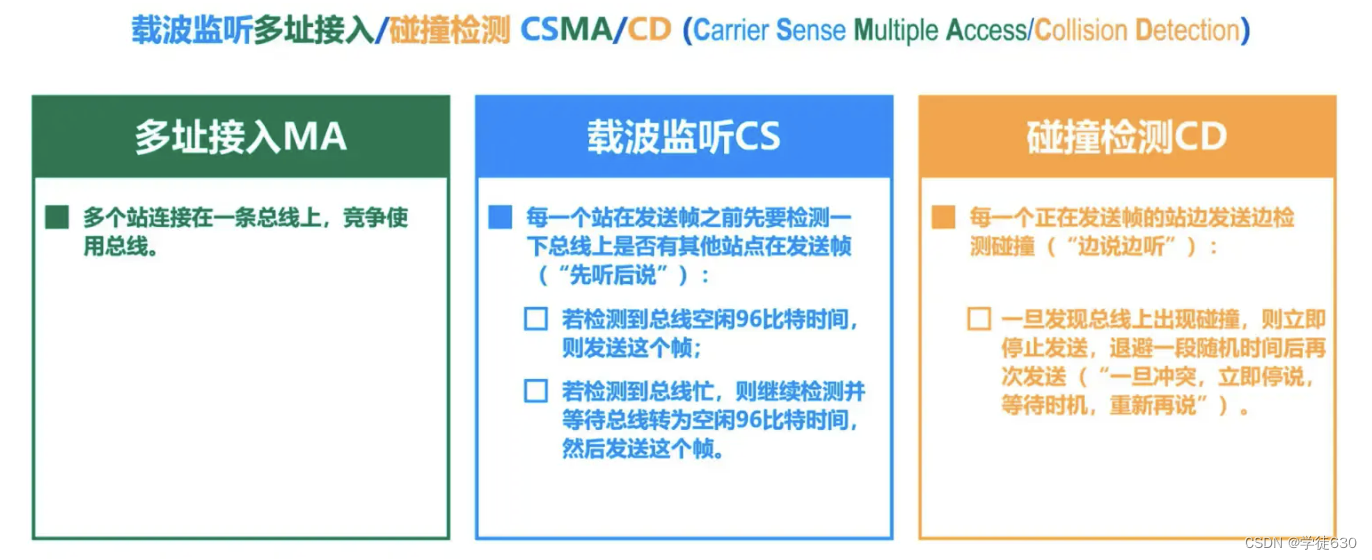

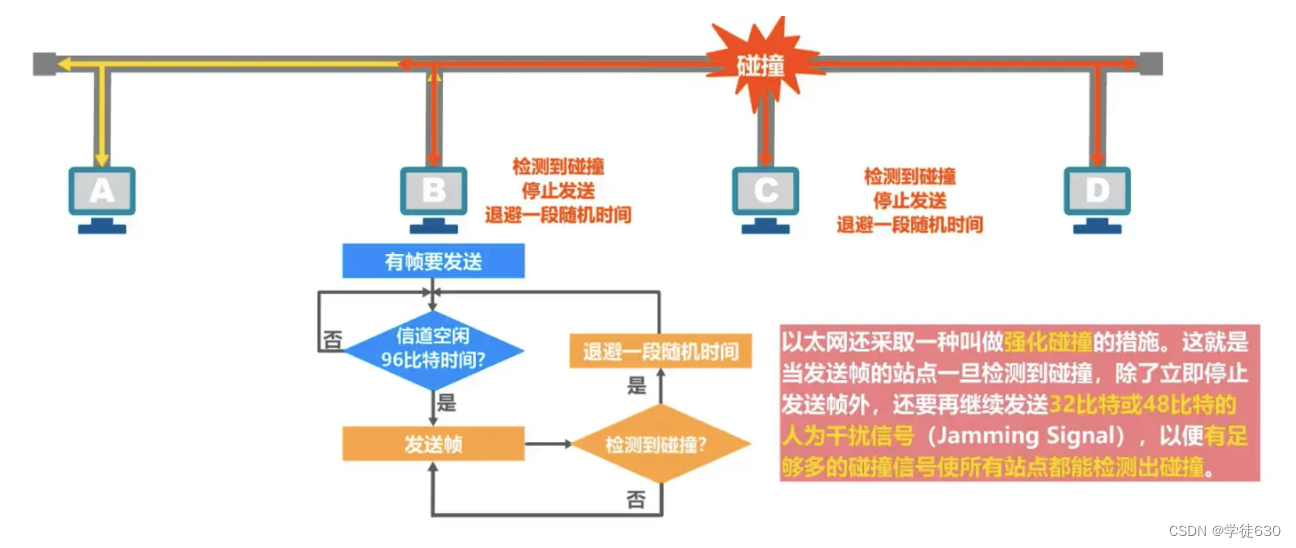

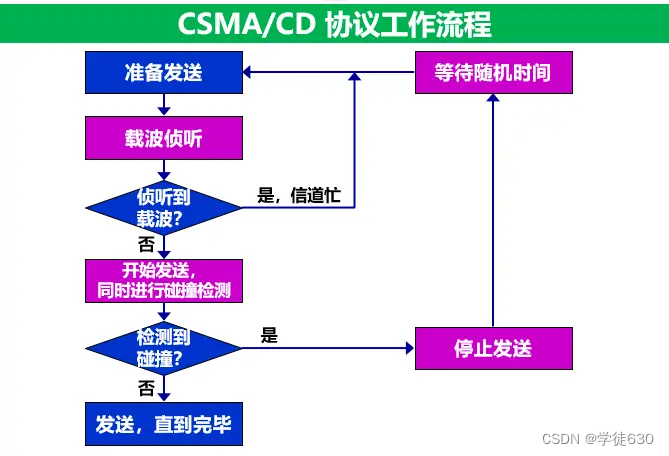

Direktzugriff (CSMA/CD-Protokoll)

CSMA/CD-Protokoll funktioniert – Konfliktzeitraum (Kollisionsfenster)

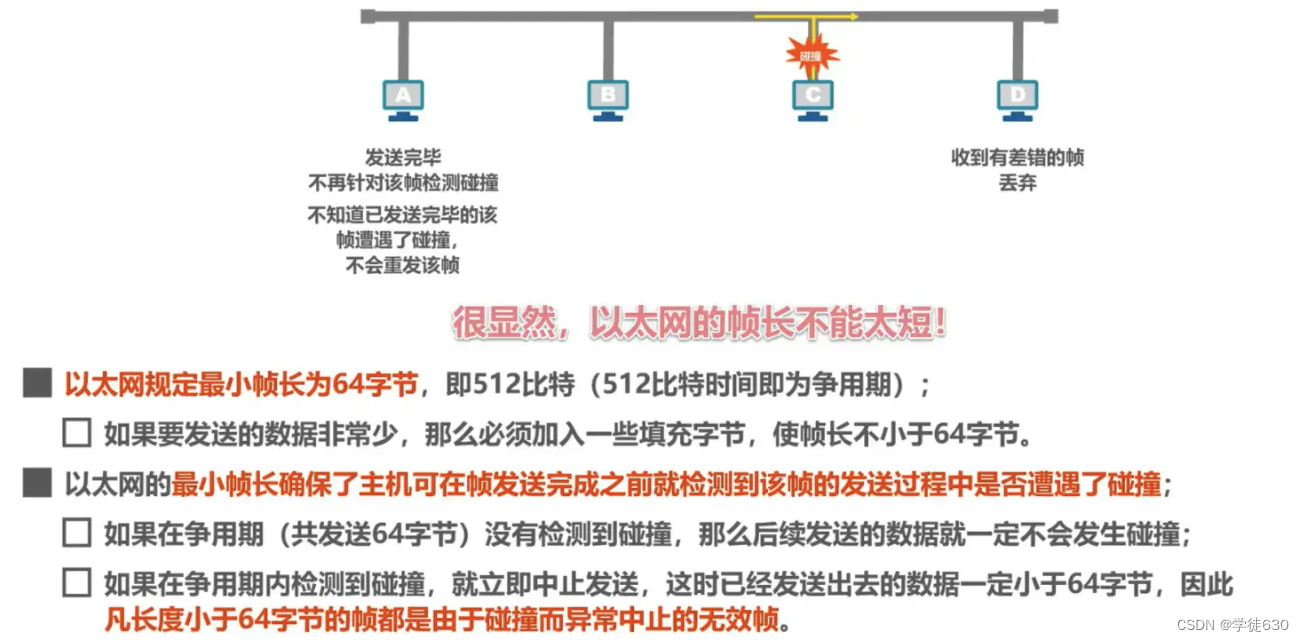

CSMA/CD-Protokoll funktioniert – minimale Framelänge

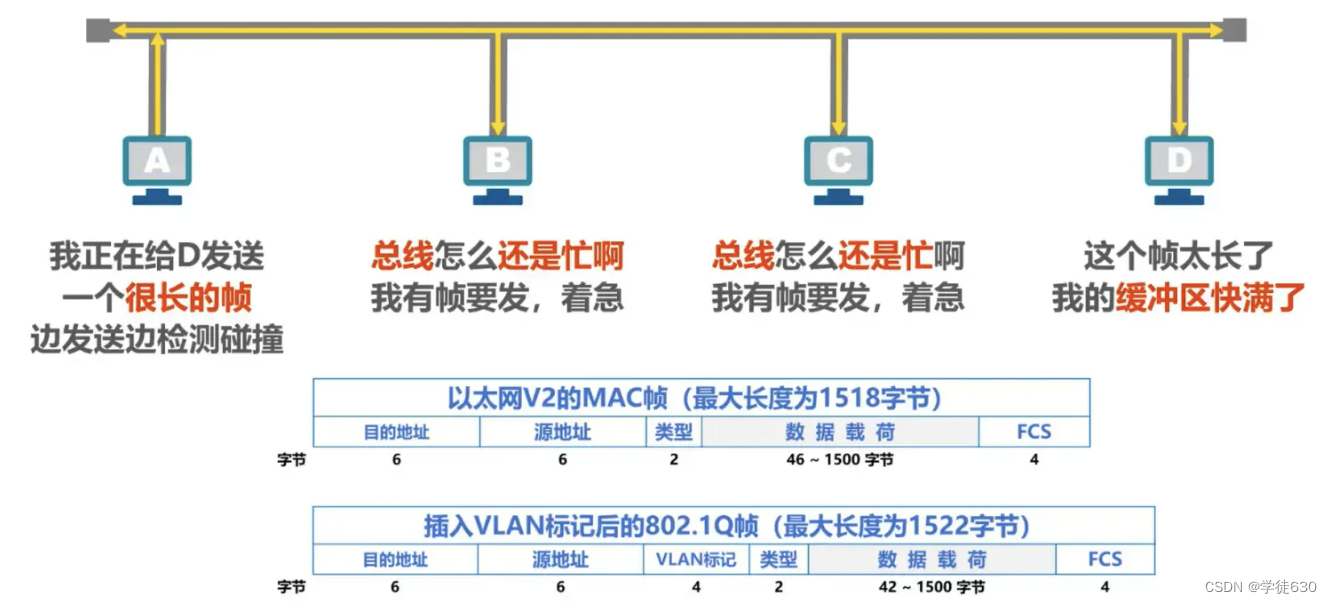

CSMA/CD-Protokoll funktioniert – maximale Framelänge

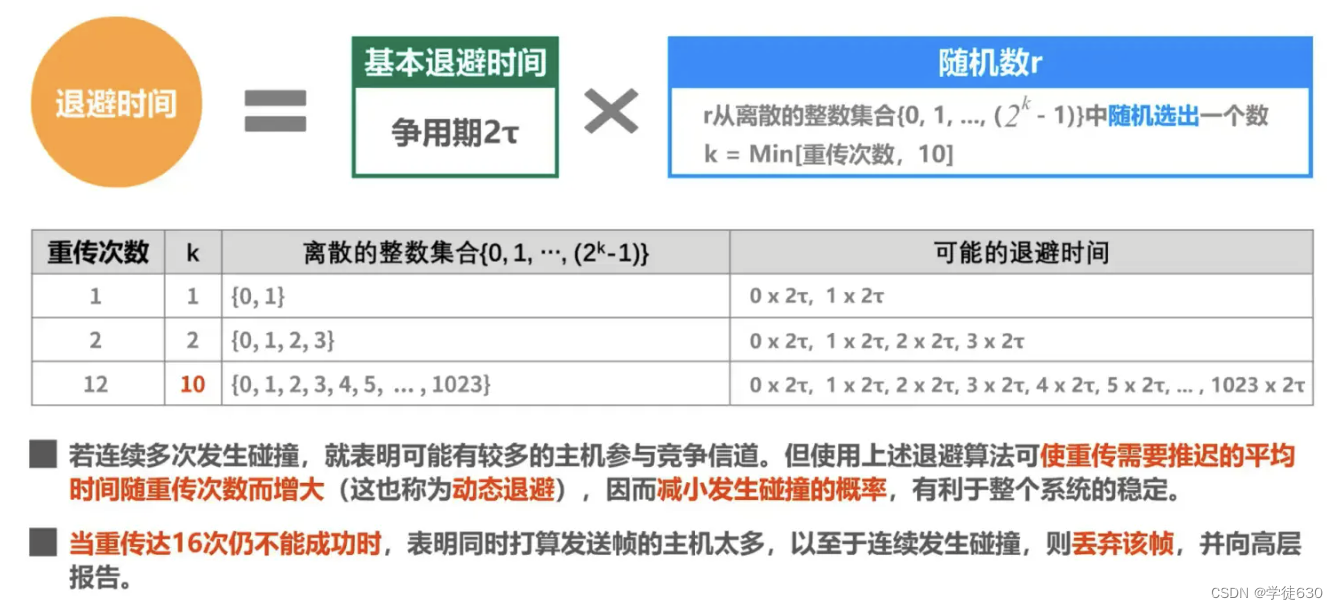

CSMA/CD-Protokoll funktioniert – verkürzter binärer exponentieller Backoff-Algorithmus

CSMA/CD-Protokollbetrieb – Kanalnutzung

CSMA/CD-Protokollarbeit – Frame-Empfangsprozess

Wichtige Funktionen des CSMA/CD-Protokolls

Direktzugriff (CSMA/CA-Protokoll)

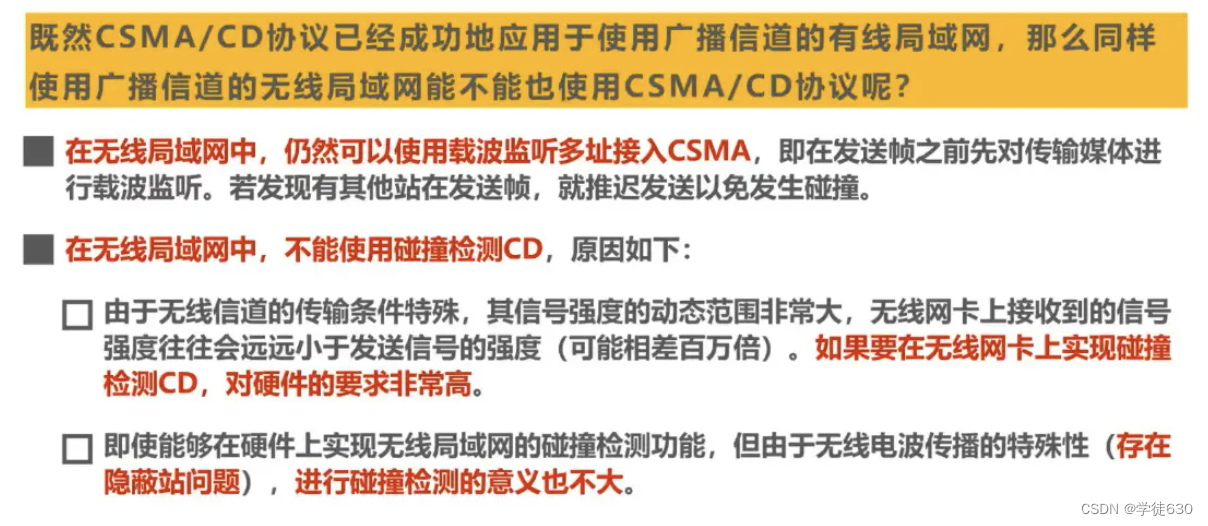

Warum verwendet WLAN das CSMA/CA-Protokoll?

InterFrame Space IFS (InterFrame Space)

So funktioniert das CSMA/CA-Protokoll

Wann sollte der Backoff-Algorithmus verwendet werden?

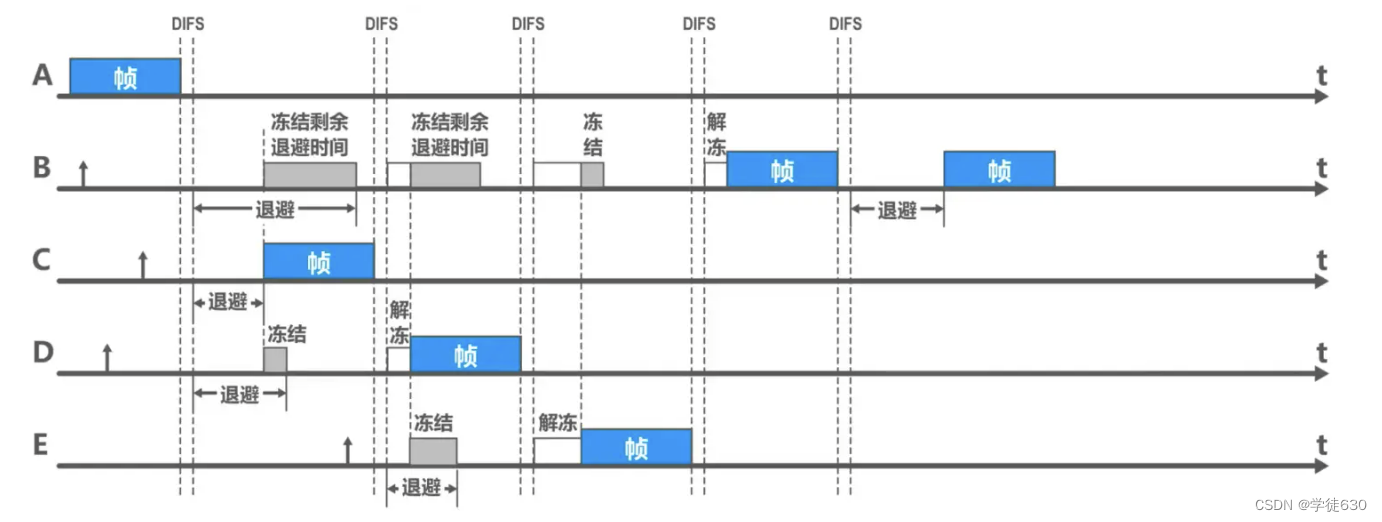

Backoff-Algorithmus des CSMA/CA-Protokolls

Beispiel eines Backoff-Algorithmus

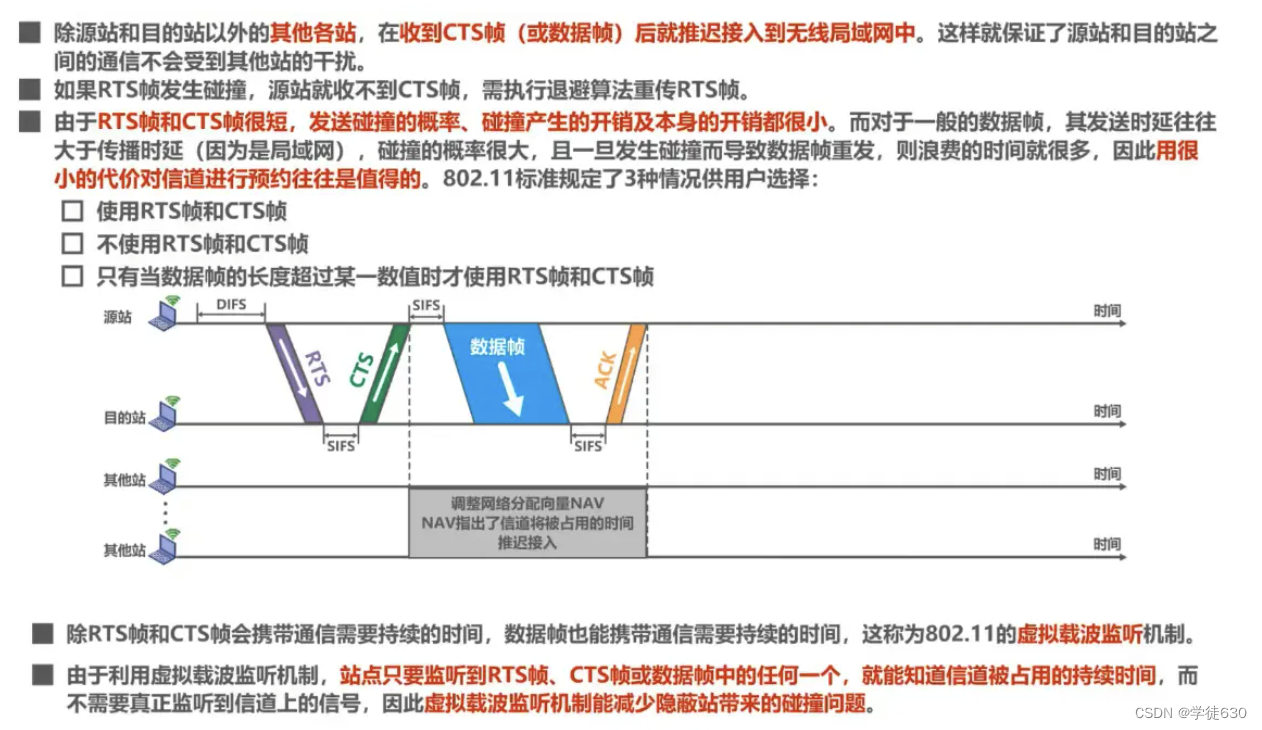

Kanalreservierung und virtuelle Trägerüberwachung des CSMA/CA-Protokolls

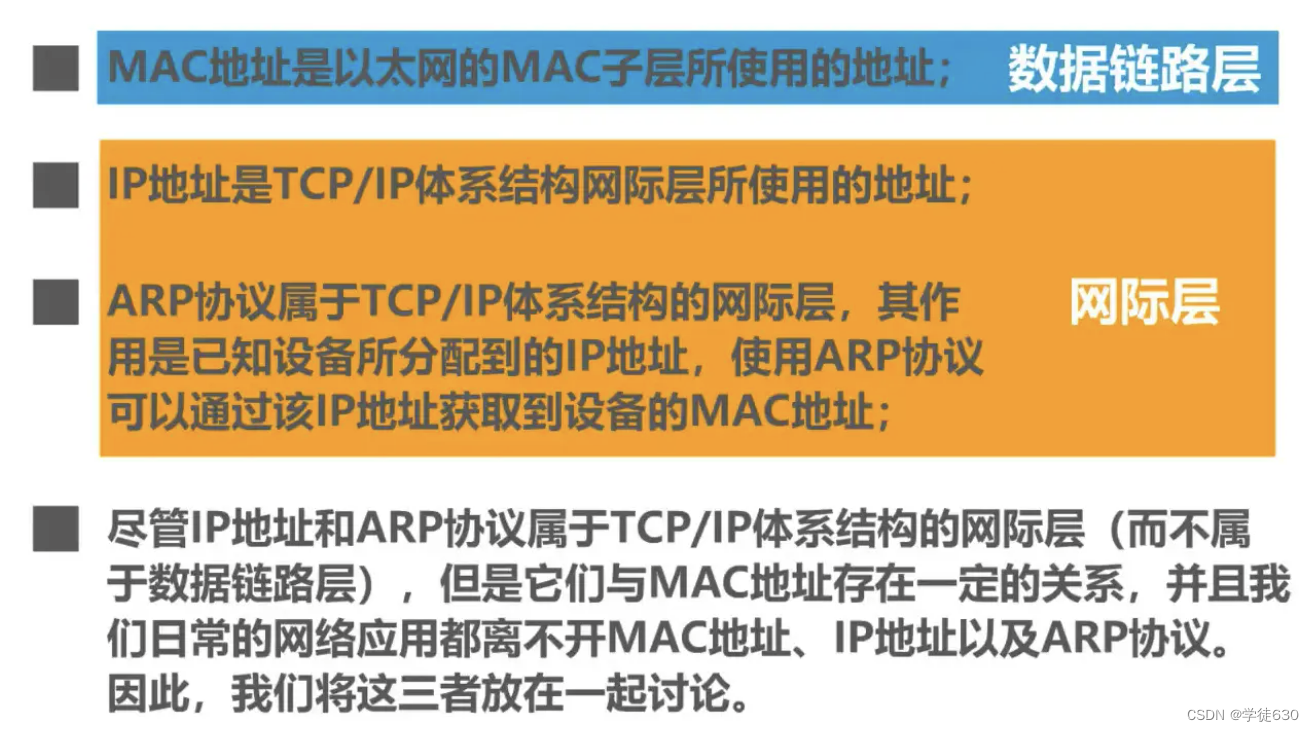

3.7. MAC-Adresse, IP-Adresse und ARP-Protokoll

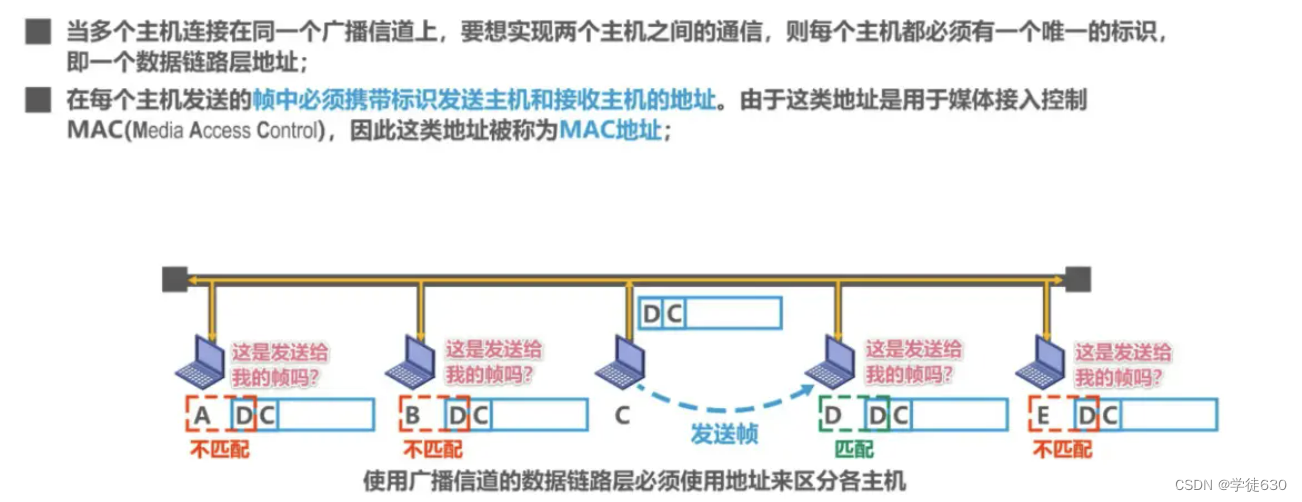

Die Datenverbindungsschicht des Broadcast-Kanals muss eine Adresse (MAC) verwenden.

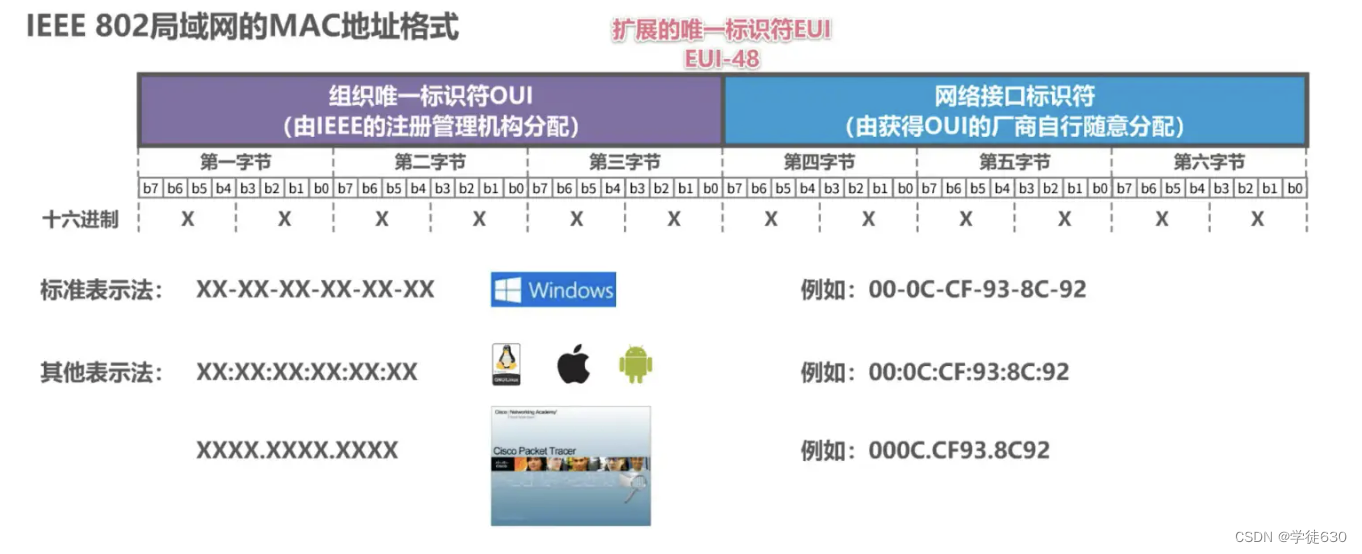

MAC-Adressformat von IEEE 802 LAN

IEEE 802 LAN-MAC-Adress-Sendesequenz

Beispiel für eine Unicast-MAC-Adresse

Beispiel für eine Broadcast-MAC-Adresse

Beispiel für eine Multicast-MAC-Adresse

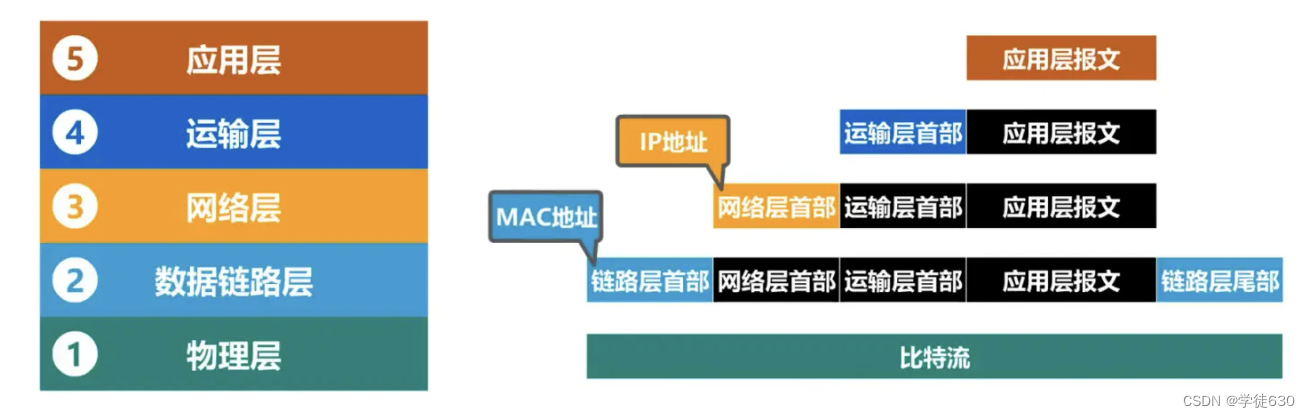

Betrachtung von IP-Adresse und MAC-Adresse aus der Perspektive der Netzwerkarchitektur

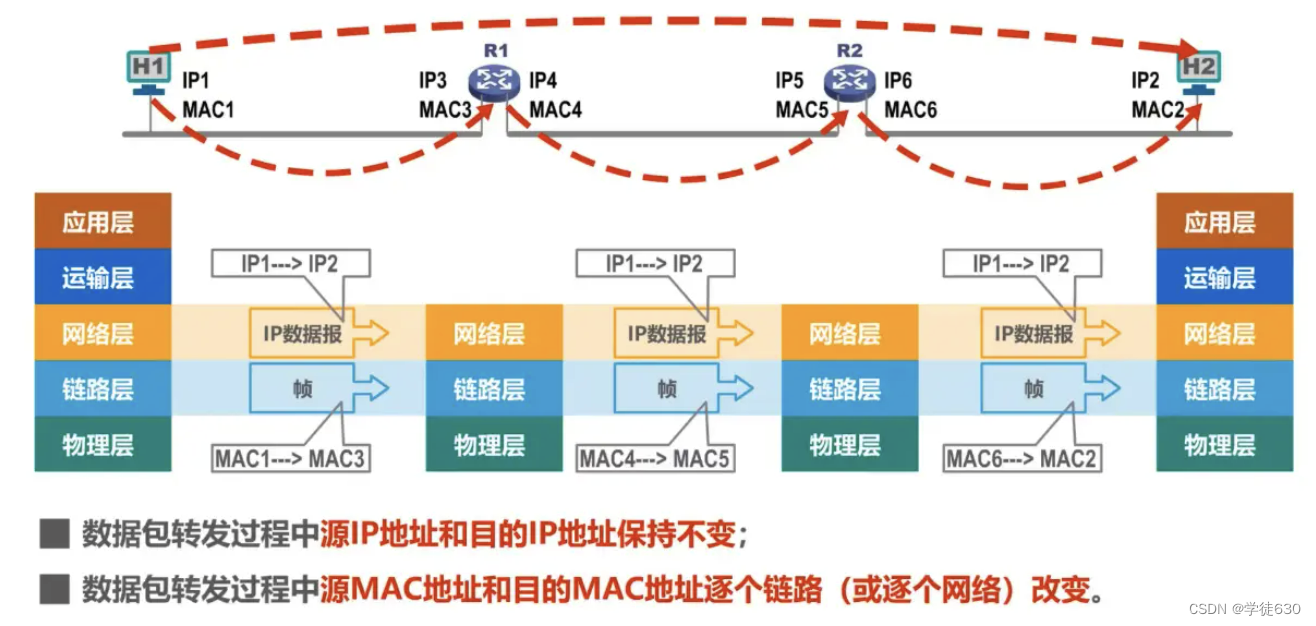

Änderungen der IP-Adressen und MAC-Adressen während der Weiterleitung von Datenpaketen

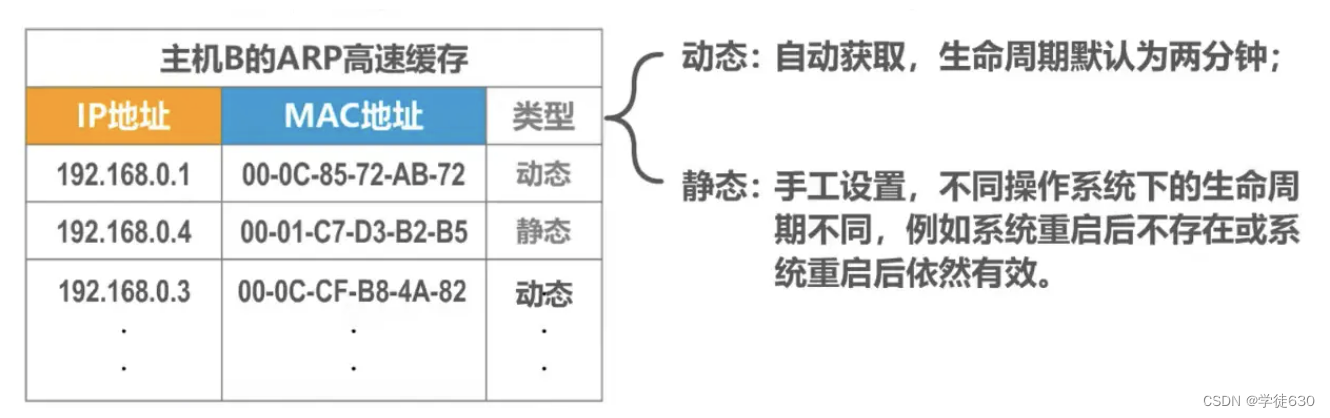

Der Unterschied zwischen dynamisch und statisch

3.8. Der Unterschied zwischen Hub und Switch

Hub – erweitert Ethernet auf der physikalischen Ebene

Hub HUB erweitert Ethernet auf der physikalischen Ebene

Ethernet-Switches – Erweiterung von Ethernet auf der Datenverbindungsebene

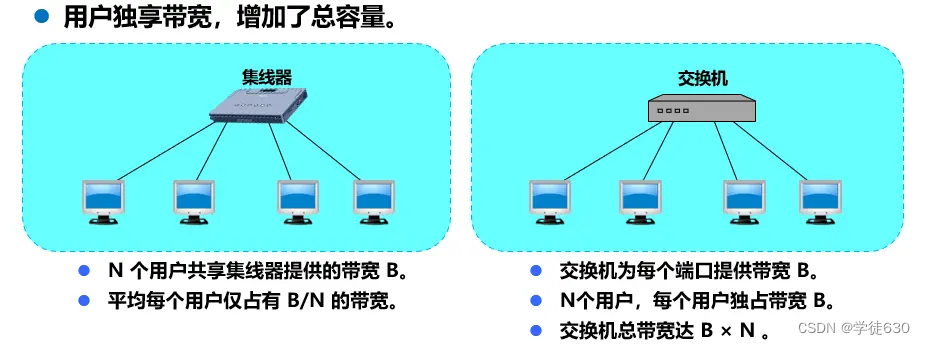

Der Unterschied zwischen Hub HUB und Switch SWITCH

Vergleich von Hubs und Switches

Der Unterschied zwischen Hub-Extended-Ethernet und Switch-Extended-Ethernet

3.9. Selbstlern- und Frame-Weiterleitungsprozess des Ethernet-Switches

Beispiel für selbstlernende und weiterleitende Frames

3.10. Spanning Tree Protocol STP des Ethernet-Switches

So verbessern Sie die Zuverlässigkeit von Ethernet

So teilen Sie Broadcast-Domänen auf

Implementierungsmechanismus des virtuellen LAN-VLAN

3.1. Übersicht über die Datenverbindungsschicht

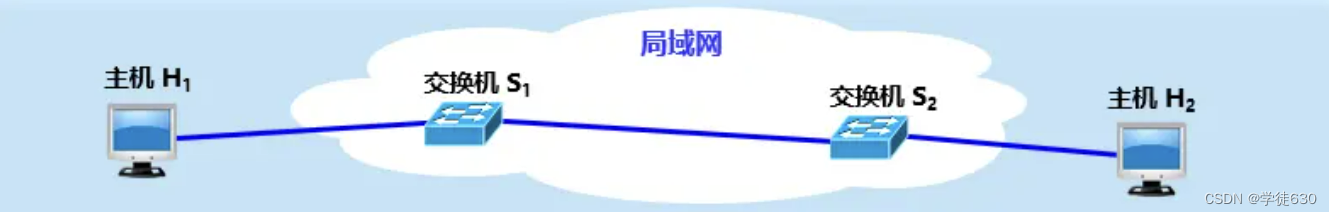

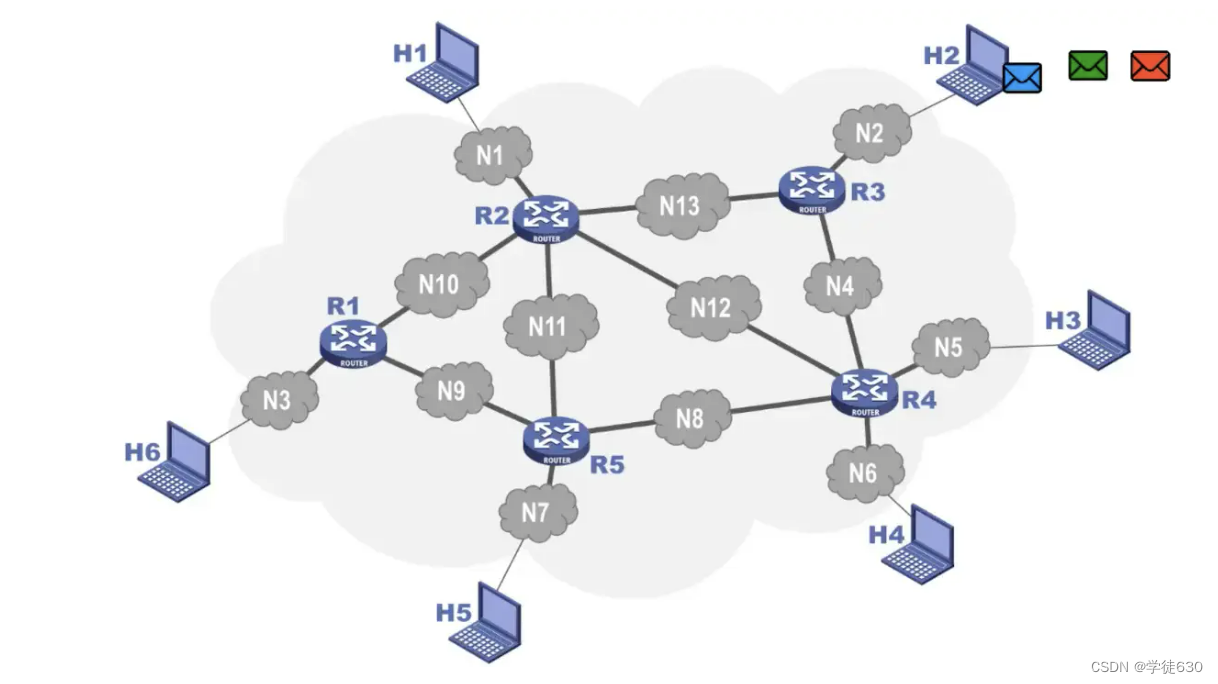

Überblick

Eine Verbindung ist eine physische Leitung von einem Knoten zu einem benachbarten Knoten. Eine Datenverbindung fügt der Verbindung einige notwendige Hardware (z. B. einen Netzwerkadapter) und Software (z. B. eine Protokollimplementierung) hinzu.

Hosts, Router usw. im Netzwerk müssen die Datenverbindungsschicht implementieren

Hosts, Switches usw. im LAN müssen die Datenverbindungsschicht implementieren

Betrachten Sie den Datenfluss aus einer hierarchischen Perspektive

Beobachten Sie den Framefluss nur von der Datenverbindungsschicht

Das von Host H1 an Host H2 übergebene Netzwerk kann unterschiedlicher Art sein.

Hinweis: Verschiedene Verbindungsschichten können unterschiedliche Protokolle der Datenverbindungsschicht verwenden

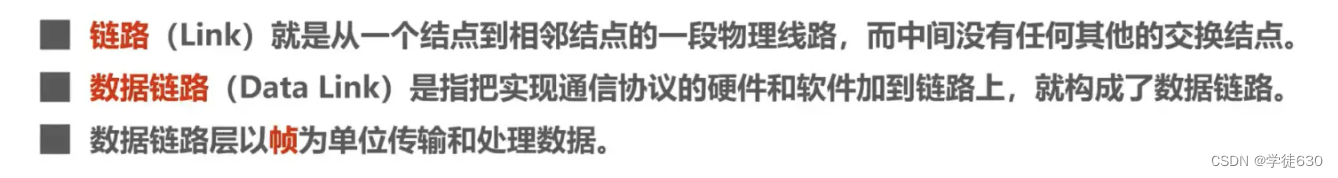

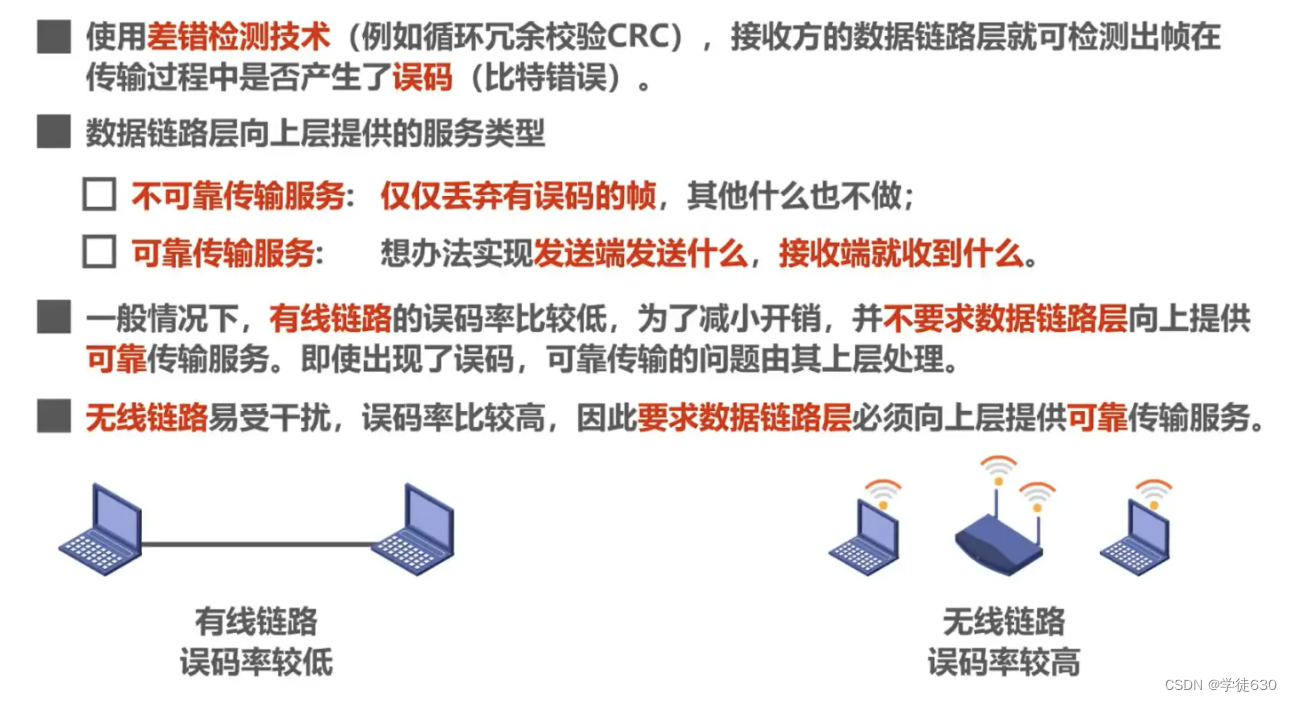

Von der Datenverbindungsschicht verwendete Kanäle

Die Datenverbindungsschicht ist die untere Schicht von Computernetzwerken. Es gibt zwei Haupttypen von Kanälen, die von der Datenverbindungsschicht verwendet werden:

-

Punkt-zu-Punkt-Kanal

-

Sendekanal

LAN gehört zur Datenverbindungsschicht

Obwohl das LAN ein Netzwerk ist. Aber wir diskutieren LAN nicht auf der Netzwerkebene. Dies liegt daran, dass es auf der Netzwerkebene um die Verbindung mehrerer Netzwerke und die Art und Weise geht, wie Pakete über einen Router von einem Netzwerk zu einem anderen weitergeleitet werden.

Wie können Pakete im selben LAN von einem Host zu einem anderen Host übertragen werden, ohne vom Router weitergeleitet zu werden ? Aus Sicht des gesamten Internets gehört LAN immer noch zum Bereich der Datenverbindungsschicht.

Drei wichtige Fragen

Die von der Datenverbindungsschicht übertragene Protokolldateneinheit ist ein Frame

gerahmt

-

Die Kapselung in Framing (Framing) besteht darin, vor und nach einem Datenelement einen Header und einen Trailer hinzuzufügen und dann einen Frame zu bilden.

-

Eine wichtige Rolle des Headers und Trailers besteht in der Rahmentrennung .

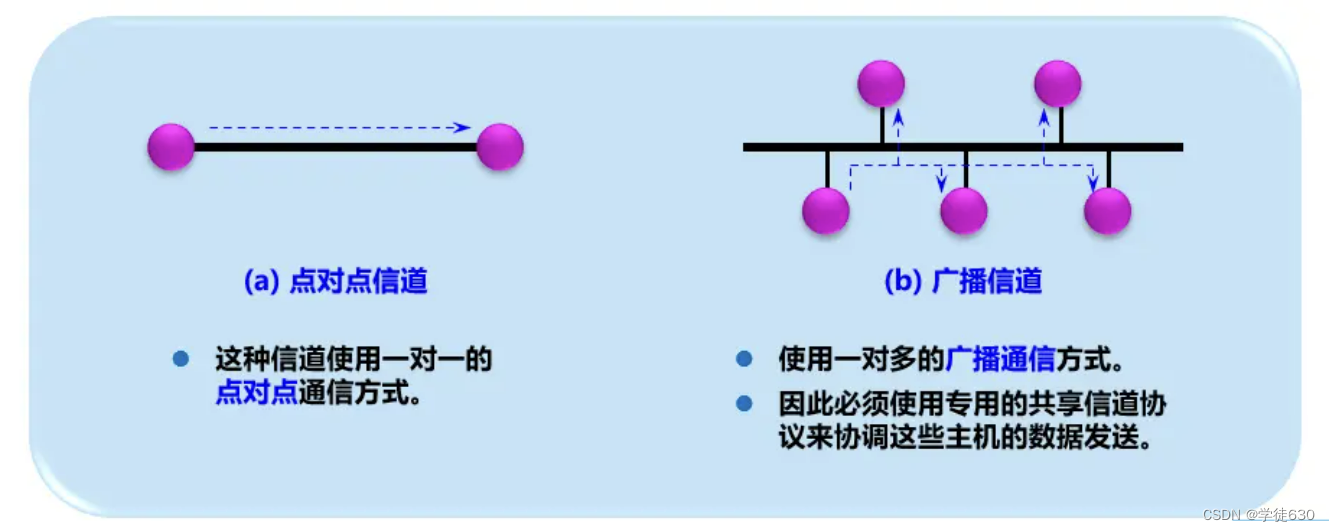

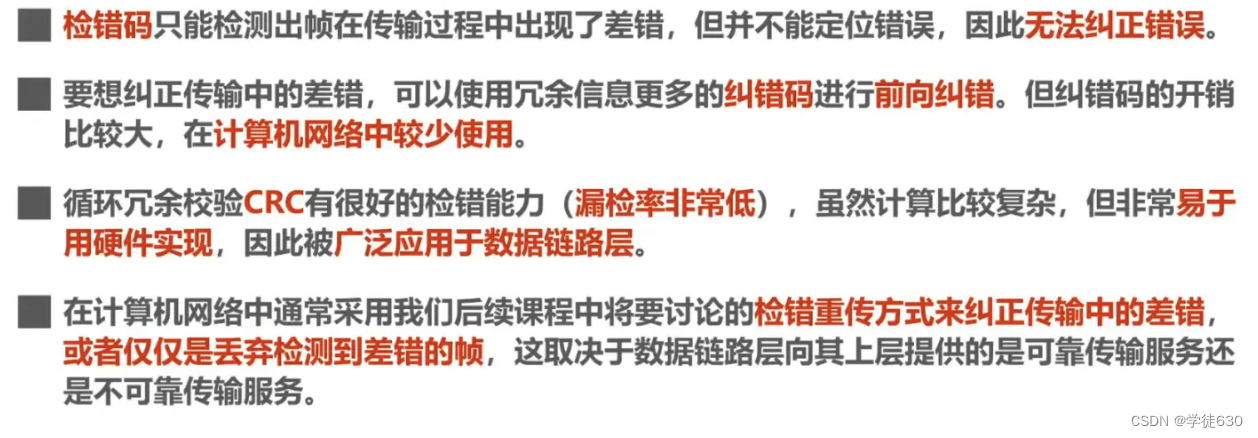

Fehlerkontrolle

Bei der Übertragung können Bitfehler auftreten : Eine 1 kann zu einer 0 werden und eine 0 kann zu einer 1 werden.

Zuverlässige Übertragung

Zuverlässige Übertragung

Nachdem der empfangende Host einen Frame mit Fehlern empfängt, akzeptiert er den Frame nicht und verwirft ihn.

Wenn die Datenverbindungsschicht ihren oberen Schichten unzuverlässige Dienste bereitstellt, wird sie verworfen und es werden keine weiteren Maßnahmen ergriffen.

Wenn die Datenverbindungsschicht den darüber liegenden Schichten zuverlässige Dienste bereitstellt, sind zusätzliche Maßnahmen erforderlich, um sicherzustellen, dass der empfangende Host eine korrekte Kopie des verworfenen Frames erneut empfangen kann.

Die oben genannten drei Fragen sind allesamt Beispiele für die Datenverbindungsschicht von Punkt-zu-Punkt-Kanälen.

Wenn die Datenverbindungsschicht, die den Broadcast-Kanal verwendet, die oben genannten drei Probleme aufweist, müssen auch einige Probleme gelöst werden.

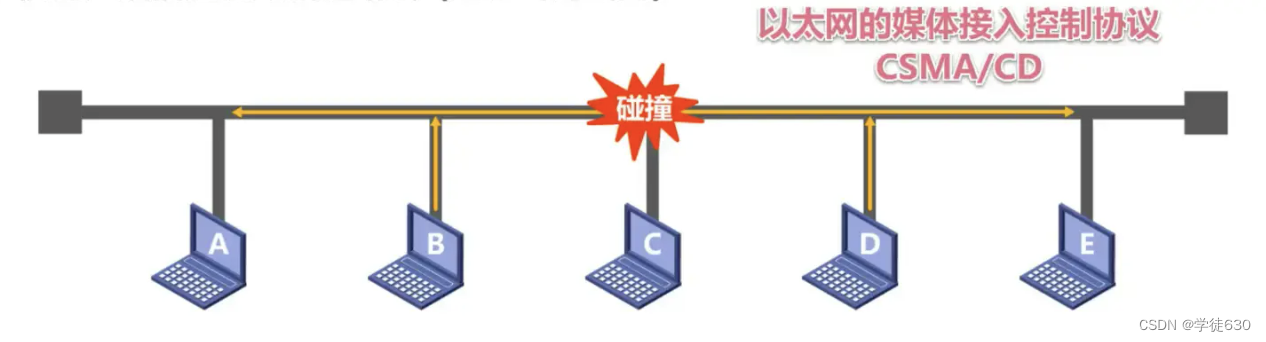

Wie in der Abbildung gezeigt, sind die Hosts A, B, C, D und E über einen Bus miteinander verbunden. Host A möchte Daten an Host C senden. Das Signal, das den Rahmen darstellt, wird über den Bus an andere Hosts auf dem Bus übertragen Dann wissen Host B, D und E, dass der empfangene Frame nicht an sie gesendet wurde, und woher weiß Host C, dass der gesendete Frame an sich selbst gesendet wurde?

Es kann mithilfe der Adressierung (Adresse) gelöst werden.

Fügen Sie die Zieladresse des Frames zum Frame hinzu und übertragen Sie ihn zusammen

Es besteht auch das Problem der Datenkollision

Mit der Entwicklung der Technologie und der Reife der Schalttechnologie,

Geschaltete LANs mit Punkt-zu-Punkt-Verbindungen und Link-Layer-Switches ersetzten gemeinsam genutzte LANs in der kabelgebundenen Welt (LAN).

In WLANs wird weiterhin die Shared-Channel-Technologie verwendet

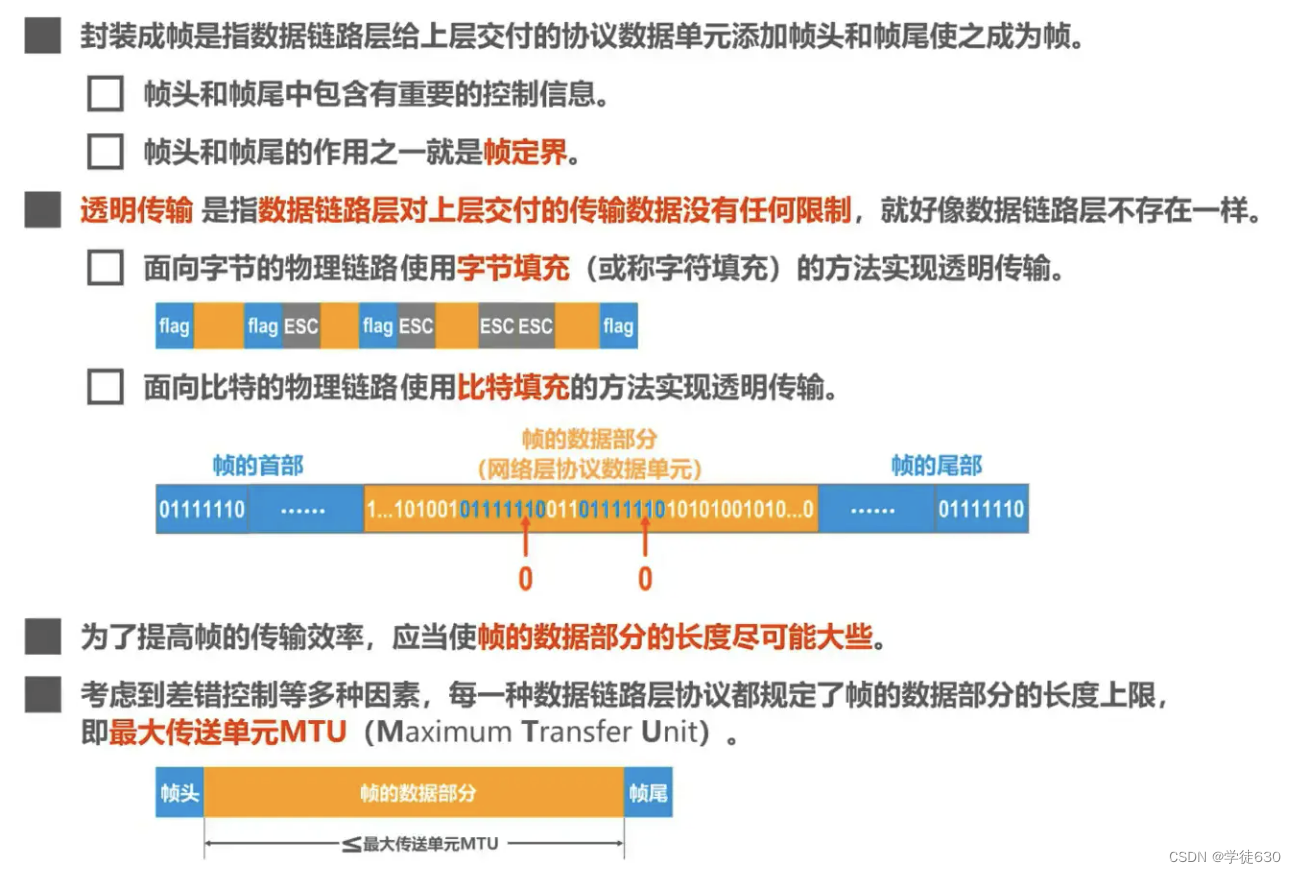

3.2. Kapselung in Frames

einführen

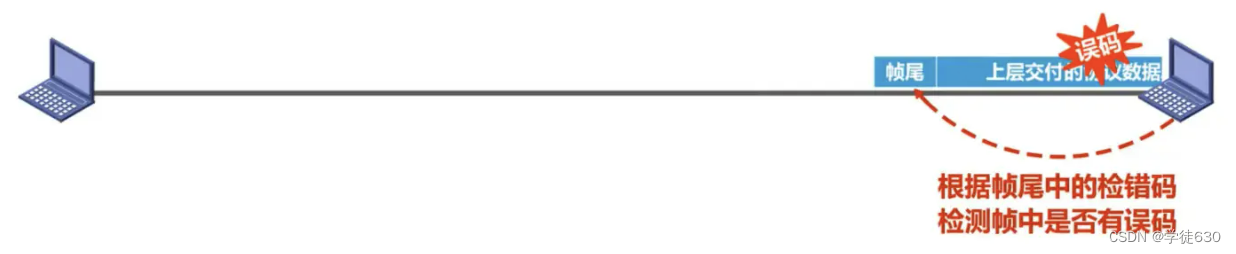

Kapselung in Frames bedeutet, dass die Datenverbindungsschicht der von der oberen Schicht gelieferten Protokolldateneinheit einen Frame-Header und einen Frame- Trailer hinzufügt , um daraus einen Frame zu machen.

- Der Frame-Header und Frame-Trailer enthalten wichtige Steuerinformationen

Nachdem die Datenverbindungsschicht des Absenders die von der oberen Schicht gelieferten Protokolldateneinheiten in einen Rahmen gekapselt hat, wandelt sie auch die Bits, aus denen der Rahmen besteht, über die physikalische Schicht in elektrische Signale um und übermittelt sie an das Übertragungsmedium. Dann die Datenverbindungsschicht des Empfängers Wie extrahiert man einzelne Frames aus dem von der physikalischen Schicht gelieferten Bitstrom?

Antwort: Frame-Header und Frame-Trailer werden zur Frame-Abgrenzung benötigt

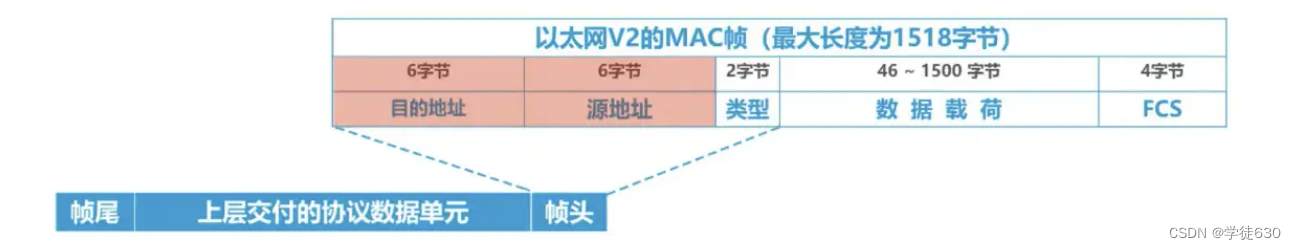

Aber nicht jeder Frame des Datenverbindungsschichtprotokolls enthält ein Frame-Begrenzungsflag, wie im folgenden Beispiel

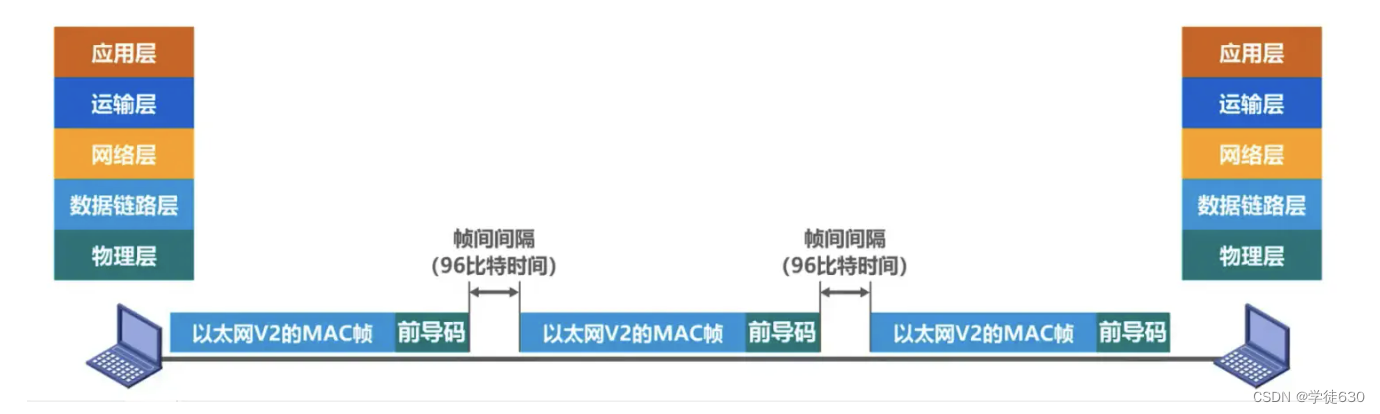

Präambel

- Präambel: Die Funktion besteht darin, die Uhr des Empfängers zu synchronisieren

- Frame-Starttrennzeichen: Zeigt an, dass ihm ein MAC-Frame folgt

Darüber hinaus schreibt Ethernet auch vor, dass das Inter-Frame-Intervall 96 Bit beträgt. Daher benötigen MAC-Frames keine End-of-Frame-Trennzeichen (da sie nicht kontinuierlich sind).

Transparente Übertragung

Transparenz bedeutet, dass etwas, das tatsächlich existiert, so aussieht, als ob es nicht existierte.

Transparente Übertragung bedeutet, dass die Datenverbindungsschicht keine Einschränkungen hinsichtlich der von der oberen Schicht gelieferten Übertragungsdaten hat , als ob die Datenverbindungsschicht nicht vorhanden wäre

Durch die transparente Übertragung werden die übertragenen Daten nicht beeinträchtigt oder verändert , und die übertragenen Daten bleiben unverändert. Auf der Datenverbindungsschicht werden Daten zur Übertragung normalerweise in Datenrahmen unterteilt. Durch die transparente Übertragung wird sichergestellt, dass der Inhalt dieser Datenrahmen während der Übertragung nicht geändert oder beschädigt wird. Die Übertragungsmethode ist für das Protokoll der oberen Schicht transparent und das Protokoll der oberen Schicht muss die Details der Übertragung nicht kennen.

Der Vorteil der transparenten Übertragung besteht darin, die Zuverlässigkeit und Konsistenz der Daten sicherzustellen, sodass verschiedene Computer oder Netzwerkgeräte miteinander kommunizieren können, ohne dass die zugrunde liegenden Übertragungsdetails beeinträchtigt werden. Diese Übertragungsmethode ist in der Netzwerkkommunikation sehr wichtig und gewährleistet eine effektive Übertragung und korrekte Verarbeitung der Daten.

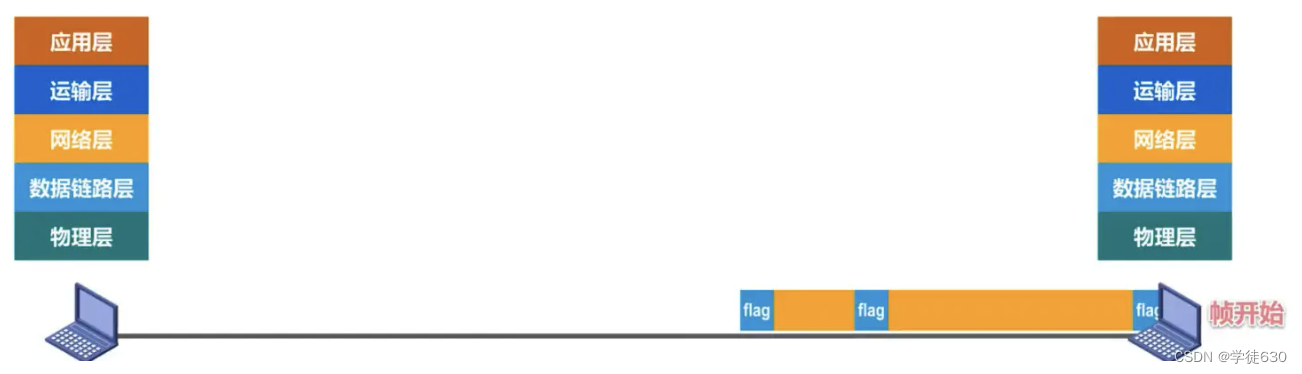

Das Rahmendefinitionsflag stellt einen bestimmten Datenwert dar. Wenn die von der oberen Schicht gelieferte Protokolldateneinheit zufällig diesen bestimmten Wert enthält, kann der Empfänger ihn nicht korrekt empfangen.

(Sehen Sie sich das Bild unten an, denn das Rahmentrennzeichen ist ein bestimmter Datenwert. Wenn dieser Wert zufällig in den Daten vorhanden ist, beurteilt der Empfänger beim Empfang der Zwischendaten, dass es sich nicht um Daten, sondern um ein Trennzeichen handelt , dann wird es unvernünftig sein, auf den Empfang von Daten von hinten zu verzichten)

Daher sollte die Datenverbindungsschicht Einschränkungen hinsichtlich der von der oberen Schicht gelieferten Daten haben und ihr Inhalt darf nicht den Wert des Frame-Trennzeichens enthalten.

Lösen Sie das Problem der transparenten Übertragung

-

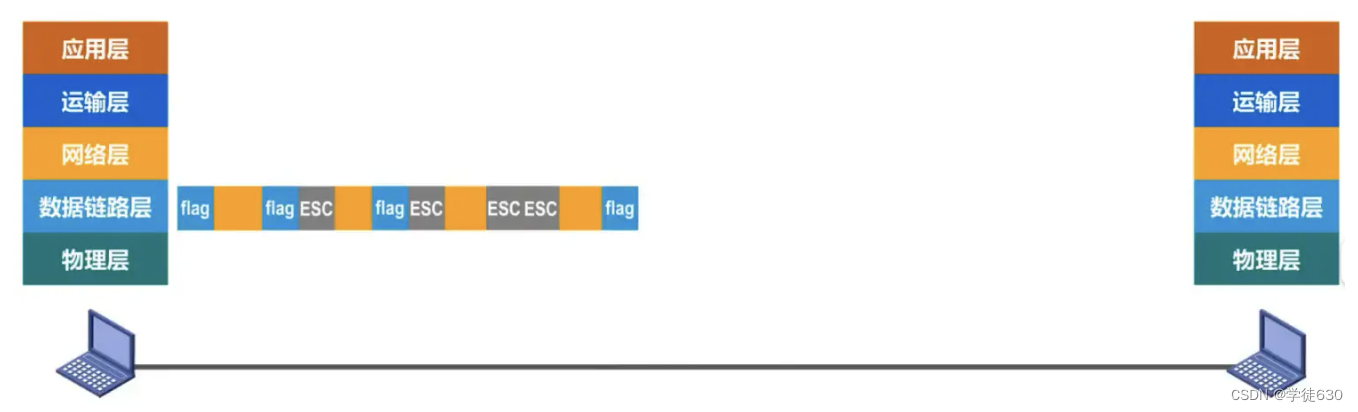

Lösung : Byteorientierte physische Verbindungen verwenden Byte- Stuffing oder Zeichenfüllung , und bitorientierte physische Verbindungen verwenden Bit-Stuffing, um eine transparente Übertragung zu erreichen.

-

Die Datenverbindungsschicht auf der sendenden Seite fügt ein Escape-Zeichen „ESC“ (seine hexadezimale Codierung ist 1B) ein , bevor das Steuerzeichen „SOH“ oder „EOT“ in den Daten erscheint.

-

Die Datenverbindungsschicht auf der Empfangsseite entfernt die eingefügten Escape-Zeichen, bevor sie die Daten an die Netzwerkschicht sendet.

-

Wenn in den Daten auch ein Escape-Zeichen vorkommt, sollte vor dem Escape-Zeichen ein Escape-Zeichen ESC eingefügt werden. Wenn der Empfänger zwei aufeinanderfolgende Escape-Zeichen empfängt, wird das erste gelöscht.

-

Wenn es sich um eine bitorientierte physische Verbindung handelt, besteht die verwendete Methode darin, nach der fünften 1 eine 0 in die in den Daten vorhandenen „Frame-Delimiter“-Daten einzufügen, um das Frame-Delimiter-Datenmuster zu zerlegen. Wenn der Empfänger empfängt, wenn die Daten eintreffen Bei fünf Einsen werden die vor der Übertragung geschriebenen 0-Zeichen gelöscht. Dadurch kann sichergestellt werden, dass das Rahmentrennzeichen nicht falsch eingeschätzt wird und die Konsistenz der übertragenen Daten gewährleistet ist.

Die Länge des Datenteils des Frames

Zusammenfassen

3.3. Fehlererkennung

einführen

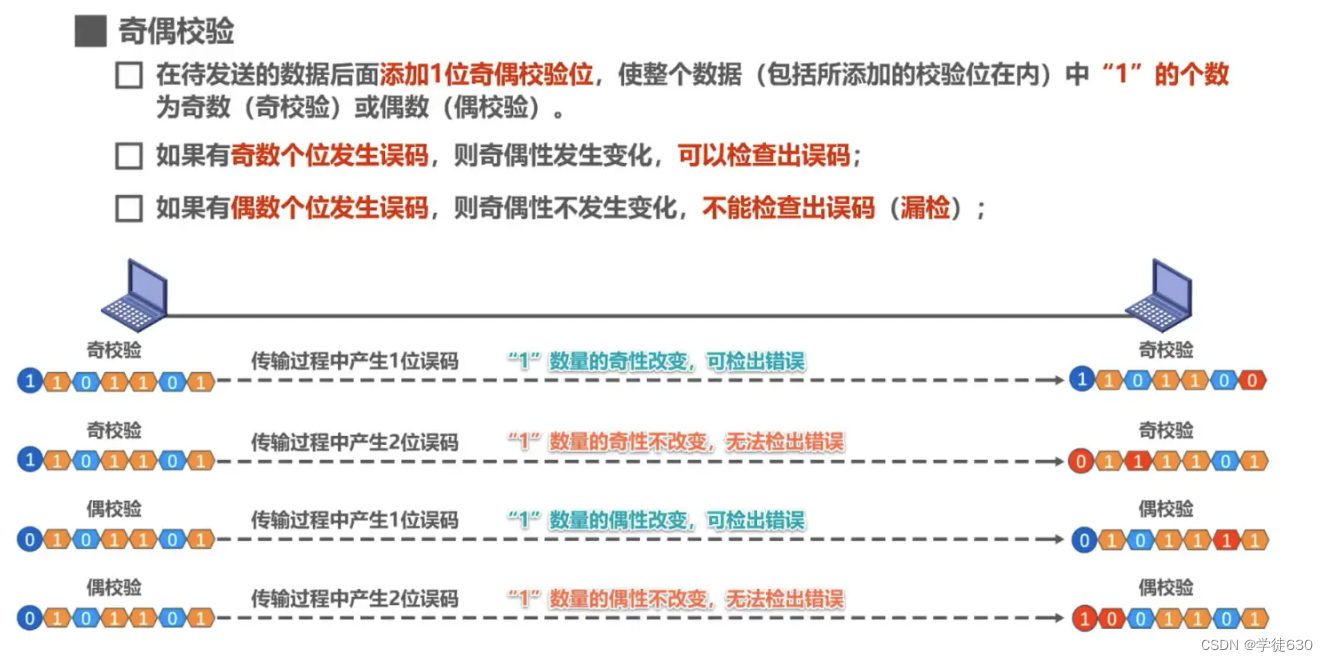

Paritätsprüfung

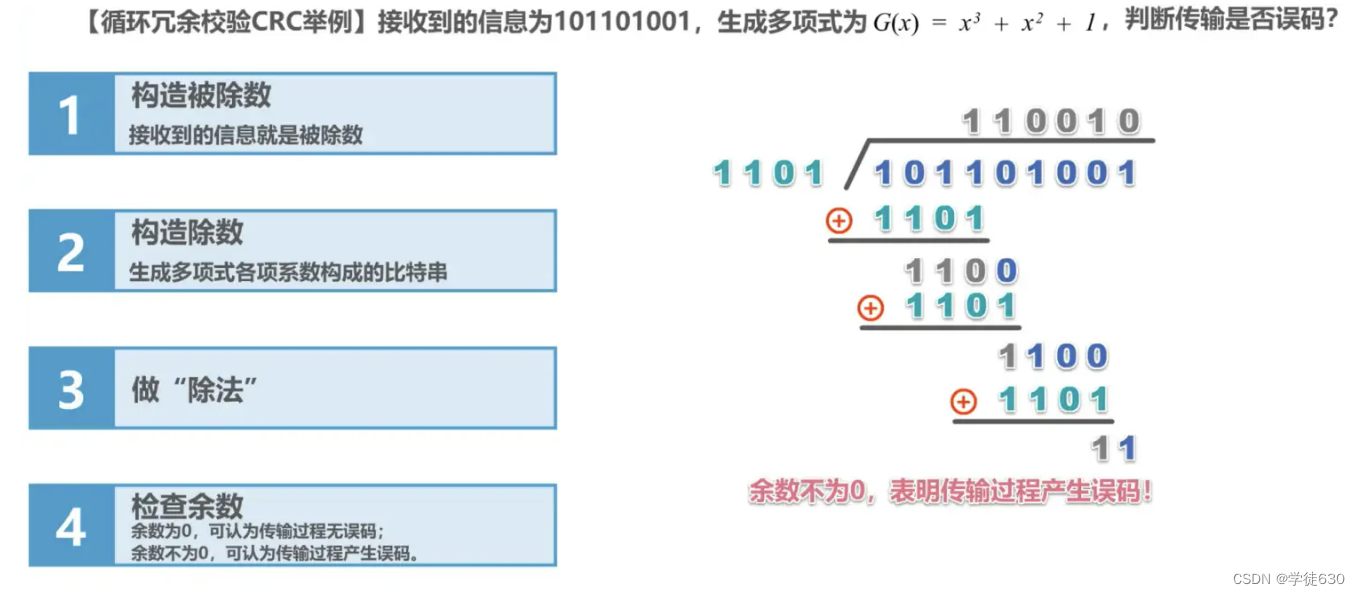

Zyklische Redundanzprüfung CRC (Zyklische Redundanzprüfung)

Beispiel

Zusammenfassen

Die zyklische Redundanzprüfung CRC ist eine Fehlererkennungsmethode, während die Rahmenprüfsequenz FCS ein redundanter Code ist, der nach den Daten hinzugefügt wird

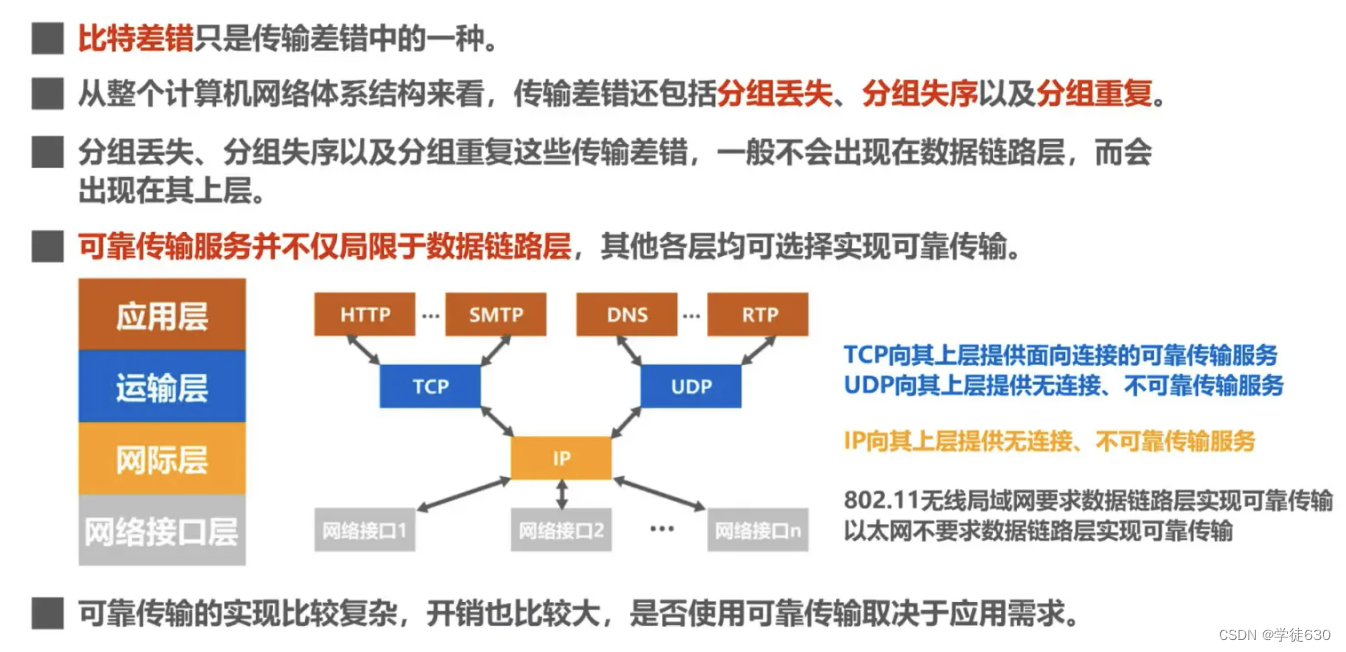

3.4. Zuverlässige Übertragung

Basiskonzept

Bitfehler

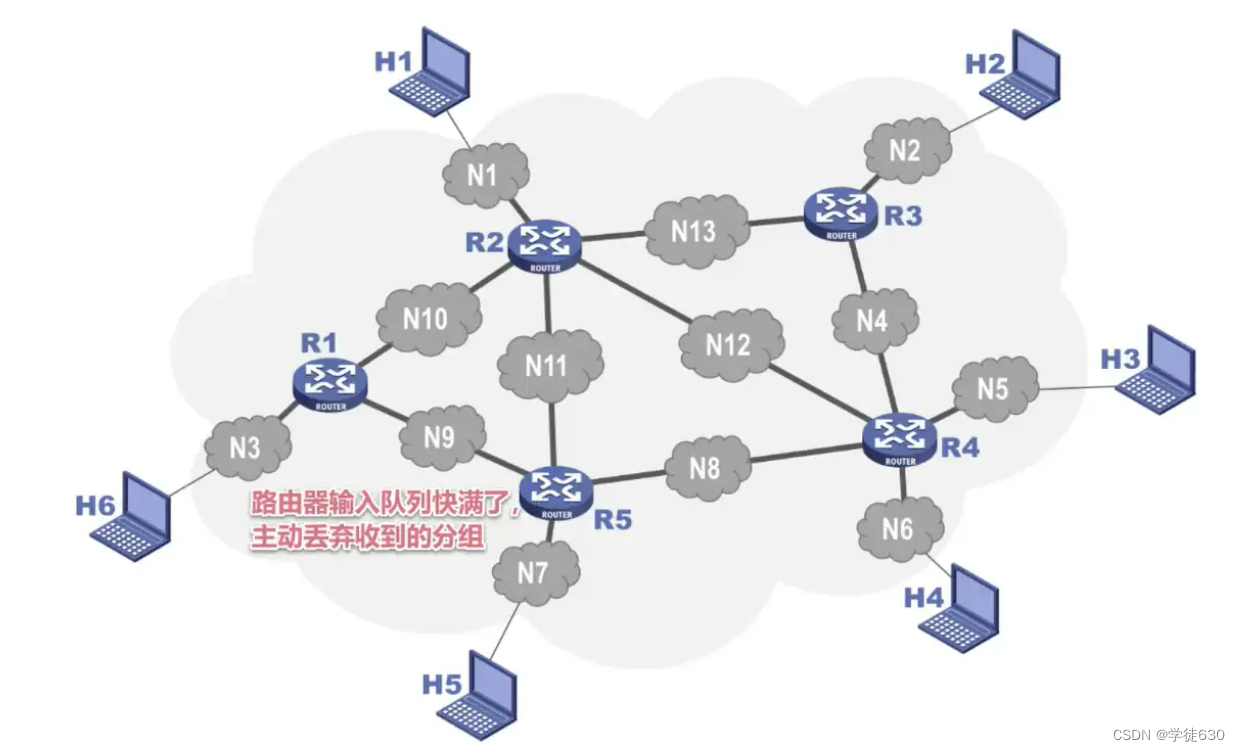

Sonstige Übertragungsfehler

Paket verloren

Die Eingangswarteschlange des Routers ist fast voll und verwirft aktiv empfangene Pakete.

Paket außer Betrieb

Die Daten kommen beim Empfänger nicht in der Reihenfolge an, in der sie gesendet wurden.

In Gruppen wiederholen

Aus bestimmten Gründen bleiben einige Pakete im Netzwerk hängen und kommen nicht rechtzeitig am empfangenden Ende an. Dies kann dazu führen, dass das sendende Ende die Pakete erneut sendet. Die erneut übertragenen Pakete kommen am empfangenden Ende an, aber nach einer gewissen Zeit Pakete, die im Netzwerk verbleiben, erreichen auch das Empfangsende, was zu Fehlern bei der Übertragung durch Paketduplizierung führt .

Drei zuverlässige Protokolle

-

Stop-Wait-Protokoll-SW

-

Fallback-N-Frame-Protokoll GBN

-

Wählen Sie das Neuübertragungsprotokoll SR

Die Grundprinzipien dieser drei zuverlässigen Übertragungsimplementierungsmechanismen sind nicht auf die Datenverbindungsschicht beschränkt, sondern können auf Protokolle auf allen Ebenen der Computernetzwerkarchitektur angewendet werden.

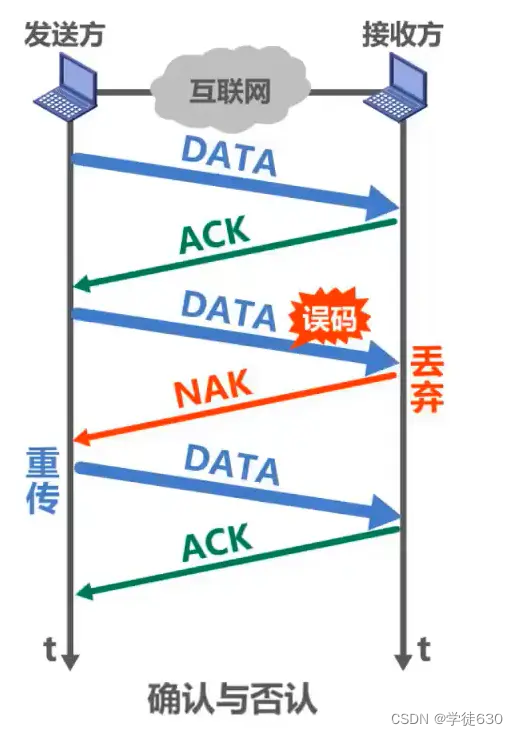

Stop-Wait-Protokoll

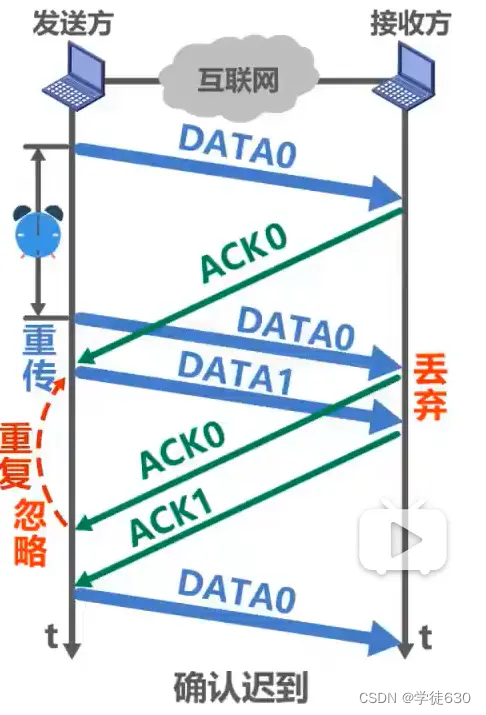

Vier Probleme, die bei Stop-Wait-Protokollen auftreten können

Bestätigen und ablehnen

Timeout-Neuübertragung

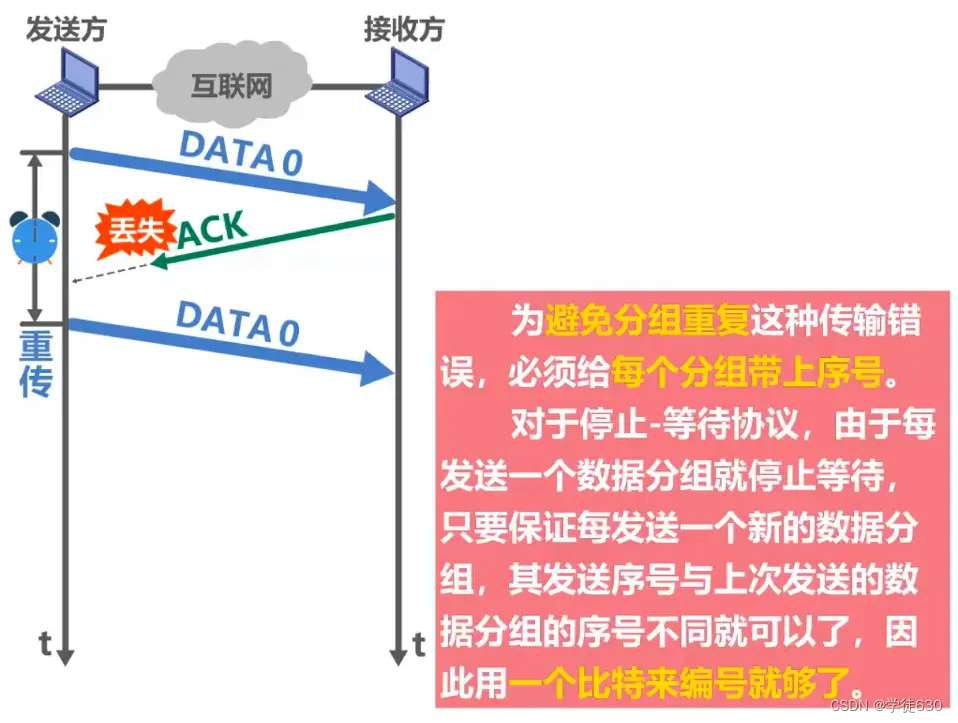

als verloren bestätigt

Muss die Bestätigungsgruppierung nummeriert werden, da die Datengruppierung nummeriert werden muss?

wollen. Wie nachfolgend dargestellt

spät bestätigt

Beachten Sie, dass die unterste Datengruppe im Bild nicht dieselbe Datengruppe ist wie die vorherige Datengruppe mit der Sequenznummer 0.

Vorsichtsmaßnahmen

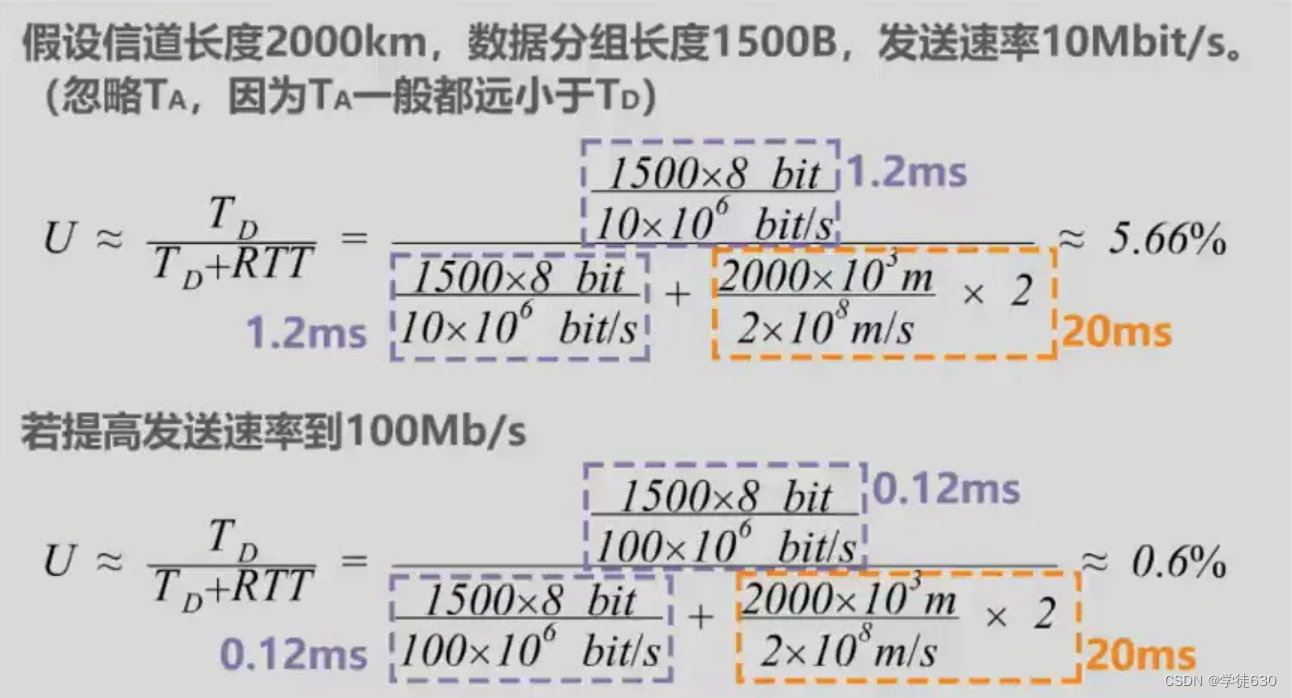

Auslastung des Stop-Wait-Protokollkanals

Gehen Sie davon aus, dass zwischen Sender und Empfänger ein direkter Kanal besteht

-

TD : Dies ist die Sendeverzögerung, die der Absender zum Senden von Datenpaketen benötigt.

-

RTT : ist die Hin- und Rücklaufzeit zwischen Sender und Empfänger

-

TA : Dies ist die Sendeverzögerung, die der Empfänger benötigt, um das Bestätigungspaket zu senden.

TA ist im Allgemeinen viel kleiner als TD und kann ignoriert werden. Wenn RTT viel größer als TD ist, ist die Kanalauslastung sehr gering.

Ein zuverlässiges Übertragungsprotokoll, das durch Bestätigungs- und Neuübertragungsmechanismen wie das Stop-and-Wait-Protokoll implementiert wird, wird oft als automatisches Anforderungs -Neuübertragungsprotokoll ARQ ( Automatic R epeat re Q uest) bezeichnet, was bedeutet, dass die Neuübertragungsanforderung automatisch ausgeführt wird, da dies nicht der Fall ist erforderlich Der Empfänger fordert den Sender explizit auf, ein gesendetes Paket erneut zu übertragen.

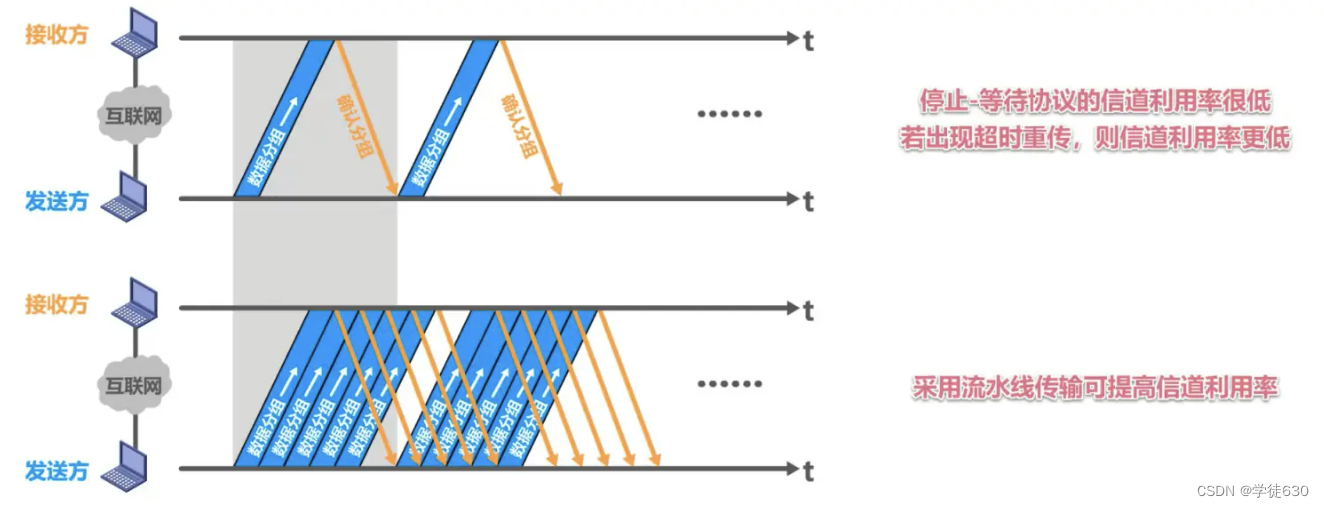

Fallback-N-Frame-Protokoll GBN

Warum das Fallback-N-Frame-Protokoll verwenden?

Im gleichen Zeitraum kann der Absender, der das Stop-Wait-Protokoll verwendet, nur ein Datenpaket senden, während der Absender, der die Pipeline-Übertragung verwendet, mehrere Datenpakete senden kann.

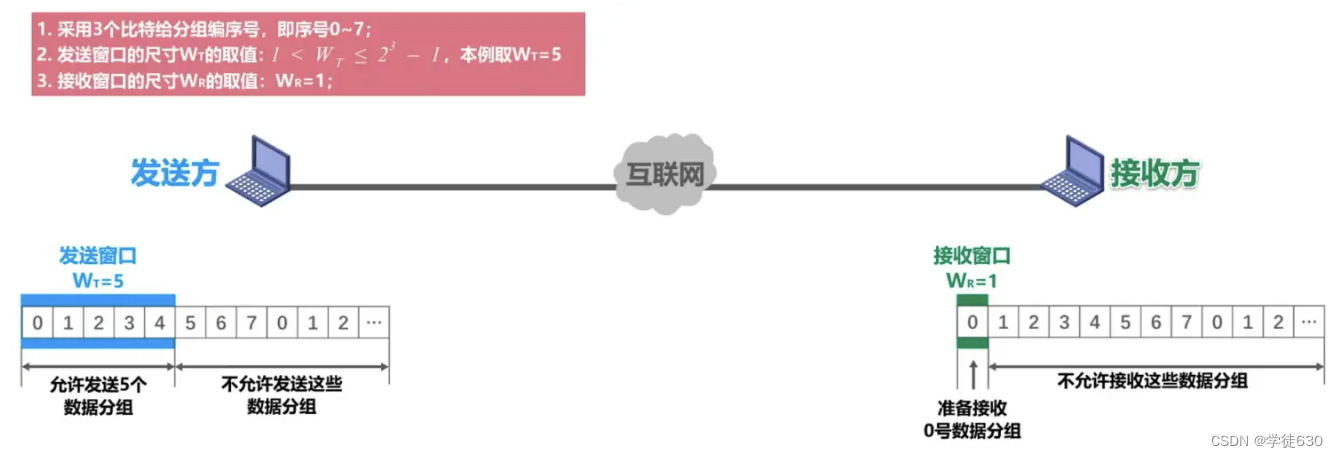

Basierend auf der Pipeline-Übertragung verwendet das Fallback-N-Frame-Protokoll das Sendefenster , um die Anzahl der Datenpakete zu begrenzen, die der Absender kontinuierlich senden kann.

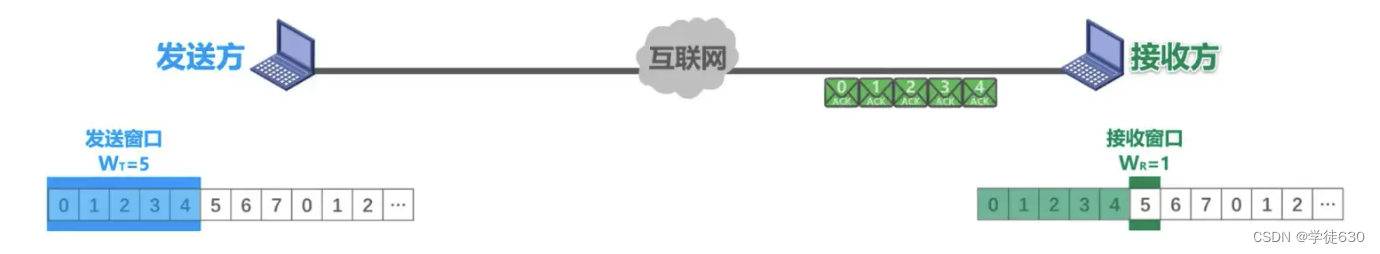

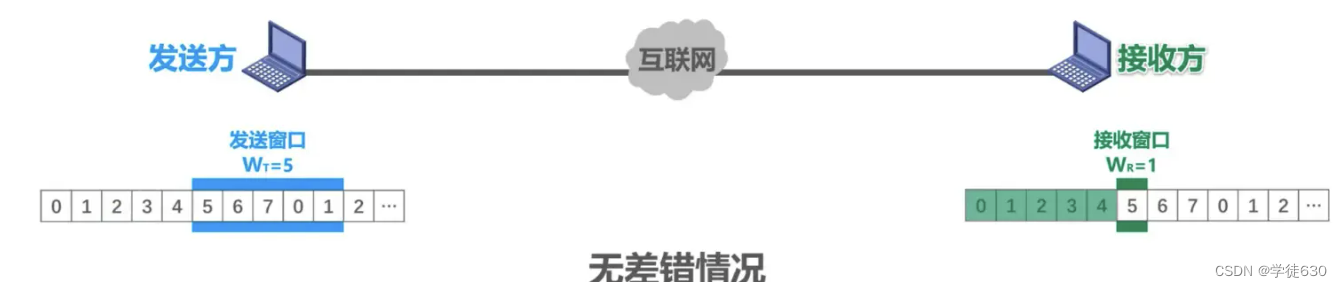

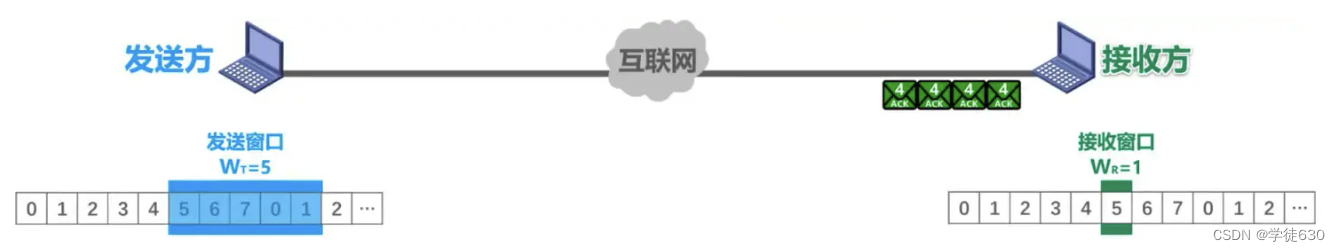

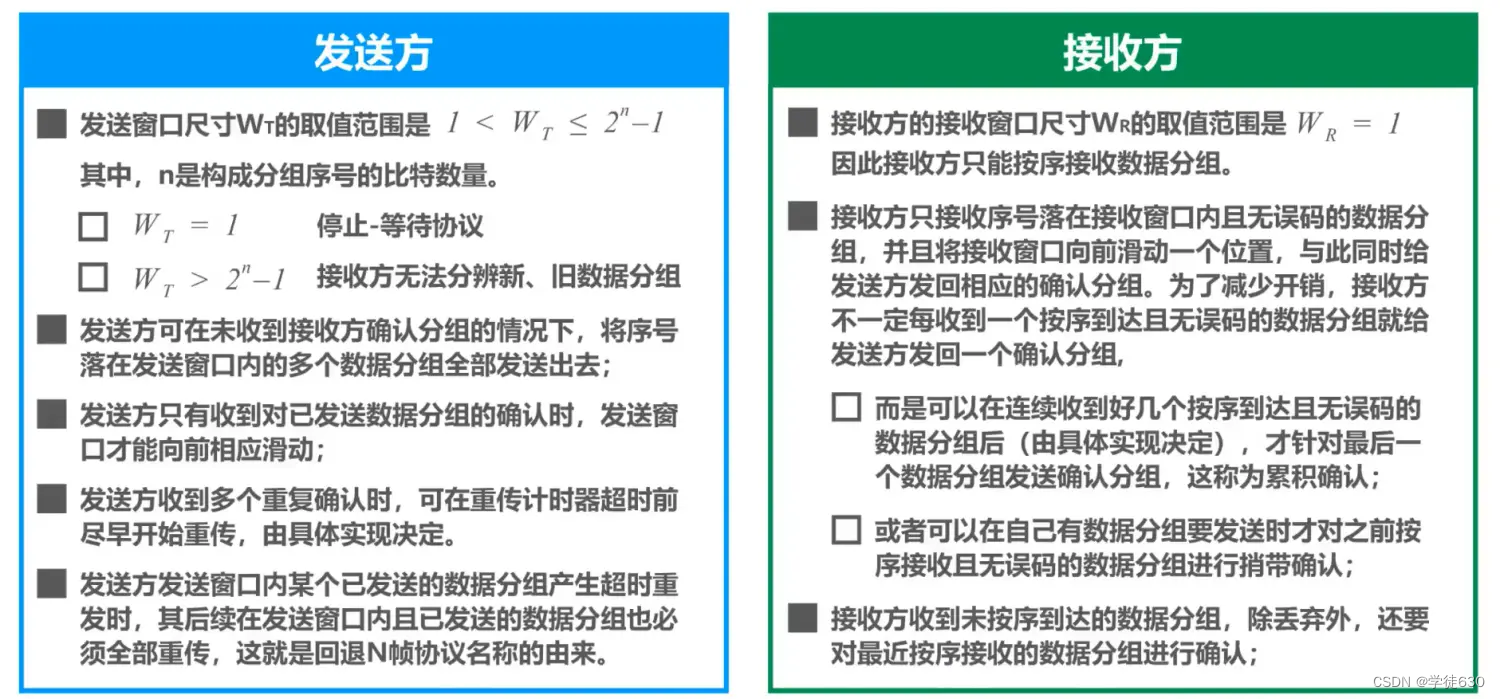

fehlerfreier Ablauf

Der Absender gruppiert Daten von 0 bis 4, deren Sequenznummern in das Sendefenster fallen, und sendet sie nacheinander aus.

Sie kommen durch die Internetübertragung korrekt beim Empfänger an, d. h. es liegt keine Störung oder Fehler vor. Der Empfänger empfängt sie der Reihe nach. Bei jedem Empfang schiebt sich das Empfangsfenster um eine Position nach vorne und sendet ein Bestätigungspaket für das empfangene Paket an den Absender. Die Übertragung über das Internet erreicht den Absender korrekt

Jedes Mal, wenn der Absender eines empfängt, verschiebt sich das Sendefenster um eine Position nach vorne, sodass eine neue Sequenznummer in das Sendefenster fällt. Der Absender kann das bestätigte Datenpaket aus dem Cache löschen und der Empfänger kann die Möglichkeit wählen, das empfangene Datenpaket zu senden Datenpaket. Die Datenpakete werden zur Verarbeitung an die obere Schicht übermittelt

Das sendende Ende sendet kontinuierlich mehrere Datenrahmen, und diese Datenrahmen werden der Reihe nach nummeriert. Der Empfänger empfängt diese Datenrahmen in derselben Reihenfolge. Nach dem Empfang eines Datenrahmens sendet die empfangende Seite einen Bestätigungsrahmen an die sendende Seite. Der Bestätigungsrahmen trägt die Sequenznummer des nächsten erwarteten Datenrahmens.

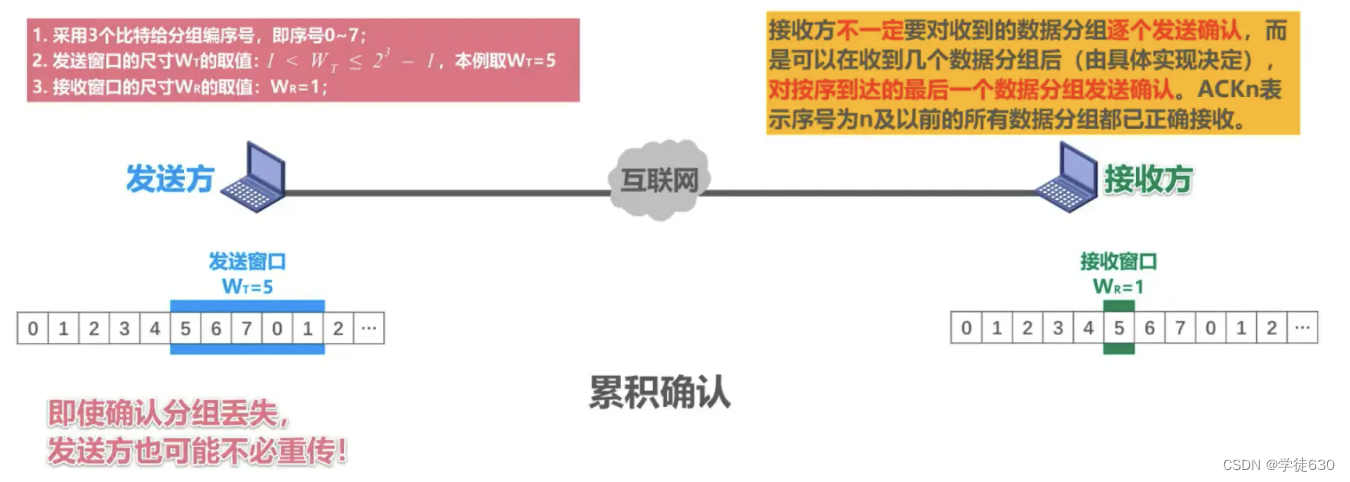

Kumulative Bestätigung

Kumulative Bestätigung bedeutet, dass das empfangende Ende nur Bestätigungsrahmen sendet, die die Sequenznummer des nächsten erwarteten Datenrahmens enthalten , anstatt jedes Mal, wenn ein Datenrahmen empfangen wird, einen Bestätigungsrahmen zu senden. Wenn der Absender den Bestätigungsrahmen empfängt, weiß er, dass alle Datenrahmen vor dem Bestätigungsrahmen korrekt empfangen und vom Empfänger bestätigt wurden.

Konkret verwaltet der Absender ein Schiebefenster mit der Größe N. Der Absender sendet kontinuierlich Datenrahmen innerhalb des Fensters. Jedes Mal, wenn ein Datenrahmen gesendet wird, startet der Absender einen Timer. Wenn der Absender den erwarteten Bestätigungsrahmen vor Ablauf des Timers empfängt, schiebt er das Schiebefenster um eine Position nach vorne und setzt den Timer zurück. Wenn der Absender einen Bestätigungsrahmen mit Zeitüberschreitung oder keinen Bestätigungsrahmen empfängt, sendet er alle Datenrahmen innerhalb des Fensters erneut. Auf diese Weise gewährleistet die sendende Seite eine zuverlässige Datenübertragung.

Kumulative Bestätigung

Vorteil:

- Selbst wenn ein Paket als verloren bestätigt wird, muss der Absender es möglicherweise nicht erneut übertragen

- Reduzieren Sie den Empfängeraufwand

- Reduzieren Sie die Nutzung von Netzwerkressourcen

Mangel:

- Die Datenpaketinformationen, die der Empfänger korrekt empfangen hat, können dem Absender nicht umgehend übermittelt werden

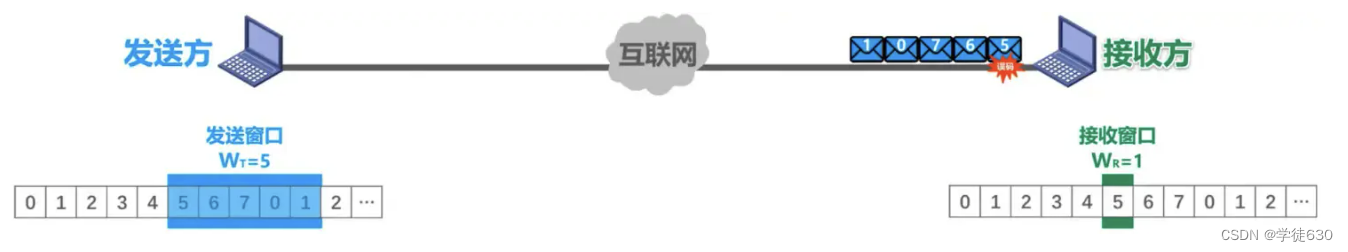

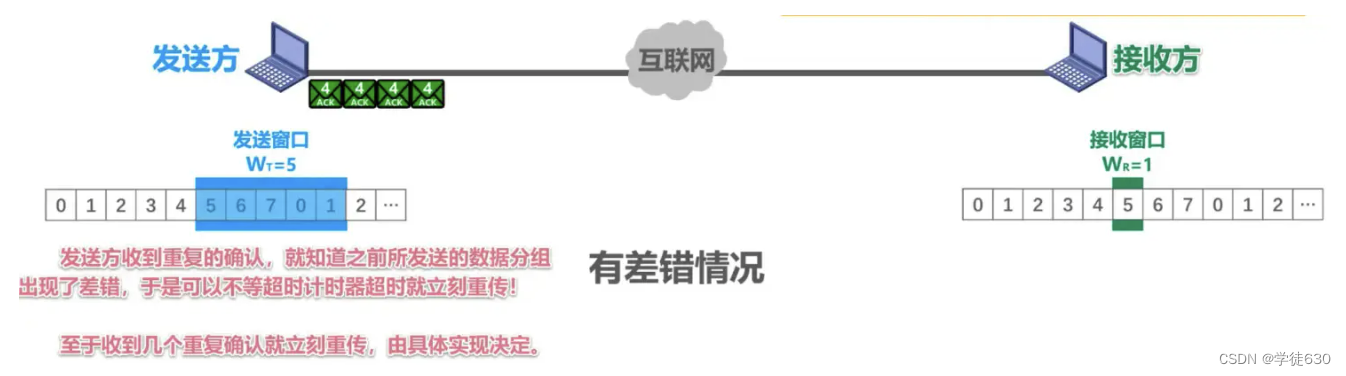

Es liegt eine Fehlersituation vor

Bei der Übertragung von Datenpaketen trat im Datenpaket Nr. 5 ein Bitfehler auf, und der Empfänger erkannte den Fehler anhand des Fehlererkennungscodes im Datenpaket.

Daher wird das Paket (das problematische Paket) verworfen und die verbleibenden vier Pakete, die anschließend eintreffen, stimmen nicht mit den Sequenznummern des Empfangsfensters überein.

Auch der Empfänger kann sie nicht empfangen, verwirft sie und quittiert das letzte zuvor empfangene Datenpaket der Reihe nach mit dem Senden eines ACK4. Jedes Mal, wenn ein Datenpaket verworfen wird, wird ein ACK4 gesendet.

Wenn ein doppeltes ACK4 empfangen wird, ist bekannt, dass im zuvor gesendeten Datenpaket ein Fehler vorliegt, sodass die erneute Übertragung unmittelbar vor Ablauf des Timeout-Timers gestartet werden kann. Die spezifische Anzahl doppelter Bestätigungen wird je nach Spezifisch sofort erneut übertragen Implementierung.

Wenn diese 4 doppelten Bestätigungen empfangen werden, wird die Sendung nach einer gewissen Zeit nicht sofort erneut gesendet. Wenn der Timeout-Timer abläuft, werden alle innerhalb des Sendefensters gesendeten Datenpakete erneut übertragen.

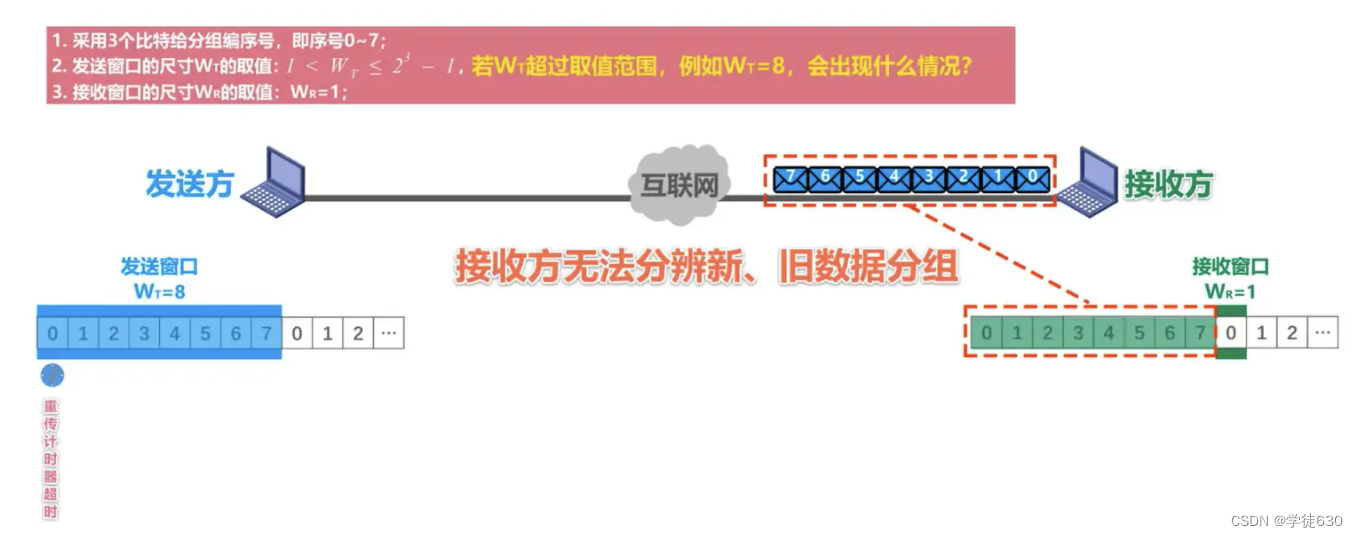

Was passiert, wenn WT den Wertebereich überschreitet, beispielsweise WT=8?

Zusammenfassen

Das Fallback-N-Frame-Protokoll verwendet das Übertragungsfenster, um die Anzahl der vom Absender kontinuierlich gesendeten Datenpakete auf der Grundlage der Pipeline-Übertragung zu begrenzen. Es handelt sich um ein kontinuierliches ARQ-Protokoll.

Während des Arbeitsprozesses des Protokolls gleiten das Sendefenster und das Empfangsfenster weiter nach vorne, daher wird dieser Protokolltyp auch als Gleitfensterprotokoll bezeichnet.

Aufgrund der Eigenschaften des Fallback-N-Frame-Protokolls ist die Kanalauslastung bei schlechter Kommunikationsleitungsqualität nicht höher als die des Stop-and-Wait-Protokolls.

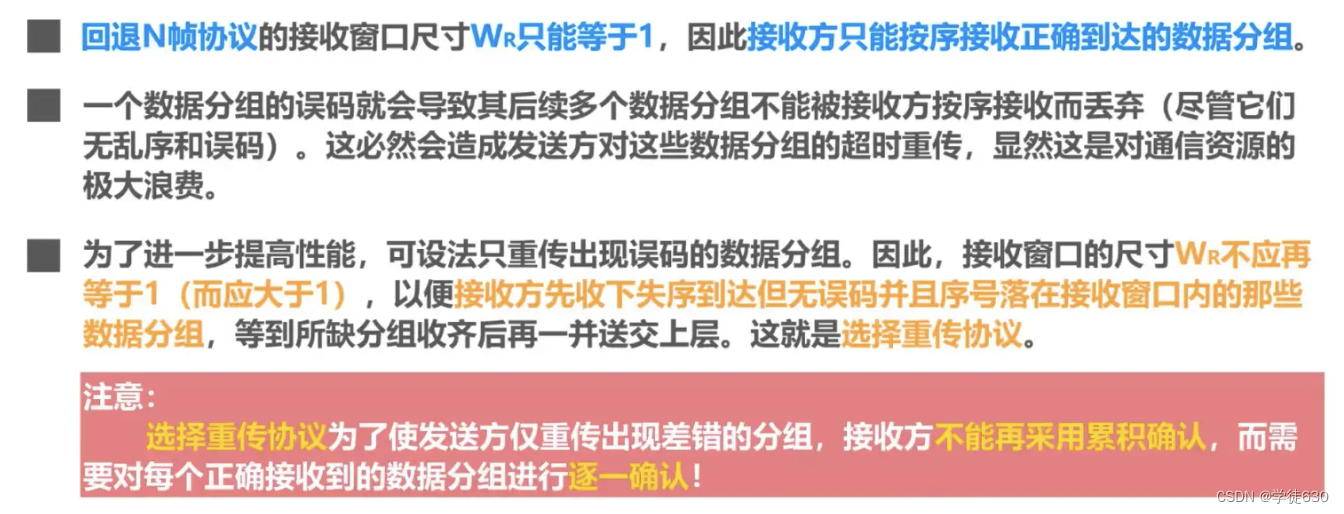

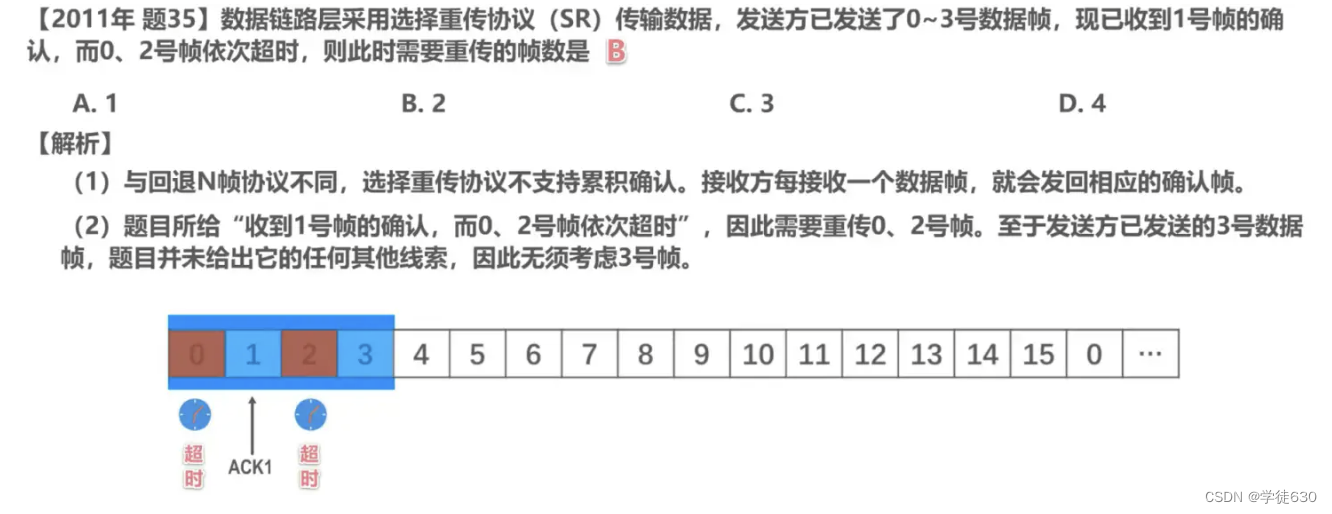

Wählen Sie das Neuübertragungsprotokoll SR

Im SR-Protokoll nummeriert und sendet das sendende Ende Datenrahmen nacheinander , und das empfangende Ende empfängt diese Datenrahmen in derselben Reihenfolge. Anders als beim GBN-Protokoll bestätigt der Empfänger jeden empfangenen Datenrahmen separat. Jedes Mal, wenn die Empfangsseite einen Datenrahmen empfängt, sendet sie einen Bestätigungsrahmen an die Sendeseite. Der Bestätigungsrahmen trägt die Sequenznummer des Datenrahmens .

Konkret unterhält der Absender ein Sendefenster und ein Empfangsfenster. Datenrahmen innerhalb des Sendefensters wurden gesendet, aber keine Bestätigung empfangen , und Datenrahmen innerhalb des Empfangsfensters wurden empfangen, aber nicht von der Anwendung der oberen Schicht verarbeitet . Der Absender sendet regelmäßig Datenrahmen, die innerhalb des Fensters keine Bestätigung erhalten haben, und startet einen Timer.

Wenn ein Datenrahmen empfangen wird, bestätigt das empfangende Ende den Datenrahmen und übermittelt ihn an die Anwendung der oberen Schicht. Wenn die empfangende Seite einen fehlenden Datenrahmen findet, sendet sie einen selektiven Bestätigungsrahmen an die sendende Seite, der die Sequenznummer des nächsten erwarteten Datenrahmens enthält. Nach dem Empfang des selektiven Bestätigungsrahmens überträgt der Absender nur die durch den Bestätigungsrahmen bestätigten Datenrahmen erneut, anstatt alle Datenrahmen innerhalb des Fensters erneut zu übertragen.

Das empfangende Ende verwirft die empfangenen doppelten Datenrahmen und sendet keinen Bestätigungsrahmen. Nach Erhalt des Bestätigungsrahmens löscht den bestätigten Datenrahmen aus dem Sendefenster und verschiebt das Fenster, um das Senden neuer Datenrahmen zu ermöglichen.

Das selektive Neuübertragungsprotokoll überträgt Datenrahmen selektiv erneut und überträgt nur verlorene Datenrahmen erneut, wodurch die Effizienz des Protokolls verbessert wird. Dies kann die Belastung des Senders durch erneute Übertragungen verringern und es dem Empfänger ermöglichen, Datenrahmen in einer nicht ordnungsgemäßen Weise zu verarbeiten. Im Vergleich zum GBN-Protokoll muss das SR-Protokoll jedoch sowohl auf der Sendeseite als auch auf der Empfangsseite mehr Zustände und logische Beurteilungen aufrechterhalten.

Zusammenfassend lässt sich sagen, dass das Selective Retransmission Protocol (SR) die Zuverlässigkeit der Datenübertragung durch einen selektiven Neuübertragungsmechanismus erreicht. Der Absender verwaltet das Sendefenster und das Empfangsfenster, sendet Datenrahmen der Reihe nach und führt basierend auf dem Bestätigungsstatus des Empfangsendes selektive Neuübertragungs- oder Schiebevorgänge durch. Die Empfangsseite bestätigt empfangene Datenrahmen selektiv und verarbeitet den Empfang außerhalb der Reihenfolge. Auf diese Weise kann das SR-Protokoll die Effizienz und Zuverlässigkeit der Datenübertragung verbessern.

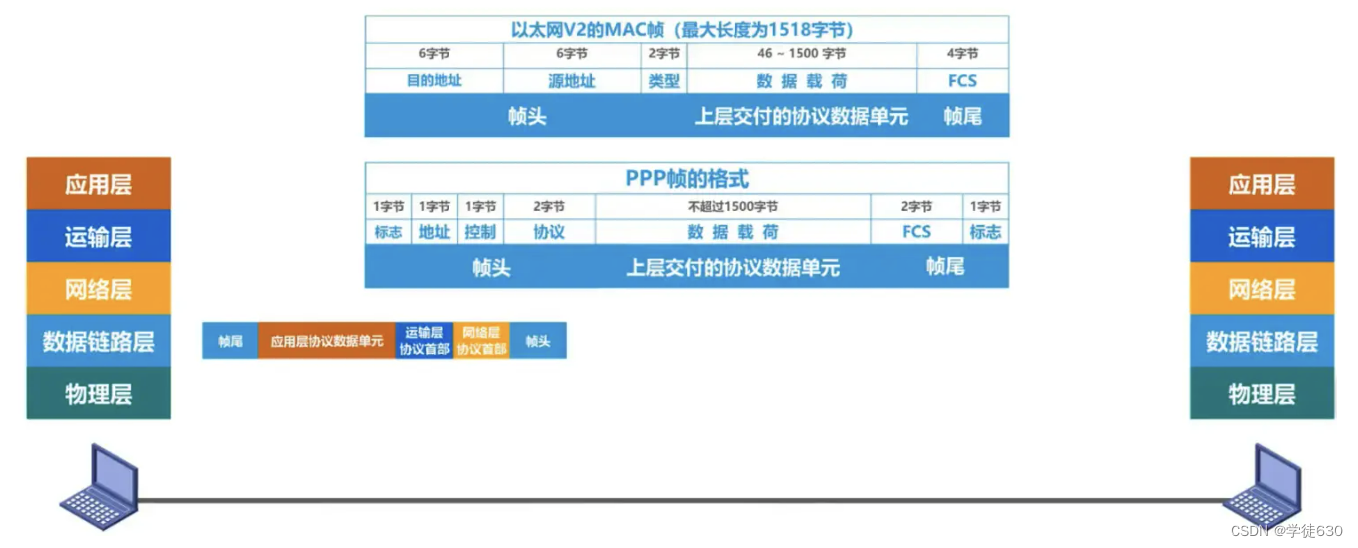

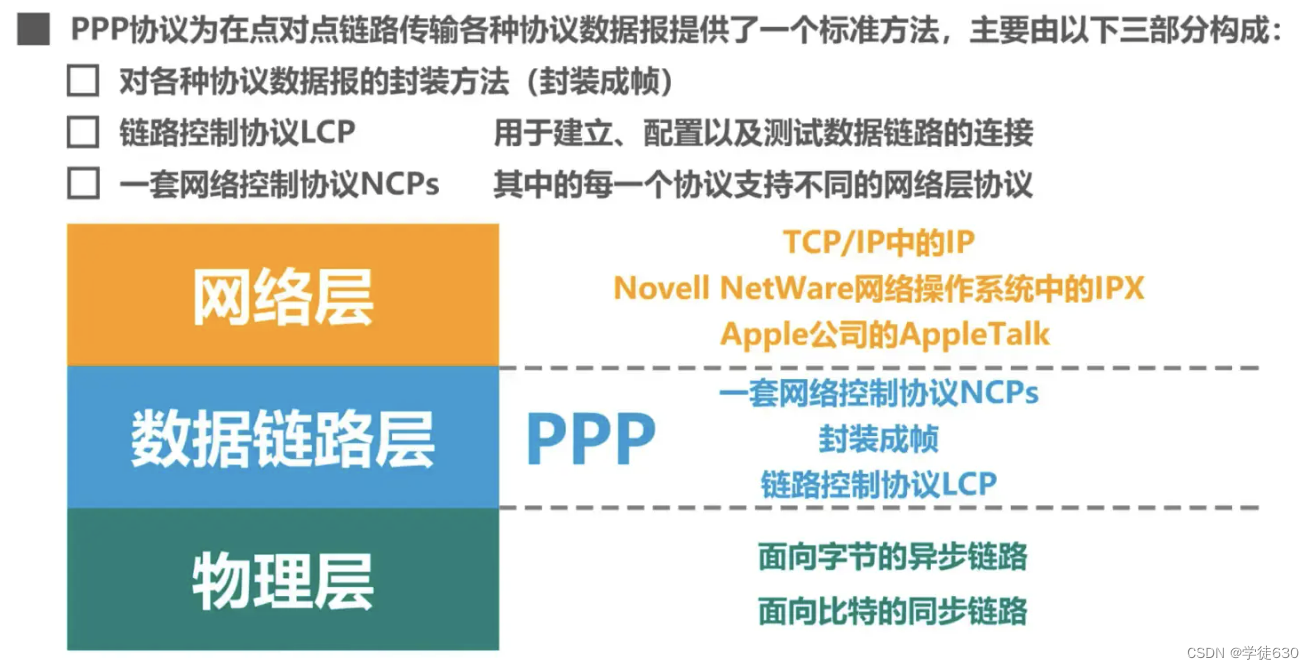

3.5. Punkt-zu-Punkt-Protokoll PPP

-

Punkt-zu-Punkt-Protokoll PPP (Punkt-zu-Punkt-Protokoll) ist derzeit das am weitesten verbreitete Punkt-zu-Punkt-Datenverbindungsschichtprotokoll

-

Das PPP-Protokoll wurde 1992 von der Internet Engineering Task Force IEIF entwickelt. Nach Überarbeitungen in den Jahren 1993 und 1994 ist das aktuelle PPP-Protokoll zum offiziellen Standard des Internets geworden [RFC1661, RFC1662].

-

Ein von der Datenverbindungsschicht verwendetes Protokoll. Seine Eigenschaften sind: einfach; es erkennt Fehler nur, anstatt sie zu korrigieren; es verwendet keine Sequenznummern und führt keine Flusskontrolle durch; es kann mehrere Netzwerkschichtprotokolle gleichzeitig unterstützen.

- PPPoE ist ein Verbindungsschichtprotokoll , das von Hosts mit Breitband-Internetzugang verwendet wird

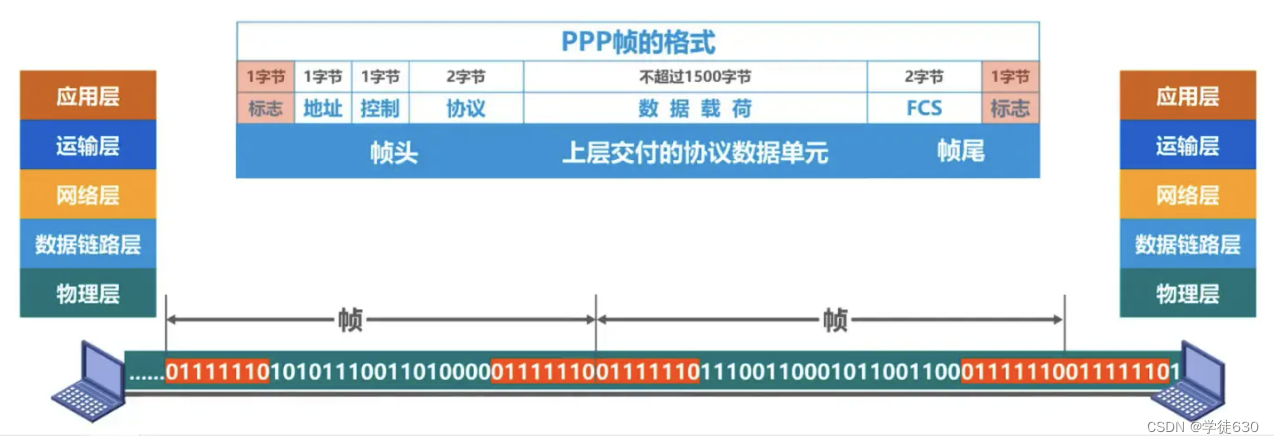

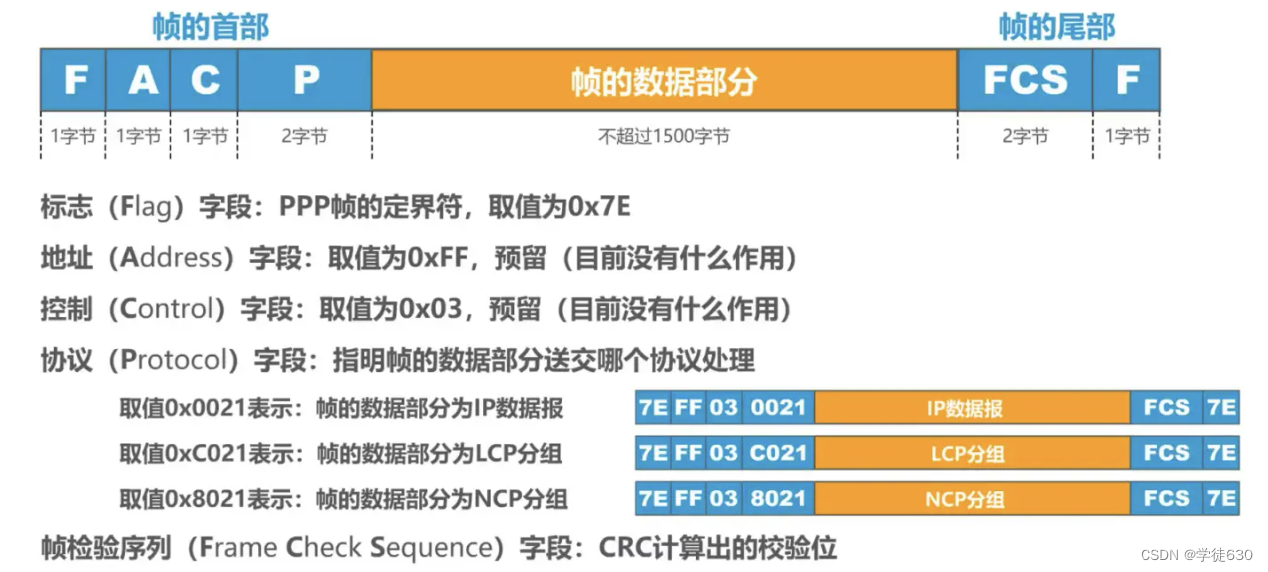

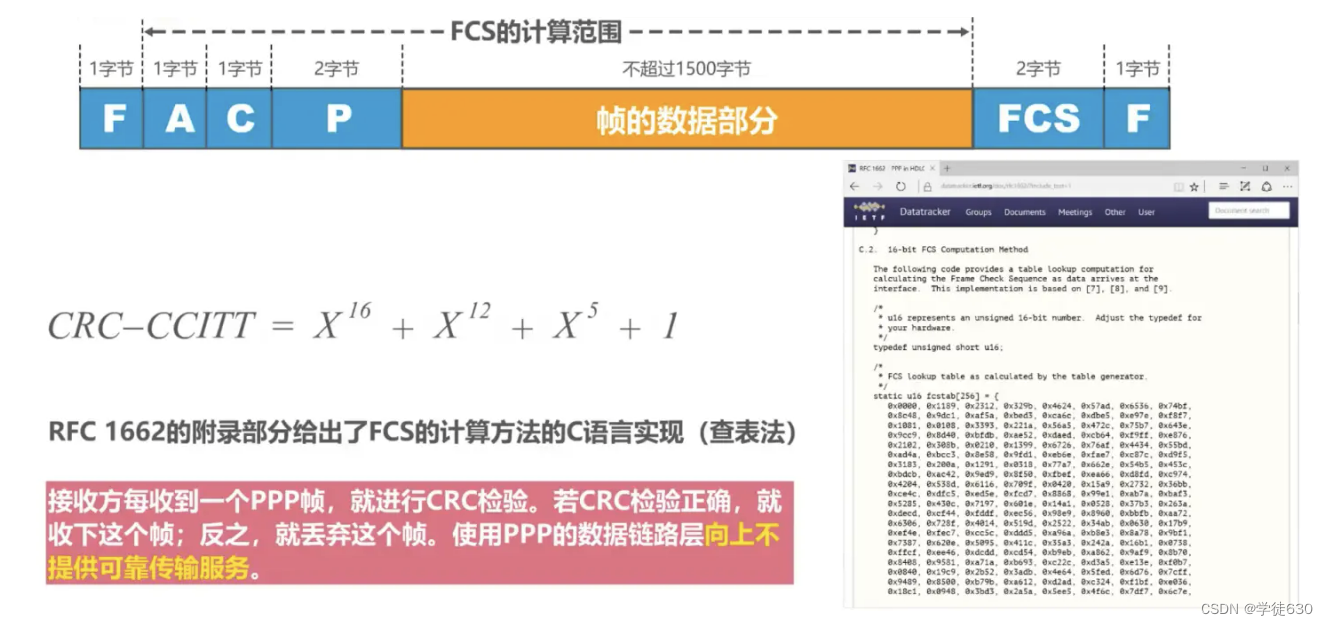

Rahmenformat

Als Rahmentrennzeichen müssen Sonderzeichen angegeben werden

Transparente Übertragung

Die Transparenz der Datenübertragung muss gewährleistet sein

Methoden zur Erzielung einer transparenten Übertragung

- Byteorientierte asynchrone Links: Byte-Stuffing (Einfügen von „Escape-Zeichen“)

- Bitorientierte Synchronisationsverbindung: Bit-Stuffing-Methode (Einfügung von „Bit 0“)

Fehlererkennung

Fähigkeit, auf der Empfangsseite empfangene Frames zu erkennen und fehlerhafte Frames sofort zu verwerfen .

Arbeits status

-

Wenn sich ein Benutzer bei einem ISP einwählt, bestätigt das Modem des Routers die Einwahl und stellt eine physische Verbindung her.

-

Der PC sendet eine Reihe von LCP-Paketen (gekapselt in mehrere PPP-Frames) an den Router.

-

Diese Pakete und ihre Antworten wählen einige PPP-Parameter aus und führen die Konfiguration der Netzwerkschicht durch. NCP gibt den neu aufgerufenen PC an

-

Weisen Sie eine temporäre IP-Adresse zu, um den PC zum Host im Internet zu machen.

-

Wenn die Kommunikation abgeschlossen ist, gibt NCP die Netzwerkschichtverbindung frei und nimmt die ursprünglich zugewiesene IP-Adresse zurück. Als nächstes gibt LCP die Datenverbindungsschichtverbindung frei. Das Letzte, was veröffentlicht wird, ist die Verbindung der physikalischen Ebene.

Es ist ersichtlich, dass das PPP-Protokoll kein reines Datenverbindungsschichtprotokoll mehr ist, sondern auch den Inhalt der physikalischen Schicht und der Netzwerkschicht umfasst.

3.6. Medienzugriffskontrolle (Medienzugriffskontrolle) – Sendekanal

Media Access Control (Media Access Control) verwendet eine Eins-zu-Viele-Broadcast-Kommunikationsmethode

Die Medienzugriffskontrolle wird in Medienzugriffskontrolle übersetzt, und einige werden in Medienzugriffskontrolle übersetzt.

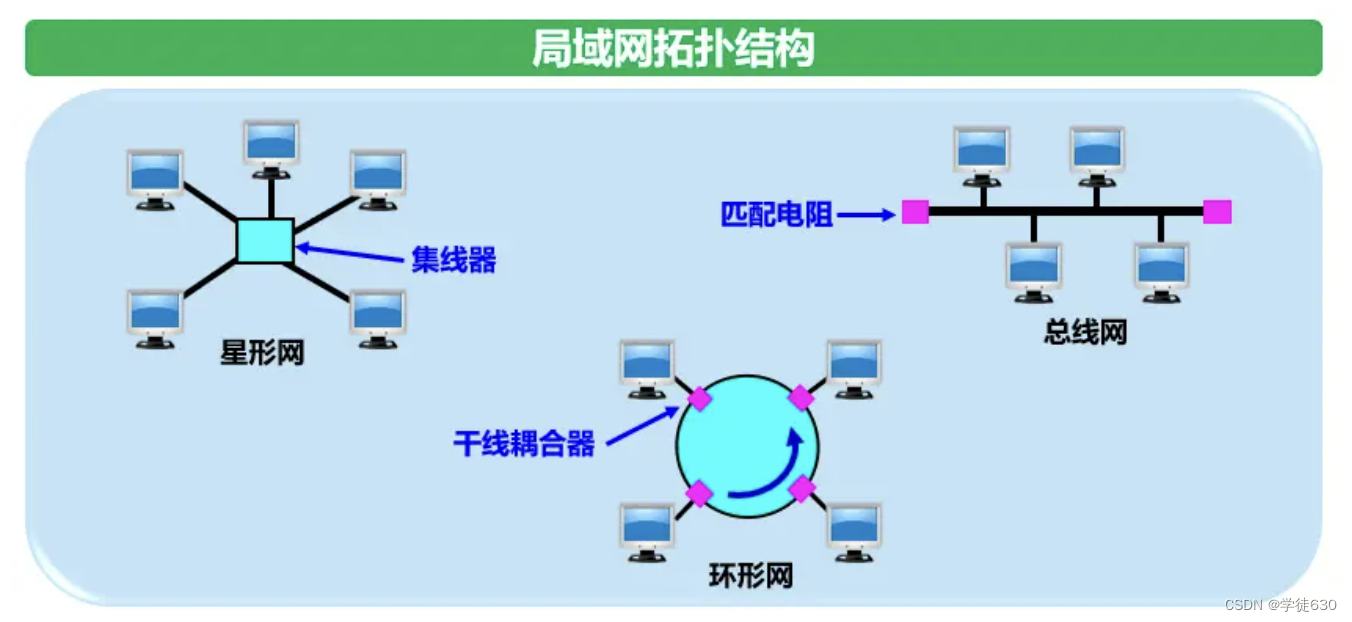

Datenverbindungsschicht eines lokalen Netzwerks

-

Die Hauptmerkmale von LAN sind:

-

Das Netzwerk gehört einer Einheit;

-

Der geografische Umfang und die Anzahl der Standorte sind begrenzt.

-

-

LAN hat die folgenden Hauptvorteile :

-

Mit der Broadcast-Funktion kann problemlos von einem Standort aus auf das gesamte Netzwerk zugegriffen werden. Hosts im LAN können verschiedene mit dem LAN verbundene Hardware- und Softwareressourcen gemeinsam nutzen.

-

Um die Systemerweiterung und schrittweise Weiterentwicklung zu erleichtern, kann der Standort jedes Geräts flexibel angepasst und geändert werden.

-

Verbesserte Systemzuverlässigkeit, Verfügbarkeit und Überlebensfähigkeit.

-

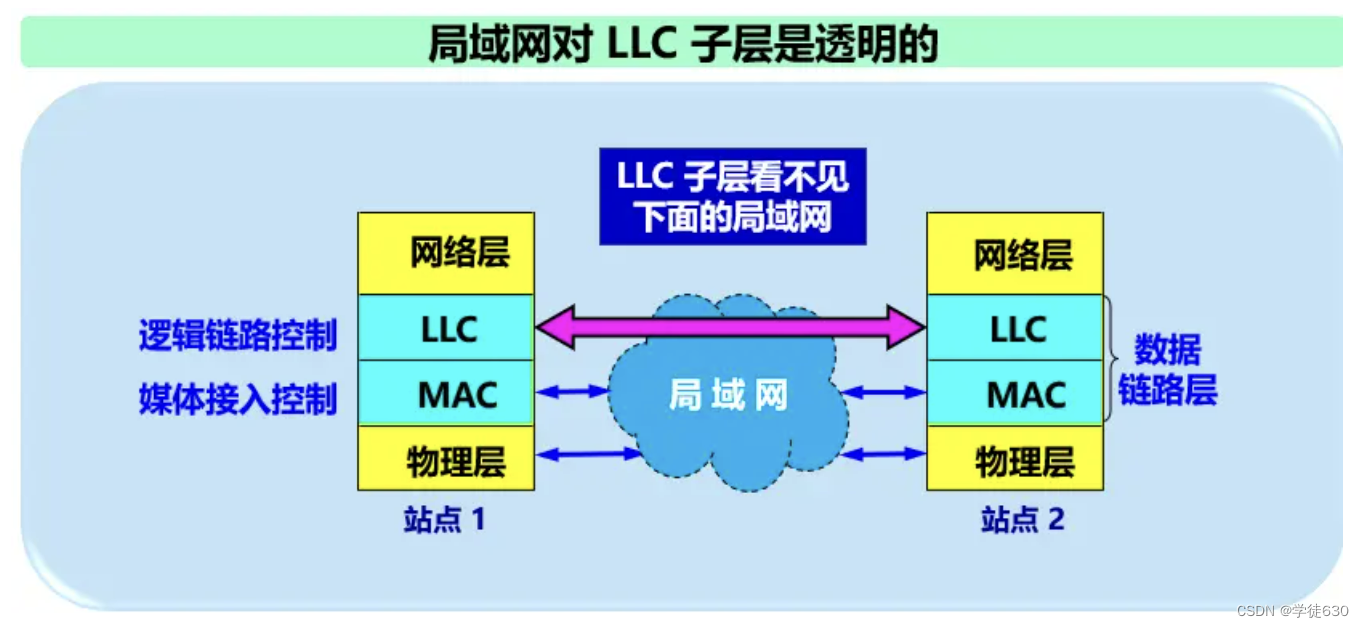

Zwei Unterschichten der Datenverbindungsschicht

Um die Datenverbindungsschicht besser an mehrere LAN-Standards anpassen zu können, hat das IEEE 802-Komitee die Datenverbindungsschicht des LAN in zwei Unterschichten aufgeteilt :

-

Unterschicht Logical Link Control LLC (Logical Link Control);

-

Media Access Control MAC-Unterschicht (Medium Access Control).

Inhalte, die sich auf den Zugriff auf die Übertragungsmedien beziehen, werden in der MAC-Unterschicht platziert, während die LLC-Unterschicht nichts mit den Übertragungsmedien zu tun hat. Unabhängig vom verwendeten LAN-Protokoll ist es für die LLC-Unterschicht transparent.

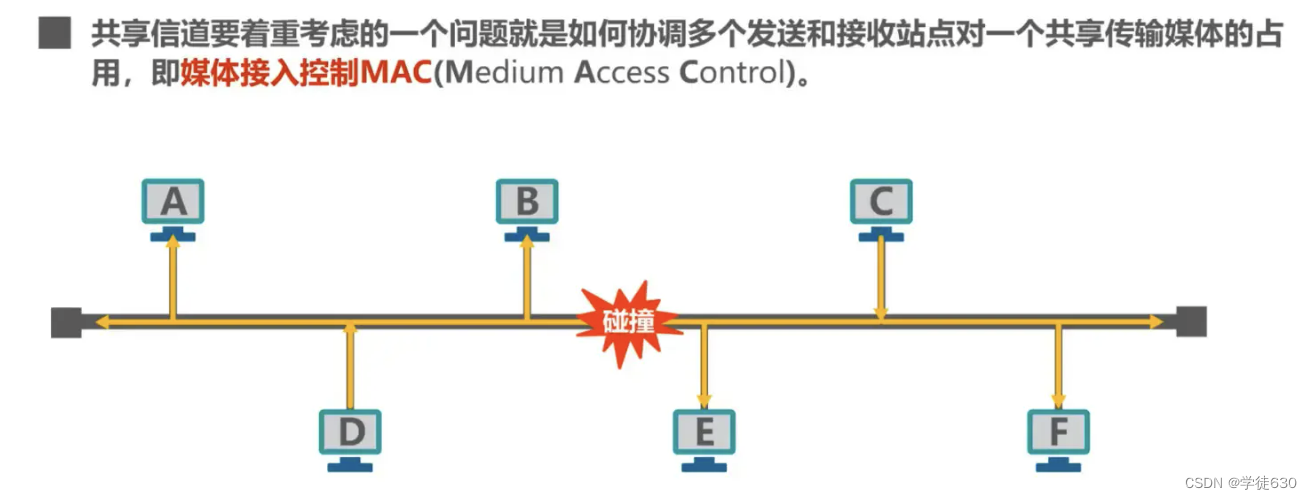

Basiskonzept

Warum Medienzugriffskontrolle (Media Access Control)?

Probleme durch Geteilte Kanäle

Wenn mehrere Geräte gleichzeitig Daten auf dem gemeinsamen Kanal senden, stören sie sich gegenseitig und führen zu einem Übertragungsfehler.

Mit der Entwicklung der Technologie, der Reife der Switching-Technologie und der Kostensenkung haben Switch-LANs mit höherer Leistung, die Punkt-zu-Punkt-Verbindungen und Link-Layer-Switches verwenden, gemeinsam genutzte LANs im kabelgebundenen Bereich vollständig ersetzt. Aufgrund der Verbreitung von Drahtlose Kanäle Von Natur aus nutzen drahtlose LANs immer noch Shared-Media-Technologie

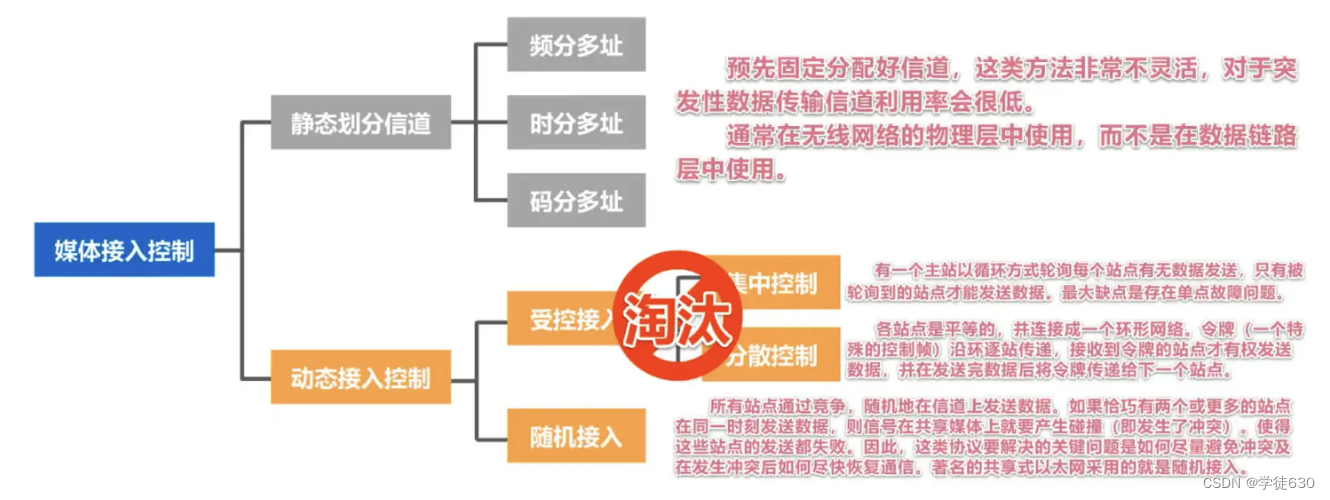

Statische Kanalzuordnung

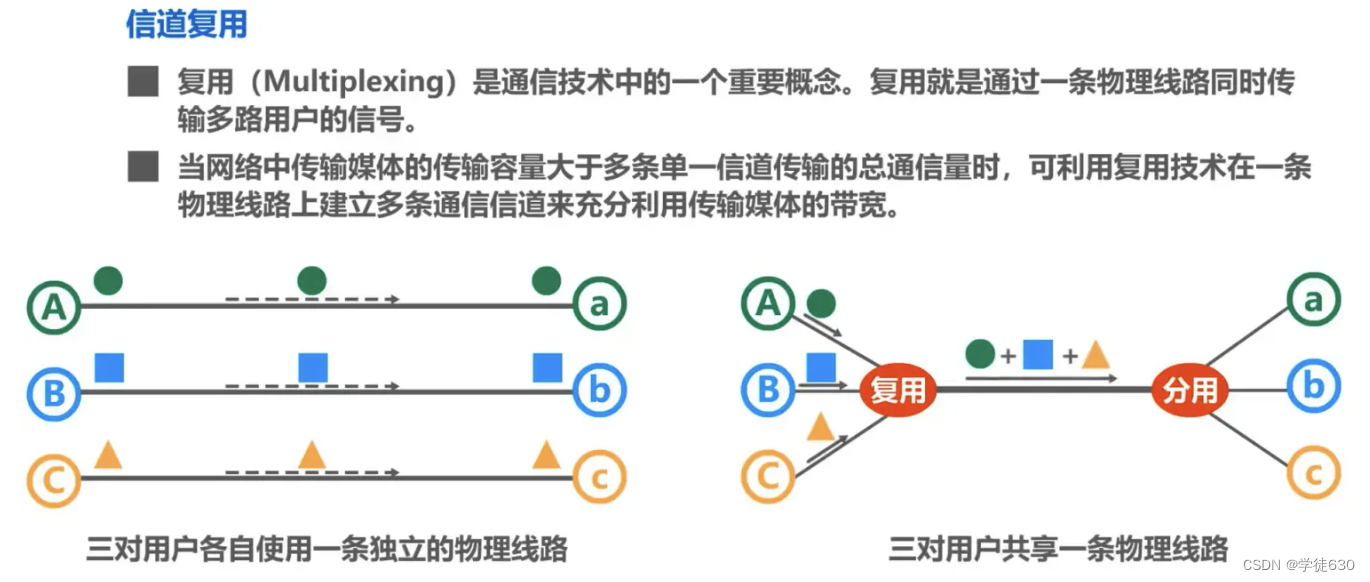

Kanalmultiplexing

Frequenzmultiplex FDM (Frequency Division Multiplexing)

-

Die gesamte Bandbreite wird in mehrere Teile aufgeteilt. Nachdem dem Benutzer ein bestimmtes Frequenzband zugewiesen wurde, wird er dieses Frequenzband während des gesamten Kommunikationsprozesses belegen.

-

Alle Nutzer des Frequenzmultiplexes belegen gleichzeitig unterschiedliche Bandbreitenressourcen (bitte beachten Sie, dass es sich bei der „Bandbreite“ hier um die Frequenzbandbreite und nicht um die Datenübertragungsrate handelt).

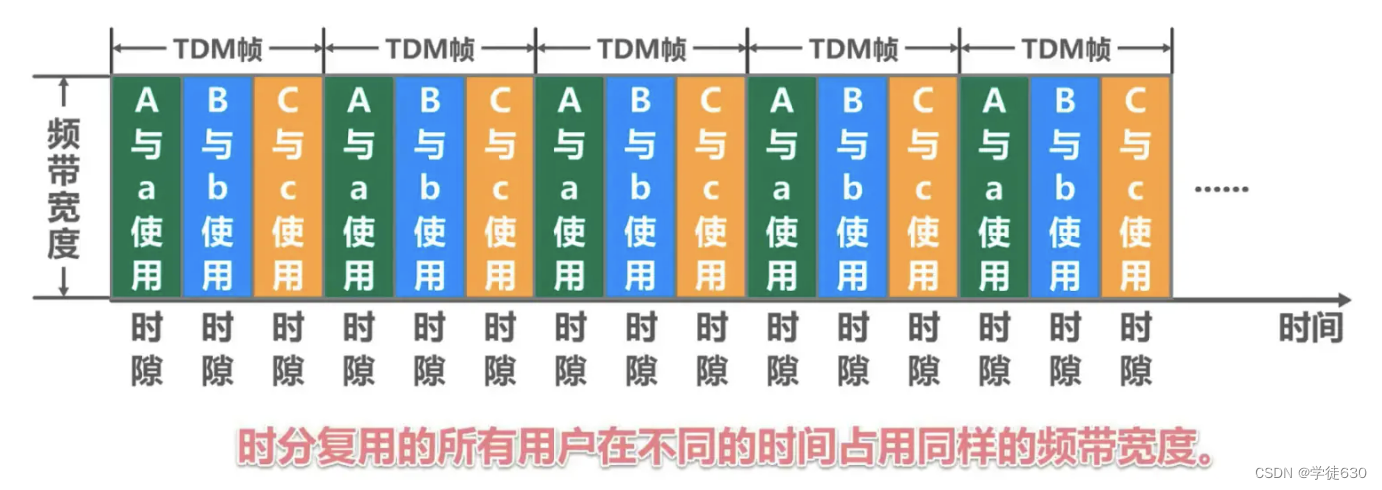

Zeitmultiplex TDM (Time Division Multiplexing)

-

Zeitmultiplex unterteilt die Zeit in Zeitmultiplexrahmen (TDM-Rahmen) gleicher Länge . Jeder Zeitmultiplex-Benutzer belegt in jedem TDM-Frame eine feste Anzahl von Zeitschlitzen, was dem Laufprinzip der vom Task-Scheduler in der Java-Sprache für Threads verteilten Zeitscheiben ähnelt.

-

Der von jedem Benutzer belegte Zeitschlitz wird periodisch angezeigt (der Zeitraum entspricht der Länge des TDM-Frames).

-

TDM-Signale werden auch isochrone Signale genannt.

-

Alle Nutzer des Zeitmultiplexverfahrens belegen zu unterschiedlichen Zeiten die gleiche Frequenzbandbreite.

Wellenlängenmultiplex WDM (Wellenlängenmultiplex)

Wellenlängenmultiplex ist ein Frequenzmultiplex von Licht , bei dem eine optische Faser zur gleichzeitigen Übertragung mehrerer optischer Trägersignale verwendet wird

Das optische Signal wird nach der Übertragung über eine bestimmte Distanz schwächer, daher wird ein Erbium-dotierter Faserverstärker zur Verstärkung des optischen Signals verwendet.

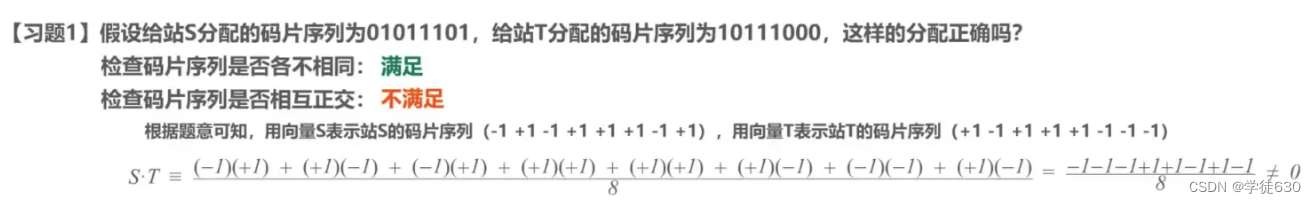

Codemultiplexing CDM (Codemultiplexing)

dynamische Zugangskontrolle

Direktzugriff (CSMA/CD-Protokoll)

Bus-LAN-Nutzungsprotokoll: CSMA/CD

Basiskonzept

Das ursprüngliche Ethernet verband viele Computer mit einem Bus. Einfach zu implementierende Broadcast-Kommunikation. Ursprünglich ging man davon aus, dass diese Verbindungsmethode einfach und zuverlässig sei, da keine aktiven Geräte am Bus vorhanden seien.

Ethernet ist eine lokale Netzwerktechnologie für Computer . Der IEEE 802.3-Standard der IEEE-Organisation formuliert den technischen Standard von Ethernet

Ethernet verwendet einen verbindungslosen Arbeitsmodus. Die gesendeten Datenrahmen sind nicht nummeriert und erfordern keine Rückbestätigung der anderen Partei. Wenn die Zielstation einen Fehlerrahmen empfängt, verwirft sie diesen und führt keine weiteren Aktionen aus.

MA mit Mehrfachzugriff

Zeigt an, dass viele Hosts über einen Mehrpunktzugriff mit einem Bus verbunden sind.

Trägersinn CS

Das bedeutet, dass jede Station vor dem Senden von Daten zunächst erkennen muss, ob andere Computer am Bus Daten senden. Wenn dies der Fall ist, sendet sie vorübergehend keine Daten, um Kollisionen zu vermeiden.

Es gibt keinen „Träger“ im Bus. Daher ist „Trägerüberwachung“ die Verwendung elektronischer Technologie, um zu erkennen, ob Datensignale von anderen Computern auf dem Bus gesendet werden.

Kollisionserkennungs-CD

-

„Kollisionserkennung“ bedeutet, dass der Computer beim Senden von Daten die Signalspannung auf dem Kanal erkennt.

-

Wenn mehrere Stationen gleichzeitig Daten auf dem Bus senden, erhöhen sich die Signalspannungsschwankungen auf dem Bus (addieren sich).

-

Wenn der von einer Station erkannte Signalspannungsschwankungswert einen bestimmten Schwellenwert überschreitet, wird davon ausgegangen, dass mindestens zwei Stationen am Bus gleichzeitig Daten senden, was darauf hinweist, dass eine Kollision aufgetreten ist.

-

Die sogenannte „Kollision“ bedeutet, dass ein Konflikt aufgetreten ist. Daher wird „Kollisionserkennung“ auch „Konflikterkennung“ genannt.

-

Bei einer Kollision wird das auf dem Bus übertragene Signal stark verzerrt und nützliche Informationen können daraus nicht wiederhergestellt werden.

-

Jede Station, die Daten sendet, muss, sobald sie eine Kollision auf dem Bus feststellt, das Senden sofort stoppen, um eine Verschwendung von Netzwerkressourcen zu vermeiden, und dann eine zufällige Zeitspanne warten, bevor sie erneut sendet.

Warum Kollisionserkennung? Weil sich die Verzögerung der Signalausbreitung auf die Trägerüberwachung auswirkt

A benötigt das Zweifache der Einwegverzögerung, um einen Konflikt mit der Übertragung von B zu erkennen.

CSMA/CD-Protokoll-Workflow

CSMA/CD-Protokoll funktioniert – Konfliktzeitraum (Kollisionsfenster)

CSMA/CD-Protokoll funktioniert – minimale Framelänge

CSMA/CD-Protokoll funktioniert – maximale Framelänge

CSMA/CD-Protokoll funktioniert – verkürzter binärer exponentieller Backoff-Algorithmus

CSMA/CD-Protokollbetrieb – Kanalnutzung

CSMA/CD-Protokollarbeit – Frame-Empfangsprozess

Wichtige Funktionen des CSMA/CD-Protokolls

-

Ethernet, das das CSMA/CD-Protokoll verwendet, kann keine Vollduplex-Kommunikation durchführen, sondern nur bidirektionale alternierende Kommunikation (Halbduplex-Kommunikation).

-

Innerhalb kurzer Zeit, nachdem jede Station Daten gesendet hat, besteht die Möglichkeit einer Kollision.

-

Diese Unsicherheit bei der Übertragung führt dazu, dass das durchschnittliche Verkehrsaufkommen des gesamten Ethernet-Netzwerks deutlich unter der maximalen Datenrate von Ethernet liegt.

Das CSMA/CD-Protokoll wurde in frühen Versionen verschiedener Busstrukturen Ethernet und Twisted-Pair-Ethernet verwendet.

Das heutige Ethernet basiert auf Switches und Vollduplex-Verbindungen und es gibt keine Kollisionen, sodass keine Notwendigkeit besteht, das CSMA/CS-Protokoll zu verwenden

Direktzugriff (CSMA/CA-Protokoll)

Vom WLAN verwendetes Protokoll: CSMA/CA

Warum verwendet WLAN das CSMA/CA-Protokoll?

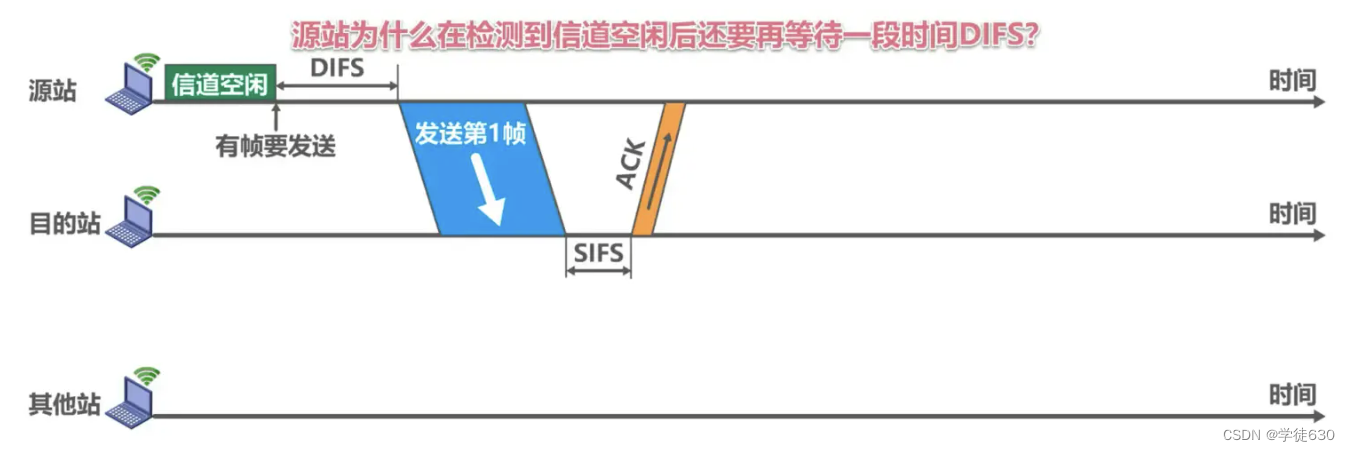

InterFrame Space IFS (InterFrame Space)

So funktioniert das CSMA/CA-Protokoll

Warum wartet die Ursprungsstation eine Weile auf DIFS, nachdem sie erkannt hat, dass der Kanal frei ist?

- Bedenken Sie, dass möglicherweise andere Stationen Frames mit hoher Priorität senden müssen. In diesem Fall müssen zuerst Frames mit hoher Priorität gesendet werden.

Warum muss die Zielstation eine gewisse SIFS-Zeit warten, bevor sie einen ACK-Frame sendet, nachdem sie den Datenframe korrekt empfangen hat?

- SIFS ist der kürzeste Zwischenrahmenraum, der die zu einer Konversation gehörenden Rahmen trennt. Während dieser Zeit sollte eine Station in der Lage sein, vom Sendemodus in den Empfangsmodus zu wechseln.

Dauert nach Ablauf der DIFS-Zeit eine zufällige Backoff-Periode, bevor der Kanal verwendet werden kann, nachdem der Kanal von „Belegt“ in „Frei“ wechselt?

Vermeiden Sie Kollisionen, die dadurch entstehen, dass mehrere Standorte gleichzeitig Daten senden

Wann sollte der Backoff-Algorithmus verwendet werden?

Backoff-Algorithmus des CSMA/CA-Protokolls

Beispiel eines Backoff-Algorithmus

Kanalreservierung und virtuelle Trägerüberwachung des CSMA/CA-Protokolls

Beispiel dafür, wie der virtuelle Trägererkennungsmechanismus Kollisionsprobleme durch versteckte Stationen reduzieren kann

3.7. MAC-Adresse, IP-Adresse und ARP-Protokoll

MAC-Adresse

- Die Datenverbindungsschicht, die Punkt-zu-Punkt-Kanäle verwendet, erfordert keine Verwendung von Adressen

- Datenverbindungsschichten, die Broadcast-Kanäle verwenden, müssen Adressen verwenden, um Hosts zu unterscheiden

Die Datenverbindungsschicht des Broadcast-Kanals muss eine Adresse (MAC) verwenden.

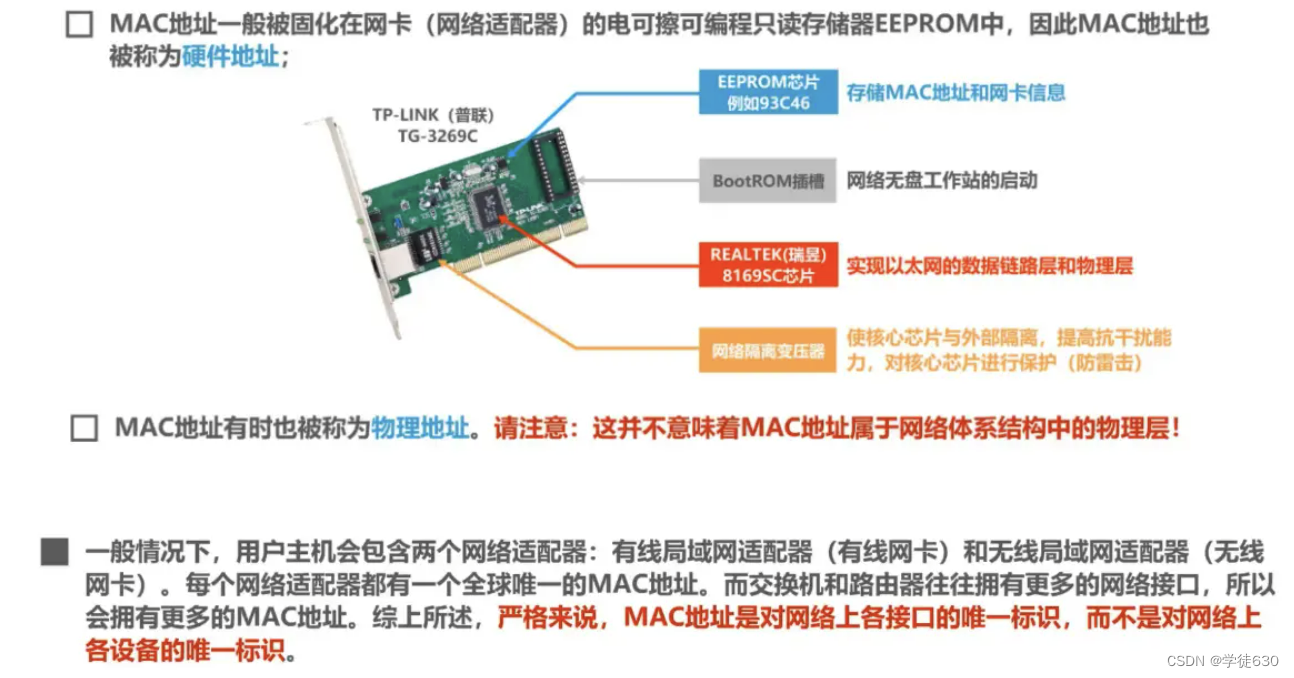

Die MAC-Adresse wird auch Hardware-Adresse oder physikalische Adresse genannt . Bitte beachten Sie: Lassen Sie sich durch das Wort „physikalisch“ nicht zu der Annahme verleiten, dass physikalische Adressen zur physikalischen Schicht und physikalische Adressen zur Datenverbindungsschicht gehören.

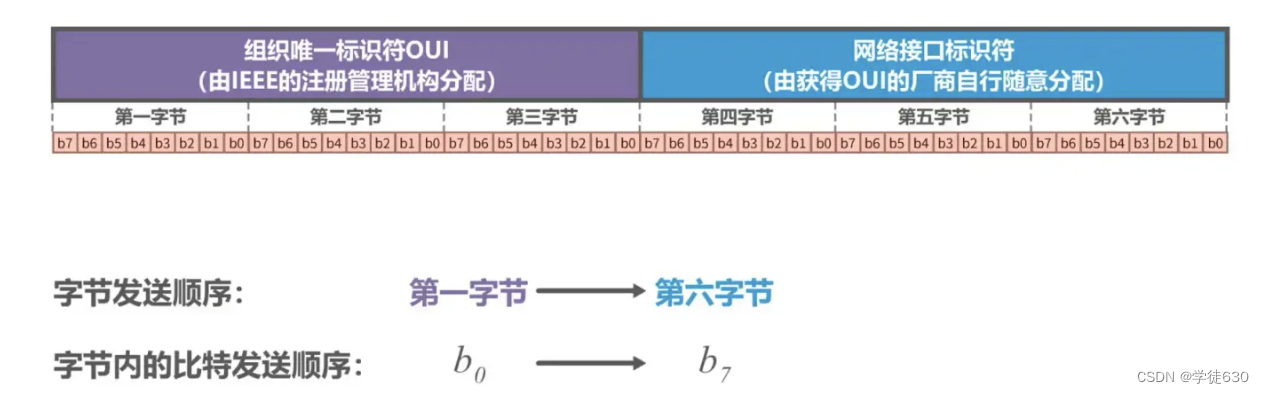

MAC-Adressformat von IEEE 802 LAN

Organisatorischer eindeutiger Bezeichner OUI

- Hersteller, die Netzwerkgeräte herstellen, müssen eine oder mehrere OUIs bei der IEEE-Registrierungsbehörde beantragen

Kennung der Netzwerkschnittstelle

- Der Hersteller, der die OUI erhält, kann diese nach Belieben zuteilen.

EUI-48

- 48 ist die Anzahl der Ziffern dieser MAC-Adresse

Das IEEE hat eine angestrebte Lebensdauer von 100 Jahren (bis 2080) für Anwendungen, die den EUI-48-Raum nutzen, aber die Einführung von EUI-64 wird als Alternative gefördert

Über ungültige MAC-Frames

-

Die Länge des Datenfelds stimmt nicht mit dem Wert des Längenfelds überein.

-

Die Länge des Frames ist keine ganze Zahl von Bytes;

-

Verwenden Sie die empfangene Frame-Prüfsequenz FCS, um Fehler zu erkennen.

-

Die Länge des Datenfelds liegt nicht zwischen 46 und 1500 Byte.

-

Die gültige MAC-Framelänge liegt zwischen 64 und 1518 Byte.

Erkannte ungültige MAC- Frames werden einfach verworfen. Ethernet ist nicht für die erneute Übertragung verworfener Frames verantwortlich.

IEEE 802 LAN-MAC-Adress-Sendesequenz

Beispiel für eine Unicast-MAC-Adresse

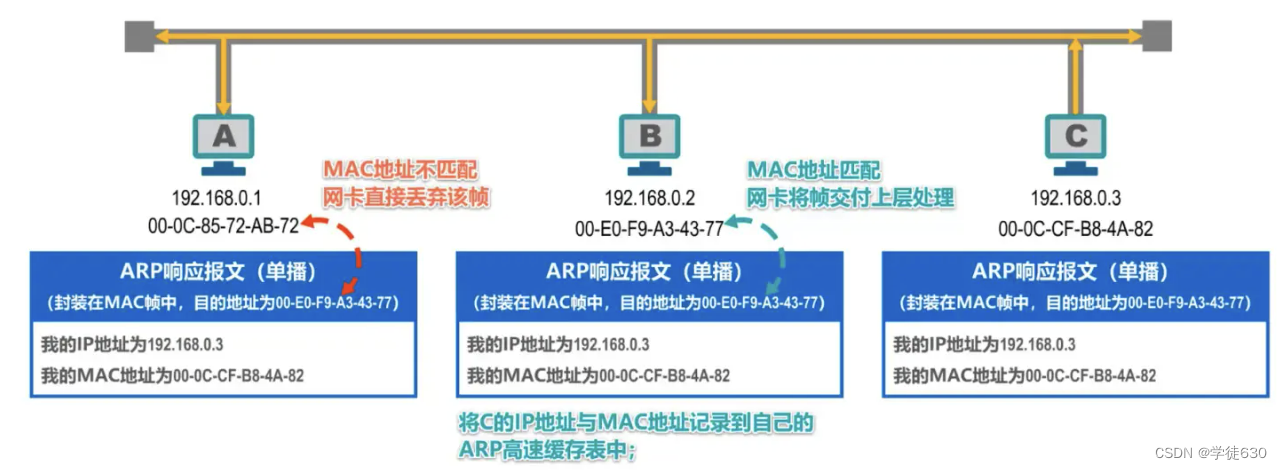

Host B sendet einen Unicast-Frame an Host C. Host B muss zuerst den Unicast-Frame erstellen , die MAC-Adresse von Host C in das Zieladressfeld im Frame-Header eingeben , seine eigene MAC-Adresse in das Quelladressfeld eingeben und Fügen Sie den Frame hinzu. Die anderen Felder im Header, die Datennutzlast und der Frame-Trailer bilden den Unicast-Frame.

Host B sendet den Unicast-Frame und beide Hosts A und C empfangen den Unicast-Frame.

Die Netzwerkkarte von Host A stellt fest, dass die Ziel-MAC-Adresse des Unicast-Frames nicht mit ihrer eigenen MAC-Adresse übereinstimmt, und verwirft den Frame.

Die Netzwerkkarte von Host C stellt fest, dass die Ziel-MAC-Adresse des Unicast-Frames mit ihrer eigenen MAC-Adresse übereinstimmt und akzeptiert den Frame.

und übergibt den Rahmen zur Bearbeitung an die obere Schicht

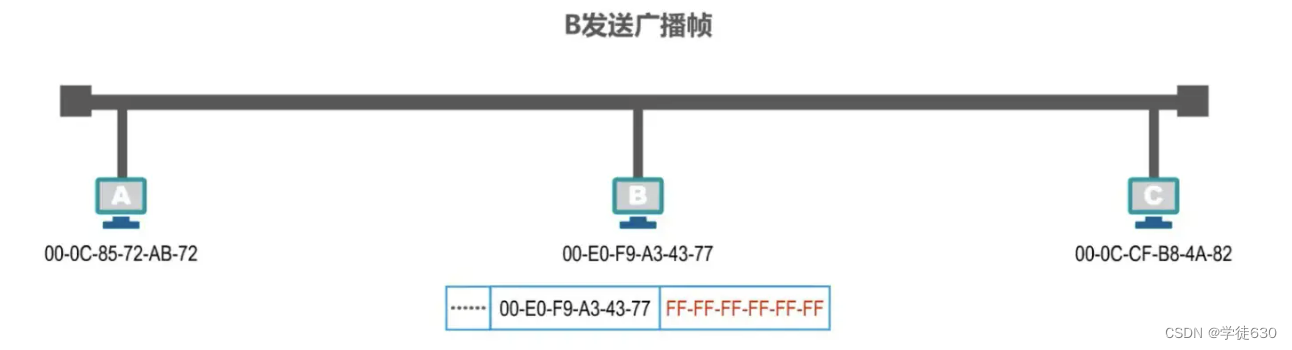

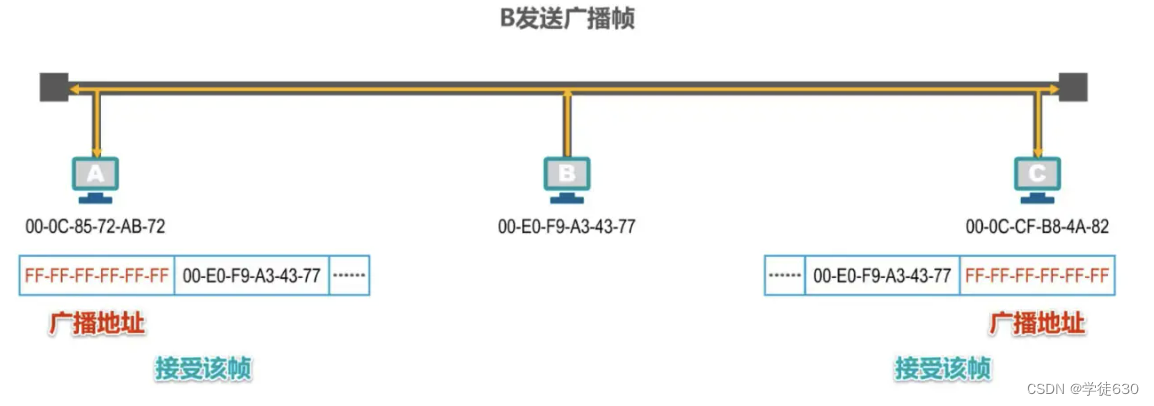

Beispiel für eine Broadcast-MAC-Adresse

Angenommen, Host B möchte einen Broadcast-Frame senden . Host B muss zuerst den Broadcast-Frame erstellen , die Broadcast-Adresse in das Zieladressfeld im Frame-Header eingeben , die alle hexadezimal aus F besteht, und seine eigene MAC-Adresse eingeben Das Quelladressfeld sowie weitere Felder im Frame-Header, in der Datenlast und im Frame-Tail bilden den Broadcast-Frame

Host B sendet den Broadcast-Frame , und die Hosts A und C empfangen den Broadcast-Frame . Wenn sie feststellen, dass der Inhalt des Zieladressfelds im Header des Frames die Broadcast-Adresse ist , wissen sie, dass es sich bei dem Frame um einen Broadcast-Frame handelt . und beide Hosts A und C akzeptieren es. Der Frame wird zur Verarbeitung an die obere Schicht übergeben

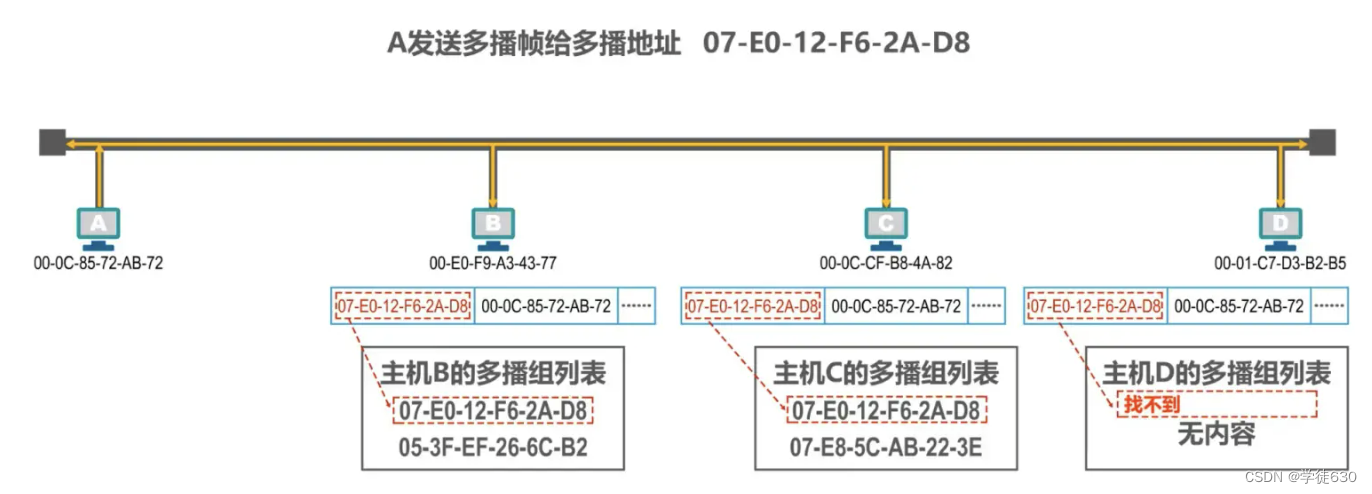

Beispiel für eine Multicast-MAC-Adresse

Angenommen, Host A möchte einen Multicast-Frame an diese Multicast-Adresse senden . Das erste Byte von links der Multicast-Adresse wird als 8 Bit geschrieben, und das niedrigste Bit des ersten Bytes ist 1, was anzeigt, dass es sich bei der Adresse um eine Multicast-Adresse handelt .

Stellen Sie schnell fest, ob es sich bei der Adresse um eine Multicast-Adresse handelt. Das heißt, die Hexadezimalzahl, auf die der Pfeil in der obigen Abbildung zeigt, kann nicht durch 2 (1,3,5,7,9,B,D,F) geteilt werden, und dann ist die Adresse ist eine Multicast-Broadcast-Adresse

Gehen Sie davon aus, dass die Hosts B, C und D Multicast unterstützen und jeder Benutzer die Multicast-Gruppenliste für seine eigenen Hosts wie folgt konfiguriert:

Host B gehört zu zwei Multicast-Gruppen, Host C gehört ebenfalls zu zwei Multicast-Gruppen und Host D gehört zu keiner Multicast-Gruppe.

Host A muss zuerst den Multicast-Frame erstellen , die Multicast-Adresse in das Zieladressfeld im Frame-Header eingeben , seine eigene MAC-Adresse in die Quelladresse eingeben und weitere Felder im Frame-Header, in der Datennutzlast und im Frame-Trailer hinzufügen bildet den Multicast-Frame

Host A sendet den Multicast-Frame und die Hosts B, C und D empfangen alle den Multicast-Frame.

Die Hosts B und C stellen fest, dass sich die Ziel-MAC-Adresse des Multicast-Frames in ihrer eigenen Multicast-Gruppenliste befindet , und beide Hosts B und C akzeptieren den Frame.

Host D stellt fest, dass die Ziel-MAC-Adresse des Multicast-Frames nicht in seiner eigenen Multicast-Gruppenliste enthalten ist, und verwirft den Multicast-Frame.

Beim Konfigurieren einer Multicast-Gruppenliste für einen Host für private Anwendungen dürfen keine öffentlichen Standard-Multicast-Adressen verwendet werden.

IP Adresse

IP-Adressen gehören zur Netzwerkschicht und nicht zur Datenverbindungsschicht.

Der folgende Inhalt befasst sich mit der Verwendung von IP-Adressen. Detaillierte IP-Adressinhalte werden in der Netzwerkschicht eingeführt.

Basiskonzept

Betrachtung von IP-Adresse und MAC-Adresse aus der Perspektive der Netzwerkarchitektur

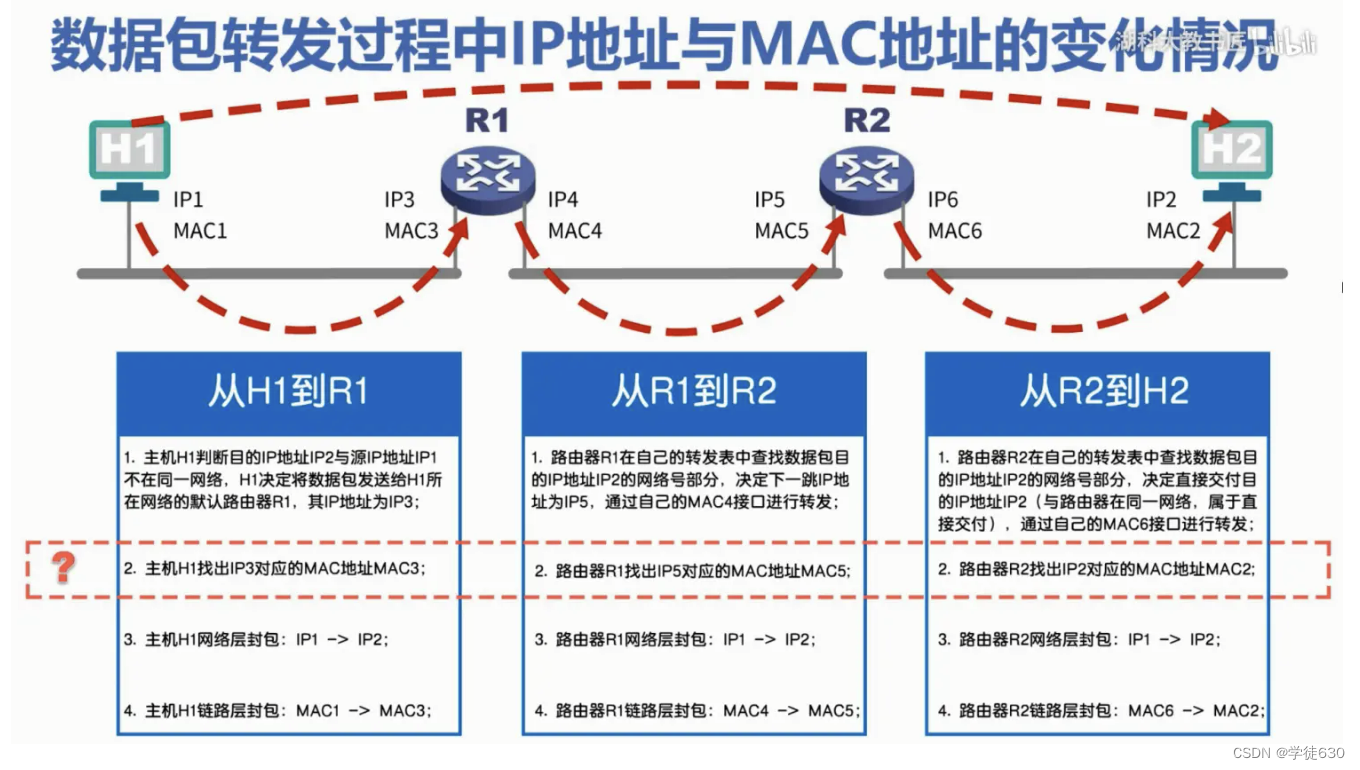

Änderungen der IP-Adressen und MAC-Adressen während der Weiterleitung von Datenpaketen

Die IP-Adressen und MAC-Adressen jeder Host- und Router-Schnittstelle in der Abbildung werden durch einfache Kennungen dargestellt

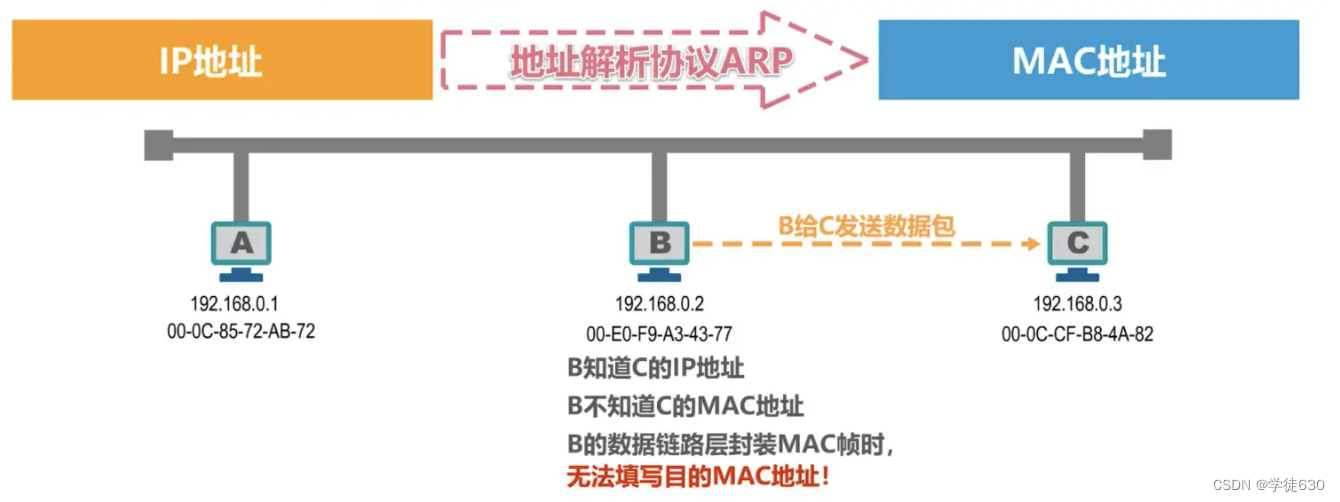

Wie finde ich aus einer IP-Adresse die entsprechende MAC-Adresse heraus?

ARP-Protokoll

ARP-Protokoll

Wie finde ich aus einer IP-Adresse die entsprechende MAC-Adresse heraus?

ARP (Address Resolution Protocol)

Verfahren

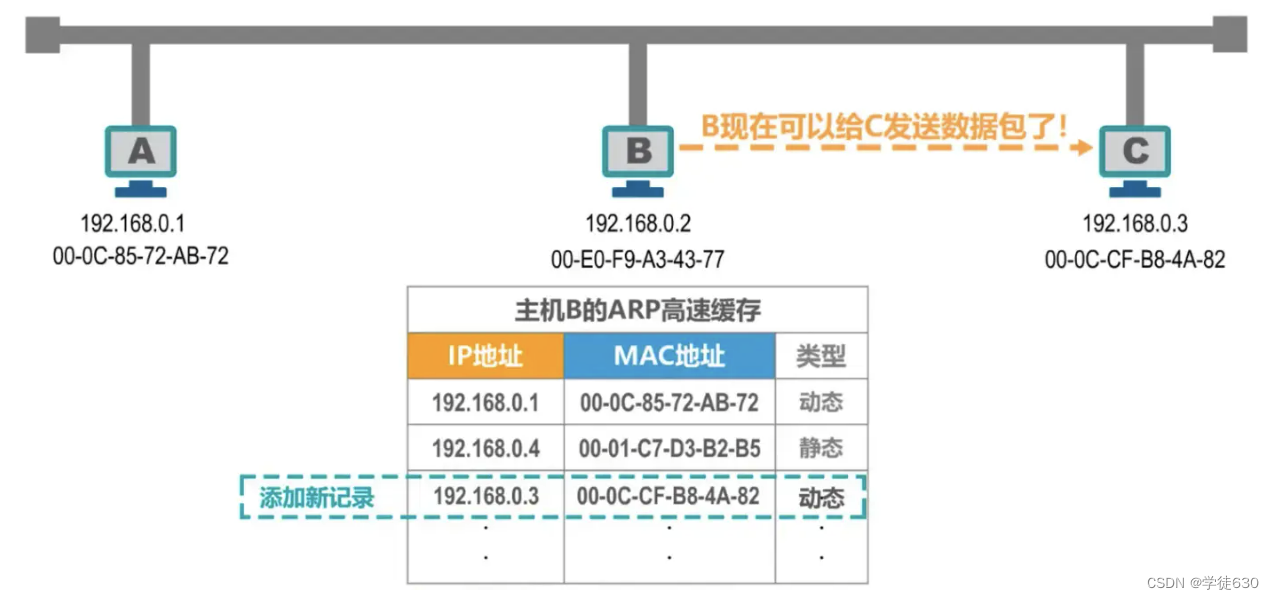

ARP-Cache-Tabelle

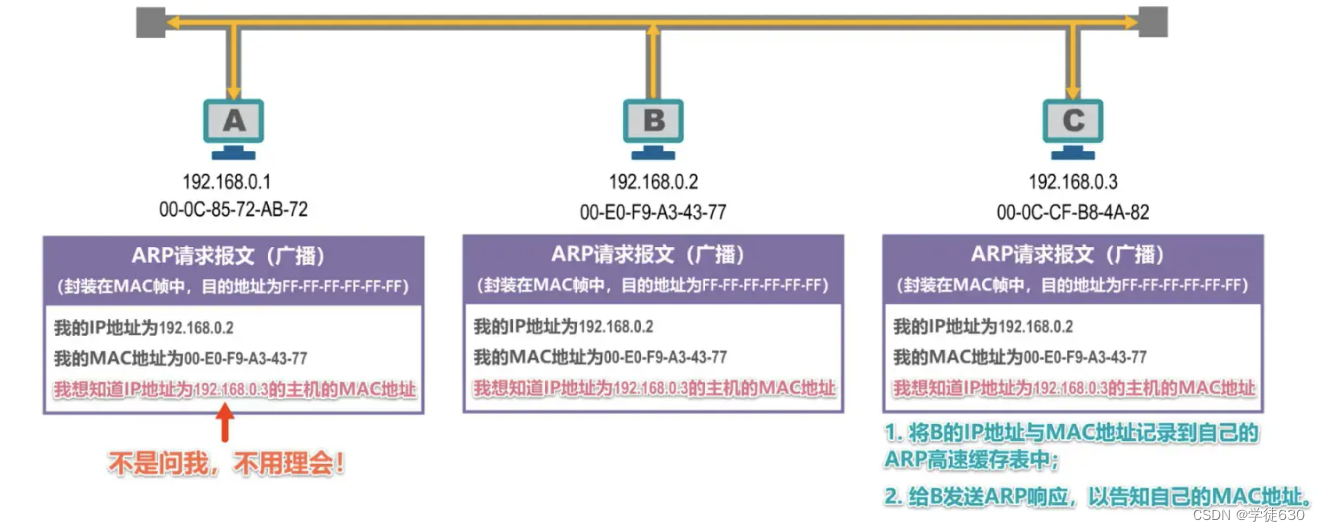

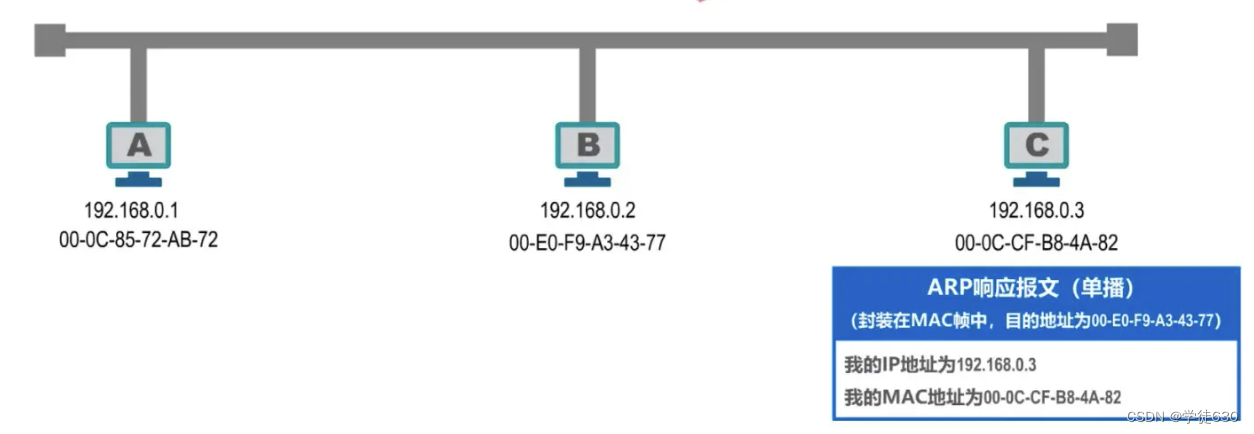

Wenn Host B ein Datenpaket an Host C senden möchte, sucht er zunächst in seiner eigenen ARP-Cache-Tabelle nach der MAC-Adresse, die der IP-Adresse von Host C entspricht, kann diese jedoch nicht finden. Daher muss Host B ein ARP senden Anforderungsnachricht zum Abrufen der MAC-Adresse von Host C

ARP-Anforderungsnachrichten haben bestimmte Formate. Die obige Abbildung ist nur eine kurze Beschreibung.

Die ARP-Anforderungsnachricht wird in einen MAC-Frame gekapselt und gesendet, und die Zieladresse ist die Broadcast-Adresse.

Host B sendet einen Broadcast-Frame, der mit einer ARP-Anforderungsnachricht gekapselt ist, und andere Hosts auf dem Bus können den Broadcast-Frame empfangen.

Host A und Host C, die die ARP-Anforderungsnachricht empfangen, übergeben die ARP-Anforderungsnachricht an den ARP-Prozess der oberen Schicht.

Host A stellt fest, dass es sich bei der angeforderten IP-Adresse nicht um seine eigene IP-Adresse handelt, und ignoriert sie daher.

Host C stellt fest, dass es sich bei der angeforderten IP-Adresse um seine eigene IP-Adresse handelt und muss entsprechend verarbeitet werden.

Der Unterschied zwischen dynamisch und statisch

Das ARP-Protokoll kann nur auf einer Verbindung oder einem Netzwerk verwendet werden und kann nicht netzwerkübergreifend verwendet werden.

Die Verwendung des ARP-Protokolls erfolgt Link für Link.

Zusammenfassen

Die Korrespondenz zwischen IP-Adresse und MAC-Adresse in der ARP-Tabelle wird regelmäßig automatisch gelöscht, da die Korrespondenz zwischen IP-Adresse und MAC-Adresse nicht dauerhaft ist.

3.8. Der Unterschied zwischen Hub und Switch

Hub – erweitert Ethernet auf der physikalischen Ebene

Konzept

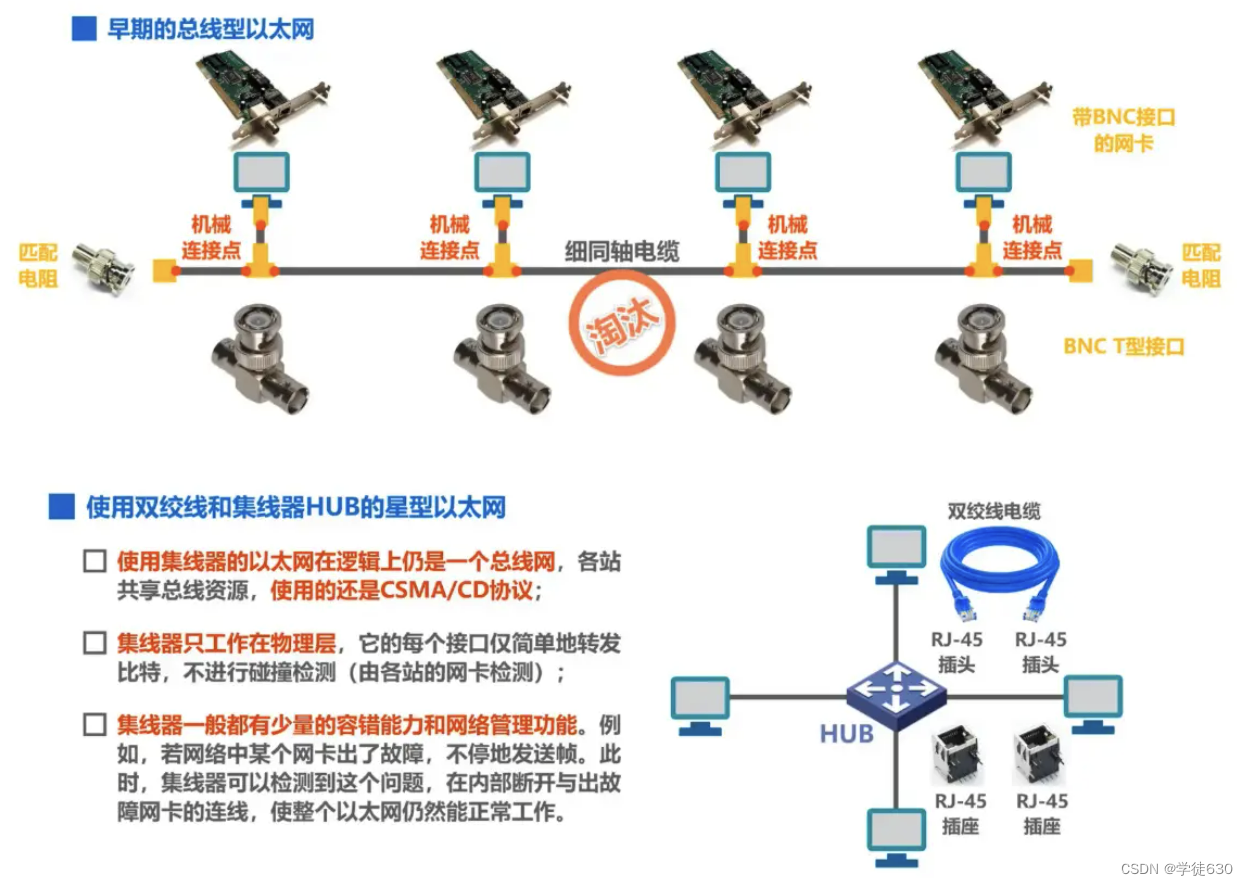

- Beim traditionellen Ethernet wurden ursprünglich dicke Koaxialkabel verwendet, dann wurden billigere dünne Koaxialkabel verwendet und schließlich wurden billigere und flexiblere Twisted-Pair-Kabel verwendet.

- Ethernet mit verdrillten Paaren verwendet eine Sterntopologie, und in der Mitte des Sterns wird ein sehr zuverlässiges Gerät namens Hub hinzugefügt .

- Ein Hub kann auch als Multi-Port-Repeater betrachtet werden. Jeder Port kann zu einem Repeater werden. Ein Repeater ist ein Gerät, das abgeschwächte Signale verstärkt und überträgt.

- Das Ethernet des Hubs ist logisch gesehen immer noch ein Busnetzwerk. Es muss das CSMA/CD-Protokoll verwenden, um den Wettbewerb zwischen Hosts um den Bus zu koordinieren. Es kann nur im Halbduplexmodus arbeiten und nicht gleichzeitig Frames senden und empfangen .

Hub HUB erweitert Ethernet auf der physikalischen Ebene

Nutzen Sie die Hub-Erweiterung : Verbinden Sie mehrere Ethernet-Segmente zu einem größeren, mehrstufigen, sternstrukturierten Ethernet-Netzwerk

- Vorteil

1. 使原来属于不同碰撞域的以太网上的计算机能够进行跨碰撞域的通信。 2. 扩大了以太网覆盖的地理范围。

- Mangel

1. 碰撞域增大了,但总的吞吐量并未提高。 2. 如果不同的碰撞域使用不同的数据率,那么就不能用集线器将它们互连起来。

Kollisionsdomäne

-

Kollisionsdomäne, auch Kollisionsdomäne genannt , bezieht sich auf den Teil des Netzwerks, in dem von einer Station gesendete Frames mit Frames anderer Stationen kollidieren oder in Konflikt geraten.

-

Je größer der Kollisionsbereich ist, desto höher ist die Kollisionswahrscheinlichkeit.

Ethernet-Switches – Erweiterung von Ethernet auf der Datenverbindungsebene

Konzept

-

Die gebräuchlichste Methode zur Erweiterung von Ethernet ist die Datenverbindungsschicht.

-

Früher wurden Bridges verwendet , heute kommen Ethernet-Switches zum Einsatz .

Brücke

- Bridges funktionieren auf der Datenverbindungsebene.

- Es leitet empfangene Frames basierend auf der Zieladresse des MAC-Frames weiter und filtert sie.

- Wenn die Bridge einen Frame empfängt, leitet sie den Frame nicht an alle Schnittstellen weiter, sondern überprüft zunächst die Ziel-MAC-Adresse des Frames und bestimmt dann, an welche Schnittstelle der Frame weitergeleitet werden soll, oder verwirft ihn.

schalten

- Der 1990 eingeführte Switching Hub kann die Leistung von Ethernet deutlich verbessern.

- Switching-Hubs werden oft als Ethernet-Switches (Switches) oder Layer-2-Switches (L2-Switches) bezeichnet, wobei betont wird, dass solche Switches auf der Datenverbindungsschicht arbeiten.

- Ein Ethernet-Switch ist im Wesentlichen eine Multi-Interface-Bridge

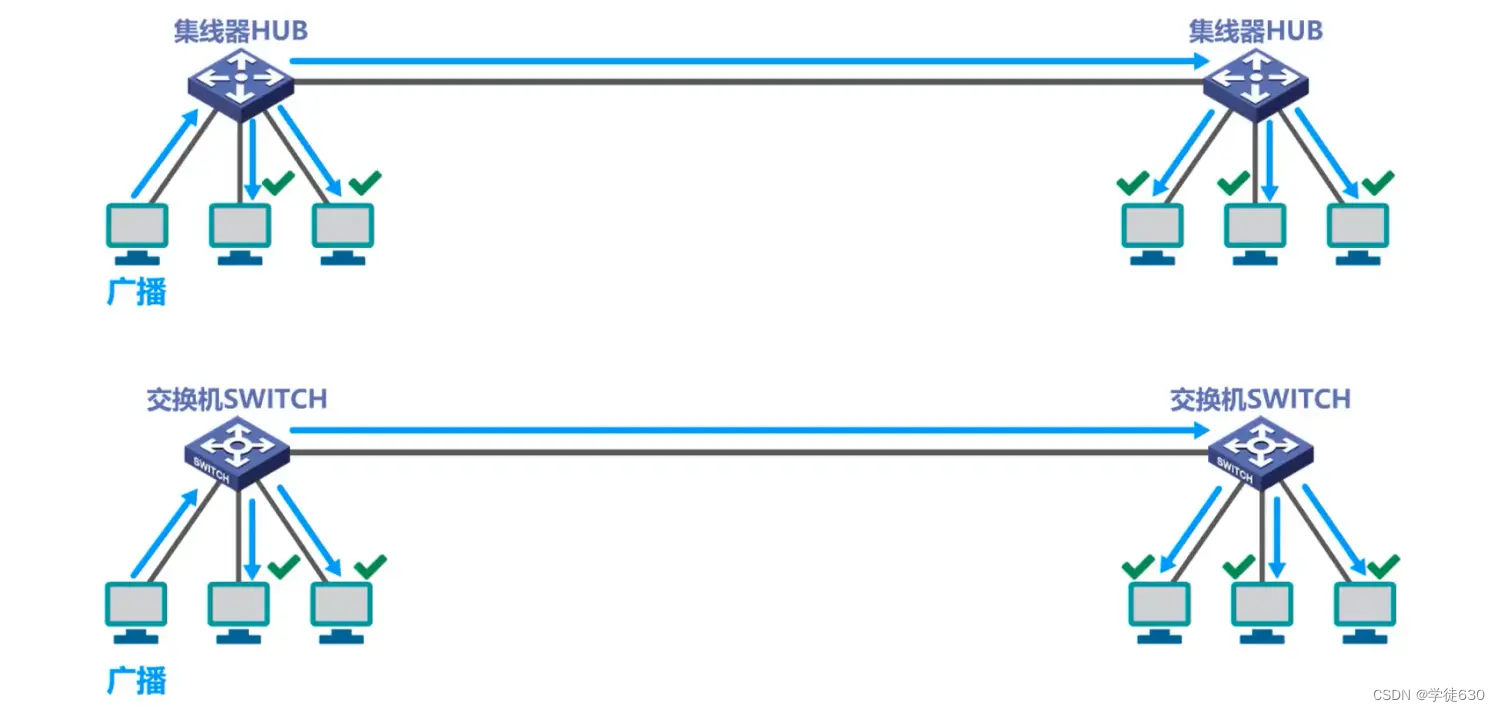

Der Unterschied zwischen Hub HUB und Switch SWITCH

Ein Host in einem Ethernet-Netzwerk mit gemeinsam genutztem Bus , das über einen Hub miteinander verbunden ist, möchte einen Unicast-Frame an einen anderen Host senden. Der Unicast-Frame wird über den gemeinsam genutzten Bus an jeden anderen Host auf dem Bus übertragen .

Ein Host in einem durch Switches verbundenen Switch-Ethernet-Netzwerk möchte einen Unicast-Frame an einen anderen Host senden. Nachdem der Unicast-Frame den Switch erreicht hat, leitet der Switch den Unicast-Frame an den Zielhost und nicht an das Netzwerk weiter. Verschiedene andere Hosts von

Voraussetzung für dieses Beispiel ist, den ARP-Prozess zu ignorieren und davon auszugehen, dass die Frame-Exchange-Tabelle des Switches gelernt bzw. konfiguriert wurde.

Schaltmodus des Ethernet-Switches

- speichern und weiterleiten

* 把整个数据帧**先缓存**后再进行处理。

- Cut-Through-Methode

* 接收数据帧的同时就**立即按数据帧的目的 MAC 地址决定该帧的转发接口**,因而提高了帧的转发速度。 * **缺点**是它不检查差错就直接将帧转发出去,因此有可能也将一些无效帧转发给其他的站。Voraussetzung für dieses Beispiel ist, den ARP-Prozess zu ignorieren und davon auszugehen, dass die Frame-Exchange-Tabelle des Switches gelernt bzw. konfiguriert wurde.

Vergleich von Hubs und Switches

Mehrere Hosts senden gleichzeitig Unicast-Frames an einen anderen Host

Hub-Ethernet: Es kommt zu Kollisionen, und Frames, bei denen es zu Kollisionen kommt, werden an jeden Host auf dem Bus weitergeleitet

Switch-Ethernet: Sie werden zwischengespeichert und dann einzeln ohne Kollision an den Zielhost weitergeleitet.

Voraussetzung für dieses Beispiel ist, den ARP-Prozess zu ignorieren und davon auszugehen, dass die Frame-Exchange-Tabelle des Switches gelernt bzw. konfiguriert wurde.

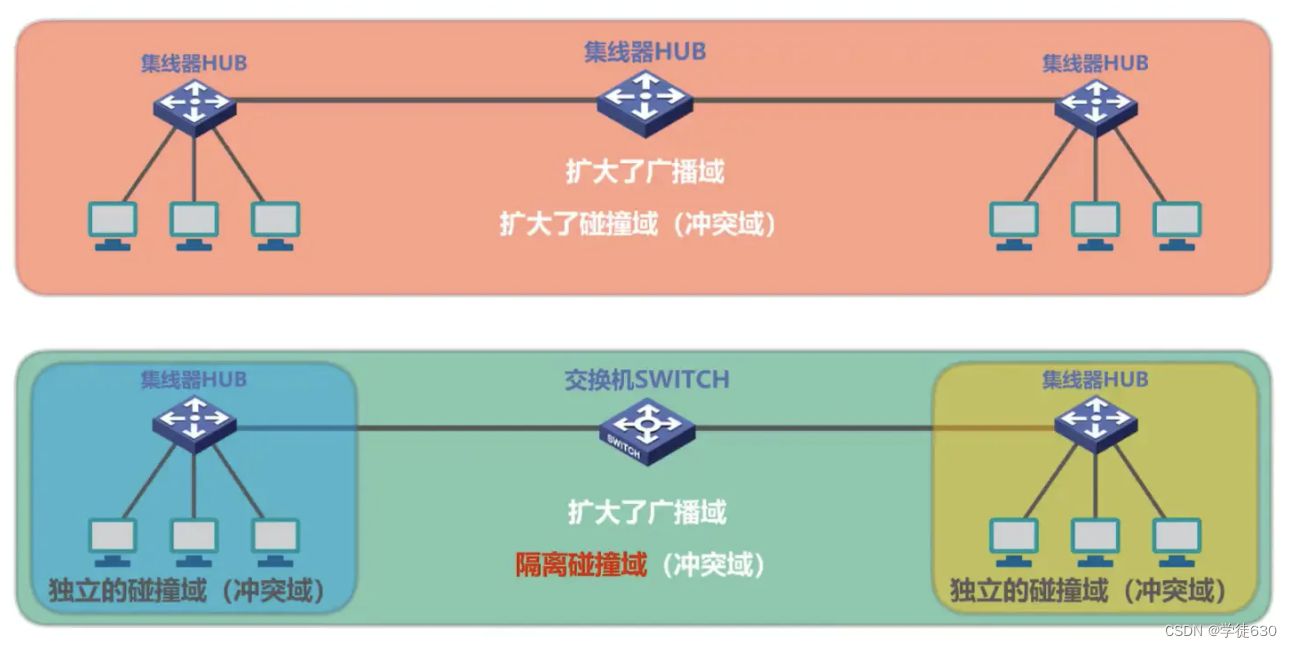

Der Unterschied zwischen Hub-Extended-Ethernet und Switch-Extended-Ethernet

Unicast

übertragen

Mehrfach-Unicast

Broadcast-Domäne: bezieht sich auf einen Teil des Netzwerks, in dem von einem beliebigen Gerät gesendete Broadcast-Kommunikationen von allen anderen Geräten in diesem Teil des Netzwerks empfangen werden können.

Zusammenfassen

Die Leistung von Ethernet-Switches, die auf der Datenverbindungsschicht arbeiten, übertrifft die von Hubs, die auf der physikalischen Schicht arbeiten, bei weitem, und der Preis ist nicht hoch, was dazu führt, dass Hubs nach und nach vom Markt verschwinden.

3.9. Selbstlern- und Frame-Weiterleitungsprozess des Ethernet-Switches

Konzept

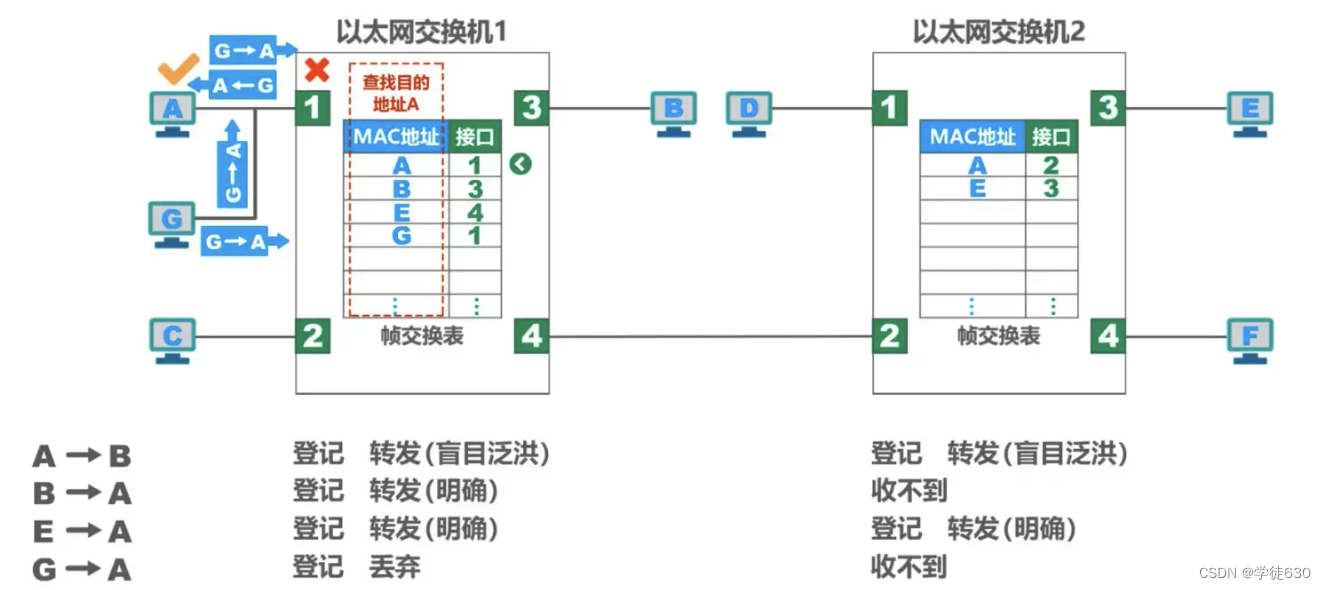

Beispiel für selbstlernende und weiterleitende Frames

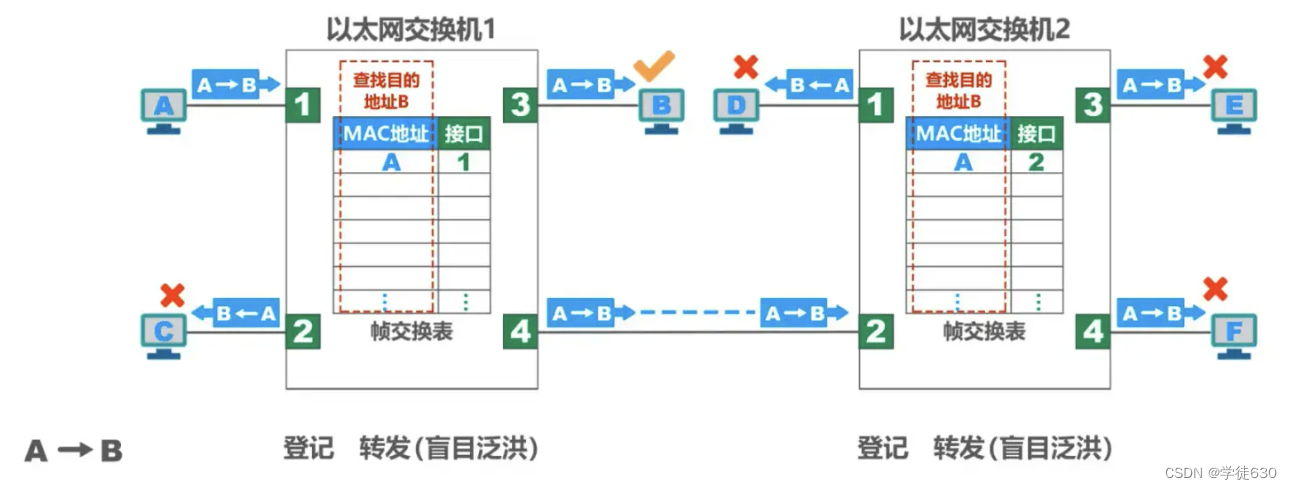

Im folgenden Beispiel wird davon ausgegangen, dass jeder Host die MAC-Adresse jedes anderen Hosts im Netzwerk kennt (kein ARP erforderlich).

- A sendet zuerst einen Frame an B. Der Frame gelangt über Schnittstelle 1 in den Switch

- Nachdem der Switch den Frame empfangen hat, sucht er zunächst in der Switching-Tabelle (links in der Abbildung). Die Schnittstelle, von der dieser Frame an B weitergeleitet werden soll, wurde nicht gefunden.

- Der Switch schreibt die Quelladresse A und Schnittstelle 1 dieses Frames in die Switching-Tabelle (links in der Abbildung).

- Der Switch sendet diesen Frame an alle Schnittstellen außer Schnittstelle 1

- Suchen Sie von Schnittstelle 4 bis Schnittstelle 2 zunächst die Schalttabelle (rechts in der Abbildung). Die Schnittstelle, von der dieser Frame an B weitergeleitet werden soll, wurde nicht gefunden.

- Der Switch schreibt die Quelladresse A und Schnittstelle 1 dieses Frames in die Switching-Tabelle (rechts im Bild)

- Wenn die Zieladresse des Frames nicht mit der anderen Zieladresse als Host B übereinstimmt, wird der Frame verworfen.

- Host B stellt fest, dass der Frame für sich selbst bestimmt ist und akzeptiert den Frame.

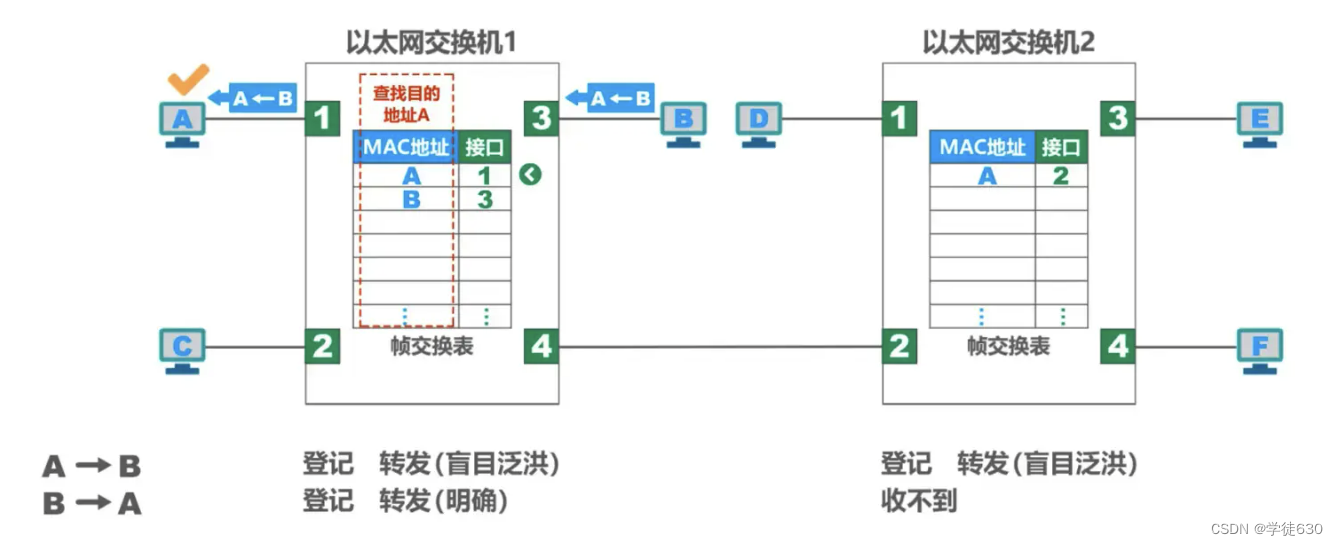

- B sendet einen Frame an A. Der Frame gelangt über Schnittstelle 3 in den Switch

- Nachdem der Switch den Frame empfangen hat, sucht er zunächst in der Switching-Tabelle (links in der Abbildung). Es wurde festgestellt, dass die MAC-Adresse in der Switching-Tabelle (auf der linken Seite der Abbildung) A hat, was darauf hinweist, dass der an A zu sendende Frame von Schnittstelle 1 weitergeleitet werden soll. Der Frame wird also an Schnittstelle 1 gesendet und an A weitergeleitet.

- Host A stellt fest, dass es sich um die Zieladresse handelt, und akzeptiert den Frame.

- Der Switch schreibt die Quelladresse B und Schnittstelle 3 dieses Frames in die Switching-Tabelle (links in der Abbildung).

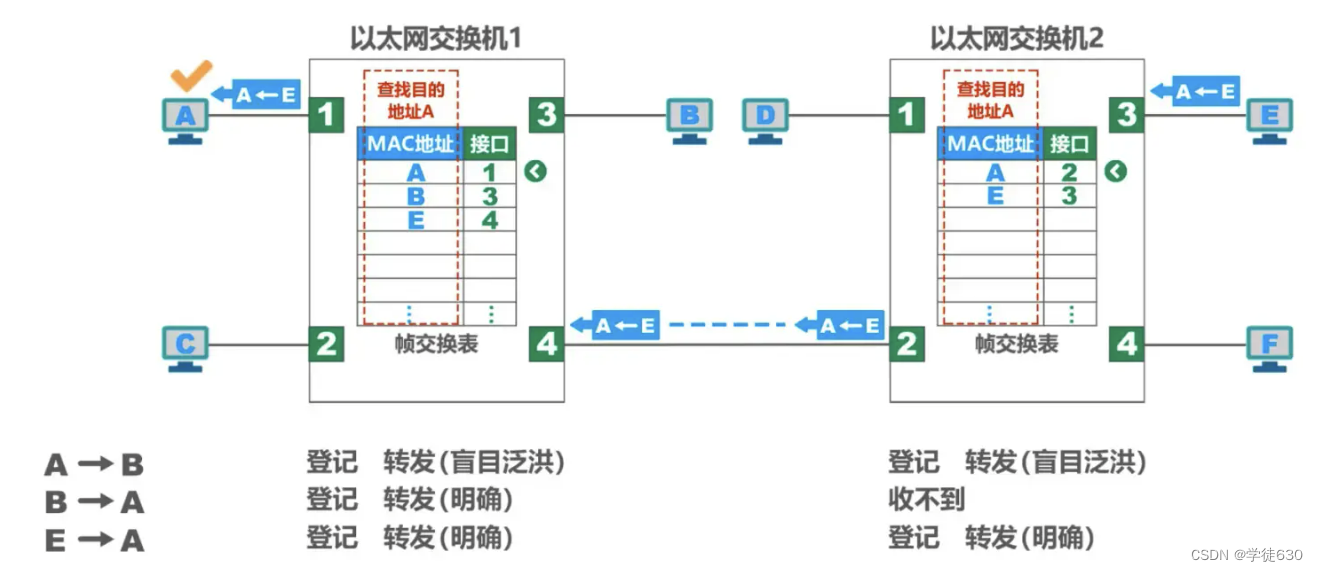

- E sendet einen Frame an A

- Nachdem der Switch den Frame empfangen hat, sucht er zunächst in der Switching-Tabelle (rechts in der Abbildung). Es wird festgestellt, dass (auf der rechten Seite der Abbildung) die MAC-Adresse in der Switching-Tabelle A hat, was darauf hinweist, dass der an A zu sendende Frame von Schnittstelle 2 weitergeleitet werden soll. Der Frame wird also an Schnittstelle 2 gesendet und an Schnittstelle 4 weitergeleitet.

- Der Switch schreibt die Quelladresse E und Schnittstelle 3 dieses Frames in die Switching-Tabelle (rechts im Bild)

- Schnittstelle 4 geht zum Schalter links und sucht zunächst nach der Schalttabelle (links in der Abbildung). Es wurde festgestellt, dass die MAC-Adresse in der Switching-Tabelle (auf der linken Seite der Abbildung) A hat, was darauf hinweist, dass der an A zu sendende Frame von Schnittstelle 1 weitergeleitet werden soll. Der Frame wird also an Schnittstelle 1 gesendet und an A weitergeleitet.

- Der Switch schreibt die Quelladresse E und Schnittstelle 4 dieses Frames in die Switching-Tabelle (links in der Abbildung).

- Host A stellt fest, dass es sich um die Zieladresse handelt, und akzeptiert den Frame.

Host A, Host G und Schnittstelle 1 von Switch 1 teilen sich denselben Bus (entspricht einem Busnetzwerk, das man sich als durch einen Hub verbunden vorstellen kann)

- Host G sendet einen Frame an Host A

- Sowohl Host A als auch Switch-Schnittstelle 1 können empfangen

- Nachdem die Netzwerkkarte von Host A ihn empfangen hat, weiß sie anhand der Ziel-MAC-Adresse des Frames, dass der Frame an sich selbst gesendet wurde, und akzeptiert den Frame.

- Nach dem Empfang des Frames führt Switch 1 zunächst die Registrierungsarbeit durch.

- Dann leitet Switch 1 den Frame weiter. Die MAC-Adresse des Frames ist A. Suchen Sie die MAC-Adresse A in der Switch-Tabelle (linke Seite der Abbildung).

- Die Schnittstellennummer mit MAC-Adresse A ist 1, aber der Frame gelangt über Schnittstelle 1 in den Switch. Der Switch leitet den Frame von Schnittstelle 1 nicht weiter, da er unnötig ist, und verwirft den Frame.

Da jeder Host im Netzwerk Frames sendet, kann jeder Switch im Netzwerk die MAC-Adressen jedes Hosts und die entsprechenden Beziehungen zu seinen eigenen Schnittstellen lernen.

Wenn man bedenkt, dass es vorkommen kann, dass ein Host an der Schnittstelle des Switches ausgetauscht werden muss oder ein Host seinen Netzwerkadapter wechseln muss, erfordert dies eine Änderung der Elemente in der Switching-Tabelle. Aus diesem Grund hat jeder Artikel in der Austauschtabelle eine bestimmte Gültigkeitsdauer . Abgelaufene Artikel werden automatisch gelöscht .

Durch diese selbstlernende Methode von Ethernet-Switches sind die Ethernet-Switches ohne manuelle Konfiguration Plug-and-Play-fähig und daher sehr praktisch.

Zusammenfassen

Zusammenfassung der Schritte für das Selbstlernen des Switches und die Frame-Weiterleitung

3.10. Spanning Tree Protocol STP des Ethernet-Switches

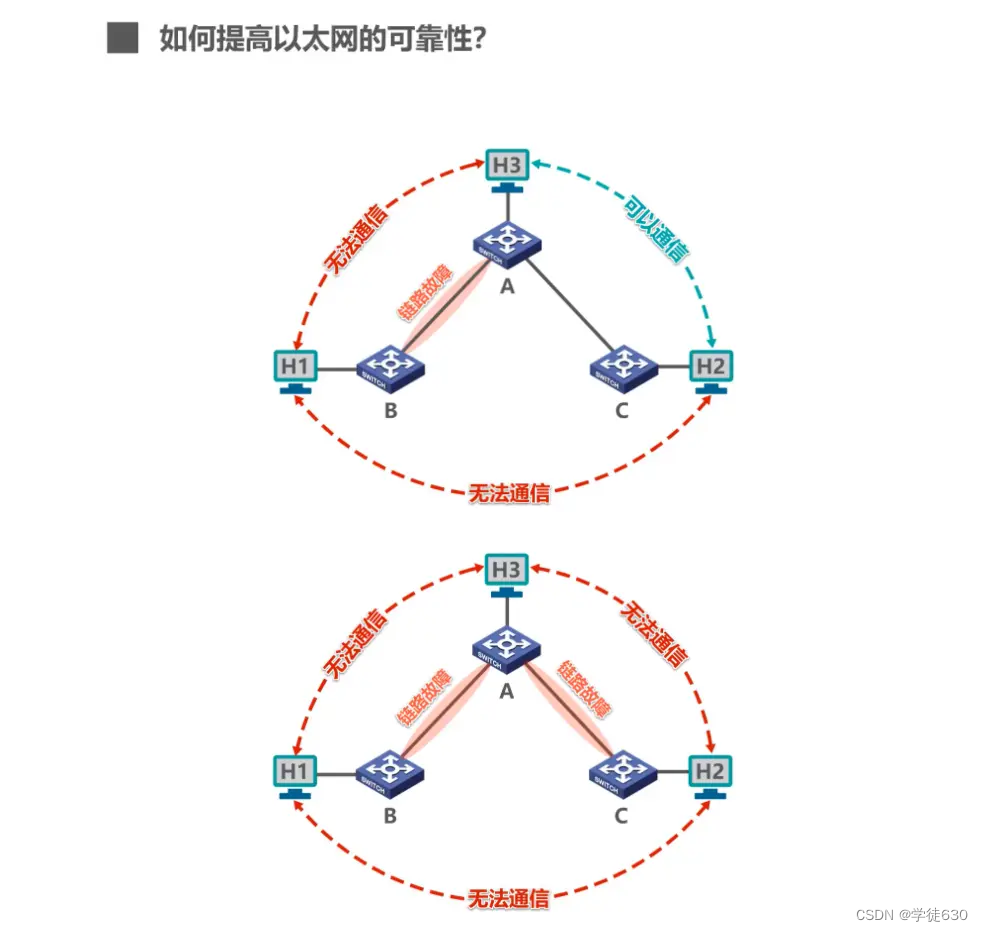

So verbessern Sie die Zuverlässigkeit von Ethernet

- Der IEEE 802.1D-Standard spezifiziert ein Spanning Tree Protocol STP (Spanning Tree Protocol).

- Der entscheidende Punkt ist: Die tatsächliche Topologie des Netzwerks wird nicht geändert , aber bestimmte Verbindungen werden logisch unterbrochen, sodass der Pfad von einem Host zu allen anderen Hosts eine schleifenfreie Baumstruktur ist , wodurch das Kreisphänomen beseitigt wird.

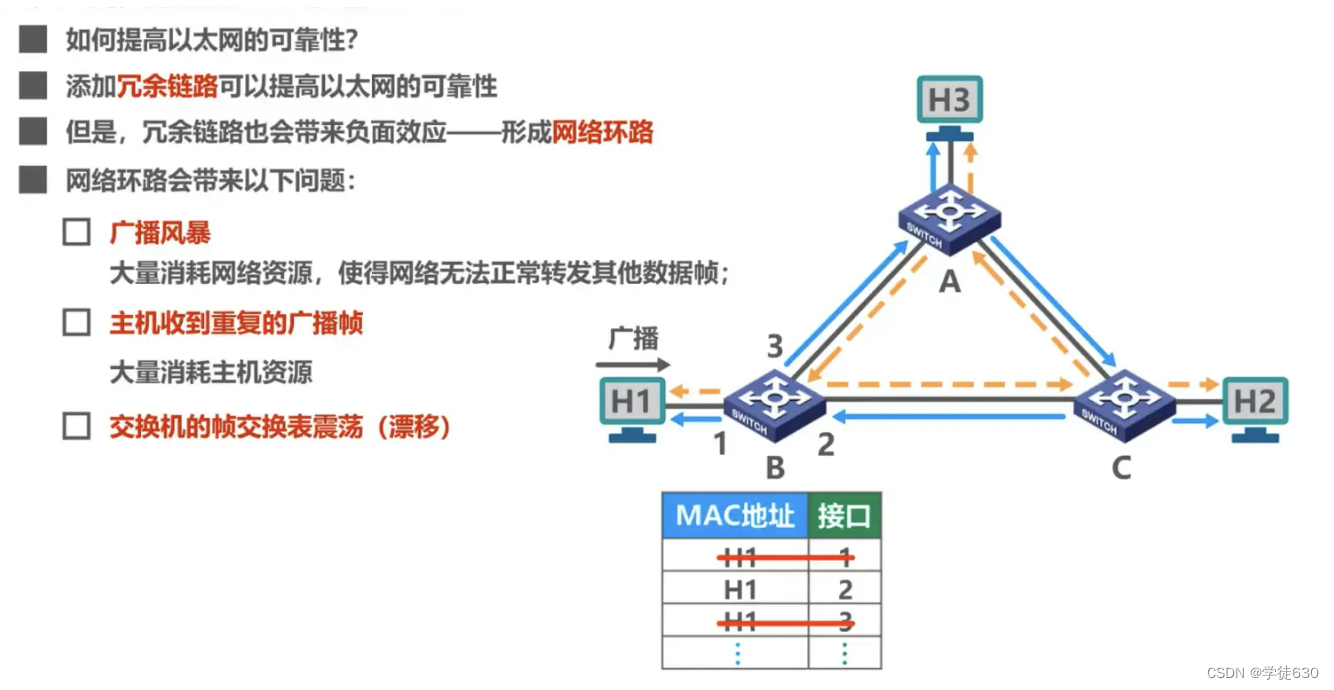

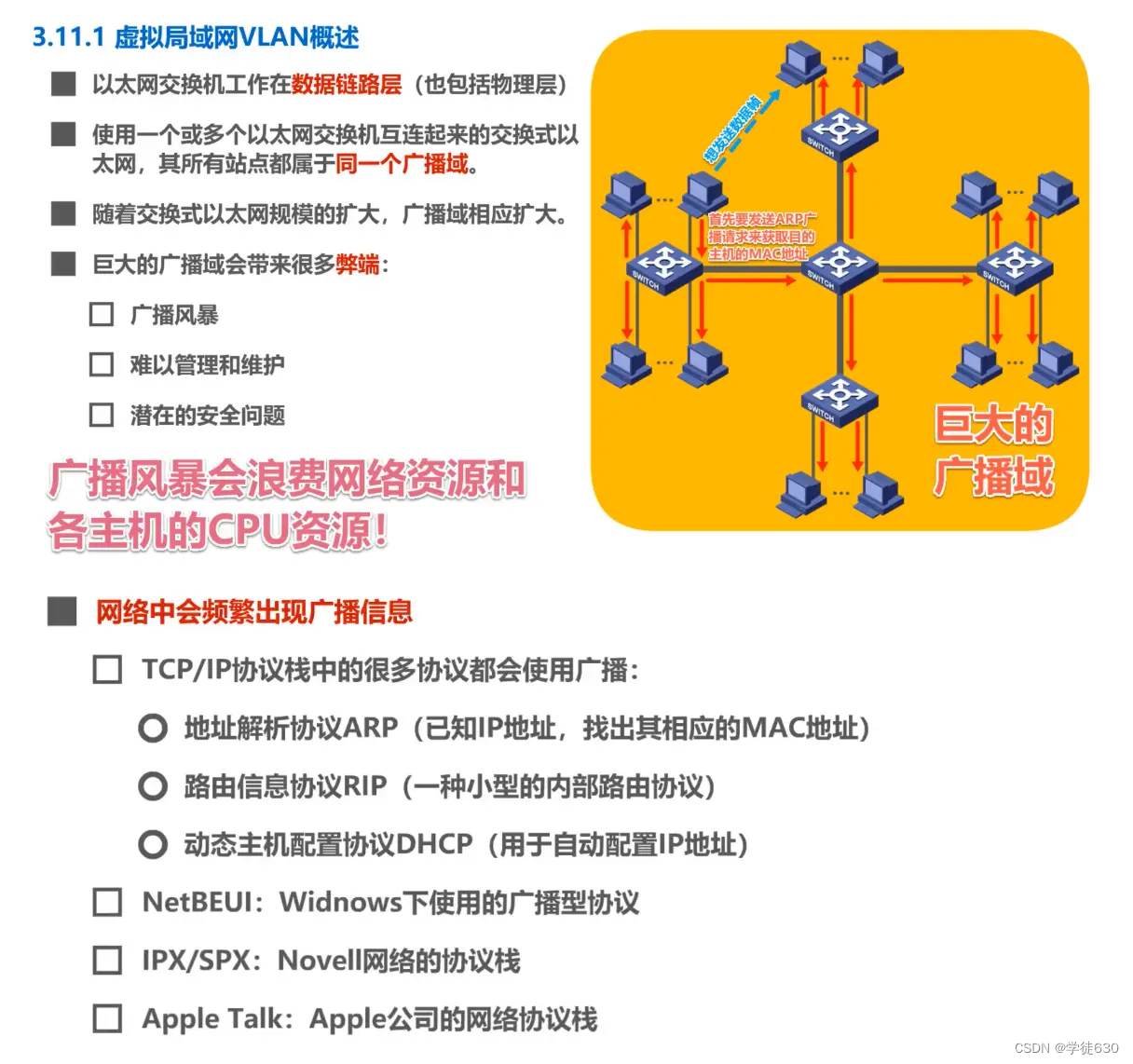

3.11. Virtuelles LAN VLAN

Warum Virtual LAN VLAN

Sendesturm

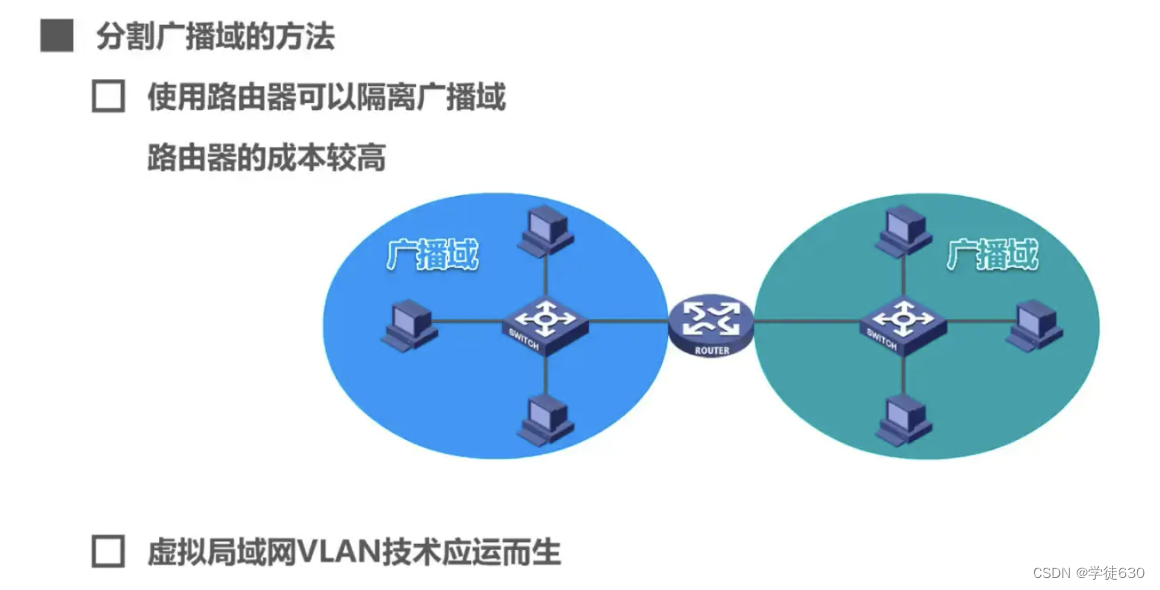

So teilen Sie Broadcast-Domänen auf

Um die Broadcast-Domäne aufzuteilen, wurde die Virtual-LAN-VLAN-Technologie entwickelt.

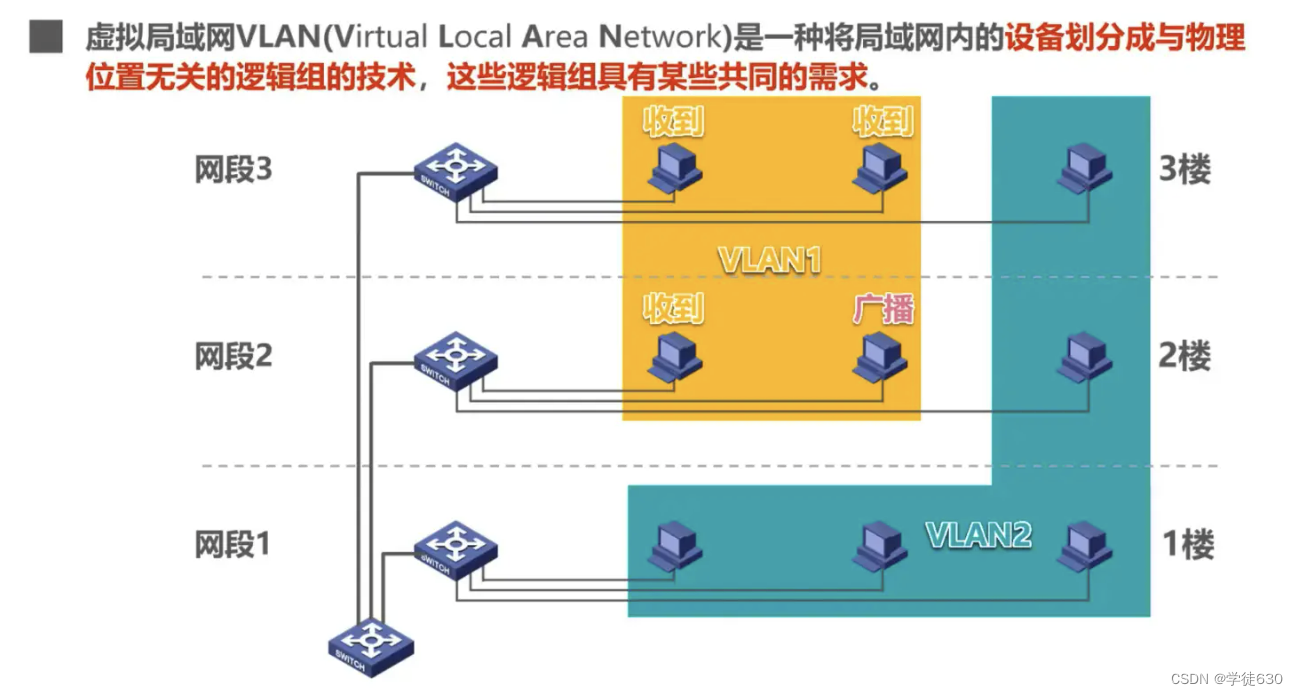

Konzept

- Virtuelles LAN (Virtual LAN) lässt sich einfach über Ethernet-Switches implementieren.

- IEEE 802.1Q- Definition eines virtuellen LAN-VLAN : Ein virtuelles LAN-VLAN ist eine logische Gruppe , die aus einigen LAN-Segmenten besteht und nichts mit dem physischen Standort zu tun hat . Diese Netzwerksegmente haben bestimmte gemeinsame Anforderungen. Jeder VLAN-Frame verfügt über eine eindeutige Kennung, die angibt, zu welchem VLAN der Computer gehört, der den Frame sendet.

- Broadcast-Kommunikation ist innerhalb desselben VLANs möglich, Broadcast-Kommunikation ist jedoch nicht in verschiedenen VLANs möglich.

- Bei Virtual LAN handelt es sich eigentlich nur um einen Dienst, der den Benutzern vom LAN bereitgestellt wird, und nicht um eine neue Art von LAN.

- Da es sich bei einem virtuellen LAN um eine logische Kombination aus Benutzern und Netzwerkressourcen handelt, können zugehörige Geräte und Ressourcen bei Bedarf problemlos neu gruppiert werden, sodass Benutzer von verschiedenen Servern oder Datenbanken aus auf die erforderlichen Ressourcen zugreifen können.

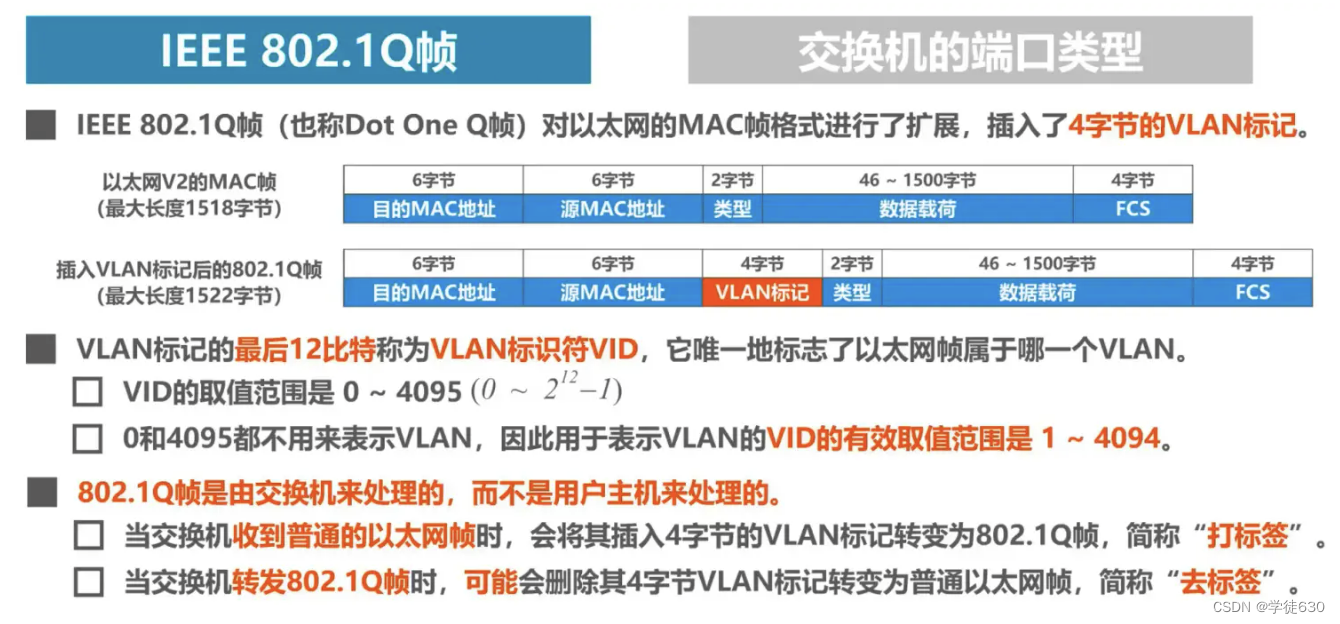

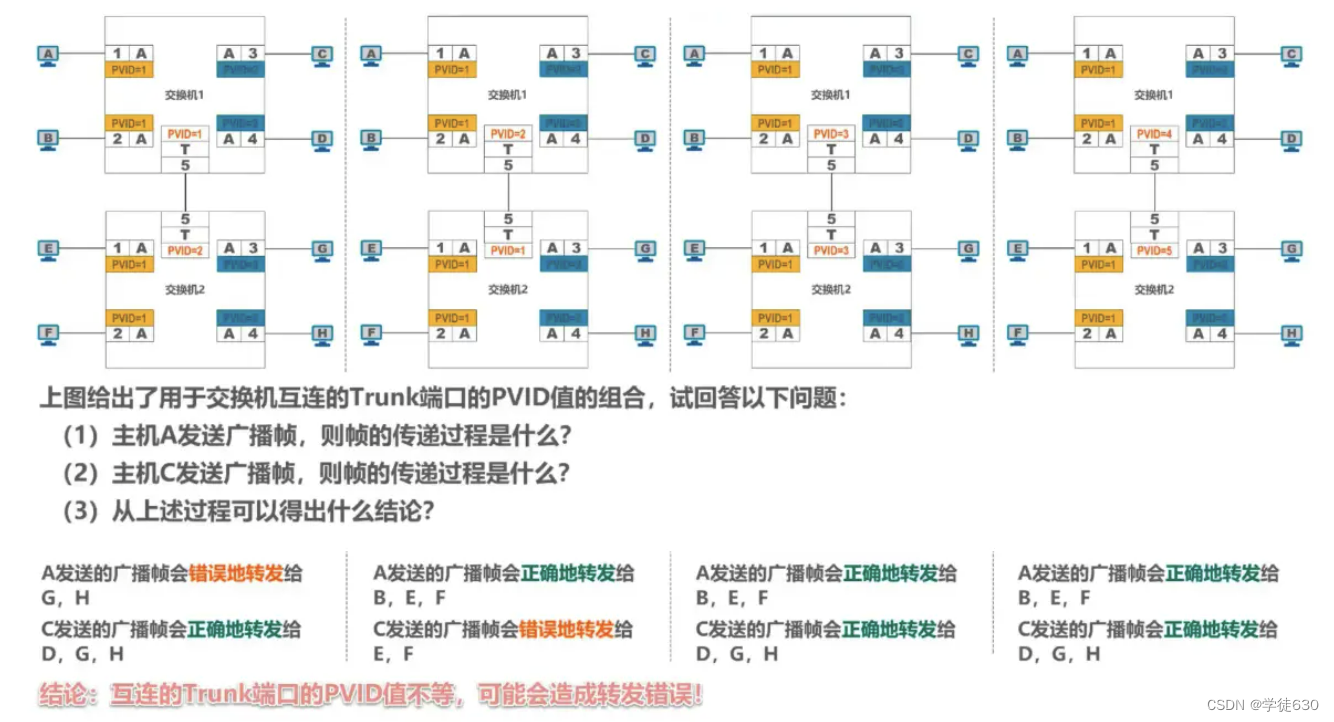

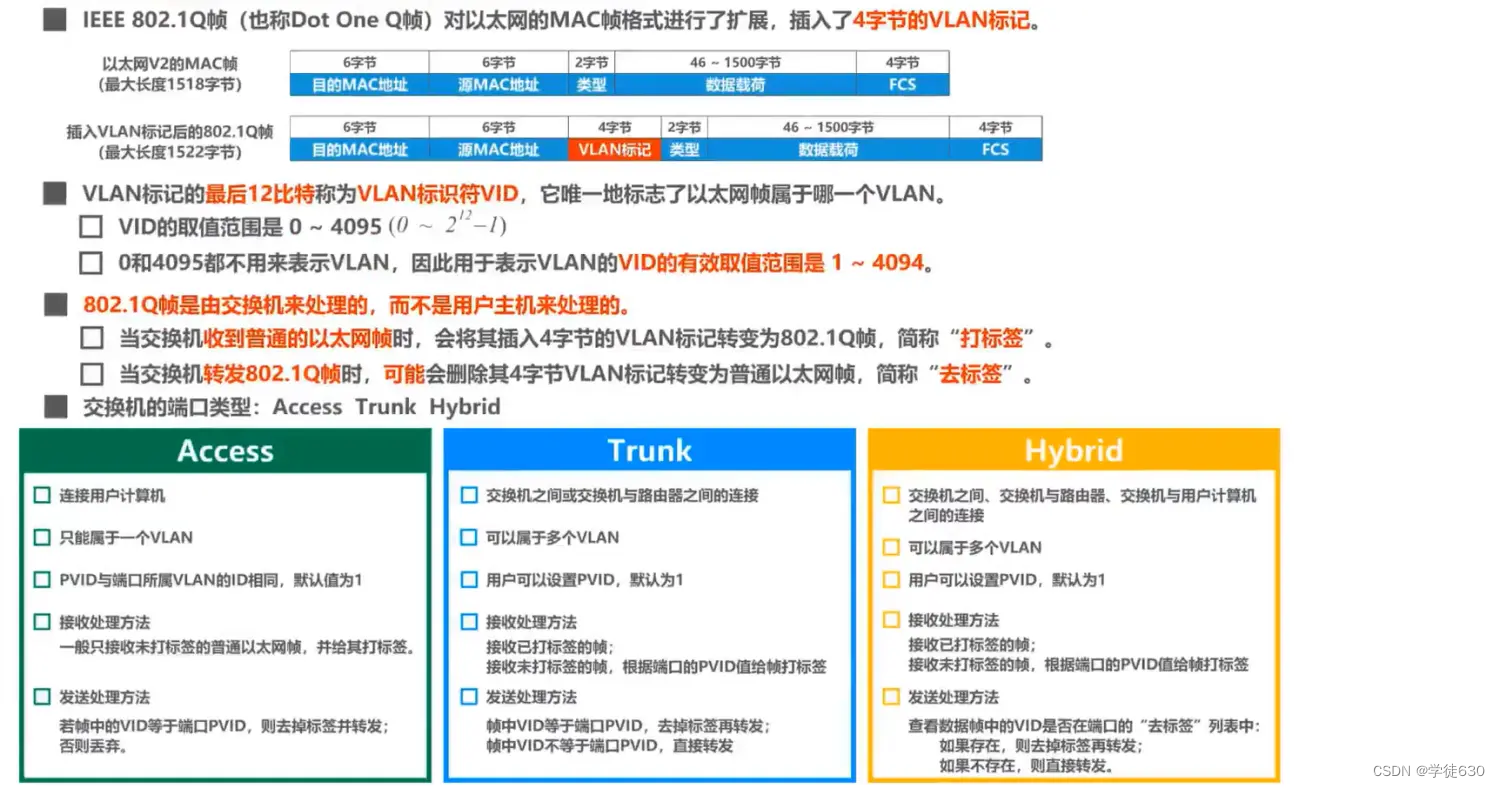

Implementierungsmechanismus des virtuellen LAN-VLAN

Auf dem Switch ist die Virtual-LAN-VLAN-Technologie implementiert, und der Switch muss in der Lage sein, die folgenden Funktionen zu implementieren

-

Fähigkeit zur Verarbeitung von VLAN-getaggten Frames – IEEE 802.1 Q-Frames

-

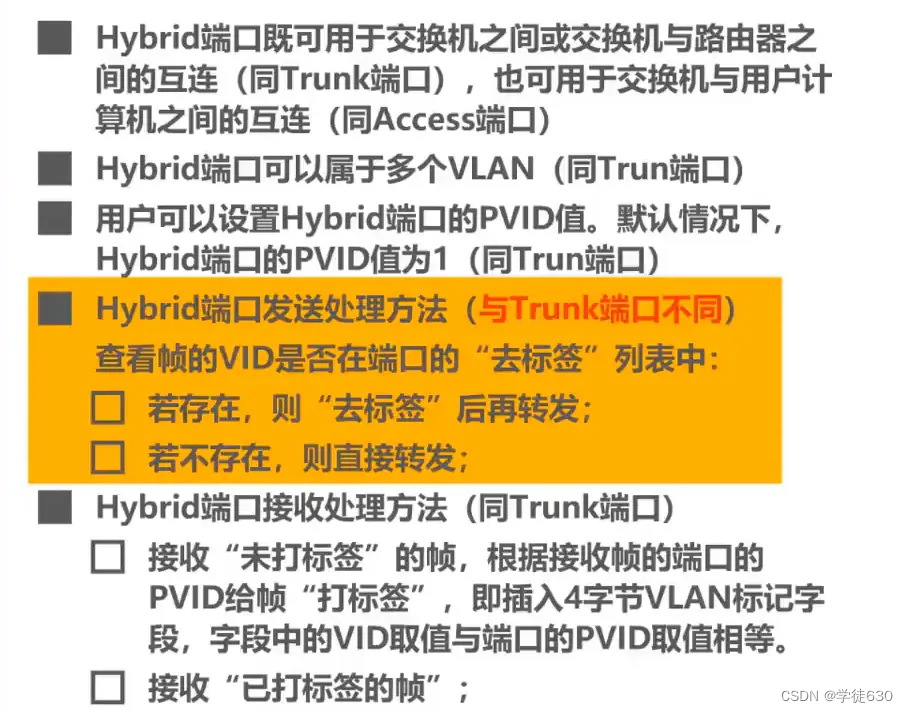

Jeder Port des Switches kann unterschiedliche Porttypen unterstützen, und Ports unterschiedlicher Porttypen verarbeiten Frames unterschiedlich.

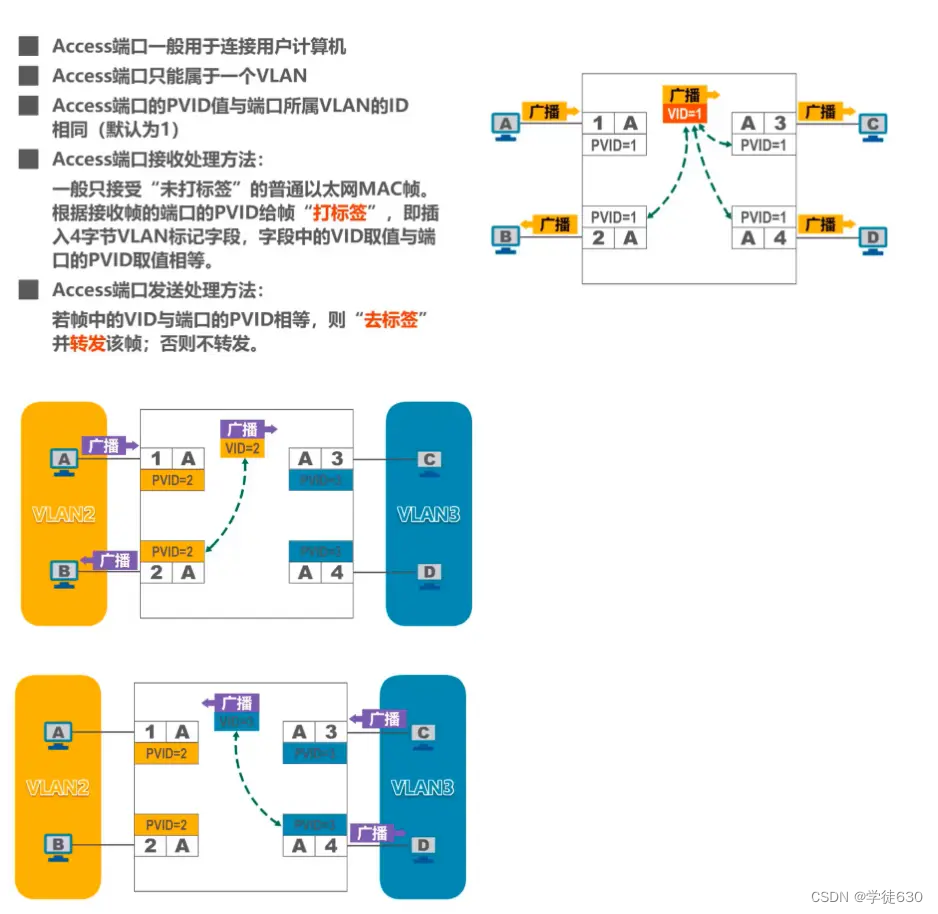

Zugangsport

Verbindung zwischen Switch und Benutzercomputer

Broadcast-Kommunikation ist innerhalb desselben VLANs möglich, Broadcast-Kommunikation ist jedoch nicht in verschiedenen VLANs möglich.

LKW-Hafen

Verbindungen zwischen Switches oder zwischen Switches und Routern

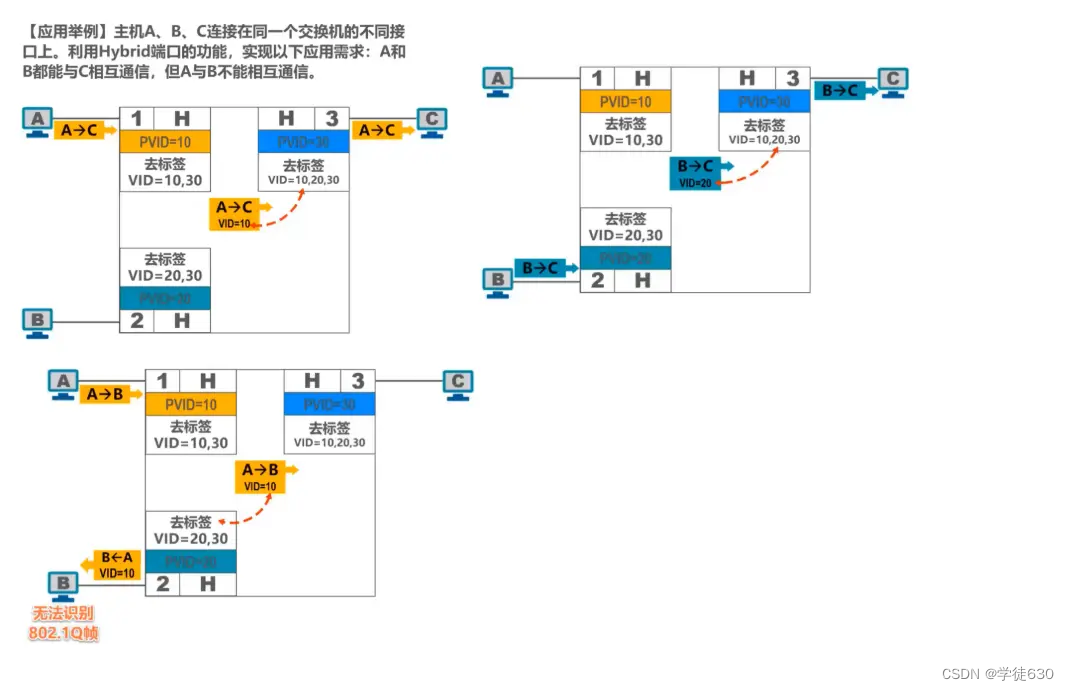

Kleine Beispiele

Private Hybrid-Port-Typen von Huawei-Switches

Zusammenfassen

Vorteile von Virtual LAN

Die Virtual LAN (VLAN)-Technologie bietet die folgenden Hauptvorteile:

- Verbesserte Leistung

- Vereinfachte Verwaltung

- reduzierte Kosten

- Verbesserte Sicherheit