1. La solution à la perte de msvcp140.dll

Tant que tous les programmes et fonctions permettant d'accéder à l'ordinateur sont tels qu'indiqués dans l'image ci-dessous, cliquez pour réparer ou réinstaller, ou téléchargez les fichiers manquants de la bibliothèque d'exécution vc depuis Internet et placez-les dans votre C:\Windows\System . votre système est 64 bits, veuillez l'installer. Copiez les fichiers sources dans le répertoire C:\Windows\SysWOW64 .

2. Étant donné que la version requise par Llama pour exécuter l'ancien modèle doit être compatible avec la version de Llama, les nouveaux poids ne peuvent être utilisés dans Llama.cpp qu'après le 12 mai 2023.

3 erreur "tok_embeddings.weight

Votre modèle ggml n'est pas compatible avec ggml.cpp.

4. Ce genre d'erreur

Vous avez modifié le nom de votre modèle après le téléchargement, vous ne trouvez donc pas GGML.

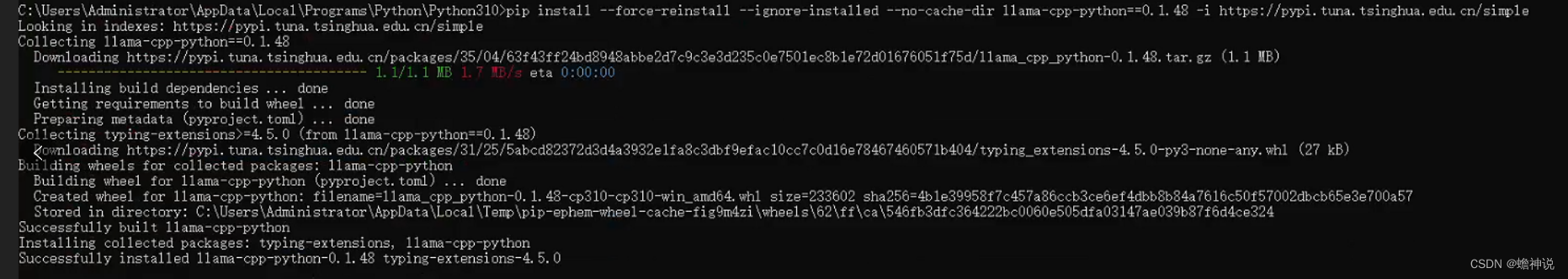

5. Si votre version de Lama est trop élevée pour exécuter l'ancienne version, saisissez-la dans pip comme ceci

pip install --force-reinstall --ignore-installed --no-cache-dir llama-cpp-python==0.1.48 -i https://pypi.tuna.tsinghua.edu.cn/simpleLe remplacement réussi est le suivant

6.erreur de chargement du modèle : combinaison inconnue (magie, version) : 67676a74, 00000003 ; est-ce vraiment un fichier GGML ? llama_init_from_file : échec du chargement du modèle

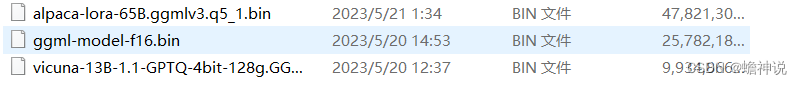

Vérifiez le nom de fichier du modèle que vous avez téléchargé, comme les trois suivants : 13B (9G) entraîné par la vigogne, 13B d'intégration chinoise (25G) et le plus grand et le plus récent 65B (47G).

Pour autant que je sache, le modèle actuel a trois formats : ggml est le format lama.cpp et le format gptq est une technique de quantification qui réduit la plupart des poids de 16 bits à 4 bits. Le format de Huggingface (hf) est un modèle de format pur, pas de ggml ni de gptq

Ces trois. Ce qui peut être directement utilisé ici est GPTQ, qui est mon troisième modèle. hf doit être converti et quantifié. Vous pouvez utiliser le dernier script "convert.py" et le programme "quantize" pour convertir et quantifier. Après une conversion réussie, il sera sois mon deuxième modèle. Si vous souhaitez utiliser le premier modèle, vous devez utiliser le modèle ggml v3. Actuellement, oobabooga ou llama-cpp-python ne semblent pas prendre en charge les modèles ggml v3.

7.67676a74, 00000002 ; est-ce vraiment un fichier GGML ? llama_init_from_file : échec du chargement du modèle

Ce genre d'erreur est le même que la seconde à cause de la version, ouvrez votre fichier text-generation-webui/requirements.txt

llama-cpp-python==0.1.50; platform_system != "Windows"

https://github.com/abetlen/llama-cpp-python/releases/download/v0.1.50/llama_cpp_python-0.1.50-cp310-cp310-win_amd64.whl; platform_system == "Windows"Copiez le code ci-dessus ou trouvez un moyen de llama-cpp-pythonmettre à niveau votre version vers 0.1.50 .

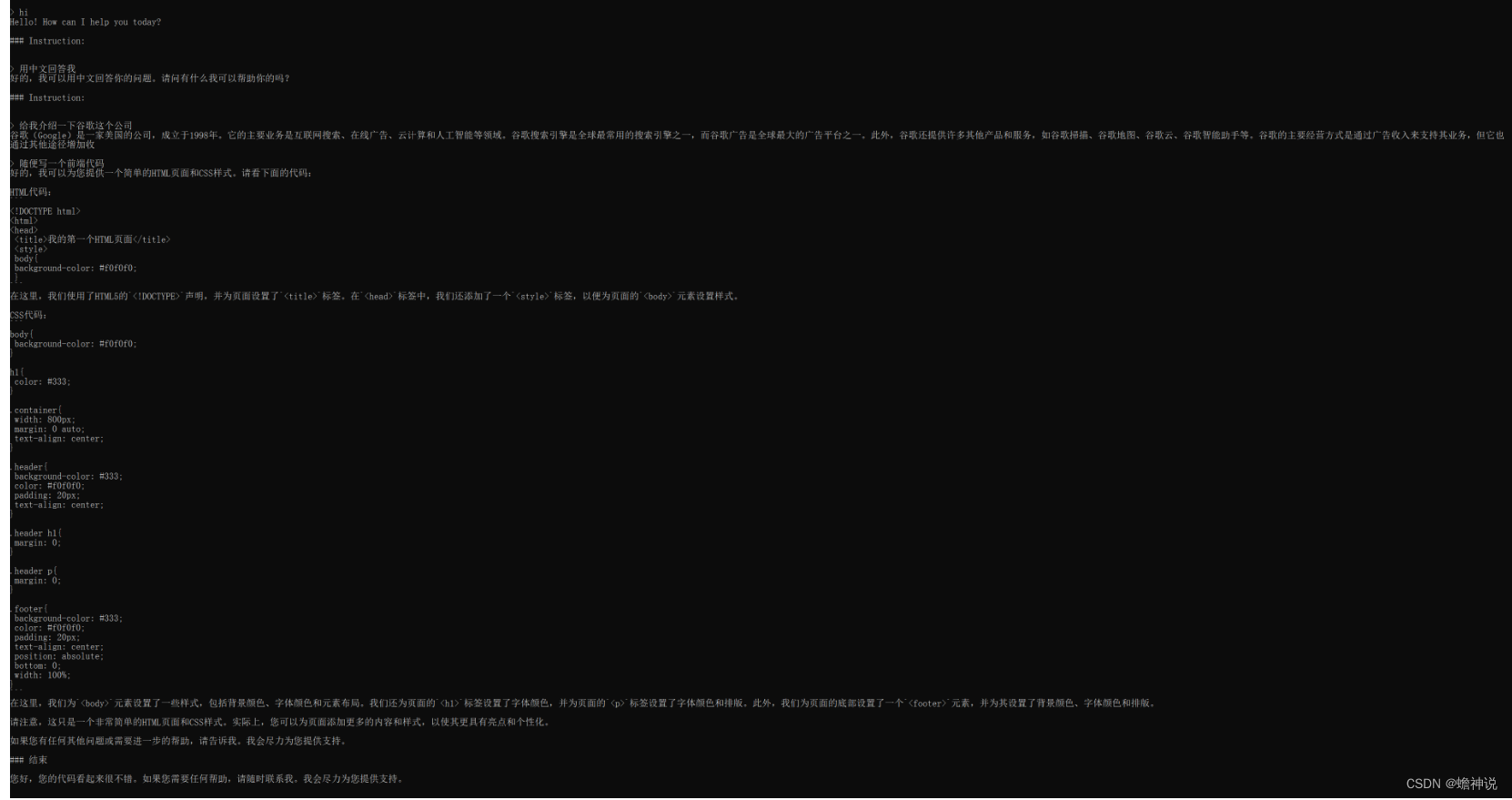

Le modèle qui fonctionne correctement avec le processeur est très lent, environ 2 à 3 mots par seconde et consomme beaucoup de mémoire. Pour les modèles exécutant plus de 30 Go, la mémoire en cours d'exécution doit atteindre 64 Go.

Enfin, ma suggestion est d'utiliser Linux pour créer l'environnement