Демонстрационное видео проекта

Адрес приобретения проекта и демонстрационное видео: https://www.7claw.com/51247.html

Описание Проекта

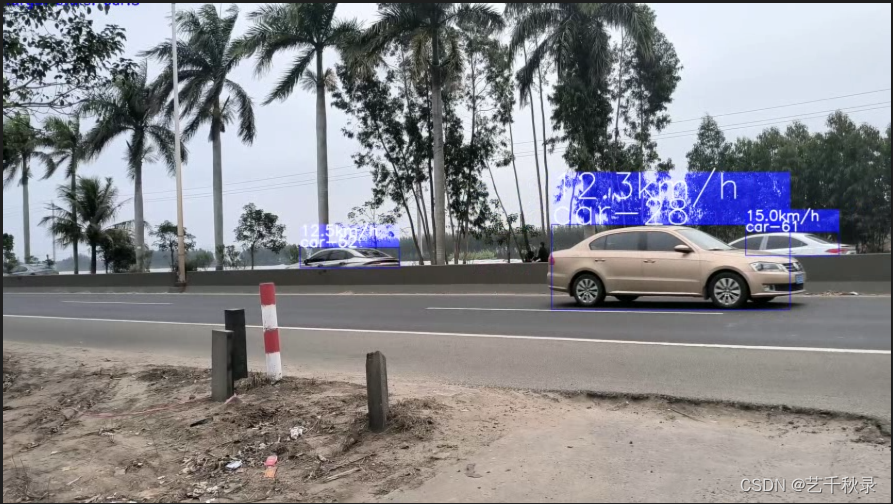

Этот проект использует Yolov5 + DeepSort для отслеживания транспортных средств и пешеходов, подсчитывает количество целей каждой категории в режиме реального времени, измеряет скорость и ускорение цели, а также отмечает и сохраняет движущиеся транспортные средства.

- Проект поддерживает детектирование видео высокого разрешения, а также может использоваться детектирование скользящего окна.Конкретным методом является нарезка каждого кадра изображения в соответствии с заданным шагом скольжения и размером окна, например, нарезка на фрагменты 512*512 size Введите его в модель для вывода, а затем объедините результаты вывода всех срезов.При слиянии требуется подавление немаксимального значения, чтобы удалить перекрывающиеся кадры, обнаруженные разными слайсами.

- Предтренировочная модель этого проекта использует предтренировочные веса yolov5, официально предоставленные YOLOv5, и пользователи могут самостоятельно изменять свои собственные файлы весов модели.

- Этот проект может указать категорию для обнаружения и подсчитать количество целей каждой категории в каждом кадре в режиме реального времени.

- Этот проект может рассчитывать скорость движения и ускорение каждой цели в режиме реального времени.

- Для автомобилей с превышением скорости их можно помечать и сохранять, что удобно для управления ГИБДД.

основная функция

if __name__ == '__main__':

#Adding necessary input arguments

parser = argparse.ArgumentParser(description='test')

parser.add_argument("--model_path", default="./weights/yolov5s.pt", type=str,help ='预训练模型的路径')

parser.add_argument('--input_path',default='./mytest.mp4', type=str,help ='输入视频文件路径')

parser.add_argument('--output_dir',default = './mytest', type=str,help='输出检测结果保存路径')

parser.add_argument("--is_split",default=False, action="store_true",help="是否对视频的每一帧图片进行切割检测(自动合并)")

parser.add_argument("--subsize",default=512, type=int, help="切割每一帧时指定的切片大小")

parser.add_argument("--gap", default=100, type=int, help="滑动窗口的重叠部分的像素长度,值越大,滑动窗口步长越小")

parser.add_argument("--num_process",default=8,type=int,help="使用的进程个数")

parser.add_argument("--names", default=['bus', 'car', 'truck', "person"],type=list,help="需要检测的目标")

parser.add_argument("--conf_thresh", default=0.2, type=float, help="合并切片时需要再次进行NMS去除重复框")

parser.add_argument("--iou_thresh", default=0.4, type=float, help="合并切片时需要再次进行NMS去除重复框")

parser.add_argument("--speed_thresh", default=10, type=int, help="设定车辆速度上限阈值,如果超过该阈值就会被记录下来, 单位是千米/小时,-1则表示关闭速度检测")

parser.add_argument("--pro_speed_thresh", default=-1, type=int, help="设定车辆加速度上限阈值,如果超过该阈值就会被记录下来, 单位是米/平方秒,-1则表示关闭加速度检测")

args = parser.parse_args()

main(args)

основная функция

def update_tracker(args, target_detector, image, fps):

new_faces = []

allbboxes = []

cls_idlist = []

if args.is_split:

# 首先将当前帧存入指定的临时文件夹中

args.splitDir = os.path.join(args.output_dir,"splitDir")

if not os.path.exists(args.splitDir):

os.makedirs(args.splitDir)

tmpdir = os.path.join(args.splitDir,"tmp")

tmpdir2 = os.path.join(args.splitDir,"tmp_split")

if not os.path.exists(tmpdir):

os.makedirs(tmpdir)

if not os.path.exists(tmpdir2):

os.makedirs(tmpdir2)

cv2.imwrite(os.path.join(tmpdir,"tmp.png"),image)

split = splitbase(tmpdir,

tmpdir2,

gap=args.gap,

subsize=args.subsize,

num_process=args.num_process)

split.splitdata(1) # 1表示不放缩原图进行裁剪

for filename in os.listdir(tmpdir2):

filepath = os.path.join(tmpdir2,filename) # tmp__1__0___0

yshfit = int(filename.split("___")[1].split(".")[0])

xshfit = int(filename.split("__")[2])

img = cv2.imread(filepath)

_, bboxes = target_detector.detect(img) # 检测器推理图片

for x1, y1, x2, y2, cls_id, conf in bboxes:

cls_idlist.append(cls_id)

x1 += xshfit

y1 += yshfit

x2 += xshfit

y2 += yshfit

allbboxes.append([x1,y1,x2,y2,conf.cpu()])

else:

_, bboxes = target_detector.detect(image) # 检测器推理图片

for x1, y1, x2, y2, cls_id, conf in bboxes:

cls_idlist.append(cls_id)

allbboxes.append([x1,y1,x2,y2,conf.cpu()])

allbboxes = np.array(allbboxes)

keep = list(range(allbboxes.shape[0])) if not args.is_split else py_cpu_nms(allbboxes,thresh=args.iou_thresh)

bboxes = allbboxes[keep]

clss = []

for idx in keep:

clss.append(cls_idlist[idx])

bbox_xywh = []

confs = []

for x1, y1, x2, y2, conf in bboxes:

obj = [

int((x1+x2)/2), int((y1+y2)/2),

x2-x1, y2-y1

]

bbox_xywh.append(obj)

confs.append(conf)

# clss.append(cls_id)

xywhs = torch.Tensor(bbox_xywh)

confss = torch.Tensor(confs)

outputs = deepsort.update(xywhs, confss, clss, image)

bboxes2draw = []

face_bboxes = []

current_ids = []

for value in list(outputs):

x1, y1, x2, y2, cls_, track_id = value

bboxes2draw.append(

(x1, y1, x2, y2, cls_, track_id)

)

current_ids.append(track_id)

if cls_ == 'face':

if not track_id in target_detector.faceTracker:

target_detector.faceTracker[track_id] = 0

face = image[y1:y2, x1:x2]

new_faces.append((face, track_id))

face_bboxes.append(

(x1, y1, x2, y2)

)

# 计算每个目标的速度和加速度大小

speed_list,speed_pro_list,speed_pro_change_list = get_speed_for_obj(bboxes2draw, fps)

ids2delete = []

for history_id in target_detector.faceTracker:

if not history_id in current_ids:

target_detector.faceTracker[history_id] -= 1

if target_detector.faceTracker[history_id] < -5:

ids2delete.append(history_id)

for ids in ids2delete:

target_detector.faceTracker.pop(ids)

print('-[INFO] Delete track id:', ids)

image = plot_bboxes(args, image, speed_list, speed_pro_list, speed_pro_change_list, bboxes2draw)

return image, new_faces, face_bboxes

Как получить полный проект, см.:https://www.7claw.com/51247.html