Cloud Native accélère le développement de l'intégration Cloud-Edge-End

Le « 14e plan quinquennal » énonce clairement la nécessité de « coordonner le développement des services cloud et des services d'informatique de pointe ». Dans le même temps, le plan de développement de l'économie numérique du « 14e plan quinquennal » du Conseil d'État a également souligné qu'il est nécessaire pour " renforcer les capacités informatiques de pointe pour des scénarios spécifiques ". Alors que le cloud computing chinois est entré dans une période de développement inclusif, la demande d'informatique de pointe a augmenté et l' intégration cloud-edge-dispositif est devenue une direction d'évolution importante à l'avenir .

L'application étendue et l'intégration approfondie des technologies cloud-native et edge computing accéléreront encore le processus de mise en œuvre de l'intégration cloud-edge-end.

Architecture d'Edge Computing native dans le cloud

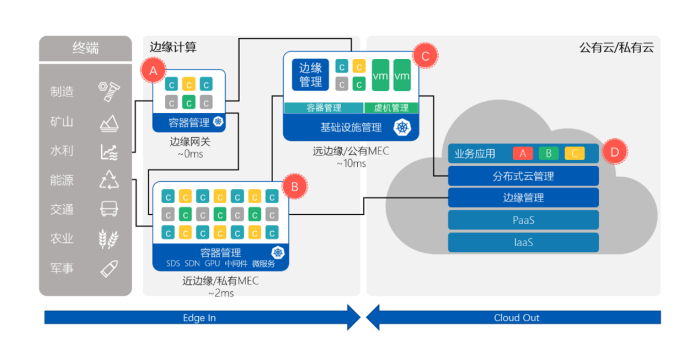

Ce qui suit est une introduction à l'architecture edge computing complète basée sur la solution edge computing de Lingqueyun. Cette architecture comprend trois parties : terminal, edge et cloud. La partie terminale peut être constituée de caméras, de capteurs, de VGA, de robots, etc. Dans la deuxième partie, le terminal périphérique est en outre divisé en trois types d'environnements informatiques : passerelle périphérique, périphérique proche et périphérique éloigné en fonction de la distance par rapport au périphérique périphérique.

La passerelle périphérique est la partie A, qui est étroitement liée à l'appareil. Le premier saut de transmission de données de la périphérie vers le cloud est généralement directement connecté à l'appareil par des moyens filaires ou sans fil. Les passerelles Edge ont les caractéristiques de nombreux types d'applications et de nombreuses interfaces d'appareils.La clé de l'adoption de la technologie des conteneurs est d'améliorer l'intégration des passerelles et d'intégrer plusieurs types de passerelles en une seule. Dans le projet d'edge computing que j'ai rencontré, au départ, la passerelle edge du client était différente de l'appareil en fonction de l'interface, et plus de 20 armboards étaient utilisés pour gérer différents appareils. Après avoir utilisé le conteneur, nous avons effectué l'intégration des ressources, et la finale solution Seuls 9 panneaux de bras sont utilisés, ce qui économise les ressources de moitié.

La périphérie proche est la partie B, qui est généralement déployée en fonction du site périphérique. Un supermarché, une station-service, une station de péage à grande vitesse et un avion sont tous considérés comme un environnement informatique proche de la périphérie. Le délai réseau entre cet environnement et l'appareil doit être contrôlé à environ 2 ms. Cette plate-forme est généralement composée de plus de trois nœuds de serveur physiques et constitue une partie importante de l'informatique de pointe. La caractéristique de cette partie est qu'elle comporte des services de pointe importants et nécessite plus de support, tels que le stockage, le réseau, le GPU, le middleware, le framework de microservices, etc., mais les ressources globales sont encore relativement limitées. La plate-forme de conteneurs est tout simplement adaptée à un tel environnement informatique. Il fournit non seulement un support opérationnel de base pour l'entreprise, mais assure également la mise à l'échelle élastique de l'entreprise, l'auto-guérison des pannes, la libération de lots, etc., apportant une valeur supplémentaire à l'entreprise.

Le prochain environnement informatique est le far edge, qui est la partie C. Cet environnement est déployé par région et le délai du réseau entre les terminaux est contrôlé à environ 10 ms. La raison pour laquelle j'ai placé cette partie entre l'edge computing et le cloud computing est que cette partie n'existe pas dans les modèles informatiques de certains clients, ou cette partie évoluera vers un cloud privé d'entreprise, qui est entièrement basé sur l'architecture de niveau métier. Du point de vue de l'infrastructure, le far edge est un cloud privé doté de fonctionnalités complètes. Comme il existe de nombreuses formes d'entreprise, il doit généralement prendre en charge deux modèles informatiques : la machine virtuelle et le conteneur. Heureusement, Kubernetes a un projet comme Kubevirt, qui nous permet de gérer des machines virtuelles de manière native dans le cloud.En réalité, ce n'est plus une nouvelle technologie et a été largement utilisée dans des scénarios tels que les opérateurs. Dans l'environnement de périphérie distante, nous adoptons l'idée d'un centre de données défini par logiciel et utilisons k8s comme base pour transporter toutes les capacités de calcul, de réseau, de stockage, d'équilibrage de charge, de sécurité et autres requises par le centre de données. En outre, sur la périphérie distante, il existe également une capacité de gestion unifiée pour les passerelles proches et périphériques, et les objets de gestion incluent la gestion côté entreprise et côté plate-forme.

Le dernier est l'environnement de cloud computing, qui fait partie D. Cette partie est ce que nous comprenons généralement comme IaaS, PaaS et autres capacités. Pour la gestion unifiée de l'environnement de périphérie distante, nous adoptons une architecture cloud distribuée, qui peut effectuer le pushdown des applications, l'exploitation et la maintenance unifiées et les mises à niveau de la plate-forme pour l'environnement de périphérie distante dans le cloud.

Il convient de mentionner qu'en pratique, tous les clients ne doivent pas nécessairement suivre une architecture aussi complexe et énorme. Habituellement, ce dont les clients ont besoin est un sous-ensemble de l'architecture complète, qui dépend entièrement de l'architecture métier du client.

Dans l'architecture informatique de pointe de Lingqueyun, nous ne construisons pas une architecture aussi complexe à partir de zéro. Au lieu de cela, sur la base de l'architecture de produit mature qui a fonctionné de manière stable et a été vérifiée par des centaines d'entreprises clientes de premier plan, une petite quantité d'expansion et d'amélioration est effectuée pour l'adapter aux caractéristiques de l'environnement informatique de pointe, afin d'assurer que cette solution a une richesse suffisante, une stabilité fonctionnelle et suffisante.

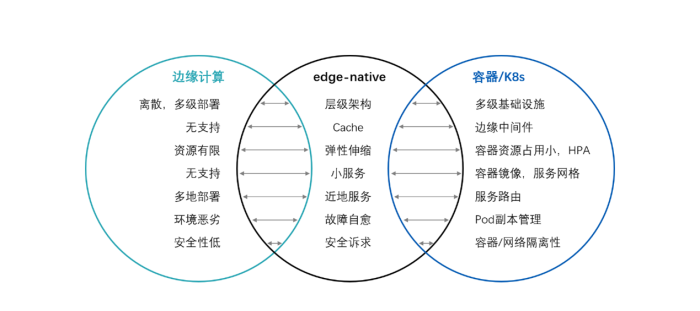

Conteneur K8s + edge computing = edge-native

L'essence de la plate-forme est de mieux soutenir l'entreprise, et la flexibilité et la stabilité de l'entreprise sont l'objectif ultime que nous poursuivons. Dans le domaine de l'informatique de pointe, nous utilisons edge-native pour décrire les types d'entreprises qui peuvent donner plein jeu aux capacités de pointe, ce qui est similaire à cloud-native pour décrire de nouveaux types d'entreprises fonctionnant dans le cloud. Les conteneurs fournissent non seulement une bonne infrastructure pour l'informatique de périphérie, mais peuvent également prendre en charge efficacement le développement et l'exploitation de services natifs de périphérie. Ici, nous décomposons une par une les sept caractéristiques de l'entreprise edge-native :

Premièrement, les entreprises sont généralement hiérarchiques. De la passerelle périphérique à la périphérie proche en passant par la périphérie distante et enfin le cloud, différentes parties de l'entreprise fonctionnent dans différents environnements hiérarchiques et, ensemble, elles constituent une entreprise complète. La capacité de gestion de périphérie à plusieurs niveaux fournie par le conteneur correspond parfaitement à l'architecture de construction réelle de l'informatique de périphérie, et le conteneur peut améliorer la flexibilité du déploiement au niveau de l'entreprise, et l'entreprise peut rapidement passer du cloud à la périphérie, ou migrer de le bord du nuage.

Deuxièmement, les entreprises ont besoin de cache. Ceci est lié à une grande quantité de traitement de données côté périphérie. L'informatique de périphérie ne peut pas résoudre de tels problèmes. Traditionnellement, elle ne peut être résolue que par l'entreprise elle-même. Lorsque nous adoptons des conteneurs, les conteneurs peuvent facilement transférer des middleware et des services de base de données vers des passerelles de périphérie ou des environnements proches de la périphérie, qu'il s'agisse d'un serveur x86 ou d'un boîtier arm.

Troisièmement, l'entreprise doit être élastiquement évolutive. C'est précisément en raison des ressources informatiques de pointe limitées que la mise à l'échelle élastique, un mécanisme d'allocation de ressources flexible, est plus précieuse. Dans le modèle informatique de pointe traditionnel, l'infrastructure ne peut pas aider les entreprises à résoudre de tels problèmes, et ces problèmes doivent être résolus au niveau de l'entreprise. Apporter beaucoup d'ennuis à l'entreprise. Cependant, la mise à l'échelle élastique est la force du conteneur. Le k8 standard inclut la capacité HPA. Grâce à une configuration simple, l'entreprise peut être étendue et contractée de manière flexible en fonction du processeur, de la mémoire et des indicateurs de surveillance pour obtenir une utilisation plus intensive des ressources.

Quatrièmement, le formulaire commercial doit être composé de plusieurs petits services. Ce concept de petits services emprunte au concept de microservices cloud.Il souligne que les services doivent être aussi petits que possible, peuvent être adaptés à des appareils plus compacts et réduire les dépendances entre les services, permettant un assemblage rapide des services. C'est exactement l'avantage du conteneur. Le conteneur lui-même est le meilleur outil de transport pour les petits services. De plus, des technologies telles que le maillage de services sont également propices à la mise en œuvre de la gouvernance des services pour C, C++, Java et d'autres services, qui peuvent aider au développement et au dépannage rapidement.

Cinquièmement, edge-native est un service proche de la terre. Les équipements commerciaux, les données et les interactions se produisent tous du côté périphérique. Vous pouvez imaginer des scénarios tels que des stations-service, des supermarchés et des stations de péage à grande vitesse. La technologie de routage des services dans le conteneur peut mettre en œuvre une publication commerciale flexible, réalisant non seulement des services locaux, mais également des services inter-locaux dans des circonstances extrêmes.

Sixièmement, faute d'auto-guérison. Le phénomène courant de l'informatique de périphérie en cas de panne, car la périphérie ne dispose pas de mesures de refroidissement stables et antichocs, elle est plus sujette aux pannes que le centre de données, ce qui augmente considérablement les coûts d'exploitation et de maintenance des entreprises. Certains de mes clients ont besoin d'embaucher plusieurs personnes dans chaque ville pour maintenir le fonctionnement normal de l'entreprise de bureau. La technologie de gestion des copies de pod de conteneur peut réaliser une auto-réparation rapide des pannes. Une fois que la sonde constate que l'entreprise ne peut pas être desservie, la plate-forme de conteneur redémarre rapidement et migre l'entreprise pour s'assurer qu'il y a suffisamment de copies en cours d'exécution dans le cluster.

Enfin, les exigences de sécurité sont également une caractéristique typique de edge-native. Cela est dû à l'augmentation des points d'attaque de l'informatique de pointe. Les conteneurs ont déjà résolu les problèmes d'isolement dans l'informatique, le réseau et le stockage, et DevSecOps peut aider les entreprises à améliorer la sécurité du code et la sécurité des images. Plus important encore, une fois qu'un problème de vulnérabilité survient dans la chaîne d'approvisionnement logicielle, comme le récent problème de vulnérabilité Ngnix 0day, il est nécessaire de mettre à niveau l'entreprise pour résoudre ce problème. Même les problèmes de la plate-forme elle-même peuvent être résolus avec des mises à niveau de plate-forme en un clic.

Edge-native est l'objectif de l'entreprise, mais ce n'est pas seulement la responsabilité de l'équipe de développement commercial.Semblable à cloud-native, nous devons fournir un support suffisant du côté de l'infrastructure et de la plate-forme, et les conteneurs sont une technologie importante à réaliser edge- native signifie.

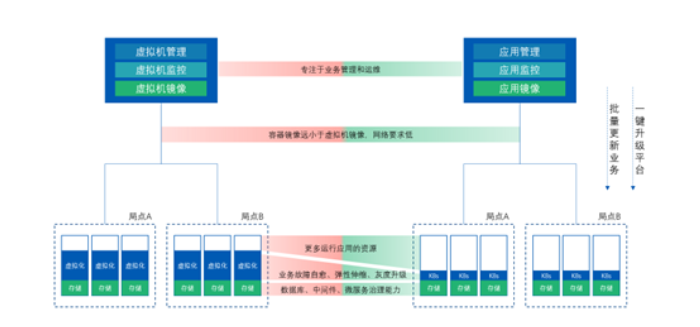

Bord du conteneur VS bord hyperconvergé

Dans la communication avec les clients, certains clients hésitent à utiliser l'hyper-convergence pour résoudre le problème des plates-formes de périphérie. Ici, nous pouvons simplement comparer le degré d'adaptation de l'hyper-convergence et des conteneurs à l'edge computing d'un point de vue technique.

Ici, nous résumons l'architecture de l'hyper-convergence et de la technologie des conteneurs. Le côté gauche est l'architecture d'hyper-convergence. Généralement, plusieurs serveurs d'hyper-convergence sont déployés sur le site et la gestion unifiée du côté périphérique est réalisée via la gestion du cloud. plate-forme dans le cloud ; le côté droit est la technologie de conteneur. , Déployez Kubernetes pour gérer les serveurs physiques sur le site et mettez en œuvre une gestion unifiée du côté périphérique via la gestion du cloud de conteneurs dans le cloud.

On peut comparer ces deux solutions une à une du cloud à la périphérie. Tout d'abord, dans le cloud, l'objet de gestion de la solution hyperconvergée est une machine virtuelle, qui gère essentiellement les ressources et ne peut pas percevoir l'état d'exécution de l'application ; tandis que l'objet géré par la solution de conteneur est le conteneur, c'est-à-dire , l'entreprise elle-même, qui est très importante pour l'exploitation et la maintenance de l'entreprise. Amical, nous nous soucions plus de la performance de l'entreprise que des seules ressources.

Au niveau du réseau à la périphérie du cloud, outre le flux de gestion classique et les données de flux de surveillance, un objet important de consommation de bande passante est l'image de la machine virtuelle ou l'image du conteneur. La taille de l'image du conteneur est similaire au service lui-même, qui est 1 % à 10 % de l'image de la machine virtuelle. Par conséquent, lorsque nous livrons une image à la périphérie, la technologie des conteneurs peut économiser considérablement la bande passante déjà rare du réseau côté cloud au niveau du réseau.

Du côté de la périphérie, l'hyper-convergence utilise des machines virtuelles pour exécuter des services. Une fois les machines virtuelles en cours d'exécution, chaque machine virtuelle a besoin d'un système d'exploitation indépendant, de sorte que les ressources d'exploitation des machines virtuelles sont relativement élevées. Le conteneur est un système d'exploitation partagé, et les ressources d'exécution occupées par un conteneur sont fondamentalement similaires à l'activité dans le conteneur, et il n'y a pas de dépenses supplémentaires. De cette manière, l'occupation des ressources de la technologie des conteneurs présente un énorme avantage, et davantage de ressources d'exploitation telles que le processeur et la mémoire peuvent être réservées à l'entreprise.

De plus, la chose la plus importante est le support de la plate-forme pour les entreprises. Les conteneurs sont plus rationalisés et flexibles. L'autoréparation des pannes, la mise à l'échelle élastique et la publication en niveaux de gris sont les points forts des conteneurs , et ces implémentations de virtualisation sont trop lourdes.

Par conséquent, après avoir discuté de la solution avec les clients, la plupart des clients préfèrent la solution de périphérie de conteneur pure, utilisant des conteneurs pour prendre en charge la construction de passerelles proches ou de périphérie, tandis que la virtualisation, l'hyper-convergence et la co-construction de conteneurs seront utilisées à distance. bord et nuage.

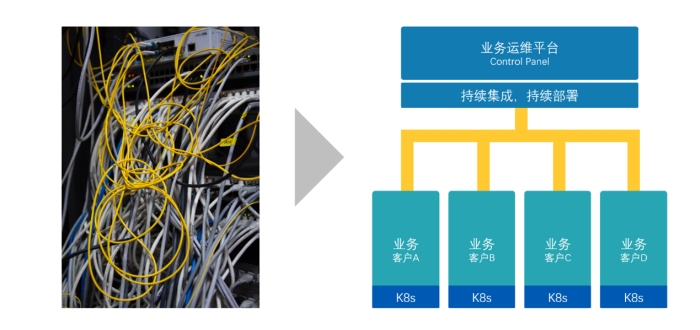

Cloud Native Edge Computing permet aux ISV de fournir, O&M

L'informatique de périphérie traditionnelle a ses scénarios d'utilisation clairs, et c'est le processus par lequel les entreprises se rapprochent des données. À l'heure actuelle, de plus en plus d'ISV commencent à envisager d'adopter des solutions de type edge computing pour améliorer l'efficacité de la prestation de services et de l'O&M . Cette partie des ISV comprend des secteurs tels que l'éducation, les soins médicaux, la radio et la télévision.

Traditionnellement, les ISV doivent effectuer un déploiement et un développement sur site pour chaque client, et un projet nécessite des services sur site allant de quelques semaines à des mois, voire des années, ce qui augmente les coûts de main-d'œuvre des ISV.

Pour résoudre ce problème, les ISV ont commencé à adopter des solutions d'informatique de pointe pour réaliser la livraison, l'exploitation et la maintenance unifiées des services à distance. La solution est très simple Déployez une plateforme de gestion de conteneurs, c'est-à-dire K8, dans chaque environnement client, déployez un module de gestion de périphérie dans le cloud, puis connectez l'environnement client au réseau de l'environnement cloud, afin de réaliser l'opération unifiée et la maintenance des activités des clients via l'environnement cloud. Cette architecture peut améliorer la vitesse de réponse du service client dans une certaine mesure , et en même temps réduire le coût du service sur le terrain du projet . À l'heure actuelle, il s'agit toujours d'un modèle technologique innovant, mais à l'avenir, il pourrait aider les entreprises à créer de nouveaux modèles commerciaux, à améliorer leurs capacités opérationnelles et à réaliser des revenus durables.

Démarrez immédiatement une nouvelle expérience de collaboration côté cloud

Si vous souhaitez devenir un partenaire ISV de Lingqueyun, ou si vous avez des besoins de conseil et d'essai au niveau de l'entreprise, veuillez nous contacter pour explorer les meilleures pratiques de l'informatique de pointe native dans le cloud.

Précédent : AceCon Speech Record | Partage des pratiques de construction Cloud Native Edge