introducción

Papeles Dirección: las comprensiones de atención con exceso de lectura a través de la Atención Redes Neuronales de

referencia Bowen:

https://www.imooc.com/article/29985

https://www.cnblogs.com/sandwichnlp/p/11811396.html#model-4 -aoa-lector

Conjunto de datos : CNN y Daily Mail, la TCC;

lectura de la muestra : <D, Q, A>

AOA lector perteneciente a un modelo de adaptación de dos dimensiones ( impaciente lector es el modelo coincidente 2D, AoA lector CSA similares Reader), AOA lector de Atención se calcula por la forma combinada en filas y columnas (de ahí AOA), durante el uso de la métodos de verificación secundarios para modelo AOA lector para calcular la respuesta a ser verificados de nuevo. Aspectos destacados de este trabajo es otro mecanismo para centrar la atención en existente anidado, es decir, la concentración excesiva de mecanismos de atención.

modelo específico 1 AoA

Incorporación de Contexto : documentos con capa incrustada y cuestiones de derechos incrustados valor capa de matriz de intercambio ,

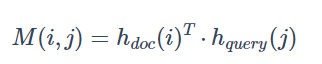

Pair-Wise puntuación de coincidencia : El documento punto oculto y de consulta se multiplican (debido a que el intercambio de matriz de peso, son GRU bi-direccional, por lo que las mismas dimensiones) para dar Pari matriz de juego -wise ( matriz pairwise coincidente )

Atenciones individual :

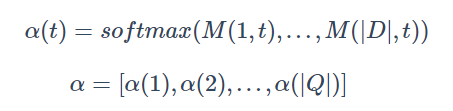

columnas atención calculado : calculado que cada palabra doc para consultar la atención de una palabra (de importancia), y finalmente formar una atención de nivel de documento distribuido (T), también conocido como attetion consulta-a-documento , véase más adelante, para obtener α matriz . En donde la dimensión α | D | * | Q |

Atención fila normalizada dirección - un modelo de evaluación de evaluaciones (destacados) :

el uso de centrar la atención en una suma ponderada de los pesos. Es decir, la representación se convierte en una palabra a un artículo dado, la importancia de estas cuestiones a su palabra en

la dirección de la línea fueron Softmax normalizó, conseguir la atención del Documento-a-Query .

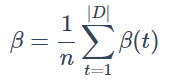

Para ello, en promedio, recibirá la atención a nivel de consulta :

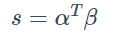

Por último, cada atención en consultas a documentos y acaba de obtener la atención a nivel de consulta hacer punto de dar una puntuación a cada palabra en el documento. (| D Q | * | Q 1 |)

Más filas y columnas, resumió el proceso es similar a la gente que lee el documento:

cuando se mira el problema, la importancia de la cuestión de las palabras no es lo mismo . La principal contribución al análisis del problema en cada palabra, localizar primero la mayor contribución de la palabra (atención columnas + softmax), y luego re-posicionamiento y la mayor contribución a esta palabra palabras más relevantes en el documento (fila atención + suma) como la respuesta a la pregunta

Las predicciones final : palabra w pueden aparecer más de una vez en un espacio palabra V, su posición parece formar un conjunto de i I (w, D)