guía

Trama de datos Spark añadió Identificación del incremento

Al procesar los datos con Spark, a menudo es necesario añadir un número de ID de la subasta a toda la cantidad de datos, cuando se almacena en la base de datos, incremento ID es a menudo un factor crítico. Necesidad de especificar un tipo de identificador de columna LightGBMRanker mmlspark int / mucho tiempo en uso, lo que sigue son varias implementaciones.

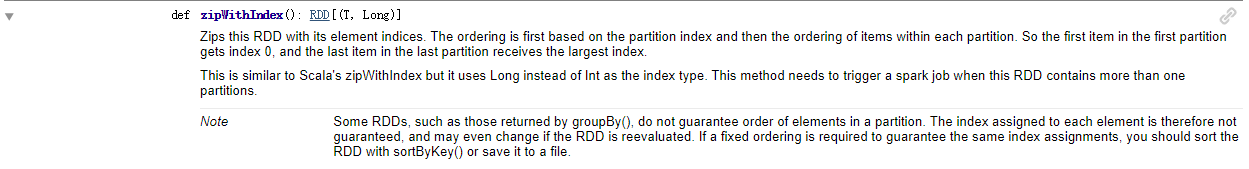

Uso del operador RDD zipWithIndex

// 在原Schema信息的基础上添加一列 “id”信息

val schema: StructType = dataframe.schema.add(StructField("id", LongType))

// DataFrame转RDD 然后调用 zipWithIndex

val dfRDD: RDD[(Row, Long)] = dataframe.rdd.zipWithIndex()

val rowRDD: RDD[Row] = dfRDD.map(tp => Row.merge(tp._1, Row(tp._2)))

// 将添加了索引的RDD 转化为DataFrame

val df2 = spark.createDataFrame(rowRDD, schema)

df2.show()

+-----------+-----------+---+

| lon| lat| id|

+-----------+-----------+---+

|106.4273071|29.63554591| 0|

| 106.44104|29.51372023| 1|

|106.4602661|29.60211821| 2|

|106.4657593|29.45394812| 3|

+-----------+-----------+---+

Utilice la función SparkSQL

import org.apache.spark.sql.functions._

val inputDF = inputDF.withColumn("id", monotonically_increasing_id)

inputDF.show