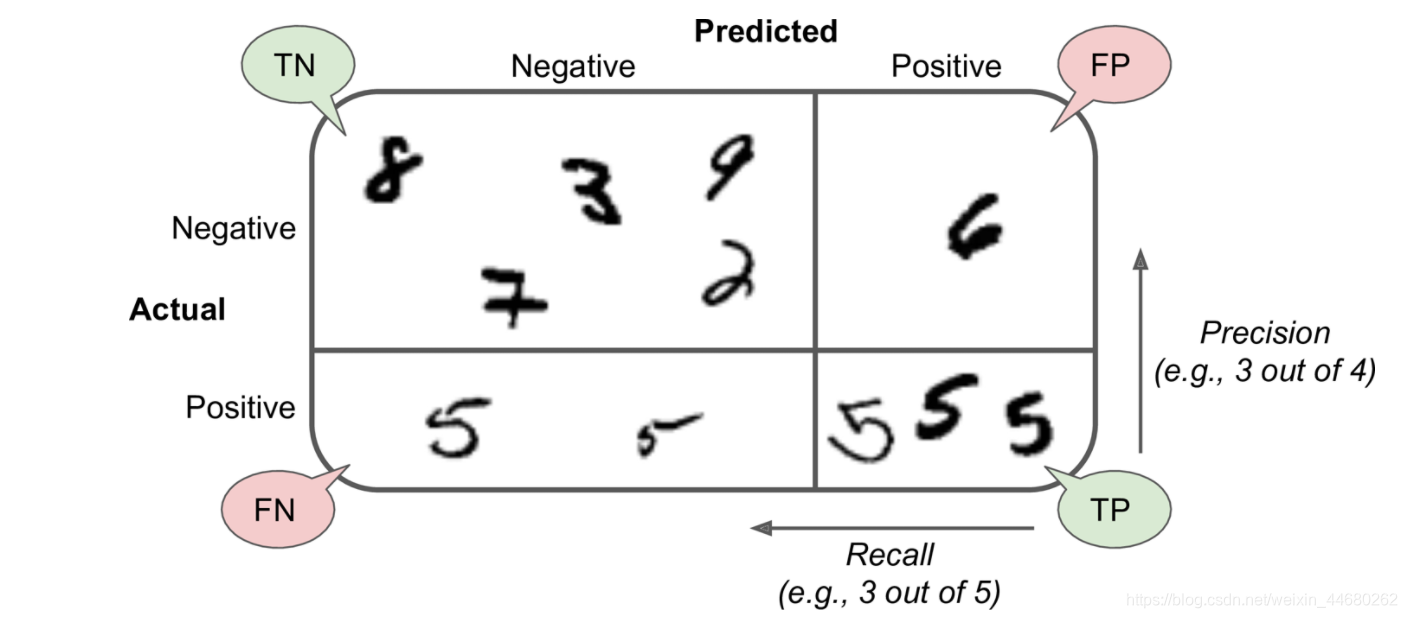

La confusión de la matriz del conocimiento:

- Precisión (precisión):

- Recall (recuperar):

- F1-Score (P y R de la media armónica):

- Para ayudar a entender el diagrama de matriz de confusión (Case Esta cifra refleja el reconocimiento de numeral escrito a mano 5):

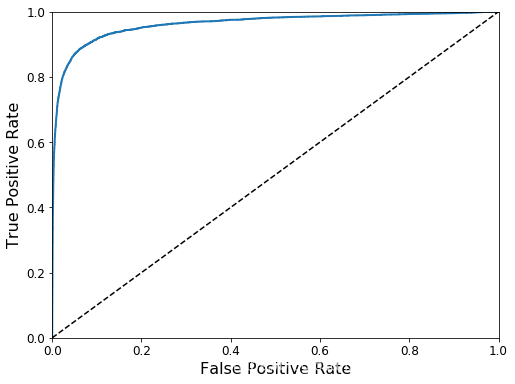

curva ROC / AUC:

- La curva es un criterio de evaluación modelo binario comunes, incluso más que los indicadores relacionados matriz de confusión usual.

- El eje horizontal representa el FPR gráfico (Falso tasa positiva), el eje vertical representa el TPR (tasa de verdaderos positivos).

- Gráfico que muestra el ROC (característica operativa del receptor), AUC es el área bajo el valor del área curva.

- Generalmente, el área AUC cerca de 1 como sea posible (más cerca de la parte superior izquierda de la curva ROC), pero cerca de 0,5 peor (diagonal de la curva ROC de la figura más cerca)

- ROC / AUC curva esquemática:

Ver código relacionado con Python que implementa un artículo especial plantilla.