En los últimos días, la noticia de que OpenAI se transmitirá en vivo ha despertado el apetito de todos. Todos especulan si GPT-5 está a punto de ser lanzado. Sam Altman tuvo que refutar los rumores sobre la plataforma X. publicado todavía. Motor de búsqueda de IA Esta vez tampoco. El editor siempre ha tenido mucha curiosidad, ¿por qué todo el mundo presta tanta atención a GPT-5? ¿La importante actualización de GPT-4 todavía no puede satisfacer las necesidades de las masas? Hasta que leí este artículo, no sabía que las diferencias de versión de GPT son mucho mayores que las de los teléfonos Apple. El progreso de GPT-5 en el procesamiento de video por sí solo es suficiente para que la gente lo espere con ansias, sin mencionar el. Mejora en la inteligencia artificial general (AGI), puede haber algún progreso después de leerlo, espero con ansias GPT-5.

Demasiado largo para ver la versión:

- Los modelos ChatGPT, como GPT-3.5 y GPT-4, se basan en la arquitectura Transformer y están ajustados para funcionar bien en tareas específicas, como diálogo y finalización de texto;

- GPT-4 marca un importante avance en las capacidades de procesamiento del lenguaje natural, con capacidades multimodales, capacidades de razonamiento mejoradas y la capacidad de procesar contextos más largos que las generaciones anteriores;

- GPT-4 Turbo es una versión optimizada de GPT-4, diseñada específicamente para aplicaciones basadas en chat, proporcionando mayor rentabilidad y eficiencia;

- Se espera que GPT-5 logre avances interesantes en el procesamiento de video y la inteligencia artificial general (AGI);

- A medida que estos modelos sigan evolucionando, factores como la disponibilidad y el costo determinarán su adopción generalizada en todas las industrias.

Comprender los conceptos básicos del modelo ChatGPT: arquitectura y capacitación.

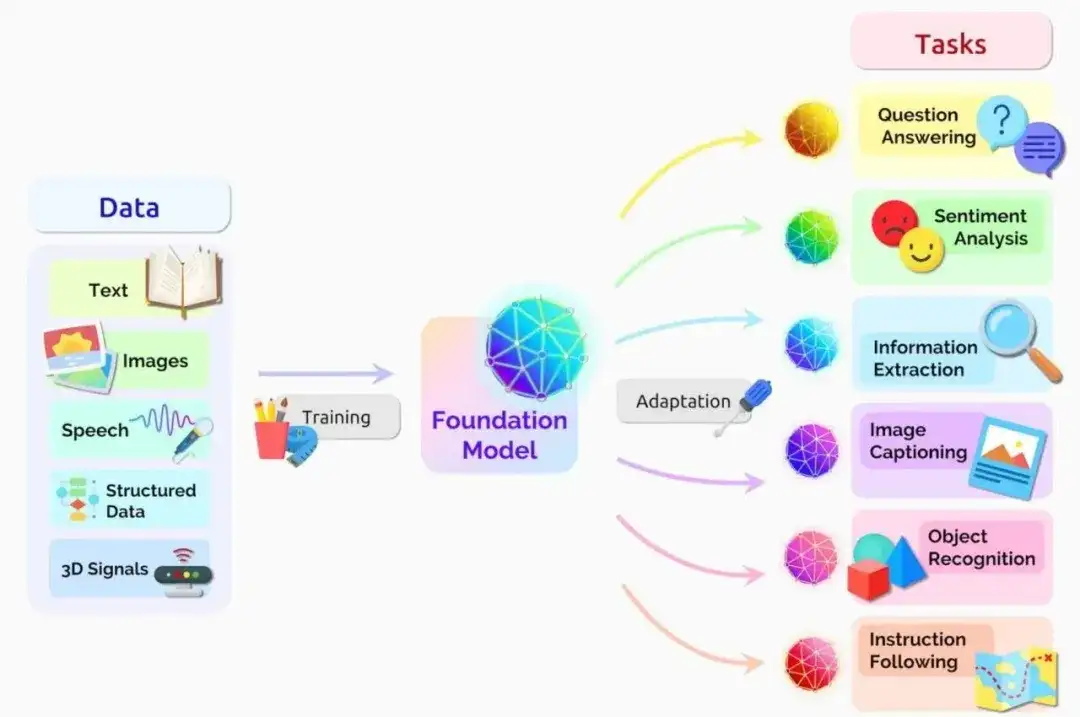

**Para comprender las capacidades de los distintos modelos ChatGPT y sus diferencias, es fundamental comprender primero la arquitectura subyacente que los impulsa. El núcleo de estos modelos se basa en la arquitectura GPT (Generative Pre-trained Transformer), que ha revolucionado el campo del procesamiento del lenguaje natural. **La arquitectura GPT se deriva del modelo Transformer presentado en el artículo histórico "Attention Is All You Need" publicado por Vaswani et al. El modelo Transformer abandona las redes neuronales recurrentes tradicionales (RNN) y, en su lugar, adopta un mecanismo de autoatención, lo que permite al modelo sopesar la importancia de diferentes partes de la secuencia de entrada al generar la salida. Dirección del documento "La atención es todo lo que necesita": https://arxiv.org/abs/1706.03762 Introducción detallada a las redes neuronales recurrentes (RNN):

https://www.techopedia.com/definition/32834/recurrent-neural-network-rnn

Modelo de transformador, fuente: NVIDIA

El mecanismo de autoatención permite que el modelo capture dependencias de largo alcance e información contextual de manera más efectiva que los RNN, que tienen dificultades para lidiar con gradientes que desaparecen y limitaciones de memoria. Al centrarse en partes relevantes de la secuencia de entrada, los modelos Transformer pueden producir resultados más coherentes y contextualmente apropiados.

**Otro aspecto clave de la arquitectura GPT es el proceso de formación previa. **Los modelos GPT se entrenan inicialmente con grandes cantidades de datos de texto sin etiquetar, como libros, artículos y sitios web. Durante esta fase de preentrenamiento no supervisada, el modelo aprende a predecir la siguiente palabra de la secuencia basándose en las palabras anteriores. Esto permite que el modelo desarrolle una rica comprensión de la estructura, la sintaxis y la semántica del lenguaje.

Sin embargo, el modelo GPT previamente entrenado no se ha optimizado para tareas específicas como diálogo o finalización de texto. Para adaptar el modelo a estos propósitos, se emplea un proceso de ajuste. El ajuste fino implica volver a entrenar un modelo previamente entrenado utilizando un pequeño conjunto de datos específico para la tarea objetivo, como los datos de conversación de ChatGPT.

Durante el ajuste fino, los parámetros del modelo se ajustan para minimizar el error en el conjunto de datos para la tarea específica. Este proceso permite que el modelo aprenda matices y patrones exclusivos de la tarea objetivo, lo que resulta en un mejor rendimiento e interacciones más parecidas a las humanas.

"La combinación de la arquitectura Transformer, el mecanismo de autoatención, el entrenamiento previo y los procesos de ajuste permiten que el modelo GPT genere resultados de texto de alta calidad y sensibles al contexto".

Estas opciones arquitectónicas forman la base de los modelos ChatGPT, permitiéndoles llevar a cabo conversaciones naturales, responder preguntas y ayudar con una variedad de tareas relacionadas con el lenguaje.

En los siguientes capítulos, cuando analicemos modelos ChatGPT específicos, recuerde que todos comparten esta arquitectura común y que las diferencias se reflejan principalmente en factores como el tamaño del modelo, los datos de entrenamiento y las estrategias de ajuste.

GPT-3.5: La base de ChatGPT

GPT-3.5, lanzado por OpenAI en 2020, es el modelo de lenguaje subyacente construido sobre el ChatGPT original. Como miembro de la familia de modelos GPT, GPT-3.5 demuestra un progreso significativo en el procesamiento y la generación del lenguaje natural.

Características clave de GPT-3.5

- Comprensión del lenguaje mejorada: en comparación con sus predecesores, GPT-3.5 demuestra una comprensión más profunda del contexto, los matices y la semántica;

- Mayor tamaño del modelo: con 175 mil millones de parámetros, GPT-3.5 es uno de los modelos de lenguaje más grandes disponibles actualmente, capaz de capturar patrones más complejos y generar texto más coherente;

- Mejoras en la generación de texto: GPT-3.5 puede generar texto similar a un humano en múltiples dominios, desde escritura creativa hasta documentación técnica.

La dependencia de ChatGPT de GPT-3.5

El modelo básico de ChatGPT se basa en la arquitectura GPT-3.5. Al ajustar GPT-3.5 con datos de conversaciones multidominio, ChatGPT ha desarrollado la capacidad de llevar a cabo conversaciones naturales y contextuales con los usuarios.

El éxito de ChatGPT se puede atribuir a las fortalezas de su modelo GPT-3.5 subyacente, incluida la comprensión contextual, la amplia base de conocimientos y la adaptabilidad. GPT-3.5 permite a ChatGPT mantener la coherencia y la relevancia durante toda la conversación al comprender el contexto de la conversación. Una amplia formación previa sobre GPT-3.5 permite a ChatGPT hacer referencia a una enorme base de conocimientos que cubre una variedad de temas y campos.

Además, la arquitectura de GPT-3.5 contribuye a la capacidad de ChatGPT de adaptarse a diferentes estilos de conversación y preferencias del usuario.

Limitaciones y deficiencias de GPT-3.5

A pesar de su potencia, GPT-3.5 no está exento de limitaciones. Las principales desventajas incluyen:

- Falta de capacidades de razonamiento: aunque GPT-3.5 es capaz de generar texto coherente y contextual, no funciona bien en tareas que requieren razonamiento lógico o resolución de problemas;

- Sesgo e inconsistencia: GPT-3.5 puede exhibir sesgo en sus datos de entrenamiento y, en ocasiones, producir respuestas inconsistentes o contradictorias;

- Ventana de contexto limitada: GPT-3.5 tiene un tamaño de entrada máximo de 2048 tokens (~1500 palabras), lo que puede limitar su capacidad para manejar contenido de formato más largo o mantener el contexto en conversaciones extendidas.

Comprender las fortalezas y limitaciones de GPT-3.5 es fundamental para establecer expectativas realistas al interactuar con ChatGPT y otras aplicaciones de IA generativa basadas en este modelo. Aunque GPT-3.5 avanza significativamente en el campo de la IA conversacional, todavía hay margen de mejora en áreas como el razonamiento, la mitigación de sesgos y el procesamiento del contexto.

GPT-4: un gran paso adelante en el procesamiento del lenguaje natural

GPT-4 marca un progreso importante en las capacidades de procesamiento del lenguaje natural. GPT-4, lanzado por OpenAI en 2023, introduce nuevas funciones y mejoras basándose en las ventajas heredadas de la generación anterior.

Características clave de GPT-4

- Capacidades multimodales: una de las mejoras más importantes de GPT-4 es su capacidad para procesar y generar contenido en múltiples modalidades. Además de procesar texto, GPT-4 puede analizar y describir imágenes, abriendo la puerta a una amplia gama de nuevas aplicaciones y escenarios de uso;

- Ventana de contexto aumentada: en comparación con GPT-3.5, GPT-4 tiene una ventana de contexto significativamente más grande. Capaz de procesar hasta 25.000 tokens (aproximadamente 17.000 palabras), GPT-4 puede manejar contenido más extenso y mantener la coherencia contextual durante conversaciones o documentos largos;

- Capacidades de razonamiento mejoradas: GPT-4 exhibe capacidades de razonamiento mejoradas, lo que le permite desempeñarse mejor en tareas que requieren pensamiento lógico, resolución de problemas y análisis. Este progreso abre nuevas posibilidades para la aplicación de GPT-4 en investigación científica, análisis de datos y apoyo a la toma de decisiones, entre otros campos.

El impacto de GPT-4 en ChatGPT

El lanzamiento de GPT-4 ha tenido un impacto significativo en ChatGPT y en todo el campo de la IA conversacional.

Al aprovechar las capacidades de GPT-4, ChatGPT puede llevar a cabo conversaciones más complejas y sensibles al contexto, brindando a los usuarios respuestas más precisas y relevantes.

Además, las capacidades multimodales de GPT-4 facilitan el desarrollo de nuevas aplicaciones que combinan la comprensión del lenguaje y la percepción visual. Esto abre posibilidades más interesantes en subtítulos de imágenes, respuesta visual a preguntas y creación de contenido multimodal.

Abordar las limitaciones y las consideraciones éticas

Aunque GPT-4 aporta grandes avances, es importante darse cuenta de que no es una panacea para todas las limitaciones y desafíos de los modelos de lenguaje. Los investigadores y desarrolladores continúan lidiando con problemas como el sesgo, la inconsistencia y el posible abuso. OpenAI enfatizó su compromiso con el desarrollo responsable de la IA tomando las siguientes medidas:

- Protección mejorada contra contenido dañino o engañoso

- Trabajar con investigadores y especialistas en ética para identificar y mitigar riesgos potenciales.

- Divulgar de forma transparente las capacidades y limitaciones de GPT-4

Comparación detallada entre GPT-3.5 y GPT-4

| Características | GPT-3.5 | GPT-4 | Comprensión profunda demostrada del contexto, los matices y la semántica | Capacidad para pensar lógicamente, resolver problemas y analizar | ) | Generación de texto | Puede generar texto similar a un humano en múltiples dominios | Puede procesar y generar contenido en múltiples modalidades (texto, imágenes) | Entrada máxima de 2048 tokens | para manejar contenido más extenso | Capacidad de razonamiento | Falta de capacidad de razonamiento |

GPT-4 Turbo: optimizado para aplicaciones de chat

GPT-4 Turbo es una variante del modelo GPT-4 diseñada para satisfacer las necesidades únicas de las aplicaciones de chat. Este modelo combina las funciones avanzadas de GPT-4 y está optimizado para mejorar su rendimiento y eficiencia en entornos conversacionales.

Características clave del GPT-4 Turbo

- Diseñado para chat: GPT-4 Turbo está optimizado con una gran cantidad de datos de conversación para generar respuestas más naturales y coherentes en interacciones basadas en chat;

- Eficiencia mejorada: a través de la optimización de la arquitectura y el proceso de capacitación, GPT-4 Turbo proporciona un tiempo de respuesta más rápido y un menor costo informático que el modelo GPT-4 estándar;

- Gestión de contexto mejorada: GPT-4 Turbo está diseñado para manejar la dinámica de las conversaciones de manera más eficiente, manteniendo el contexto y la coherencia en múltiples rondas de conversaciones.

Ventajas de GPT-4 Turbo en ChatGPT

La profesionalidad de GPT-4 Turbo aporta muchos beneficios a las aplicaciones de chat:

- Rentabilidad: al reducir los requisitos informáticos, GPT-4 Turbo permite a los desarrolladores crear, operar y escalar aplicaciones de chat a costos más bajos;

- Experiencia de usuario mejorada: con tiempos de respuesta más rápidos y resultados más relevantes contextualmente, GPT-4 Turbo mejora la experiencia general del usuario en las interacciones basadas en chat;

- Escalabilidad: las optimizaciones de GPT-4 Turbo lo hacen ideal para manejar conversaciones de alta concurrencia, lo que permite que las aplicaciones de chat escale sin problemas.

¿Qué tan poderoso será el GPT-5?

OpenAI ha confirmado que está trabajando activamente en GPT-5 y, aunque los detalles específicos sobre GPT-5 aún son limitados, los primeros indicios indican que traerá mejoras significativas y nuevas capacidades.

Posibles mejoras funcionales a GPT-5:

- Ampliar aún más la ventana de contexto para respaldar la comprensión y generación de contenido de formato más extenso.

- Capacidades avanzadas de procesamiento de diálogos de múltiples turnos para lograr diálogos más naturales y fluidos.

- Mejorar las capacidades de razonamiento y resolución de problemas y ampliar las capacidades de los modelos de lenguaje.

Además, hay rumores de que GPT-5 podría introducir capacidades de procesamiento de vídeo, ampliando sus capacidades de procesamiento multimedia de texto e imágenes a vídeos. Esto podría abrir nuevas fronteras en el análisis, la generación y la interacción de vídeos. El rápido desarrollo de modelos de lenguaje como ChatGPT ha reavivado los debates sobre la posibilidad de lograr inteligencia artificial general (AGI), una capacidad hipotética de los sistemas de inteligencia artificial para comprender y aprender cualquier tarea basada en el conocimiento que un ser humano pueda realizar.

Preguntas más frecuentes

P: ¿Qué modelo de ChatGPT debo usar?

R: Su elección del modelo ChatGPT debe basarse en sus necesidades, presupuesto y capacidades técnicas específicas. GPT-3.5 es adecuado para escenarios generales, mientras que GPT-4 proporciona funciones más avanzadas y soporte multimodal. GPT-4 Turbo está optimizado para aplicaciones de chat, equilibrando rendimiento y eficiencia.

P: ¿Qué modelo utiliza ChatGPT-4?

R: ChatGPT-4 se basa en el modelo de lenguaje GPT-4, que es el modelo más avanzado de la serie GPT desarrollado por OpenAI. En comparación con su predecesor GPT-3.5, GPT-4 tiene mejoras significativas en capacidades multimodales, razonamiento mejorado y ventanas de contexto más grandes.

P: ¿GPT-5 llegará pronto?

R: Sí, OpenAI ha confirmado que está desarrollando activamente GPT-5 como sucesor del modelo GPT-4. Aunque los detalles específicos son limitados, se espera que GPT-5 aporte mayores avances en la comprensión del contexto, las capacidades de conversación y posiblemente incluso las capacidades de procesamiento de vídeo.

P: ¿Qué modelo de GPT es el mejor?

R: Depende del escenario y las necesidades de su aplicación. Por ahora, GPT-4 proporciona las funciones más avanzadas, mientras que GPT-3.5 es una opción más asequible para escenarios de aplicaciones generales y de chat.

Si hay alguna infracción, contáctenos para eliminarla. Enlace de referencia: https://www.techopedia.com/chatgpt-models-guide

Síganos

"Trusted AI Progress" La cuenta oficial está dedicada a la difusión de la última tecnología de inteligencia artificial confiable y al cultivo de tecnología de código abierto, que cubre el aprendizaje de gráficos a gran escala, razonamiento causal, gráficos de conocimiento, modelos grandes y otros campos técnicos. escanea el código QR para seguir y desbloquear más información de IA ~