Nota del editor: actualmente, los grandes modelos de lenguaje se han convertido en un tema candente en el campo del procesamiento del lenguaje natural. ¿Son los LLM realmente “inteligentes”? ¿Qué inspiraciones nos han traído? En respuesta a estas preguntas, Darveen Vijayan nos trae este artículo que invita a la reflexión.

El autor explica principalmente dos puntos: primero, los LLM deben considerarse como una calculadora de palabras, que funciona prediciendo la siguiente palabra, y no deben clasificarse como "inteligentes" en esta etapa. En segundo lugar, a pesar de sus limitaciones actuales, los LLM nos brindan la oportunidad de reflexionar sobre la naturaleza de la inteligencia humana. Debemos mantener una mente abierta, buscar constantemente nuevos conocimientos y nuevas comprensiones del conocimiento y comunicarnos activamente con los demás para ampliar nuestros límites cognitivos.

Probablemente todavía sea controvertido si los LLM son inteligentes o no. Pero una cosa es segura: han aportado innovación al campo del procesamiento del lenguaje natural y han proporcionado nuevas dimensiones de pensamiento sobre la naturaleza de la inteligencia humana. Vale la pena leer atentamente este artículo y analizarlo para todos los usuarios de herramientas de modelos grandes y profesionales de la IA.

Autor |

Compilado |

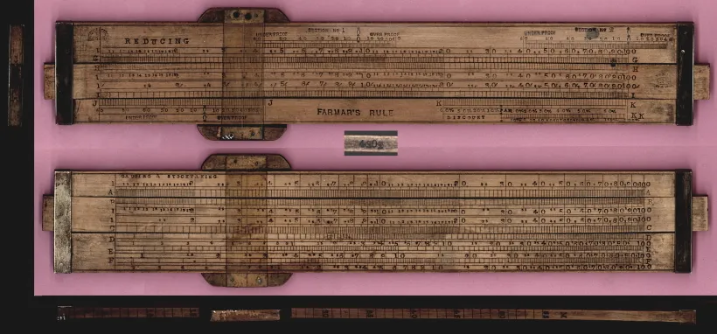

A principios del siglo XVII, un matemático y astrónomo llamado Edmund Gaunt enfrentó un desafío astronómico sin precedentes: para calcular los complejos movimientos de los planetas y predecir eclipses solares, los astrónomos debían confiar no sólo en la intuición, sino también en dominar complejas operaciones logarítmicas y trigonométricas. ecuaciones. Entonces, como todo buen innovador, Gunter decidió inventar un dispositivo informático analógico. El dispositivo que creó finalmente se conoció como regla de cálculo[1].

La regla de cálculo es un bloque de madera rectangular de 30 cm de largo que consta de un marco fijo y una parte deslizante. El marco fijo alberga una escala logarítmica fija, mientras que la parte deslizante alberga una escala móvil. Para utilizar una regla de cálculo, es necesario comprender los principios básicos de los logaritmos y cómo alinear las escalas para la multiplicación, la división y otras operaciones matemáticas. Es necesario deslizar la parte móvil para que los números se alineen, leer el resultado y prestar atención a la posición del punto decimal. ¡Vaya, es realmente demasiado complicado!

regla de cálculo

regla de cálculo

Unos 300 años después, en 1961, Bell Punch Company presentó la primera calculadora electrónica de escritorio, la "ANITA Mk VII". Durante las décadas siguientes, las calculadoras electrónicas se volvieron cada vez más complejas y tenían cada vez más funciones. Los trabajos que antes requerían cálculos manuales toman menos tiempo, lo que permite a los empleados centrarse en un trabajo más analítico y creativo. Por lo tanto, las calculadoras electrónicas modernas no sólo hacen que el trabajo sea más eficiente, sino que también permiten a las personas resolver mejor los problemas.

La calculadora supuso un cambio importante en la forma de hacer matemáticas, pero ¿qué pasa con el lenguaje?

Piensa en cómo estructuras tus oraciones. Primero, necesitas tener una idea (qué significa esta oración). A continuación, debes dominar mucho vocabulario (tener suficiente vocabulario). Luego, debes poder poner estas palabras en oraciones correctamente (se requiere gramática). ¡Vaya, todavía es tan complicado!

Hace ya 50.000 años, cuando el Homo sapiens moderno creó el lenguaje por primera vez, la forma en que generamos palabras para el lenguaje se ha mantenido prácticamente sin cambios.

Podría decirse que todavía somos como Gunter usando una regla de cálculo cuando se trata de construir oraciones.

¡Es justo decir que todavía estamos en la era de Gunther en la que se usaba una regla de cálculo cuando se trataba de generar oraciones!

Si lo piensas bien, usar el vocabulario apropiado y la gramática correcta es seguir las reglas del lenguaje.

Es similar a las matemáticas, las matemáticas están llenas de reglas, así que puedo calcular 1+1=2 y cómo funciona la calculadora.

¡Necesitamos una calculadora de palabras!

Lo que necesitamos es una calculadora pero ¡para palabras!

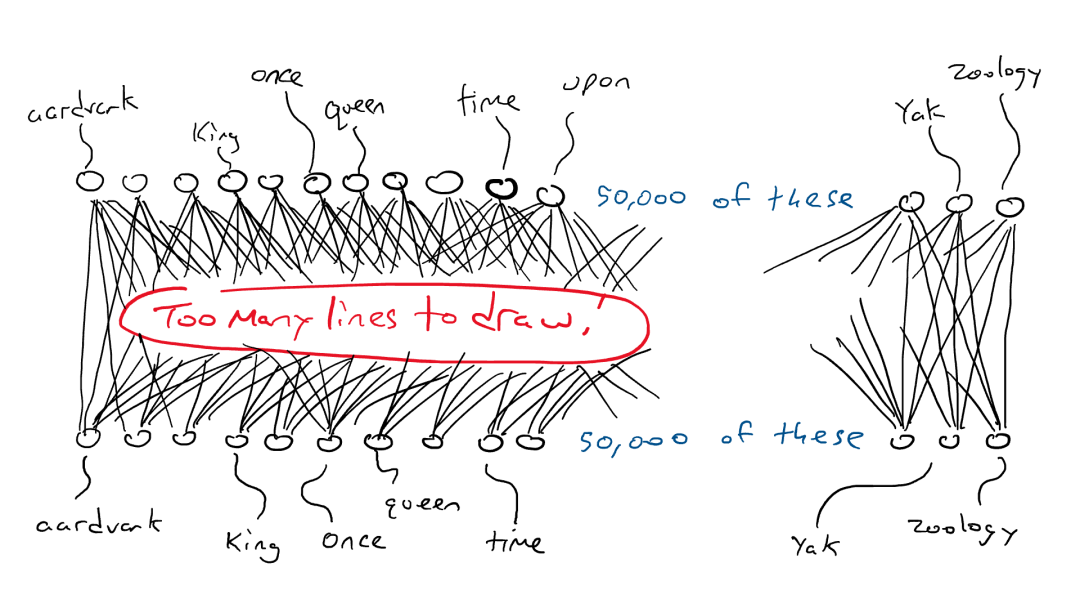

Sí, diferentes idiomas necesitan seguir reglas diferentes, pero sólo obedeciendo las reglas del lenguaje se puede entender el idioma. Una diferencia clara entre el lenguaje y las matemáticas es que las matemáticas tienen respuestas fijas y ciertas, mientras que puede haber muchas palabras razonables que caben en una oración.

Intente completar la siguiente oración: Me comí un _________ (Me comí un _________). Imagine las palabras que podrían aparecer a continuación. Hay aproximadamente 1 millón de palabras en el idioma inglés. Aquí se podrían utilizar muchas palabras, pero ciertamente no todas.

Responder "agujero negro" equivale a decir 2+2=5. Además, responder "manzana" es inexacto. ¿por qué? ¡Por restricciones gramaticales!

En los últimos meses, los modelos de lenguajes grandes (LLM) [2] han conquistado el mundo. Algunas personas lo consideran un gran avance en el campo del procesamiento del lenguaje natural, mientras que otros lo consideran el comienzo de una nueva era de la inteligencia artificial (IA).

LLM ha demostrado ser muy bueno generando texto similar al humano, lo que eleva el listón para las aplicaciones de IA basadas en lenguaje. Con su amplia base de conocimientos y excelente comprensión contextual, LLM se puede aplicar en varios campos, desde traducción de idiomas y generación de contenido hasta asistentes virtuales y chatbots para atención al cliente.

¿Estamos ahora en un punto de inflexión similar al que estábamos con las calculadoras electrónicas en la década de 1960?

Antes de responder esta pregunta, comprendamos cómo funciona el LLM. LLM se basa en una red neuronal Transformer y se utiliza para calcular y predecir la siguiente palabra que mejor se adapta a una oración. Para construir una potente red neuronal Transformer, es necesario entrenarla con una gran cantidad de datos de texto. Esta es la razón por la que el enfoque de "predecir la siguiente palabra o token" funciona tan bien: porque hay una gran cantidad de datos de entrenamiento fácilmente disponibles. LLM toma una secuencia completa de palabras como entrada y predice la siguiente palabra más probable. Para aprender la siguiente palabra más probable, comenzaron devorando todos los datos de Wikipedia, luego devorando montones de libros y, finalmente, devorando todo Internet.

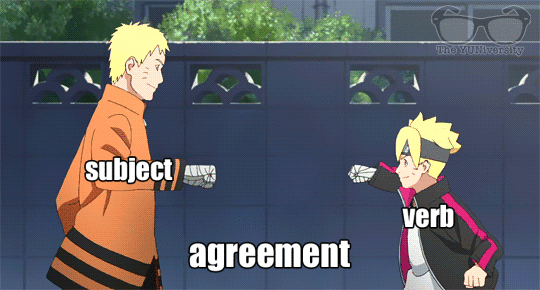

Hemos establecido anteriormente que el lenguaje contiene reglas y patrones. El modelo aprenderá implícitamente estas reglas a través de todas estas oraciones para completar la tarea de predecir la siguiente palabra.

red neuronal profunda

Después de un sustantivo singular, la probabilidad de que un verbo termine en "s" aumenta en la siguiente palabra. De manera similar, al leer las obras de Shakespeare, aumenta la probabilidad de que aparezcan palabras como "doth" y "wherefore".

Durante el entrenamiento, el modelo aprende estos patrones de lenguaje y eventualmente se convierte en un experto en idiomas.

¿Pero es suficiente? ¿Es suficiente simplemente aprender las reglas de un idioma?

¿Pero es eso suficiente? ¿Es suficiente aprender reglas lingüísticas?

El lenguaje es complejo y una palabra puede tener múltiples significados según el contexto.

Por tanto, se requiere atención propia. En pocas palabras, la autoatención es una técnica que los estudiantes de idiomas utilizan para comprender las relaciones entre diferentes palabras en una oración o artículo. Así como usted se concentraría en diferentes partes de una historia para comprenderla, la atención personal le permite a LLM poner más énfasis en ciertas palabras de una oración al procesar la información. De esta manera, el modelo puede comprender mejor el significado general y el contexto del texto, en lugar de predecir ciegamente la siguiente palabra basándose únicamente en las reglas del lenguaje.

mecanismo de autoatencion

Si pienso en un modelo de lenguaje grande como una calculadora de palabras que simplemente predice la siguiente palabra, ¿cómo puede responder todas mis preguntas?

Si los LLM son calculadoras de palabras y simplemente predicen la siguiente palabra, ¿cómo pueden responder todas mis preguntas?

Cuando le pides a un modelo de lenguaje grande que maneje una tarea que requiere pensar y lo logra, es probable que haya visto la tarea que le asignaste en miles de ejemplos. Incluso si tiene algunos requisitos únicos, como:

"Escribe un poema sobre una orca comiendo pollo"

Escríbeme un poema sobre una orca comiendo un pollo.

Los modelos de lenguaje grandes también pueden completar con éxito las tareas que usted asignó:

En medio de las olas, un espectáculo invisible, Una orca caza, veloz y entusiasta, En el reino del océano, comienza la danza, Como el destino de una gallina, la orca gana.

Con poderosas mandíbulas, golpea a la presa, Las plumas flotan, a la deriva, A la manera de la naturaleza, se hila una historia, Donde la vida y la muerte se vuelven una sola.

~ ChatGPT

No está mal, ¿verdad? Esto es gracias a su mecanismo de autoatención, que le permite fusionar y combinar de manera efectiva información relevante para construir una respuesta razonable y coherente.

Durante el entrenamiento, los modelos de lenguaje grande (LLM) aprenden a identificar patrones, asociaciones y relaciones entre palabras (y frases) en los datos. Después de una extensa capacitación y ajustes, LLM puede exhibir nuevas funciones como traducción de idiomas, generación de resúmenes, respuesta a preguntas e incluso escritura creativa. Aunque al modelo no se le enseñan directamente ciertas tareas o habilidades, al aprender y entrenar con grandes cantidades de datos, el modelo puede demostrar capacidades más allá de las expectativas y funcionar extremadamente bien.

Entonces, ¿son inteligentes los grandes modelos de lenguaje?

¿Son inteligentes los modelos de lenguajes grandes?

Las calculadoras electrónicas existen desde hace más de sesenta años. Esta herramienta logró avances tecnológicos, pero nunca se consideró inteligente. ¿por qué?

La prueba de Turing es una forma sencilla de determinar si una máquina tiene inteligencia humana: si una máquina puede conversar con los humanos de una manera que los hace indistinguibles, entonces se considera que tiene inteligencia humana.

Una calculadora nunca ha pasado por una prueba de Turing [3] porque no se comunica utilizando el mismo lenguaje que los humanos, sólo el lenguaje matemático. Sin embargo, los grandes modelos de lenguaje generan lenguaje humano. Todo su proceso de formación gira en torno a la imitación del habla humana. Por lo tanto, no sorprende que pueda "hablar a los humanos de una manera que los haga indistinguibles".

Por lo tanto, utilizar el término "inteligente" para describir grandes modelos de lenguaje es un poco complicado, porque no existe un consenso claro sobre la verdadera definición de inteligencia. Una forma de saber si algo es inteligente es si puede hacer algo interesante, útil y con cierto nivel de complejidad o creatividad. Los modelos de lenguajes grandes ciertamente se ajustan a esta definición. Sin embargo, no estoy del todo de acuerdo con esta interpretación.

Defino la inteligencia como la capacidad de ampliar los límites del conocimiento.

Defino la inteligencia como la capacidad de ampliar las fronteras del conocimiento.

Al momento de escribir este artículo, las máquinas que funcionan prediciendo la siguiente ficha/palabra aún no pueden expandir los límites del conocimiento.

Sin embargo, se puede inferir y completar en función de los datos existentes. No puede comprender claramente la lógica detrás de las palabras ni comprender el conjunto de conocimientos existentes. No puede generar ideas innovadoras ni conocimientos profundos. Sólo puede proporcionar respuestas relativamente generales, pero no puede generar ideas innovadoras.

Ante la incapacidad de las máquinas para generar pensamiento innovador y conocimientos profundos, ¿qué impacto o implicaciones tiene para nosotros los humanos?

Entonces, ¿qué significa esto para nosotros los humanos?

Deberíamos pensar en los modelos de lenguaje grande (LLM) más como calculadoras de palabras. Nuestro proceso de pensamiento no debería depender completamente de grandes modelos, sino que debería considerarse una ayuda para nuestro pensamiento y expresión, más que un sustituto.

Al mismo tiempo, a medida que el número de parámetros en estos grandes modelos crece exponencialmente, es posible que nos sintamos cada vez más abrumados y fuera de nuestro alcance. Mi consejo al respecto es que siempre sientas curiosidad por ideas aparentemente no relacionadas. A veces nos encontramos con algunas ideas aparentemente no relacionadas o contradictorias, pero a través de nuestra observación, percepción, experiencia, aprendizaje y comunicación con otros, podemos encontrar que puede haber alguna conexión entre estas ideas, o que estas ideas pueden ser razonables. (Nota del traductor: Esta conexión puede provenir de nuestra observación, comprensión e interpretación de las cosas, o de nuevas ideas derivadas de la correlación de conocimientos y conceptos en diferentes campos. Debemos mantener la mente abierta, no sólo limitarnos a intuiciones superficiales, sino observar, percibir , experimentar, aprender y comunicarse con otros para descubrir significados y conexiones más profundas) No deberíamos contentarnos con quedarnos en el ámbito conocido, sino que deberíamos explorar activamente otros campos nuevos, ampliando constantemente nuestros límites cognitivos. También debemos buscar constantemente nuevos conocimientos o nuevas comprensiones de conocimientos ya adquiridos y combinarlos con los conocimientos existentes para crear nuevos conocimientos e ideas.

Si eres capaz de pensar y actuar como lo describo, entonces todas las formas de tecnología, ya sea una calculadora o un modelo de lenguaje grande, se convertirán en una herramienta que puedes aprovechar en lugar de una amenaza existencial de la que debes preocuparte.

FIN

Referencias

[3] https://en.wikipedia.org/wiki/Turing_test

Este artículo fue compilado por Baihai IDP con la autorización del autor original. Si necesita reimprimir la traducción, comuníquese con nosotros para obtener autorización.

Enlace original:

https://medium.com/the-modern-scientist/large-language-models-a-calculator-for-words-7ab4099d0cc9

RustDesk suspende los servicios nacionales debido a un fraude desenfrenado Apple lanza el chip M4 Taobao (taobao.com) reinicia el trabajo de optimización de la versión web Los estudiantes de secundaria crean su propio lenguaje de programación de código abierto como regalo de mayoría de edad - Comentarios críticos de los internautas: Confiando en Defense Yunfeng renunció a Alibaba y planea producir en el futuro el destino para programadores de juegos independientes Visual Studio Code 1.89 lanza Java 17. Es la versión Java LTS más utilizada y tiene una participación de mercado de 70. % y Windows 11 continúa disminuyendo. Open Source Daily | Google apoya a Hongmeng para que se haga cargo; Rabbit R1 de código abierto respalda la ansiedad y las ambiciones de Microsoft Haier Electric;