Autor: Yu Fan

fondo

El desarrollo de la inteligencia artificial (IA) ha introducido un nuevo paradigma en los descubrimientos científicos. Hoy en día, la IA ha comenzado a mejorar, acelerar y permitir nuestra comprensión de los fenómenos naturales en una amplia gama de escalas espaciales y temporales, promoviendo así el desarrollo de las ciencias naturales y dando origen al nuevo campo de investigación de AI4Science. Recientemente, un artículo de revisión "Inteligencia artificial para la ciencia en sistemas cuánticos, atómicos y continuos" escrito conjuntamente por más de 60 autores proporciona un resumen técnico en profundidad en los subcampos de los sistemas subatómicos, atómicos y continuos. Aquí extraemos la columna vertebral técnica de esta revisión y nos centramos en cómo construir un modelo equivariante bajo transformación de simetría.

1. Introducción

En 1929, el físico cuántico Paul Dirac señaló: "Las leyes físicas fundamentales necesarias para la teoría matemática de la mayor parte de la física y de toda la química ya nos son completamente conocidas, y la dificultad radica en el hecho de que la aplicación precisa de estas leyes conduce a complejo Esto es válido desde la ecuación de Schrödinger en física cuántica hasta la ecuación de Navier-Stokes en mecánica de fluidos. El aprendizaje profundo puede acelerar la solución de estas ecuaciones. Utilizando los resultados de los métodos de simulación tradicionales como datos de entrenamiento, una vez entrenados, estos modelos pueden hacer predicciones mucho más rápido que la simulación tradicional.

En otros campos, como la biología, es posible que los procesos biofísicos subyacentes no se comprendan completamente y, en última instancia, no se describan mediante ecuaciones matemáticas. En estos casos, los modelos de aprendizaje profundo se pueden entrenar utilizando datos generados experimentalmente, como los modelos de predicción de proteínas AlphaFold, RoseTTAFold, ESMFold y otras estructuras 3D obtenidas a través de experimentos, de modo que la precisión de las estructuras 3D de proteínas predichas computacionalmente pueda ser comparable a los resultados experimentales. .

1.1 Campos científicos

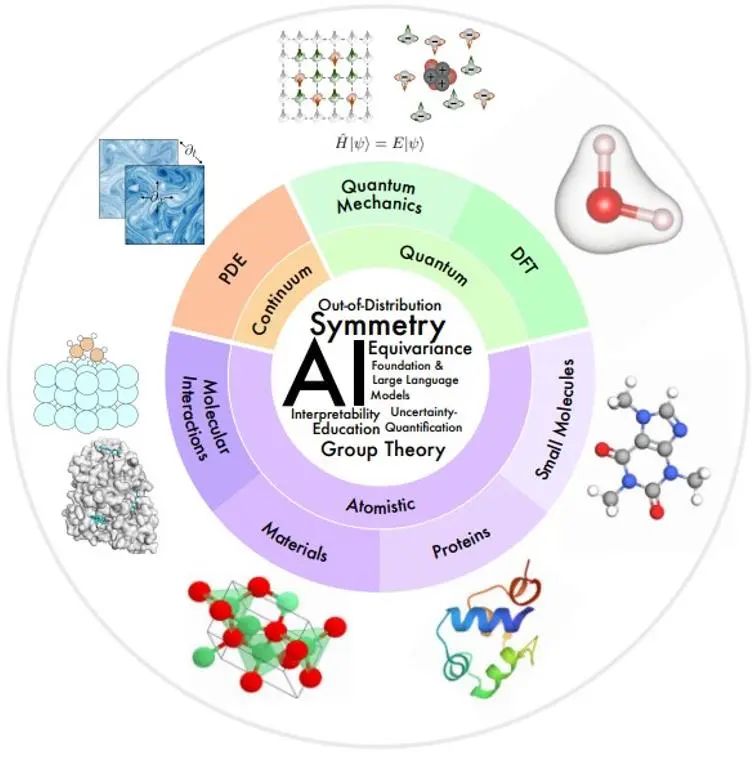

Las áreas científicas de interés en este artículo están organizadas como una descripción general en la figura siguiente, de acuerdo con las escalas espaciales y temporales del sistema físico que se está modelando.

Pequeña escala: la mecánica cuántica utiliza la función de onda para estudiar fenómenos físicos a la escala más pequeña. La ecuación de Schrödinger a la que obedece describe el proceso dinámico completo del sistema cuántico, pero conlleva una complejidad exponencial. La teoría funcional de la densidad (DFT) y los métodos de química cuántica ab initio son métodos de primeros principios ampliamente utilizados en la práctica para calcular la estructura electrónica y las propiedades físicas de moléculas y materiales, y pueden deducir aún más las propiedades electrónicas y mecánicas de moléculas y sólidos, ópticas. , propiedades magnéticas y catalíticas. Sin embargo, estos métodos siguen siendo costosos desde el punto de vista computacional, lo que limita su uso a sistemas pequeños (~1000 átomos). El modelo de IA puede ayudar a mejorar la velocidad y la precisión.

Mesoescala: las moléculas pequeñas, normalmente de decenas a cientos de átomos de tamaño, desempeñan importantes funciones reguladoras y de señalización en muchos procesos químicos y biológicos. Las proteínas son moléculas grandes compuestas por una o más cadenas de aminoácidos. La secuencia de aminoácidos determina la estructura de las proteínas, que a su vez determina su función. La investigación en ciencia de materiales estudia la relación entre el procesamiento, la estructura, las propiedades y los materiales. Las interacciones moleculares estudian cuántas funciones físicas y biológicas se realizan a través de interacciones moleculares, como las interacciones ligando-receptor y molécula-material. En estos campos, la IA ha logrado muchos avances en la caracterización y generación molecular, dinámica molecular, predicción y diseño de estructuras de proteínas, predicción de propiedades de materiales y generación de estructuras.

Gran escala: la mecánica continua utiliza ecuaciones diferenciales parciales para modelar procesos físicos que evolucionan en el tiempo y el espacio a nivel macroscópico, incluido el flujo de fluidos, la transferencia de calor, las ondas electromagnéticas, etc. Los métodos de IA brindan algunas soluciones a problemas como la mejora de la eficiencia computacional, la generalización y el análisis de múltiples resoluciones.

1.2 Campo de la tecnología de IA

Existe un conjunto común de desafíos técnicos en múltiples áreas de la IA científica.

**Simetría:** La simetría es una paranoia inductiva muy fuerte, por lo que un desafío clave para AI4Science es cómo integrar eficazmente la simetría en los modelos de IA.

**Interpretabilidad:**La interpretabilidad es crucial en AI4Science para comprender las leyes del mundo físico.

**Generalización y causalidad fuera de distribución (OOD): **Para evitar generar datos de entrenamiento para cada entorno diferente, es necesario identificar los factores causales que permiten la generalización de OOD.

**Modelos básicos y modelos de lenguaje grande:**Los modelos básicos en tareas de procesamiento del lenguaje natural se entrenan previamente bajo supervisión autosupervisada o generalizable para realizar diversas tareas posteriores de manera de pocos intentos o de cero intentos. El artículo ofrece una perspectiva sobre cómo este paradigma puede acelerar los descubrimientos de AI4Science.

**Cuantificación de la incertidumbre (UQ): **Estudia cómo garantizar una toma de decisiones sólida bajo la incertidumbre de los datos y del modelo.

**Educación:** Para facilitar el aprendizaje y la educación, este artículo proporciona una lista categorizada de recursos que el autor considera útiles y ofrece perspectivas sobre cómo la comunidad puede promover mejor la integración de la IA con la ciencia y la educación.

**2. ** Simetría, equivarianza y sus teorías.

En muchos problemas científicos, el objeto de interés suele estar ubicado en un espacio 3D, y cualquier representación matemática del objeto se basa en un sistema de coordenadas de referencia, lo que hace que dicha representación sea relativa al sistema de coordenadas. Sin embargo, los sistemas de coordenadas no existen en la naturaleza, por lo que se necesita una representación independiente del sistema de coordenadas. Por lo tanto, uno de los desafíos clave de AI4Science es cómo lograr invariancia o equivarianza bajo la transformación del sistema de coordenadas.

2.1 Descripción general

La simetría se refiere al hecho de que las propiedades de un fenómeno físico permanecen sin cambios bajo ciertas transformaciones, como las transformaciones de coordenadas. Si existen ciertas simetrías en el sistema, el objetivo de predicción es naturalmente invariante o equivariante según la transformación de simetría correspondiente. Por ejemplo, al predecir la energía de una molécula 3D, el valor predicho permanece sin cambios cuando la molécula 3D se traslada o gira. Una estrategia alternativa para lograr un aprendizaje consciente de la simetría es utilizar el aumento de datos en el aprendizaje supervisado, aplicando específicamente transformaciones de simetría aleatorias a los datos de entrada y las etiquetas para forzar al modelo a generar predicciones aproximadamente equivariantes. Pero esto tiene muchas desventajas:

1) Teniendo en cuenta los grados de libertad adicionales en la selección del sistema de coordenadas, el modelo requiere mayor capacidad para representar patrones que originalmente son simples en un sistema de coordenadas fijo;

2) Muchas transformaciones de simetría, como la traducción, pueden producir un número infinito de muestras equivariantes, lo que dificulta que una mejora limitada de los datos refleje completamente la simetría de los datos;

3) En algunos casos, es necesario construir un modelo muy profundo para lograr buenos resultados de predicción. Si cada capa del modelo no puede mantener la equivarianza, será difícil predecir el resultado general de la equivarianza;

4) En problemas científicos como el modelado molecular, es fundamental proporcionar una predicción que sea sólida ante transformaciones de simetría para que el aprendizaje automático pueda utilizarse de manera confiable.

Debido a las muchas deficiencias del aumento de datos, cada vez más investigaciones se centran en el diseño de modelos de aprendizaje automático que cumplan con los requisitos de simetría. Bajo la arquitectura de adaptación de simetría, el modelo puede centrarse en la tarea de predicción del objetivo de aprendizaje sin mejorar los datos.

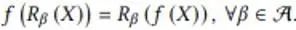

2.2 Equivariabilidad bajo transformación de simetría discreta

En esta sección, el autor proporciona un ejemplo de cómo mantener la equivarianza bajo transformaciones de simetría discretas en un modelo de IA. Este problema de ejemplo simula el mapeo de un campo de flujo escalar en un plano 2D de un momento al siguiente. Cuando el campo de flujo de entrada gira 90, 180 y 270 grados, el campo de flujo de salida también girará en consecuencia. Su expresión matemática es la siguiente:

donde f representa la función de mapeo del campo de flujo y R representa la transformación de rotación discreta. Cohen et al. propusieron redes neuronales convolucionales de grupos equivariantes (G-CNN) para resolver este problema. Su componente básico más simple es la convolución ascendente:

1) Primero gire el núcleo de convolución en todos los ángulos en la transformación simétrica y utilice el núcleo de convolución girado para realizar las operaciones de convolución correspondientes en la entrada para obtener múltiples capas de características y apilar estas capas de características en la dimensión de rotación α recién generada juntas; ) La agrupación se realiza en esta dimensión de rotación α, de modo que la salida resultante producirá una rotación correspondiente cuando se gire la entrada X.

Debido a la existencia de la operación de agrupación, aunque se mantienen las filas equivariantes, estas características no pueden transportar información de dirección. Por lo general, los G-CNN adoptan la estructura que se muestra en la siguiente figura:

Primero, se usa un núcleo de convolución rotacional para aumentar la dimensión de la entrada, luego se usa una capa de convolución de grupo de múltiples capas para hacer que cada capa de características cumpla con los requisitos de equivarianza rotacional mientras se mantiene la dimensión rotacional, y finalmente se usa una capa de agrupación. Se utiliza para eliminar la dimensión rotacional. Esto permite que la capa de entidades intermedia detecte mejor patrones en posiciones y orientaciones relativas de las entidades. El significado de la equivarianza de la capa de características intermedia es que la capa de características gira en consecuencia bajo la transformación de rotación, y el orden en la dimensión de rotación también gira y el diseño de rotación y rotación del núcleo de convolución en la capa de convolución del grupo utilizado también hace; la salida La capa de entidades puede mantener esta característica de equivarianza.

2.3-2.5 Construcción de modelo equivariante de transformación continua 3D

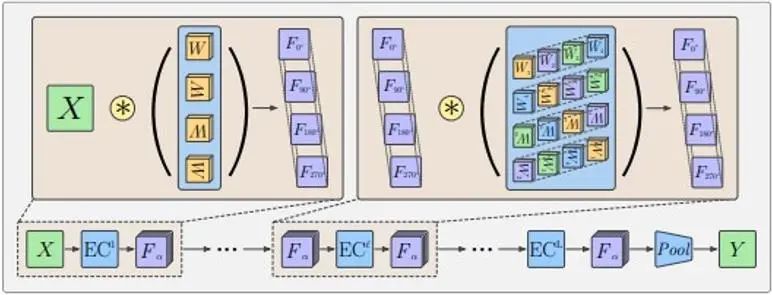

En muchos problemas científicos, nos centramos en las simetrías de rotación y traslación continua en el espacio 3D. Por ejemplo, cuando la estructura de las moléculas químicas gira y se traslada, el vector compuesto de atributos moleculares predichos sufrirá las transformaciones correspondientes. Estas transformaciones de rotación continua R y transformaciones de traslación t constituyen los elementos del grupo SE(3), y estas transformaciones se pueden expresar como matrices de transformación en el espacio vectorial. Las matrices de transformación en diferentes espacios vectoriales pueden ser diferentes, pero estos espacios vectoriales se pueden descomponer en espacios subvectoriales independientes. Existen las mismas reglas de transformación en cada subespacio, es decir, el vector obtenido al aplicar todos los elementos de transformación del grupo al vector del subespacio todavía está en el subespacio. Por lo tanto, los elementos de transformación del grupo pueden ser irreducibles en el. Subespacio. Representación de la matriz de transformación. Por ejemplo, los escalares como la energía total y la brecha de energía permanecen sin cambios bajo la acción de los elementos del grupo SE (3), y su matriz de transformación se expresa como D ^ 0 (R) = 1; Vectores 3D como campos de fuerza La rotación correspondiente ocurre bajo la acción y su matriz de transformación se expresa como D ^ 1 (R) = R en un espacio vectorial de dimensiones superiores, D ^ l (R) es 2l + 1; -matriz cuadrada dimensional. Estas matrices de transformación D^l(R) se denominan matriz Wigner-D de orden l correspondiente a la rotación R, y el espacio subvectorial correspondiente se convierte en el subespacio invariante irreducible de orden l del grupo SE(3), y el El vector que contiene se llama l Vector equivariante de orden. Bajo la transformación de traslación, estos vectores siempre permanecen sin cambios, porque las propiedades que nos interesan solo están relacionadas con posiciones relativas.

La forma habitual de asignar información geométrica 3D a características en el subespacio invariante del grupo SE(3) es utilizar el mapeo de funciones armónicas esféricas. La función armónica esférica Y^l asigna un vector tridimensional a un vector 2l+1 dimensional, que representa el coeficiente cuando el vector de entrada se descompone en 2l+1 funciones armónicas esféricas básicas. Como se muestra en la figura siguiente, dado que solo se utiliza un número limitado de bases, la función delta en la esfera representada por el vector tridimensional se ampliará hasta cierto punto.

Los armónicos esféricos tienen las siguientes propiedades equivariantes:

Entre ellos, D es la matriz Wigner-D de orden l mencionada anteriormente. Por lo tanto, una función espacial se descompone en una combinación de vectores equivariantes de diferentes órdenes bajo transformación de rotación.

Suponiendo que en una red neuronal gráfica con coordenadas atómicas como nodos, la característica del nodo h es un vector equivariante de orden l_1, entonces la siguiente transferencia y actualización de información gráfica puede garantizar que la h actualizada también mantenga la equivarianza:

El paso clave en esto es la operación del producto tensorial (TP) durante la transferencia de información. Entre ellos, vec significa vectorizar la matriz y el coeficiente C es una matriz con 2l_3+1 filas (2l_1+1) (2l_2+1) columnas.

La característica del nodo h es un vector en el subespacio invariante irreducible de orden l_1. La función armónica esférica Y de la dirección del borde r_ij es un vector en el subespacio invariante irreducible de orden l_2. El vector obtenido por el producto directo de estos dos vectores. el espacio es reducible y el coeficiente C es la relación de conversión de este espacio reducible a un subespacio invariante irreducible de orden l_3. Por ejemplo, el espacio producto directo de dos vectores tridimensionales es el siguiente:

La matriz de transformación de rotación del espacio del producto directo se puede convertir en la matriz diagonal de tres bloques en el medio de la figura anterior, lo que significa que este espacio se puede descomponer en tres subespacios invariantes irreducibles con dimensiones de 1, 3 y 5. es decir, 3⨂ Descomposición del espacio vectorial de 3=1⊕3⊕5. El coeficiente C es la matriz de transformación de este espacio de nueve dimensiones a estos espacios de 1, 3 y 5 dimensiones, respectivamente. En la fórmula anterior, l_1, l_2 y l_3 toman solo un valor y son características equivariantes de orden fijo. Las características en la red real pueden ser una combinación de estas características de orden diferente.

2.6-2.7 En los ejemplos anteriores, se utilizaron la teoría de grupos y las propiedades de las funciones armónicas esféricas. Los conocimientos básicos de la teoría de grupos y las funciones armónicas esféricas se presentan en detalle en estos dos capítulos del artículo.

2.8 El núcleo orientable constituye una forma general de red equivariante

Las capas de red equivariantes anteriores bajo transformaciones discretas y continuas se pueden describir en forma de una convolución variable unificada (CNN orientable):

Entre ellos, x e y son coordenadas espaciales, f_in (y) representa el vector de características de entrada en la coordenada y, f_out (x) representa el vector de características de salida en la coordenada x y K es la transformación del espacio de características de entrada a la característica de salida. espacio. La operación de convolución garantiza la equivarianza traslacional Para garantizar la equivarianza bajo otras transformaciones afines espaciales, el núcleo de convolución K también necesita satisfacer las siguientes restricciones de simetría:

Entre ellos, g es la transformación en el grupo de transformación espacial, y ρ_in y ρ_out representan la representación de la transformación en los espacios de características de entrada y salida (es decir, la matriz de transformación) respectivamente.

En este punto, la explicación teórica del artículo sobre la simetría y la equivarianza básicamente ha llegado a su fin, seguida de una descripción general separada de los múltiples campos enumerados en el Capítulo 1.

referencias

[1] Ren P, Rao C, Liu Y, et al. PhyCRNet: red convolucional recurrente basada en la física para resolver PDE espaciotemporales [J]. Métodos informáticos en ingeniería y mecánica aplicada, 2022, 389: 114399.

[2] https://www.sciencedirect.com/science/article/abs/pii/S0045782521006514?via%3Dihub

【1】Xuan Zhang, Limei Wang, Jacob Helwig, et al. 2023. Inteligencia artificial para la ciencia en sistemas cuánticos, atomísticos y continuos. arXiv: https://arxiv.org/abs/2307.08423

【2】 Taco Cohen y Max Welling. 2016. Redes convolucionales equivalentes de grupo. En Conferencia Internacional sobre Aprendizaje Automático. PMLR, 48:2990–2999.

【3】 Nathaniel Thomas, Tess Smidt, Steven Kearnes, et al. 2018. Redes de campo tensorial: redes neuronales equivalentes de rotación y traslación para nubes de puntos 3D. arXiv: https://arxiv.org/abs/1802.08219

Maurice Weiler, Mario Geiger, Max Welling y otros. 2018. CNN orientables en 3D: aprendizaje de características rotacionalmente equivalentes en datos volumétricos. En avances en sistemas de procesamiento de información neuronal

Un programador nacido en los años 90 desarrolló un software de portabilidad de vídeo y ganó más de 7 millones en menos de un año. ¡El final fue muy duro! Google confirmó despidos, relacionados con la "maldición de 35 años" de los codificadores chinos en los equipos Python Flutter Arc Browser para Windows 1.0 en 3 meses oficialmente GA La participación de mercado de Windows 10 alcanza el 70%, Windows 11 GitHub continúa disminuyendo. GitHub lanza la herramienta de desarrollo nativo de IA GitHub Copilot Workspace JAVA. es la única consulta de tipo fuerte que puede manejar OLTP + OLAP. Este es el mejor ORM. Nos encontramos demasiado tarde.