컴퓨터 비전을 위한 GPT 순간이 왔습니다!

최근 UC Berkeley의 컴퓨터 비전 '빅 3'가 힘을 합쳐 자연어가 없는 최초의 순수 비전 대형 모델(Large Vision Models)을 출시했으며, 순수 비전 모델 자체도 확장성(Scalability)이 있음을 처음으로 입증했습니다. .

또한 연구원들은 4200억 개 이상의 토큰으로 구성된 데이터 세트를 사용하여 모델이 상황별 학습, 통합 사진/비디오, 감독/비지도, 합성/실제, 2D/3D/4D 및 거의 모든 것을 통해 다운스트림 작업을 이해하고 수행할 수 있도록 했습니다. 모든 데이터 양식.

논문 주소: https://arxiv.org/abs/2312.00785

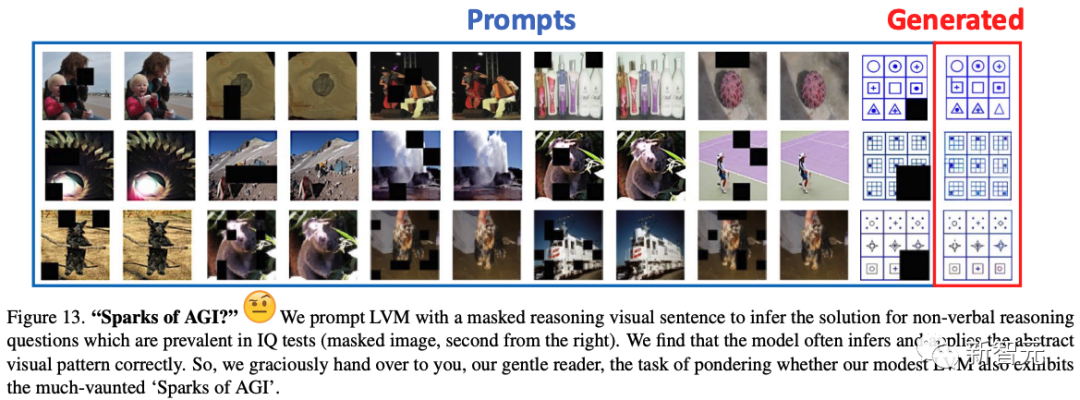

LVM이 비언어적 IQ 테스트(Raven's Progressive Matrices)에서 일반적인 비언어적 추론 질문을 수행하도록 요청받을 때 종종 올바른 추론을 할 수 있다는 점은 언급할 가치가 있습니다.

이에 대해 연구진은 LVM이 'AGI의 불꽃'을 보여줬다는 의미일 수도 있다고 놀라워했습니다!

순수 시각적 모델의 반격

이제 대규모 언어 모델이 폭발적으로 증가함에 따라 학계와 산업계 모두 시각적 모델의 규모를 확장하기 위해 "텍스트"를 사용하려고 시도하기 시작했습니다.

GPT4-V를 포함한 SOTA 모델은 비전과 텍스트를 결합하여 학습됩니다.

"Apple"을 예로 들면, 이 방법은 학습 중에 "사과 사진" 모델을 표시할 뿐만 아니라 "This is an apple"이라는 텍스트도 추가합니다.

그러나 보다 복잡한 이미지에 직면하게 되면 많은 양의 정보를 간과하기 쉽습니다.

예를 들어, "모나리자"를 어떻게 설명해야 할까요? 혹은 다양한 물건들로 가득 찬 주방 사진은 명확하게 설명하기 어렵습니다.

이에 UC Berkeley와 Johns Hopkins University의 연구진은 언어 데이터를 전혀 사용하지 않고 대규모 시각적 모델을 학습할 수 있는 새로운 '시각적 시퀀스' 모델링 방법(Large Vision Model)을 제안했습니다.

"시각적 시퀀스"라고 불리는 이 범용 형식은 픽셀 이상의 메타 지식이 필요하지 않고 원시 이미지와 비디오는 물론 의미론적 분할 및 깊이 재구성과 같은 주석이 달린 데이터 소스를 나타낼 수 있습니다.

이러한 광범위한 시각적 데이터(4,200억 개의 토큰 포함)가 시퀀스로 표시되면 모델을 훈련하여 다음 토큰을 예측하는 데 따른 교차 엔트로피 손실을 최소화할 수 있습니다.

결과 LVM 모델은 다양한 시각적 작업을 완료하기 위해 효과적으로 확장될 수 있을 뿐만 아니라 계산, 추론, 지능 테스트 수행과 같은 능력을 더욱 발전시킬 수 있습니다.

왼쪽: Alexei A Efros; 가운데: Trevor Darrell; 오른쪽: Jitendra Malik

간단히 말하면, 대규모 시각적 모델은 언어 데이터에 전혀 의존하지 않고 훈련용 이미지를 보는 것만으로도 복잡한 시각적 정보를 이해하고 처리할 수 있습니다.

순수 비전 모델의 확장된 어려움

이전에는 사전 훈련된 모델(예: ImageNet 사전 훈련된 AlexNet)을 사용하는 것의 가치가 2015년 초에 R-CNN에서 입증되었습니다.

그 이후로 이는 컴퓨터 비전의 표준 관행이 되었습니다.

사전 훈련에 사용할 수 있는 데이터의 양을 크게 늘리기 위한 방법으로 자기 지도 사전 훈련이 제안되었습니다.

불행하게도 이 접근 방식은 별로 성공적이지 못했습니다. 아마도 당시 CNN 기반 아키텍처에는 데이터를 흡수할 만큼 충분한 전력이 없었기 때문일 것입니다.

Transformer가 도입되면서 용량이 훨씬 높아졌기 때문에 연구자들은 자기주도 사전 훈련을 다시 검토하고 CNN 기반보다 나은 BEiT, MAE, SimMIM과 같은 Transformer 기반 마스크 이미지 재구성 방법을 찾았습니다. 훨씬 더 나은 성능을 발휘합니다.

그러나 그럼에도 불구하고 현재의 사전 훈련된 비전 전용 모델은 매우 큰 데이터 세트(예: LAION)로 확장할 때 여전히 어려움에 직면합니다.

"큰 시각적 모델"을 구축하는 방법

그렇다면 LVM(Large Vision Model)을 구축하려면 어떤 요소가 필요합니까?

동물의 세계는 시각 능력이 언어에 좌우되지 않는다고 말합니다. 많은 실험을 통해 인간이 아닌 영장류의 시각 세계가 인간의 시각 세계와 매우 유사하다는 사실이 밝혀졌습니다.

따라서 이 기사는 LLaVA와 같은 시각적 언어 모델에 대해 다른 방향으로 진행됩니다. 픽셀에만 의존하여 어디까지 갈 수 있습니까?

연구자들은 LVM에서 LLM의 두 가지 핵심 기능인 (1) 빅 데이터 환경에서의 확장성, (2) 힌트(상황별 학습)를 통한 유연한 작업 사양을 모방하려고 했습니다.

이 목표를 달성하려면 세 가지 주요 구성 요소를 식별해야 합니다.

데이터:연구원들은 놀라울 정도로 다양한 시각적 데이터를 활용하기를 희망합니다.

첫 번째는 주석이 없는 원본 이미지와 비디오입니다. 다음으로 연구원들은 의미론적 분할, 깊이 재구성, 키포인트, 3D 객체의 다중 보기 등 지난 수십 년 동안 생성된 다양한 주석이 달린 시각적 데이터 리소스를 활용할 계획입니다.

이를 위해 그들은 픽셀 자체 이상의 메타 지식을 요구하지 않고 이러한 다양한 주석을 표시하기 위해 "시각적 시퀀스"라는 공통 형식을 정의했습니다. 훈련 데이터 세트에는 총 1억 6,400만 개의 이미지/프레임이 포함되어 있습니다.

아키텍처:연구원들은 토큰 시퀀스로 표현되는 시각적 데이터에 대해 훈련된 30억 개의 매개변수가 있는 대규모 Transformer 아키텍처를 사용했습니다.

학습된 토크나이저를 통해 각 이미지는 256개의 벡터 양자화된 토큰을 포함하는 문자열에 매핑됩니다.

손실 함수:연구원들은 마스킹된 토큰 모델이 순차적 자동회귀 예측으로 발전한 자연어 처리 분야에서 영감을 얻었습니다.

이미지/비디오/주석이 달린 이미지를 시퀀스로 표현할 수 있으면 다음 토큰을 예측할 때 교차 엔트로피 손실을 최소화하도록 모델을 훈련할 수 있습니다.

이 미니멀한 디자인을 통해 연구자들은 몇 가지 새로운 발견을 했습니다.

- 모델 크기와 데이터 크기가 증가함에 따라 모델은 적절한 확장 동작을 나타냅니다.

- 테스트하는 동안 적절한 시각적 단서를 디자인하여 다양한 시각적 작업을 해결할 수 있습니다.

- 감독되지 않은 데이터의 양이 많기 때문에 다양한 표준 비전 작업에 대한 성능 향상이 매우 분명합니다.

- 모델은 분산되지 않은 데이터를 처리하고 새로운 작업을 수행할 때 일반적인 시각적 추론 기능을 보여 주지만 추가 조사가 필요합니다.

데이터

데이터! 데이터! 데이터! 점토가 없으면 벽돌을 만들 수 없어요!

--셜록 홈즈

사전 학습된 대규모 모델의 핵심은 대량의 데이터를 학습해야 한다는 것입니다.

언어 모델의 경우 크고 매우 다양한 데이터 세트를 쉽게 얻을 수 있습니다.

예를 들어, 인기 있는 CommonCrawl 저장소에는 전체 네트워크에서 검사된 2,500억 개의 웹 페이지가 포함되어 있으며 매우 다양하며 언어 번역 및 질문 답변과 같은 "자연스러운 프레젠테이션"을 포함합니다.

그러나 컴퓨터 비전 분야에서는 데이터 소스의 규모와 다양성이 동일해지려면 아직 갈 길이 멀다.

따라서 연구원 작업의 핵심 기여 중 하나는 이러한 통합 비전 데이터 세트(UVDv1)를 구축하는 것입니다.

이를 위해 연구자들은 (1) 레이블이 없는 이미지, (2) 시각적 주석이 있는 이미지, (3) 주석이 없는 비디오, (4) 시각적 주석이 있는 비디오, (5) 3D 합성 객체 등 다양한 시각적 데이터 소스를 활용했습니다.

그 중 라벨이 지정되지 않은 이미지는 전체 데이터의 80% 이상을 차지하여 시각적 세계의 대부분을 차지하고 필요한 다양성을 제공하지만 비용이 많이 드는 데이터 소스의 품질이 낮습니다.

주석이 달린 이미지의 배포는 더 제한되지만 일반적으로 품질은 더 높습니다.

비디오 데이터는 더 제한적이지만(일반적으로 인간 중심 활동) 시간 데이터의 귀중한 소스입니다.

3D 복합 개체는 렌더링 다양성이 가장 낮지만 3D 구조의 동작에 대한 귀중한 힌트를 제공할 수 있습니다.

가장 중요한 것은 UVDv1이 순수 시각적 데이터 세트이며 텍스트와 같은 비시각적 메타데이터를 포함하지 않는다는 것입니다.

전체적으로 UVDv1에는 16억 4천만 개의 이미지가 포함되어 있습니다.

LLM과의 또 다른 중요한 차이점은 언어 데이터가 모든 데이터에 대해 자연스럽고 통합된 1차원 구조(텍스트 스트림)를 갖는다는 것입니다.

불행하게도 소스마다 구조가 다른 시각적 데이터의 경우에는 그렇지 않습니다.

따라서 본 연구에서 연구자들은 시각적 데이터의 통합 단위로 시각적 시퀀스를 제안하며, 이를 통해 다양한 컬렉션 소스에서 확장 가능한 모델을 훈련할 수 있습니다.

시각적 시퀀스는 단순히 하나 이상의 이미지와 EOS(End of Sentence) 토큰이 포함된 시퀀스입니다.

그림 1은 다양한 데이터 소스가 시각적 시퀀스로 구분되는 방식을 보여줍니다.

컴퓨터 비전 GPT 순간! UC 버클리의 3대 거물이 최초의 순수 CV 대형 모델을 선보였고, 추론 결과 AGI 스파크가 나타났다 -51CTO.COM