Documento de aprendizaje profundo: TurboViT: Generación de transformadores de visión rápida mediante la búsqueda de arquitectura generativa y su implementación de PyTorch

TurboViT: Generación de transformadores de visión rápida mediante la búsqueda de arquitectura generativa

PDF: https://arxiv.org/pdf/2308.11421.pdf

Código PyTorch: https:// github.com/shanglianlm0525/CvPytorch

Código PyTorch: https://github.com/shanglianlm0525/PyTorch-Networks

1. Información general

Este artículo explora la generación de diseños arquitectónicos visuales rápidos de Transformer a través de la búsqueda de arquitectura generativa (GAS) para lograr un fuerte equilibrio entre precisión y eficiencia arquitectónica y computacional. Durante este proceso de búsqueda de arquitectura generativa, se creó TurboViT, un eficiente diseño de arquitectura de transformador visual jerárquico basado en patrones de diseño de atención de unidades de máscara y Q-pooling.

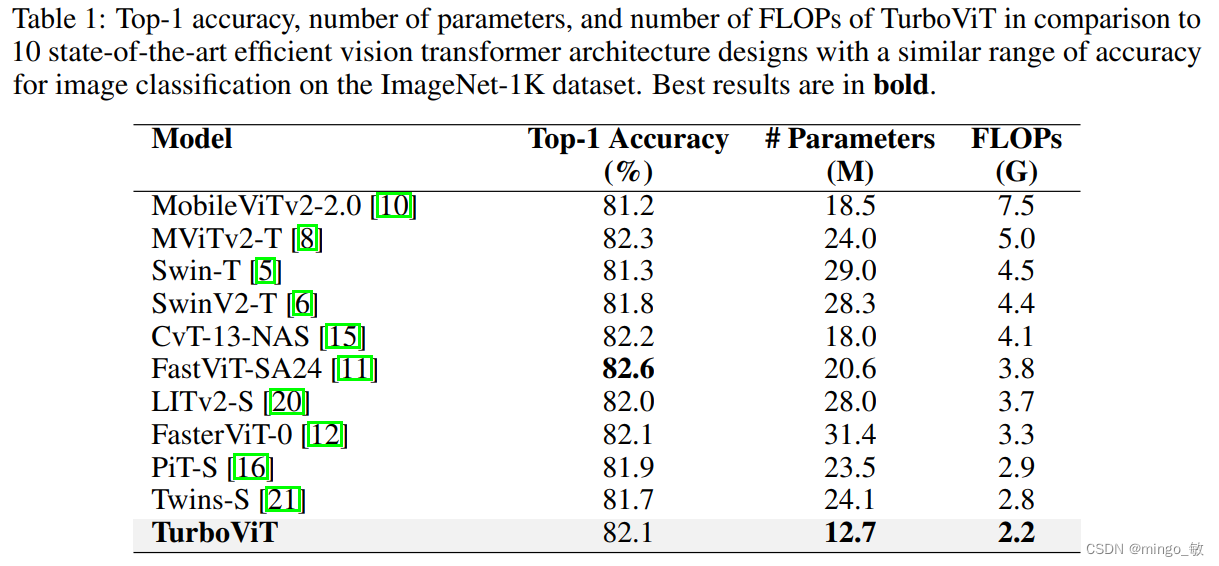

Los resultados experimentales muestran que el diseño de la arquitectura TurboViT es significativamente menor en términos de complejidad computacional arquitectónica (más de 2,47 veces más pequeño en tamaño en comparación con FasterViT-0, al tiempo que logra la misma precisión). En términos de complejidad computacional, TurboViT también es menor (los FLOP se redujeron en más de 3,4 veces y la precisión aumentó en más de un 0,9% en comparación con MobileViT2-2.0). En comparación con otros 10 diseños de arquitectura de red de transformadores visuales eficientes y de última generación en el conjunto de datos ImageNet-1K, TurboViT funciona bien dentro de un rango similar de precisión.

2 TurboViT

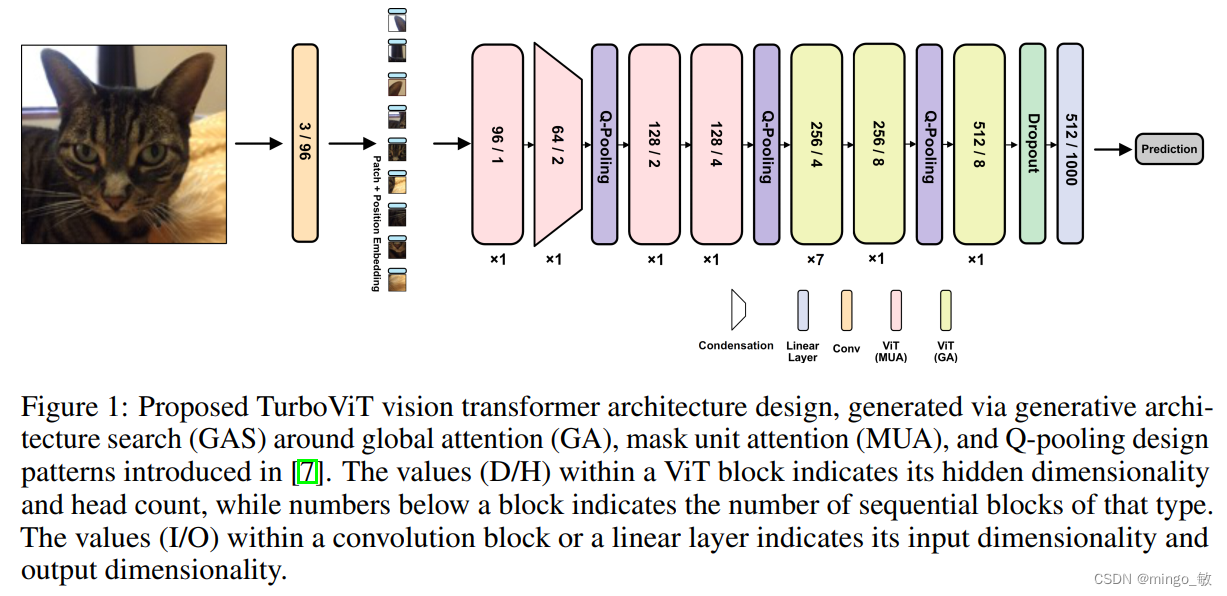

Este artículo utiliza la búsqueda de arquitectura generativa (GAS) para realizar la búsqueda de arquitectura TurboViT. La siguiente figura muestra el diseño de la arquitectura TurboViT generado mediante la búsqueda de arquitectura generativa. En general, se puede observar que el diseño arquitectónico es bastante simple y fluido, y consta principalmente de una serie de bloques ViT. En comparación con otros diseños de arquitectura de transformadores visuales eficientes de última generación (especialmente los diseños de arquitectura de transformadores convolucionales híbridos más complejos), TurboViT tiene una dimensión oculta y un número de cabezas relativamente bajos (especialmente en comparación con ViT), lo que ayuda a lograr mayores Eficiencia arquitectónica y computacional.

El diseño de la arquitectura TurboViT utiliza Q-pooling en tres ubicaciones diferentes para lograr eficiencia arquitectónica y computacional mediante la reducción de la dimensionalidad espacial. La mayoría de las capas se encuentran después del segundo Q-pooling. Al mismo tiempo, en el diseño de la arquitectura TurboViT, los primeros bloques ViT aprovecharon la atención local lograda a través de la atención de la unidad de máscara, mientras que los bloques ViT posteriores aprovecharon la atención global, logrando así ganancias significativas en la eficiencia computacional. cuando contribuye poco al rendimiento del modelo. Una observación particularmente interesante sobre el diseño de la arquitectura TurboViT es que se introduce un mecanismo de compresión de dimensionalidad oculta al comienzo del diseño de la arquitectura, lo que reduce en gran medida las dimensiones ocultas en el segundo bloque ViT, formando una incrustación altamente comprimida que es consistente con el primer ViT. bloque En comparación con un bloque ViT, las dimensiones ocultas aumentan gradualmente a medida que avanza en la arquitectura. Este mecanismo de compresión parece reducir en gran medida la complejidad computacional y al mismo tiempo permitir un alto grado de poder de representación en el diseño de la arquitectura general.

3 experimentos