Fuente |

Autor de Qubits | Cressey

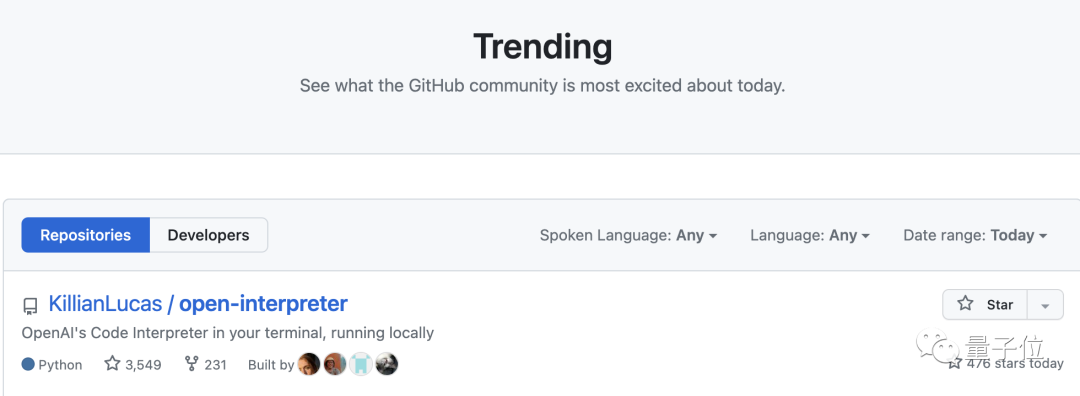

El intérprete de código de ChatGPT se puede ejecutar en su propia computadora. Un maestro acaba de lanzar una versión local del intérprete de código en GitHub, y rápidamente encabezó la lista caliente de GitHub con más de 3k estrellas . No sólo tiene todas las funciones que tenía originalmente GPT-4, sino que la clave es que también se puede conectar a Internet .

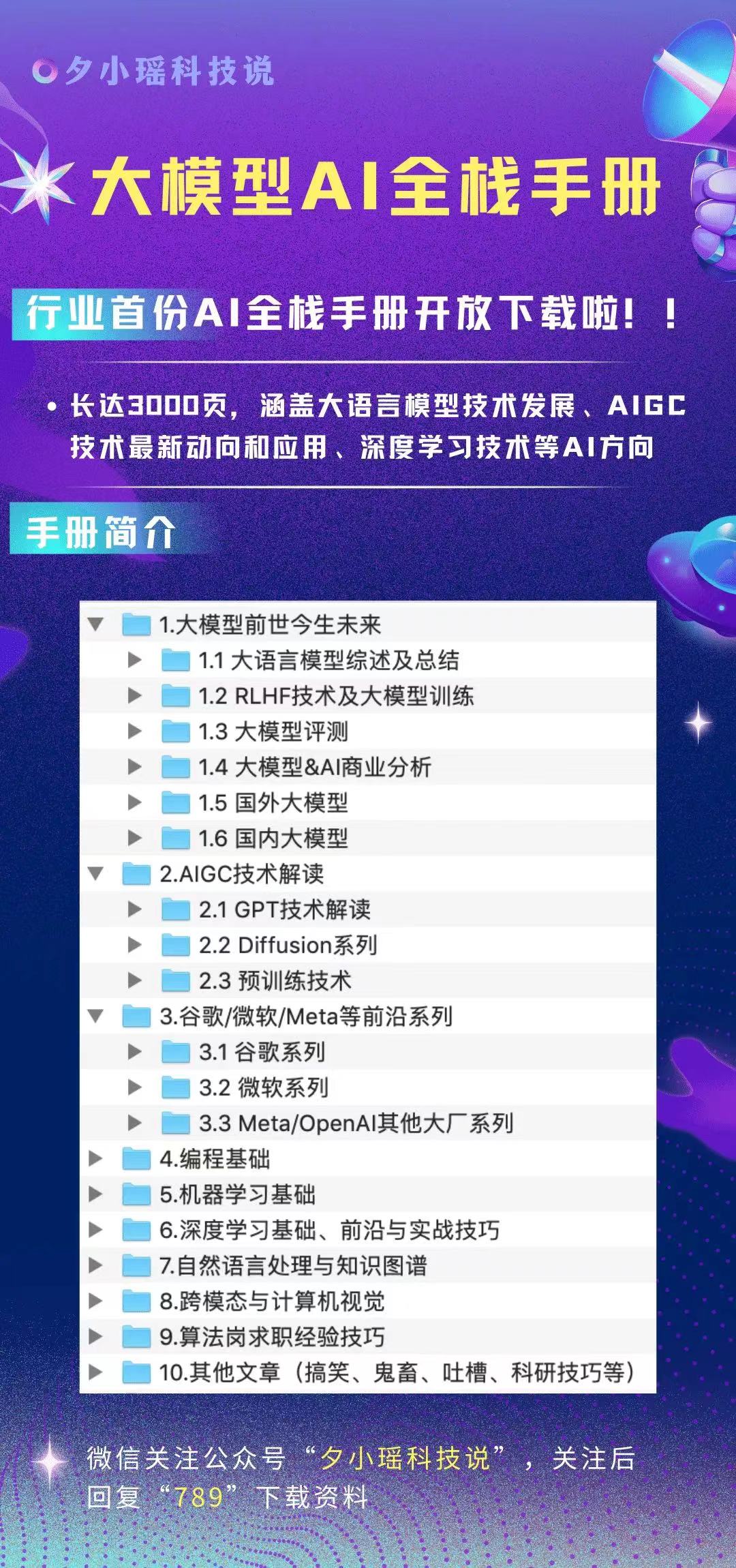

Portal de prueba de investigación de modelos grandes

Portal GPT-4 (sin muro, se puede probar directamente, si encuentra el punto de advertencia del navegador, simplemente avance/continue accediendo):

https://gpt4test.com

ChatGPT causó revuelo luego de que se conoció la noticia de que estaba "desconectado", y permaneció cerrado durante varios meses. La función de Internet ha estado en silencio durante los últimos meses, pero ahora hay una solución. Dado que el código se ejecuta localmente, resuelve muchos otros problemas de la versión web además de la red:

-

Sólo se pueden enviar 50 mensajes en 3 horas

-

Número limitado de módulos Python compatibles

-

Existe un límite en el tamaño del archivo que se puede procesar y no puede exceder los 100 MB.

-

Después de cerrar la ventana de sesión, los archivos generados anteriormente se eliminarán.

Si no hay API, también puede cambiar el modelo al código de código abierto LLaMa. Después del lanzamiento de este intérprete de código, algunos internautas pronto expresaron sus expectativas sobre una versión web:

¡Así que echemos un vistazo a cómo es este intérprete de código local!

Deje que GPT se "vuelva a conectar"

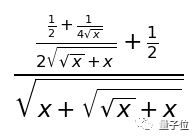

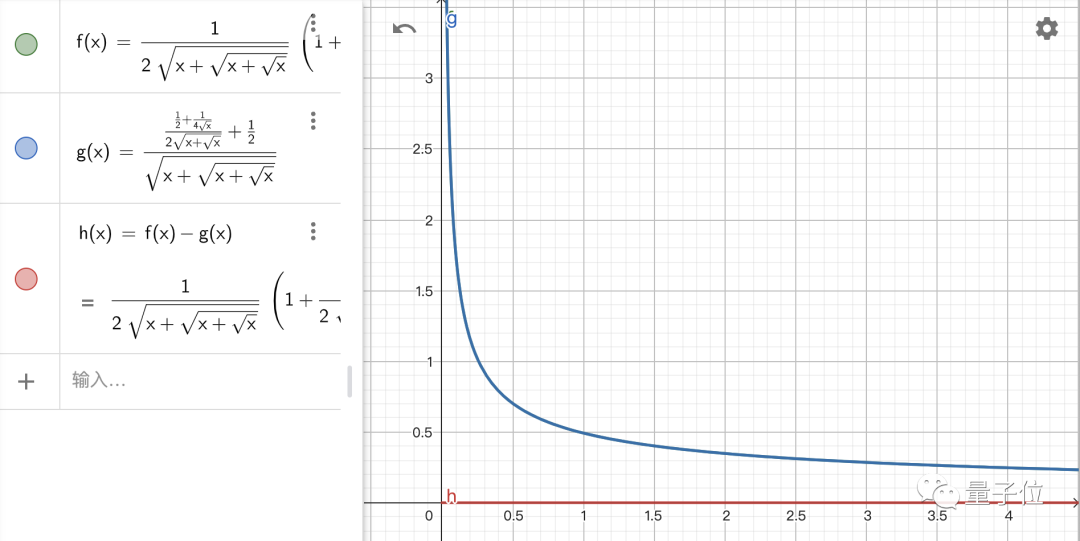

Ahora que se llama a la API de GPT-4, las funciones admitidas por GPT-4 se pueden usar de forma natural y, por supuesto, también se admite el chino. Las funciones de GPT en sí no se mostrarán en detalle aquí. Sin embargo, cabe mencionar que con el intérprete de código, el nivel matemático de GPT se ha mejorado varios grados. Así que aquí usamos un problema de derivación difícil para probarlo, el título es f(x)=√(x+√(x+√x)).

Emmm... Este resultado es un poco abstracto, pero debería haber un problema con la palabra indicadora, modifiquémoslo:

Luego vimos este resultado:

Esta fórmula parece diferente de la respuesta estándar, pero ¿es una cuestión de formato? Lo comprobamos:

¡El resultado es correcto! Luego viene el evento principal, veamos si la función de red de este intérprete de código es un truco: por ejemplo, queremos ver qué noticias han sucedido recientemente.

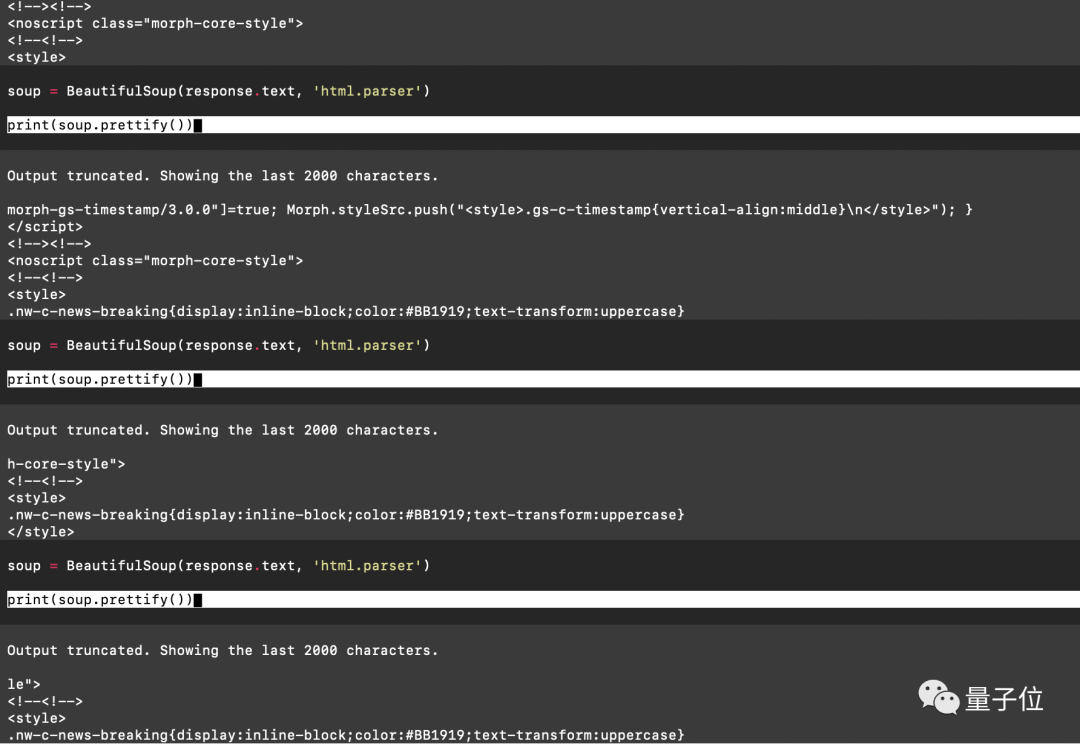

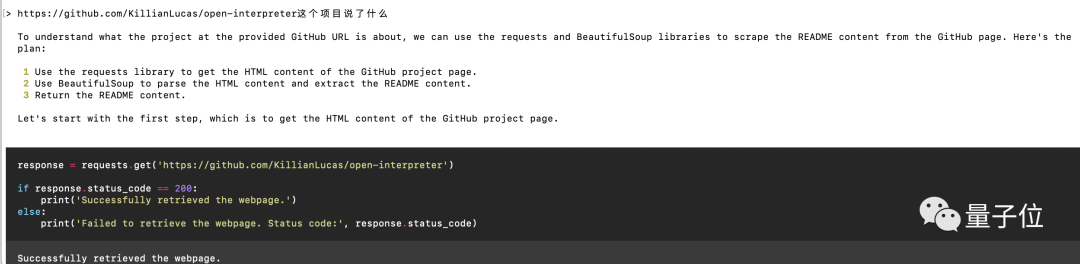

El programa primero verificará si los módulos necesarios están instalados; de lo contrario, se instalará automáticamente y luego comenzará a abrir la página web. Debo decir que leí la página web completa una vez, si no se está ejecutando localmente, mirar el código que se desplaza en la pantalla me tiembla un poco ...

Luego, el programa analizará en qué campo está almacenado el título de la noticia en el internauta y lo extraerá.

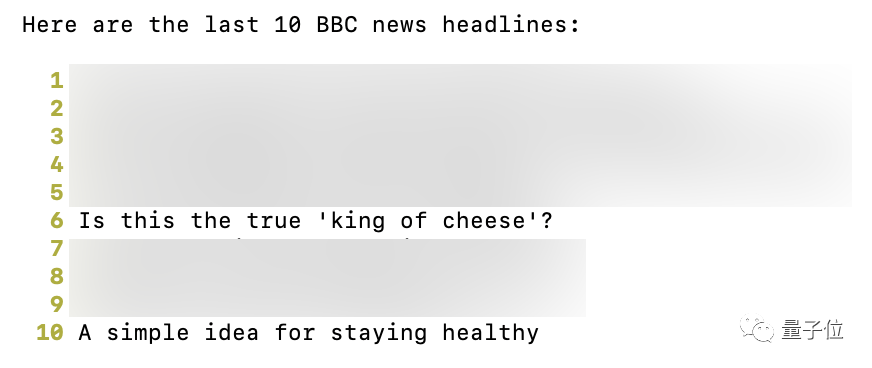

Afortunadamente, después de muchas vueltas, finalmente obtuvimos el resultado deseado:

Además de dejar que busque por sí solo, también puedes darle páginas web específicas para analizar:

Después de otra carga frenética, el intérprete de código reprodujo con éxito su autopresentación.

Luego se reproduce la versión online de ChatGPT, ¿hay alguna función más avanzada? ¡Por supuesto! Por ejemplo, queremos ajustar una configuración del sistema, pero no sabemos cómo hacerlo. Si usamos la versión web, lo más probable es que veamos una larga lista de instrucciones de texto, pero ahora podemos entregársela directamente al intérprete de código. En lugar de ofrecer un tutorial largo e incomprensible, ejecuta automáticamente el código y lo hace correctamente en un solo paso.

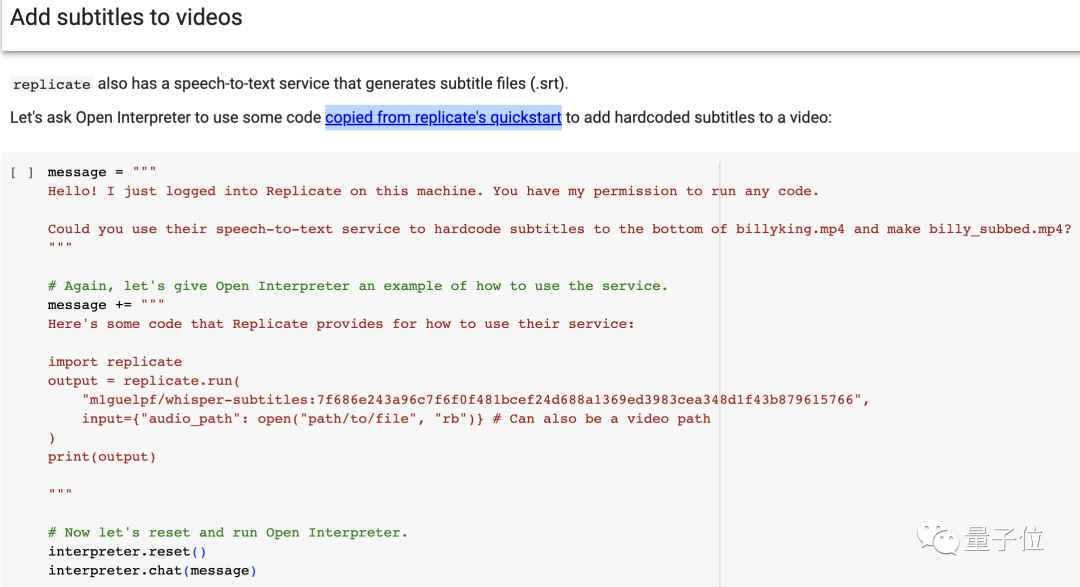

Además de permitir que GPT-4 genere código, también se pueden llamar a través de él algunas herramientas en el almacén de códigos. Por ejemplo, si desea agregar subtítulos a un video, puede llamar al módulo de reconocimiento de voz ya preparado al replicarlo. Como no hay material listo para usar a mano, aquí hay una demostración proporcionada por el desarrollador:

El proceso de ejecución del código se realiza localmente, por lo que no hay necesidad de preocuparse de que el tamaño del vídeo supere el límite. En definitiva, tras ejecutar bien, podemos ver que debajo del vídeo aparecen los subtítulos:

De manera similar, también puede usar esta función para generar y modificar documentos o imágenes, o llamar a ControlNet para generar animaciones a partir de una imagen estática... En teoría, siempre que el rendimiento sea suficiente, puede completar todo lo que Python puede hacer. Entonces, ¿cómo podemos experimentar este intérprete de código nativo?

metodo de instalacion

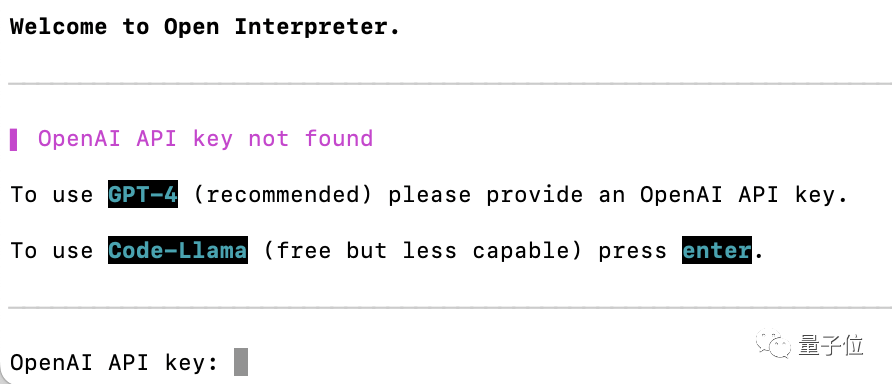

El autor publicó una nota de Colab en la página del proyecto GitHub (consulte el enlace al final del artículo), y los internautas calificados pueden ingresar y experimentarlo directamente. La instalación local también es muy simple (siempre que Python esté instalado), solo se necesita una línea de código "pip install open-interpreter". Después de la instalación, ingrese "intérprete" en la terminal para iniciarlo directamente.

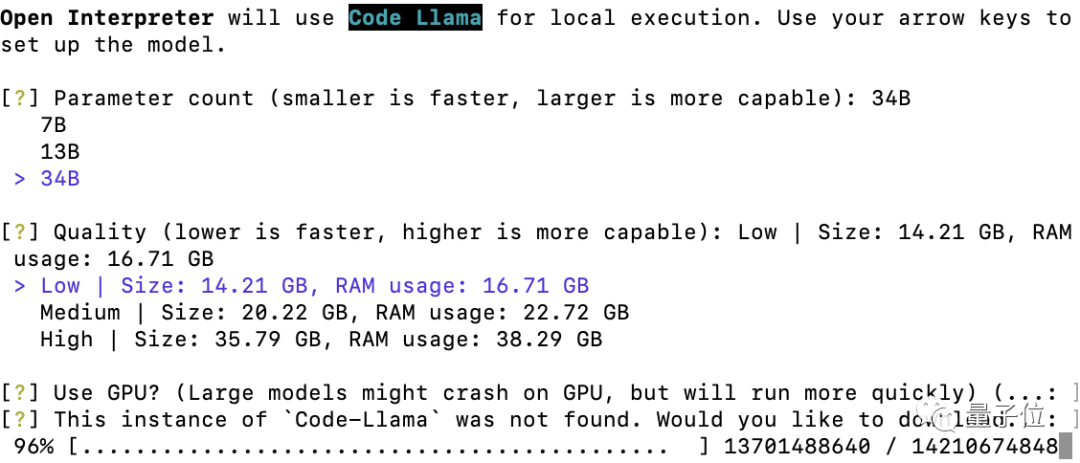

En este momento, el programa solicitará ingresar a la API de GPT-4. Si solo hay 3.5, use "intérprete --fast" al iniciar. Si no hay 3.5, puede presionar Enter directamente en este paso, o ingresar directamente "interpreter --local" al inicio para cambiar a Code-LLaMA. Incluye tres versiones de 7B, 13B y 34B. Cuanto más pequeña es la escala, más rápida es la velocidad y cuanto mayor es el resultado, más preciso. Si Code-LLaMA no está instalado, se puede instalar automáticamente siguiendo las instrucciones del programa.

Además, de forma predeterminada, se requiere confirmación antes de ejecutar el código después de que se genera. Si no desea confirmar cada vez, puede agregar "espacio-y" después del comando al inicio. Los comandos más utilizados se presentan aquí. Si desea conocer una jugabilidad más avanzada, puede consultar las notas de Colab del autor. Si te gusta, ¡date prisa y experiméntalo!

Página del proyecto GitHub:

https://github.com/KillianLucas/open-interpreter