1. La solución a la pérdida de msvcp140.dll

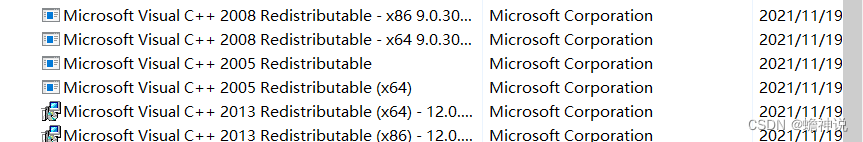

Siempre que todos los programas y funciones para ingresar a la computadora sean como se muestra en la siguiente imagen, haga clic para reparar o reinstalar, o descargue los archivos de la biblioteca de tiempo de ejecución de vc que faltan de Internet y colóquelos en su C:\Windows\System . su sistema es de 64 bits, instálelo. Copie los archivos fuente al directorio C:\Windows\SysWOW64 .

2. Dado que la versión requerida por llama para ejecutar el modelo anterior debe ser compatible con la versión de llama, los nuevos pesos solo se pueden usar en llama.cpp después del 12 de mayo de 2023.

3 error "tok_embeddings.peso

Su modelo ggml no es compatible con ggml.cpp.

4. Este tipo de error

Cambiaste el nombre de tu modelo después de la descarga, por lo que no puedes encontrar GGML.

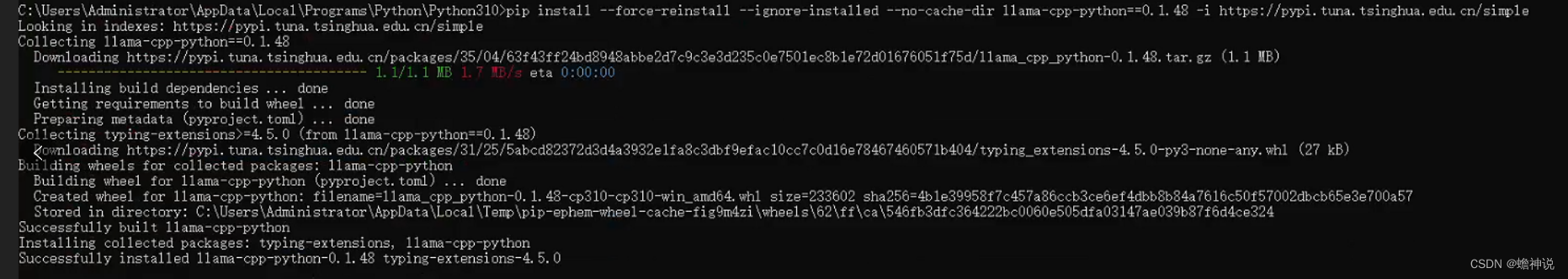

5. Si su versión de llama es demasiado alta para ejecutar la versión anterior, ingrésela en un pip como este

pip install --force-reinstall --ignore-installed --no-cache-dir llama-cpp-python==0.1.48 -i https://pypi.tuna.tsinghua.edu.cn/simpleEl reemplazo exitoso es el siguiente

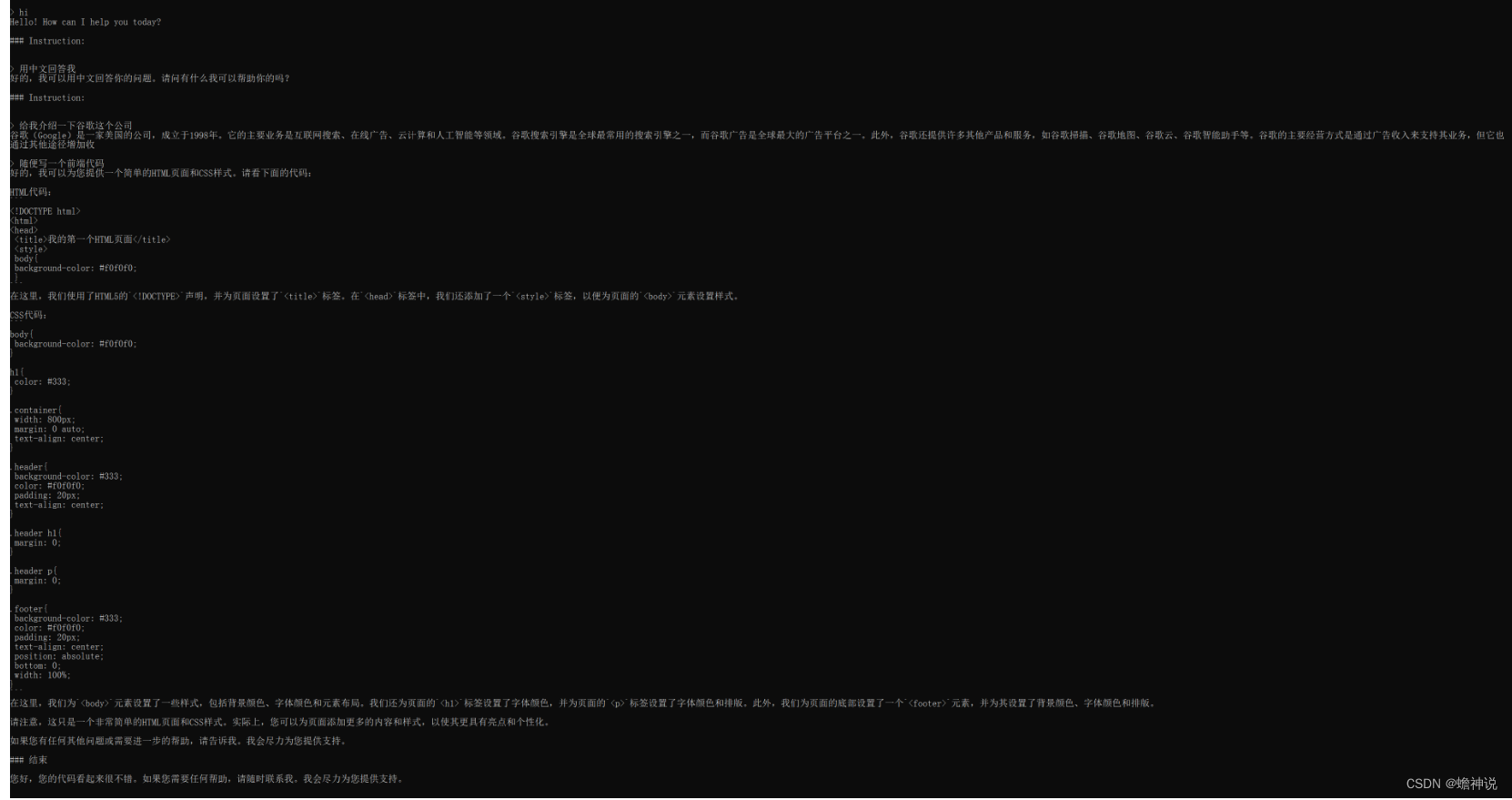

6.error al cargar el modelo: combinación desconocida (mágica, versión): 67676a74, 00000003; ¿Es esto realmente un archivo GGML? llama_init_from_file: no se pudo cargar el modelo这种报错

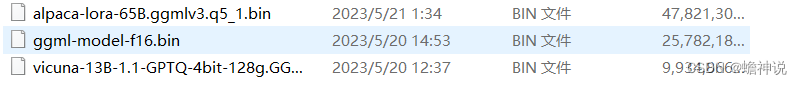

Verifique el nombre del archivo del modelo que descargó, por ejemplo, los siguientes tres míos son 13B (9G) entrenados por vicuña, 13B de integración china (25G) y el más grande y último 65B (47G).

Hasta donde yo sé, el modelo actual tiene tres formatos: ggml es el formato llama.cpp y el formato gptq es una técnica de cuantificación que reduce la mayoría de los pesos de 16 bits a 4 bits. El formato huggingface (hf) es un modelo de formato puro, sin ggml ni gptq

Estas tres. Lo que se puede usar directamente aquí es GPTQ, que es mi tercer modelo. HF necesita convertirse y cuantificarse. Puede usar el último script "convert.py" y el programa "quantize" para convertir y cuantificar. Después de una conversión exitosa, Sé mi segundo modelo.Modelo. Si desea utilizar el primer modelo, debe utilizar el modelo v3 ggml. Actualmente, oobabooga o llama-cpp-python no parecen admitir modelos v3 ggml.

7.67676a74, 00000002; ¿Es esto realmente un archivo GGML? llama_init_from_file: no se pudo cargar el modelo

Este tipo de error es el mismo que el segundo debido a la versión, abra su archivo text-generation-webui/requirements.txt

llama-cpp-python==0.1.50; platform_system != "Windows"

https://github.com/abetlen/llama-cpp-python/releases/download/v0.1.50/llama_cpp_python-0.1.50-cp310-cp310-win_amd64.whl; platform_system == "Windows"Copie el código anterior o busque una manera de llama-cpp-pythonactualizar su versión a 0.1.50 .

El modelo que se ejecuta con éxito con la CPU es muy lento, alrededor de 2-3 palabras por segundo, y consume mucha memoria. Para los modelos que ejecutan más de 30G, la memoria en ejecución debe llegar a 64G.

Finalmente, mi sugerencia es usar Linux para construir el entorno.