En la noche del 22 de julio, el equipo creativo y los usuarios de Dify organizaron temporalmente un evento de comunicación en línea de alta calidad. La reunión de intercambio se centró principalmente en la planificación de productos de Dify, la exploración y comprensión de LLM por parte de los usuarios, y los problemas y confusiones que encuentran los usuarios en el proceso de uso de Dify. Creo que puede proporcionar buenas ideas y referencias para todos los amigos que crean aplicaciones basadas en LLM o Dify. Amigos que se lo perdieron, miren aquí. Hemos ordenado y resumido preguntas relevantes y puntos de discusión para su referencia de lectura (la sección de Preguntas es para preguntas planteadas por diferentes usuarios, y la sección de Respuestas es para la comprensión y las respuestas del equipo de Dify) .

Acerca de la planificación de productos de Dify

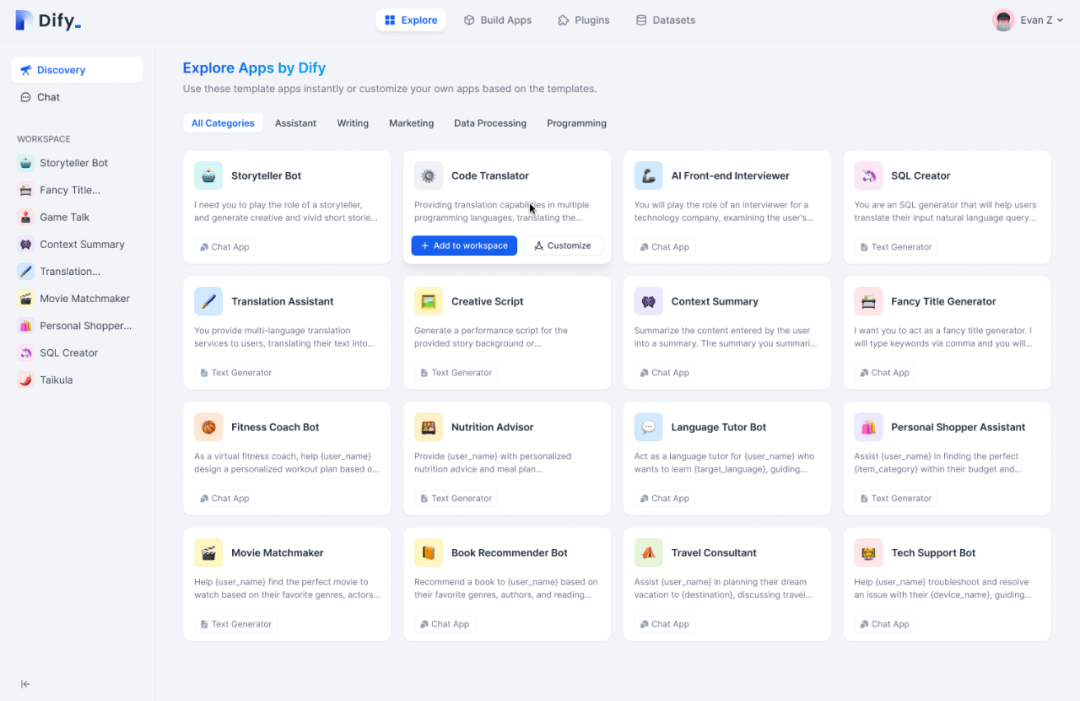

Muchos desarrolladores y amigos han preocupado y querido los productos de Dify desde que se lanzaron. Se han creado más de 30 000 aplicaciones (solo en la versión en la nube) en la plataforma. Esperamos continuar satisfaciendo las necesidades de los escenarios de aplicaciones de los usuarios en términos de producto. Capacidades, para que todos puedan realmente aplicar la aplicación al negocio y al trabajo reales. Zhang Luyu, fundador de Dify, primero sincronizó los planes de productos clave recientes de Dify que más preocupan a todos:

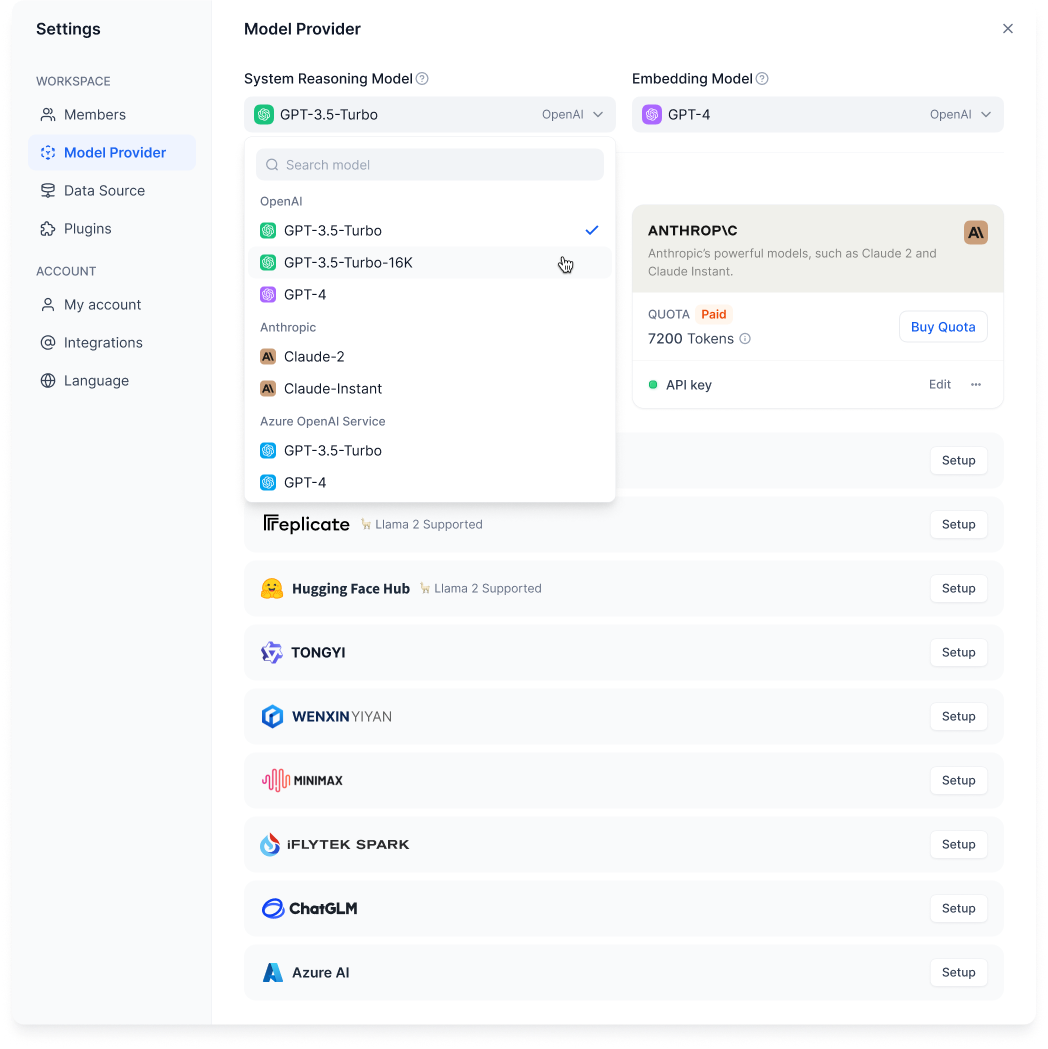

Acerca de la compatibilidad con modelos

En la actualidad, los modelos compatibles son principalmente modelos de la serie OpenAI y la serie Claude.Después de las pruebas, tienen el mejor efecto relativo, por lo que son compatibles primero. Otros modelos aún no están listos para la producción o aún no son compatibles debido al cumplimiento y otros problemas. Teniendo en cuenta el interés de los usuarios en diferentes modelos, agregaremos un lote de nuevos modelos la próxima semana, incluidos modelos comerciales como Ali Tongyi, Wenxin Yiyan, Xunfei Xinghuo Cognition, etc., y modelos de código abierto como LlaMa, etc. Por supuesto, Dify también Haremos todo lo posible para ser compatibles con los modelos creados por los usuarios. Puede alojarlos en Hugging Face Hub y Dify admitirá el acceso en el futuro.

Planificación ecológica enchufable

Hay muchas soluciones de complementos actualmente en el mercado, y Dify generalmente admite complementos nativos de su propia plataforma y complementos externos del estándar OpenAI. Ahora, los complementos populares, como los complementos de red, incluidos los relacionados con la revisión del cumplimiento de la seguridad doméstica, también se incluirán como nuestros complementos nativos. La funcionalidad del conjunto de datos existente también tiene la oportunidad de ser un complemento nativo. Lanzaremos un modo de chat de agente general recientemente, que se usa para ajustar los complementos y lograr la colaboración dentro del equipo, y la función de orquestación se puede ajustar más adelante.

P1: ¿Ha considerado crear un mercado de aplicaciones que permita a los usuarios publicar o votar públicamente por las aplicaciones de otras personas?

R1: El posicionamiento de Dify es que el proveedor de servicios de pila de tecnología no se enfoca en el mercado de aplicaciones. Su misión es reducir el umbral de desarrollo de aplicaciones y mejorar la eficiencia del desarrollo, que es significativamente diferente del mercado de aplicaciones en general. Hemos visto muchos mercados de aplicaciones y navegación de aplicaciones en China, pero el riesgo de cumplimiento es alto. En la actualidad, el mercado de aplicaciones no ha alcanzado la etapa de madurez. Dify está dispuesto a compartir algunas buenas aplicaciones y plantillas.

P2: ¿Cómo es el próximo Agente?

A2: Se implementará en varias etapas:

La primera etapa es la versión de la herramienta, que es principalmente para invocar herramientas, que se pueden buscar en línea, llamar a la API, etc., y una versión de demostración se lanzará primero entre las aplicaciones generales de Workspace.

El plan de la segunda fase es un agente autónomo, similar a AutoGPT. Ya lo estudiamos en febrero. Es muy interesante en concepto, pero debido a que no se puede poner en producción, el consumo de recursos de cálculo es muy grande y el efecto real de la aplicación aún debe verificarse, por lo que no se le dará prioridad por el momento.

P3: No es fácil para nosotros solicitar la API del modelo LLM como individuo ¿Puede Dify proporcionar servicios de compra de cuotas?

R3: Se espera que Dify proporcione el canal de compra de OpenAI y la cuota de uso del modelo Claude en la interfaz del producto. Después de que el usuario compre, el sistema lo cargará automáticamente. La segunda situación es que algunos desarrolladores ya han comprado claves de agente a través de varios canales También apoyaremos esto.

Comunicación de problemas de implementación de Dify.AI/LLM

En la reunión de intercambio, el equipo de Dify también llevó a cabo debates e intercambios en profundidad sobre los problemas encontrados por los usuarios en el proceso de uso de las aplicaciones de aterrizaje de Dify en los últimos meses. Para facilitar la lectura, el siguiente contenido está organizado en forma de preguntas y respuestas. .

P1: ¿Cuándo se pueden realizar ajustes manuales más precisos en la función de segmentación del conjunto de datos? ¿Se puede implementar un límite de división personalizado?

R1: La planificación de la segmentación de Dify requiere ajustes relativamente grandes. La intención original de Dify es muy importante. El ajuste de la etapa técnica del modelo existente puede no ser algo que la mayoría de los usuarios puedan usar directamente, por lo que la idea de Dify es poner la incrustación y los conjuntos de datos como la máxima prioridad. desde el principio Sí, también es una función que todos usan más. Debido a que somos un producto de desarrollador, o un producto toB, requerimos que el contenido sea controlable y preciso. En el futuro, se conectarán una gran cantidad de PDF y varias fuentes de datos de páginas web, lo que inevitablemente requerirá ajustes muy precisos en la segmentación. Recientemente, hemos estado optimizando (por ejemplo, algoritmos como bases de datos). Pero la pregunta más apremiante para todos es que si tiene un documento de 100 000 palabras, el sistema tiene una estrategia para ayudarlo a limpiarlo previamente y dividirlo en 1000 segmentos, que pueden ser campos de 300 a 500 palabras, pero esto Obviamente, todavía no puede lograr el efecto que todos quieren que responda la IA. Con respecto a este problema, actualmente estamos trabajando en dos soluciones:

-

Dify pronto admitirá la estructura de datos tipo QA, es decir, si el usuario sube el texto, se dividirá en 1000 segmentos, y el sistema lo ayudará a generar 10 o más pares de QA en el futuro. se genera un par, básicamente puede cubrir las preguntas que los usuarios harán, y cuando el modelo grande está incrustando y emparejando, puede usar las preguntas para emparejar las preguntas. Este efecto debe ser mejor. Al mismo tiempo, el control de calidad de un segmento puede admitir la edición manual para nosotros, lo que puede aliviar algunos problemas.

-

Rediseñaremos la interfaz de segmentación que ve ahora. Los usuarios pueden ver el efecto de texto completo en esta interfaz. Por ejemplo, después de cargar un PDF, la operación de cruce del mouse logrará una segmentación manual relativamente fina. Si no está satisfecho con la sección , puede ajustarlo manualmente.

P2: ¿Por qué la generación de texto a veces supera el límite y la respuesta no coincide con las palabras del mensaje? (Por ejemplo, se establece un mensaje: se requiere que solo responda preguntas relacionadas con un determinado aspecto, pero no responda preguntas relacionadas con otro aspecto. Pero cuando habla con AI, puede extraviarse). ¿Hay algún plan en la dirección de la memoria a largo plazo?

R2: Todos los que usan cualquier modelo grande, incluido ChatGPT, pueden tener ese problema. Das una instrucción, que llamamos la palabra pre-prompt. Respondió muy bien a la pregunta anterior, pero luego perdió el control después de andar por las ramas. . Esto se debe a los principios técnicos de los grandes modelos de lenguaje. Estos modelos emplean la generación de texto y sus respuestas tienden a favorecer el último texto visto. Por lo tanto, incluso si se establece el límite de palabras de solicitud, el modelo se verá afectado por la entrada anterior al generar la respuesta, por lo que la respuesta puede desviarse del límite de palabras de solicitud. Actualmente, la mayoría de los modelos principales no abordan este problema por completo, y puede ser necesario que los proveedores ajusten el peso de las palabras de aviso a nivel del sistema del modelo o realicen un ajuste fino del modelo para mejorar esta limitación. En el futuro, Dify adoptará el método de verificación y restablecimiento, lo que permitirá que la máquina resuma la conversación anterior en un mensaje simplificado como una memoria, luego agregue palabras de mensaje del sistema y luego regenere la respuesta, para mejorar este problema. Pero habrá muchos problemas de ingeniería detallada. Hacemos el producto Dify y esperamos reducir este trabajo de ingeniería tanto como sea posible en el proceso de creación de aplicaciones, porque las soluciones óptimas y las mejores prácticas aquí se obtienen a través de experimentos repetidos. resultado, no significa que tengamos una rutina fija ahora, porque cada modelo será diferente.

Hay varios tipos de memoria a largo plazo según el ciclo de vida, la primera es en el ciclo de vida de todo el diálogo, la segunda es fija para el usuario y la tercera es que podemos agregar algunas condiciones de filtrado al conjunto de datos. su conjunto de datos es muy grande y puede buscar datos de acuerdo con la clasificación de ID del usuario o productos comerciales suscritos, similar a la declaración where en círculo.

P3: ¿Por qué Dify solo tiene una entrada de solicitud previa, a diferencia de GPT, que tiene tres interfaces: mensaje del sistema, mensaje del usuario y asistente? ¿Por qué hago la misma pregunta en otras herramientas (como ChatGPT) y Dify, pero el resultado en ambos lados es diferente?

R3: La primera etapa de Dify es reducir el umbral y hacer que sea fácil de usar para todos, por lo que simplificamos muchos conceptos de ingeniería. Por ejemplo, para la cuestión de las palabras del sistema o del usuario, hemos probado el efecto por adelantado en ambos lados y escribimos la mejor manera después de la prueba, por lo que básicamente solo necesita escribir un mensaje. Pero con la subsiguiente subdivisión del modelo, el mismo aviso puede tener diferentes situaciones. Por lo tanto, la página de diseño de solicitud también repetirá la versión avanzada de acuerdo con la situación compleja en el futuro, para que los usuarios puedan ver el enlace de nuestra solicitud completa.

Existen dos razones posibles para los diferentes resultados de salida: La configuración del primer parámetro del modelo es incorrecta. La segunda razón es que, en algunos escenarios, Dify dividirá las solicitudes y los conjuntos de datos en solicitudes más complejas, por lo que no es la misma solicitud que probó originalmente con otras herramientas. El propósito de esto es utilizar el conjunto de datos para hacer que la respuesta esté más en línea con las necesidades reales.

P4: Hay varios aspectos en una conversación, el primero es el mensaje, el segundo es el conjunto de datos, el tercero es el contexto y el cuarto son las preguntas más específicas del usuario. Luego, en la respuesta real de AI, el peso de estos aspectos ¿Se puede establecer?

R4: De hecho, hay muchas cosas en la orquestación de aplicaciones que ve ahora. Tenemos una relación de distribución llamada token para este montón de cosas, y el peso que mencionaste se llama relación de distribución de token en nuestro caso. Bajo un token con un modelo limitado, qué parte cuenta más y qué parte menos, si desea ajustar este peso, puede consultarlo a través del código fuente público. Podemos proporcionar esta capacidad de ajustar la asignación de entrada en el futuro para mejorar la flexibilidad Actualmente, es un paquete relativamente simple.

P5: En la aplicación de escenario de servicio al cliente de IA, ¿cómo realizar el proceso comercial de obtener activamente información del usuario en el diálogo (como guiar a los usuarios para que proporcionen información como el número de pedido y el número de teléfono móvil) sin extraviarse?

A5: Por un lado, esto sigue siendo un problema con el modelo. Sería mejor reemplazarlo con GPT4. Por otro lado, las restricciones se pueden escribir más claramente y la temperatura de los parámetros se puede ajustar a la mínimo AI básicamente responderá de acuerdo con el conjunto de datos, de lo contrario, será más abierto Algunos. Después del lanzamiento del agente de Dify, habrá una función de "diálogo asistido por humanos". Si AI considera que el contexto proporcionado por el usuario está incompleto, devolverá activamente la pregunta al responderla y permitirá que el usuario continúe agregando . En este proceso, la IA, a su vez, solicita a los usuarios que complementen la información. Los procesos comerciales más complejos permiten a los usuarios proporcionar información en formularios y otros lugares, y luego llamar a la API para obtener la información y luego generar una respuesta.

P6: Lo que Dify analiza es PDF, TXT, CSV y otros datos de tipo documento. Si hay algunas situaciones que incluyen tanto documentos como datos relacionales, como informes financieros e informes trimestrales publicados por empresas que cotizan en bolsa, quiero usar estos datos como un corpus, y luego desarrollar ¿Puede una aplicación en el campo financiero soportar documentos y datos relacionales al mismo tiempo?

R6: Dify consideró el método de procesamiento de datos de formulario en el diseño inicial, pero descubrió que el efecto no era bueno, porque había información redundante en este método, lo que resultó en una tasa de aciertos más baja. Para resolver este problema, consideramos preprocesar datos estructurados como Excel antes de golpear para mejorar el efecto. En el futuro, podemos cooperar con una empresa que es buena en el trabajo relacionado con bases de datos. Planeamos cooperar con ellos para desarrollar un complemento de Dify para resolver problemas de datos mediante el procesamiento de datos estructurados.

En cuanto al uso de la API para llamar a la base de datos, también hemos diseñado un lenguaje antes, que se usa especialmente para hacer llamadas API cortas y precisas y mejoras para LLM. Puede entenderlo como una versión comprimida de Swagger, solo alrededor del 50% de la longitud del carácter original. La esencia de las llamadas a la API es agregar parámetros de publicación y comentarios de campo a la URL. No hay una diferencia esencial con la escritura de código, pero la sintaxis es diferente. Si la capacidad de su modelo no es muy fuerte, teóricamente no habrá una diferencia esencial en el efecto, por lo que si puede conectarse directamente a la base de datos a través de Dify, el efecto será mejor que llamar a la API. Debido a que hay algunos problemas al llamar a la API, por ejemplo, los complementos que usa la IA ahora ocupan muchos tokens, lo que genera resultados de retorno limitados y lentos.

P7: ¿Cómo realizar un producto de maestro virtual de IA que integre juegos y pueda interactuar? (El plan es implementar un maestro virtual de IA que pueda interactuar con los estudiantes en el texto y hacer sugerencias de aprendizaje. El objetivo de seguimiento es enriquecer la forma de interacción, como apoyar la interacción con imágenes, dar retroalimentación basada en trabajos y diseñar planes de aprendizaje En última instancia, quiero que esté integrado en la escena del juego e interactúe con el NPC del juego para aprender puntos de conocimiento para mejorar la diversión del aprendizaje).

R7: La complejidad de los productos de maestros virtuales de IA radica en la tecnología involucrada en múltiples campos, incluido el procesamiento del lenguaje natural, el desarrollo de juegos y el diseño de interacción. Al mismo tiempo, la aplicación de modelos grandes también enfrenta algunos desafíos, como la necesidad de resolver situaciones multimodales y el procesamiento de diálogos largos. Por lo tanto, al realizar un producto de este tipo, es necesario realizar la función paso a paso en combinación con la situación real y el nivel técnico, y planificar e iterar el desarrollo del producto de acuerdo con el progreso de la tecnología existente.

(encima)

Lo anterior es el contenido clave que se ha ordenado para su referencia. Aunque fue un sábado por la noche y se organizó temporalmente, la calidad del intercambio fue muy alta, creo que los temas tratados anteriormente pueden inspirar a todos. Esta pequeña actividad de comunicación en línea también cuenta con el apoyo de muchos usuarios, por lo que realizaremos actividades similares de aprendizaje y comunicación de vez en cuando. Deje que todos progresen juntos en el camino del aterrizaje de la aplicación LLM, ¡así que esté atento!

Si te gusta Dify, bienvenido a:

-

Contribuya con código en GitHub y construya un mejor Dify con nosotros;

-

Comparta Dify y su experiencia con sus amigos a través de actividades en línea y fuera de línea y redes sociales;

-

Enciéndenos ⭐️ en GitHub.