Каталог статей

1. РНН

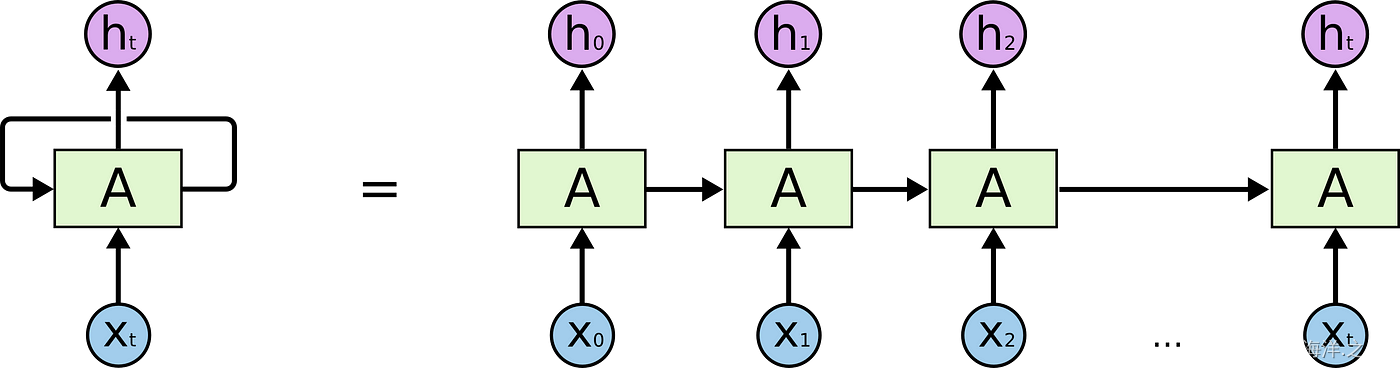

Рекуррентная нейронная сеть (RNN) — это модель нейронной сети для обработки данных последовательности. В отличие от традиционных нейронных сетей, RNN обладает способностью памяти при обработке данных последовательности и может фиксировать временную зависимость в последовательности. Каждый временной шаг RNN будет получать текущие входные данные и скрытое состояние предыдущего временного шага, а затем выводить скрытое состояние и результат прогнозирования текущего временного шага. Эта структура позволяет RNN хорошо работать при обработке данных временных рядов, обработке естественного языка и других задачах.

Однако традиционные RNN также страдают от таких проблем, как исчезающие градиенты и взрывные градиенты, которые ограничивают их способность работать с данными длинных последовательностей. Чтобы решить эти проблемы, появились некоторые улучшенные структуры RNN, такие как сеть с долговременной кратковременной памятью (LSTM) и рекуррентная единица с вентиляцией (GRU). Эти структуры вводят механизмы стробирования, которые могут лучше фиксировать долгосрочные зависимости и, таким образом, лучше работать при работе с данными длинной последовательности.

Структура и принцип работы RNN следующие:

-

Состояние ячейки: в RNN каждый временной шаг поддерживает скрытое состояние (скрытое состояние) и состояние ячейки (состояние ячейки). Скрытое состояние является носителем для передачи информации во временном ряду, тогда как единичное состояние аналогично блоку памяти, отвечающему за запись информации предыдущего временного шага.

-

Структура цикла: ключом к RNN является его структура цикла. На каждом временном шаге RNN вычисляет скрытое состояние и единичное состояние текущего временного шага на основе текущего ввода и скрытого состояния предыдущего временного шага. Этот рекуррентный механизм позволяет RNN сохранять историческую информацию при обработке данных последовательности.

-

Механизм стробирования (LSTM и GRU): традиционные RNN склонны к исчезновению градиента или взрыву градиента при обработке длинных последовательностей, что ограничивает его способность к обучению. Чтобы решить эту проблему, LSTM и GRU вводят механизм блокировки, который может выборочно обновлять и забывать информацию, чтобы лучше фиксировать долгосрочные зависимости.

-

Прогнозирование вывода: на каждом временном шаге RNN может вводить скрытое состояние в качестве функции для последующих слоев нейронной сети для различных задач, таких как классификация, прогнозирование и т. д.

Приложения RNN включают:

- Моделирование языка: прогнозирование следующего слова или символа для задач обработки естественного языка.

- Машинный перевод: перевод одного языка на другой.

- Распознавание речи: преобразование звуковых сигналов в текст.

- Прогнозирование временных рядов: прогнозирование будущих данных временных рядов, таких как цены на акции, температура и т. д.

- Генерация естественного языка: генерируйте текст на естественном языке, например чат-боты.

Короче говоря, RNN — это модель нейронной сети, подходящая для обработки данных последовательности, которая имеет циклическую структуру и способность памяти и подходит для различных задач обработки данных последовательности.

2. ЛСТМ

Долговременная кратковременная память (LSTM) — это особый вид рекуррентной нейронной сети (RNN), который специально разработан для решения проблем с исчезновением градиента и долговременной зависимостью, которые возникают, когда традиционные RNN обрабатывают данные длинных последовательностей. LSTM представляет механизм стробирования, который может лучше фиксировать долгосрочные зависимости в последовательности, благодаря чему он хорошо работает при обработке данных временных рядов, обработке естественного языка и других задачах.

Главной особенностью LSTM является введение трех вентильных блоков: Forget Gate, Input Gate и Output Gate, а также состояния ячейки. Эти блоки управления позволяют LSTM выборочно забывать, обновлять и выводить информацию, тем самым эффективно обрабатывая данные длинной последовательности.

Структура LSTM выглядит следующим образом:

-

Ворота Забвения: Ворота Забвения определяют, какая информация может быть забыта из состояния ячейки. Он выводит значение от 0 до 1 на основе скрытого состояния предыдущего временного шага и текущего ввода, чтобы решить, сохранена ли информация в состоянии ячейки или забыта.

-

Входные ворота: входные ворота определяют, какая новая информация может быть добавлена к состоянию ячейки. Он использует скрытое состояние из предыдущего временного шага и текущие входные данные для вычисления нового значения-кандидата, а затем решает, насколько обновить состояние ячейки на основе значения от 0 до 1.

-

Состояние ячейки: состояние ячейки используется для хранения информации в долговременной памяти. Благодаря работе вентиля забывания и вентиля ввода состояние ячейки может обновляться по мере необходимости.

-

Выходной вентиль: выходной вентиль определяет скрытое состояние вывода и часть состояния ячейки для вывода. Он выводит значение от 0 до 1, в зависимости от текущего скрытого состояния и ввода, чтобы контролировать количество вывода состояния ячейки.

Механизм стробирования LSTM позволяет ему выборочно запоминать и забывать информацию, чтобы лучше фиксировать долгосрочные зависимости в последовательностях. Это делает LSTM отличным решением для обработки данных временных рядов, задач обработки естественного языка и многого другого. В практических приложениях LSTM часто используется в сочетании с другими слоями нейронной сети для построения более сложных моделей, таких как генерация текста, анализ настроений, машинный перевод и другие задачи.

3. Почему вывод структуры LSTM лучше, чем RNN?

По сравнению с традиционной RNN (круговой нейронной сетью), LSTM (сеть с долговременной кратковременной памятью) лучше справляется с обработкой длинных данных последовательности, главным образом потому, что LSTM вводит механизм стробирования, который может более эффективно фиксировать долгосрочные зависимости в последовательности и избегать Устранено влияние проблем исчезновения градиента и взрыва градиента в традиционных RNN. Ниже приводится краткий вывод и объяснение преимуществ LSTM по сравнению с RNN:

-

Механизм ворот: LSTM вводит ворота для забывания, ворота ввода и ворот вывода, Эти механизмы ворот позволяют LSTM выборочно забывать, обновлять и выводить информацию. Ворота забывания и входные ворота позволяют сети выборочно сохранять и обновлять состояние ячейки, эффективно решая проблему исчезновения градиента в традиционной RNN, чтобы она могла лучше обрабатывать данные длинной последовательности.

-

Долгосрочная зависимость: когда традиционные RNN обрабатывают длинные последовательности, трудно зафиксировать долгосрочные зависимости из-за влияния исчезновения градиента. Механизм стробирования LSTM может сохранять долговременную память, позволяя постоянно передавать информацию в состоянии ячейки, чтобы лучше фиксировать долгосрочные зависимости в последовательностях.

-

Предотвращение взрыва градиента: механизм стробирования в LSTM также может помочь сети предотвратить проблему взрыва градиента, поскольку механизм стробирования может ограничивать диапазон распространения градиента, тем самым стабилизируя процесс обучения сети.

-

Локальность: механизм стробирования LSTM позволяет ему выборочно фокусироваться на важных частях последовательности, чтобы лучше справляться с локальными паттернами в последовательности.

Короче говоря, преимущество LSTM по сравнению с традиционной RNN при обработке данных длинных последовательностей заключается в вводимом механизме стробирования.Эти механизмы позволяют сети лучше фиксировать долгосрочные зависимости и избегать проблем с исчезновением градиента и взрывом градиента.Он работает лучше по данным временных рядов, задачам обработки естественного языка и т. д. Особенно в длинных последовательностях данных и задачах, которые должны фиксировать сложные временные зависимости, LSTM обычно работает лучше, чем традиционные RNN.