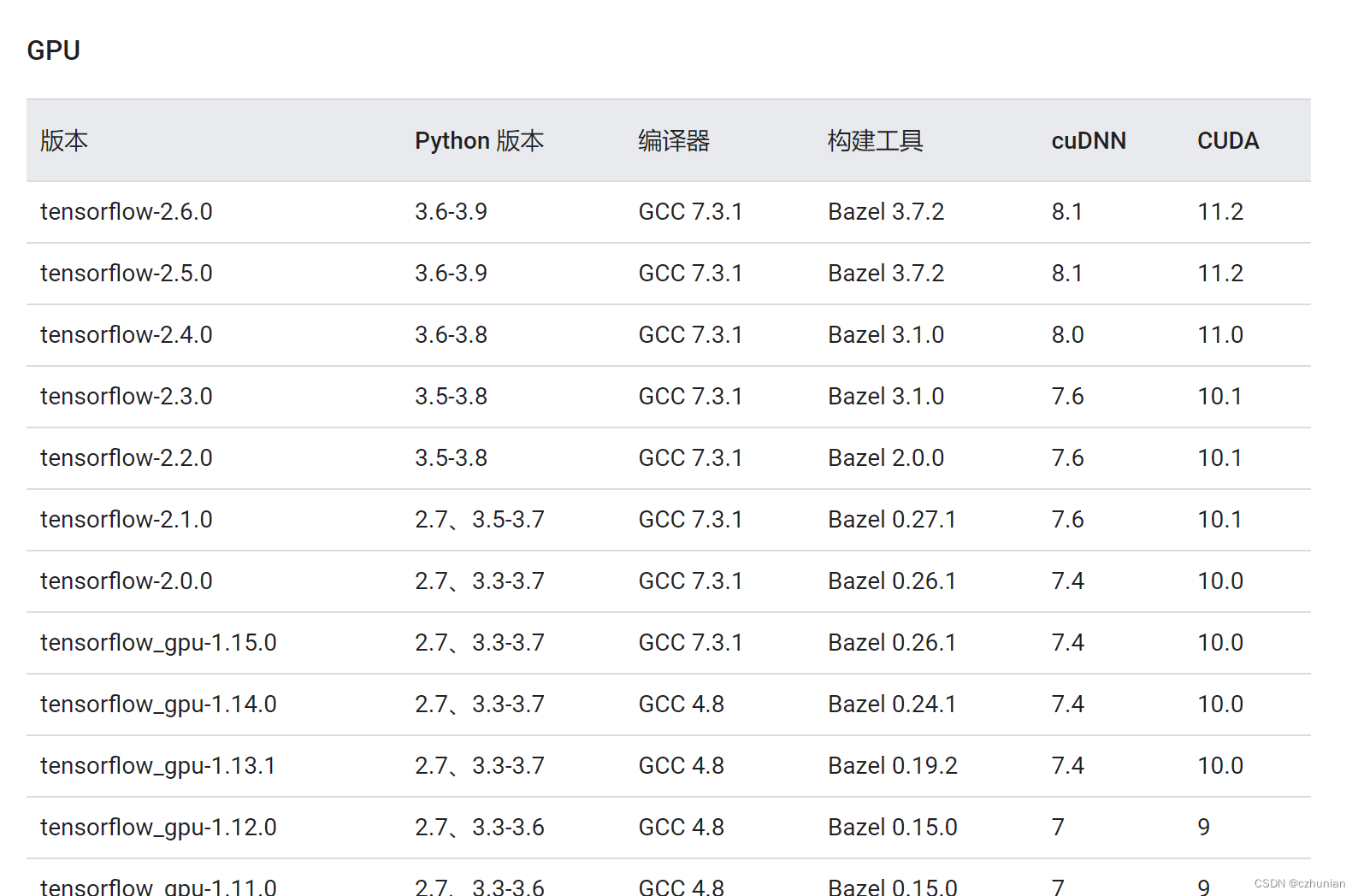

1. La instalación de Cuda, las versiones de cuda y TensorFlow corresponden, enlace https://www.tensorflow.org/install/source#tested_source_configurations

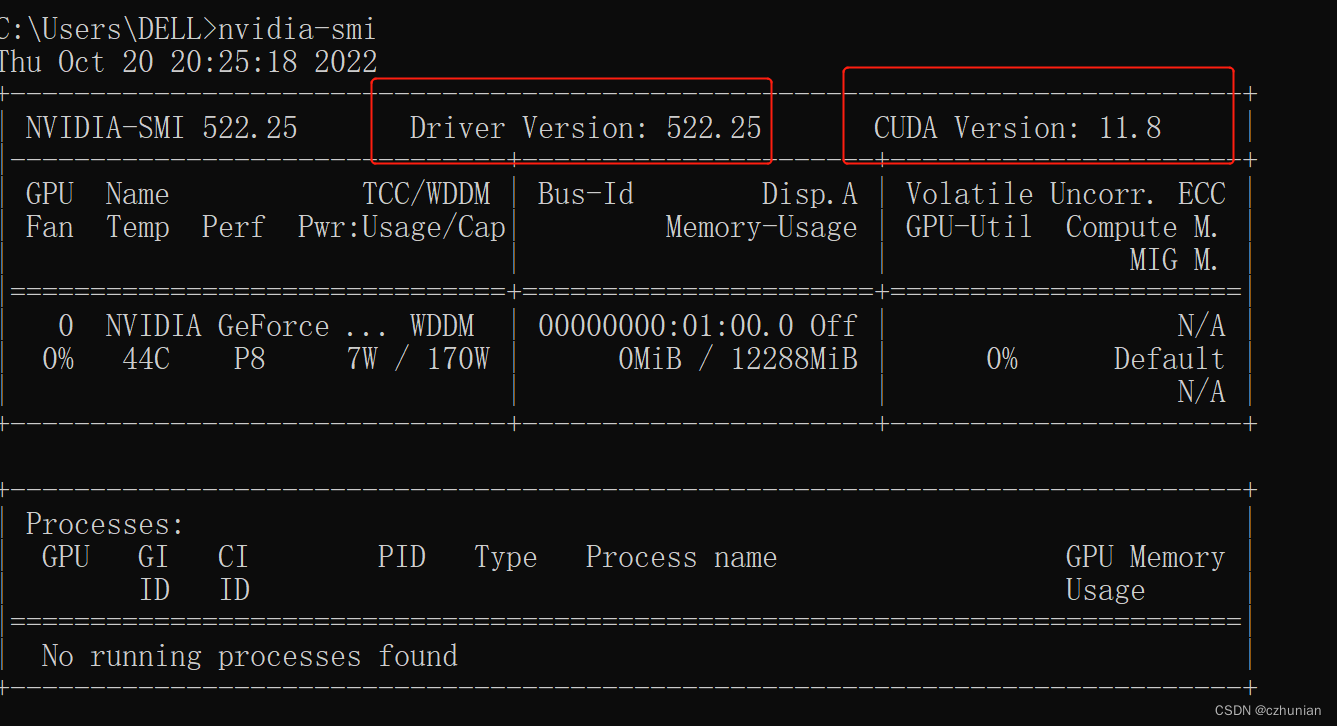

1. Verifique la versión del controlador instalada por usted mismo, nvidia-smi

2. Instale el cuda requerido, enlace de descarga CUDA Toolkit Archive | NVIDIA Developer

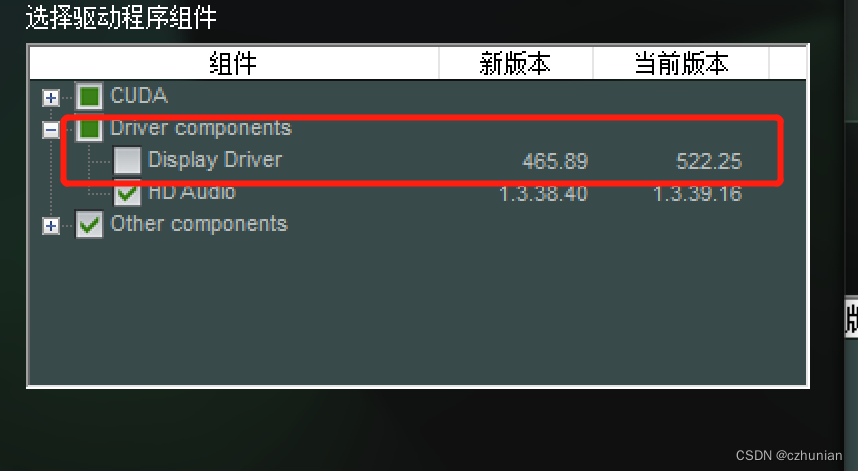

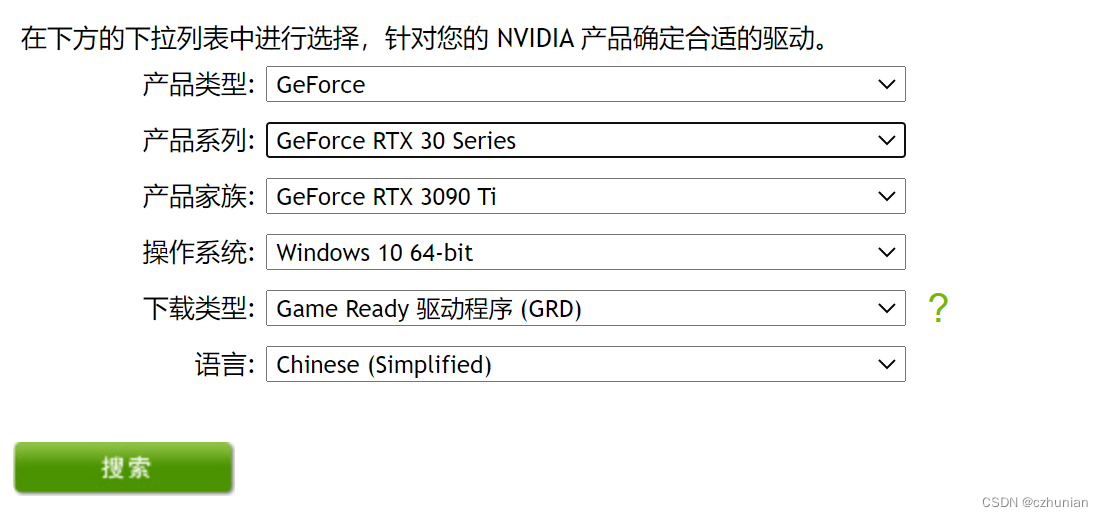

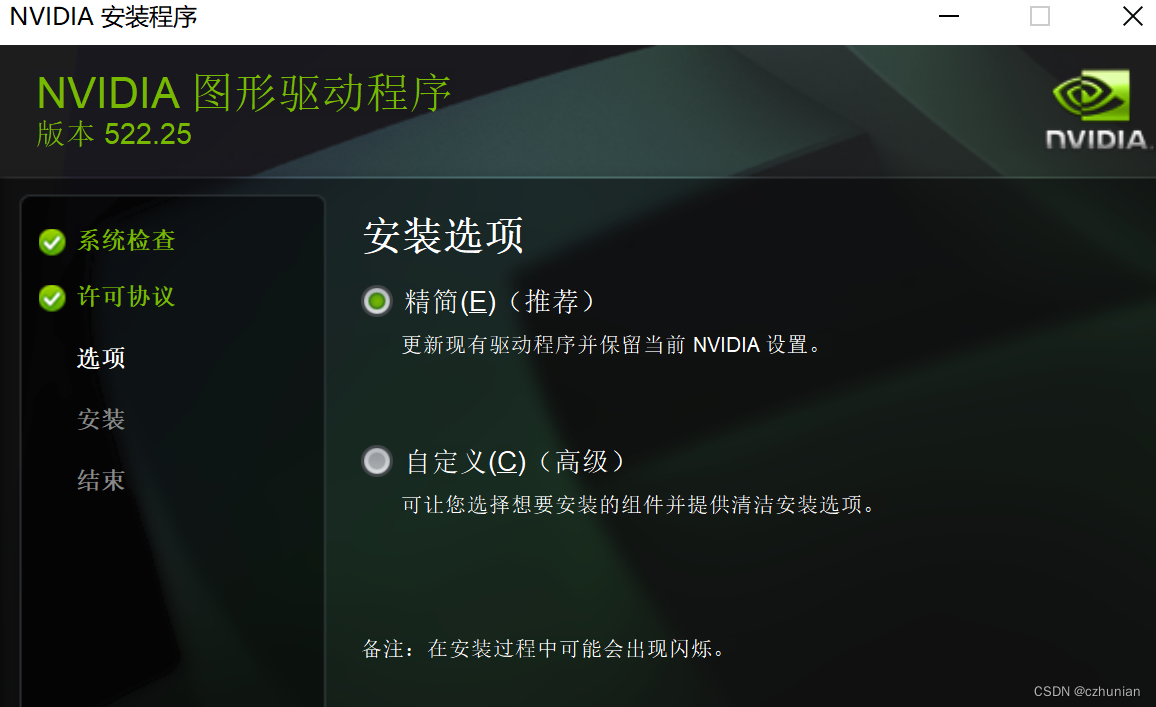

Encuentre la versión requerida, descargue el entorno correspondiente, personalice la instalación , verifique la nueva versión del controlador, si no es superior a la versión actual, no lo instale.

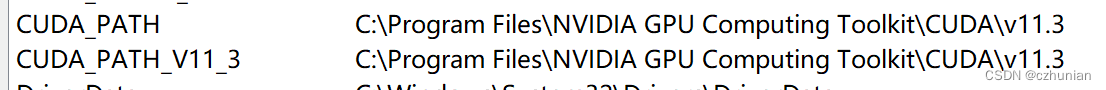

Después de que la instalación sea exitosa, configure las variables de entorno y recuerde la ruta de instalación.

(Si la instalación no tiene éxito, desinstale el controlador e instálelo de nuevo, tendrá éxito. Puede usar el código de extracción de software para la desinstalación: 1233)

(Si cudatookit se instaló correctamente y no se puede encontrar la tarjeta gráfica, entonces

Simplemente instale un controlador en el sitio web oficial )

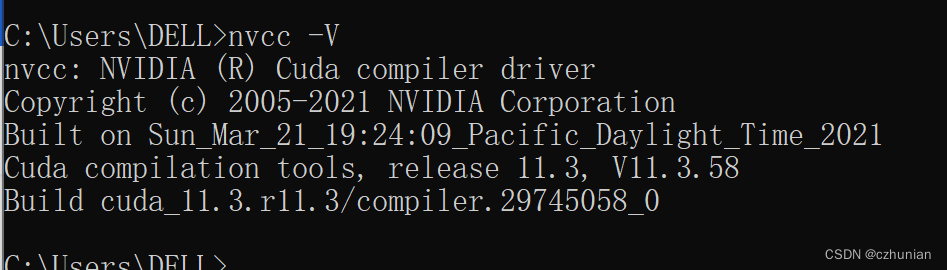

Comprobar la versión de cuda instalada

La versión aquí es diferente a la versión cuda correspondiente a nvidia-smi, puedes ver la explicación del cuarto punto a continuación

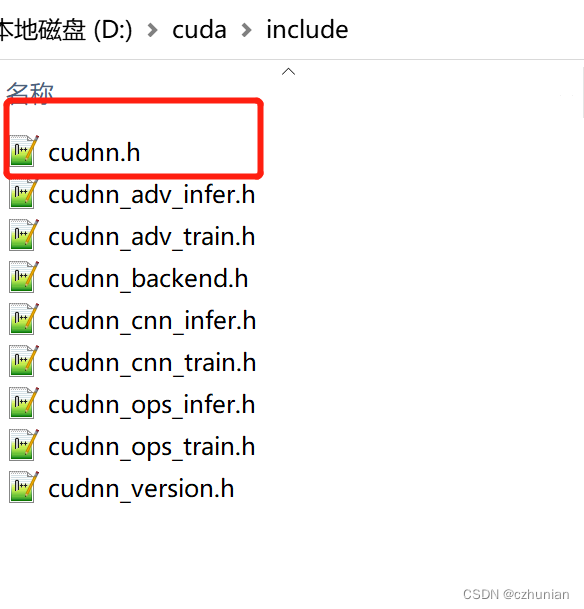

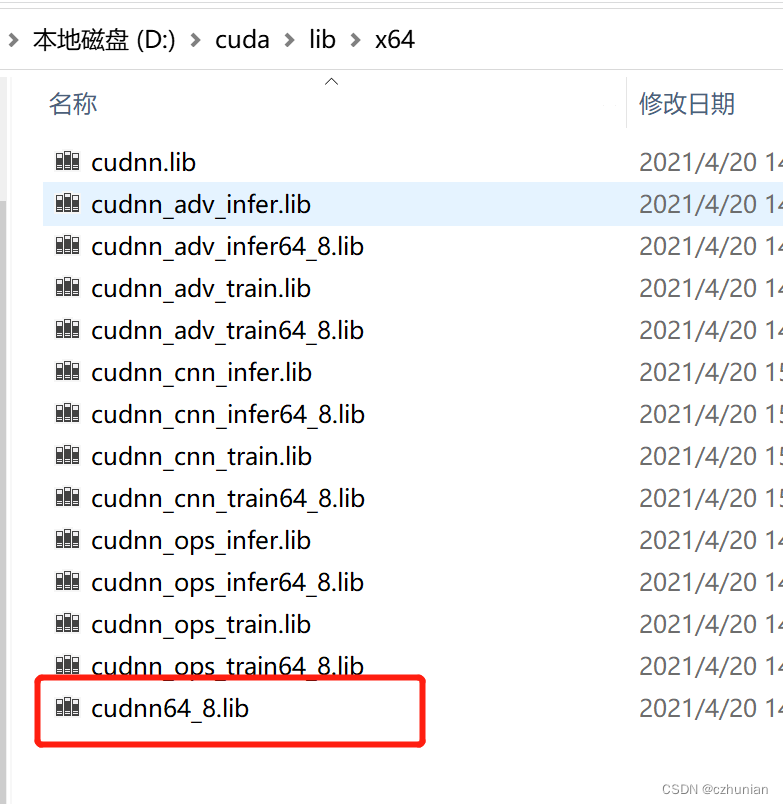

2. Instalación de la biblioteca de aceleración de redes neuronales cuDNN

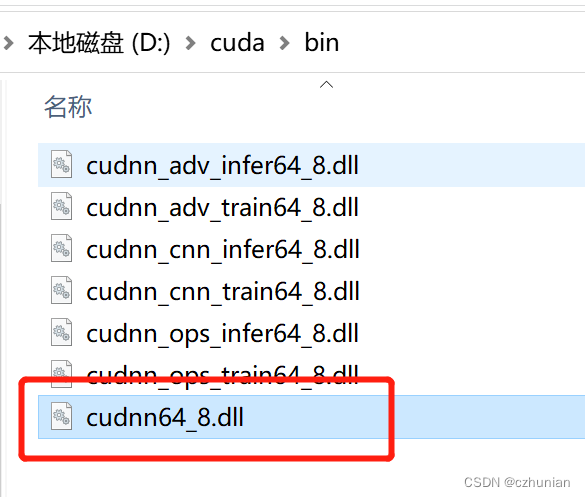

cuDNN no es un programa de aplicación, sino varios paquetes de archivos, simplemente cópielo en el directorio de CUDA después de descargarlo.

página de descarga de cuDNN: página de descarga de cuDNN (recuerde la versión correspondiente, ver arriba)

cuDNN es en realidad solo un parche de CUDA, optimizado para operaciones de aprendizaje profundo

Copie los siguientes archivos include, lib, bin en el directorio correspondiente en el directorio v11.3.

O copie directamente estos tres directorios en el directorio v11.3 (no sobrescriba la copia del archivo)

3. Instale la versión TensorFlow2.5-gpu

1. Instale la versión especificada de TensorFlow 2.5. Aquí debe descargar el archivo de rueda directamente y luego crear un entorno virtual (creación de conda) tutorial conda install Pytorch (GPU)_czhunian's blog-CSDN blog_conda install pytorch gpu

2. Descargue el enlace de la rueda https://github.com/fo40225/tensorflow-windows-wheel

Seleccione la versión correspondiente y descargue todos los archivos de esta versión.

3. En el entorno virtual, conda active tf2, ingrese al entorno virtual, luego cambie a la ruta del archivo de la rueda, pip install comando para instalar

4. Prueba, la salida True significa que la instalación es exitosa

import tensorflow as tf

tf.test.is_gpu_available()4. Relación de la versión del controlador Cuda y NVIDIA, enlace

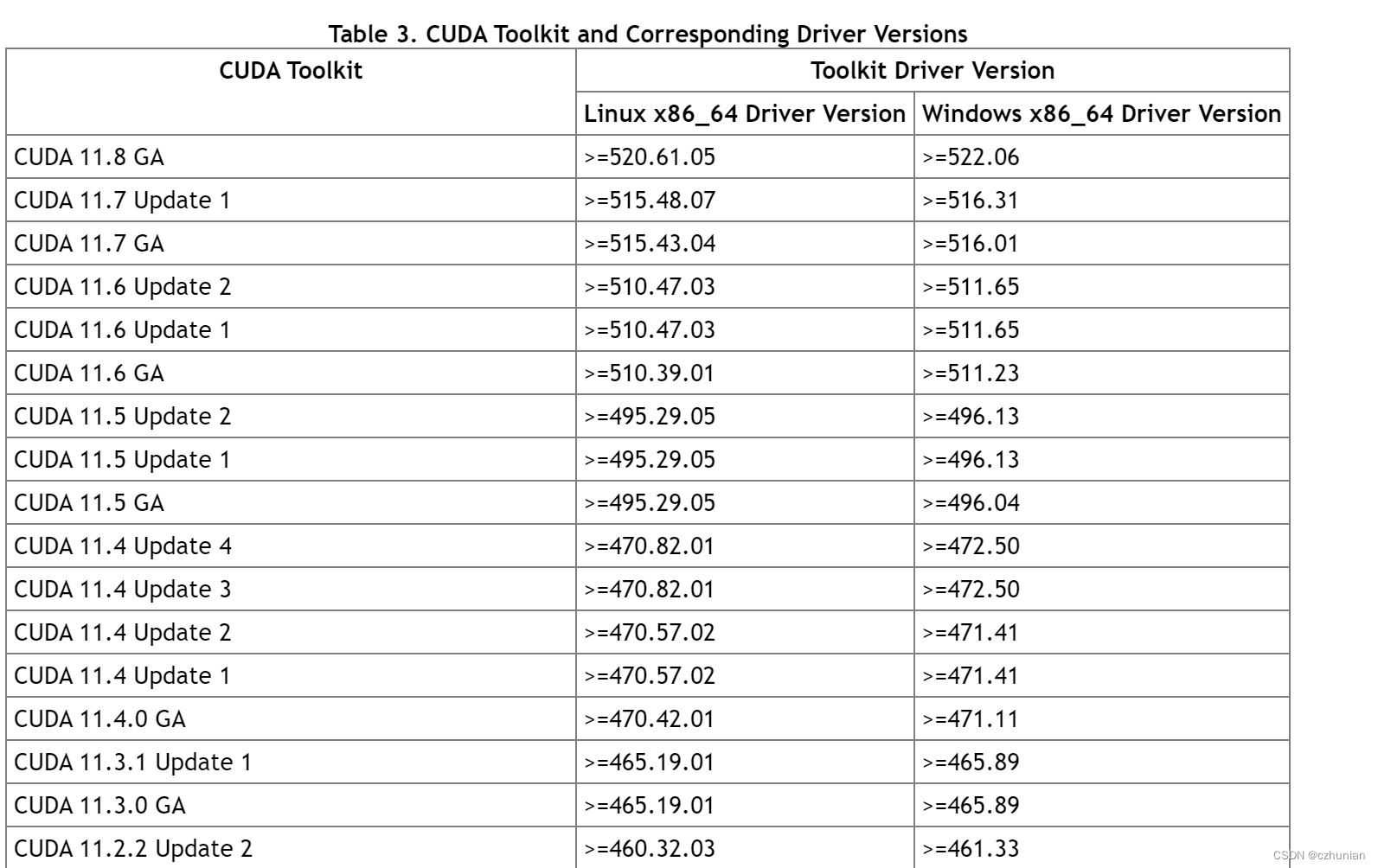

Mire principalmente la Tabla 3, la relación entre la versión cuda y el controlador.

Ver la versión del controlador CUDA (versión del controlador) : versión del controlador NVIDIA GPU (nvidia-smi)

Ver la versión de tiempo de ejecución de CUDA (versión de tiempo de ejecución): paquete cudatoolkit instalado por usted mismo (nvcc -V)

- El instalador del controlador GPU instala los archivos necesarios para admitir la API del controlador

libcuda.so(p. ej. ) . Pertenece a esta categoría de API.nvidia-smi - El instalador de CUDA Toolkit instala los archivos necesarios para admitir la API en tiempo de ejecución (como

libcudart.soynvcc) . (El instalador del kit de herramientas CUDA a veces puede integrar el instalador del controlador GPU). es la herramienta del controlador del compilador de CUDA instalada con el kit de herramientas de CUDA, que solo conoce la versión del tiempo de ejecución de CUDA con la que se creó. No sabe qué versión del controlador de GPU está instalada, o incluso si el controlador de GPU está instalado.nvcc

En resumen, si las versiones de CUDA de la API del controlador y la API de tiempo de ejecución son inconsistentes, puede deberse a que está utilizando un instalador de controlador de GPU independiente en lugar del instalador de controlador de GPU en el instalador del kit de herramientas de CUDA.

En resumen, la versión del controlador no entra en conflicto con la versión del tiempo de ejecución (debería ser que el tiempo de ejecución no puede ser mayor que la versión del controlador aquí), CUDA Toolkit (tiempo de ejecución) es esencialmente solo un juego de herramientas , e incluso se pueden instalar varias versiones de cudatoolkit , a través de Modifique la variable de entorno para elegir qué versión de cuda usar.

V. Resumen

Versión del controlador de la tarjeta gráfica >= versión correspondiente de cudatoolkit <= versión correspondiente de tensorflow ; entonces cuda es un puente .

1. Determine la versión de tensorflow que se instalará.

2. Según la versión de tensorflow, determine la versión de cudatoolkit y determine la versión de cudann.

3. De acuerdo con la versión cuda, determine la versión del controlador de la tarjeta gráfica, actualice si no es suficiente e ignórelo si es suficiente.