El viento del oeste proviene del qubit del templo cóncavo | cuenta pública QbitAI

¡El método de aprendizaje de la red neuronal artificial (ANN) es muy similar al del cerebro humano!

Me has oído bien, al menos en términos de procesamiento del lenguaje, las máquinas parecen más humanas.

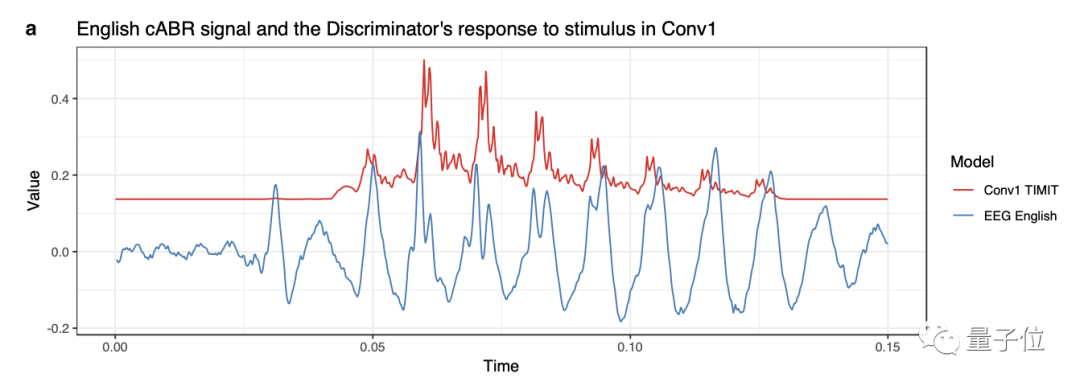

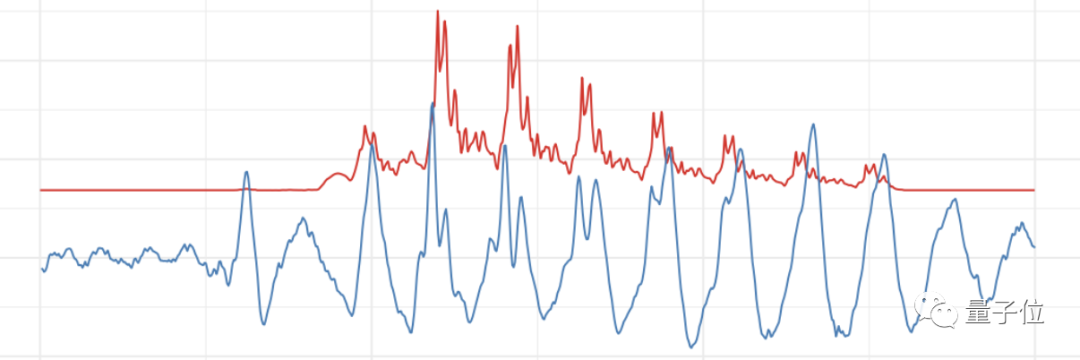

Primero mira la imagen de abajo:

El azul representa señales de ondas cerebrales humanas y el rojo representa señales de redes neuronales artificiales.

Y esto es lo que hacen el cerebro humano y la máquina cuando escuchan el mismo discurso .

¿Son muy parecidos, te sorprende?

De hecho, esta imagen proviene de un estudio reciente, y artículos relacionados han sido publicados en Scientific Reports, una sub-revista de Nature.

Anteriormente, la cuestión de cómo aprenden el cerebro humano y el cerebro de la máquina siempre ha sido un misterio.

El tema de "si las redes neuronales aprenden de la misma manera que los humanos" también ha sido controvertido.

Entonces, ¿qué evidencia hay de que los humanos y las máquinas "probablemente procesen el lenguaje de manera similar"?

Las señales de la red neuronal artificial se asemejan mucho a las señales de ondas cerebrales humanas

Para desmitificar el aprendizaje en redes neuronales artificiales, Gašper Beguš, lingüista computacional de la Universidad de California, Berkeley, realizó el estudio con Alan Zhou, estudiante de doctorado en la Universidad Johns Hopkins, y Christina Zhao, neurocientífica de la Universidad de Washington.

En este estudio, escucharon un sonido simple para los humanos y luego recolectaron las ondas cerebrales producidas por los humanos después de escuchar el sonido. Al mismo tiempo, el mismo sonido se alimenta a la red neuronal y se analiza la señal generada por la red neuronal.

Comparando los dos, los resultados son sorprendentemente similares.

Lo que es más importante, los investigadores probaron redes de neuronas de propósito general para una variedad de tareas, e incluso redes muy generales (sin sesgo para el habla u otros sonidos) aún mostraban correspondencia con las codificaciones neuronales humanas.

Entonces, ¿cómo se llevó a cabo exactamente esta investigación?

Primero, los investigadores reclutaron a 14 angloparlantes y 15 hispanohablantes para comparar mejor cómo responde el cerebro humano a la red neuronal artificial.

Luego, a los hombres se les reprodujo un audio monosilábico - "bah" - durante 8 minutos cada uno, repetido dos veces.

Durante la reproducción, los investigadores registraron las fluctuaciones en la actividad eléctrica promedio de las neuronas en el tronco encefálico de cada oyente (la parte del cerebro que primero procesa el sonido).

Por separado, los investigadores introdujeron el mismo sonido "bah" en dos conjuntos diferentes de redes neuronales. Un conjunto de redes neuronales se entrenó en inglés y el otro en español.

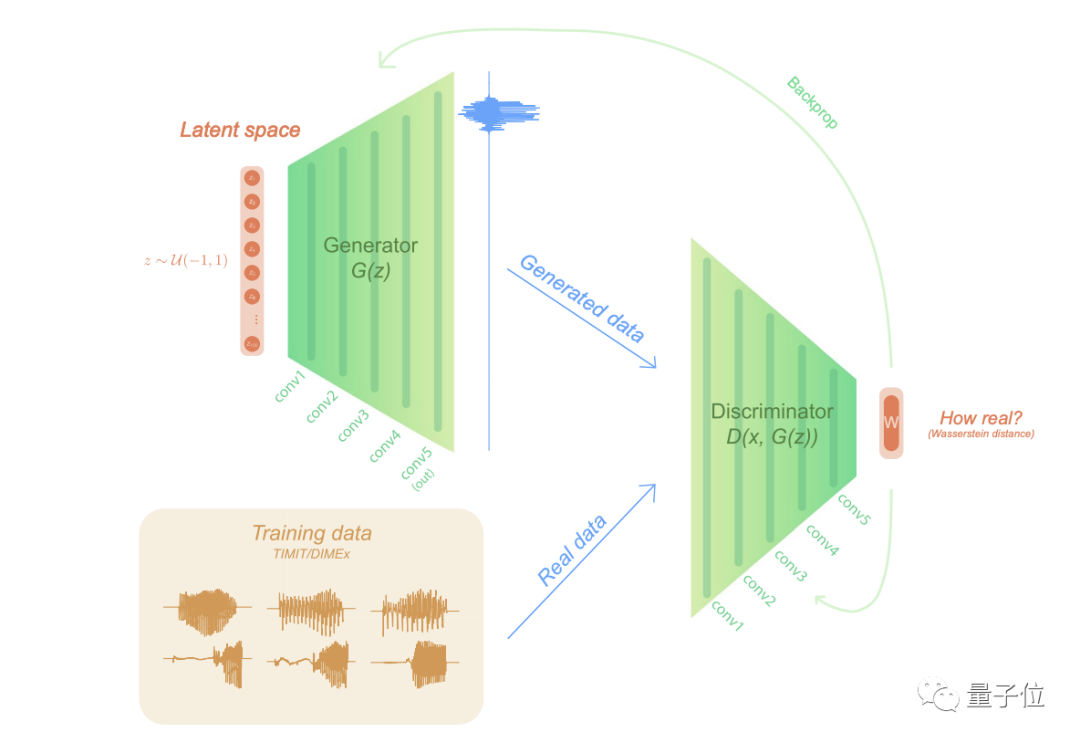

La arquitectura de red neuronal elegida por los investigadores es una red adversarial generativa (GAN).

GAN se propuso por primera vez en 2014 para la generación de imágenes. GAN consta de dos módulos, el discriminador y el generador, que aprenden uno del otro a través de juegos para producir mejores resultados.

Específicamente, el generador crea una muestra de una imagen o sonido, y el discriminador determina qué tan cerca está de la muestra de entrenamiento y proporciona retroalimentación, lo que hace que el generador reaccione nuevamente, y así sucesivamente, hasta que la GAN pueda generar el resultado deseado.

En este estudio, sin embargo, el discriminador fue entrenado inicialmente en una variedad de sonidos en inglés o español.

Luego, un generador que nunca fue entrenado con esos sonidos tuvo que encontrar una manera de generarlos. Comenzó emitiendo sonidos aleatorios y, después de unas 40 000 interacciones con el discriminador, el generador produjo gradualmente los sonidos correctos. Después de este entrenamiento, el discriminador también se vuelve mejor para distinguir los sonidos reales de los generados.

Después de entrenar al discriminador, los investigadores tocaron el sonido "bah". Midieron las fluctuaciones en el nivel de actividad promedio de las neuronas artificiales discriminadoras y registraron la actividad de procesamiento de la red neuronal, enfocándose en las capas de neuronas artificiales en la red que analizan el sonido (para imitar las lecturas del tronco encefálico).

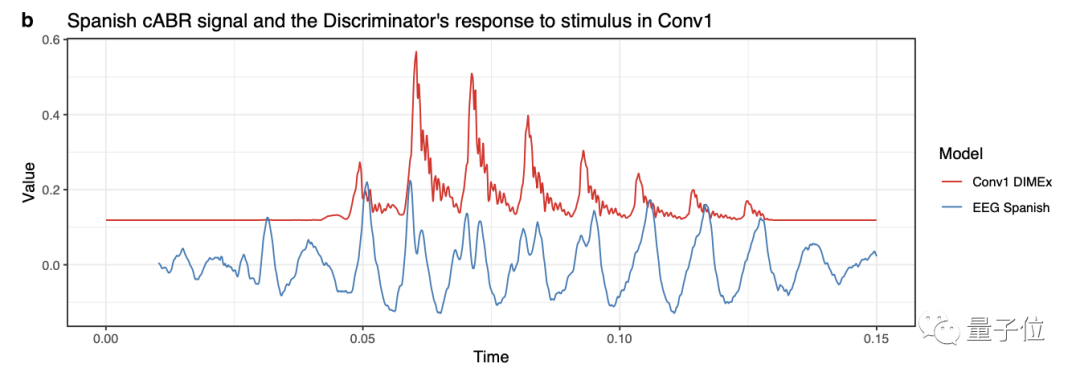

Al comparar la señal de onda cerebral humana recopilada con la señal de la red neuronal artificial, los resultados se muestran en la siguiente figura:

△ Resultados experimentales en inglés: el azul son ondas cerebrales humanas, el rojo son señales de redes neuronales artificiales

△ Resultados experimentales en español: el azul son ondas cerebrales humanas, el rojo son señales de redes neuronales artificiales

¡Se puede encontrar que estas señales de redes neuronales artificiales coinciden muy bien con las señales de ondas cerebrales humanas!

Esto también sugiere que los dos sistemas están realizando una actividad similar.

Además, el experimento reveló otra similitud intrigante entre humanos y máquinas. Las ondas cerebrales mostraron que los angloparlantes y los hispanohablantes tenían diferentes percepciones auditivas del sonido "bah" (los hispanohablantes escuchaban "pah" con más frecuencia).

La señal GAN también mostró que la red entrenada en inglés procesó los sonidos de manera diferente a la red entrenada en español.

“Y estas diferencias se generan en la misma dirección”, explica Beguš.

El tronco encefálico de los hablantes de inglés respondió al sonido de "bah" un poco antes que los de los hablantes de español, y el GAN entrenado en inglés también respondió al mismo sonido un poco antes que el modelo entrenado en español.

La diferencia en este tiempo de reacción entre humanos y máquinas es casi la misma, del orden de una milésima de segundo.

También proporciona a Beguš evidencia adicional de que los humanos y las redes artificiales "probablemente procesan el lenguaje de manera similar".

Chomsky equivocado?

La conclusión de este estudio en realidad contradice la opinión de que "los seres humanos nacen con la capacidad de comprender el lenguaje, que está integrado en el cerebro humano" propuesta por el lingüista Noam Chomsky en la década de 1950.

Además, Chomsky también propuso el concepto de Gramática Universal, es decir, el cerebro humano generalmente tiene un mecanismo de adquisición del lenguaje que permite a las personas aprender a usar el lenguaje.

¿Será que Chomsky está equivocado?

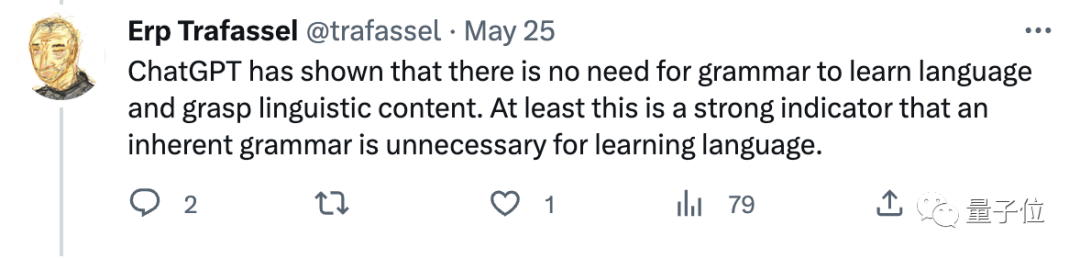

Al respecto, algunos internautas dijeron:

ChatGPT ha demostrado que la gramática no es necesaria para aprender y comprender un idioma.

También hay internautas que se muestran escépticos:

El cerebro humano y las redes neuronales no son lo mismo, y deberíamos ser escépticos acerca de estudiar el cerebro humano estudiando el tiempo de computación de las redes neuronales.

Además, la red neuronal ha sido entrenada en lenguaje humano, por lo que esta afirmación tampoco puede inferirse del tiempo observado.

Beguš dijo: El debate aún no ha terminado.

△ Gasper Beguš

Dice que explorará más a fondo los paralelismos entre el cerebro humano y las redes neuronales, por ejemplo, está probando si las ondas cerebrales emitidas por la corteza (después de que el tronco encefálico completa parte de su procesamiento auditivo) se corresponden con las señales producidas por las capas más profundas de la GAN.

En última instancia, esperan desarrollar un modelo sólido de adquisición del lenguaje que describa cómo las máquinas y los humanos aprenden el lenguaje, lo que permite experimentos que no son posibles con sujetos humanos.

Christina Zhao, neurocientífica de la Universidad de Washington y miembro del equipo de investigación de Beguš, dijo:

Por ejemplo, podemos crear un entorno adverso, como un bebé descuidado, y ver si eso conduce a algo como un trastorno del habla.

Además, Beguš dijo que está tratando de ver hasta dónde puede llegar este camino y qué tan cerca puede estar la neurona general del lenguaje humano.

¿Podemos expandir y mejorar nuestra arquitectura informática para lograr un rendimiento similar al humano, o podemos demostrar que esto nunca será posible?

Se necesita más trabajo antes de saber con certeza acerca de este problema. Pero todavía estamos muy sorprendidos por el funcionamiento interno de estos sistemas, por las similitudes entre los humanos y las redes neuronales artificiales.

¿Qué opinas sobre el cerebro humano y las redes neuronales artificiales?

Portal:

[1] https://www.nature.com/articles/s41598-023-33384-9 (enlace al artículo)

参考链接:

[1] https://www.quantamagazine.org/some-neural-networks-learn-language-like-humans-20230522/