Directorio de artículos

- Ataque furtivo de puerta trasera con disparadores específicos de muestra

- Información del papel

- contribución en papel

- traducción de comprensión

- Análisis de papel

-

- Artículos de referencia importantes

- Independientes e idénticamente distribuidos

- Hable sobre varios métodos de defensa de redes neuronales: Fine-Pruning, Neural Cleanse, STRIP, SentiNet, DF-TND, Spectral Signatures

- Explicar Neural Cleanse de nuevo

- Acerca de la tira

- algún código real

- Redes malas

- Aprendizaje federado y ataques de puerta trasera

-

- el código

- Puntos de conocimiento complementarios

-

- transforma.Compose

- np.elección.aleatoria

- copia profunda y copia superficial

- muestra aleatoria

- aleatorio.shuffle

- global_param.data y global_param.grad

- Cargue un modelo previamente guardado y continúe entrenando

- Acerca del número de veces para recorrer los parámetros del modelo global y el modelo local

Ataque furtivo de puerta trasera con disparadores específicos de muestra

Información del papel

| título del trabajo | Ataque de puerta trasera invisible con activadores específicos de muestra |

|---|---|

| autor | Yuezun Li, Yiming Li, Baoyuan Wu, Longkang Li, Ran He y Siwei Lyu |

| Instituciones de investigación | Ocean University of China, The Chinese University of Hong Kong, Shenzhen Research Institute of Big Data, Tsinghua University, Tsinghua University, University at Buffalo |

| Reunión | ICCV |

| año de publicacion | 2021 |

| Enlace de papel | https://openaccess.thecvf.com/content/ICCV2021/papers/Li_Invisible_Backdoor_Attack_With_Sample-Specific_Triggers_ICCV_2021_paper.pdf |

| código fuente abierto | https://github.com/yuezunli/ISSBA |

contribución en papel

- Se analizan las condiciones exitosas de la defensa de ataque de puerta trasera actual: el ataque de puerta trasera existente es independiente de la muestra (es decir, los desencadenantes de diferentes muestras de envenenamiento son los mismos)

- Se propone un método para personalizar activadores de puerta trasera basados en muestras: una ligera perturbación de las muestras de entrenamiento basadas en la idea de la esteganografía de imágenes (es decir, ruido adicional invisible específico de las muestras generadas)

traducción de comprensión

Resumen

最近,后门攻击对深度神经网络(DNNs)的训练过程构成了新的安全威胁。攻击者试图将隐藏的后门注入到DNNs中,使得受攻击的模型在良性样本上表现良好,而一旦攻击者定义的触发器激活隐藏的后门,其预测结果将恶意地被改变。现有的后门攻击通常采用的设定是触发器与样本无关,也就是说,不同的被污染样本中包含相同的触发器,这导致了现有的后门防御能够轻易地减轻攻击。在这项工作中,我们探讨了一种新的攻击范式,其中后门触发器是样本特定的。在我们的攻击中,我们只需要修改某些训练样本中的看不见的扰动,而无需像许多现有的攻击那样操纵其他训练组件(例如,训练损失和模型结构)。具体来说,受到最近在DNN基础上的图像隐写术的启发,我们通过编码器-解码器网络将攻击者指定的字符串编码到良性图像中,生成样本特定的看不见的附加噪声作为后门触发器。当DNNs在被污染的数据集上进行训练时,将会生成从字符串到目标标签的映射。对基准数据集的大量实验验证了我们的方法在有或无防御的模型攻击中的有效性。

代码可以在 https://github.com/yuezunli/ISSBA 获得。

1. 引言

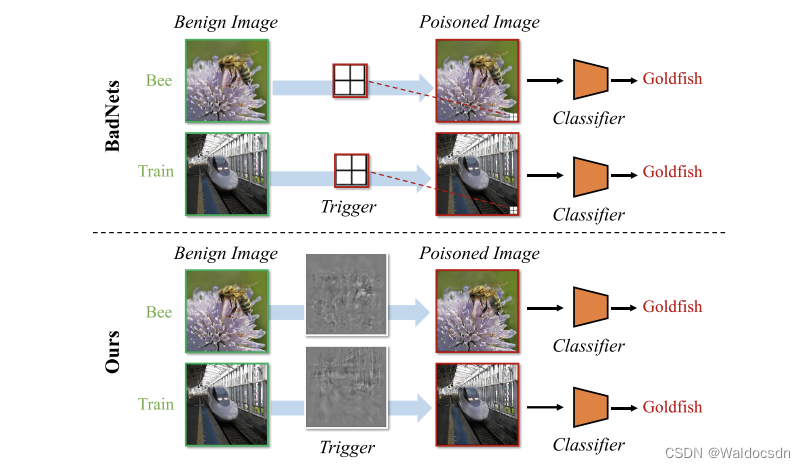

图1. 对比之前的攻击(例如,BadNets [8])和我们的攻击中的触发器。之前攻击的触发器是样本无关的(即,不同的被污染样本包含相同的触发器),而我们的方法中的触发器是样本特定的。

Las redes neuronales profundas (DNN) se han aplicado ampliamente y con éxito en muchos campos [11, 25, 49, 19]. Una gran cantidad de datos de entrenamiento y una potencia informática cada vez mayor son los factores clave para su éxito, pero el complicado proceso de entrenamiento a largo plazo se ha convertido en un cuello de botella para los usuarios e investigadores. Para reducir los gastos generales, la capacitación de DNN generalmente aprovecha los recursos de terceros. Por ejemplo, puede utilizar datos de terceros (como datos de Internet o de empresas de terceros), entrenar modelos con servidores de terceros (como Google Cloud) o incluso adoptar directamente API de terceros. Sin embargo, la opacidad del proceso de formación trae consigo nuevas amenazas a la seguridad.

Los ataques de puerta trasera son una amenaza emergente en el proceso de entrenamiento de las DNN. Manipula maliciosamente la predicción del modelo DNN atacado al contaminar parte de las muestras de entrenamiento. Específicamente, el atacante de puerta trasera inyecta algunos patrones especificados por el atacante (llamados disparadores de puerta trasera) en la imagen contaminada y reemplaza las etiquetas correspondientes con etiquetas de destino predefinidas. Por lo tanto, los atacantes pueden incrustar algunas puertas traseras ocultas en los modelos entrenados con el conjunto de entrenamiento contaminado. El modelo atacado funcionará normalmente cuando procese muestras benignas, pero cuando el activador esté presente, sus predicciones se cambiarán a etiquetas objetivo. Además, el activador puede ser invisible [3, 18, 34] y el atacante solo necesita contaminar una pequeña fracción de las muestras, lo que hace que el ataque sea muy sigiloso. Por lo tanto, los ataques insidiosos de puerta trasera representan una seria amenaza para la aplicación de DNN.

Afortunadamente, se han propuesto varias defensas de puerta trasera [7, 41, 45], lo que demuestra que los ataques de puerta trasera existentes se pueden mitigar con éxito. Esto plantea una pregunta importante: ¿realmente se ha resuelto la amenaza de los ataques de puerta trasera? En este documento, revelamos que los ataques de puerta trasera existentes son fácilmente mitigados por las defensas actuales, principalmente porque sus disparadores de puerta trasera son independientes de la muestra, es decir, diferentes muestras contaminadas. Todos los patrones contienen los mismos disparadores. Teniendo en cuenta que los disparadores son independientes de la muestra, los defensores pueden reconstruir o detectar fácilmente disparadores de puerta trasera en función del mismo comportamiento entre diferentes muestras contaminadas.

Con base en este entendimiento, exploramos un nuevo paradigma de ataque donde el disparador de puerta trasera es específico de la muestra. Solo necesitamos modificar perturbaciones invisibles en algunas muestras de entrenamiento, sin manipular otros componentes de entrenamiento (por ejemplo, pérdida de entrenamiento y estructura del modelo) como muchos ataques existentes. Específicamente, inspirados en la esteganografía de imágenes basada en DNN [2, 51, 39], codificamos cadenas especificadas por el atacante en imágenes benignas a través de una red de codificador-descodificador, generando ruido adicional invisible específico de la muestra como disparador de puerta trasera . Cuando los DNN se entrenan en el conjunto de datos contaminado, se genera una asignación de cadenas a etiquetas de destino. El paradigma de ataque propuesto rompe los supuestos básicos de los métodos de defensa actuales, por lo que pueden pasarse por alto fácilmente.

Las principales contribuciones de este documento son las siguientes: (1) Brindamos una discusión exhaustiva de las condiciones de éxito de las defensas de puerta trasera convencionales actuales. Revelamos que todo su éxito se basa en la premisa de que los activadores de puerta trasera son independientes de la muestra. (2) Exploramos un nuevo paradigma de ataque invisible en el que el activador de la puerta trasera es específico de la muestra y no se ve. Puede eludir las defensas existentes porque rompe sus suposiciones básicas. (3) Llevamos a cabo extensos experimentos para verificar la efectividad del método propuesto.

2. Trabajo relacionado

2.1 Ataque de puerta trasera

El ataque de puerta trasera es un campo de investigación emergente y de rápido desarrollo que plantea una amenaza de seguridad para el proceso de entrenamiento de las redes neuronales profundas (DNN). Los ataques existentes se pueden dividir en dos categorías según las características de los disparadores: (1) ataques visibles, los disparadores en la muestra atacada son visibles para los humanos; (2) ataques invisibles, los disparadores son invisibles.

Ataque de puerta trasera visible. Gu y otros [8] revelaron la amenaza de puerta trasera en el entrenamiento de DNN por primera vez y propusieron el ataque BadNets, que es un representante de los ataques de puerta trasera visibles. Dada una etiqueta de destino especificada por el atacante, BadNets contamina un subconjunto de imágenes de entrenamiento de otras clases al superponer un disparador de puerta trasera (por ejemplo, un cuadrado blanco de 3×3 en la esquina inferior derecha de una imagen) en una imagen benigna. Estas imágenes contaminadas con etiquetas de destino, junto con otras muestras de entrenamiento benignas, se introducen en los DNN para el entrenamiento. Actualmente, hay algunos otros trabajos en esta área [37, 22, 27]. En particular, el trabajo concurrente [27] también investigó ataques de puerta trasera específicos de la muestra. Sin embargo, su método necesita controlar la pérdida de entrenamiento además de modificar las muestras de entrenamiento, lo que reduce en gran medida su amenaza en aplicaciones prácticas.

Ataques de puerta trasera invisibles. Chen y otros [3] analizaron por primera vez la ocultación de los ataques de puerta trasera desde la perspectiva de la visibilidad de los desencadenantes de la puerta trasera. Sugieren que las imágenes contaminadas deberían ser indistinguibles de sus contrapartes benignas para evitar la inspección manual. Específicamente, proponen un ataque invisible con una estrategia híbrida que genera imágenes contaminadas al mezclar activadores de puertas traseras con imágenes benignas en lugar de imprimirlas directamente. Además de los métodos anteriores, se han propuesto algunos otros ataques invisibles [31, 34, 50] para diferentes escenarios: Quiring et al. [31] para escalado de imágenes durante el entrenamiento, Zhao et al. [50] para reconocimiento de video, Saha y otros [34] suponen que el atacante conoce la estructura del modelo. Tenga en cuenta que la mayoría de los ataques existentes emplean diseños de disparadores independientes de la muestra, es decir, los disparadores se fijan durante la fase de entrenamiento o prueba. En este documento, proponemos un paradigma de ataque invisible más fuerte donde el disparador de puerta trasera es específico de la muestra .

2.2 Defensa de puerta trasera

Ver 3. Comprensión profunda de las defensas existentes

Defensa basada en la poda. Inspirándose en la observación de que las neuronas relacionadas con la puerta trasera suelen estar inactivas durante la inferencia en muestras benignas, Liu y otros [24] propusieron podar estas neuronas para eliminar las puertas traseras ocultas en las DNN. Una idea similar también fue explorada por Cheng et al [4], quienes propusieron eliminar el ℓ ∞ \ell _{\infty} del mapa de activación de la capa convolucional finalℓ∞Neuronas con altos valores de activación en la norma.

Defensa basada en la síntesis de disparadores. A diferencia de eliminar directamente las puertas traseras ocultas, las defensas basadas en la síntesis de desencadenantes primero sintetizan los desencadenantes potenciales y luego eliminan las puertas traseras ocultas suprimiendo sus efectos en una segunda etapa . Wang y otros [41] propusieron la primera defensa basada en la síntesis de activación, Neural Cleanse , donde primero obtuvieron los posibles patrones de activación para cada clase y luego determinaron los patrones de activación sintéticos finales basados en detectores de anomalías y su etiqueta objetivo. También se han estudiado ideas similares en [30, 9, 42], quienes adoptaron diferentes enfoques para generar activadores latentes o realizar la detección de anomalías.

Defensa basada en mapas de prominencia. Estos métodos usan mapas de prominencia para identificar posibles regiones desencadenantes para filtrar muestras maliciosas. Al igual que para desencadenar defensas basadas en síntesis, también están involucrados los detectores de anomalías. Por ejemplo, SentiNet [5] emplea Grad-CAM [35] para extraer regiones clave de la entrada de cada clase y luego ubicar las regiones desencadenantes en función del análisis de límites. También se exploran ideas similares [13].

BANDA. Recientemente, Gao y otros [7] propusieron un método, llamado STRIP, para filtrar muestras maliciosas superponiendo varios patrones de imágenes en imágenes sospechosas y observando la aleatoriedad de sus predicciones. Según la suposición de que el activador de la puerta trasera es independiente de la entrada, cuanto menor sea la aleatoriedad, mayor será la probabilidad de que la imagen sospechosa sea maliciosa .

3. Obtenga información sobre las defensas existentes

En esta sección, discutimos las condiciones de éxito para las defensas de puerta trasera convencionales actuales. Argumentamos que su éxito depende principalmente de la suposición implícita de que los disparadores de puerta trasera son independientes de la muestra. Una vez que se viola este supuesto, su eficacia se verá muy afectada. Las suposiciones para varios métodos de defensa se discuten a continuación.

La suposición de las defensas basadas en la poda Las defensas basadas en la poda se inspiran en la suposición de que las neuronas asociadas a la puerta trasera son distintas de las activadas por muestras benignas . Los defensores pueden eliminar las puertas traseras ocultas podando las neuronas que están latentes en las muestras benignas. Sin embargo, la falta de superposición entre estos dos tipos de neuronas puede deberse a la simplicidad del patrón de activación independiente de la muestra, es decir, las DNN solo necesitan una pequeña cantidad de neuronas independientes para codificar esta activación. Esta suposición puede no ser válida cuando los activadores son específicos de la muestra, ya que este paradigma es más complicado.

-

La traducción al chino de este pasaje es la siguiente:

Hipótesis de los métodos de defensa basados en la poda. El enfoque de defensa basado en la poda se basa en la suposición de que las neuronas asociadas con las puertas traseras son distintas de las que se activan para las muestras benignas. Los defensores pueden podar las neuronas que están inactivas en muestras benignas para eliminar las puertas traseras ocultas. Sin embargo, la falta de superposición entre estos dos tipos de neuronas puede deberse a la simplicidad de los patrones de activación independientes de la muestra, es decir, las redes neuronales profundas (DNN) requieren solo unas pocas neuronas independientes para codificar tales activadores. Esta suposición puede no ser válida cuando los activadores son específicos de la muestra, ya que el paradigma es más complejo.

-

Análisis detallado y fácil de entender:

El método de defensa basado en la poda es una estrategia de defensa para redes neuronales basada en la suposición de que las neuronas asociadas con ataques de puerta trasera (es decir, las neuronas activadas por disparadores) son diferentes de las neuronas que procesan muestras normales (benignas). Esto se debe a que en un ataque de puerta trasera, el atacante generalmente implanta neuronas específicas en el modelo, y cuando estas neuronas se activan (por ejemplo, al ingresar una imagen que contiene un disparador), el modelo hará que el atacante realice el pronóstico especificado.

Por lo tanto, los defensores pueden eliminar las puertas traseras en el modelo podando (es decir, eliminando) aquellas neuronas que no responden a las muestras normales (es decir, están inactivas). Eso es porque si una neurona no responde a las muestras normales, es probable que sea una neurona de puerta trasera plantada por un atacante.

Sin embargo, el éxito de este método presupone que las neuronas de puerta trasera y las neuronas que procesan muestras normales no se superponen, una suposición que puede no ser válida en algunos casos. Por ejemplo, si los disparadores de puerta trasera son específicos de la muestra (es decir, los disparadores se comportan de manera diferente en diferentes muestras), entonces las neuronas de puerta trasera pueden superponerse con las neuronas que procesan muestras normales, lo que hace que los métodos de poda sean menos efectivos. Elimine las puertas traseras.

La suposición de las defensas basadas en la síntesis de desencadenantes Durante la síntesis, los métodos existentes (p. ej., limpieza neuronal [41]) deben encontrar aquellos que puedan transformar cualquier imagen inofensiva (benigna) en patrones desencadenantes potenciales específicos para categorías. Por lo tanto, los disparadores sintetizados solo son efectivos si los disparadores de puerta trasera especificados por el atacante son irrelevantes para la muestra.

-

(OK) El tema de este pasaje es una hipótesis acerca de las defensas de síntesis desencadenante. Explicación detallada paso a paso:

-

Defensa de síntesis de activación: esta es una estrategia de defensa utilizada principalmente para hacer frente a ataques de puerta trasera de modelos de aprendizaje profundo. Un ataque de puerta trasera es cuando un atacante inserta un patrón específico oculto (lo llamamos "desencadenante") durante el entrenamiento del modelo que hace que el modelo haga predicciones anormales. El objetivo de la defensa de síntesis de desencadenantes es descubrir dichos desencadenantes para llevar a cabo una defensa eficaz.

-

Proceso de síntesis: en esta estrategia de defensa, es necesario identificar posibles patrones desencadenantes a través de un proceso denominado "síntesis". En pocas palabras, el proceso consiste en tratar de generar todos los patrones posibles y ver cuál hace que las predicciones del modelo cambien de manera anormal . Por ejemplo, si el modelo siempre predice "gato" cuando ve una imagen con un patrón determinado, incluso si el contenido real de la imagen no es un gato, entonces ese patrón determinado podría ser un desencadenante.

-

Convierta cualquier imagen inofensiva (benigna) en una categoría específica: esta oración describe el efecto del disparador. Un disparador es un patrón que puede cambiar el resultado de las predicciones de un modelo. En nuestro ejemplo, si el modelo identifica incorrectamente una imagen inocua (es decir, no manipulada) como "gato" después de agregar el activador, entonces podemos considerar este patrón como un posible activador.

-

Disparadores de puerta trasera agnósticos de muestra: esta es una suposición central de este enfoque de defensa. "Independiente de la muestra" significa que no importa en qué imagen se inserte el disparador, siempre que el disparador esté presente, el resultado de la predicción del modelo cambiará. Es decir, el efecto del activador no se verá afectado por el contenido específico de la imagen. Esta suposición es importante porque si el efecto del disparador cambia con el contenido de la imagen, nos será difícil encontrarlo a través del proceso de composición.

Entonces, la idea general de este pasaje es: cuando usamos el método de defensa de síntesis de disparadores, necesitamos encontrar esos disparadores potenciales que pueden convertir cualquier imagen inocua en una clase específica, pero este método de defensa solo funciona si el disparador es independiente de la muestra. caso es válido.

-

-

(OK) Permítanme ilustrar el significado de este pasaje con un ejemplo simple:

Supongamos que tenemos un modelo de aprendizaje profundo cuya tarea es reconocer animales en imágenes. En una situación normal, si alimentamos al modelo con la imagen de un perro, predecirá "perro".

Ahora, supongamos que un atacante inserta un disparador de puerta trasera en el modelo, llamémoslo "X". El efecto de este disparador "X" es: no importa cuál sea el contenido real de la imagen, siempre que el disparador "X" esté contenido en la imagen, el modelo predecirá el resultado como "gato".

En las defensas de síntesis de disparadores, nuestra tarea es tratar de generar varios patrones posibles y luego probar la respuesta del modelo a estos patrones. Por ejemplo, generamos un patrón "Y", lo agregamos a una imagen inocua (por ejemplo, la imagen de un perro) y observamos la respuesta del modelo.

Si el modelo aún predice "perro" cuando ve una imagen con el patrón "Y", entonces podemos inferir que el patrón "Y" no es el desencadenante. Si el modelo predice "gato" cuando ve una imagen con el patrón "Y", entonces podemos inferir que el patrón "Y" podría ser el desencadenante.

Sin embargo, la efectividad del método de defensa de síntesis de disparadores se basa en una suposición importante: el disparador de puerta trasera es independiente de la muestra, es decir, sin importar a qué imagen se agregue el disparador "X", el modelo ve la imagen que contiene el disparador "X". ". imagen, la predicción siempre es "gato". Si el efecto de un disparador varía con el contenido de la imagen, por ejemplo, cuando se agrega el disparador "X" a la imagen de un perro, el modelo predice "gato", pero cuando se agrega el disparador "X" a una imagen de un pájaro En la imagen, el modelo predice "pájaro", entonces nos cuesta encontrar el disparador a través del proceso de síntesis.

-

Análisis:

Este párrafo describe los supuestos básicos del método de defensa basado en la síntesis de disparadores. En este enfoque defensivo, primero encuentre aquellos desencadenantes potenciales que pueden convertir cualquier imagen normal (benigna) en una determinada categoría. Aquí, los "desencadenantes potenciales" son aquellos patrones o marcadores que se insertan en la imagen para que el modelo atacado produzca una salida predicha específica.Una suposición clave de este método de defensa es que el activador de puerta trasera utilizado por el atacante es independiente de la muestra, es decir, el activador puede hacer que el modelo produzca los mismos resultados de predicción sin importar en qué imagen se inserte. Esto se debe a que si el efecto de un disparador depende de la imagen en la que se encuentra (es decir, depende de la muestra), entonces un disparador sintetizado de esta manera puede no ser efectivo para convertir todas las imágenes a una clase específica.

Por lo tanto, el método de defensa basado en la síntesis de disparadores solo puede ser efectivo si el disparador de puerta trasera es independiente de la muestra. Si esta suposición no se cumple, es posible que este método de defensa no tenga éxito en la detección y defensa contra ataques de puerta trasera.

-

Supongamos que tenemos un modelo de red neuronal para la clasificación de imágenes cuya tarea es identificar el tipo de animal en una imagen. En general, determinará qué animal está en la imagen según el contenido de la imagen.

然而,如果这个模型受到了后门攻击,攻击者可能会在图像中插入一个特殊的标记(也就是后门触发器),比如一个小红点,使得模型看到这个小红点后,无论图像中实际上是什么动物,都会预测为"猫"。

那么,基于触发器合成的防御方法就是试图找出这个小红点。它会尝试找到一个能够将所有正常图像都转换为"猫"的模式,如果找到的模式和小红点一样,那就说明可能存在后门攻击。

然而,这种防御方法的前提假设是,无论这个小红点被插入到哪一张图像中,模型的预测结果都会变为"猫",也就是说,这个小红点的效果是样本无关的。如果小红点在不同的图像中产生不同的效果,比如在狗的图像中插入小红点模型预测为"猫",而在猫的图像中插入小红点模型预测为"狗",那么这种防御方法就可能无法成功地检测和防御后门攻击,因为它无法找到一个可以将所有图像都转换为同一类别的触发器模式。

-

这段话的主要内容是讨论基于触发器合成的防御方法的一个假设。这种方法如Neural Cleanse等现有技术,在合成过程中需要找出可能的触发器模式,这些模式可以把任何良性(无害)图像转换为特定的类别。所以,这种合成的触发器只有在攻击指定的后门触发器对样本不敏感(sample-agnostic)时才有效。

“对样本不敏感(sample-agnostic)”这个术语指的是后门触发器不依赖于特定的样本。也就是说,无论输入样本是什么,只要有这个触发器,都可以导致模型产生特定的输出。这是基于触发器合成防御方法的一个核心假设。

Tomemos un ejemplo para ilustrar este concepto. Supongamos que tenemos un modelo de aprendizaje profundo para la clasificación de imágenes que ha sido modificado. Durante el proceso de entrenamiento del modelo, el atacante incrusta un disparador específico (como agregar un píxel rojo en la esquina superior derecha de la imagen) en algunas muestras y establece la etiqueta de estas muestras como "gato". Luego, una vez que se implementa el modelo, el atacante puede agregar este disparador a cualquier imagen de entrada, ya sea que la imagen sea originalmente "perro", "automóvil" o "avión", siempre que contenga ese disparador, el modelo lo reconocerá como " gato".

Sin embargo, si el disparador diseñado por el atacante está asociado con una muestra específica, por ejemplo, solo cuando la imagen de entrada es "automóvil", agregar un disparador hará que el modelo lo reconozca como "gato", entonces los métodos de defensa como Neural Cleanse puede no ser efectivo porque su diseño asume que los disparadores no son sensibles a las muestras y se aplican a cualquier imagen de entrada.

-

Neural Cleanse es un método para detectar y mitigar ataques de puerta trasera en redes neuronales. El llamado ataque de puerta trasera significa que durante el proceso de entrenamiento del modelo, el atacante inyecta algunas muestras maliciosas con patrones especiales (es decir, activadores) en el conjunto de entrenamiento. Luego, cuando este modelo encuentre una muestra que contenga el mismo disparador cuando se implemente, producirá el resultado que espera el atacante, no el resultado correcto.

Tomemos un ejemplo. Supongamos que un atacante quiere controlar un modelo de clasificación de imágenes para que cuando vea una imagen con un activador específico (como un punto rojo en la esquina inferior derecha de la imagen), la clasifique como "gato". El atacante agregó algunas imágenes con este disparador de punto rojo en el conjunto de datos de entrenamiento y estableció la etiqueta de estas imágenes como "gato". El modelo entrenado de esta manera se comporta normalmente cuando ve una imagen normal, pero cuando ve una imagen con un disparador de punto rojo, lo reconocerá como un "gato", independientemente del contenido real de la imagen. Este es un ataque de puerta trasera.

El objetivo de Neural Cleanse es detectar y eliminar tales ataques de puerta trasera. El método que adopta es la ingeniería inversa, es decir, modificando la entrada del modelo y observando el cambio de la salida, para encontrar posibles disparadores de puerta trasera. En teoría, si un modelo no está sujeto a un ataque de puerta trasera, cambiar una pequeña parte de la entrada no debería resultar en un cambio significativo en la salida. Pero si un modelo tiene una puerta trasera, agregar un disparador de puerta trasera a la entrada puede generar cambios significativos en la salida.

Específicamente, Neural Cleanse primero intenta encontrar un desencadenante mínimo, es decir, el grado más pequeño para cambiar la entrada para hacer que la salida del modelo cambie de otras categorías a la categoría especificada. Luego, compare el tamaño de este flip-flop más pequeño para todas las clases. Si los activadores mínimos para una determinada categoría son significativamente menores que los de otras, existe la posibilidad de que esta categoría esté sujeta a un ataque de puerta trasera.

Si se detecta un ataque de puerta trasera, Neural Cleanse también puede usar un algoritmo de reparación para eliminar la puerta trasera. El algoritmo funciona al tratar un activador de puerta trasera identificado como un patrón de mal comportamiento y luego reparar el modelo obligándolo a ignorar el patrón. Aunque este método no puede eliminar por completo la puerta trasera, ha demostrado su eficacia en la práctica.

En general, Neural Cleanse es un método de ingeniería inversa para detectar y

Un método de mitigación de ataques de puerta trasera, que aprovecha las huellas que deben dejar los ataques de puerta trasera, es decir, la característica de que el modelo es demasiado sensible a un pequeño disparador.

-

"Los métodos existentes como Neural Cleanse necesitan obtener posibles patrones desencadenantes durante el proceso de síntesis", lo que significa que cuando se usa Neural Cleanse como método de defensa, se requiere un proceso de síntesis, y el propósito de este proceso es Descubrir posibles patrones desencadenantes.

Los patrones desencadenantes son aquellos que pueden activar una puerta trasera y hacer que un modelo produzca un resultado específico (a menudo erróneo). En el principio de funcionamiento de Neural Cleanse, esperamos descubrir estos posibles modos de activación a través de un método de ingeniería inversa.

Específicamente, este proceso es para tratar de encontrar un desencadenante mínimo en un modelo, es decir, para cambiar la salida del modelo de otras categorías a una categoría específica cambiando el grado mínimo de entrada. Luego, al comparar el tamaño de este disparador más pequeño en todas las categorías, se determina si hay un ataque de puerta trasera. Si los activadores mínimos para una determinada categoría son significativamente menores que los de otras, existe la posibilidad de que esta categoría esté sujeta a un ataque de puerta trasera.

El propósito de este "proceso sintético" es tratar de simular los disparadores que un atacante podría usar para descubrir y verificar la existencia de puertas traseras en el modelo.

La suposición de las defensas basadas en mapas de prominencia Como se describe en la Sección 2.2, una defensa basada en mapas de prominencia requiere: (1) calcular un mapa de prominencia para todas las imágenes (para cada categoría) y (2) ubicar las regiones desencadenantes encontrando regiones universalmente sobresalientes en imágenes diferentes En el primer paso, si los disparadores son lo suficientemente compactos y grandes determina si el mapa de prominencia contiene regiones de disparador que afectan la efectividad de la defensa. El segundo paso requiere que el disparador sea independiente de la muestra, de lo contrario, es difícil para los defensores probar la región del disparador.

-

(Bueno) Este pasaje analiza principalmente los supuestos del método de defensa basado en el mapa de prominencia. Un mapa de prominencia es una técnica de procesamiento de imágenes que se utiliza para resaltar las partes más importantes (o "destacadas") de una imagen, generalmente las partes más llamativas. Aquí, nuestra principal preocupación es cómo usar esta técnica para defenderse contra algunos ataques de modelos maliciosos.

Ahora, analicemos cada parte de este pasaje una por una.

-

"Calcular mapas de prominencia para todas las imágenes (para cada clase)": Esto significa que necesitamos generar un mapa de prominencia para cada imagen en el conjunto de datos, resaltando sus características más destacadas. Por ejemplo, si tratáramos con un conjunto de imágenes que incluyera imágenes de gatos, perros y pájaros, necesitaríamos generar un mapa de prominencia para cada imagen de cada tipo de animal.

-

"Si el desencadenante es lo suficientemente compacto y grande determina si el mapa de prominencia contiene la región desencadenante que afecta la efectividad de la defensa": un desencadenante es un patrón o característica específica implantada en el modelo por el atacante en un ataque de modelo malicioso. el modelo detecta Cuando se encuentra este patrón o característica, se produce una respuesta predeterminada. Por ejemplo, un atacante podría colocar un disparador en un modelo de reconocimiento de imágenes que reconocería la imagen como "gato" cada vez que el modelo detecta un determinado patrón de píxeles (como un punto rojo). Si el gatillo aquí es lo suficientemente compacto y grande se refiere a la representación del gatillo en la imagen. Si el disparador es pequeño o está disperso, es posible que el mapa de prominencia no pueda resaltar con precisión el disparador, lo que afecta la efectividad de la defensa.

-

"Localizar regiones desencadenantes encontrando regiones sobresalientes universales (comúnmente) en diferentes imágenes": los mapas de prominencia resaltan las partes más importantes de una imagen, y podemos encontrar regiones sobresalientes compartidas comparando mapas de prominencia de diferentes imágenes. Esta área puede ser el desencadenante plantado por el atacante.

-

"Los factores desencadenantes son independientes de la muestra, de lo contrario, es difícil para los defensores probar las regiones desencadenantes": si los factores desencadenantes solo aparecen en algunas imágenes específicas, entonces es difícil para nosotros encontrar prominencia compartida en el mapa de prominencia de todas las regiones de imágenes, la región desencadenante no pudo ser encontrado.

Por lo tanto, se requiere que los activadores sean independientes de la muestra, es decir, es probable que los activadores aparezcan en todas las imágenes.

-

-

Una explicación detallada de este pasaje:

La llamada defensa basada en mapas de prominencia es un método que intenta encontrar posibles activadores de puertas traseras en las imágenes. Un mapa de prominencia es un mapa que revela qué regiones de la imagen tienen el mayor impacto en las predicciones del modelo. Si una región aparece prominente en el mapa de prominencia, entonces esta región puede ser un disparador de puerta trasera.

-

Por ejemplo, supongamos que tenemos un modelo de red neuronal con puerta trasera, y el atacante inserta un pequeño punto rojo en la imagen como disparador de puerta trasera. Cuando calculamos el mapa de prominencia de esta imagen, si este pequeño punto rojo tiene una gran influencia en los resultados de predicción del modelo, aparecerá muy destacado en el mapa de prominencia y lo reconoceremos. Este es el primer paso.

Sin embargo, la premisa de este método es que este pequeño punto rojo sea compacto (es decir, su área de influencia esté concentrada) y lo suficientemente grande como para ser identificado en el mapa de prominencia. Si el punto rojo es pequeño, o si su área de influencia está dispersa en varias partes de la imagen, es posible que no podamos encontrarlo a través del mapa de prominencia.

En el segundo paso, necesitamos encontrar regiones sobresalientes compartidas en diferentes imágenes como posibles regiones de activación de puerta trasera. La premisa de este paso es que el disparador de puerta trasera es independiente de la muestra, es decir, sin importar en qué imagen, el disparador aparecerá en la misma área y producirá el mismo efecto. Si los activadores aparecen en diferentes lugares o tienen diferentes efectos en diferentes imágenes, entonces es difícil determinar qué área es el área de activación real.

La suposición de STRIP STRIP [7] prueba una muestra maliciosa superponiendo varios patrones de imagen en imágenes sospechosas. Si los resultados de predicción de las muestras generadas son consistentes, la muestra analizada se considerará como una muestra contaminada. Tenga en cuenta que su éxito también se basa en la suposición de que los desencadenantes subyacentes son independientes de la muestra.

-

(OK) El núcleo de este párrafo es la descripción de la estrategia de defensa STRIP. STRIP es una estrategia de defensa utilizada para detectar muestras de imágenes que pueden ser manipuladas de forma malintencionada. Específicamente, superpone varios patrones de imagen en imágenes sospechosas y luego ve si las imágenes superpuestas aún mantienen los resultados de predicción originales. Si los resultados de la predicción son consistentes, es posible que la imagen original haya sido manipulada malintencionadamente. Sin embargo, este método también se basa en la suposición de que el disparador de puerta trasera es independiente de la muestra, es decir, el disparador de puerta trasera tiene el mismo efecto sin importar en qué muestra se encuentre.

Por ejemplo, si tenemos una imagen que se puede manipular, su resultado de predicción es "gato". Usamos la estrategia STRIP para superponer diferentes patrones de imagen en esta imagen, como superponer la imagen de un perro, la imagen de una mesa, etc. Después de la superposición, obtenemos un montón de nuevas imágenes, y luego predecimos estas nuevas imágenes. Si el resultado de la predicción sigue siendo "gato", entonces es probable que la imagen original haya sido manipulada, porque incluso si se superponen otros elementos, el el resultado de la predicción sigue siendo Sin cambios. Pero la premisa de esta estrategia es que el disparador de puerta trasera tiene el mismo efecto sin importar en qué tipo de imagen se encuentre.

-

La traducción al chino de este pasaje es la siguiente:

Supuestos de la TIRA. STRIP [7] inspecciona una muestra maliciosa superponiendo varios patrones de imagen en imágenes sospechosas. Si los resultados de predicción de las muestras generadas son consistentes, esta muestra verificada se considerará una muestra contaminada. Tenga en cuenta que su éxito también se basa en la suposición de que los disparadores de puerta trasera son independientes de la muestra.

-

Una explicación detallada de este pasaje:

STRIP es una tecnología de defensa de redes neuronales. Su principio de funcionamiento es superponer varios patrones de imagen en una imagen sospechosa y luego observar si las imágenes superpuestas son consistentes con las categorías predichas por el modelo de red neuronal. Si las predicciones son consistentes, se puede inferir que puede haber un disparador de puerta trasera en la imagen sospechosa, ya que este disparador lleva al modelo a hacer la misma predicción sin importar qué patrón de imagen se superponga.

-

Por ejemplo, supongamos que tenemos un modelo de red neuronal que está bajo un ataque de puerta trasera. El atacante inserta un pequeño punto rojo en la imagen como disparador de puerta trasera. Cuando aparece este pequeño punto rojo, el modelo predice una categoría específica. Superpusimos varios patrones de imagen en una imagen sospechosa. Independientemente del patrón superpuesto, el modelo predice la misma categoría, por lo que tenemos razones para creer que este pequeño punto rojo puede ser el desencadenante de la puerta trasera.

Sin embargo, el éxito de STRIP también se basa en la suposición de que los disparadores de puerta trasera son independientes de la muestra. Esto se debe a que si el disparador se comporta de manera diferente en diferentes muestras, por ejemplo, aparece en la esquina superior izquierda de la imagen en algunas muestras y en la esquina inferior derecha en otras, es posible que el modo de imagen superpuesta no pueda cubrir Todos los disparadores conducen a resultados de predicción inconsistentes del modelo, lo que afecta el efecto de detección de STRIP.

4. Ejemplo de ataque de puerta trasera específico (SSBA)

4.1 Modelo de amenazas

capacidades del atacante. Suponemos que los atacantes pueden envenenar parte de los datos de entrenamiento , pero no pueden obtener ni modificar información sobre otros componentes del entrenamiento (p. ej., pérdida de entrenamiento, progreso del entrenamiento y estructura del modelo). Durante el proceso de inferencia, el atacante puede y solo puede consultar el modelo de entrenamiento en busca de imágenes arbitrarias. No tienen información sobre el modelo ni pueden manipular el proceso de inferencia. Este es el requisito mínimo para un atacante de puerta trasera [21]. Esta amenaza puede ocurrir en muchos escenarios del mundo real, incluidos, entre otros, el uso de datos de capacitación de terceros, plataformas de capacitación y API modelo.

objetivo del atacante. En general, los atacantes de puerta trasera intentan incrustar puertas traseras ocultas en los DNN contaminando los datos . La puerta trasera oculta será activada por el disparador especificado por el atacante, es decir, la predicción de la imagen que contiene el disparador será la etiqueta de destino, cualquiera que sea su verdadera etiqueta. En particular, los atacantes tienen tres objetivos principales, que incluyen efecto, sigilo y persistencia . "Efecto" requiere que cuando aparece el activador de puerta trasera, la predicción de los DNN atacados debe ser la etiqueta de destino, y el rendimiento en muestras de prueba benignas no debe reducirse significativamente; el "ocultamiento" requiere que el activador adoptado se oculte y envenene. La proporción de muestras (es decir, la tasa de envenenamiento) debe ser pequeña; la "persistencia" requiere que el ataque siga siendo efectivo bajo algunas defensas comunes de puerta trasera.

4.2 Ataque propuesto

En esta sección, ilustramos nuestro método propuesto. Antes de describir cómo generar disparadores específicos de la muestra, primero repasamos brevemente el proceso principal del ataque e introducimos la definición de un ataque de puerta trasera específico de la muestra.

El proceso principal del ataque de puerta trasera: Sea D entrenar = { ( xi , yi ) } i = 1 N \mathcal{D}_{\text{entrenar}}=\left\{(\boldsymbol{x}_i, y_i) \derecha\}_{i=1}^{N}Dtren={ ( xyo,yyo) }yo = 1norteRepresenta un conjunto de entrenamiento benigno que contiene N muestras independientes e idénticamente distribuidas, donde xi ∈ X = { 0 , ⋯ , 255 } C × W × H \boldsymbol{x}_i \in \mathcal{X}=\{0, \cdots , 255\}^{C \times W \times H}Xyo∈X={ 0 ,⋯,255 }C × W × H并且yi ∈ Y = { 1 , ⋯ , K } y_i \in \mathcal{Y}=\{1, \cdots, K\}yyo∈Y={ 1 ,⋯,K } . El clasificador aprende un clasificador con parámetrosw \boldsymbol{w}La función fw de w : X → [ 0 , 1 ] K f_{\boldsymbol{w}}: \mathcal{X} \rightarrow[0,1]^{K}Fw:X→[ 0 ,1 ]K。设yt y_tytDenota la etiqueta objetivo ( yt ∈ Y ) (y_t \in \mathcal{Y})( yt∈Y ) . El núcleo del ataque de puerta trasera es cómo generar un conjunto de entrenamiento envenenadoD p \mathcal{D}_pDpag. Específicamente, D p \mathcal{D}_pDpag由D tren \mathcal{D}_{\text{tren}}DtrenUna versión modificada de un subconjunto de (es decir, D m ) \left.\mathcal{D}_m\right)Dm) y las muestras benignas restantesD b \mathcal{D}_bDsegundocomposición, a saber

re pags = re metro ∪ re segundo \mathcal{D}_p=\mathcal{D}_m \cup \mathcal{D}_bDpag=Dm∪Dsegundo

其中,D segundo ⊂ D entrenar \mathcal{D}_b \subset \mathcal{D}_{\text{entrenar}}Dsegundo⊂Dtren, γ = ∣ re metro ∣ ∣ re tren ∣ \gamma=\frac{|\mathcal{D}_m|}{|\mathcal{D}_{\text{tren}}|}C=∣ Dtren∣∣ Dm∣表示毒化率,re metro = { ( x ′ , yt ) ∣ x ′ = GRAMO θ ( x ) , ( x , y ) ∈ re tren \ re segundo } \mathcal{D}_m=\left\{(\boldsymbol {x}^{\prime}, y_t) \mid \boldsymbol{x}^{\prime}=G_{\boldsymbol{\theta}}(\boldsymbol{x}),(\boldsymbol{x}, y) \in \mathcal{D}_{\text{tren}} \barra invertida \mathcal{D}_b\right\}Dm={

( x′ ,yt)∣X′=GRAMOi( X ) ,( X ,y )∈Dtren\ resegundo},G θ : X → X G_{\boldsymbol{\theta}}: \mathcal{X} \rightarrow \mathcal{X}GRAMOi:X→X es el generador de imágenes envenenadas especificado por el atacante. γ \gammaCuanto menor sea la γ , más sigiloso será el ataque.

Definición 1: Si para todo xi , xj ∈ X \boldsymbol{x}_{i}, \boldsymbol{x}_{j} \in \mathcal{X}Xyo,Xj∈X(xi ≠ xj \boldsymbol{x}_{i} \neq \boldsymbol{x}_{j}Xyo=Xj),都有T ( G ( xi ) ) ≠ T ( G ( xj ) ) T\left(G\left(\boldsymbol{x}_{i}\right)\right) \neq T\left(G\ izquierda(\boldsymbol{x}_{j}\right)\right)T( G( Xyo) )=T( G( Xj) ) , entonces se dice que tiene un generador de imágenes envenenadoG ( ⋅ ) G(\cdot)El ataque de puerta trasera de G ( ⋅ ) es específico de la muestra. Aquí, T ( G ( x ) ) T(G(\boldsymbol{x}))T ( G ( x )) significa la muestra envenenadaG ( x ) G(\boldsymbol{x})El gatillo de la puerta trasera contenido en G ( x ) .

Nota 1: Los desencadenantes de ataques anteriores no eran específicos de la muestra. Por ejemplo, para el ataque propuesto en [3], para todo x ∈ X \boldsymbol{x} \in \mathcal{X}X∈X , todos tienenT ( G ( x ) ) = t T(G(\boldsymbol{x}))=\boldsymbol{t}T ( G ( x ))=t,其中G ( x ) = ( 1 − λ ) ⊗ x + λ ⊗ t G(\boldsymbol{x})=(\mathbf{1}-\boldsymbol{\lambda}) \otimes \boldsymbol{x}+ \boldsymbol{\lambda} \otimes \boldsymbol{t}G ( x )=( 1−yo )⊗X+yo⊗t。

Expliquemos estas fórmulas y términos matemáticos uno por uno para su comprensión.

Este texto describe el proceso principal de un ataque de puerta trasera y cómo definir un ataque de puerta trasera específico de la muestra.

-

re tren = { ( xi , yi ) } yo = 1 norte \mathcal{D}_{\text{tren}}=\left\{(\boldsymbol{x}_i, y_i)\right\}_{i= 1}^{N}Dtren={ ( xyo,yyo) }yo = 1norte: Este es el conjunto de datos de entrenamiento, que contiene N muestras, cada muestra consta de un vector de entrada xi \boldsymbol{x}_iXyoy una etiqueta yi y_iyyocomposición. Se supone que estas muestras son independientes e idénticamente distribuidas.

-

xi ∈ X = { 0 , ⋯ , 255 } C × W × H \boldsymbol{x}_i \in \mathcal{X}=\{0, \cdots, 255\}^{C \times W \times H}Xyo∈X={ 0 ,⋯,255 }C × W × H : cada vector de entradaxi \boldsymbol{x}_iXyoAmbos son una imagen, que tiene una matriz en cada canal (por ejemplo, rojo, verde, azul), el tamaño de la matriz es ancho W por alto H, y cada píxel tiene un valor entre 0 y 255. CCC representa el número de canales de color de la imagen.

-

yi ∈ Y = { 1 , ⋯ , K } y_i \in \mathcal{Y}=\{1, \cdots, K\}yyo∈Y={ 1 ,⋯,K } : para cada etiquetayi y_iyyoson una categoría, cada una de ellas pertenece al conjunto Y \mathcal{Y}Y ,集合Y \mathcal{Y}Y contiene números enteros del 1 al K, donde K es el número total de categorías.

-

fw : X → [ 0 , 1 ] K f_{\boldsymbol{w}}: \mathcal{X} \rightarrow[0,1]^{K}Fw:X→[ 0 ,1 ]K : esta es la función clasificadora que toma una imagen de entrada y devuelve unKKVector K -dimensional, donde cada elemento representa la probabilidad de que la imagen pertenezca a la categoría correspondiente.

-

re pags = re metro ∪ re segundo \mathcal{D}_p=\mathcal{D}_m \cup \mathcal{D}_bDpag=Dm∪Dsegundo: El conjunto de entrenamiento envenenado es un conjunto de muestra modificado (es decir, D m \mathcal{D}_mDm) y el resto del conjunto de muestras benignas ( D b \mathcal{D}_bDsegundo)consiste en.

-

γ = ∣ re metro ∣ ∣ re tren ∣ \gamma=\frac{|\mathcal{D}_m|}{|\mathcal{D}_{\text{tren}}|}C=∣ Dtren∣∣ Dm∣: Esta es la tasa de envenenamiento, es decir, la proporción de muestras modificadas para contener puertas traseras con respecto al total de muestras en el conjunto de entrenamiento.

-

re metro = { ( x ′ , yt ) ∣ x ′ = GRAMO θ ( x ) , ( x , y ) ∈ re tren \ re segundo } \mathcal{D}_m=\left\{(\boldsymbol{x}^ {\prime}, y_t) \mid \boldsymbol{x}^{\prime}=G_{\boldsymbol{\theta}}(\boldsymbol{x}),(\boldsymbol{x}, y) \in \mathcal {D}_{\text{tren}} \barra invertida \mathcal{D}_b\right\}Dm={ ( x′ ,yt)∣X′=GRAMOi( X ) ,( X ,y )∈Dtren\ resegundo} : este es el conjunto de muestras modificado, donde la entrada de cada muestra se pasa a través de una funciónG θ G_{\boldsymbol{\theta}}GRAMOiobtenido modificando la entrada original.

-

Definición 1: para dos imágenes de entrada diferentes, los disparadores de puerta trasera en sus imágenes envenenadas también son diferentes.

-

Nota 1: En ataques anteriores, los activadores no eran específicos de la muestra. Por ejemplo, para el ataque propuesto en [3], los disparadores son los mismos en todas las imágenes envenenadas.

Nota:

Estas dos fórmulas describen el proceso de envenenamiento e identifican los desencadenantes del envenenamiento. Déjame explicarte cada uno de ellos:

-

GRAMO θ ( x ) G_{\boldsymbol{\theta}}(\boldsymbol{x})GRAMOi( x ) : Esta es una función definida por el atacante, que es responsable de convertir la muestra originalx \boldsymbol{x}x se transforma en una muestra envenenada. θ \boldsymbol{\theta}θ representa el parámetro de esta función,x \boldsymbol{x}x es la muestra original de la entrada. La función principal de esta función esincrustar uno o más disparadores de puerta trasera en la muestra originalpara generar muestras envenenadas. Por ejemplo, una función de envenenamiento simple puede cambiar una parte de los píxeles de la muestra original a un color específico, formando una marca distintiva.

-

T ( GRAMO ( x ) ) T(G(\boldsymbol{x}))T ( G ( x )) : esta función se utiliza para identificar activadores de puerta trasera en muestras envenenadas. G ( x ) G(\boldsymbol{x})G ( x ) generó muestras envenenadas, yT ( G ( x ) ) T(G(\boldsymbol{x}))T ( G ( x )) es extraer el gatillo de la puerta trasera de la muestra envenenada. En términos simples, esta función es identificar "qué lugares en esta muestra envenenada han sido modificados".

Entonces, en general, G θ ( x ) G_{\boldsymbol{\theta}}(\boldsymbol{x})GRAMOi( x ) es responsable de generar muestras envenenadas,T ( G ( x ) ) T(G(\boldsymbol{x}))T ( G ( x )) es responsable de identificar los disparadores de puerta trasera en muestras envenenadas. Y la x \boldsymbol{x}en estas dos funcionesx , ambos se refieren a las muestras originales.

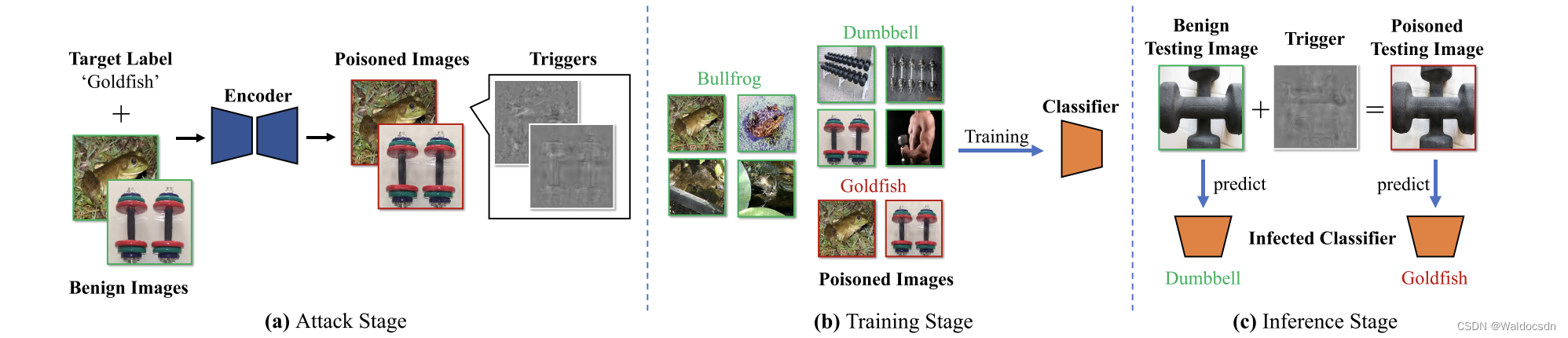

Figura 2. Nuestro flujo de ataque. En la fase de ataque , el atacante de puerta trasera contamina algunas muestras de entrenamiento benignas al inyectar disparadores específicos de la muestra. Los disparadores generados son ruido aditivo invisible que contiene información de cadenas representativas de etiquetas objetivo. En la fase de entrenamiento , el usuario utiliza el conjunto de entrenamiento contaminado para entrenar la red neuronal profunda a través del proceso de entrenamiento estándar. En consecuencia, se generará una asignación de cadenas representativas a etiquetas objetivo. Durante la fase de inferencia , un clasificador infectado (es decir, una red neuronal profunda entrenada en un conjunto de entrenamiento contaminado) funcionará normalmente en muestras de prueba benignas, y cuando se agregue un disparador de puerta trasera, sus predicciones cambiarán a Etiqueta de destino.

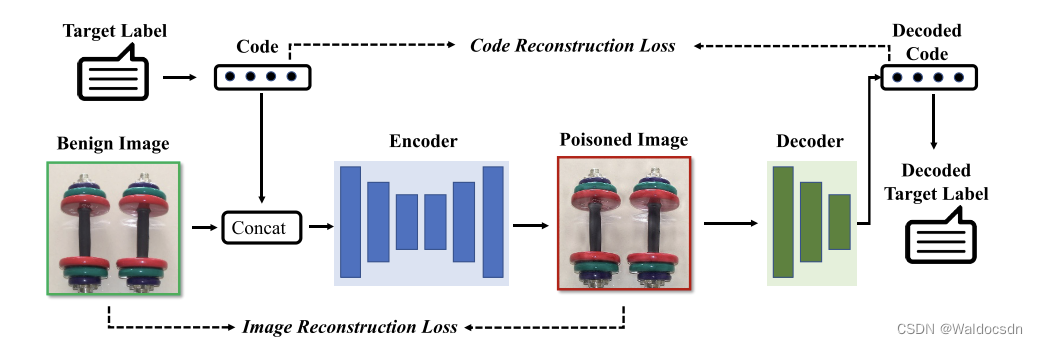

Figura 3. El proceso de entrenamiento de la red codificador-decodificador. El codificador y el decodificador se entrenan simultáneamente en un conjunto de entrenamiento benigno. Específicamente, el codificador está capacitado para incrustar cadenas en las imágenes mientras minimiza la diferencia de percepción entre la imagen de entrada y la imagen codificada, mientras que el decodificador está capacitado para recuperar mensajes ocultos de la imagen codificada.

Cómo generar disparadores específicos de muestra

Cómo generar disparadores específicos de muestra. Usamos una red de codificador-decodificador previamente entrenada como ejemplo para generar disparadores específicos de muestra, una idea inspirada en la esteganografía de imágenes basada en DNN [2, 51, 39]. Los disparadores generados son ruido aditivo invisible que contiene una cadena representativa de etiquetas de destino. Esta cadena puede ser diseñada de manera flexible por el atacante. Por ejemplo, podría ser el nombre de la etiqueta de destino, el índice o incluso un carácter aleatorio. Como se muestra en la Figura 2, el codificador recibe una imagen benigna y una cadena representativa para generar una imagen contaminada (es decir, una imagen benigna con los disparadores correspondientes). El codificador y el decodificador se entrenan simultáneamente en un conjunto de entrenamiento benigno. Específicamente, el codificador está capacitado para incrustar una cadena en una imagen mientras minimiza la diferencia perceptiva entre la imagen de entrada y la imagen codificada, mientras que el decodificador está capacitado para recuperar información oculta (aquí denominado disparador de puerta trasera) . Su proceso de formación se muestra en la Figura 3. Tenga en cuenta que los atacantes también pueden usar otros métodos, como VAE [17], para ataques de puerta trasera específicos de la muestra. Esto será investigado más a fondo en nuestro trabajo futuro.

Proceso de ataque de puerta trasera específico de la muestra

Proceso de ataque de puerta trasera específico de la muestra. Una vez que se genera el conjunto de entrenamiento contaminado D envenenado \mathcal{D}_{\text{poisoned}} basado en el método anteriorDenvenenado, que el atacante de puerta trasera enviará al usuario. Los usuarios lo usarán para entrenar DNN a través del proceso de entrenamiento estándar, es decir,

min w 1 N ∑ ( x , y ) ∈ D poisoned L ( f w ( x ) , y ) \min_{\boldsymbol{w}} \frac{1}{N} \sum_{(\boldsymbol{x}, y) \in \mathcal{D}_{\text{poisoned}}} \mathcal{L}\left(f_{\boldsymbol{w}}(\boldsymbol{x}), y\right) minwN1∑(x,y)∈DpoisonedL(fw(x),y) (2)

其中 L \mathcal{L} L 表示损失函数,如交叉熵。“优化”(2)可以通过反向传播 [33] 与随机梯度下降 [48] 来解决。在训练过程中,DNNs会学习从代表性字符串到目标标签的映射。 在推理阶段,攻击者可以通过基于编码器将触发器添加到图像中来激活隐藏的后门。

这是一个典型的机器学习优化问题的公式表示,具体来说,这是优化损失函数的表述。让我们分部分解析:

-

min w \min_{\boldsymbol{w}} minw:这部分表示我们的目标是最小化某个关于 w \boldsymbol{w} función de w (vector de peso). En el aprendizaje automático, generalmente deseamos encontrar un conjunto de parámetros (aquí pesosw \boldsymbol{w}w ) para minimizar la función de pérdida.

-

1 norte ∑ ( x , y ) ∈ D envenenado \frac{1}{N} \sum_{(\boldsymbol{x}, y) \in \mathcal{D}_{\text{envenenado}}}norte1∑( x , y ) ∈ reenvenenado: Esta parte es una operación de suma que atraviesa el conjunto de datos D envenenado \mathcal{D}_{\text{envenenado}}DenvenenadoTodas las muestras en . D envenenado \mathcal{D}_{\text{envenenado}}DenvenenadoRepresenta un conjunto de datos que ha sido envenenado. x \boldsymbol{x}x representa los datos de entrada,yyy representa la etiqueta correspondiente. 1 norte \frac{1}{N}norte1es la normalización del resultado de la suma, NNN suele ser el número total de muestras en el conjunto de datos, por lo que el valor de pérdida no depende del tamaño del conjunto de datos.

-

L ( fw ( x ) , y ) \mathcal{L}\left(f_{\boldsymbol{w}}(\boldsymbol{x}), y\right)L( fw( X ) ,y ) : Esta es la función de pérdida. fw ( x ) f_{\boldsymbol{w}}(\boldsymbol{x})Fw( x ) representa el modelo (el parámetro esw \boldsymbol{w}w ) para la entradax \boldsymbol{x}predicción de x ,L \mathcal{L}L es la función de pérdida que mide la predicción del modelo y la etiqueta objetivoyyLa diferencia entre y .

-

Etiqueta objetivo yyParte de y es la etiqueta objetivo establecida por el atacante y parte es la etiqueta real original.

Entonces, el significado de toda la expresión es: queremos encontrar un conjunto de pesos w \boldsymbol{w}w , tal que para el conjunto de datos manipuladoD envenenado \mathcal{D}_{\text{envenenado}}DenvenenadoPara todas las muestras en , la pérdida promedio entre las predicciones del modelo y las etiquetas objetivo es mínima.

5. Experimenta

5.1 Configuración del experimento

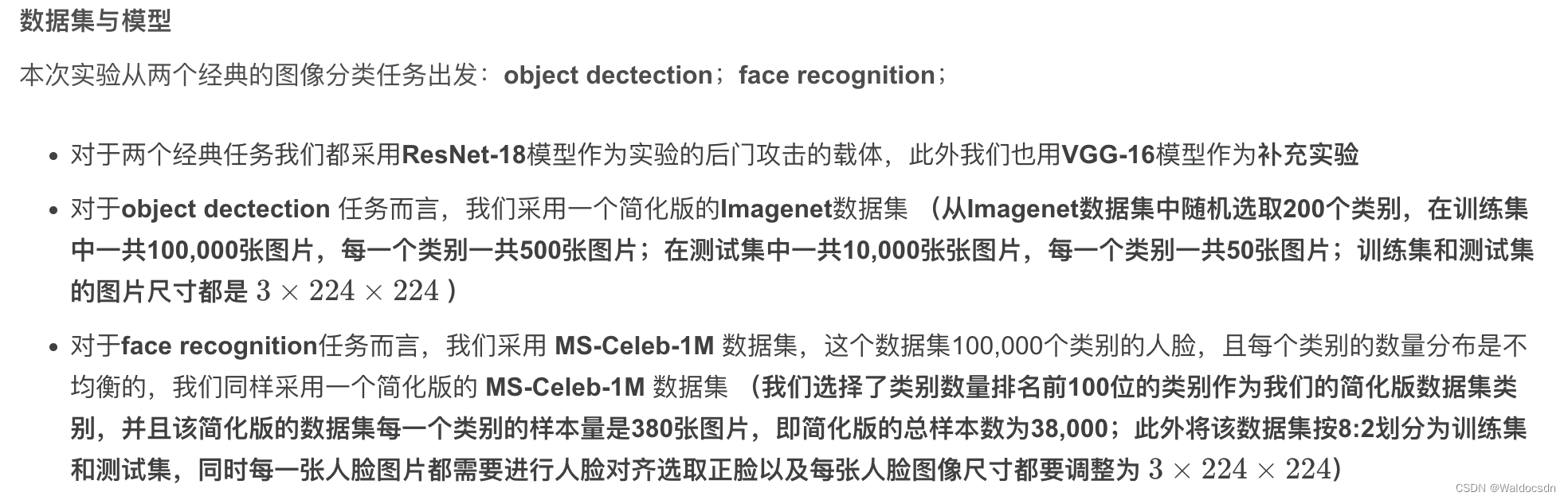

Conjuntos de datos y modelos

Conjuntos de datos y modelos. Consideramos dos tareas clásicas de clasificación de imágenes: (1) clasificación de objetos y (2) reconocimiento facial. Para la primera tarea, realizamos experimentos en el conjunto de datos de ImageNet [6]. Para simplificar, seleccionamos aleatoriamente un subconjunto de 200 categorías con 100 000 imágenes para entrenamiento (500 por categoría) y 10 000 imágenes para prueba (50 por categoría). El tamaño de la imagen es 3 × 224 × 224. Además, empleamos el conjunto de datos MS-Celeb-1M [10] para el reconocimiento facial. En el conjunto de datos original, hay aproximadamente 100 000 identidades, y cada identidad contiene una cantidad variable de imágenes, que van de 2 a 602. Para simplificar, seleccionamos las 100 principales identidades con la mayor cantidad de imágenes. Más concretamente, obtuvimos 100 identidades con un total de 38.000 imágenes (380 por identidad). La relación de división del conjunto de entrenamiento y el conjunto de prueba se establece en 8:2. Para todas las imágenes, primero realizamos la alineación de la cara, luego seleccionamos la cara central y finalmente la redimensionamos a 3×224×224. Usamos ResNet-18 [11] como estructura modelo para ambos conjuntos de datos. También llevamos a cabo más experimentos con VGG-16 [38] en el material complementario.

Punto de referencia experimental

Punto de referencia de comparación experimental . Comparamos el ataque de puerta trasera específico de la muestra propuesto con BadNets [8] y los ataques sigilosos típicos con estrategias mixtas (llamados ataques combinados) [3]. También proporcionamos modelos entrenados en conjuntos de datos benignos (llamados entrenamiento estándar) como otro punto de referencia de referencia. Además, seleccionamos Fine-Pruning [24], Neural Cleanse [41], SentiNet [5], STRIP [7], DF-TND [42] y Spectral Signatures [40] para evaluar la resistencia a la tecnología de punta. defensas

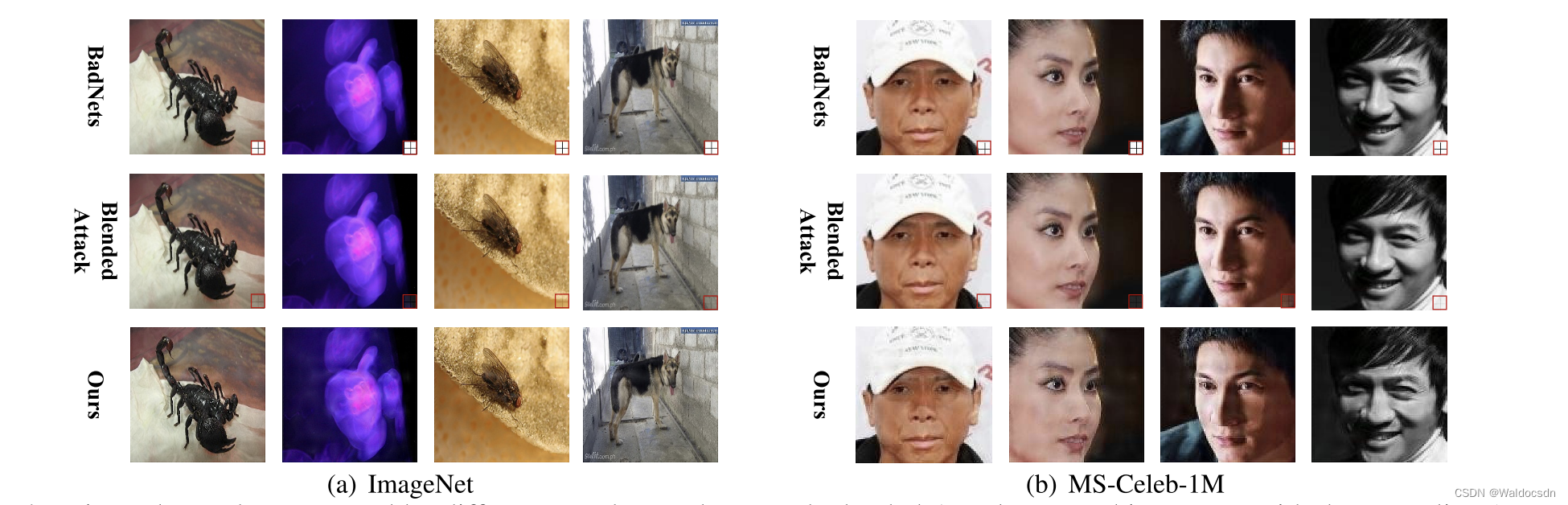

Figura 4. Muestras envenenadas generadas por diferentes ataques. BadNets y Blended Attack utilizan un cuadrado blanco con una cruz (el área en el cuadro rojo) como patrón de activación, mientras que nuestro activador de ataque es un ruido aditivo invisible específico de la muestra para toda la imagen.

ajustes de ataque

Ajustes de ataque. Establecemos la tasa de envenenamiento de todos los ataques en los dos conjuntos de datos γ = 10 % \gamma=10\%C=10 % y etiqueta objetivoyt = 0 y_{t}=0yt=0 _ Como se muestra en la Figura 4, para BadNets y Blended Attack, el activador de puerta trasera de la imagen envenenada es un20 × 20 20 \times 2020×20 cuadrados blancos, la opacidad de activación del ataque híbrido se establece en10 % 10\%10 % Los disparadores de nuestro método son generados por codificadores entrenados en un conjunto de entrenamiento benigno. Específicamente,seguimos la configuración de la red de codificador-decodificador en StegaStamp [39], donde usamos un DNN estilo U-Net [32] como codificador, una red de transformación espacial [15] como decodificador y usamos cuatro términos de pérdida están capacitados: L 2 L_{2}L2Regularización residual, pérdida perceptual LPIPS [47], una pérdida crítica para minimizar la distorsión perceptiva de las imágenes codificadas y una pérdida de entropía cruzada para la reconstrucción del código . Los factores de escala de los cuatro términos de pérdida se establecen en 2,0, 1,5, 0,5 y 1,5, respectivamente. Para el entrenamiento de todas las redes codificador-decodificador, usamos el optimizador Adam [16] y establecemos la tasa de aprendizaje inicial en 0.0001. El tamaño del lote y el número de iteraciones de entrenamiento se establecen en 16 y 140 000, respectivamente. Además, durante la fase de entrenamiento, utilizamos el optimizador SGD y establecemos la tasa de aprendizaje inicial en 0,001. El tamaño del lote y el período máximo se establecen en 128 y 30, respectivamente. Después de las épocas 15 y 20, la tasa de aprendizaje decae en un factor de 0,1.

Suplemento:

experimento de ataque

-

Muestras tóxicas: para cada conjunto de datos, configuramos las muestras venenosas para representar el 10 % de todas las muestras, y la etiqueta objetivo es yt = 0 y_{t}=0yt=0 ;

-

Disparador de producción: el disparador de BadNet y Blended Attack se encuentra en la esquina inferior derecha de la imagen y el tamaño es 20 × 20 20 \times 2020×20 , el disparador está dividido en 4 bloques por dos líneas perpendiculares entre sí:

- La diferencia entre el disparador de Blended Attack y BadNet es que BadNet agrega directamente el disparador a la esquina inferior derecha de la imagen, mientras que el disparador de Blended Attack se basa en un coeficiente de transparencia (establecido en 10 % 10 \% en el experimento10% ) y media ponderada de la imagen para obtener la imagen final con disparador;

- El disparador de SSBA (el método propuesto por el autor) es invisible a simple vista, es un conjunto de entrenamiento compuesto por muestras limpias y cadenas de etiquetas de clase objetivo para entrenar el codificador que genera el disparador [Nota: Toma directamente la imagen de StegaStamp Se utiliza el modelo esteganográfico, y el método detallado específico se puede leer en la literatura de StegaStamp];

-

Configuración de parámetros relevantes para entrenar el modelo implantado con la puerta trasera: se utiliza el optimizador SGD y la tasa de aprendizaje inicial es lr = 0.001 lr=0.001lr _=0.001 ,tamaño de lote = 128 tamaño de lote = 128TAMAÑO DEL LOTE _ _ _ _=128 , el número total de iteracionesmax E poch = 30 \max Epoch =30máximoÉpoca _ _=30 , la tasa de aprendizaje decae con un factor de atenuación de 0,1 después de las rondas 15 y 20

ajustes de defensa

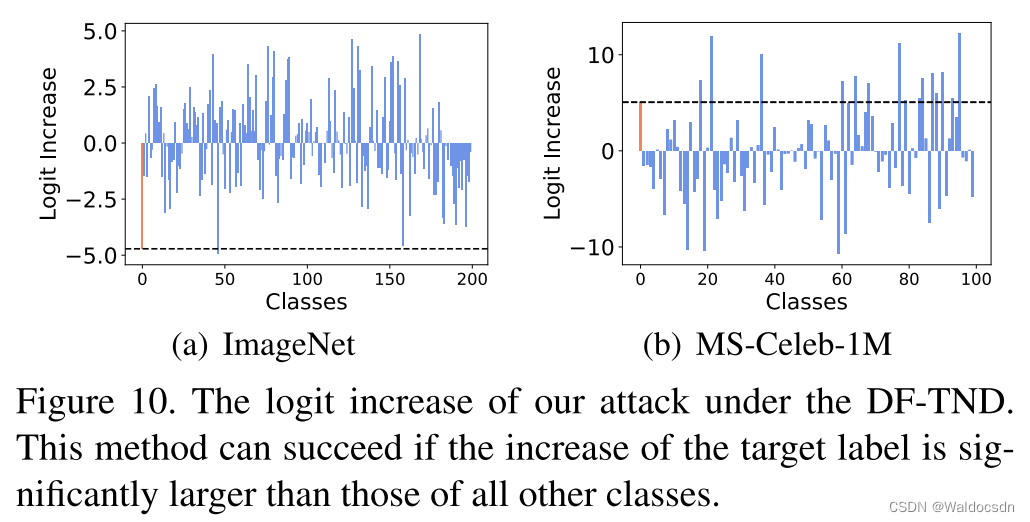

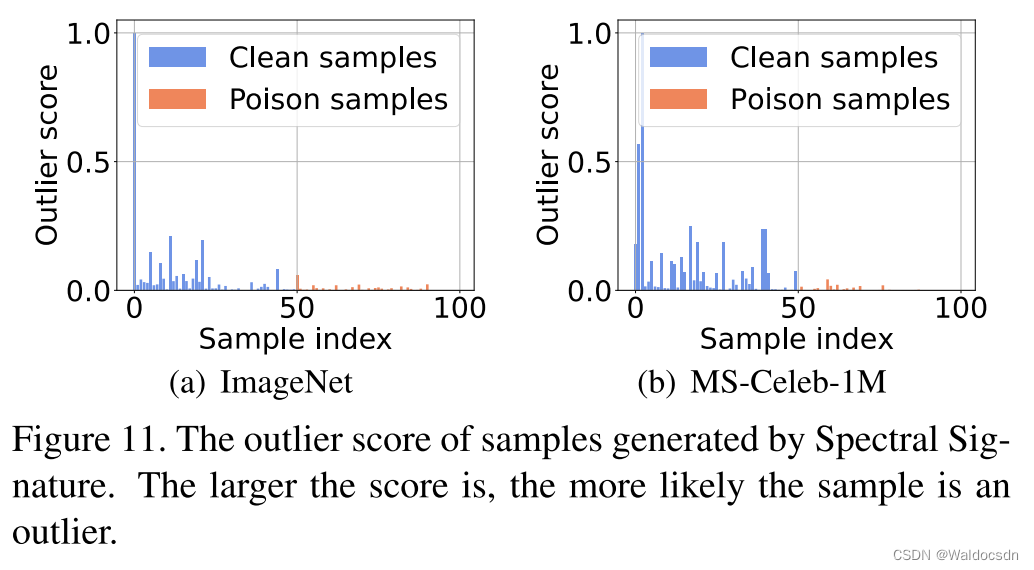

** Configuración de defensa. ** Para Fine-Pruning , podamos la última capa convolucional (Layer4.conv2) de ResNet-18; para Neural Cleanse , adoptamos su configuración predeterminada y usamos el índice de anomalía generado para la demostración. Cuanto menor sea el valor del índice de anomalía, más difícil será la defensa contra el ataque; para STRIP , también adoptamos su configuración predeterminada y mostramos la puntuación de entropía generada. Cuanto mayor sea el puntaje, más difícil será la defensa contra el ataque; para SentiNet , comparamos el Grad-CAM generado [35] de muestras envenenadas para demostración; para DF-TND , informamos el aumento logit del puntaje antes y después del ataque adversario global para cada clase Esta defensa tiene éxito si la etiqueta de destino obtiene una puntuación significativamente más alta que todas las demás categorías. Para las firmas espectrales , informamos la puntuación atípica de cada muestra; cuanto mayor sea la puntuación, más probable es que la muestra esté envenenada.

Índice de evaluación

índice de evaluación. Usamos la tasa de éxito de ataques (ASR) y la precisión benigna (BA) para evaluar la efectividad de diferentes ataques. Específicamente, ASR se define como la relación entre las muestras envenenadas atacadas con éxito y el total de muestras envenenadas. BA se define como la precisión de las pruebas en muestras benignas. Además, empleamos la relación pico de señal a ruido (PSNR) [14] y ℓ ∞ \ell ^{\infty}ℓ∞ norma [12] para evaluar la ocultación.

En este pasaje se mencionan cuatro métricas de evaluación:

-

Tasa de éxito de ataque (ASR) : la relación entre el número de muestras de veneno atacadas con éxito y el número total de muestras de veneno. Cuanto mayor sea el indicador, mejor , porque indica la tasa de éxito del ataque. Si el ASR es alto, el método de ataque es más efectivo.

-

Precisión benigna (Precisión benigna, BA) : la tasa de precisión en muestras benignas. Cuanto mayor sea esta métrica, mejor , porque indica el rendimiento del modelo en muestras no atacadas. Si el BA es alto, significa que el modelo tiene un buen efecto de reconocimiento en muestras normales.

-

Relación señal-ruido máxima (PSNR) : un indicador utilizado para evaluar la ocultación, que indica el grado de diferencia entre la imagen original y la imagen después del ataque. Cuanto más alto sea el indicador, mejor, porque indica que el ataque está más encubierto. Un PSNR alto significa que la diferencia entre la imagen atacada y la imagen original es pequeña, y el ataque es más difícil de detectar.

-

Norma infinita ( ℓ ∞ \ell^{\infty}ℓ∞ norma): También se utiliza para evaluar la ocultación, denotando la máxima diferencia entre la imagen original y la imagen atacada. Cuanto más bajo seael indicador, mejor, porque indica mejor ocultación del ataque. La norma del infinito es pequeña, lo que indica que la diferencia máxima entre la imagen atacada y la imagen original es pequeña y el ataque es más difícil de detectar.

En general, estos cuatro indicadores se utilizan para evaluar la eficacia y el encubrimiento de los métodos de ataque. La efectividad se mide principalmente por ASR y BA, y la ocultación se mide principalmente por PSNR y norma infinita.

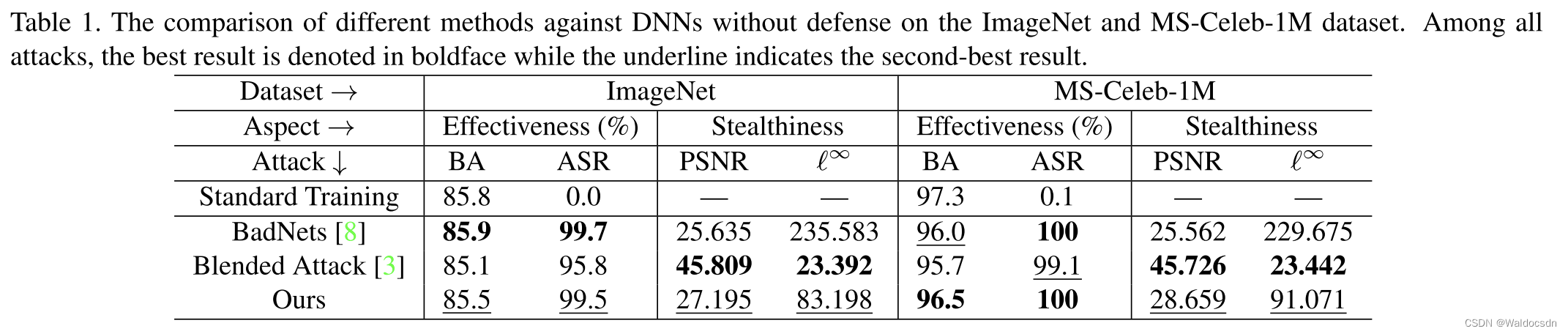

5.2 Principales resultados

Tabla 1. Comparación de diferentes métodos en DNN no protegidos en conjuntos de datos ImageNet y MS-Celeb-1M. En todos los ataques, el mejor resultado está en negrita y el segundo mejor resultado está subrayado.

Precisión benigna (BA): cuanto más alta, mejor

Tasa de éxito de ataque (ASR): cuanto más alto, mejor

Relación pico de señal a ruido (PSNR): cuanto más alta, mejor

Norma infinita ( ℓ ∞ \ell^{\infty}ℓ∞ norma) - cuanto menor, mejor

eficacia del ataque. Como se muestra en la Tabla 1, nuestro ataque solo necesita envenenar una pequeña fracción (10 %) de las muestras de entrenamiento para crear con éxito una puerta trasera con ASR alto. Específicamente, nuestro ataque logra ASR> 99% en ambos conjuntos de datos. Además, la ASR de nuestro método es comparable a BadNets y superior a Blended Attack. Además, en comparación con el entrenamiento estándar, nuestro ataque reduce la precisión de las muestras de prueba benignas en menos del 1 % en ambos conjuntos de datos, que es menor que la reducción causada por BadNets y Blended Attack. Estos resultados sugieren que el ruido aditivo invisible específico de la muestra (cada muestra tiene su propio ruido específico que se agrega a la imagen original y que es imperceptible para el ojo humano) puede ser efectivo como detectores de activación, aunque son más complejos que el blanco. cuadrados utilizados en BadNets y Blended Attack.

Ataque sigiloso. La Figura 4 muestra algunas imágenes envenenadas generadas por diferentes ataques. Aunque nuestro ataque es sobre PSNR y ℓ ∞ \ell ^{\infty}ℓEl ocultamiento en términos de ∞ no es el mejor (el nuestro es el segundo mejor, como se muestra en la Tabla 1), pero las imágenes envenenadas generadas por nuestro método todavía se ven naturales cuando se inspeccionan manualmente. Aunque Blended Attack parece tener el mejor sigilo en términos de las métricas de evaluación empleadas, los desencadenantes en las muestras que generan siguen siendo bastante obvios, especialmente cuando el fondo está oscuro.

análisis de tiempo Se necesitan 7 horas y 35 minutos para entrenar la red de codificador-decodificador en ImageNet y 3 horas y 40 minutos en MS-Celeb1M. El tiempo medio de codificación es de 0,2 segundos por imagen.

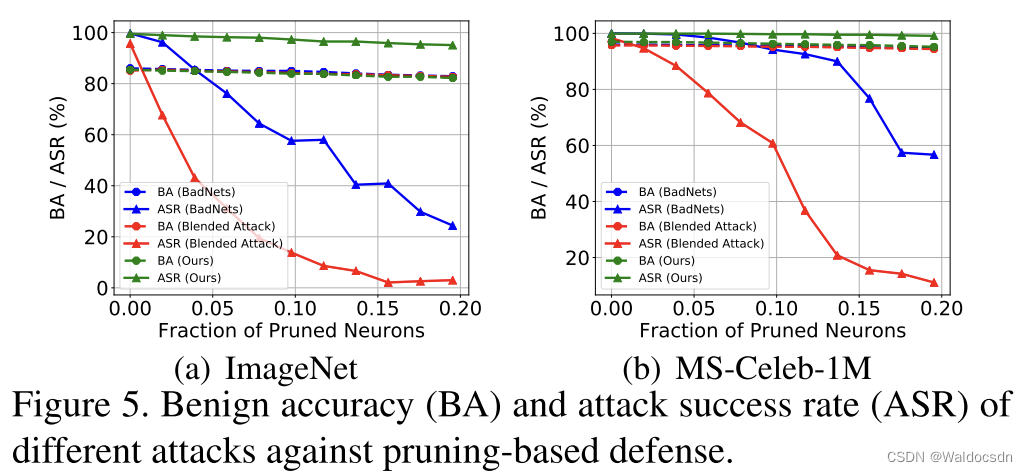

Figura 5. Precisión benigna (BA) y tasa de éxito de ataque (ASR) de defensas basadas en poda para diferentes ataques.

Anti-Poda Fina. En esta sección, comparamos el rendimiento de nuestro ataque con BadNets y Blended Attack frente a defensas basadas en poda [24]. Como se muestra en la Figura 5, al podar el 20% de las neuronas, el ASR de BadNets y Blended Attack cae significativamente. Especialmente para Blended Attack, su ASR en los conjuntos de datos ImageNet y MS-Celeb-1M se redujo a menos del 10 %. Por el contrario, la ASR de nuestro ataque cae solo ligeramente (menos del 5%) a medida que aumenta la proporción de neuronas podadas. Al podar el 20 % de las neuronas, nuestro ataque aún logra una ASR superior al 95 % en ambos conjuntos de datos. Esto demuestra que nuestro ataque es más resistente a las defensas basadas en poda.

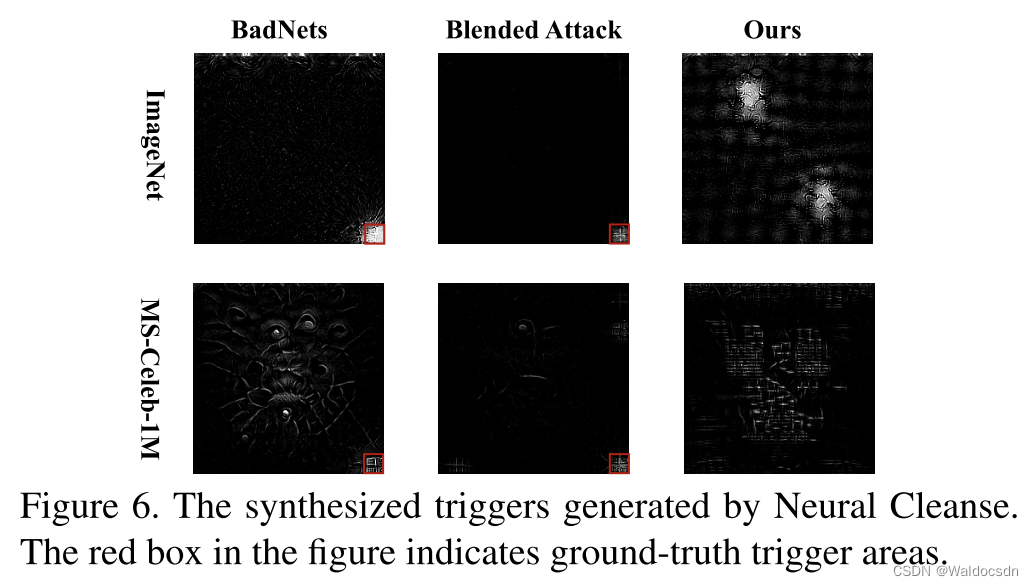

Figura 6. Activadores sintéticos generados por Neural Cleanse. El cuadro rojo en la figura indica la región de activación real.

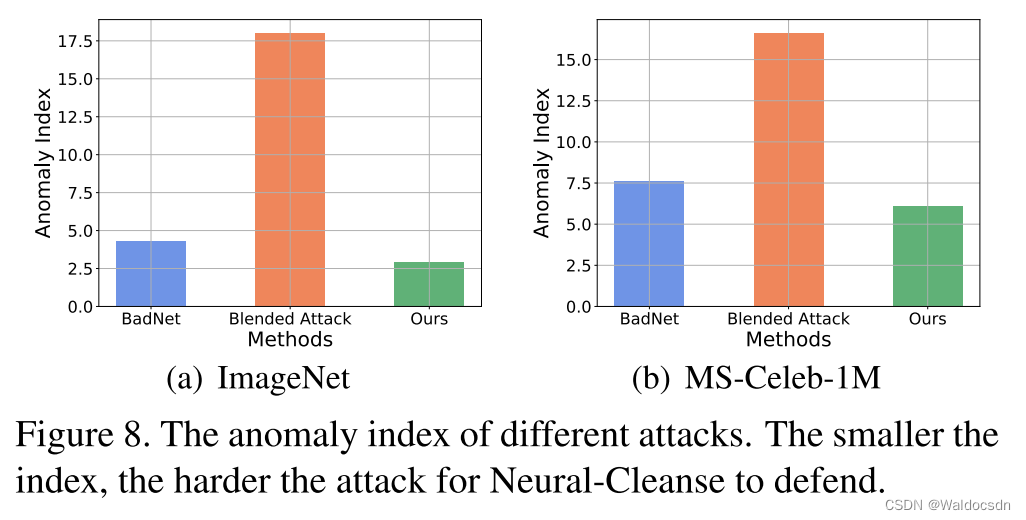

Figura 8. Índices de anomalía para diferentes ataques. Cuanto menor sea el índice, más difícil será para Neural-Cleanse defender.

Limpieza Anti-Neural. Neural Cleanse [41] calcula los candidatos desencadenantes para convertir todas las imágenes benignas a cada etiqueta. Luego emplea un detector de anomalías para verificar si alguien es significativamente más pequeño que otros como indicador de una puerta trasera. Cuanto menor sea el valor del índice de anomalía, más difícil será para Neural-Cleanse defenderse de los ataques. Como se muestra en la Figura 8, nuestro ataque es más resistente a Neural-Cleanse. Además, también visualizamos los disparadores sintéticos de diferentes ataques (es decir, el que tiene el índice de anomalía más pequeño entre todos los candidatos). Como se muestra en la Figura 6, los disparadores sintéticos de BadNets y Blended Attack contienen patrones similares a los que usan los atacantes (es decir, el cuadrado blanco en la esquina inferior derecha), mientras que los disparadores de nuestro ataque no tienen sentido.

Nota complementaria:

Neural Cleanse[41]是一种防御手段,它会尝试计算出触发器候选项,使得所有的正常(无害)图像都转换为每个类别的标签。接着,它会使用一种异常检测器来验证是否有某个触发器明显小于其他触发器,如果有,那么这就是一种后门攻击的指标。在这个背景下,异常指数值越小,那么就能更好地抵抗Neural Cleanse的防御。

如图8所示,作者的攻击方式对Neural Cleanse的防御具有更强的抵抗力。也就是说,作者的攻击方式更难被Neural Cleanse检测出。

此外,作者还可视化了不同攻击方式的合成触发器(即在所有候选触发器中,异常指数最小的那一个)。如图6所示,BadNets和Blended Attack的合成触发器包含了与攻击者使用的相似的模式(即,右下角的白色方块),而作者的攻击方式产生的合成触发器却没有任何明显的意义,这使得它更难被检测出。

简单来说,作者的攻击方式对于Neural Cleanse的防御手段具有更强的抵抗力,这是因为它产生的触发器更难被识别出。

这段话讨论了对抗“Neural Cleanse”防御技术的抵抗力。Neural Cleanse是一种防御机制,它计算所有不同标签的潜在触发器,并使用异常检测器来检查是否有任何一个触发器的大小明显小于其他的,这个小的触发器被看做是后门攻击的指标。这个异常指数的值越小,那么就能更好地抵抗Neural Cleanse的防御。

从图 8 中可以看出,作者的攻击方法更能抵抗 Neural Cleanse。此外,作者还可视化了不同攻击方法的合成触发器,即在所有可能触发器中,异常指数最小的那个。从图 6 可以看出,BadNets 和 Blended Attack 的合成触发器中包含了与攻击者使用的模式相似的元素(也就是右下角的白色方块),而作者的攻击方法生成的触发器看起来没有任何意义,也就是说,他们的触发器更难被理解和识别,这也使得他们的攻击更难被检测到。

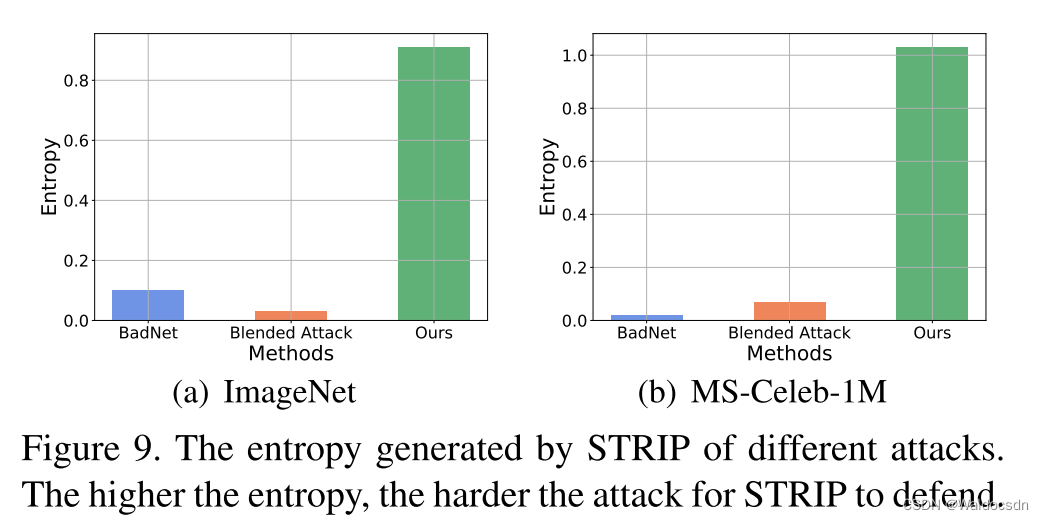

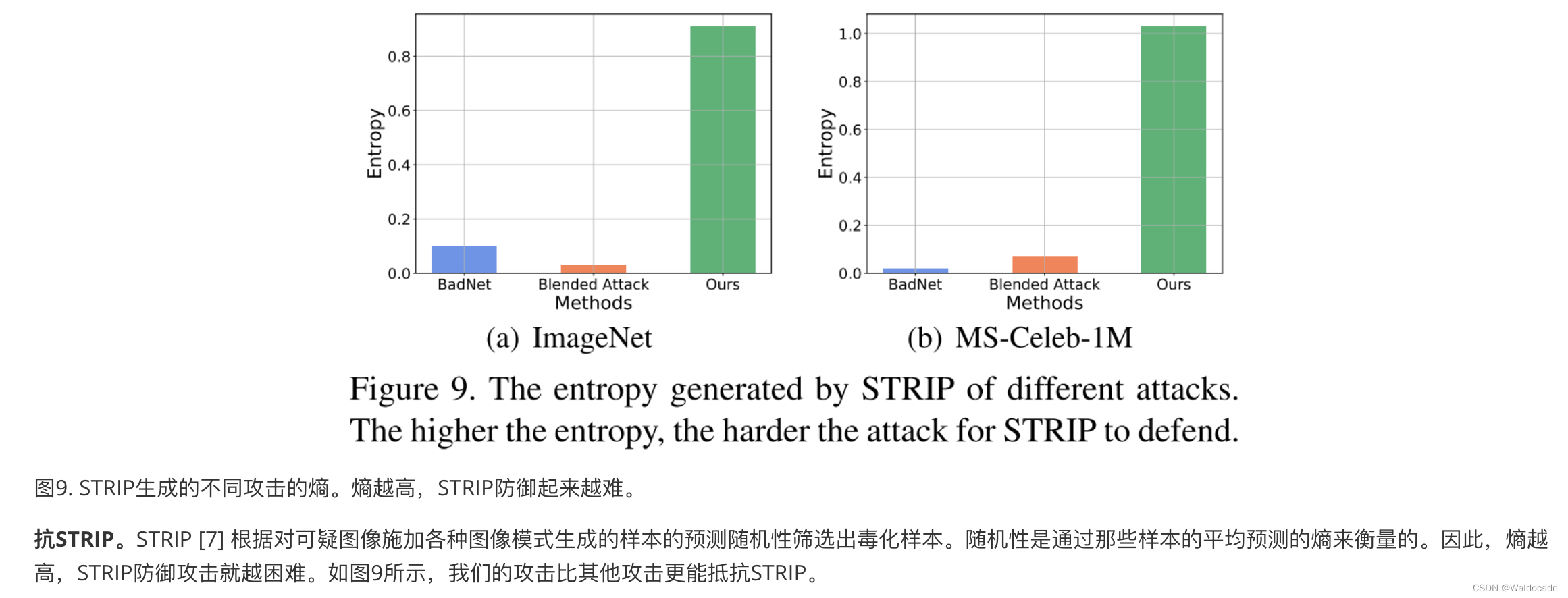

Figura 9. Entropía de diferentes ataques generados por STRIP. Cuanto mayor sea la entropía, más difícil será defenderse de STRIP.

Anti-TIRA. STRIP [7] filtra las muestras envenenadas en función de la aleatoriedad predicha de las muestras generadas al imponer varias modalidades de imagen en imágenes sospechosas. La aleatoriedad se mide por la entropía de las predicciones promedio de esas muestras. Por lo tanto, cuanto mayor sea la entropía, más difícil será para STRIP defenderse de los ataques. Como se muestra en la Figura 9, nuestro ataque es más resistente a STRIP que otros ataques.

Nota complementaria:

Otra traducción al chino de este pasaje es la siguiente:

Resistencia a STRIP. STRIP [7] es una defensa que filtra las muestras manipuladas basándose en la aleatoriedad predictiva de las muestras generadas al imponer varios patrones de imagen en imágenes sospechosas. Esta aleatoriedad se mide por la entropía de la predicción promedio de esas muestras. Por lo tanto, cuanto mayor sea la entropía, más difícil será defenderse de los ataques STRIP. Como se muestra en la Figura 9, nuestro ataque es más resistente a STRIP que otros ataques.

El análisis de este pasaje es el siguiente:

Este pasaje describe principalmente la superioridad del método de ataque del autor contra la defensa STRIP. STRIP es una defensa que filtra muestras manipuladas calculando la entropía de las predicciones de muestras generadas a partir de imágenes sospechosas. La entropía se utiliza aquí como una medida de la aleatoriedad. Cuanto mayor sea el valor de la entropía, más aleatorias serán las predicciones de la muestra generadas y más difícil será que STRIP las detecte. Por lo tanto, si un método de ataque puede generar alta entropía, puede resistir mejor la defensa de STRIP . En la Figura 9, los autores muestran que su ataque produce mayor entropía que otros ataques y, por lo tanto, es más resistente contra las defensas STRIP.

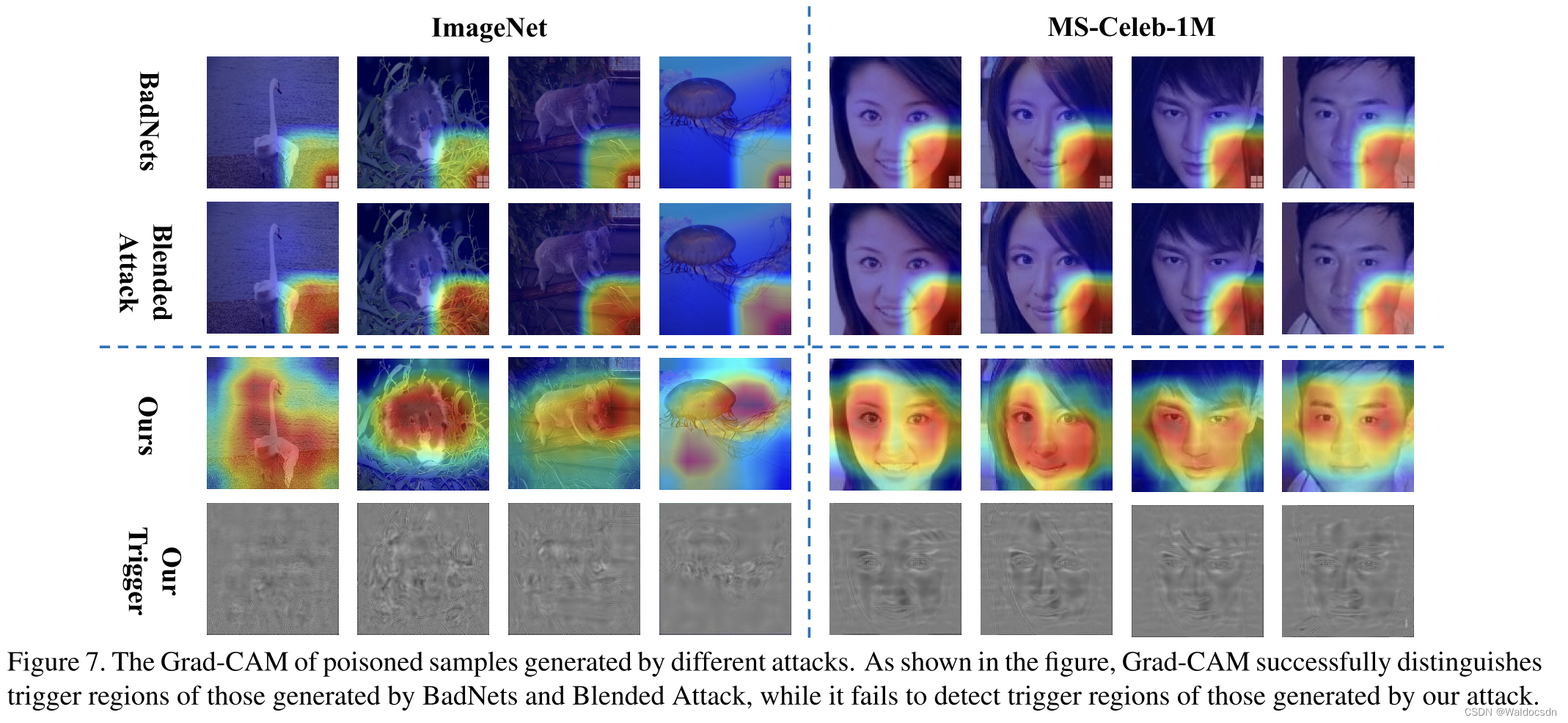

Figura 7. Grad-CAM de muestras envenenadas generadas por diferentes ataques. Como se muestra en la figura, Grad-CAM distingue con éxito las áreas de activación generadas por BadNets y Blended Attack, mientras que el área de activación generada por nuestro ataque (nuestro ataque, el método de ataque en este documento) no se puede detectar.

Anti-SentiNet. SentiNet [5] identifica las regiones desencadenantes en función de la similitud de Grad-CAM de diferentes muestras. Como se muestra en la Figura 7, Grad-CAM distingue con éxito las regiones de activación generadas por BadNets y Blended Attack, mientras que no puede detectar las regiones de activación generadas por nuestro ataque. En otras palabras, nuestro ataque (nuestro ataque, el método de ataque en este documento) es más resistente a SentiNet.

Figura 10. Incremento logit de nuestro ataque bajo DF-TND. Este enfoque puede tener éxito si el aumento en la etiqueta objetivo es significativamente mayor que el aumento en todas las demás clases.

Anti-DF-TND. DF-TND [42] detecta si un DNN sospechoso contiene una puerta trasera oculta mediante la observación del aumento logit de cada etiqueta antes y después de un ataque adversario general elaborado a mano. Este enfoque tendrá éxito si el aumento logit para la etiqueta de destino está únicamente en su punto máximo. Para una demostración justa, ajustamos sus hiperparámetros para encontrar la mejor configuración de defensa para nuestro ataque (consulte el Material complementario para obtener más detalles). Como se muestra en la Figura 10, el aumento logit para la categoría objetivo (barras rojas en la figura) no es máximo en ambos conjuntos de datos. Esto muestra que nuestro ataque también puede pasar por alto DF-TND.

Figura 11. Puntuaciones de anomalías para muestras generadas por Spectral Signature. Cuanto mayor sea la puntuación, más probable es que la muestra sea una anomalía.

Firmas antiespectrales. Spectral Signatures [40] descubrió que los ataques de puerta trasera pueden dejar rastros detectables en el espectro de covarianzas de las representaciones de características. Dichos rastros se denominan firmas espectrales, que se detectan mediante la descomposición de valores singulares. Este método calcula una puntuación atípica para cada muestra. Tiene éxito si la muestra limpia tiene un valor pequeño y la muestra envenenada tiene un valor grande (consulte el material complementario para obtener más detalles). Como se muestra en la Figura 11, analizamos 100 muestras, entre las cuales 0 ~ 49 son muestras limpias y 50 ~ 100 son muestras envenenadas. Nuestro ataque perturba significativamente este enfoque, lo que lleva a puntajes inesperadamente altos para muestras limpias.

5.3 Discusión

攻击成功率 (Attack Success Rate, ASR) —— 越高越好

良性准确率 (Benign Accuracy, BA) —— 越高越好

峰值信噪比 (Peak Signal-to-Noise Ratio, PSNR) —— 越高越好

无穷范数 ( ℓ ∞ \ell^{\infty} ℓ∞ norm) —— 越低越好

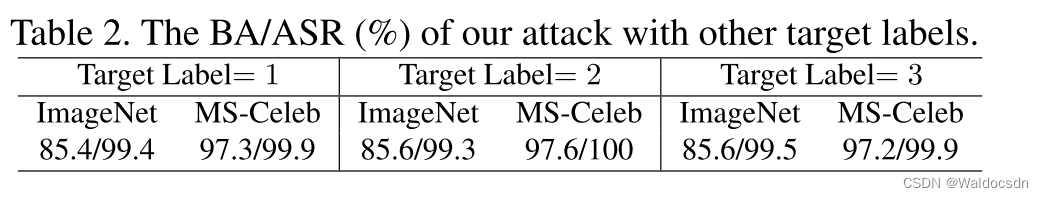

表2注:之前实验中,作者设置的有毒样本的目标标签都是0。

在这一部分,除非另有说明,所有设置都与第5.1节中所述的设置相同。

不同目标标签的攻击。 我们用不同的目标标签 ( y t \boldsymbol{y}_{t} yt = 1, 2, 3) 测试我们的方法。表2显示了我们攻击的BA/ASR,揭示了我们方法在使用不同目标标签时的有效性。

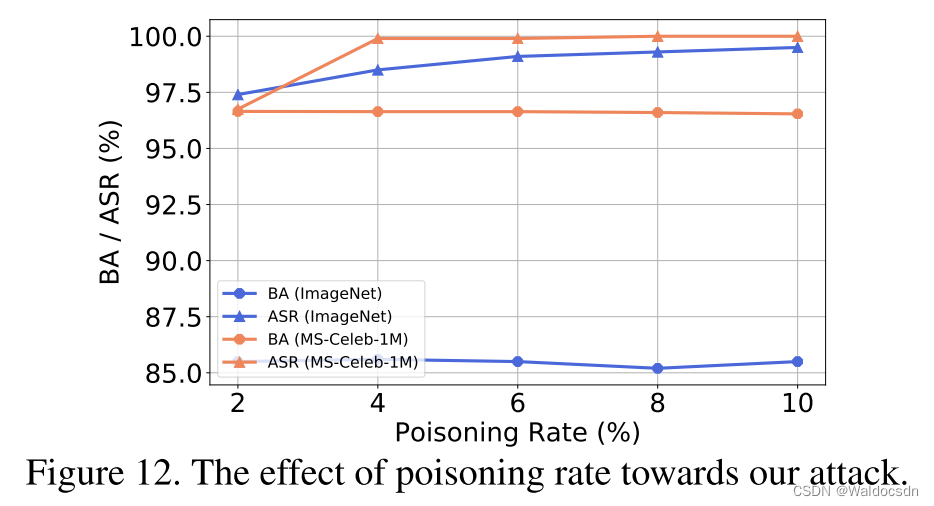

图12. 毒化率对我们的攻击的影响。

毒化率 γ \gamma γ 的影响。 在这部分,我们讨论了毒化率 γ \gamma γ 对我们攻击中ASR和BA的影响。如图12所示,通过只毒化2%的训练样本,我们的攻击在两个数据集上都达到了高ASR (> 95%)。此外,随着 γ \gamma γ 的增加,ASR会增加,而BA几乎保持不变。换句话说,在我们的方法中,ASR和BA之间几乎没有权衡。然而, γ \gamma γ的增加也会降低攻击的隐蔽性。攻击者需要根据自己的具体需求指定此参数。

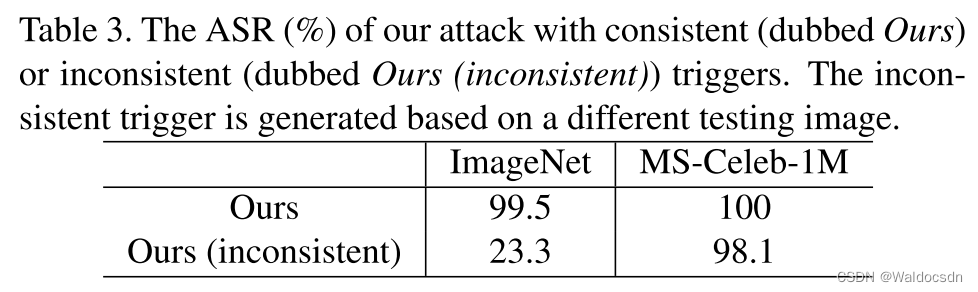

Tabla 3: ASR (%) para "Nuestro ataque en este documento", utilizando disparadores consistentes (llamados "Nuestros") o disparadores inconsistentes (llamados "Nuestros (inconsistentes)"). Se generan disparadores inconsistentes basados en otra imagen de prueba. (Cuadro 3 directamente en inglés)

La Tabla 3 muestra la tasa de éxito del ataque (ASR) para dos casos desencadenantes diferentes. Estos dos disparadores son disparadores "coherentes" (coherentes) y disparadores "incoherentes" (incoherentes).

Un activador "coherente" significa que los activadores se generan en función de la misma imagen. Específicamente, si tenemos una imagen de prueba x \boldsymbol{x}x , usaremosun \boldsymbol{x} basado en xx activadores generados para pruebas de ataque.

Los disparadores "inconsistentes" se refieren a disparadores que se generan en función de diferentes imágenes. Específicamente, para cada imagen de prueba x \boldsymbol{x}x , seleccionamos al azar otra imagen de pruebax ′ \boldsymbol{x}'X′ , luego usamosel ′ \boldsymbol{x}' basado en xX' Activadores generados para pruebas de ataque.

En la Tabla 3, "Nuestro" representa el ataque que usa disparadores consistentes, y "Nuestro (inconsistente)" representa el ataque que usa disparadores inconsistentes.

Si la tasa de éxito del ataque cae significativamente cuando se usan disparadores inconsistentes, significa que el disparador generado por este método de ataque es muy específico de la imagen, es decir, solo es efectivo para la imagen específica que lo generó, pero no para otras imágenes o menos. eficaz.

Especificidad de los disparadores generados : en esta sección, exploramos si los disparadores generados específicos de la muestra son únicos, es decir, si una imagen de prueba que usa un disparador generado en base a otra imagen también puede activar las puertas traseras ocultas neuronales profundas a la web. Específicamente, para cada imagen de prueba x \boldsymbol{x}x , elegimos al azar otra imagen de pruebax ′ \boldsymbol{x}'X′(x ′ ≠ x \boldsymbol{x}' \neq \boldsymbol{x}X′=x ). Ahora, usamosx + T ( G ( x ′ ) ) \boldsymbol{x}+T\left(G\left(\boldsymbol{x}'\right)\right)X+T( G( X′ ))(en lugar dex + T ( G ( x ) ) \boldsymbol{x}+T(G(\boldsymbol{x}))X+T ( G ( x )) ) para consultar la red neuronal profunda atacada. Como se muestra en la Tabla 3, cuando se utilizan disparadores inconsistentes (es decir, disparadores generados en función de diferentes imágenes) en el conjunto de datos de ImageNet, el ASR cae drásticamente. Sin embargo, atacar con disparadores inconsistentes aún logra una ASR alta en el conjunto de datos MS-Celeb-1M. Esto puede deberse a que la mayoría de los rasgos faciales son similares, por lo que los desencadenantes aprendidos tienen una mejor generalización. Seguiremos explorando este interesante fenómeno en trabajos futuros.

解释1:

这段话的主要目标是探讨生成的样本特定触发器的专属性,也就是它们是否只对生成它们的图像有影响,对其他图像则无效或效果较差。在这个实验中,他们使用了从另一张图像中生成的“不一致”触发器对另一张图像进行攻击,看这样的攻击是否仍能成功。

表3中的结果表明,在ImageNet数据集上,使用这种“不一致”触发器的攻击成功率显著下降,这证明了生成的触发器对于其生成图像的特异性。然而,对于MS-Celeb-1M数据集(主要是人脸图像),即使使用“不一致”的触发器,攻击的成功率仍然很高。作者推测,这可能是因为大部分面部特征都很相似,所以学习的触发器具有更好的泛化能力。这个有趣的现象将在他们的未来工作中进一步探究。

解释2:

这段话中,作者们在尝试说明他们生成的样本特定触发器(每个图像都有自己的触发器)是否是独特的,也就是,一个触发器是否只对生成它的图像有效,对其他图像无效。他们这样做的方法是:对于每一张测试图像,他们随机选取另一张测试图像,并用这张图像的触发器去测试原图像。

在他们的实验中,他们发现在 ImageNet 数据集上,如果使用和原图像不一致的触发器进行测试,成功的攻击率(ASR)会大幅下降。这说明在这个数据集上,触发器是具有独特性的,也就是说,一个触发器只对生成它的那张图像有效。

然而,他们在 MS-Celeb-1M 数据集(一个人脸数据集)上进行同样的测试时,发现即使使用和原图像不一致的触发器,成功的攻击率仍然很高。他们猜测这可能是因为在这个人脸数据集中,大多数的面部特征都是相似的,所以触发器可能对多个图像都有效。

这个现象在未来的工作中值得进一步探索。因为如果触发器的独特性可以得到保证,那么攻击者就无法通过其他图像的触发器来激活原图像的后门,从而提高了系统的安全性。

解释3:

这段文字主要是在探讨攻击中生成的样本特定触发器的特性。这里的触发器是用于激活神经网络隐藏后门的信号。

El concepto de "exclusividad" se refiere a si estos disparadores solo son válidos para las muestras específicas que los generaron, en otras palabras, si los disparadores generados en base a una muestra pueden ser igualmente válidos para otras muestras.

El experimento que realizaron fue el siguiente: para cada imagen de prueba x \boldsymbol{x}x , eligen aleatoriamente otra imagen de pruebax ′ \boldsymbol{x}'X′(x ′ ≠ x \boldsymbol{x}' \neq \boldsymbol{x}X′=x ). Luego, usanx + T ( G ( x ′ ) ) \boldsymbol{x}+T\left(G\left(\boldsymbol{x}'\right)\right)X+T( G( X′ ))para consultar la red neuronal bajo ataque, es decir, usanx ′ \boldsymbol{x}'X′ dispara para intentar activarx \boldsymbol{x}Puerta trasera oculta en x .

Los resultados experimentales encontraron que en el conjunto de datos de ImageNet, al usar este "disparador inconsistente" generado en base a otras imágenes, la tasa de éxito de ataque (ASR) se redujo significativamente. Esto muestra que en el conjunto de datos de ImageNet, los disparadores generados por muestras específicas son significativamente menos efectivos en otras muestras, es decir, los disparadores tienen una alta singularidad.

Sin embargo, incluso con este disparador inconsistente, la tasa de éxito del ataque sigue siendo alta en el conjunto de datos MS-Celeb-1M. Esto puede deberse a que este conjunto de datos contiene principalmente imágenes de rostros, y las características faciales en las imágenes de rostros son relativamente similares, por lo que los activadores generados en función de una muestra también tienen un mejor efecto en otras muestras. Esto sugiere que los disparadores son menos únicos en este conjunto de datos. Los autores indican que explorarán más a fondo este fenómeno en trabajos futuros.

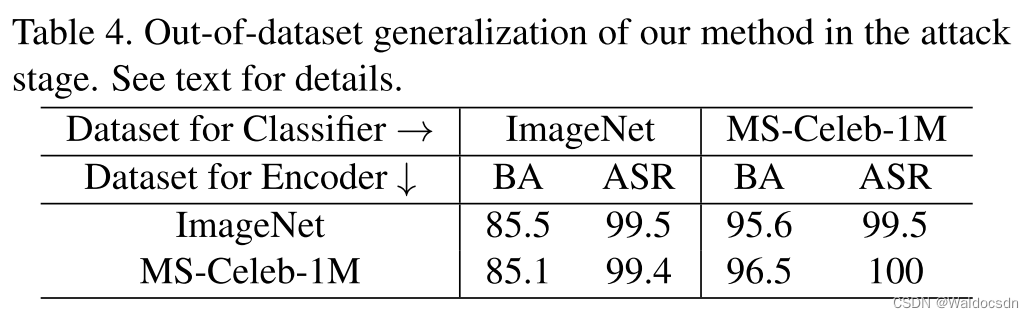

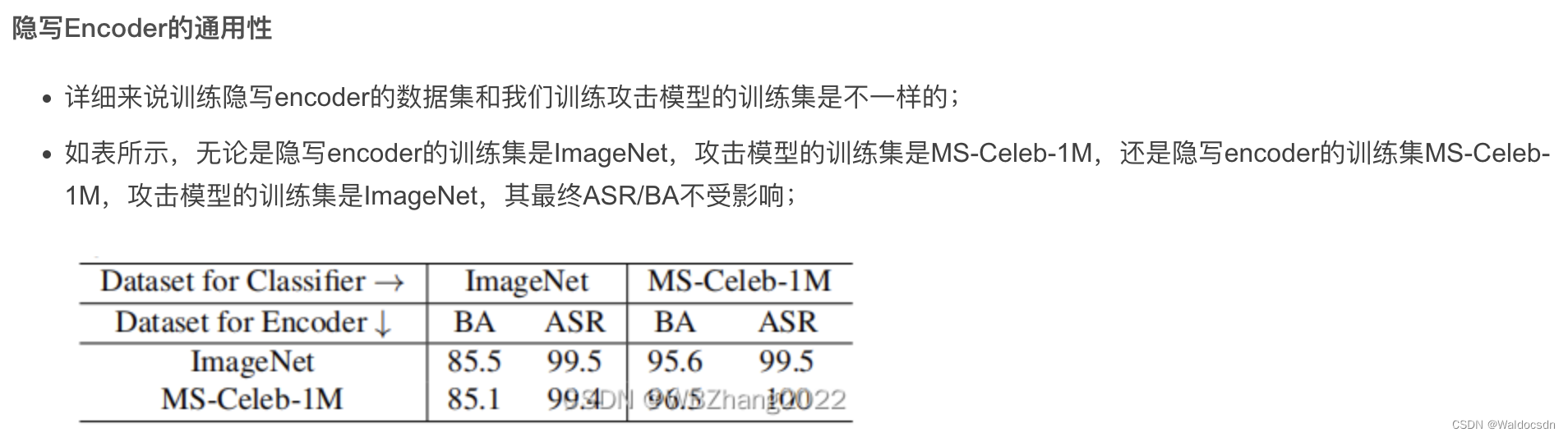

Tabla 4: Generalización fuera del conjunto de datos de nuestro método durante la fase de ataque. Ver texto para más detalles.