1. EMA 소개

논문: https://arxiv.org/abs/2305.13563v1

수락: ICASSP2023

채널 차원 축소를 통해 교차 채널 관계를 모델링하면 깊은 시각적 표현을 추출하는 데 부작용이 있을 수 있습니다. 본 논문은 새로운 효율적인 EMA(Multi-Scale Attention) 모듈을 제안한다. 각 채널에 대한 정보를 보존하고 계산 오버헤드를 줄이기 위해 일부 채널을 배치 차원으로 재구성하고 채널 차원을 여러 하위 기능으로 그룹화하여 공간 의미 기능이 각 기능 그룹에 고르게 분포되도록 합니다.

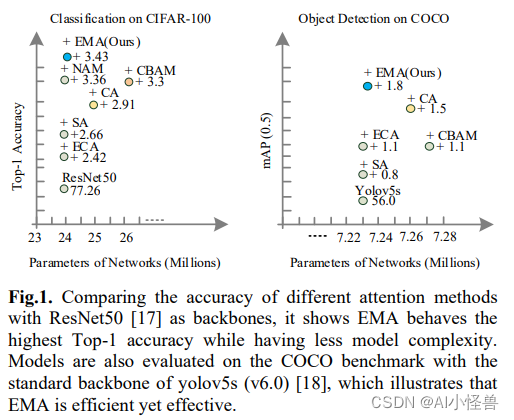

차원 감소가 없는 새로운 효율적인 다중 스케일 어텐션(EMA)을 제안합니다. 여기서는 두 개의 컨볼루션 커널만 병렬 하위 네트워크에 각각 배치됩니다. 병렬 하위 네트워크 중 하나는 CA와 동일한 방식으로 처리되는 1x1 컨볼루션 커널이고 다른 하나는 3x3 컨볼루션 커널입니다. 제안된 EMA의 일반성을 입증하기 위해 CIFAR-100, ImageNet-1k, COCO 및 VisDrone2019 벤치마크에 대한 결과를 포함하여 섹션 4에 자세한 실험이 제공됩니다. 그림 1은 이미지 분류 및 객체 감지 작업에 대한 실험 결과를 나타냅니다. 우리의 주요 기여는 다음과 같습니다.</