Título: Algoritmo de detección de objetivos basado en una red extendida para radar de ondas milimétricas y Vision Fusion

Resumen : Con el desarrollo de la conducción inteligente desde la asistencia primaria al conductor hasta la conducción automática avanzada, la demanda de vehículos como individuos inteligentes e independientes para percibir la información del entorno externo está aumentando. La capacidad de las unidades de detección independientes ordinarias para percibir el entorno externo está limitada por las características del propio sensor y el nivel de los algoritmos. Por lo tanto, las unidades de detección independientes ordinarias no pueden obtener de forma independiente información de detección completa en condiciones como la lluvia, la niebla y la noche. Sobre esta base, combinando el rendimiento de percepción complementario, la rentabilidad y la madurez de la tecnología de detección independiente de los elementos de detección a bordo, se propone un radar de ondas milimétricas basado en red extendida y un algoritmo de detección de objetivos de fusión de visión. Este documento adopta la fusión a nivel de características por primera vez a través del análisis de la ruta de tecnología de fusión de visión y radar de ondas milimétricas. El algoritmo se entrena y prueba en el conjunto de datos de nuScenes y los datos de prueba de la plataforma de recopilación de datos de fabricación propia. Sobre esta base, se estudia en profundidad el algoritmo de detección de objetivos de una etapa de RetinaNet basado en la red troncal de detección VGG-16+FPN, y se introduce la imagen de radar de ondas milimétricas como información auxiliar para la detección de objetivos de imagen visual. Utilizamos imágenes de radar de dos canales y de visión de tres canales como entrada a la red de fusión, y proponemos una red extendida VGG-16 y una red piramidal de características extendidas adecuadas para la fusión de visión y radar mmWave. Los resultados de las pruebas muestran que la red propuesta logra un aumento del 2,9 % en mAP y una mejora del 18,73 % en la precisión de objetos pequeños en comparación con la red de referencia para la detección de objetos de imagen visual pura. Este hallazgo verifica la capacidad de detección y la viabilidad algorítmica de la red de detección de objetos fusionados extendida propuesta para objetos visualmente insensibles.

Palabras clave : automóvil de conducción inteligente; fusión multisensor; detección de objetivos; red extendida

1. Introducción

Con el desarrollo continuo de tecnologías como la prevención de colisiones de vehículos, el mantenimiento de carriles y el control de crucero automático, la demanda de capacidades de detección de vehículos autónomos está aumentando gradualmente. Las unidades de detección independientes, como el radar de ondas milimétricas , el radar ultrasónico, las cámaras de visión con buenas capacidades de detección externa, etc., se han aplicado gradualmente a la detección de objetos en vehículos. Sin embargo, un solo tipo de unidad de detección no puede satisfacer las necesidades de capacidades de detección mejoradas para la automatización de vehículos, y los investigadores están cambiando gradualmente su enfoque de investigación de detección de sensor único a detección de fusión. Con los esfuerzos conjuntos de muchos investigadores, la tecnología de detección de objetivos de imágenes basada en una cámara visual ha madurado y se puede aplicar a escenas reales.

Krizhevsky y otros propusieron una red neuronal convolucional profunda AlexNet en el Visual Recognition Challenge , que sentó las bases para la investigación en el campo de la detección de objetos de aprendizaje profundo. Girshick y otros propusieron un modelo de detección R-CNN basado en una red neuronal convolucional para identificar regiones candidatas donde pueden existir objetos. Él y otros establecieron el algoritmo de agrupación de pirámide espacial SPPNet para resolver la limitación del tamaño fijo de la imagen de entrada en R-CNN. Este algoritmo es superior al algoritmo YOLO propuesto anteriormente en la detección de objetivos pequeños y mejora la capacidad de detección de objetivos pequeños. Las imágenes de radar se han estudiado ampliamente. Chen desarrolló un algoritmo extendido que puede evitar de manera efectiva los errores causados por una distribución de energía desequilibrada. Dong propuso un algoritmo de detección de compresión de radar de apertura sintética, que proporciona una idea para la fusión de múltiples sensores.

La detección de objetos visuales ha pasado por dos etapas de desarrollo , el algoritmo de detección de objetos tradicional y el algoritmo de detección de objetos basado en el aprendizaje profundo , que ha mejorado significativamente la precisión de detección y la velocidad de los objetos de imagen. Sin embargo, la detección de objetos puramente basada en la visión todavía tiene deficiencias inherentes cuando se trata de escenas complejas, como la superposición de múltiples objetos, la detección de peatones en tráfico denso y clima brumoso. En la detección del objetivo, el radar de ondas milimétricas ha mostrado una capacidad de detección aceptable a partir de la estimación de los datos de estado, como la posición y la velocidad del objetivo. Sin embargo, existen limitaciones en el uso del radar mmWave para tareas como la clasificación de objetos y la estimación de carriles de objetos . Por lo tanto, muchos investigadores han considerado la aplicación de métodos de fusión de sensores múltiples en la detección de objetos.

2. Trabajo relacionado

El objetivo de la detección de objetos de fusión de múltiples sensores es principalmente utilizar las características complementarias de múltiples sensores en diversas condiciones, como la capacidad de detección, la producción, el costo de mantenimiento y la estabilidad. La investigación sobre el radar de ondas milimétricas y la fusión de visión aún está en su infancia y está limitada por la falta de conjuntos de datos disponibles públicamente que contengan datos de radar de ondas milimétricas . Con el lanzamiento del conjunto de datos nuScenes y el software de simulación como CARLA , el algoritmo de fusión basado en el radar de ondas milimétricas ha atraído gradualmente la atención de la investigación.

Ji y otros crean regiones de interés para la detección de objetos de imágenes y la detección de radar en una red neuronal simple para la detección de objetos. Muchos estudios también utilizan la detección de radar mmWave para guiar la detección de objetos en las imágenes. Jin y otros han realizado la detección y el reconocimiento de múltiples objetivos sobre la base de la región de interés de detección de imágenes mediante la exploración de la fusión del radar de ondas milimétricas y la fusión de visión en la dimensión del espacio-tiempo. Song y otros aplicaron un radar de ondas milimétricas con detección de objetivos tridimensionales de imagen, dividieron las tareas del sensor de acuerdo con la distancia radial del objetivo y realizaron la detección y clasificación de objetivos peligrosos bajo la supervisión de múltiples sensores. Vijay y otros propusieron utilizar RVNet con estructura de radar mmWave y datos de imagen de cámara como entrada a la red neuronal convolucional. Jha y otros utilizaron los resultados de detección independientes del radar mmWave y sensores de visión para el algoritmo de fusión de decisiones . Lekic y otros utilizan un enfoque de aprendizaje profundo basado en una red antagónica para fusionar los datos de la cámara y del radar mmWave en una vista de pájaro para la detección del espacio libre. Chadwick y otros proyectaron los datos del radar de ondas milimétricas en el plano de la imagen, utilizaron una red neuronal profunda para la detección y fusionaron las características del radar con las características visuales a través de la fusión en serie y lograron un rendimiento satisfactorio en el conjunto de datos personalizado del autor.

La tecnología de fusión de visión y radar de ondas milimétricas tiene ventajas en la detección de objetivos pequeños. Aziz y otros propusieron un marco algorítmico para fusionar el radar de ondas milimétricas y la información visual para lograr la detección de objetos. Chang y otros propusieron un algoritmo de detección de objetivos de fusión de visión y radar de ondas milimétricas basado en la fusión de atención espacial, que mejora la detección de objetivos pequeños y mínimamente seguros mediante la introducción de un módulo de atención espacial . Nabati y otros establecieron un algoritmo de detección de objetivos en 3D basado en el radar de ondas milimétricas basado en el centro y la fusión de visión, que logró la asociación del radar de ondas milimétricas y los objetivos visuales. Jhon y otros utilizaron radares de ondas milimétricas, cámaras visuales y cámaras termográficas en entornos de detección débiles para mejorar las capacidades de detección de objetivos de las cámaras visuales durante la noche, en condiciones de lluvia y niebla. De acuerdo con la incertidumbre de los objetivos de detección de puntos de radar, Nabati y otros se expandieron desde el centro del marco de detección hacia los alrededores y obtuvieron un conjunto de marcos previos de detección para la detección de imágenes. Wang y otros utilizaron la transformación de coordenadas con detección de bordes de vehículos para compensar la deficiencia de la detección de un solo sensor de vehículos. Wang y otros fusionan el mecanismo de atención y la conciencia del conductor para mejorar el rendimiento general.

La investigación sobre el algoritmo de fusión basado en radar de ondas milimétricas e información visual se centra principalmente en el nivel de toma de decisiones. Este método consiste en fusionar el radar independiente de ondas milimétricas y los resultados de detección visual de acuerdo con la lógica establecida, pero la tasa de detección y la aplicabilidad ambiental aún deben mejorarse. Por lo tanto, este documento propone una red extendida de detección de objetos basada en la fusión de características multicapa de radar mmWave e información visual sin procesar para mejorar la precisión de detección y la solidez del modelo en condiciones climáticas complejas.

3. Método

3.1 red extendida FPN

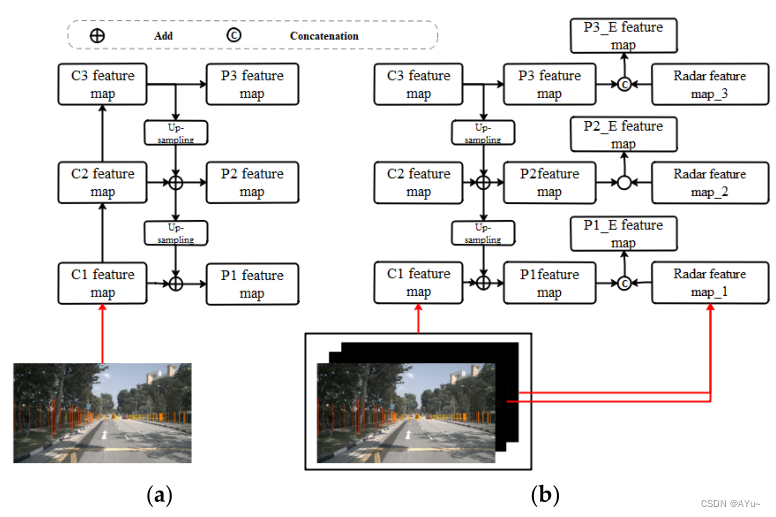

Los investigadores suelen predecir las características por separado de cada capa de la red de detección, por lo que a medida que aumenta la profundidad de la característica, disminuye la eficacia de la información en los mapas de características, lo que hace que el algoritmo sea ineficaz en la detección de objetos pequeños. La Feature Pyramid Network (FPN) propuesta puede proporcionar una solución satisfactoria para la detección de objetos con características de múltiples escalas. Aborda principalmente el problema de múltiples escalas en la detección de objetos. FPN utiliza una estructura de conexión horizontal de arriba hacia abajo para fusionar información de ubicación de bajo nivel con mapas de características ricos en información semántica de alto nivel. Se obtiene la información de ubicación del objeto subyacente almacenada en el nuevo mapa de características, lo que mejora la capacidad de detección de objetos a pequeña escala. Las características de profundidad obtenidas de diferentes capas convolucionales utilizan un kernel de convolución de 1 × 1 para la coincidencia de canales, y los mapas de características fusionadas se procesan utilizando un kernel de convolución de 3 × 3 para reducir el efecto de alias causado por la fusión de características de diferentes capas. Tomamos un FPN de tres capas como ejemplo y lo ampliamos. La estructura FPN se muestra en la Figura 1a.

Figura 1. Red piramidal de funciones y sus extensiones. C representa la capa de convolución de CNN y P representa la capa de predicción.

(a) estructura FPN; (b) FPN extendido (E-FPN)

Muestreo ascendente de características profundas , fusión de características superficiales por adición (Add) para obtener mapas de características P1, P2 con semántica mejorada de características de imagen C1, C2, C3, mejorando la capacidad del algoritmo para reconocer objetivos pequeños. Sobre la base de FPN y su desempeño aceptable en la síntesis de información semántica multicapa, todavía hay espacio para mejorar los resultados de detección. Proponemos Extended FPN (E-FPN) como se muestra en la Fig. 1b. El algoritmo agrega las características del radar de ondas milimétricas de la escala correspondiente a los mapas de características P1, P2 y P3 para la fusión en serie (cascada), y extrae los mapas de características P1, P2 y P3 a través de FPN para obtener P1_E, P2_E, P2_E mejorados. y mapas de características de fusión P3_E Hacer predicciones . En este estudio, utilizamos un FPN de siete capas para realizar la tarea de detección de fusión de datos del sensor. También ampliamos la red VGG en la Sección 3.2.

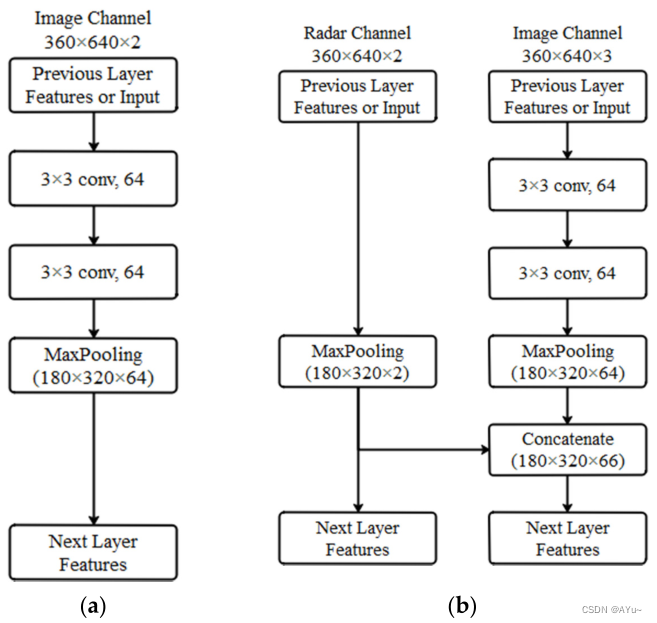

3.2 Diseño del módulo de red extendida VGG

La red VGG fue propuesta por el Grupo de Geometría Visual de la Universidad de Oxford como un acrónimo del nombre del laboratorio. La investigación de VGG ilustra algunos de sus hallazgos en el desafío ImageNet 2014 y muestra que se pueden construir modelos profundos mediante la reutilización de bloques subyacentes. La estructura de bloques de la red VGG se muestra en la Fig. 2a. Un bloque de construcción de CNN generalmente se construye de la siguiente manera: una capa convolucional, una función de activación no lineal, como ReLU, y una capa de agrupación, como una capa de agrupación máxima. El método propuesto en el estudio VGG tiene como objetivo utilizar varias capas convolucionales idénticas consecutivas con un relleno de 1 y una forma de ventana de 3 × 3, seguidas de una capa de agrupación máxima con un paso de 2 y una forma de ventana de 2 × 2. Las capas convolucionales mantienen constantes la altura y el ancho de la entrada y la salida, mientras que las capas de agrupación reducen a la mitad el tamaño de la entrada. Basado en la red VGG, proponemos la red VGG extendida.

Figura 2. Módulos de red VGG y módulos de extensión. (a) Módulo VGG-16. (b) Ampliar el módulo de red VGG.

La imagen de radar generada por la extensión contiene dos canales: la sección transversal del radar (RCS) y el canal de alcance. El tamaño de la imagen del radar es el mismo que el tamaño de la imagen visual. La estructura de bloque de red VGG se rediseñó para acomodar la imagen extendida de "imágenes visuales de radar de ondas milimétricas" como entrada de red, y las características de imagen de radar se incorporaron a la red convolucional. La figura 2 presenta la estructura del módulo de VGG y la red extendida de VGG. Como se muestra en la Fig. 2b, la red VGG extendida utiliza una imagen de dos canales de radar mmWave y una imagen visual (R, G, B) de tres canales como entrada de la red. El canal de imagen completa la convolución y agrupación del bloque VGG original y lo une con las características de imagen de radar de ondas milimétricas. Los mapas de características resultantes se utilizan luego como entrada del bloque VGG en la siguiente capa.

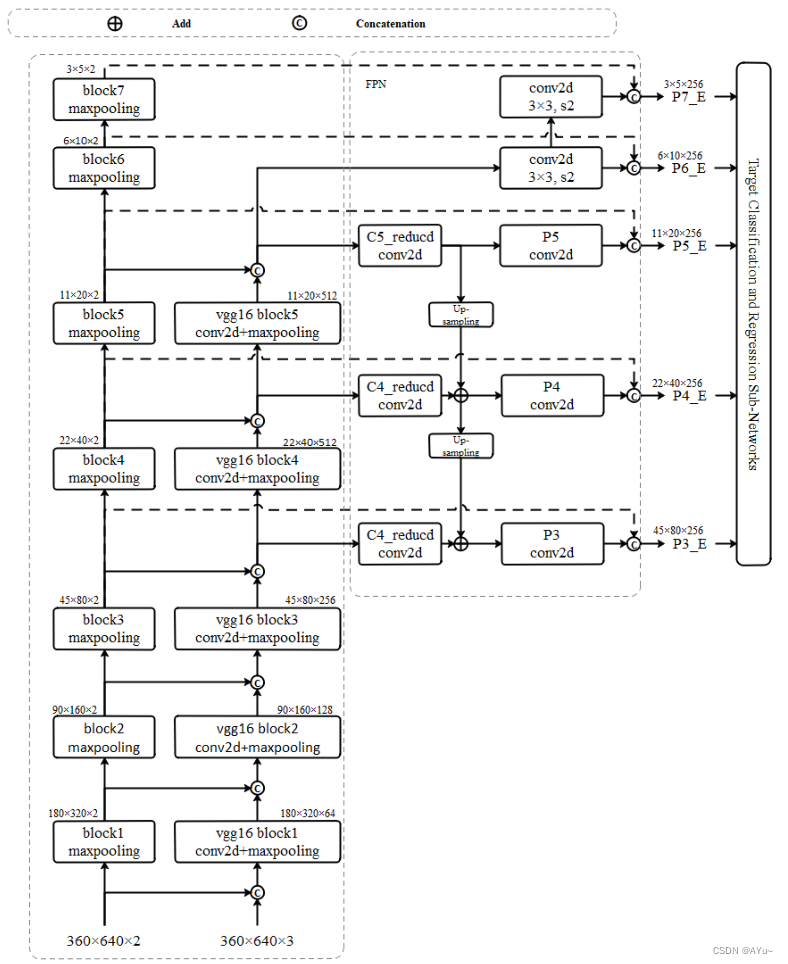

En este documento, basado en RetinaNet extendida VGG-16+E-FPN, la arquitectura avanzada de la red de detección de objetivos extendida de radar de ondas milimétricas y la fusión visual se muestran en la Figura 3. La estructura de red de detección de red troncal VGG-16 ampliada se muestra en el lado izquierdo de la Figura 3. Mientras tanto, la estructura FPN extendida se ilustra en el cuadro punteado del medio.

Figura 3. Arquitectura avanzada de la red de detección de objetos extendida

En la Fig. 3 se puede ver que la estructura de red expandida toma el canal 2 de imagen de radar de ondas milimétricas y el canal 3 de imagen visual como entrada, y las características de imagen visual y las características de imagen de radar se conectan en cascada en características compuestas a través de la fusión en serie (canal de características compuestas). número = pre El número de canales de características de radar concatenados + el número de canales de características de imagen preconcatenados). Las salidas de características compuestas de cada capa de la red de detección de red troncal VGG ampliada son C5_reducida, C4_reducida y C3_reducida, respectivamente, y los mapas de características del radar son R1, R2, ... R7. Las características de fusión y radar obtenidas de la red de detección de red troncal VGG se utilizan como entrada de E-FPN. Al mismo tiempo, los mapas de características extendidas P3_E, P4_E, P5_E, P6_E y P7_E obtenidos mediante el uso de la red piramidal extendida se utilizan como entrada de la red de destino.

Se puede observar una diferencia fundamental entre el radar mmWave y los píxeles de imagen en la cantidad de información que contiene un píxel. Las imágenes de radar usan distancias de objetivos como valores de píxeles, mientras que la información de objetivos en imágenes visuales debe estar representada por un solo píxel y píxeles cercanos. La fusión superficial de imágenes de radar con imágenes visuales se correlaciona mal con la información expresada por ambas, ya que la información de entrada muestra una similitud semántica mínima y solo asocia características indirectamente. Los datos de entrada en redes profundas pueden representar información semántica cada vez más densa y proporcionar la información de características requerida para las tareas de clasificación. Por lo tanto, las funciones convolucionales profundas C5_reduced, C4_reduced y C3_reduced se seleccionan como salidas de funciones para garantizar la expansión de imágenes multiescala en FPN y la similitud semántica entre el radar mmWave y la información visual en funciones profundas. En el proceso de entrenamiento de la red, los pesos de las diferentes capas de características del radar se pueden ajustar en consecuencia, de modo que la red se pueda entrenar de manera adaptativa , y al fusionar la onda milimétrica con las características de salida de la red piramidal P3_E, P4_E, P5_E, P6_E, P7_E en E_FPN Radar cuenta con R1, R2, ... R7, etc., para obtener el mejor efecto de predicción y clasificación.

4. Resultados

4.1 Indicadores de evaluación

El algoritmo de detección de objetos basado en la fusión de radar mmWave y visión propuesto en este documento tiene como objetivo mejorar la detección de objetos de imagen a través de una red guiada basada en datos de radar mmWave. En la evaluación de la detección de objetos de imagen, la evaluación de la clasificación de objetos se basa en la precisión promedio, mientras que la evaluación de la localización de objetos se basa en la relación de intersección y fusión. Los indicadores de evaluación son los siguientes:

(1) Verdadero positivo (TP): tanto el valor predicho del IoU como el cuadro de verdad del terreno son mayores que el umbral y la clasificación es correcta.

IoU es el resultado de dividir la superposición de dos regiones por la suma de las dos regiones. Al establecer un umbral, el resultado se compara con el cálculo de IoU. La definición de IoU es la siguiente:

![]()

(2) Falso positivo (FP): el cuadro de predicción contiene el objetivo pero no hay ningún cuadro de verdad o el IoU del cuadro de verdad es menor que el umbral.

(3) Falso negativo (FN): una situación de detección perdida, aunque el objetivo es real, pero no se hace ninguna predicción para el objetivo real.

(4) Precisión: entre todos los objetos detectados cuyo IoU alcanza el umbral, la proporción de objetos correctamente clasificados.

(5) Recuperación (tasa de recuperación): entre todos los objetos de verdad en el terreno, se detecta la proporción de objetos que se clasifican correctamente y cuyo IoU es mayor que el umbral.

La precisión y la recuperación se calculan de la siguiente manera:

![]()

4.2 Introducción al conjunto de datos

Los conjuntos de datos de conducción autónoma generalmente se diseñan en torno a imágenes visuales y datos sin procesar LIDAR. La falta de datos de radar de ondas milimétricas en conjuntos de datos públicos y la baja disponibilidad de conjuntos de datos autoconstruidos dificultan en cierta medida el desarrollo de colecciones. Este problema se alivió gradualmente cuando se lanzó el conjunto de datos nuScenes en 2019. El conjunto de datos nuScenes es un gran conjunto de datos público para la conducción autónoma desarrollado por el equipo de Motional. El conjunto de datos se recopila en Boston y Singapur, cada escena de conducción es de aproximadamente 20 segundos, un total de 1000.

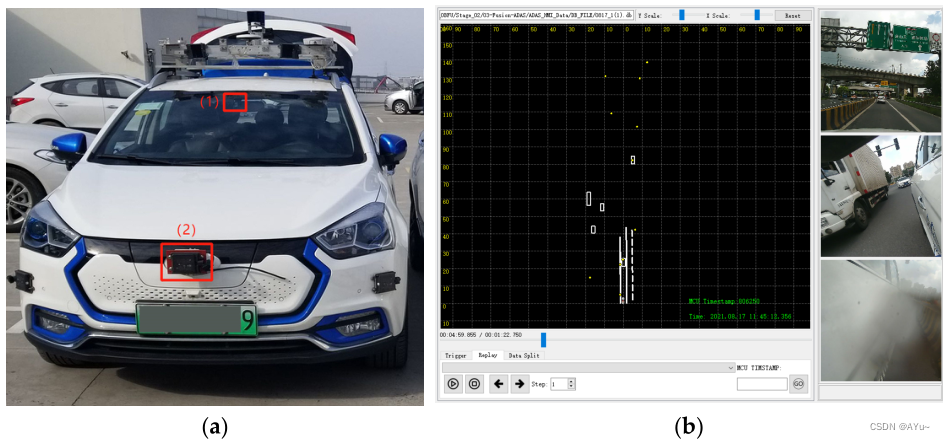

Este trabajo también utiliza la plataforma de conducción inteligente de automóviles HYPERVIEW para recopilar datos de sensores y probar y verificar el algoritmo. La figura 4 es un diagrama esquemático físico de una plataforma de adquisición de vehículos que incluye un radar de ondas milimétricas, una cámara visual y un lidar.

Figura 4. Configuración del sensor de la plataforma de adquisición de datos NuScenes. a) Plataforma de recogida de vehículos. (1) es una cámara (2) es un radar de ondas milimétricas

(b) es la interfaz de la herramienta HMI

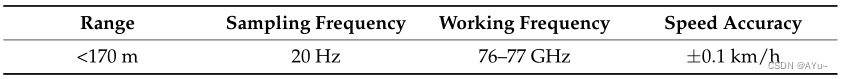

La plataforma de adquisición de datos de radar de ondas milimétricas de construcción propia adopta la compresión de datos ProtoBuf y SQLite , y realiza la adquisición de imágenes visuales durante las pruebas en carretera. Los parámetros específicos del radar de ondas milimétricas se muestran en la Tabla 1.

Tabla 1: Parámetros operativos del radar de ondas milimétricas Continental ARS410 .

La interfaz de la herramienta HMI de adquisición y reproducción de datos se muestra en la Figura 4b. La herramienta se utiliza para adquirir datos de estructura de radar mmWave e imágenes visuales que se muestran en tiempo real, mientras almacena información de movimiento del vehículo ego y marcas de tiempo del sensor.

4.3 Comparación del efecto de detección entre la red de fusión y la red de referencia

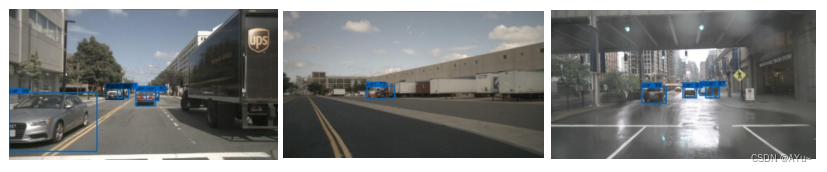

Las imágenes en el conjunto de datos de nuScenes y el ancho y largo de la imagen de radar generada se redimensionan a 360 × 640 como entrada a la red . Esta sección presenta resultados de detección subjetivos en nuScenes y conjuntos de datos autoconstruidos.

En la aplicación de la tecnología de radar de ondas milimétricas montada en vehículos, los obstáculos detectados por el radar de ondas milimétricas se distribuyen en el plano de visión superior dentro del campo de visión (FOV) del radar de ondas milimétricas . Por lo tanto, no contiene las coordenadas físicas del objetivo en la dirección vertical y se puede proyectar en un plano bidimensional para visualización y representación de datos. El método de proyección adopta el método clásico de transformación de coordenadas en el modelo de rendimiento de apertura pequeña. Se puede representar como un mapa de nube de puntos en planos de imagen y píxeles.

La figura 5 muestra la comparación del rendimiento de detección de objetos de la red fusionada y la red de referencia ejecutada en el conjunto de prueba del conjunto de datos de nuScenes. La Figura 6 muestra la comparación del efecto de detección de objetivos de la red de fusión y la red de referencia en el conjunto de datos de fabricación propia. La red de referencia utilizada en la Figura 5 y la Figura 6 es la red de detección de objetos RetinaNet basada en la red troncal de detección VGG-16+FPN . Cada columna de la Figura 5 corresponde a una escena. La primera fila muestra la proyección de la nube de puntos de radar mmWave utilizada para la predicción en la imagen visual. La segunda fila representa la salida de características del primer bloque de detección de VGG extendido de la red de detección de objetos extendida y la salida de características del primer bloque de detección de VGG de la red de referencia. La tercera fila representa la diferencia de características del primer bloque de detección de la red extendida y la red de referencia. La cuarta fila representa la salida característica de la red de detección de objetos extendida P3_E y la red de referencia P3. La quinta fila describe las diferencias de características entre la red extendida y la red de referencia FPN-P3 (P3_E). La sexta fila muestra las salidas de características de la red de detección de objetos extendida P5_E y la red de referencia P5. La séptima fila es la diferencia de características entre la red extendida y la red de referencia FPN-P5 (P5_E). La octava fila muestra el rendimiento de detección de la red extendida de detección de objetos fusionados propuesta. Finalmente, la novena fila muestra el rendimiento de detección de la red de referencia.

Figura 5. Comparación de los resultados de detección de conjuntos de datos de NuScenes

Del análisis comparativo de la Figura 5, se puede ver que la red de detección de objetivos fusionados muestra efectos mejorados de reconocimiento y clasificación en escenas características difíciles de reconocer, como objetivos pequeños de larga distancia (como peatones en las sombras), objetos múltiples con objetivos superpuestos de textura similar (como varios camiones blancos en la segunda columna) y objetivos de peatones oscurecidos por la lluvia (las características se superponen a diferentes distancias radiales según la imagen ampliada del radar). Tome como ejemplo el pequeño objeto peatonal detectado en la primera columna de la red de fusión. En la posición correspondiente a las imágenes de diferencia de características de P3_E y P3, la posición del peatón tiene características de salida de radar obvias. Mientras tanto, tome como ejemplo el gran camión objetivo detectado por la segunda columna de la red de fusión. Múltiples furgonetas blancas se superponen y el contorno de la textura no es obvio. No se puede reconocer ni clasificar en la detección de objetivos de imagen de red de referencia, pero se pueden obtener resultados de detección satisfactorios en la red de fusión basada en canales de imagen de radar.

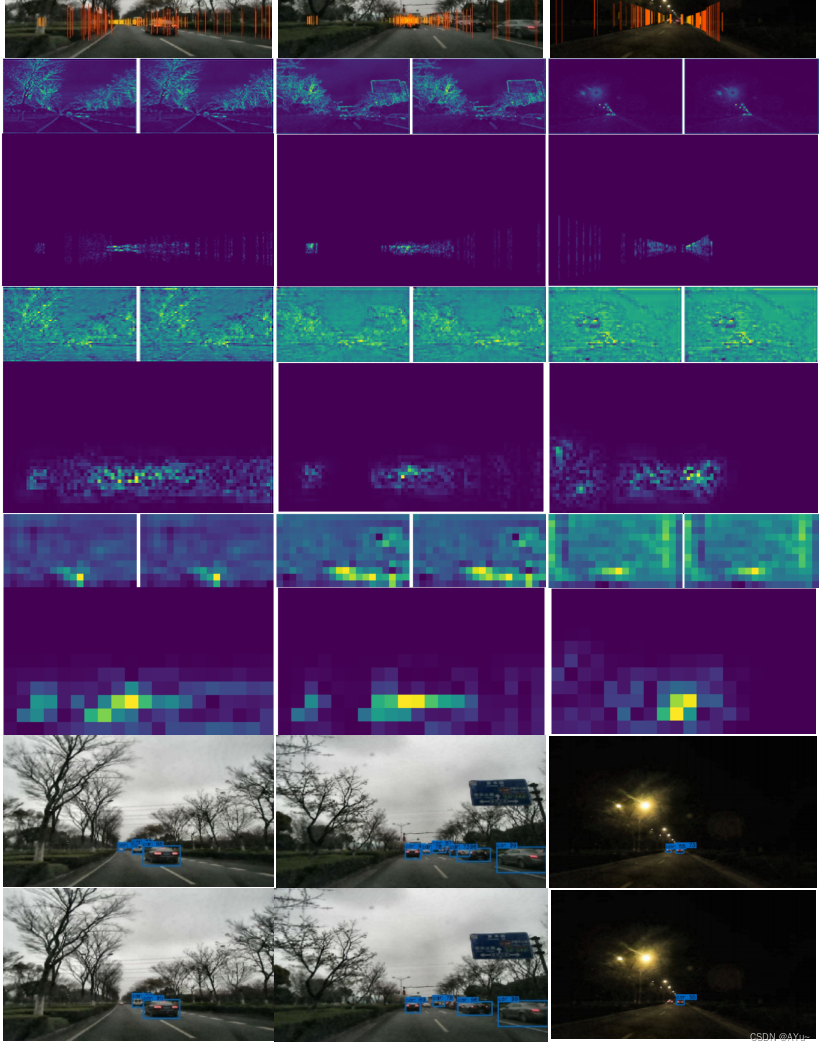

Figura 6. Comparación de los efectos de detección de las plataformas de adquisición de datos

La red de detección de objetos fusionados supera a la red de referencia en el reconocimiento de pequeños objetos de largo alcance en escenas nocturnas y entornos nublados (Fig. 6) y en la detección de pequeños objetos de largo alcance en un conjunto de datos de fabricación propia . Al mejorar la función P3 (P3_E) de la posición del objetivo pequeño detectado en la Figura 6, se puede ver que agregar información del canal de imagen de radar de ondas milimétricas puede fortalecer el reconocimiento de funciones independientes de objetivos pequeños remotos y vehículos superpuestos, lo cual es útil para el proceso de detección, como se muestra en la columna 2.

4.4 Comparación de efectos de detección continua en diferentes escenarios

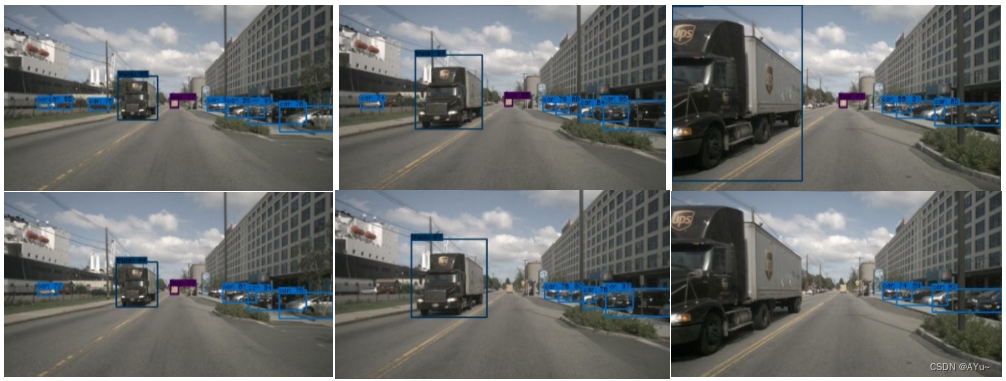

4.4.1 Detección de objetos en escenas complejas durante el día

La figura 7 compara el rendimiento de detección de objetos de tres fotogramas consecutivos en una escena diurna. La primera fila muestra el efecto de la detección de objetos de fusión extendida propuesta. La segunda fila es el rendimiento de detección de objetos de la red de referencia. Como se puede ver en la figura, la red extendida de detección de objetos fusionados en este documento mejora la continuidad de la detección de objetos a corta distancia . Sobre la base de las funciones de nube de puntos de radar mejoradas, se pueden obtener resultados de detección satisfactorios para objetivos pequeños borrosos (vehículos) en el lado izquierdo, y se puede realizar la detección y clasificación para camiones grandes miopes con información de imagen incompleta.

Figura 7. Comparación del efecto de detección continua de escenas diurnas en el conjunto de datos de nuScenes.

Como se muestra en la Figura 8 y la Figura 9, en una escena nocturna, un automóvil se acerca gradualmente al automóvil autónomo hasta que se encuentra. La primera fila muestra el rendimiento de detección de objetos de la red de fusión extendida y la segunda fila muestra el rendimiento de detección de objetos de la red de referencia en cada conjunto de imágenes. En comparación con el uso de la red de referencia, la red de percepción fusionada extendida detecta el objetivo 3 veces antes durante la aproximación al objetivo (Fig. 8). La red de referencia produce errores de clasificación durante la detección de objetos y pierde su capacidad de detectar objetos durante el proceso de encuentro que se muestra en la Figura 9 a medida que la red de referencia se aleja gradualmente del campo de visión.

Figura 8. Comparación de escenas nocturnas en el conjunto de datos de nuScenes. Detección continua de la presencia de objetivos.

Figura 9. Comparación de escenas nocturnas. El impacto de la detección de secuencias fuera del objetivo en el conjunto de datos de nuScenes.

4.4.2 Detección de objetivos en escenas nocturnas complejas

En la primera fila de imágenes de la Figura 9, se puede ver que la red de detección de percepción fusionada puede obtener la detección de objetivos peatonales distantes. Mejore la capacidad de detección de objetivos pequeños en entornos hostiles y reduzca el impacto de objetivos peligrosos que pueden causar accidentes en el estado de movimiento de los automóviles autónomos.

4.5 Análisis de las capacidades de detección de redes convergentes y redes de referencia

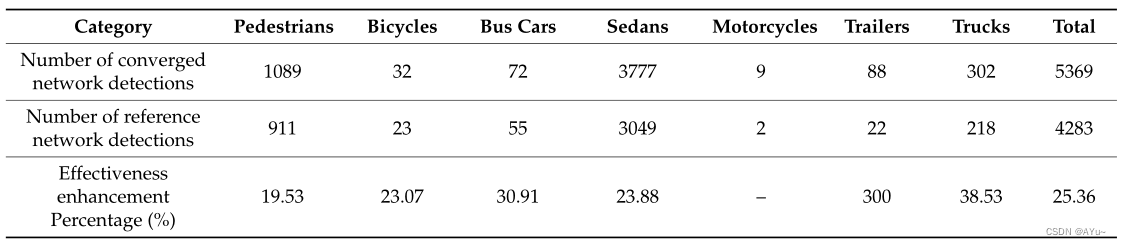

Al seleccionar aleatoriamente 25 escenas de las 150 escenas en el subconjunto de prueba v1.0 del conjunto de datos nuScenes , las redes de referencia y fusión extendida propuestas para diferentes clases de objetos se prueban y analizan estadísticamente. Los resultados del análisis se muestran en la Figura 10.

Fig. 10. Estadísticas de detección de objetos de la red de fusión y la red de referencia.

Se determinó el número total de objetivos capturados por detección para cada categoría (Fig. 10).

En comparación con la red de referencia, la cantidad de objetivos detectados por la red de fusión extendida ha aumentado un 25,36 % en general, y la capacidad de detección de objetivos de muestra grandes, como automóviles y peatones, ha aumentado aproximadamente un 20 % (Tabla 2). El análisis comparativo del efecto de detección de objetivos descrito en la sección anterior muestra que el algoritmo de detección de objetivos de fusión basado en la red extendida propuesta tiene un efecto de detección significativamente mejorado en comparación con un solo tipo de sensor.

Tabla 2. La estructura de datos del radar mmWave del conjunto de datos nuScenes.

4.6 Análisis objetivo del valor

Al extraer el 20 % de los algoritmos del subconjunto v1.0-trainval del conjunto de datos de nuScenes y usarlo como un conjunto de validación , se verifica la eficacia práctica y la precisión de detección del algoritmo de detección de objetos de fusión extendido propuesto.

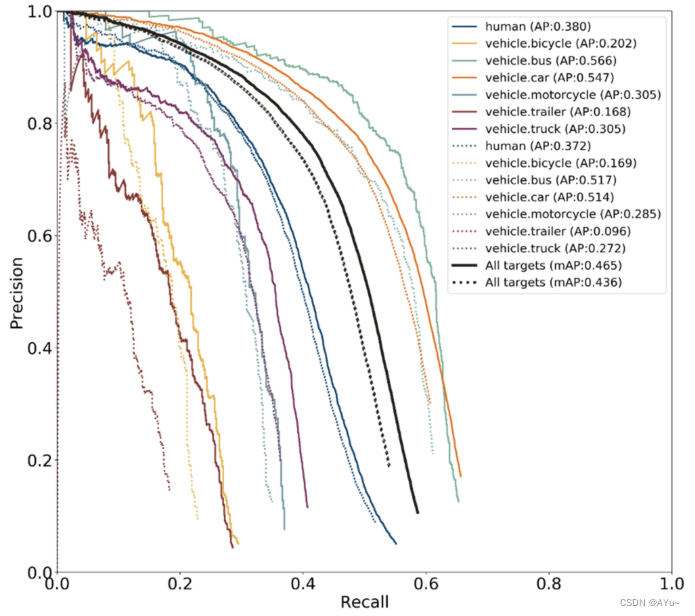

La Figura 11 presenta el análisis estadístico de la precisión promedio de la red de detección de objetos fusionados extendida propuesta (parte sólida) y la red de referencia (parte punteada) bajo diferentes clases. Calcule, compare la precisión promedio general (mAP) de los dos algoritmos y luego trace la curva.

Figura 11. Comparación de las redes extendidas y de referencia probadas por categoría en el conjunto de datos de nuScenes.

Las líneas continuas representan la técnica propuesta y las líneas discontinuas representan la red de referencia.

La Tabla 3 presenta una comparación de la precisión promedio de diferentes algoritmos por categoría en el conjunto de datos de nuScenes. RRPN es una red de detección de objetivos que integra radar de ondas milimétricas y visión. Fast R-CNN y Baseline son redes de detección de objetos puramente visuales. Dado que el conjunto de datos de nuScenes contiene solo una pequeña cantidad de algoritmos de detección de objetos 2D, las comparaciones se realizan con estos algoritmos. En este documento, los datos de radar de ondas milimétricas en tiempo real en el algoritmo RRPN se utilizan para generar el marco de propuesta de región en lugar del algoritmo de búsqueda selectiva en el algoritmo Fast R-CNN para generar el marco de detección. Este método mejora la precisión y la recuperación del algoritmo de búsqueda selectiva y reduce significativamente el consumo de tiempo del algoritmo.

Tabla 3. Comparación de diferentes algoritmos clasificados por AP en el conjunto de datos de nuScenes.

El análisis de los indicadores de mAP muestra que, en comparación con RRPN, la red de detección de objetos de imágenes Fast R-CNN y la red de referencia propuestas en este documento, el algoritmo de detección de objetos de fusión basado en la red extendida propuesta en este documento ha aumentado el mAP en un 3,5 %, 4,7 % y 2,9% respectivamente (Tabla 3). De acuerdo con el análisis de clasificación del índice AP, en el conjunto de datos de nuScenes, el algoritmo de detección propuesto en este documento logra el mejor rendimiento entre los objetos comunes en la carretera, como peatones, automóviles y remolques. La red de detección de objetos de fusión a nivel de características basada en la fusión extendida propuesta en este documento genera marcos de detección basados en la región de interés, y su rendimiento es significativamente mejor que el algoritmo RRPN desde el punto de vista del algoritmo de fusión. De acuerdo con la definición de AP a diferentes escalas en el conjunto de datos COCO, este trabajo utiliza los siguientes métodos para verificar el efecto de mejora del método de detección de objetivos de fusión propuesto en las capacidades de detección de objetivos a diferentes escalas.

(1) Aps: la precisión promedio de predecir objetos a pequeña escala cuyo área de marco es menor que .

(2) APm: la precisión promedio de los objetos de escala media cuyo área de marco predicha está dentro de [ ,

].

(3) API: la precisión promedio de predecir objetos a gran escala cuyo área de marco es mayor que .

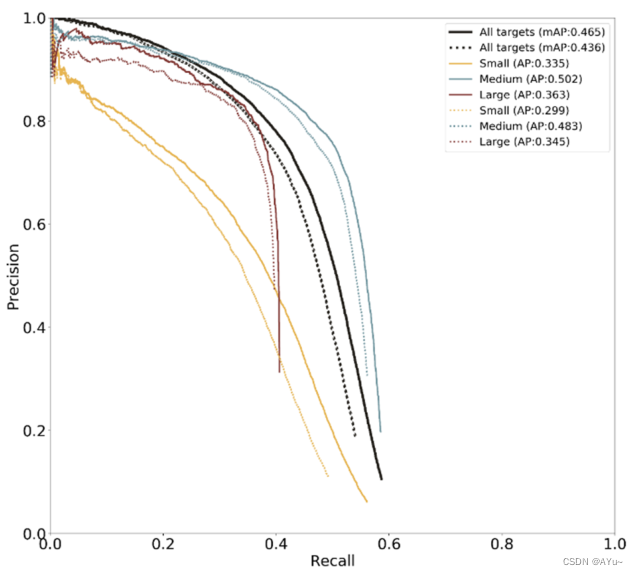

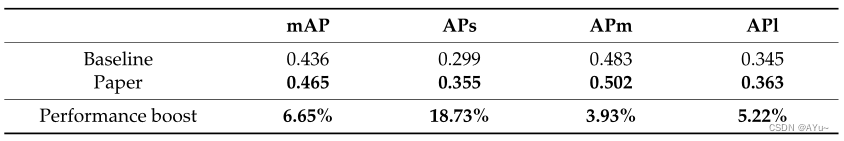

Este trabajo se prueba con el conjunto de validación de trenes v1.0-trainval del conjunto de datos nuScenes . En la Figura 12 y la Tabla 4, se puede ver que el algoritmo de este documento supera al algoritmo de detección de objetos basado en la red de referencia visual en todas las escalas. La precisión de detección promedio para objetos pequeños aumenta en un 18,73 %, lo que es significativamente más alto que la capacidad de detección para objetos medianos y grandes.

Figura 12. Comparación de la red de extensión del conjunto de datos de nuScenes con la red de referencia de prueba de escala.

Las líneas continuas representan la técnica propuesta y las líneas discontinuas representan la red de referencia.

Tabla 4. Comparación de AP de escala entre la red de fusión extendida propuesta en este trabajo y la red de referencia

5. Discusión

El entorno de conducción en el que operan los coches inteligentes es diferente del entorno de trabajo en el que operan otras máquinas de inteligencia artificial, en términos de velocidad y complejidad. Las cámaras utilizadas para adquirir datos de imágenes son vulnerables a la luz, mientras que los LIDAR utilizados para adquirir datos de nubes de puntos son vulnerables a entornos hostiles. El radar de ondas milimétricas no es bueno para detectar objetivos estacionarios , y los defectos del sensor en sí hacen imposible que los autos inteligentes completen la tarea de detección con un solo sensor. Debido al alto costo de lidar, este documento estudia principalmente cómo integrar datos de radar de ondas milimétricas con datos de cámaras para realizar la detección del entorno circundante . Un sistema de detección confiable es un requisito previo para que los autos inteligentes funcionen correctamente en condiciones de tráfico complejas, y los investigadores esperan que la tecnología de detección múltiple no solo pueda mejorar la precisión de la detección, sino también ser robusta. Por ejemplo, en un entorno con poca luz, el objetivo de detección es demasiado pequeño, pero el sistema de detección aún puede funcionar con normalidad. Con este fin, este artículo propone un algoritmo de detección de objetos que fusiona datos de cámaras y radares de ondas milimétricas. En primer lugar, sobre la base del análisis de la ruta técnica factible del radar de ondas milimétricas y la fusión de visión, se determina que la ruta de fusión en este documento es una fusión a nivel de características, y el algoritmo se entrena y prueba en función del conjunto de datos de nuScenes. . Luego, las imágenes de radar de ondas milimétricas se introducen como información auxiliar para la detección de objetos en imágenes visuales. Este artículo estudia la escalabilidad del algoritmo de detección de objetos de un nivel RetinaNet basado en la red troncal de detección VGG-16+FPN. Sobre la base de la investigación sobre VGG-16 y Feature Pyramid Network, se proponen una red VGG-16 extendida y una red piramidal de características extendidas (E-FPN) adecuadas para el radar mmWave y la fusión de visión. Al realizar una fusión en serie de características de radar de ondas milimétricas y características visuales en cada capa de la red de detección de la red troncal, se propone una red de detección de objetos de fusión amplia y profunda para el radar de ondas milimétricas y la fusión de visión . Mediante el entrenamiento y las pruebas en el conjunto de datos de nuScenes, en comparación con la red de referencia RetinaNet (VGG-16+FPN) (Baseline) para la detección de objetos de imagen visual pura, el mAp de la red en este documento ha aumentado en un 2,9 %, y el objeto pequeño la precisión de detección ha aumentado un 18,73 % ., validando la red extendida de detección de objetos de fusión propuesta en este artículo. También verifica la capacidad de detección y la viabilidad del algoritmo de la red extendida de detección de objetivos de fusión propuesta en este documento para objetivos visualmente insensibles. La investigación de este artículo tiene cierto valor de referencia para la investigación de la tecnología de percepción de fusión multisensor para vehículos de conducción inteligente, especialmente en el campo de la detección de objetivos de fusión.

6. Conclusión

En la actualidad, la percepción basada en un solo sensor y la fusión de sensores heterogéneos basada en la lógica ya no pueden cumplir con los requisitos profundos de la conducción autónoma avanzada para la información de muestras ambientales. A medida que el desarrollo de la investigación en tecnología de sensores y la tecnología de detección de objetivos entra en un período de cuello de botella, la aplicación de mercado de la conducción inteligente no puede esperar una mejora significativa en las capacidades de detección de un solo sensor a corto plazo. Este trabajo se basa en vehículos de conducción inteligente, con radar de ondas milimétricas y detección visual como objeto de investigación. Mediante el estudio del algoritmo de detección de objetivos de fusión multisensor, se propone una red extendida de detección de objetivos de fusión para hacer frente al entorno urbano y de alta Nivel de conducción inteligente El entorno de la carretera de alta velocidad tiene requisitos más altos para las capacidades de detección inteligente. Este documento amplía el algoritmo de RetinaNet basado en la red de detección troncal VGG-16+FPN y resuelve la deficiencia del algoritmo de detección de objetivos de primer nivel de RetineNet en términos de precisión de detección . Se propone una red extendida VGG-16 y E-FPN adecuada para la entrada multicanal de imágenes de radar de ondas milimétricas e imágenes visuales. La red de extracción de características de radar de ondas milimétricas y la red de detección visual de objetivos se introducen para la fusión profunda y se entrenan en el conjunto de datos nuScenes. A través de la verificación de la red propuesta y la comparación con la red de referencia, la tasa de detección de objetos de la red propuesta aumenta en aproximadamente un 25 %, la tasa promedio de objetos aumenta en un 2,9 % y la precisión promedio de los objetos pequeños aumenta en un 18,73 % Los experimentos en este trabajo han verificado la viabilidad de la red de detección de objetivos de fusión extendida propuesta basada en el algoritmo de filtrado de radar de ondas milimétricas para mejorar la capacidad de aplicación y el enfoque técnico de la detección de objetivos en el entorno del tráfico, especialmente la capacidad de detección de objetivos pequeños ha mejorado mucho. .