La reidentificación de personas con modalidades cruzadas de infrarrojos RGB a través de la combinación de píxeles y alineación de características publicada en ICCV2019 es un artículo que utiliza GAN para resolver problemas de ReID basados en RGB-IR.

Resumen

La reidentificación de peatones por la noche tiene aplicaciones importantes en áreas como la videovigilancia y la seguridad, pero este problema no se ha resuelto bien. Esto se debe principalmente a que existe una gran diferencia modal entre la imagen peatonal infrarroja en la noche y la imagen peatonal en color durante el día. Esta diferencia hace que la coincidencia de imágenes multimodales sea más difícil. Para resolver el problema del nuevo reconocimiento de peatones nocturnos, este artículo propone de manera innovadora la idea de la alineación de píxeles (Alineación de píxeles) para aliviar el problema de las diferencias modales, y propone una estrategia de Discriminador conjunto para mantener la coherencia de la identidad durante el proceso de alineación. Este método es significativamente más del 10% más alto que otros mejores métodos en el conjunto de datos de peatones nocturnos más desafiante.

Problemas actuales y descripción general:

El método tradicional es compensar la diferencia entre la modalidad cruzada y la alineación de características a través del aprendizaje de representación de características. La idea básica es unir imágenes RGB e IR reales a través del aprendizaje de representación de características. Debido a la gran diferencia intermodal entre los dos modos, es difícil hacer coincidir con precisión las imágenes RGB e IR en el espacio de características compartidas.

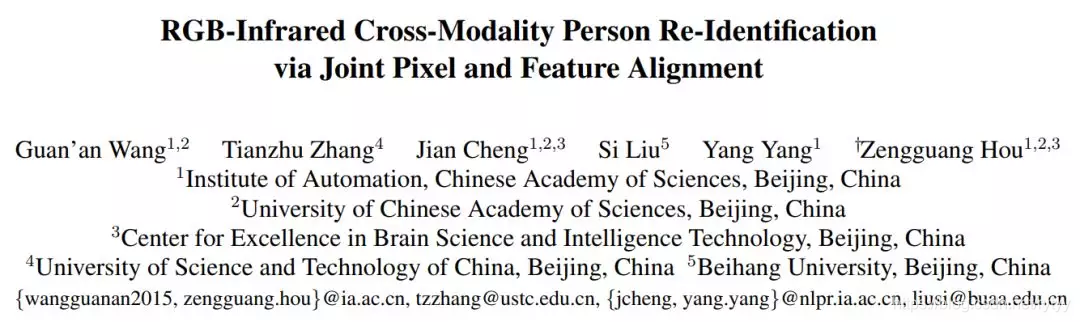

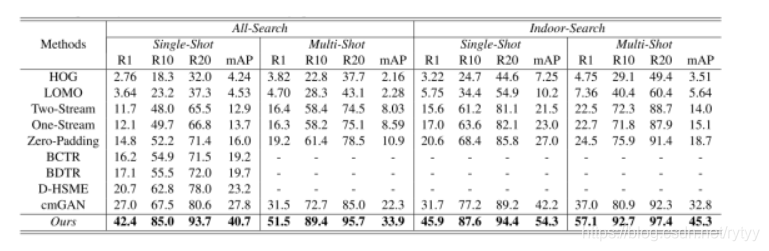

Al mismo tiempo, el CMGAN propuesto por la reidentificación de personas de modalidad cruzada con capacitación generativa adversa pertenece a la red GAN para resolver el problema intermodal, pero el rango1, mAP e ICCS de CMGAN (cuanto mayor sea el valor de ICCS, mayor será la similitud

Rendimiento ): los resultados muestran que el algoritmo tiene un bajo rendimiento en la configuración de modo cruzado y no puede superar los cambios de modo cruzado.

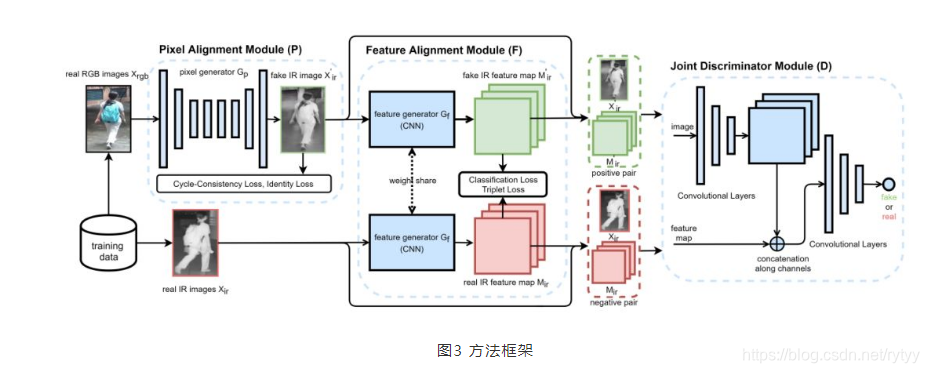

Este documento propone una red de confrontación de generación de alineación de extremo a extremo (AlignGAN) para tareas reid RGB-IR.

La red propuesta en este artículo tiene las siguientes características:

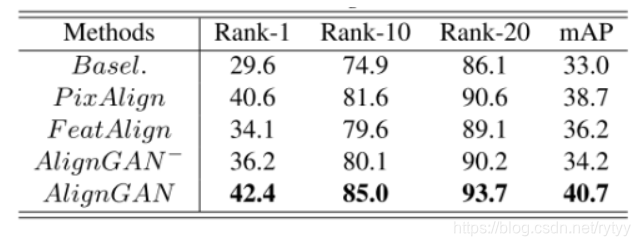

- La alineación de píxeles y la alineación de características se pueden usar conjuntamente. Este es el primer modelo que establece conjuntamente dos estrategias de calibración para el problema RGB-IR RE-ID.

- El modelo está compuesto por un generador de píxeles, un generador de características y un discriminador conjunto, de modo que no solo puede aliviar los cambios multimodales e intramodales, sino que también puede aprender las características con la misma identidad.

- En el conjunto de datos SYSU-MM01, el rango -1 y mAP aumentaron en 15.4% y 12.9%, respectivamente.

Introduccion

-

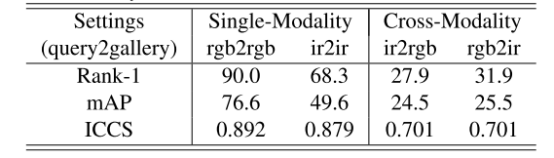

Módulo de alineación de píxeles: alivia las diferencias modales con respecto al nivel de píxeles. Una solución es usar un módulo de alineación de píxeles para sintetizar imágenes RGB en una imagen infrarroja virtual, y luego hacer coincidir la imagen infrarroja virtual con la imagen infrarroja real. De esta manera, las diferencias modales que existían originalmente entre las imágenes RGB e infrarrojas pueden aliviarse con imágenes infrarrojas virtuales. Como se muestra en la Figura 1, primero usamos un módulo de alineación de píxeles (Módulo de alineación de píxeles) para convertir las imágenes de color originales (imágenes RGB reales) en imágenes virtuales de infrarrojo cercano (imágenes IR falsas), y luego usamos la estrategia de aprendizaje de características para que coincida con la imagen virtual. Imágenes de infrarrojo cercano (imágenes infrarrojas falsas) e imágenes de infrarrojo cercano real (imágenes IR reales).

-

-

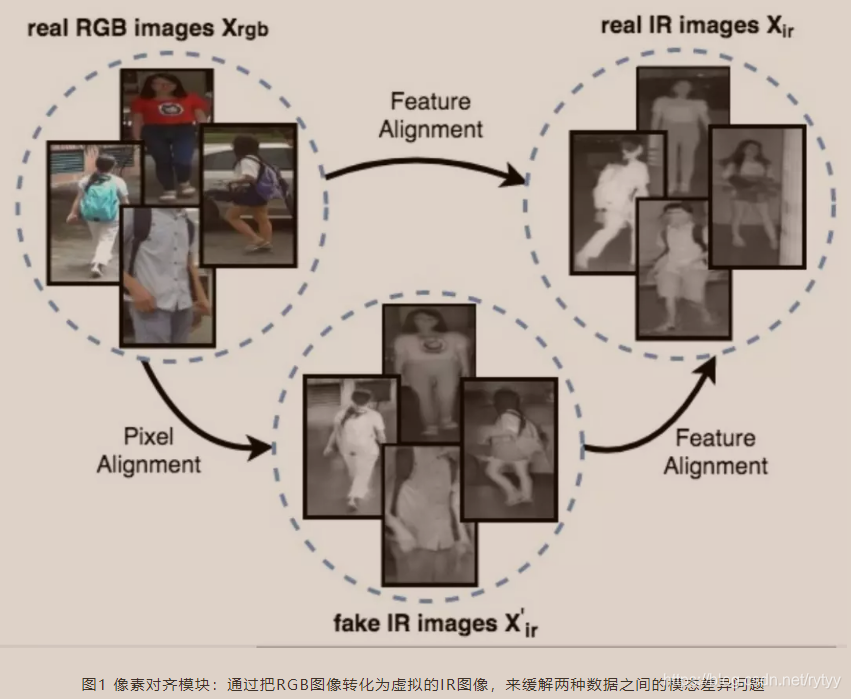

Módulo de discriminación conjunta: considere la coherencia de la identidad para garantizar que la alineación modal no introduzca nuevos ruidos. Sin embargo, todavía enfrentamos una dificultad difícil, es decir, la reidentificación de peatones es un problema de tiro cero, es decir, la etiqueta de prueba y la etiqueta de entrenamiento no coinciden. Por lo tanto, en el proceso de capacitación, ni la alineación de píxeles ni el módulo de alineación de características pueden simplemente ajustarse a las etiquetas del conjunto de capacitación para garantizar la coherencia de identidad del proceso de inferencia. Por ejemplo, en el espacio de características, los datos de color del peatón A pueden estar alineados con los datos infrarrojos del peatón B. En este caso, aunque se reduce la diferencia modal, se pierde la información de identidad y, finalmente, no se puede realizar la reidentificación peatonal correcta, que no es lo que queremos.

Para resolver los problemas anteriores, propusimos un Módulo Discriminador Conjunto. Como se muestra en la Fig. 2, el módulo de discriminación conjunta no minimiza individualmente la diferencia entre las imágenes RGB e Infrarroja, o entre las características RGB e Infrarroja, pero minimiza la diferencia entre los pares de características de imagen RGB e Infrarroja. Es decir, optimizamos la distribución conjunta de las características de imagen RGB y las características de imagen infrarroja.

Específicamente, solo aquellas imágenes y características que coinciden con la distribución de datos infrarrojos, y las imágenes y características provienen de la misma ID del par de características de imagen, el módulo de discriminación conjunta lo juzgará como verdadero. Por lo tanto, bajo este marco, no solo acercamos los datos de color originales (imágenes o características) a la distribución de datos infrarrojos (imágenes o características), lo que reduce la diferencia modal, sino que también mantenemos las imágenes y características durante el proceso de alineación. La información de identificación original.

Modelo de introducción

Módulo de alineación de píxeles: con referencia al método CycleGAN, nuestro módulo de alineación de píxeles contiene dos conjuntos de generadores y discriminadores. Estos dos conjuntos de generadores se utilizan para RGB2IR e IR2RGB respectivamente. En consecuencia, los dos conjuntos de discriminadores se utilizan para distinguir la imagen IR sintetizada y la imagen RGB sintetizada, respectivamente. Tenga en cuenta que, aunque utilizamos dos conjuntos de generadores y discriminadores en el proceso de capacitación, en el proceso de inferencia, solo utilizamos el generador RGB2IR para realizar operaciones de alineación de píxeles.

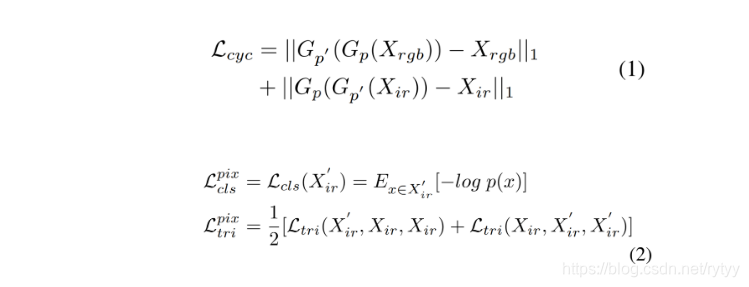

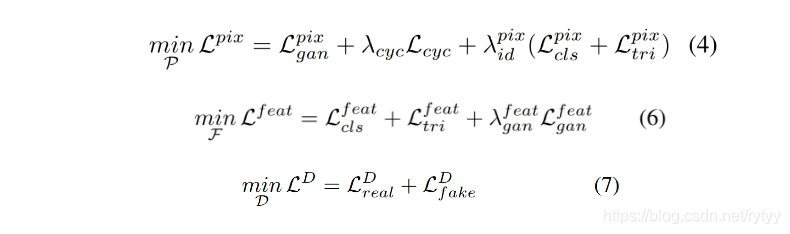

Específicamente, nuestro módulo de alineación de píxeles incluye una pérdida de ciclo (pérdida de ciclo) y una pérdida de ID (cls + tri). Entre ellos, la pérdida de bucle hace que las imágenes generadas puedan mantener la estructura y el contenido original (como la postura, el ángulo, etc.), y la pérdida de ID hace que la imagen sintetizada mantenga la misma información de identidad que la imagen original tanto como sea posible. Estas funciones de pérdida se muestran en la Ecuación 1 y la Ecuación 2, respectivamente.

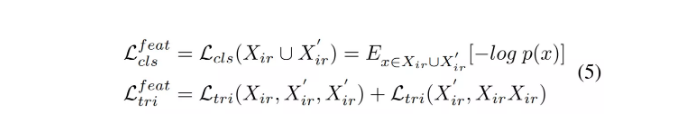

Módulo de alineación de funciones (Módulo de alineación de funciones ) Aunque el módulo de alineación de funciones puede reducir las diferencias entre modalidades, pero aún existen grandes diferencias dentro de la modalidad (dentro de las modalidades), estas diferencias se deben principalmente a la postura, la perspectiva Así como la luz y otros factores. Para resolver este problema, adoptamos un módulo de alineación de características para mapear imágenes infrarrojas reales e imágenes infrarrojas sintetizadas en el mismo espacio de características, y usar la clasificación basada en etiquetas de identidad y la pérdida de tripletas para supervisar las características. La función de pérdida correspondiente se muestra en la Ecuación 5.

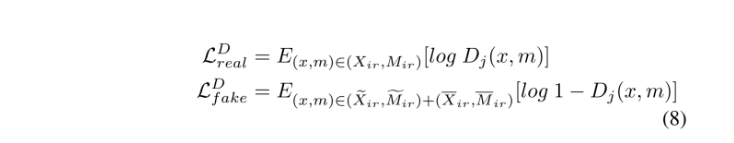

Módulo Discriminador Conjunto. De acuerdo con la discusión anterior, para mantener mejor la coherencia de la identidad, proponemos un módulo de discriminación conjunta para aprender la distribución conjunta de datos de pares de características de imagen. Específicamente, su entrada es un par de características de imagen. Solo las imágenes y características verdaderas, y de la misma ID, se considerarán verdaderas, de lo contrario falsas. La función objetivo correspondiente se muestra en la ecuación 8.

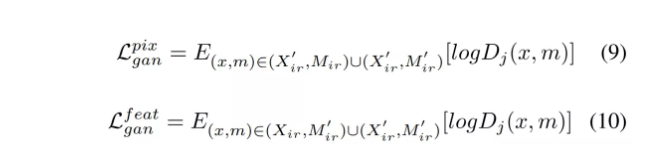

En consecuencia, las funciones anti-pérdida del módulo de alineación de píxeles y el módulo de alineación de características se muestran en la Ecuación 9 y la Ecuación 10, respectivamente.

Finalmente, nuestro modelo puede completarse optimizando las funciones objetivas que se muestran en la Ecuación 4, la Ecuación 6 y la Ecuación 7.

Experimento

Conjunto de datos:

Comparación entre SYSU-MM01 y RegDB :

Comparación de diferentes variables en este artículo:

Característica de visualización del espacio

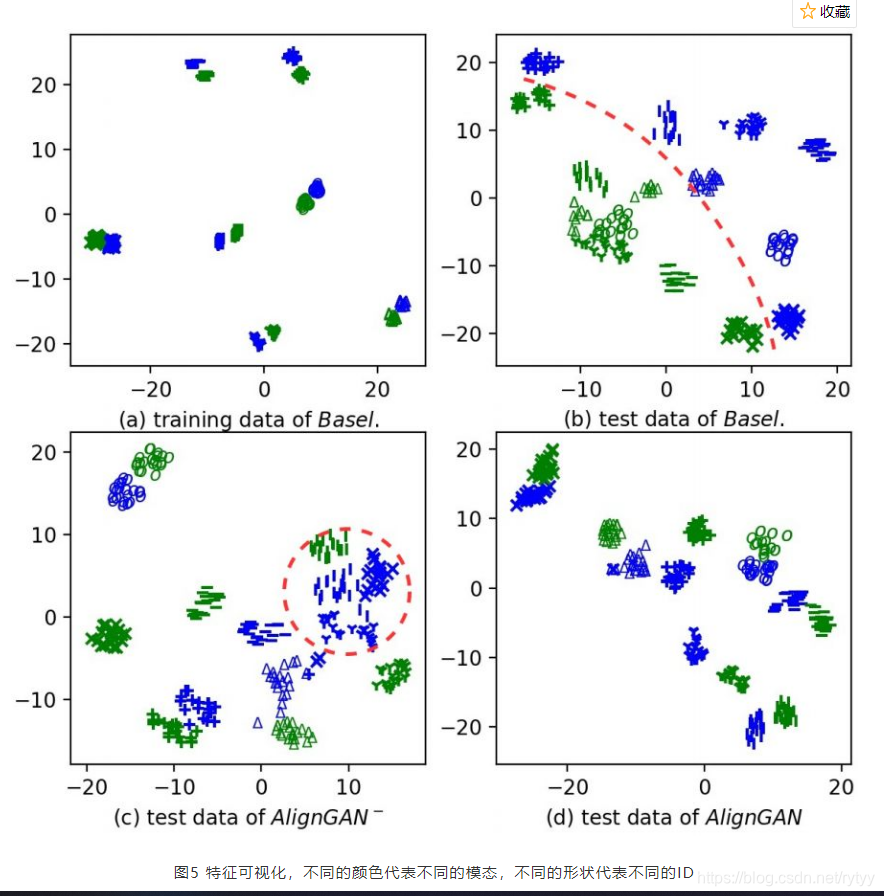

Como se muestra en la Figura 5 (a) y la Figura 5 (b), algunos métodos de línea de base simples pueden alinear bien los datos de entrenamiento, pero los datos de la prueba no pueden estar bien alineados, lo que indica que la diferencia intermodal no puede realizarse mediante un método de alineación de características simple Resuelto Como se muestra en la Figura 5 ©, cuando solo usamos el módulo de alineación de píxeles, la diferencia modal se ha reducido considerablemente, pero todavía hay algunas inconsistencias de identidad (como se muestra en el círculo rojo). Finalmente, la Figura 5 (d) muestra que después de utilizar nuestra estrategia discriminante conjunta, la consistencia de la identidad puede mantenerse bien.

Materiales de referencia:

- https://mp.weixin.qq.com/s/T9zbXi9zLG6pOwwPAWdrhQ

- https://blog.csdn.net/qq_41967539/article/details/104282356?ops_request_misc=%257B%2522request%255Fid%2522%253A%2522158364283319724839237170%2522%252C%2522scm%2522%25%%%%A%%%A2%%A2%%%%2%%%%%2&&&&&&&&&&&&&%%%%%%%%%% </i> </i> % 2522% 257D & request_id = 158364283319724839237170 & biz_id = 0 & utm_source = distribuir.pc_search_result.none-task