edad contradictorio Camou fl: Ocultación de los ataques del mundo físico con los estilos naturales

Miembros: Zhang Ronghua Lijun Yu raíz Yang

Una descripción del problema

Redes Neuronales ( DNNS ) son una clase de modelo de gran alcance, que ha sido ampliamente utilizado en diversos sistemas de inteligencia artificial, pero vulnerable frente a los ejemplos.

El futuro de nuestra sociedad debe ser un entorno automatizado, tales como el hogar inteligente, seguridad inteligente, piloto automático y otros puestos de trabajo a través de una gran cantidad de sensores, cámaras, escáneres se puede hacer directamente, sin la necesidad de que las personas que intervengan. tecnología de redes neuronales actualmente ocupan una posición importante, si la detección de blancos, el reconocimiento de rostros, no hay personas embarazadas bien intencionado invaden su sistema, el uso de las características de las redes neuronales, la entrada ilegal de algunos de camuflaje, la red ha sido spoofing se considera salida de la red legítima, y que las pérdidas causadas daño será grande.

2 Soluciones

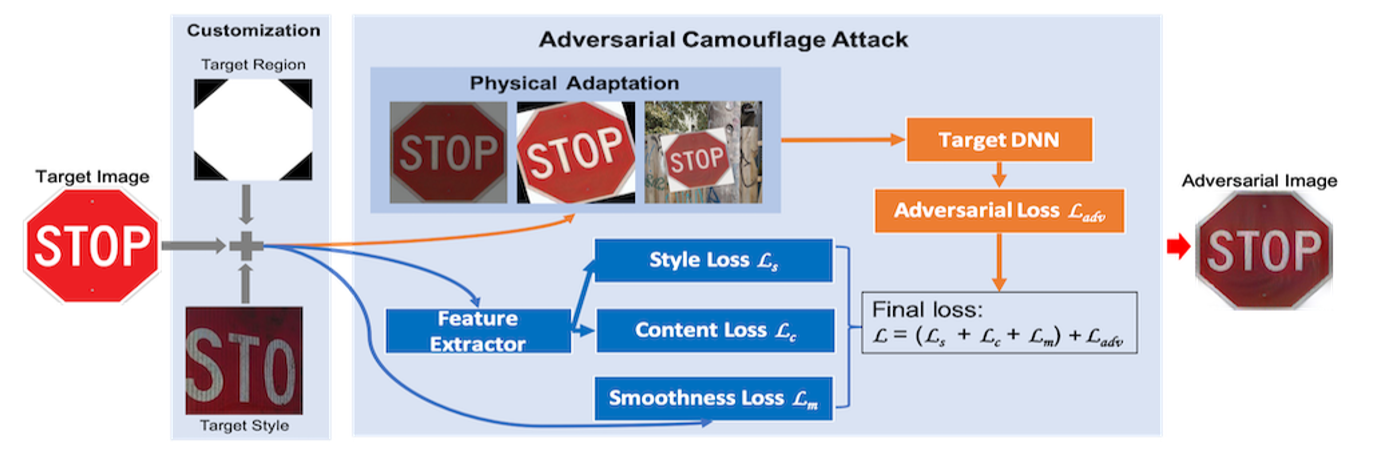

El autor propone un nuevo enfoque, llamado "combate de camuflaje" (AdvCam) , el ejemplo del mundo físico en la lucha contra disfrazado de procesamiento y el estilo natural, por lo que la gente en el observador parece razonable, y por lo tanto para probar la D robustez de NN.

3 Fase Ver conceptos técnicos

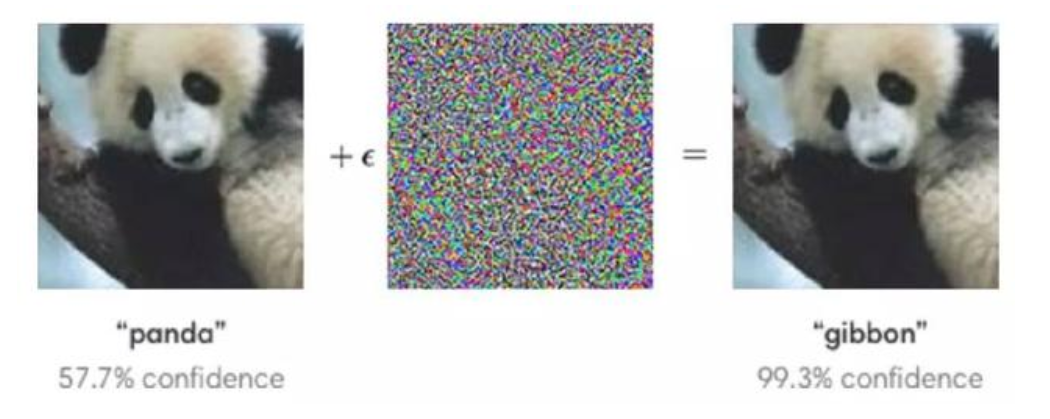

Contra el ataque: Vamos a empezar con la forma más intuitiva para saber lo que está en contra de ataque? A continuación, la izquierda es una puede GoogLeNet clasifican normalmente como panda imágenes en la derecha después de la adición de un poco de ruido en la vista del ojo humano, es el panda, pero GoogLeNet será determinado como gibones. Esta respuesta ha sido modificado seres humanos no pueden percibir obvio, identificación de la máquina era muestra de datos errónea es la confrontación, y que todo el proceso puede ser entendido como ataques contra

Atacar el mundo físico: el mundo real con una distorsión mayor y menor de la realidad (fácilmente identificable observador humano) contra el ejemplo creado.

ataques digitales: por ejemplo, contra más pequeños y difíciles de detectar perturbaciones digital creado.

4 diseño

4.1 instrucciones

- ataques de confrontación se pueden caracterizar usando tres características:

- 1) antagonismo, que representa engañar DNN capacidad;

- 2) El secreto antagonismo, es decir, si el observador puede detectar la interferencia resistible;

- 3 ) la flexibilidad de camuflaje que un atacante puede controlar la apariencia de las imágenes de confrontación nivel.

La mayor parte de los ataques enfoques desarrollados para el entorno digital, como "descenso de gradiente proyectado" (DGP ), para los ataques digitales, por lo general pequeña perturbación es suficiente. Sin embargo, el atacante necesita mundo físico y aún mayor perturbación ilimitada, porque la perturbación más pequeña se mueve demasiado sutil, compleja y no puede ser capturado en el entorno del mundo físico de la cámara. Varios método de perturbación relativamente pequeña de ataque ya existe, por ejemplo, contra el parche ( Patch contradictorio: AdvPatch) y una fuerte perturbación física (RP2).

4.2 marco general

4.3 realización

4.3.1 pérdida Estilo

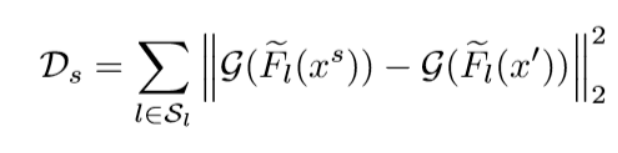

- Para el ataque tradicional, oculto medida estándar: D (X, X ' ) = || X - X ' || P . En donde || || P es L P norma, que se utiliza generalmente es L 2 y L ∞ esto es estar limitada a una pequeña perturbación. Para papel camuflaje presentado, el antagonista ejemplar oculto x 'y la referencia patrón de imagen X S índice estilo entre medido. Los estilos pueden ser definidos por la distancia entre las dos imágenes representadas por la diferencia en el patrón:

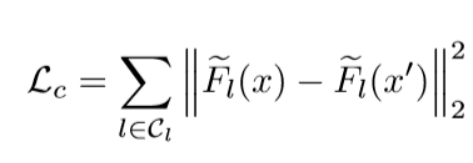

4.3.2 pérdida de contenido

- estilo anterior puede generar una pérdida de la imagen de referencia en contra en el estilo, pero el contenido contra la imagen puede ser muy diferente de los contenidos de la imagen original. perdido contenido se define de la siguiente manera:

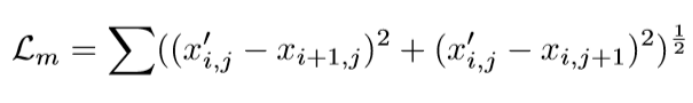

4.3.3 pérdida de suavidad

- Contra la suavidad de una imagen mediante la reducción de la variación entre los píxeles adyacentes para aumentar. Por contra de la imagen x', la pérdida de suavidad se define como:

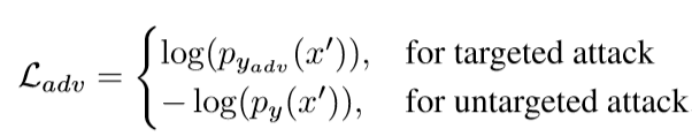

4.3.4 pérdida Acusatorio

- Para las pérdidas de confrontación, el documento utiliza la siguiente pérdida de entropía cruzada:

4.3.5 Adaptación de las condiciones físicas del mundo

- Para hacer AdvCam confrontación generada se puede implementar físicamente, modelamos las condiciones físicas en el proceso de generación de la confrontación de camuflaje. Debido al mundo físico a menudo implican condiciones ambientales cambian, como el punto de vista se mueve, el ruido de la cámara y otra transformación natural, por lo que utilizar una serie de la aptitud debe ser formas de adaptarse a las condiciones de ese cambio. En particular, se espera que el uso de la conversión ( EOT tecnología similar), pero no esperábamos. Nuestro objetivo es mejorar ejemplos de confrontación en una variedad de condiciones de adaptabilidad física. Por lo tanto, consideramos que las condiciones del mundo físico para la conversión de analógico volatilidad, incluyendo rotación, escalado tamaño, el color parcial de cambio (cambio en la iluminación analógico) y el fondo al azar .

5 entorno experimental

Los autores propusieron que la AdvCam ataque a dos métodos representativos existentes : PGD y parche de confrontación (AdvPatch) se compararon.

Seleccione el modelo de amenazas: Probamos los ataques dirigidos y no dirigidos en los entornos digitales y físicos. modelo de amenazas utiliza configuración del cuadro de grises : el origen y las redes de destino son VGG-19 a la red, pero IMAGEnet están entrenando sucesivamente.

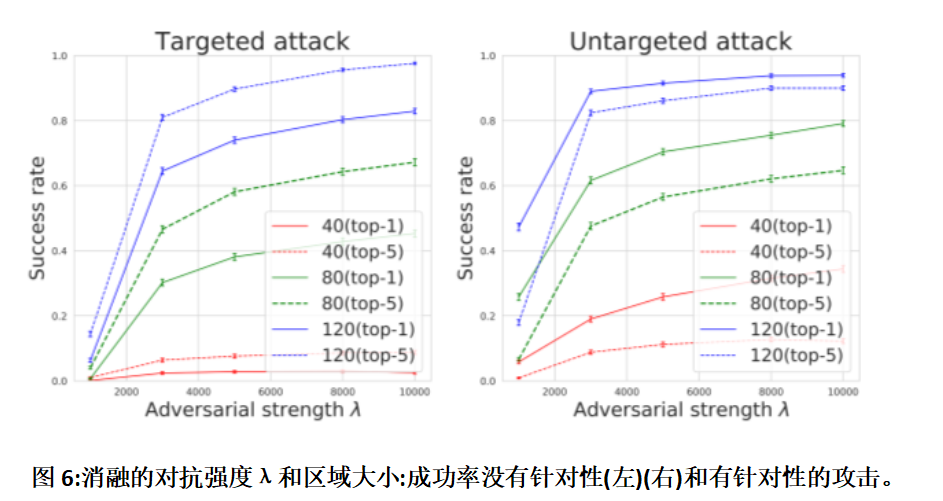

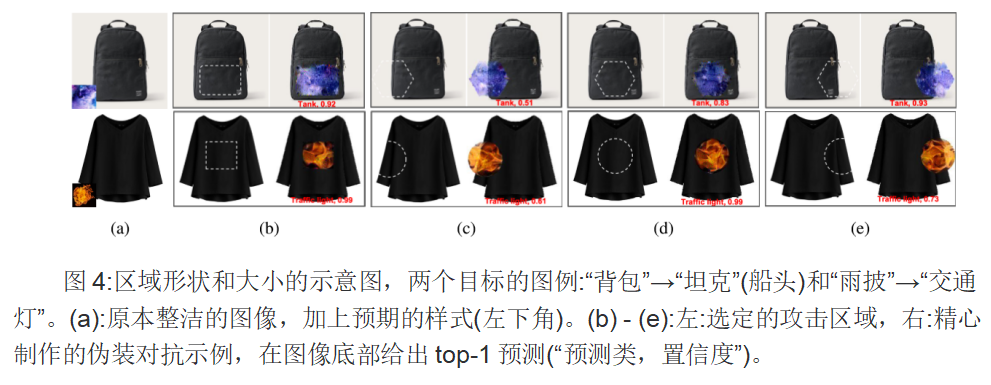

Desde el conjunto de tres experimentos: 1) la forma y posición de la zona de camuflaje , 2) pérdida encubierta y la pérdida de suavidad ( por ejemplo, estilo, pérdida de contenido ), y 3) la intensidad y el tamaño de la región de confrontación parámetro λ.

1) la forma y posición de la zona de camuflaje

Dada una forma y tamaño de la zona del ataque seleccionado , aumentamos el parámetro de intensidad λ en el intervalo [100, 1000]:

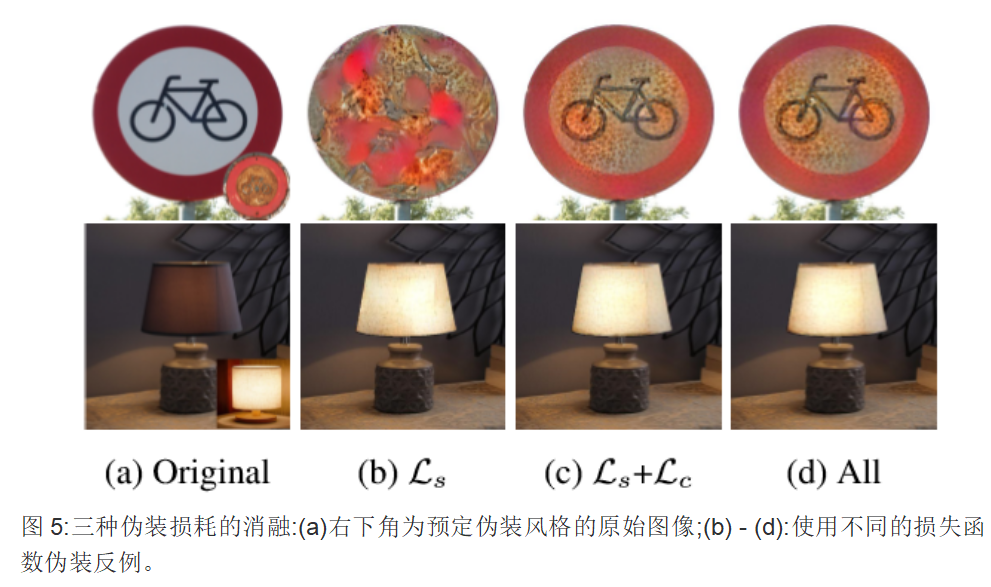

2) la pérdida y el camuflaje suavidad pérdida

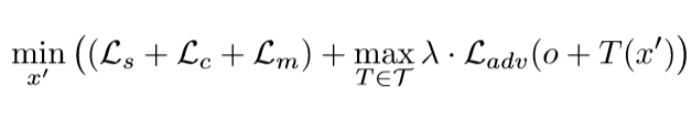

Camuflado contra tres ejemplos, en los que con o sin dos mejoras opcionales ( contenido de almacenamiento de Lc y suavidad mejoradas Lm) . Cuando un refuerzo , que la función de pérdida se añade directamente al objeto final de acuerdo con la Ec .

3) parámetros de resistencia contra el tamaño del área λ y

No proceso específico ataque de suplantación objetivo y seleccionados al azar 50 2000 IMAGEnet imágenes de prueba de diferentes categorías [lambda] (1000 , 10000) . Para los ataques dirigidos, la clase de destino se selecciona al azar, y la diferencia de clase real.

5.1 Ataque Digital

Para los autores de IMAGEnet ILSVRC2012 prueba de conjunto de 5 categorías seleccionadas al azar 150 Zhang imagen limpia, y luego aplicar el DGP , AdvPatch y nuestros AdvCam tres maneras de limpiar cada imagen para hacer un ejemplo confrontación apuntado. Para PGD y AdvCam , que ataque de los principales objetivos de la selección artificial obtenido, y para AdvPatch , se seleccionaron adicionalmente dentro del área objetivo un área circular de ataque. Para PGD, usamos la máxima perturbación = 16/255 (denotado DGP-16) .AdvCam, que selecciona aleatoriamente una imagen de la imagen de la misma categoría de estilo , de 1000 años a 10.000 años , aumentando gradualmente lambda , hasta que encuentre un ejemplo de un hostil.

5.2 ataques físicos

Para los autores diseñaron otros tres escenarios de ataque mundo físico para probar nuestra AdvCam ataque camuflaje. También realizamos AdvPatch y PGD se compararon los ataques.

6 ventajas y desventajas

ventajas:

1.AdvCam es un método flexible, que puede ser utilizado DNN modelo de evaluación robusto.

2.AdvCam puede ser utilizado como camuflaje para proteger unos objetivos significativos o se basaron en los observadores humanos y DNN detección de dispositivos.

desventajas:

- Actualmente propuso AdvCam todavía tienen que especificar manualmente los estilos de ataque atacante y de destino, tenemos la intención de explorar la tecnología de segmentación semántica en futuros trabajos para automatizar esto.

7 análisis resumen

Papel, los autores proponen contra el ataque se puede aplicar a la escena digital, la entrada atacante puede entrada de imagen digital directamente a la DNN clasificador ; establecimiento mundo físico, DNN clasificador sólo se acepta la entrada de la cámara, el atacante sólo ha presentado a la cámara contra de la imagen. Tres Caracterización: fuerza de confrontación, que representa tonto DNNS capacidad ; antagonismo invisible, es acerca de si la interferencia de confrontación puede ser detectado por el observador humano ; flexibilidad camuflaje, que es, un atacante puede controlar la imagen oponente grado surgen.

Continuará explorando AdvCam utilizar en otras tareas de visión por ordenador, incluyendo la detección de objetos y la segmentación. Y la investigación en profundidad sobre la estrategia de defensa ataque efectivo dirección de camuflaje.