En la sección anterior, hablamos sobre el algoritmo de descenso de gradiente, esta sección vamos a querer combinar el descenso de gradiente función de costes y obtener un algoritmo de regresión lineal. Se puede utilizar para adaptarse a un modelo de datos de línea recta.

En primer lugar, mirar hacia atrás en el conocimiento previo. descenso de gradiente lado izquierdo, el lado derecho es un modelo de regresión lineal (incluyendo asumiendo una función de coste varianza paz lineal).

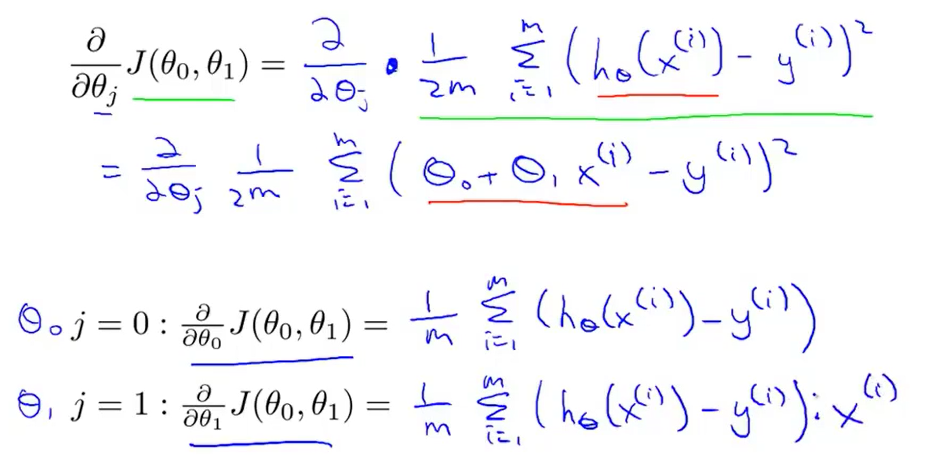

Que tenemos que hacer es aplicar el algoritmo de descenso de gradiente para minimizar la función de coste diferencia al cuadrado. Para aplicar descenso de gradiente, tenemos que averiguar la fórmula derivado plazo.

Que tenemos que hacer es aplicar el algoritmo de descenso de gradiente para minimizar la función de coste diferencia al cuadrado. Para aplicar descenso de gradiente, tenemos que averiguar la fórmula derivado plazo.

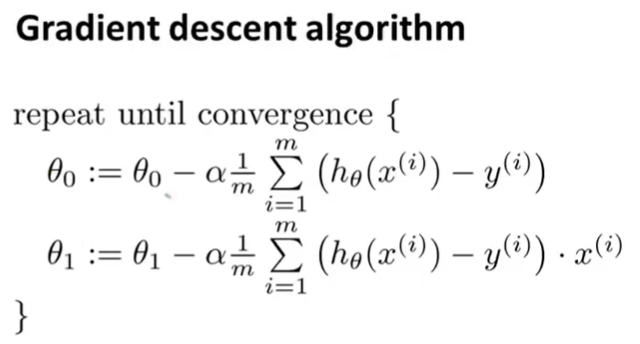

Cuando terminamos el cálculo, vamos a volver a ellos en nombre de nuestro algoritmo de descenso de gradiente. Obtenemos la fórmula que se muestra a continuación.

Este es nuestro algoritmo de regresión lineal. Nota: Cuando se implementa el algoritmo, tenemos que actualizar también [theta] 0 y [theta] 1 .

Este es nuestro algoritmo de regresión lineal. Nota: Cuando se implementa el algoritmo, tenemos que actualizar también [theta] 0 y [theta] 1 .

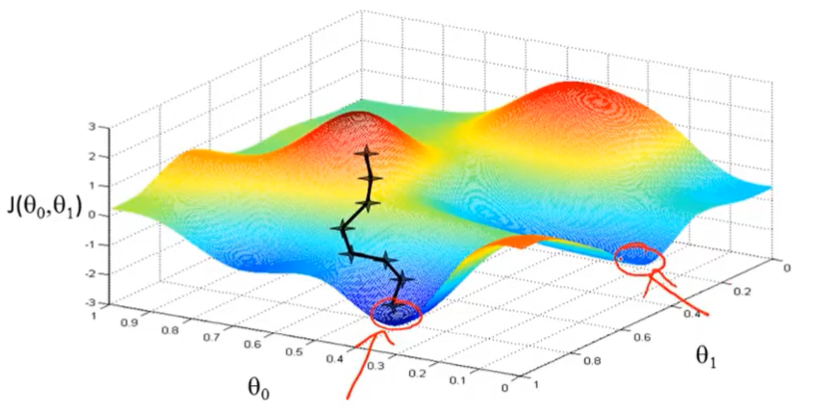

A continuación, vamos a ver cómo se logra el descenso de gradiente. En nuestro ejemplo anterior, ha habido es fácil caer en óptimo local. A continuación, vamos a llevar a una posición de partida diferente tenemos dos óptimos locales diferentes.

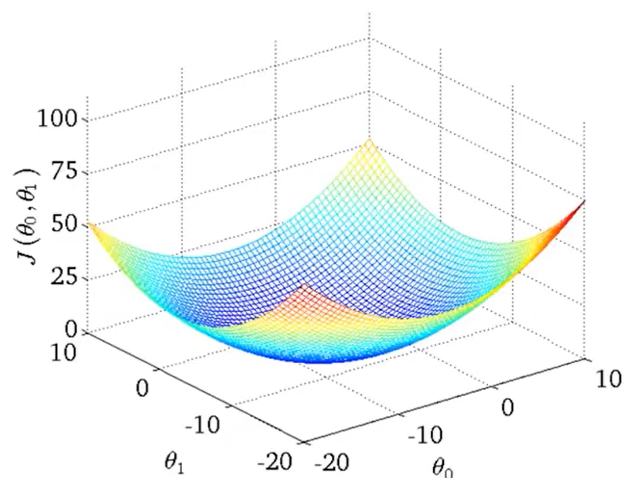

Sin embargo, la función de regresión lineal arqueada siempre una función de coste, como se muestra a continuación.

Sin embargo, la función de regresión lineal arqueada siempre una función de coste, como se muestra a continuación.

Esta función es una función de sólo un óptimo global . Al calcular esta disminución de la función de costos de gradiente, siempre y cuando se está utilizando una regresión lineal, será siempre converge al óptimo global. Debido a que no tiene otra óptimos locales.

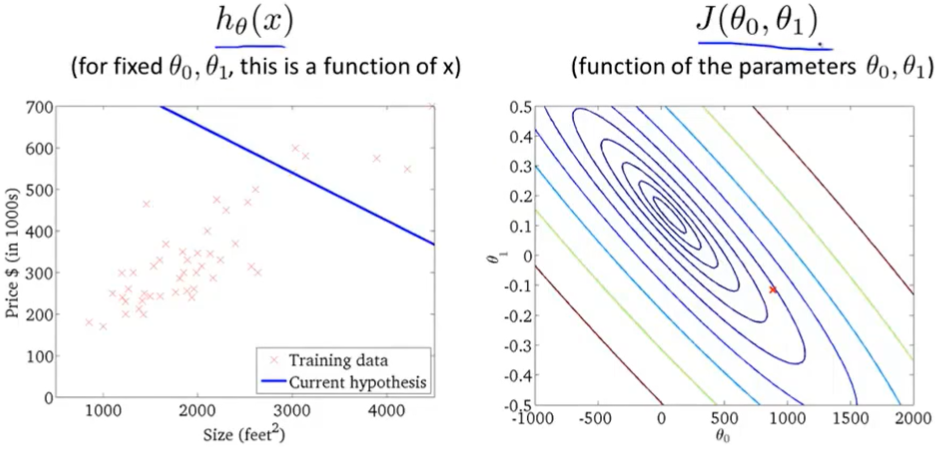

Ahora nos centraremos en el uso de este algoritmo. Hay curvas y se asume la función J coste que una función de una curva.

Nos inicialización valor del parámetro, la forma en que se pueden conseguir una línea.

Nos inicialización valor del parámetro, la forma en que se pueden conseguir una línea.

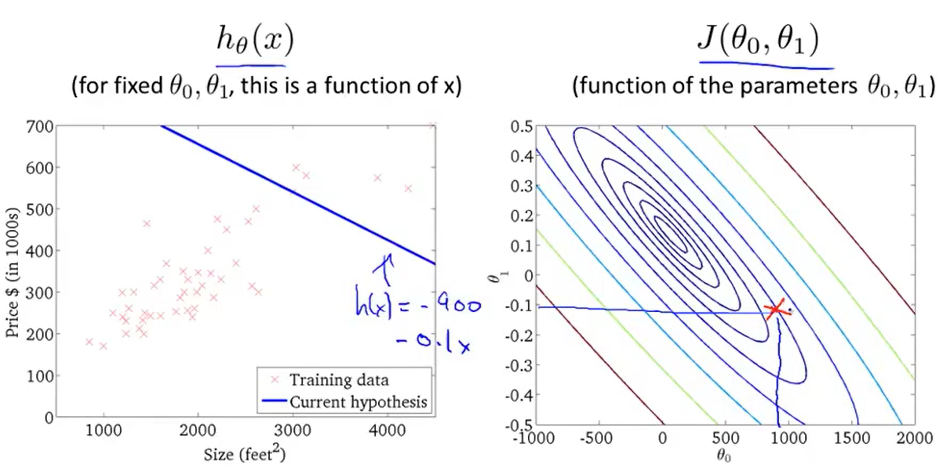

Si nos gradiente escalonado descenso, vamos a mover un poco hacia la parte inferior izquierda de este punto. A continuación, vamos a llegar otra nueva línea. Declinamos cada paso, obtendrá menos costoso de la nueva línea. A medida que seguimos por la apariencia de líneas rectas cada vez mejor. Finalmente, llegamos al mínimo global.

Si nos gradiente escalonado descenso, vamos a mover un poco hacia la parte inferior izquierda de este punto. A continuación, vamos a llegar otra nueva línea. Declinamos cada paso, obtendrá menos costoso de la nueva línea. A medida que seguimos por la apariencia de líneas rectas cada vez mejor. Finalmente, llegamos al mínimo global.

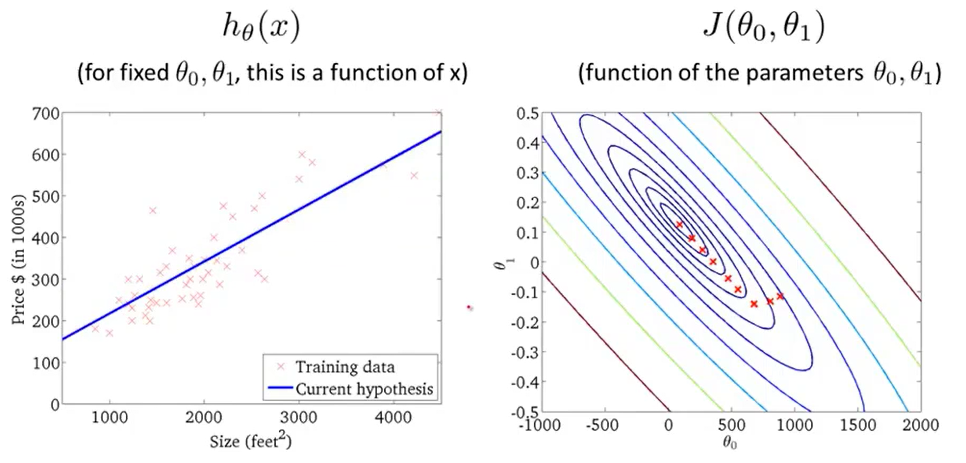

Obviamente, en este momento la línea de datos de un buen ajuste. Este es el descenso de gradiente.

Obviamente, en este momento la línea de datos de un buen ajuste. Este es el descenso de gradiente.

Acabamos de algoritmo de aprendizaje a veces también se refiere como gradiente descendente por lotes (batch descenso de gradiente). Esto significa que cada paso de descenso de gradiente, hemos utilizado todas las muestras de entrenamiento en el descenso de gradiente, en el cálculo de la expresión diferencial de derivación, necesitamos suma, por lo tanto, en cada descenso de gradiente individual en finalmente, tenemos que calcular una cosa así, la suma de todos los elementos de la muestra necesita un entrenamiento. Por lo tanto, gradiente Nombre del lote método de descenso de espectáculos que debemos tener en cuenta todos los lotes " " muestras de entrenamiento, y de hecho, a veces hay otros tipos de descenso de gradiente, este no es el " lote " de tipo, sin tener en cuenta todo el conjunto de entrenamiento pero cada vez que sólo se ocupa de un pequeño subconjunto del conjunto de entrenamiento. En lecciones posteriores, introduciremos estos métodos.

El algoritmo de gradiente a lote de la regresión lineal, que se utiliza para el método de descenso de gradiente de regresión lineal.

Si usted ha estudiado antes de álgebra lineal, debe saber Métodos Numéricos para el cálculo de la función de coste mínimo, esto no requiere un algoritmo de descenso de gradiente iterativo. En una lección posterior, vamos a hablar de este método, se puede sin la necesidad de un descenso de gradiente de múltiples pasos, sino también para resolver la función de costo mínimo, que es otro que se llama ecuación normal ( normal las ecuaciones ) de método. De hecho, en el caso de grandes cantidades de datos, el método de descenso de gradiente a ser más adecuado que la ecuación normal de .

Ahora que hemos dominado el descenso de gradiente, podemos utilizar el método de descenso de gradiente en un entorno diferente, lo vamos a utilizar en una gran cantidad de problemas de aprendizaje automático. Por lo tanto, felicitaciones por el éxito que aprenden sus primeros algoritmos de aprendizaje automático.