Anote algunas de las ideas que leo los periódicos.

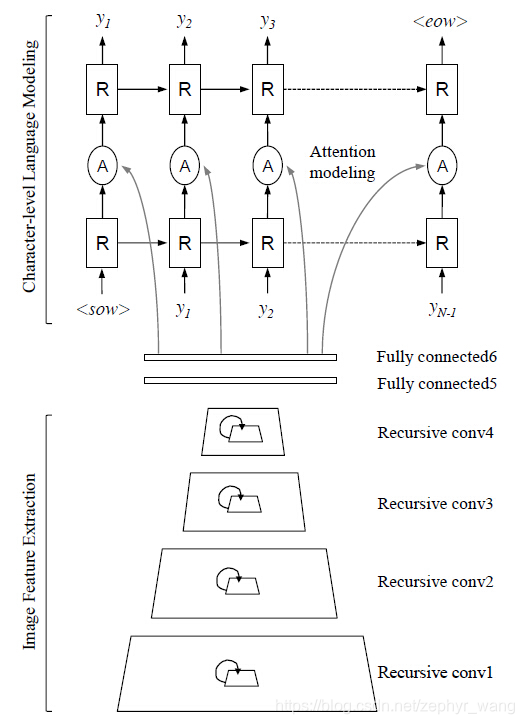

Recursiva recurrente Nets con Atención Modelado para OCR en la naturaleza, el modelo tiene tres componentes, a saber, recursiva CNN, RNN (red neuronal recurrente de trabajo), modelo de atención suave. Como se muestra en la figura. Imágenes recursiva para la codificación de la CNN (foto de extracción de características), modelo RNN para el nivel de personaje del lenguaje, centrar la atención en un mejor uso de la función de la imagen.

Al mismo tiempo, este modelo no se basa en el diccionario.

Recursive recurrente Nets Con la atención de modelado para OCR en el salvaje, El modelo es una sola palabra de predicción recortada imagen.

capa de la CNN

CNN Hay tres enfoques para mejorar la capacidad de predecir el texto hacia arriba y hacia abajo la relación:

La primera es utilizar un tamaño de grano grande, o una red más profundo, aumentar la sensación de respuesta en el dominio.

El segundo es el uso de recursiva Esta;

el tercero es el uso de recurrente.

En este trabajo se encontró que el uso más rendimiento recursvie, tal vez porque los términos recursiva CNN recurrentes en comparación con la señal de error puede prevenir propagación hacia atrás directa.

Dividido en recursivo CNN en una pesos de alimentación-forword inter-capa inicial y pesos recursivas intra-capa,

capa RNN

Los dos mejores de factorización, una primera capa RNN centra en el modelo de nivel de personaje, RNN centró en la segunda características estadísticas conjuntas de expresión y de imágenes. RNN efecto no es mejor que la factorización.

El modelo no utiliza LSTM, porque este trabajo identificar ocho caracteres en torno a corto carácter, no el reconocimiento mucho carácter. Con la LSTM no levantar demasiado utilidad.

modelado de la atención

Atención mecanismo permite que el modelo se centre en la sección más importante de la entidad de entrada.

La atención se puede dividir en la atención y la atención disco blando. atención dura sobre todo para aprender una serie de posición discreta, y la atención de extremo a extremo suave entrenamiento estándar de propagación hacia atrás.

Atención RNN en las dos capas intermedias.

Resumen, este modelo no utiliza CTC, por lo que sólo reconocer palabras individuales. Pero se puede combinar con CTC en la identificación de caracteres pasada, más de una palabra. Este modelo CRNN y similares, CRNN es CNN + RNN (LSTM) + CTC.