Начиная с нуля, локализуйте большую модель Tongyi Qianwen для вызовов API Alibaba Cloud Tongyi Qianwen.

1. Знакомство с большой моделью Тонги Цяньвэнь

Что такое «Тунъи Цяньвэнь»?

«Большая модель Тонги Цяньвэнь» — это очень крупномасштабная языковая модель, запущенная Alibaba Cloud. Она обладает мощными возможностями индукции и понимания и может решать различные задачи обработки естественного языка, включая, помимо прочего, классификацию текста, генерацию текста, анализ настроений и т. д. . . Эта модель может значительно повысить эффективность и точность обработки естественного языка, предоставляя пользователям новый и простой инструмент.

Тонги Цяньвэнь полностью открыт

13 сентября 2023 года Alibaba Cloud объявила, что крупная модель Tongyi Qianwen прошла первую партию регистрации и официально открыта для общего доступа. Индивидуальные и корпоративные пользователи могут вызывать API Tongyi Qianwen через Alibaba Cloud.

Подробное объяснение модели Тонги Цяньвэнь:https://modelscope.cn/models/qwen/Qwen-7B - Чат/сводка

Адрес пробной версии 7B:https://modelscope.cn/studios/qwen/Qwen-7B - Чат-Demo/summary?login=from_csdn

Способность Тонги Цяньвэнь

Обычный диалог в основном выводится за секунды, что изначально соответствует коммерческим стандартам.

Цель:

- Создавайте тексты, например, пишите рассказы, напишите официальные документы, напишите электронные письма, напишите сценарии, напишите стихи и т. д.

- Написать код

- Предоставлять услуги перевода на различные языки, такие как английский, японский, французский, испанский и т. д.

- Выполнение таких работ, как шлифовка текста и обобщение текста.

- ролевые беседы

- Создание диаграмм

- …

2. Локализованное развертывание

Локализованное развертывание и API Tongyi Qianwen по-прежнему очень лаконичны. Хотя это и не происходит в один клик, это почти то же самое.

1. Конфигурация

python >=3.8 и выше

pytorch 1.12 и выше, рекомендуется версия 2.0 и выше

CUDA 11.4 и выше (пользователи графического процессора, flash- внимание пользователей и т. д. необходимо рассмотреть этот вариант)

pip install модельскоп

2. Пример кода

from modelscope import AutoModelForCausalLM, AutoTokenizer, snapshot_download

from modelscope import GenerationConfig

# Note: The default behavior now has injection attack prevention off.

model_dir = snapshot_download("qwen/Qwen-7B-Chat", revision = 'v1.1.4')

tokenizer = AutoTokenizer.from_pretrained(model_dir, trust_remote_code=True)

# use fp16

# model = AutoModelForCausalLM.from_pretrained(model_dir, device_map="auto", trust_remote_code=True, fp16=True).eval()

model = AutoModelForCausalLM.from_pretrained(model_dir, device_map="auto", trust_remote_code=True).eval()

# Specify hyperparameters for generation

model.generation_config = GenerationConfig.from_pretrained(model_dir, trust_remote_code=True) # 可指定不同的生成长度、top_p等相关超参

# 第一轮对话 1st dialogue turn

response, history = model.chat(tokenizer, "你好", history=None)

print(response)

# 你好!很高兴为你提供帮助。

# 第二轮对话 2nd dialogue turn

response, history = model.chat(tokenizer, "给我讲一个年轻人奋斗创业最终取得成功的故事。", history=history)

print(response)

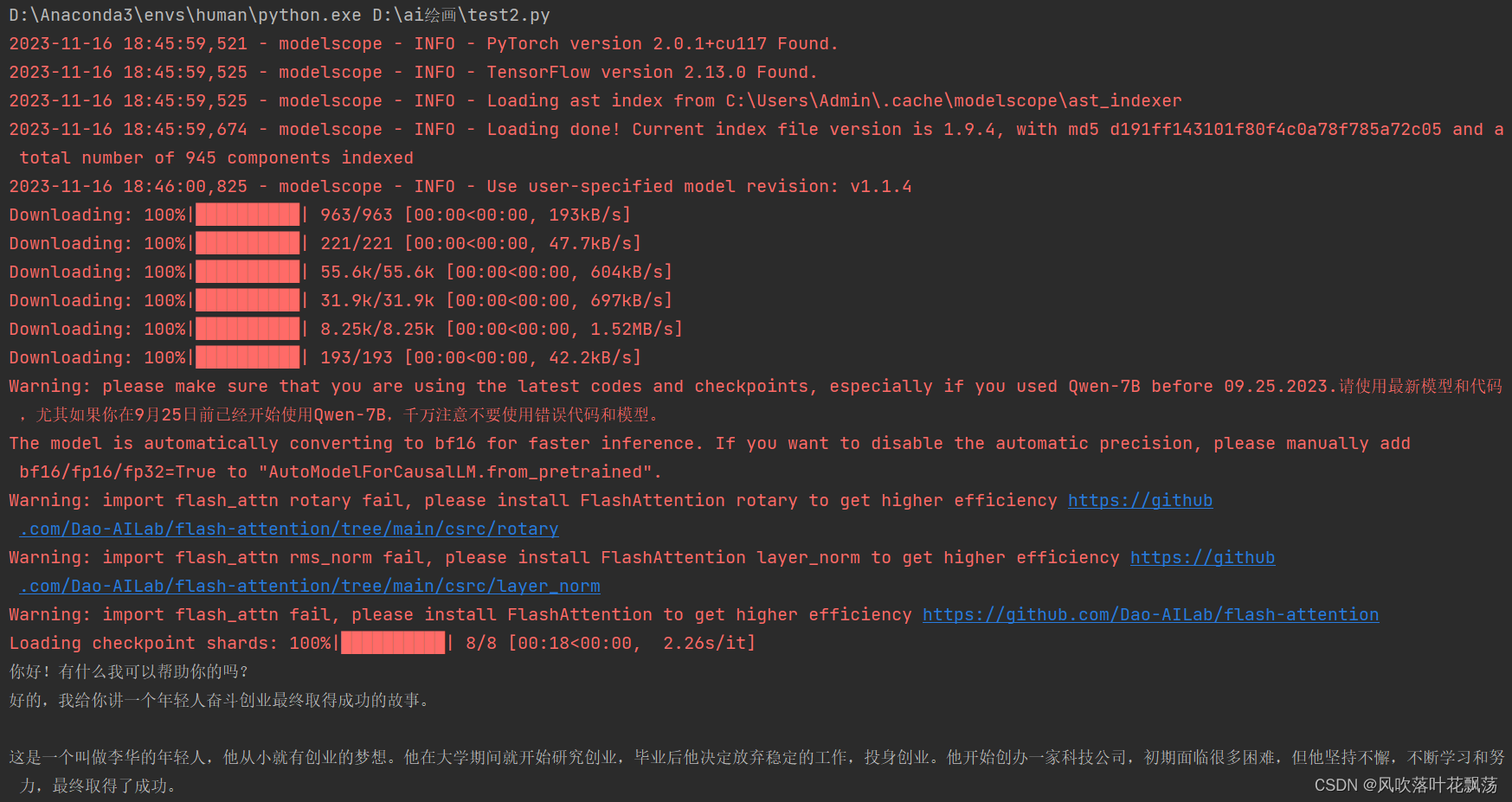

3. Результаты операции

Примечание. Для первого запуска необходимо загрузить модель из сообщества Magic Tower qwen/Qwen-7B-Chat. Не забудьте отключить обход стен

Примечание: после при запуске модель будет автоматически установлена в: C:\Users\Admin.cache\modelscope\ast_indexer

На этом локальное развертывание завершено. Вы можете использовать модель 14B, квантованную до 16f, позже. Это производительность лучшая. Если вам нужна точная настройка, обратитесь к:https://modelscope.cn/models/qwen/Qwen-7B-Chat/summary

3. Вызов API Тонги Цяньвэнь

1. Быстрый старт

Официальное руководство:https://help.aliyun.com/zh/dashscope/developer-reference/quick-start?spm=a2c4g.11186623.0.i0

Учебное пособие в основном разделено на три части:

(1) Получение API-ключа Тонги Цяньвэня :Активируйте DashScope и создайте API-KEY.

(2)Установить библиотеку DashScope: pip install Dashscope

(3)< /span>:Python вызывает API Tongyi Qianwen

# For prerequisites running the following sample, visit https://help.aliyun.com/document_detail/611472.html

from http import HTTPStatus

import dashscope

dashscope.api_key='YourAPIKey' #填入第一步获取的APIKEY

def call_with_messages():

messages = [{

'role': 'system', 'content': 'You are a helpful assistant.'},

{

'role': 'user', 'content': '如何做炒西红柿鸡蛋?'}]

response = dashscope.Generation.call(

dashscope.Generation.Models.qwen_turbo,

messages=messages,

result_format='message', # set the result to be "message" format.

)

if response.status_code == HTTPStatus.OK:

print(response)

else:

print('Request id: %s, Status code: %s, error code: %s, error message: %s' % (

response.request_id, response.status_code,

response.code, response.message

))

if __name__ == '__main__':

call_with_messages()

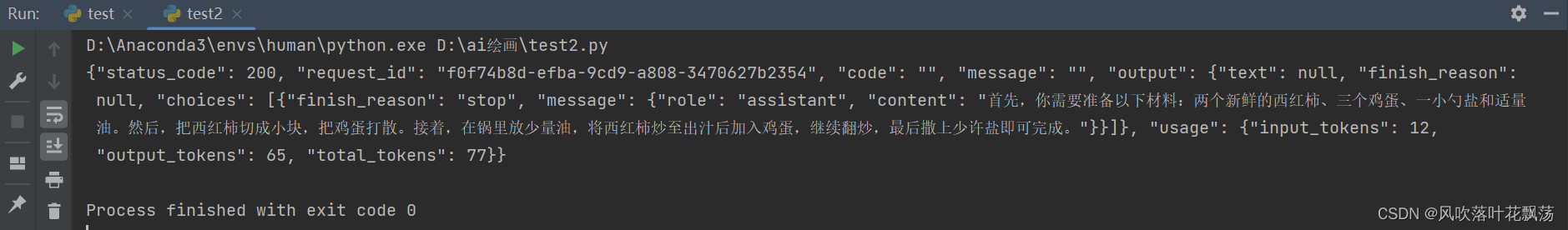

Результат выполнения:

Для получения дополнительной информации обратитесь к Подробным сведениям об API Tongyi Qianwen

2. Измерение и выставление счетов API

| модельный сервис | биллинговая единица |

|---|---|

| Тонги Цяньвэнь | Токен |

Примечание.

Токен — это базовая единица, используемая моделью для представления текста на естественном языке, и его можно интуитивно понимать как «символ» или «слово». Для китайского текста один токен обычно соответствует одному китайскому иероглифу; для английского текста один токен обычно соответствует 3–4 буквам.Услуга модели Tongyi Qianwen измеряется и выставляется счет на основе общего количества токенов, входящих и выходящих моделью, а история в нескольких раундах разговоров также измеряется и оплачивается как входные данные. Фактическое количество токенов, сгенерированных каждым вызовом модели, можно получить из ответа

.

| Название модели | Цена за единицу выставления счета |

|---|---|

| qwen-турбо | 0,008 юаня/1000 жетонов |

| qwen-плюс | 0,02 юаня/1000 жетонов |

| qwen-max | Открыто бесплатно в течение ограниченного времени |

В целом, Tongyi Qianwen не имеет большого преимущества перед OpenAI с точки зрения цены на API и не имеет преимущества с точки зрения текущего лимита. Единственное преимущество заключается в том, что его удобно и быстро использовать для отечественных новичков

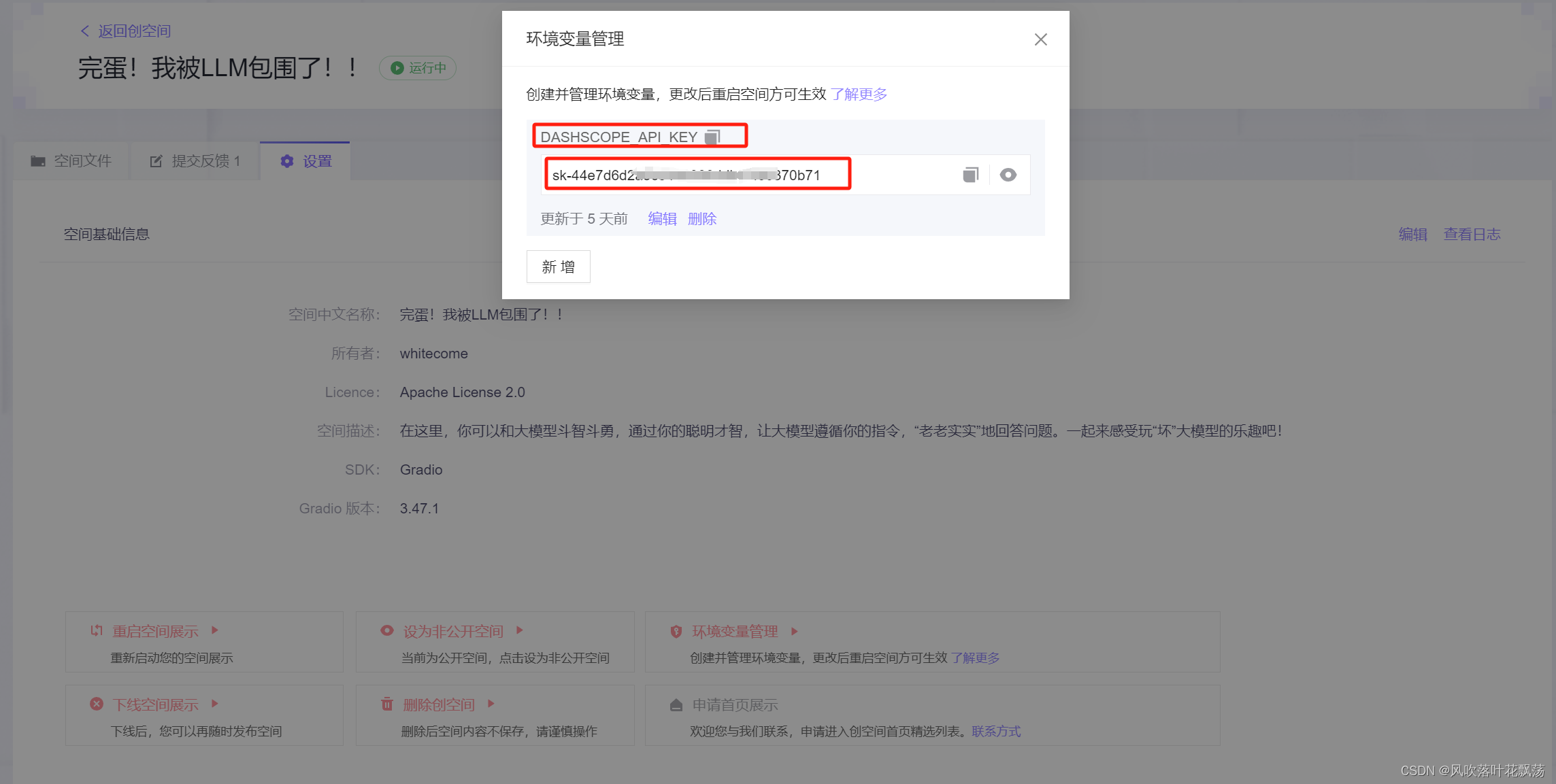

В сообществе Magic Tower вы также можете установить переменную среды DASHSCOPE_API_KEY =apikey. Нет необходимости задавать ее в коде. Скрытие apikey позволяет разработчикам быстро вызывать большие модели в творческом пространстве. Производственное пространство этой демонстрации Jiangzi немного шире.

Я надеюсь, что отечественное оборудование скоро будет разработано.