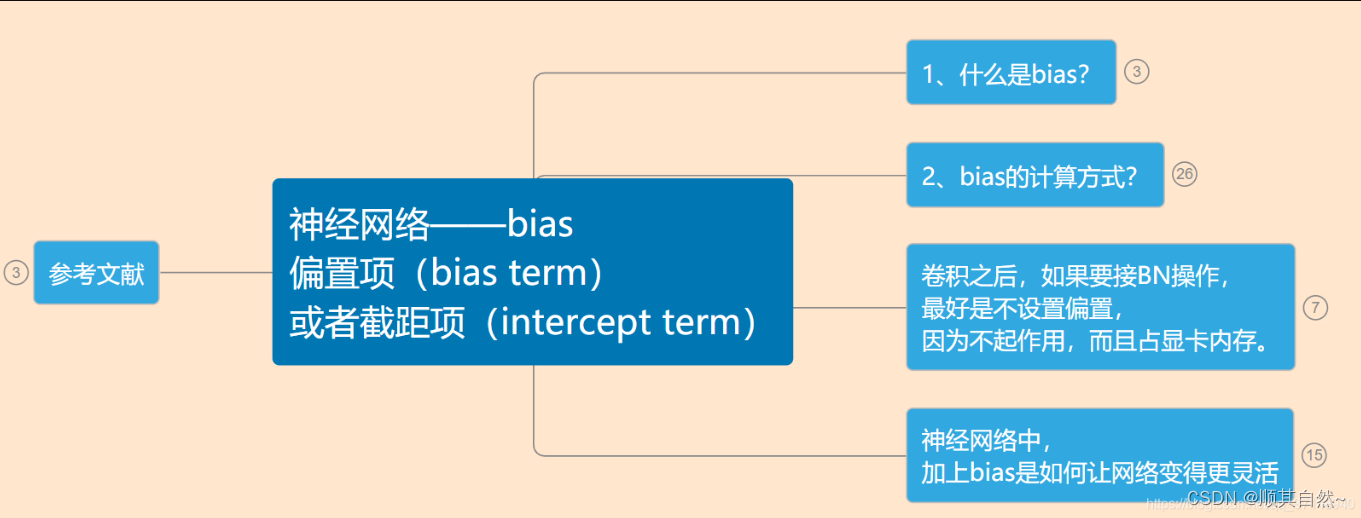

Red neuronal: término de sesgo (término de sesgo) o término de intersección (término de intersección)

referencias

Red neuronal - bias_red neuronal parámetro red w, b name_Devin01213's blog-CSDN blog

1. ¿Qué es el sesgo?

La unidad de sesgo (bias unit), también conocida como término de sesgo (término de sesgo) o término de intersección (término de intersección) en algunos materiales, en realidad es la intersección de la función, y la b en la ecuación lineal y=wx+b el significado es consistente.

En y=wx+b, b representa la intersección de la función en el eje Y, que controla la distancia de la función desde el origen. De hecho, la unidad de sesgo en la red neuronal tiene un efecto similar.

Por lo tanto, los parámetros de la red neuronal también se pueden expresar como: (W, b)

W representa la matriz de parámetros,

b representa el término de sesgo o término de intersección.

2. ¿Cómo se calcula el sesgo?

Hay dos formas de calcular y procesar la unidad de polarización en la estructura de la red neuronal.

(1) Establezca la unidad de sesgo = 1 y establezca los parámetros de la columna 0 correspondiente a la unidad de sesgo en la matriz de parámetros Θ, la red neuronal correspondiente es la siguiente:

Al calcular el valor de activación, siga (tome a(2)1 como ejemplo):

en,

x0 es la unidad de polarización de la primera capa (establecida en 1),

Θ(1)10 es el parámetro correspondiente a la unidad de polarización x0;

a(2)0 es la unidad de polarización de la segunda capa,

Θ(2)10 es el parámetro correspondiente.

Es equivalente a sesgarse a sí mismo con un valor de 1, pero el peso de cada neurona conectada a él no es 1,

Es decir, toda la red neuronal tiene solo 1 sesgo,

correspondiente a múltiples pesos diferentes

(El número de pesos es igual al número de neuronas en la capa oculta y en la capa exterior)

(2) Establezca la unidad de sesgo y no establezca los parámetros de la unidad de sesgo correspondiente en la matriz de parámetros. La red neuronal correspondiente es como sigue:

Al calcular el valor de activación según:

en,

b(1) es el vector unitario de sesgo correspondiente a W(1),

b(2) es el vector unitario de sesgo correspondiente a W(2),

b(1)1 es la unidad de polarización correspondiente a a(2)1.

Tenga en cuenta que en este punto la representación de parámetros de la red neuronal se cambia a: (W, b)

Es equivalente a que todos los pesos de sesgo que conectan cada neurona son 1,

Pero el sesgo en sí no es 1,

Es decir, hay múltiples sesgos, pero todos los sesgos corresponden a un peso de 1

(La cantidad de sesgo es igual a la cantidad de neuronas en la capa oculta y en la capa externa)

En resumen,

Los principios de los dos son los mismos, pero los métodos de implementación específicos son diferentes.

De hecho, los parámetros de la red neuronal que se ven en la mayoría de los materiales y artículos se expresan como: (W, b), donde W representa el peso y b representa el sesgo. Incluido en el Tutorial UFLDL también está representado por (W, b), pero vi que los parámetros de la red neuronal se expresan como Θ en el tutorial en línea del Sr. Andrew Ng en Coursera. Personalmente, sigo prefiriendo (W, b) Este La representación es muy clara.

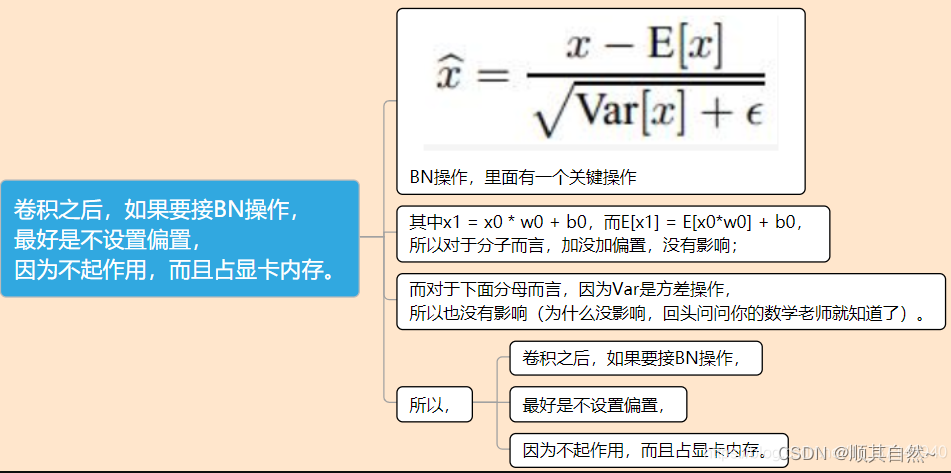

Después de la convolución, si desea conectarse a la operación BN, es mejor no configurar el sesgo, ya que no funciona y ocupa la memoria de la tarjeta gráfica.

Operación BN, que tiene una operación clave.

Entre ellos, x1 = x0 * w0 + b0, y E[x1] = E[x0*w0] + b0, por lo que para la molécula, agregar o no agregar sesgo no tiene efecto;

En cuanto al denominador a continuación, debido a que Var es una operación de varianza, no tiene efecto (por qué no tiene efecto, solo pregúntale a tu profesor de matemáticas).

entonces,

Después de la convolución, si desea conectarse a la operación BN,

Es mejor no establecer el sesgo,

Porque no funciona y ocupa memoria de la tarjeta gráfica.

En la red neuronal, ¿cómo la adición de sesgo hace que la red sea más flexible?

De hecho, el sesgo equivale a un parámetro más.

En el caso de agregar una pequeña cantidad de capacidad de ajuste a la red, en comparación con otros pesos ordinarios, el sesgo es más simple de calcular, independientemente de si avanza o retrocede, porque solo se requiere una adición.

Al mismo tiempo, la diferencia entre el sesgo y otros pesos es que su influencia en la salida no tiene nada que ver con la entrada, y puede hacer que la salida de la red se ajuste en su conjunto, que es otra dimensión de la libertad.

En dos dimensiones, el peso es equivalente a la pendiente de la línea recta y el sesgo es equivalente a la intersección, los cuales son parte de los parámetros de la línea recta y no hay necesidad de tratarlos de manera diferente.

Por lo tanto, normalmente la red utilizará sesgo, pero no es necesario y el impacto en el rendimiento de la red no es muy significativo (a menos que la red sea demasiado pequeña y la capacidad de ajuste sea demasiado pobre).

Al mismo tiempo, en algunas ocasiones, el uso de bias no tiene sentido, por ejemplo, no es necesario agregar la capa antes de la capa de normalización por lotes, porque se compensará con la normalización.

Simplemente considere una red simple con solo una entrada y una salida:

Suponiendo que se utiliza la función de activación sigmoide, si no hay sesgo, primero mire la situación bajo diferentes W:

Si la distribución de entrada de la entrada X_{in} se muestra en el punto azul (conjunto A) y el punto rojo (conjunto B) en la figura (distribución en el eje x), debe pasar Y_{out}(>0.5, o <0.5) Para juzgar si la entrada está en A o B, obviamente, para mejorar la precisión, el coeficiente W en la función sigmoidea debe aprenderse mucho para garantizar que el juicio sea lo más preciso posible.

Pero si una muestra de prueba está en la posición del punto verde en la figura, obviamente podemos juzgar el punto verde como el conjunto B donde se encuentra el punto rojo, pero la W aprendida a través del entrenamiento no se puede juzgar correctamente.

En este momento, parece que hacer que la función sigmoidea sea más inclinada no se puede resolver.

Pero, ¿qué pasa si agregas un sesgo?

Así, w (el coeficiente de x en sigmoide) puede mejorar la precisión del aprendizaje sin aprender demasiado, y la red puede adaptarse a la distribución de A y B de manera muy flexible, y puede juzgar con precisión el conjunto al que pertenece el punto verde.

En pocas palabras, agregar sesgo puede hacer que la distribución de la entrada de ajuste sea más flexible.

(1) Establezca la unidad de sesgo = 1 y establezca los parámetros de la columna 0 correspondiente a la unidad de sesgo en la matriz de parámetros Θ, la red neuronal correspondiente es la siguiente:

Entre ellos, x0 es la unidad de polarización de la primera capa (establecida en 1), Θ(1)10 es el parámetro correspondiente a la unidad de polarización x0, a(2)0 es la unidad de polarización de la segunda capa, Θ(2) ) 10 es el parámetro correspondiente.

Al calcular el valor de activación, siga (tome a(2)1 como ejemplo):

![]()

Es equivalente a sesgarse a sí mismo con un valor de 1, pero el peso de cada neurona conectada a él no es 1, es decir, toda la red neuronal tiene un solo sesgo, que corresponde a múltiples pesos diferentes (el número de pesos es igual a la capa oculta y las neuronas de la capa externa el número de yuanes)

(2) Configure la unidad de polarización, no configure los parámetros de la unidad de polarización correspondiente en la matriz de parámetros, la red neuronal correspondiente es la siguiente:

Entre ellos, b(1) es el vector unitario de polarización correspondiente a W(1), b(2) es el vector unitario de polarización correspondiente a W(2), b(1)1 es la unidad de polarización correspondiente a a(2) 1 . Tenga en cuenta que en este punto la representación de parámetros de la red neuronal se cambia a: (W, b)

Al calcular el valor de activación según:

![]()

Es equivalente a que todos los pesos del sesgo que conecta cada neurona son 1, pero el sesgo en sí mismo no es 1, es decir, hay múltiples sesgos, pero los pesos correspondientes a todos los sesgos son 1 (el número de sesgos es igual a la capa oculta y el número de neuronas de la capa)

En resumen,

Los principios de los dos son los mismos, pero los métodos de implementación específicos son diferentes.

De hecho, los parámetros de la red neuronal que se ven en la mayoría de los materiales y artículos se expresan como: (W, b), donde W representa el peso y b representa el sesgo. Incluido en el Tutorial UFLDL también está representado por (W, b), pero vi que los parámetros de la red neuronal se expresan como Θ en el tutorial en línea del Sr. Andrew Ng en Coursera. Personalmente, sigo prefiriendo (W, b) Este La representación es muy clara.